更新组装拆卸单入库时间——吉客云数据集成到轻易云集成平台技术案例

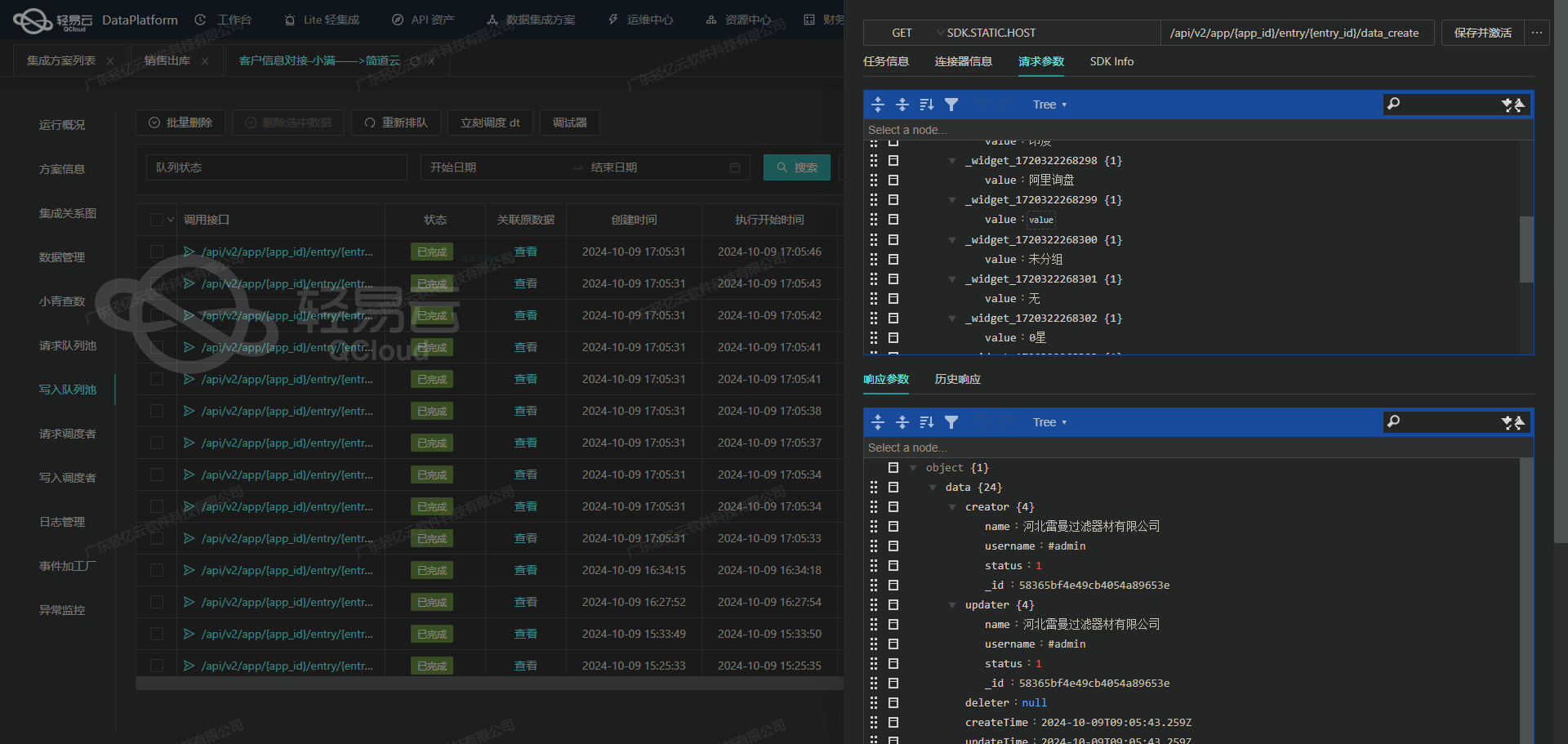

在复杂多变的业务环境中,确保数据无缝高效的流转是每一个企业面临的重要挑战。此次分享将聚焦于“更新组装拆卸单入库时间”的具体集成方案,通过详细解析如何利用轻易云和吉客云的数据接口,实现快速、稳定的数据导入。

为了完成这个任务,我们选择使用轻易云提供的UpdateStrategyData接口,将从吉客云系统获取到的数据进行处理与存储。而在这一过程中,关键步骤包括定时可靠地抓取吉客云API erp.storage.goodsdocin.v2 提供的数据,以批量方式写入,并确保整个过程中的数据质量监控及异常检测。

-

高吞吐量数据写入:通过优化传输协议和并发机制,我们实现了大规模数据在短时间内顺利载入,从而满足业务需求。

-

实时监控与告警:借助平台集中化的监控体系,每一步操作都能被实时跟踪,一旦发生问题,可以立即做出响应,有力保障了集成过程中各环节的平稳运行。

-

自定义转换逻辑:针对特定业务需求,对原始数据进行清洗、格式转换等预处理操作,使得最终导出的信息完全契合实际应用场景。

-

分页与限流处理:由于API调用频率限制以及返回结果可能溢出的情况,需要对请求进行合理分页,并加入限流策略以避免影响系统性能和可靠性。

-

异常重试机制: 集成过程中难免会遇到网络波动或其他不可预见的问题,这就需要我们设计有效的重试机制,在失败后重新尝试,从而提高整体成功率。

这些技术要点构筑起了一套完善且高效的数据集成解决方案,为后续更加复杂多样化的业务扩展奠定坚实基础。接下来将逐步介绍具体实施细节及最佳实践方法。

调用吉客云接口erp.storage.goodsdocin.v2获取并加工数据

在轻易云数据集成平台中,调用源系统接口是数据处理生命周期的第一步。本文将详细探讨如何通过调用吉客云接口erp.storage.goodsdocin.v2来获取并加工数据,以实现更新组装拆卸单入库时间的需求。

接口配置与请求参数

首先,我们需要配置接口的元数据。根据提供的元数据配置,我们可以看到该接口使用POST方法进行请求,主要参数包括分页信息、时间范围、返回字段以及特定的过滤条件。

{

"api": "erp.storage.goodsdocin.v2",

"effect": "QUERY",

"method": "POST",

"number": "goodsdocNo",

"id": "goodsdocNo",

"idCheck": true,

"request": [

{"field": "pageIndex", "label": "分页页码", "type": "string"},

{"field": "pageSize", "label": "分页页数", "type": "string", "value": "50"},

{"field": "startDate", "label": "创建时间的起始时间", "type": "string",

"value":"{{LAST_SYNC_TIME|datetime}}"},

{"field": "endDate", "label": "创建时间的结束时间",

"type":"string","value":"{{CURRENT_TIME|datetime}}"},

{"field":"selelctFields","label":"返回字段","type":"string",

"value":"goodsdocNo,inOutDate,gmtCreate,inouttype,sourceBillNo,vendCustomerCode,warehouseCode,warehouseName,redStatus,financeBillStatus"},

{"field":"inouttype","label":"入库类型","type":"string","value":"107"},

{"field":"vendCode","label":"往来供应商","type":"string"}

],

...

}请求参数详解

- 分页参数:

pageIndex和pageSize用于控制分页,确保一次请求不会返回过多的数据。 - 时间范围:

startDate和endDate用于限定查询的数据范围,分别取自上次同步时间和当前时间。 - 返回字段:通过

selelctFields指定需要返回的字段,包括单据编号、入库日期、创建时间等。 - 入库类型:通过设置

inouttype=107来筛选特定类型的入库单据。 - 供应商代码:可选参数,用于进一步筛选特定供应商的数据。

条件过滤与自动填充

在元数据配置中,还包含了条件过滤和自动填充响应的设置:

"condition_bk":[

[{"field":"inouttype","logic":"eqv2","value":"101"},

{"field":"goodsDocDetailList.quantity","logic":"gt","value":"0"}]

],

"condition":[

[{"field":"redStatus","logic":"eqv2","value":"1"}]

],

"autoFillResponse": true- 条件过滤:通过设置条件过滤,可以进一步精确地筛选出符合业务需求的数据。例如,过滤掉红冲状态为1的数据。

- 自动填充响应:设置为true后,系统会自动处理响应结果,将其填充到目标数据库或系统中。

数据加工与处理

获取到原始数据后,需要对其进行加工处理,以便后续使用。在本案例中,我们可能需要对入库日期进行格式转换或对某些字段进行计算。例如:

def process_data(data):

for record in data:

# 转换日期格式

record['formatted_inOutDate'] = convert_date_format(record['inOutDate'])

# 根据业务逻辑计算新的字段值

record['new_field'] = calculate_new_value(record)

return data

def convert_date_format(date_str):

# 假设原始日期格式为 'YYYY-MM-DD HH:MM:SS'

return datetime.strptime(date_str, '%Y-%m-%d %H:%M:%S').strftime('%d/%m/%Y')

def calculate_new_value(record):

# 示例计算逻辑

return record['quantity'] * record['price']异常处理与重试机制

在实际操作中,可能会遇到网络波动或接口超时等异常情况。为了保证数据获取的稳定性,可以实现异常处理和重试机制:

import requests

from time import sleep

def fetch_data_with_retry(url, params, max_retries=3):

attempts = 0

while attempts < max_retries:

try:

response = requests.post(url, json=params)

if response.status_code == 200:

return response.json()

else:

raise Exception(f"Unexpected status code: {response.status_code}")

except Exception as e:

attempts += 1

print(f"Attempt {attempts} failed: {e}")

sleep(2) # 等待一段时间后重试

raise Exception("Max retries exceeded")

# 使用示例

data = fetch_data_with_retry(api_url, request_params)通过以上步骤,我们可以高效地调用吉客云接口获取所需数据,并进行必要的数据加工和处理,为后续的数据写入和业务应用打下坚实基础。

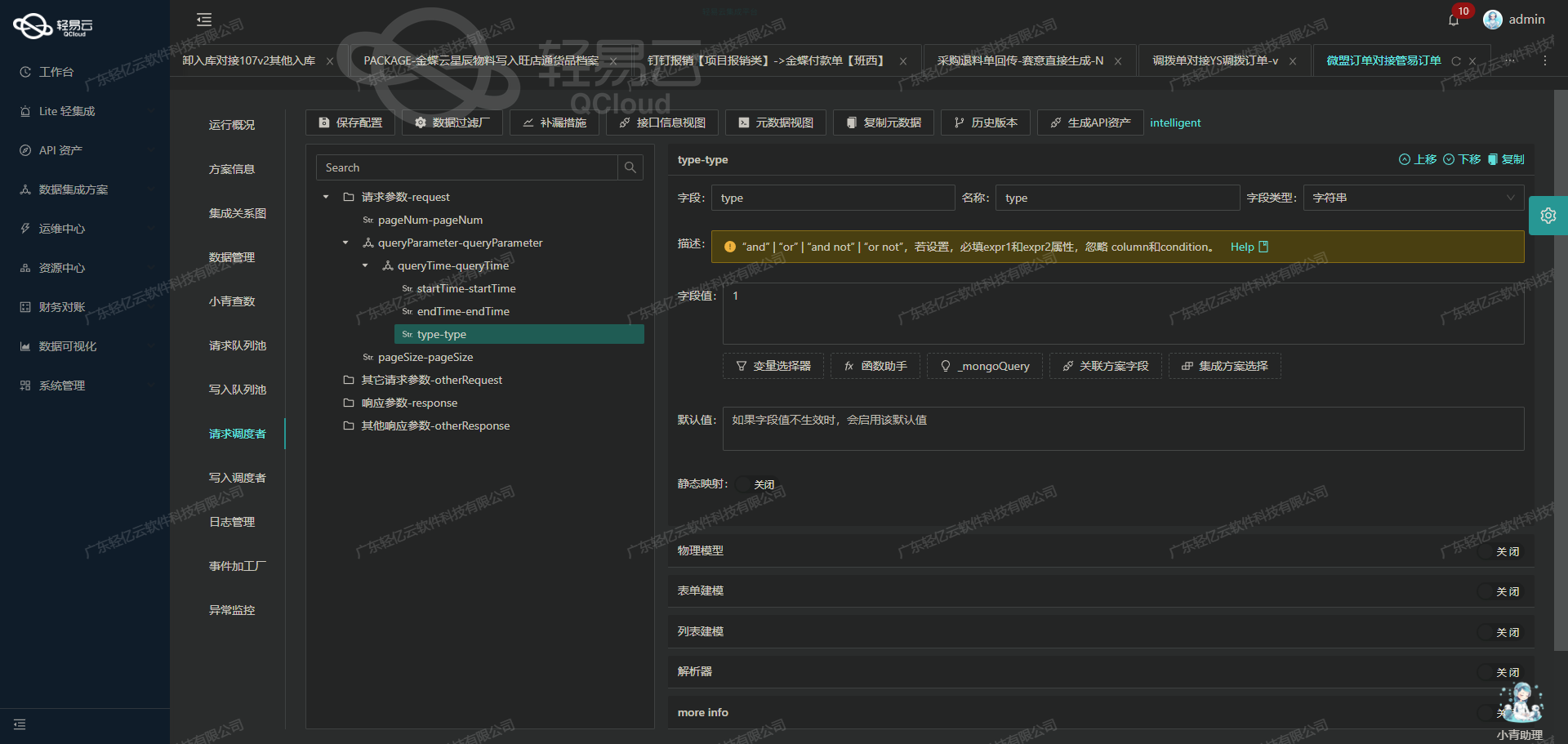

更新组装拆卸单入库时间的ETL转换与写入

在数据集成的生命周期中,将源平台的数据进行ETL(Extract, Transform, Load)转换,并将其写入目标平台是关键步骤之一。本文将详细探讨如何利用轻易云数据集成平台的API接口,实现更新组装拆卸单入库时间的功能。

API接口配置与元数据解析

在本案例中,我们使用的是UpdateStrategyData API接口,通过POST方法向目标平台发送请求。以下是元数据配置的详细解析:

{

"api": "UpdateStrategyData",

"effect": "EXECUTE",

"method": "POST",

"idCheck": true,

"request": [

{"field": "updateKeys", "label": "updateKeys", "type": "string", "value": "inDatetime"},

{"field": "updateValues", "label": "updateValues", "type": "string", "value": "{inOutDate}"},

{"field": "updateTypes", "label": "updateTypes", "type": "string", "value":"string"}

],

"otherRequest":[

{"field":"strategy_id","label":"目标方案ID","type":"string","value":"17441eb0-0e8c-3c97-b590-c0cf195d2bec"},

{"field":"whereKeys","label":"whereKeys","type":"string","value":"content.assNo"},

{"field":"whereValues","label":"whereValues","type":"string","value":"{sourceBillNo}"},

{"field":"whereType","label":"whereType","type":"string","value":"string"}

]

}数据请求与清洗

首先,我们需要从源平台提取相关数据。这一步骤通常涉及到调用源系统的API或从数据库中查询所需的数据。例如,从源系统获取包含inOutDate和sourceBillNo字段的数据。

SELECT inOutDate, sourceBillNo FROM source_table WHERE condition;数据转换

在获取到原始数据后,需要进行必要的转换,以符合目标平台API接口所需的数据格式。在本例中,主要是将日期格式化为字符串,并确保所有字段类型匹配。

# 假设我们使用Python进行数据转换

from datetime import datetime

def transform_data(row):

transformed_row = {

'inOutDate': datetime.strptime(row['inOutDate'], '%Y-%m-%d %H:%M:%S').strftime('%Y-%m-%dT%H:%M:%SZ'),

'sourceBillNo': row['sourceBillNo']

}

return transformed_row数据写入

完成数据转换后,即可构建请求体并调用目标平台的API接口。以下是构建请求体和调用API的示例代码:

import requests

def update_assembly_entry(data):

url = 'https://api.targetplatform.com/UpdateStrategyData'

payload = {

'updateKeys': 'inDatetime',

'updateValues': data['inOutDate'],

'updateTypes': 'string',

'strategy_id': '17441eb0-0e8c-3c97-b590-c0cf195d2bec',

'whereKeys': 'content.assNo',

'whereValues': data['sourceBillNo'],

'whereType': 'string'

}

headers = {'Content-Type': 'application/json'}

response = requests.post(url, json=payload, headers=headers)

if response.status_code == 200:

print('Data updated successfully')

else:

print('Failed to update data:', response.text)

# 示例调用

for row in source_data:

transformed_row = transform_data(row)

update_assembly_entry(transformed_row)实时监控与异常处理

在实际操作过程中,实时监控和异常处理至关重要。可以通过日志记录和报警机制来确保每次数据更新操作都能被及时跟踪和处理。

import logging

logging.basicConfig(level=logging.INFO)

def update_assembly_entry_with_logging(data):

try:

update_assembly_entry(data)

logging.info(f"Successfully updated entry for {data['sourceBillNo']}")

except Exception as e:

logging.error(f"Failed to update entry for {data['sourceBillNo']}: {str(e)}")

# 示例调用带日志记录

for row in source_data:

transformed_row = transform_data(row)

update_assembly_entry_with_logging(transformed_row)通过上述步骤,我们实现了从源平台提取数据、进行ETL转换并最终写入目标平台的全过程。这不仅提高了数据处理效率,也确保了数据的一致性和准确性。