吉客云·奇门数据集成到MySQL:销售订单(OMS)系统对接案例

在企业的日常运营中,数据的高效集成与处理至关重要。本文将分享一个具体技术案例:如何通过轻易云平台,将吉客云·奇门(以下称“奇门”)的数据无缝集成到MySQL数据库中,实现销售订单管理系统(OMS)的高效运作。

技术挑战与解决方案

1. 数据获取与定时抓取

首先,通过调用奇门API接口jackyun.tradenotsensitiveinfos.list.get来获取所需的交易信息。这一过程需要确保定时可靠地抓取数据,避免出现丢单现象。我们利用轻易云平台提供的调度机制,实现了对该接口数据的周期性请求,并设置告警功能以监控任务执行状态。

2. 数据转换与过滤

接收到来自奇门的数据后,需要进行适当的数据转换和过滤,以便兼容目标MySQL数据库的表结构和字段类型。在这一过程中,自定义数据转换逻辑起到了关键作用。例如,我们针对不同数据源字段格式差异进行了标准化处理,以确保写入操作的一致性。

3. 高吞吐量批量写入

为了应对大规模数据传输需求,我们采用了高吞吐量的数据写入策略,有效提升了处理效率。MySQL API executeReturn被用于实现批量插入操作,同时配置了服务器资源以支持大容量并发访问,从而保障性能稳定性。

4. 分页和限流问题

在大量数据交换场景下,分页和限流是需要特别关注的问题。通过合理调整API请求参数,我们成功规避了单次请求传输过多导致超时或失败的问题。此外,对异常进行捕获并实施重试机制,可以显著提高整体任务成功率。

实时监控与日志记录

整个集成流程实时监控对于每个环节都尤为重要。从初始抓取、到数据转化再到最终写入,每一步都有详细日志记录,这样可以迅速定位潜在问题并及时修复。同时,通过集中化监控台,可以全面掌握各项任务运行状况,为业务决策提供有效支撑。

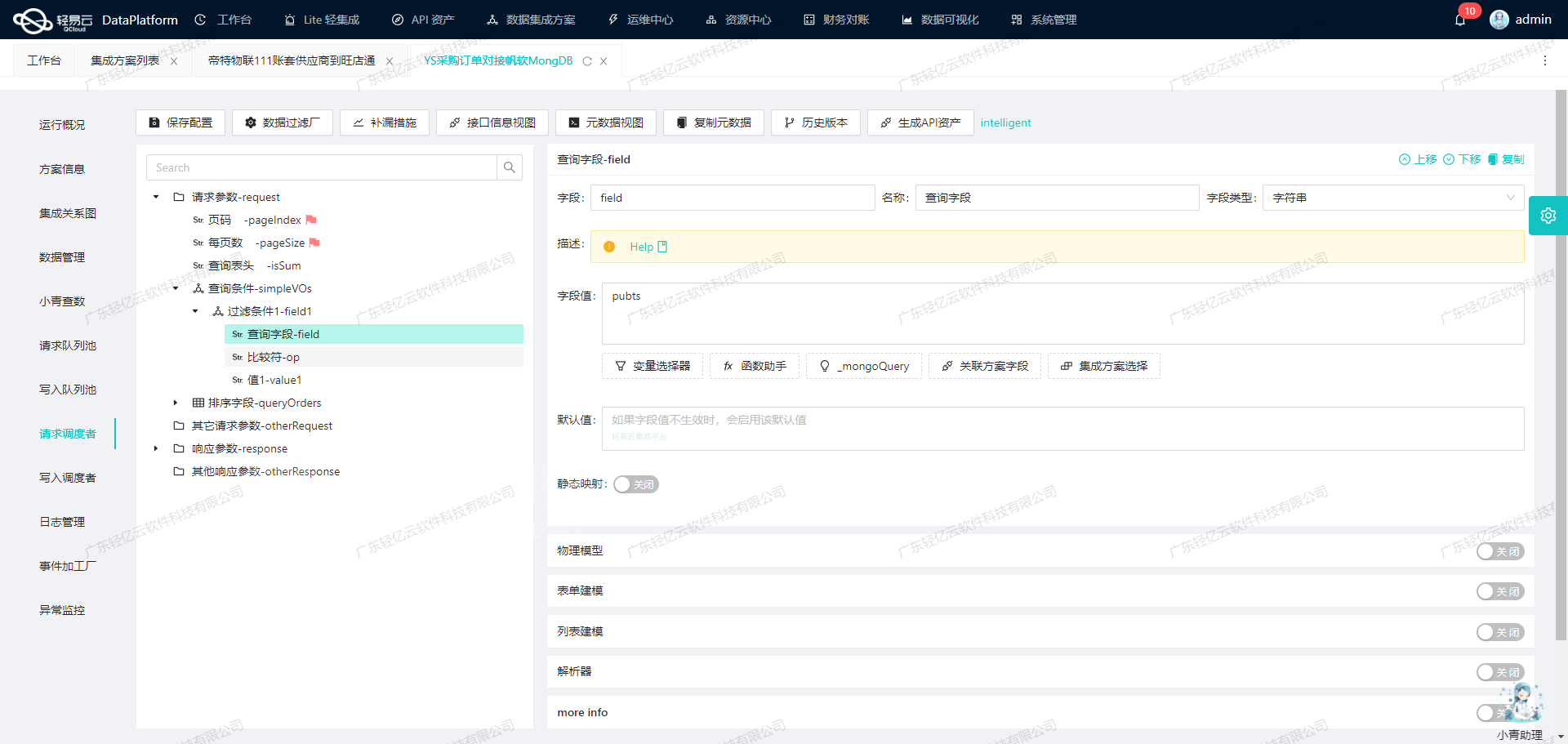

调用吉客云·奇门接口获取并加工数据的技术实现

在轻易云数据集成平台中,调用源系统吉客云·奇门接口jackyun.tradenotsensitiveinfos.list.get是数据集成生命周期的第一步。本文将详细探讨如何通过该接口获取销售订单数据,并对其进行初步加工处理。

接口调用配置

首先,我们需要配置API调用的基本信息,包括请求方法、分页参数和请求字段等。以下是元数据配置中的关键部分:

{

"api": "jackyun.tradenotsensitiveinfos.list.get",

"method": "POST",

"pagination": {

"pageSize": 20

},

"request": [

{"field":"modified_begin","label":"起始时间","type":"string"},

{"field":"modified_end","label":"结束时间","type":"string"},

{"field":"tradeNo","label":"销售单号,多个用半角逗号分隔","type":"string"},

{"field":"pageSize","label":"每页记录数,默认50,最大1000","type":"string","value":"100"},

{"field":"pageIndex","label":"页码,0为第1页","type":"string","value":"{PAGINATION_START_PAGE}"},

{"field":"hasTotal","label":"默认返回,首次调用时可以传1获取总记录数","type":"string","value":"1"}

]

}在这里,我们设置了API名称为jackyun.tradenotsensitiveinfos.list.get,请求方法为POST。分页参数中,每页记录数设定为20条。

请求参数构建

为了确保请求的有效性,需要构建包含必要字段的请求参数。以下是一个示例请求参数:

{

"modified_begin": "2023-01-01T00:00:00",

"modified_end": "2023-01-07T23:59:59",

"tradeNo": "",

"pageSize": 20,

"pageIndex": 0,

"hasTotal": 1

}其中,modified_begin和modified_end用于指定查询时间范围,确保数据的时效性和准确性。

数据清洗与格式化

获取到原始数据后,需要对其进行清洗和格式化处理。例如,将字段名consignTime重命名为consignTime_new并格式化为日期类型:

{

"formatResponse": [

{

"old": "consignTime",

"new": "consignTime_new",

"format": "date"

}

]

}通过上述配置,可以确保返回的数据符合目标系统的要求。

数据缺失补救

为了应对可能的数据缺失情况,可以设置定时任务(crontab)来定期补救遗漏的数据:

{

"omissionRemedy": {

"crontab": "30 6,1 * * *",

"takeOverRequest": [

{

"field": "startConsignTime",

"label": "发货时间(起始)",

"type": "string",

"value": "{{DAYS_AGO_2|datetime}}"

},

{

"field": "endConsignTime",

"label": "发货时间(截止)",

"type": "string",

"value": "{{CURRENT_TIME|datetime}}"

}

]

}

}该配置表示每天凌晨1点和早上6点各执行一次补救任务,以确保数据完整性。

条件过滤与ID校验

为了提高数据质量,可以设置条件过滤和ID校验。例如,仅获取订单状态大于等于6000的订单,并启用ID校验:

{

"condition":[

[

{"field":"tradeStatus","logic":"egt","value":"6000"}

]

],

"idCheck": true

}通过上述配置,可以有效过滤无效数据,并确保每条记录都有唯一标识符。

完整请求示例

综合以上配置,一个完整的API请求示例如下:

{

"_api_": {

"_name_": "_jackyun.tradenotsensitiveinfos.list.get_",

"_method_": "_POST_"

},

"_pagination_":{

"_pageSize_":20,

"_pageIndex_":{

"_startPage_":{

"_value_":{"PAGINATION_START_PAGE"}

}

}

},

"_request_":[

{"_field_":"modified_begin", "_value_":{"2023-01-01T00:00:00"}},

{"_field_":"modified_end", "_value_":{"2023-01-07T23:59:59"}},

{"_field_":"tradeNo", "_value_":{"null"}},

{"_field_":"pageSize", "_value_":{"20"}},

{"_field_":"pageIndex", "_value_":{"0"}},

{"_field_":"hasTotal", "_value_":{"1"}}

],

...

}通过以上步骤,我们可以成功调用吉客云·奇门接口获取销售订单数据,并对其进行初步加工处理,为后续的数据转换与写入奠定基础。

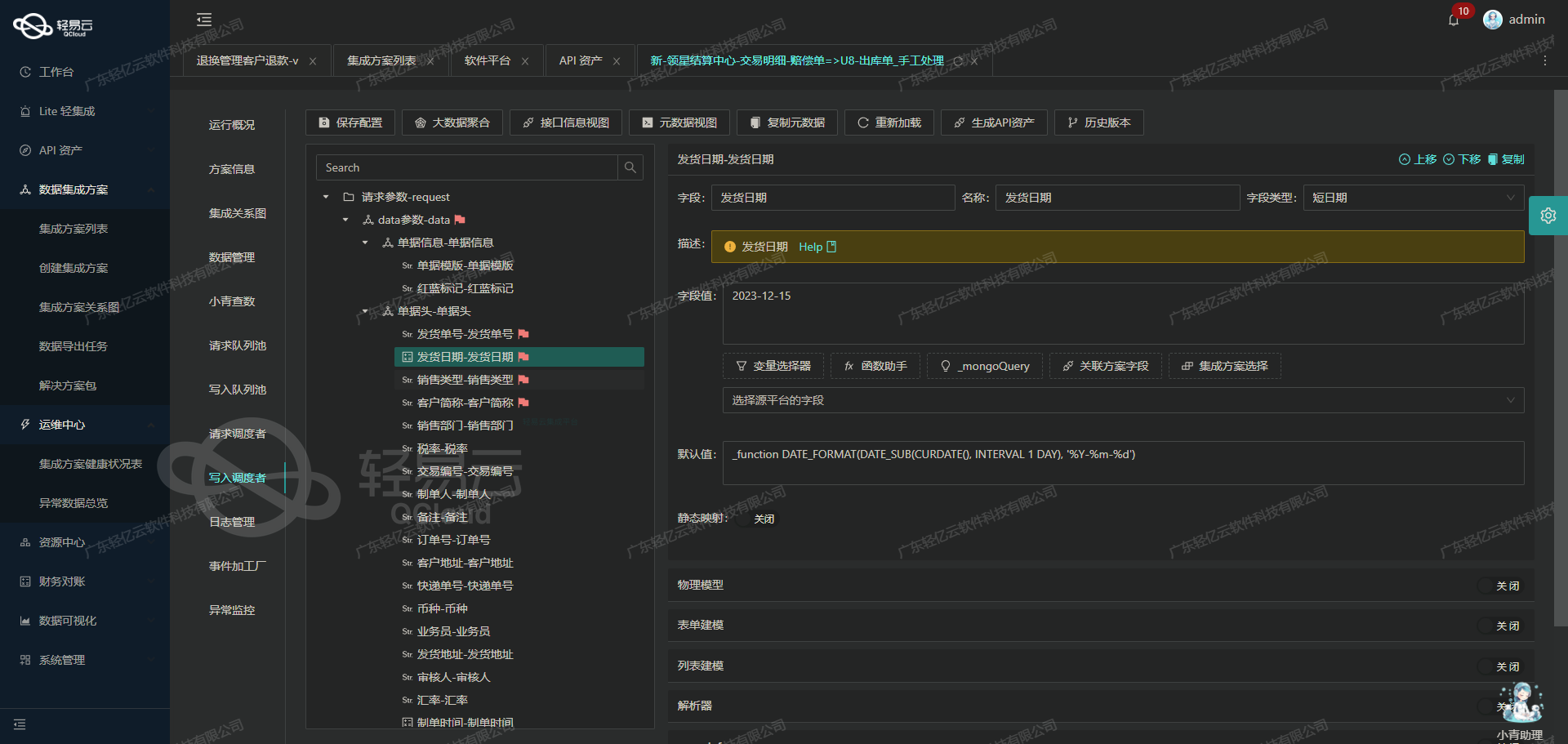

使用轻易云数据集成平台进行销售订单数据的ETL转换和写入MySQL

在数据集成过程中,将源平台的数据转换为目标平台所能接收的格式是关键步骤。本文将详细探讨如何利用轻易云数据集成平台,将销售订单(OMS)数据通过ETL(Extract, Transform, Load)过程,转换并写入到目标平台MySQL的API接口中。

数据请求与清洗

首先,我们需要从源系统提取原始数据,并进行必要的清洗和预处理。这一步骤确保了我们获取的数据是准确且符合业务需求的。在轻易云平台上,我们可以通过配置元数据来实现这一过程。

数据转换与写入

在完成初步的数据请求与清洗后,接下来就是将这些数据转换为目标平台能够接受的格式,并通过API接口写入到MySQL数据库中。以下是具体的操作步骤和技术细节:

-

配置API接口元数据

我们使用如下配置元数据,定义了API接口

executeReturn,并通过POST方法将数据发送到目标平台:{ "api": "executeReturn", "method": "POST", "idCheck": true, "request": [ { "field": "main_params", "label": "主参数", "type": "object", "children": [ {"field": "trade_no", "label": "订单编码", "type": "string", "value": "{tradeNo}", "parent": "main_params"}, {"field": "trade_type", "label": "销售单类型", "type": "string", "value": "{tradeType}", "parent": "main_params"}, {"field": "trade_status", "label": "单据状态", "type": "string", "value": "{tradeStatus}", "parent": "main_params"}, {"parent":"main_params","label":"销售组织","field":"sale_org_id","type":"string","value":"_findCollection find textField_l2iazxw0 from a7cb0b9d-2aef-342a-bcb9-7d02e747f1d8 where textField_l2iazxvw={shopCode}"}, {"parent":"main_params","label":"店铺编码","field":"shop_code","type":"string","value":"{shopCode}"}, {"parent":"main_params","label":"店铺id","field":"shop_id","type":"string","value":"{shopId}"}, {"parent":"main_params","label":"店铺名称","field":"shop_name","type":"string","value":"{shopName}"}, {"parent":"main_params","label":"公司名称","field":"company_name","type":"string","value":"{companyName}"}, {"parent":"main_params","label":"日期(发货时间)","field":"date","type":"string","value":"{consignTime}"}, {"field": "trade_date", "label": "下单日期", "type": "string", "value" : "{tradeTime}"} ] }, { ... } ], ... } -

构建SQL插入语句

配置中的

otherRequest部分定义了主要和扩展表的插入语句。主表插入语句如下:INSERT INTO `lehua`.`oms_sale_order` ( `trade_no`, `trade_type`, `trade_status`, `sale_org_id`, `shop_code`, `shop_id`, `shop_name`, `company_name`, `date`, `trade_date`, ... ) VALUES ( <{trade_no: }>, <{trade_type: }>, <{trade_status: }>, <{sale_org_id: 0}>, <{shop_code: 0}>, <{shop_id: 0}>, <{shop_name: 0}>, <{company_name: 0}>, <{date: CURRENT_TIMESTAMP}>, <{trade_date: 0000-00-00 00:00:00}> ); -

处理扩展参数

在扩展参数部分,我们定义了多个字段,例如订单详情、货品信息等。这些字段会被一一映射到相应的数据库表中:

{ ... { field: 'extend_params_1', label: '1:1扩展参数', type: 'array', children: [ { field: 'lastInsertId', label: 'order_id', type: 'string', value: ':lastInsertId', parent: 'extend_params_1' }, { parent:'extend_params_1', label:'销售单号', field:'trade_no', type:'string', value:'{tradeNo}' }, { parent:'extend_params_1', label:'货品编号', field:'goods_no', type:'string', value:'{goodsNo}' }, ... ], value:'goodsDetail' } ... } -

执行API调用

配置完成后,通过轻易云平台执行API调用,将转换后的数据发送至MySQL API接口,实现数据写入。此过程包括对每个字段进行映射和转换,确保符合数据库表结构要求。

-

监控与日志记录

在整个ETL过程中,实时监控和日志记录是不可或缺的一部分。它们帮助我们及时发现并解决潜在问题,确保数据集成过程顺利进行。

通过上述步骤,我们成功地将销售订单(OMS)数据从源系统提取、转换,并写入到目标平台MySQL中。这不仅提升了业务透明度和效率,还确保了各系统间的数据一致性和准确性。