获取工作表组件班牛:高效集成方案解析

在数据驱动的业务环境中,如何高效地实现数据集成是每个企业面临的重要课题。本文将分享一个具体的系统对接案例——将班牛的数据集成到班牛平台,探讨如何利用轻易云数据集成平台的强大功能,实现这一目标。

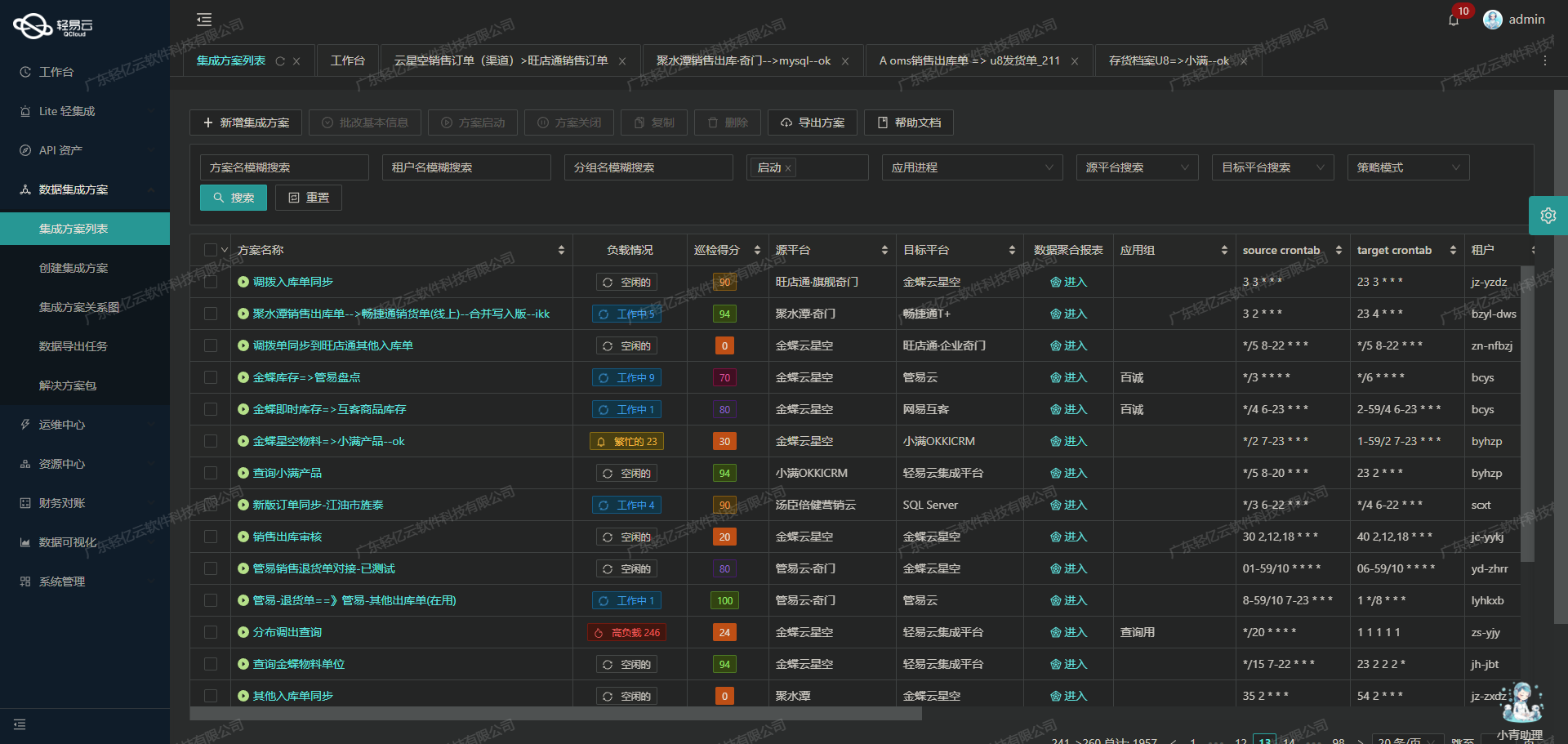

为了确保数据集成过程的高效性和可靠性,我们采用了“获取工作表组件班牛”这一方案。该方案不仅支持高吞吐量的数据写入能力,使得大量数据能够快速被集成到班牛系统中,还提供了集中监控和告警系统,实时跟踪数据集成任务的状态和性能。

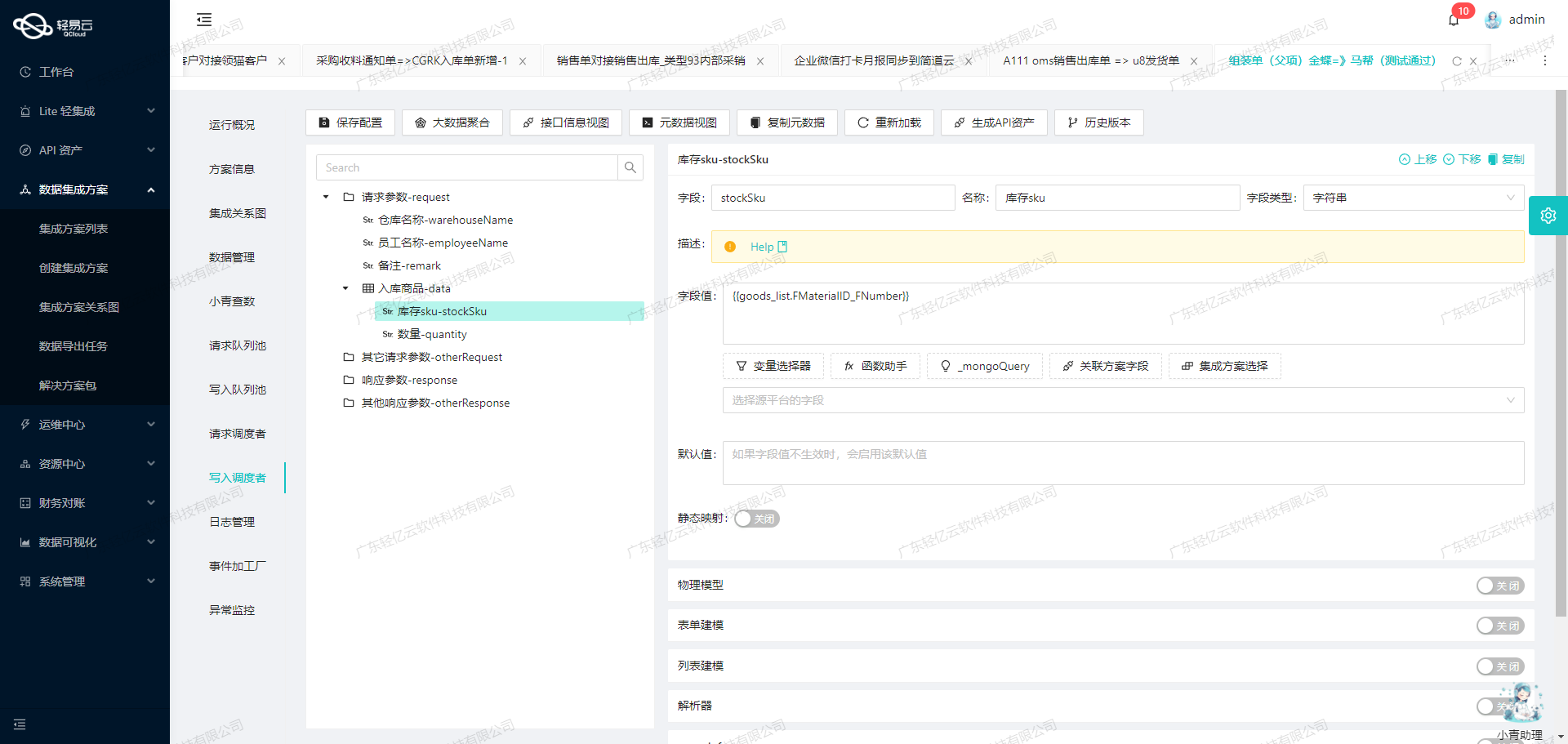

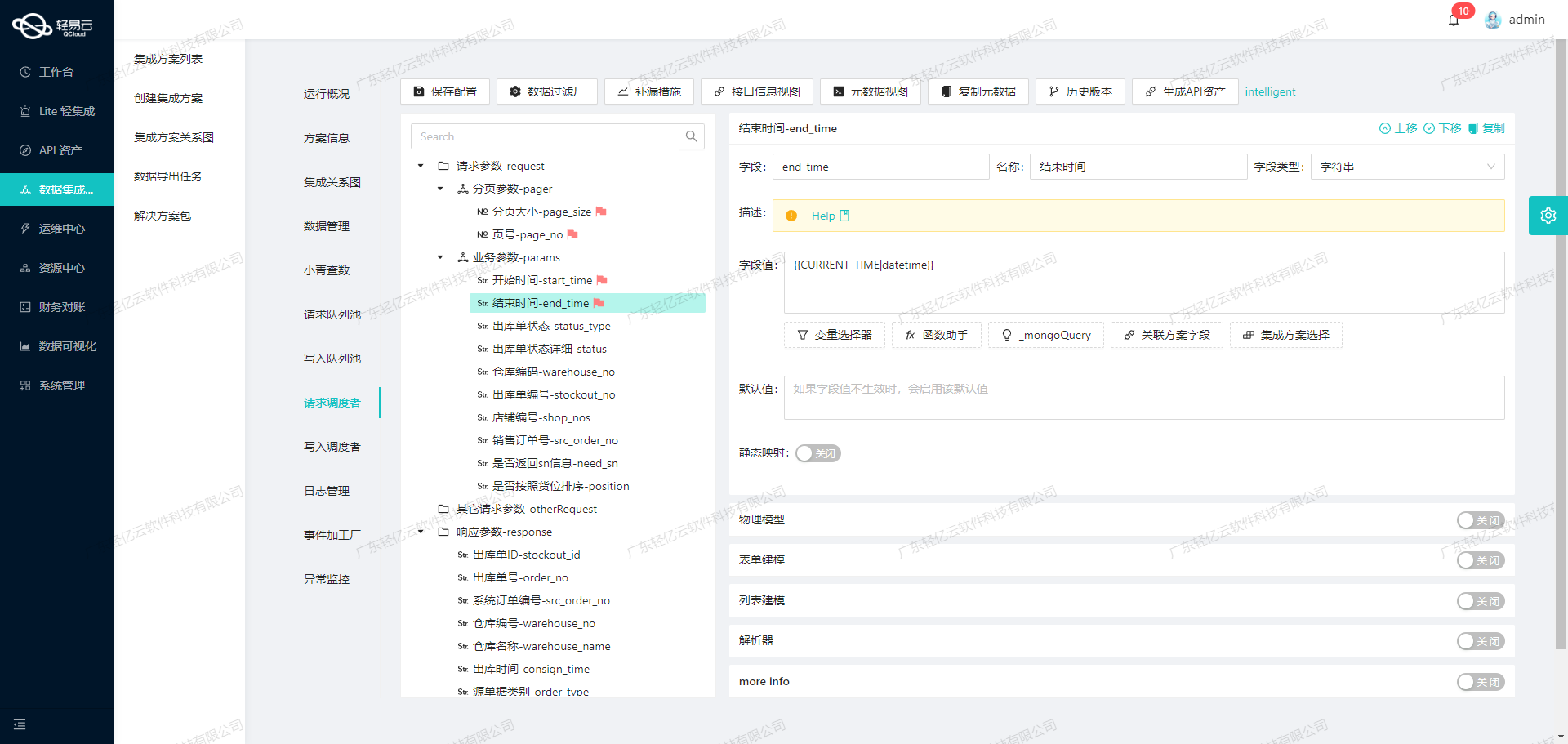

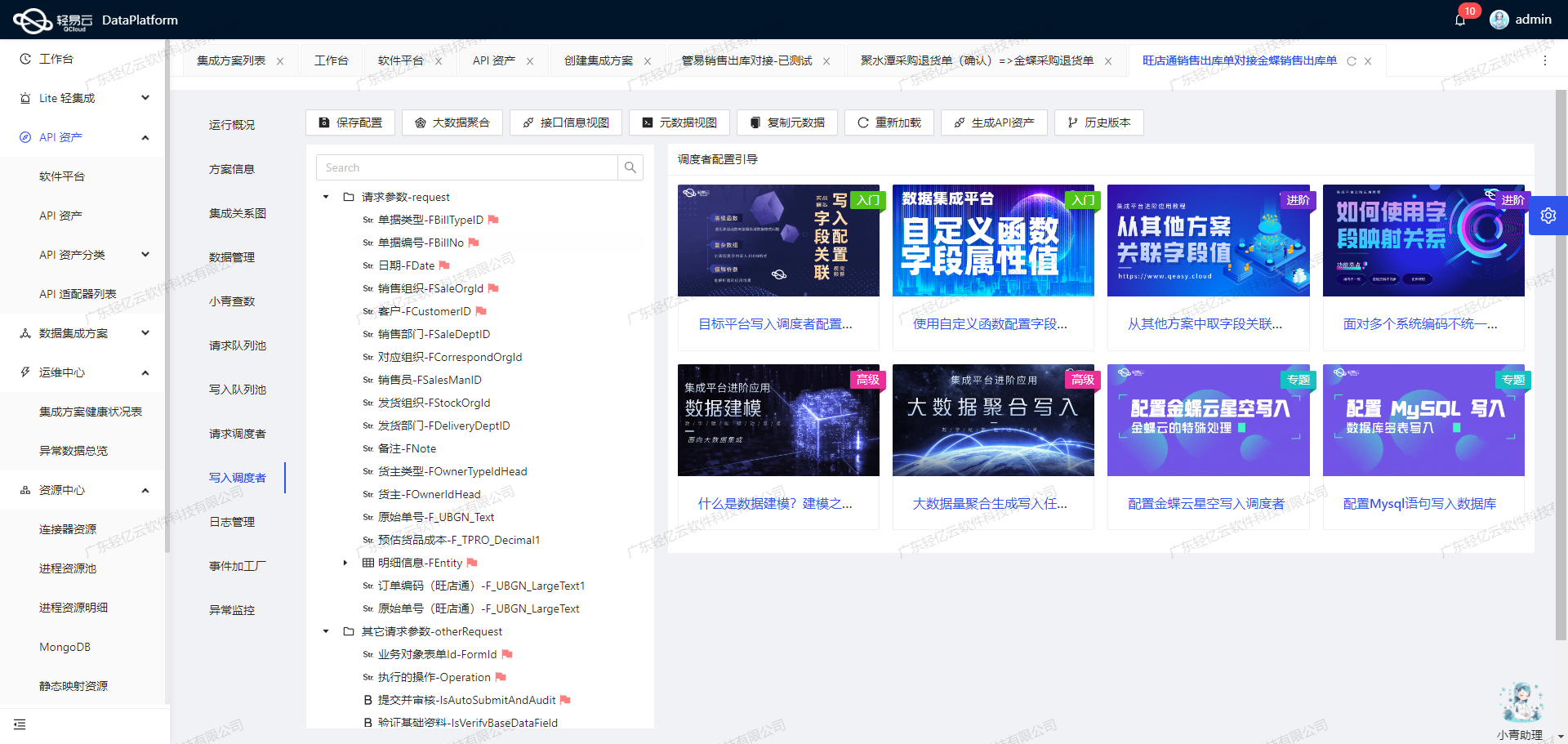

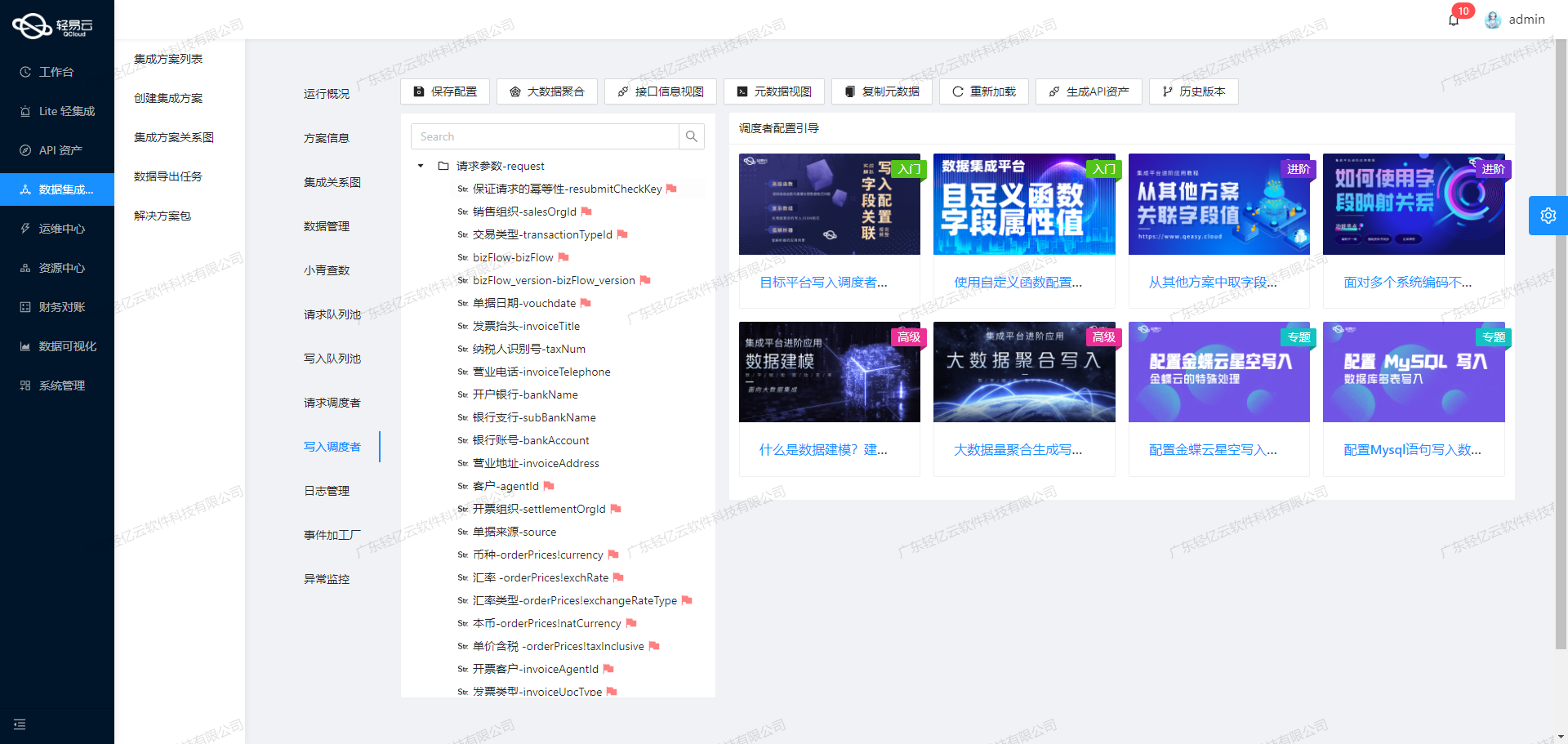

通过调用班牛提供的API接口column.list获取所需的数据,并使用workflow.task.create接口将处理后的数据写入目标平台,我们可以实现从源头到目标的一站式数据流转。在此过程中,轻易云的平台特性如自定义数据转换逻辑、可视化的数据流设计工具以及异常处理与错误重试机制等,都为我们提供了极大的便利。

此外,为了确保整个流程中的数据质量,我们还引入了实时监控与日志记录功能。这不仅帮助我们及时发现并处理潜在的问题,也为后续优化提供了宝贵的数据支持。

接下来,我们将详细解析这个方案的具体实施步骤及技术要点。

调用源系统班牛接口column.list获取并加工数据

在轻易云数据集成平台的生命周期管理中,调用源系统API接口是至关重要的第一步。本文将详细探讨如何通过调用班牛接口column.list来获取并加工数据。

接口配置与调用

首先,我们需要配置元数据以便正确调用班牛的column.list接口。以下是该接口的基本配置:

{

"api": "column.list",

"effect": "QUERY",

"method": "GET",

"number": "{random}",

"id": "{random}",

"idCheck": true,

"request": [

{

"field": "project_id",

"label": "project_id",

"type": "string",

"value": "73625"

}

],

"autoFillResponse": true

}在这个配置中,api字段指定了要调用的API名称为column.list,请求方法为GET。我们还设置了一个项目ID作为请求参数,以确保我们能够获取到特定项目的数据。

数据请求与清洗

一旦成功调用API并获取到原始数据,我们需要对这些数据进行清洗和预处理。这一步骤包括但不限于以下操作:

- 字段映射:将API返回的数据字段映射到目标系统所需的字段。例如,将返回结果中的某些字段重命名或重新组织。

- 数据过滤:根据业务需求过滤掉不必要的数据。例如,只保留状态为“active”的记录。

- 格式转换:将日期、时间等字段转换为目标系统支持的格式。

通过轻易云提供的可视化工具,这些操作可以直观地完成,无需编写复杂代码。

数据转换与写入

在完成数据清洗后,需要将其转换为目标系统所需的数据结构,并写入到相应的位置。这一步骤通常包括以下内容:

- 自定义转换逻辑:根据业务需求编写自定义脚本或规则,对数据进行进一步处理。例如,将多个字段合并成一个复合键。

- 批量写入:利用轻易云高吞吐量的数据写入能力,将大量清洗后的数据快速导入到班牛系统中。这不仅提高了效率,还确保了数据的一致性和完整性。

实时监控与异常处理

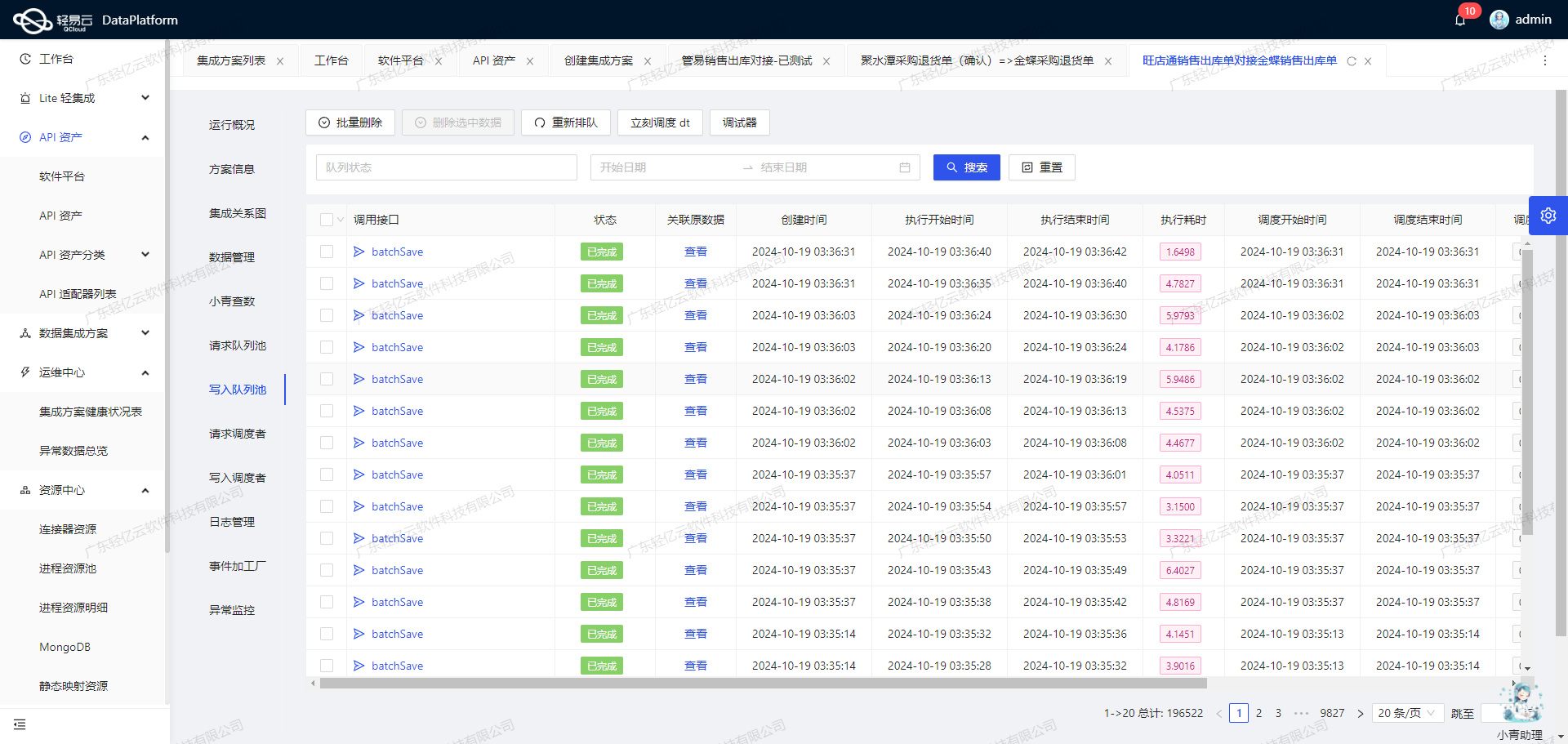

为了确保整个过程顺利进行,实时监控和异常处理机制必不可少。轻易云提供了集中监控和告警系统,可以实时跟踪每个集成任务的状态和性能。一旦发现异常情况,例如网络超时或API限流问题,可以自动触发重试机制,确保任务最终成功完成。

此外,通过日志记录功能,可以详细追踪每一步操作,为后续问题排查提供依据。

注意事项

在实际操作过程中,有几个关键点需要特别注意:

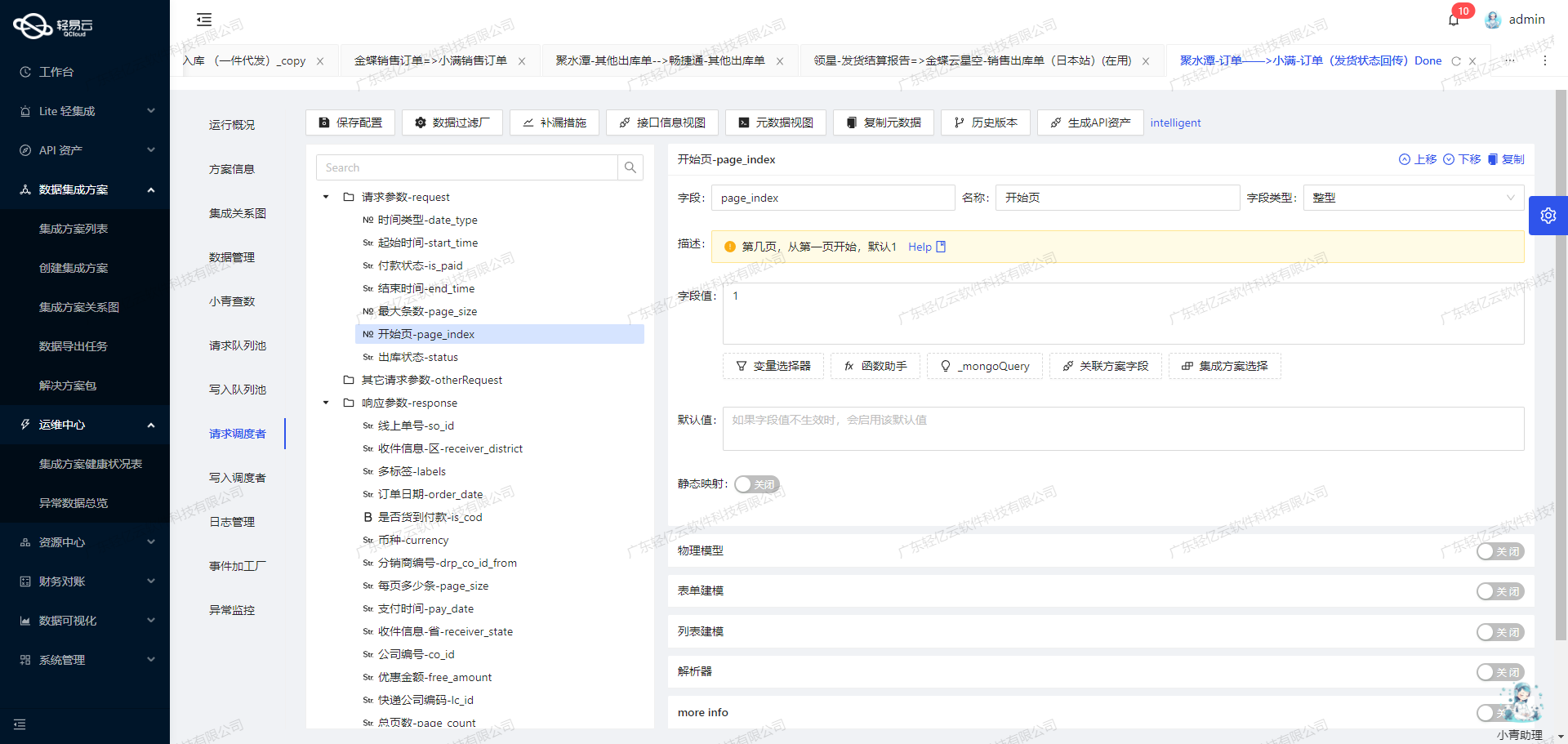

- 分页处理:对于返回结果较多的情况,需要实现分页处理,以避免单次请求过大导致超时或失败。

- 限流控制:根据班牛API文档中的限制,合理设置请求频率,避免触发限流机制。

- 错误重试机制:针对可能出现的网络波动或服务端错误,实现自动重试逻辑,提高任务成功率。

通过以上步骤,我们可以高效地调用班牛接口column.list获取并加工处理所需的数据,为后续的数据集成奠定坚实基础。

集成平台生命周期的第二步:ETL转换与写入班牛API接口

在数据集成过程中,将已经集成的源平台数据进行ETL转换是至关重要的一步。我们需要将这些数据转化为目标平台班牛API接口能够接收的格式,并最终写入班牛系统。本文将详细探讨这一过程中的关键技术和注意事项。

数据转换逻辑

首先,我们需要根据班牛API接口的要求,定义数据转换逻辑。以workflow.task.create接口为例,该接口通过POST请求创建新的工作任务。元数据配置如下:

{

"api": "workflow.task.create",

"effect": "EXECUTE",

"method": "POST",

"idCheck": true,

"request": [

{"field": "app_id", "label": "app_id", "type": "string", "value": "21151"},

{"field": "project_id", "label": "project_id", "type": "string", "value": "73625"},

{"field": "contents", "label": "contents", "type": "object",

"children": [

{"field": "1", "label": "1", "type": "string",

"value":"110529518"},

{"field":"3","label":"3","type":"string",

"value":"2023-05-03 19:10:22"},

{"field":"4","label":"4","type":"string",

"value":"2023-05-03 19:12:03"},

{"field":"5","label":"5","type":"string",

"value":"2"},

{"field":"73956","label":"73956","type":"string"}

]

}

]

}在这个配置中,我们需要确保源平台的数据字段与班牛API所需字段一一对应,并进行必要的格式转换。例如,日期格式、字符串类型等都需要根据API文档进行调整。

数据质量监控与异常处理

为了确保数据的准确性和完整性,必须实施严格的数据质量监控和异常处理机制。在数据转换过程中,可以利用轻易云提供的数据质量监控功能,实时检测并记录数据异常情况。例如,对于日期字段,可以设置规则检测其格式是否符合要求;对于必填字段,可以检查其是否为空。

在发现异常时,系统应立即触发告警并记录日志,以便后续分析和处理。同时,可以实现错误重试机制,对于暂时性错误(如网络问题),系统可以自动重试一定次数,以提高成功率。

批量数据处理与分页限流

在面对大规模数据集成时,批量处理和分页限流是两个关键技术。为了避免单次请求的数据量过大导致超时或失败,可以将数据分批次进行处理,每批次包含适量的数据量。同时,针对班牛API的限流策略,需要合理设计请求频率,以防止触发API限流机制。

例如,在调用workflow.task.create接口时,可以将待创建的任务按项目ID分批,每批次包含一定数量的任务,然后逐批发送请求。在每次请求之间,可以设置适当的延迟,以避免触发限流。

实时监控与日志记录

为了全面掌握数据集成过程中的状态和性能,实时监控与日志记录是必不可少的。通过轻易云提供的集中监控系统,可以实时跟踪每个集成任务的执行状态、处理时间、成功率等关键指标。同时,通过详细的日志记录,可以追溯每个步骤中的操作细节,有助于快速定位和解决问题。

自定义数据映射与定制化需求

在实际业务场景中,不同企业可能有不同的数据结构和业务需求。因此,自定义数据映射功能显得尤为重要。通过轻易云提供的可视化数据流设计工具,可以灵活定义和调整数据映射规则,以适应特定业务需求。例如,可以根据业务逻辑对某些字段进行计算或合并,再将结果写入班牛系统。

综上所述,将已经集成的源平台数据进行ETL转换,并转为目标平台班牛API接口所能接收的格式,是一个复杂而关键的过程。通过合理设计转换逻辑、实施严格的数据质量监控、采用批量处理与分页限流策略、实时监控与日志记录,以及灵活自定义数据映射规则,可以有效提升数据集成效率和准确性,确保业务流程顺畅运行。