吉客云采购入库对接MySQL的技术集成案例

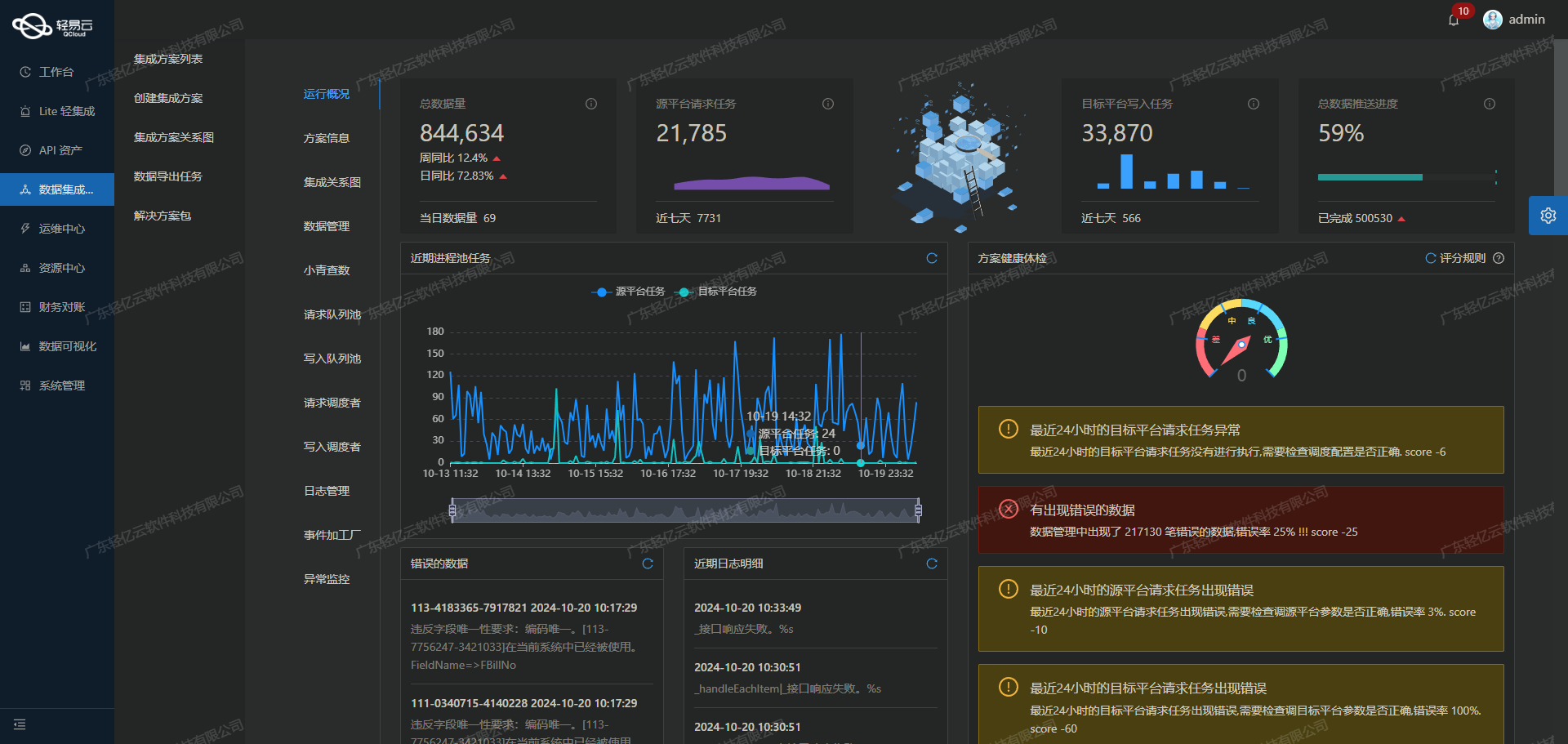

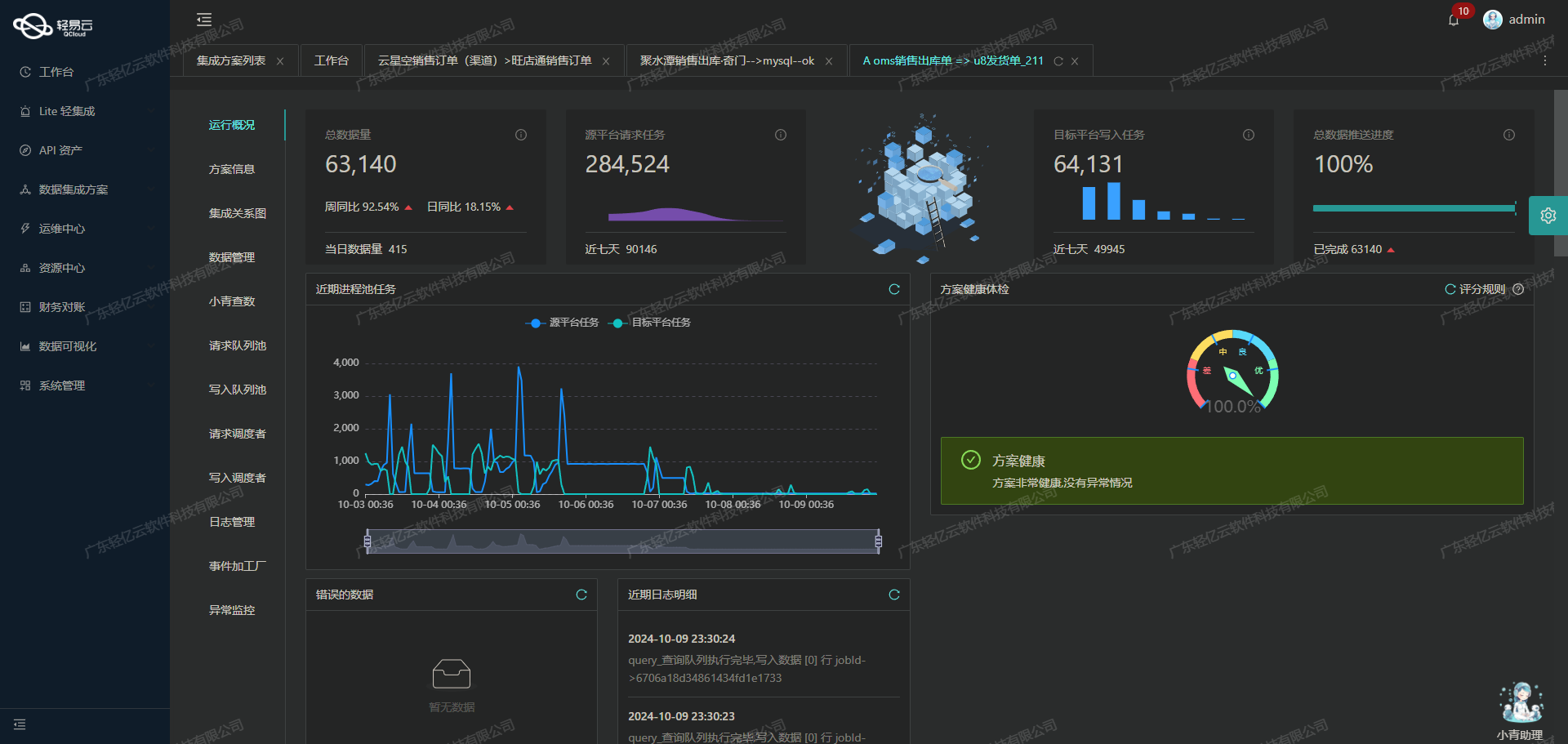

在现代企业的数据管理中,如何高效地实现不同系统之间的数据集成是一个关键挑战。本文将聚焦于吉客云采购入库数据与MySQL数据库的对接集成方案,通过轻易云数据集成平台的强大功能,实现了这一复杂任务的简化和优化。

首先,吉客云提供了丰富的API接口,其中erp.storage.goodsdocin用于获取采购入库数据。这些数据需要被可靠地抓取并批量写入到MySQL数据库中,以确保业务流程的连续性和准确性。在此过程中,高吞吐量的数据写入能力显得尤为重要,它使得大量数据能够快速进入MySQL系统,从而提升整体处理效率。

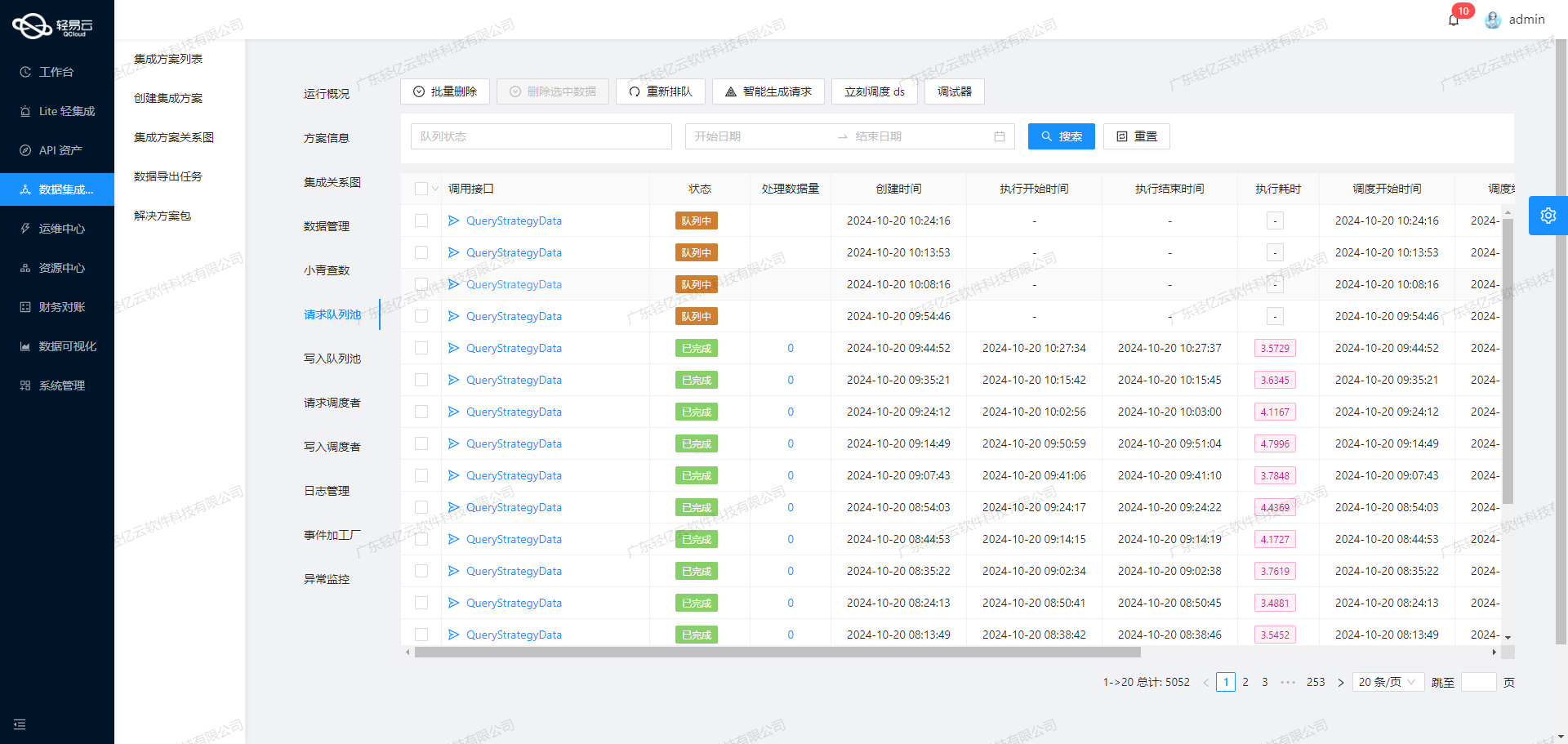

此外,为了保证数据质量和系统稳定性,集成方案中还采用了集中监控和告警系统。该系统实时跟踪数据集成任务的状态和性能,及时发现异常情况并进行处理。同时,通过自定义的数据转换逻辑,我们能够适应特定业务需求,对吉客云与MySQL之间的数据格式差异进行有效处理。

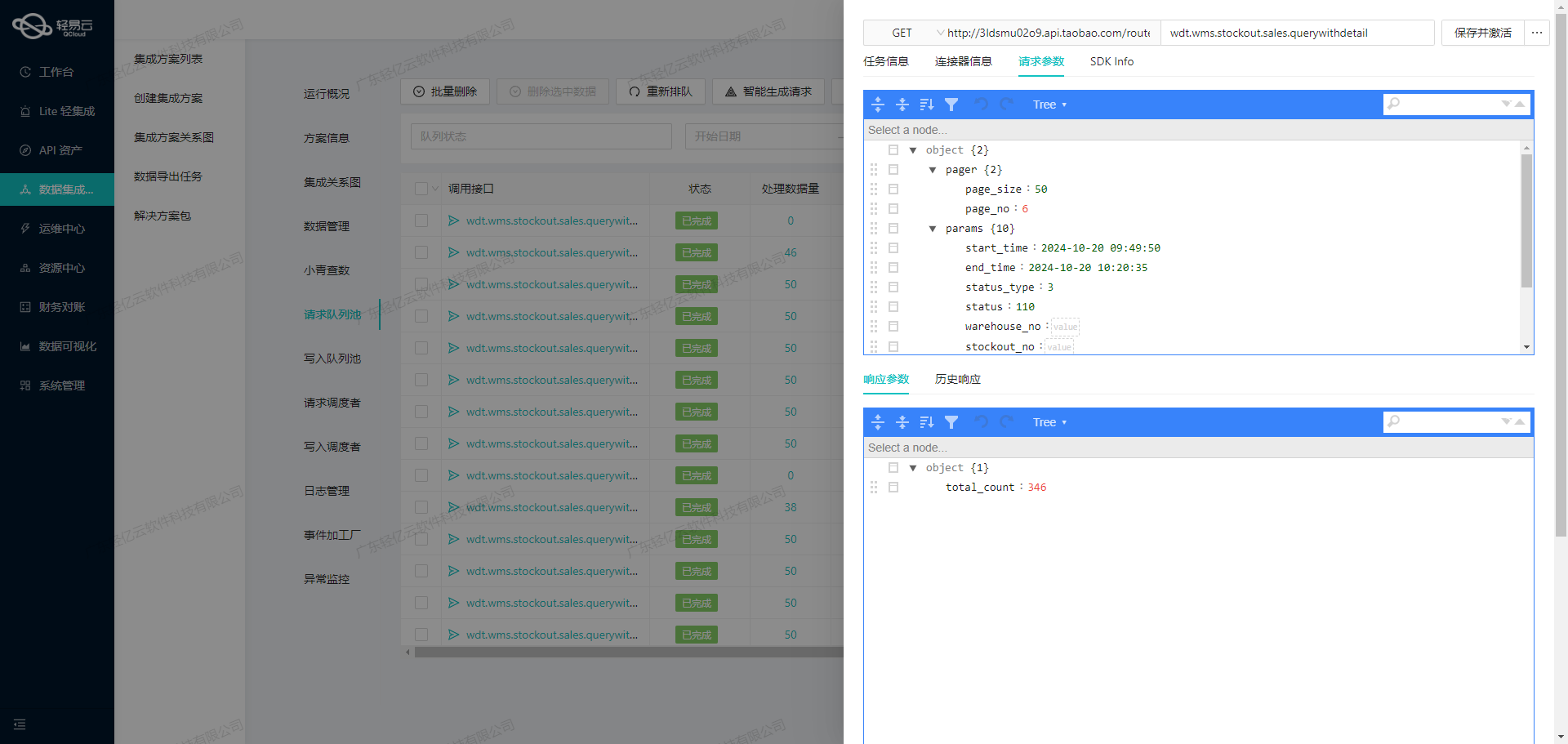

在具体实施过程中,还需特别注意分页和限流问题,这对于调用吉客云接口时至关重要。通过合理设计,可以避免因过多请求导致的性能瓶颈。此外,针对可能出现的对接异常,我们建立了错误重试机制,以确保数据不漏单,并实现可靠的数据传输。

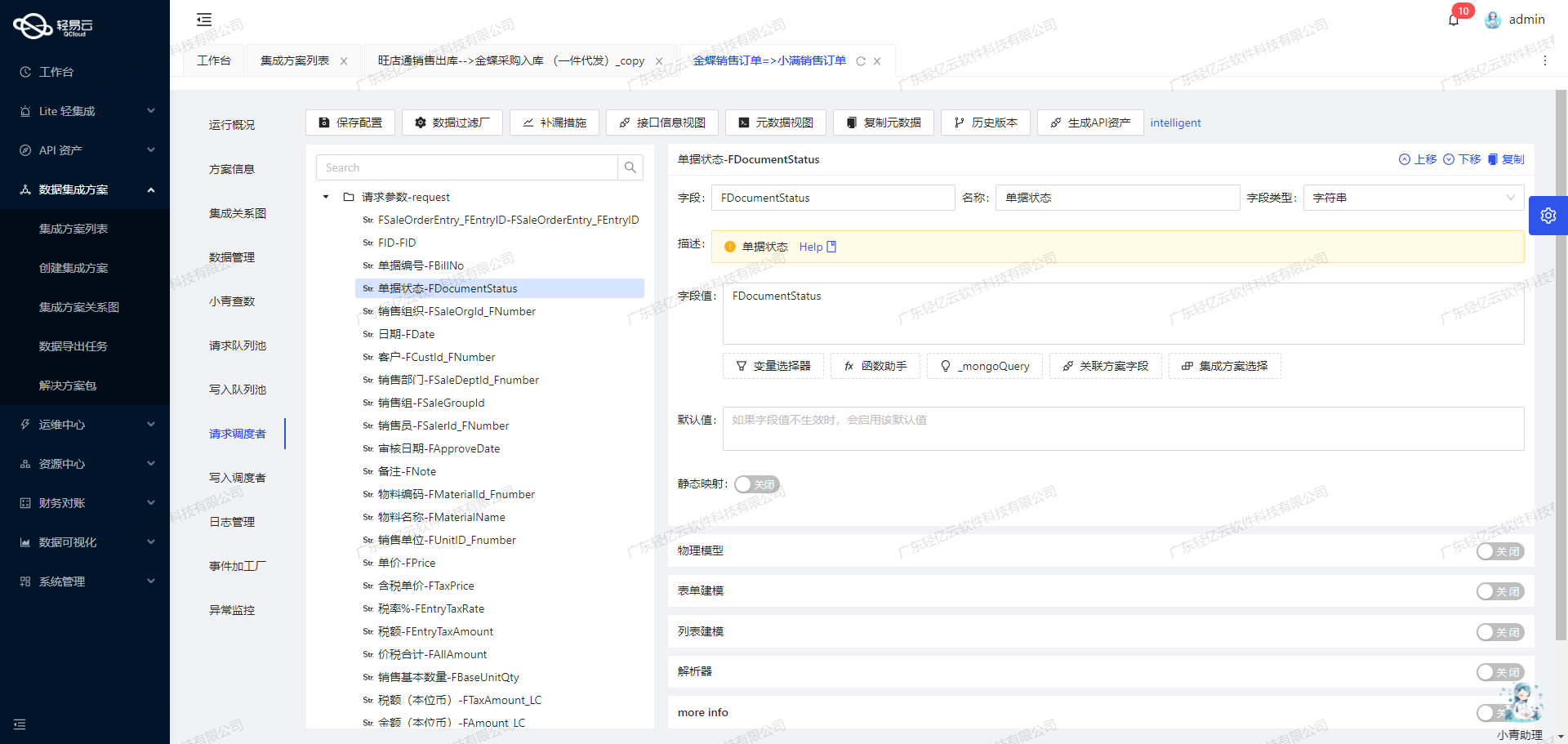

最后,通过可视化的数据流设计工具,我们可以直观地管理整个集成过程,使得复杂的数据流动变得清晰易懂。这不仅提高了操作效率,也为后续维护提供了便利条件。

调用吉客云接口erp.storage.goodsdocin进行数据集成

在数据集成过程中,调用源系统的API接口是至关重要的一步。对于轻易云数据集成平台而言,生命周期的第一步就是通过调用吉客云的erp.storage.goodsdocin接口来获取采购入库相关的数据,并对其进行加工处理。

接口调用与请求配置

为了实现高效的数据抓取,我们需要配置请求参数以确保能够准确地获取所需数据。该接口采用POST方法进行调用,支持分页机制,以便于处理大量数据时避免性能瓶颈。分页参数包括pageIndex和pageSize,其中每页默认抓取20条记录,这样可以有效控制单次请求的数据量。

- 分页页码: pageIndex

- 分页页数: pageSize (默认值为20)此外,为了保证数据的完整性和时效性,我们设置了时间范围参数,通过函数动态生成起始和结束时间。这些参数确保我们能够定期、可靠地抓取最近三天内创建的入库单信息。

- 创建时间起始: startDate (动态计算过去三天开始时间)

- 创建时间结束: endDate (当前时间)数据过滤与类型识别

在实际应用中,不同类型的入库操作可能会影响后续的数据处理。因此,我们通过指定入库类型为采购入库(代码101)来过滤掉其他不相关的入库记录。这种精准的数据筛选有助于提高后续处理效率。

- 入库类型: inouttype = 101 (采购入库)同时,为了进一步细化数据选择,可以根据仓库ID、供应商ID等字段进行过滤。这些字段提供了灵活的查询条件,使得我们能够针对特定业务场景提取所需信息。

数据质量监控与异常处理

在数据集成过程中,确保数据质量是关键任务之一。轻易云平台支持实时监控和异常检测机制,可以及时发现并解决潜在问题。例如,在对接MySQL时,需要注意处理吉客云接口返回的数据格式差异,以及分页限流问题。这些技术挑战需要通过自定义转换逻辑和错误重试机制加以解决,以保证最终写入数据库的数据准确无误。

实现高效批量写入

一旦成功获取并清洗了吉客云接口的数据,下一步就是将这些信息快速写入到MySQL数据库中。轻易云平台具备高吞吐量能力,使得大量采购入库记录能够被迅速整合到企业内部系统中,实现资源优化配置。此外,通过可视化设计工具,可以直观管理整个数据流动过程,提高整体操作效率。

综上所述,通过精确配置请求参数、实施有效的数据筛选及监控机制,我们能够充分利用吉客云API接口,实现稳定、高效的数据集成。这不仅提升了业务透明度,也为企业决策提供了可靠依据。

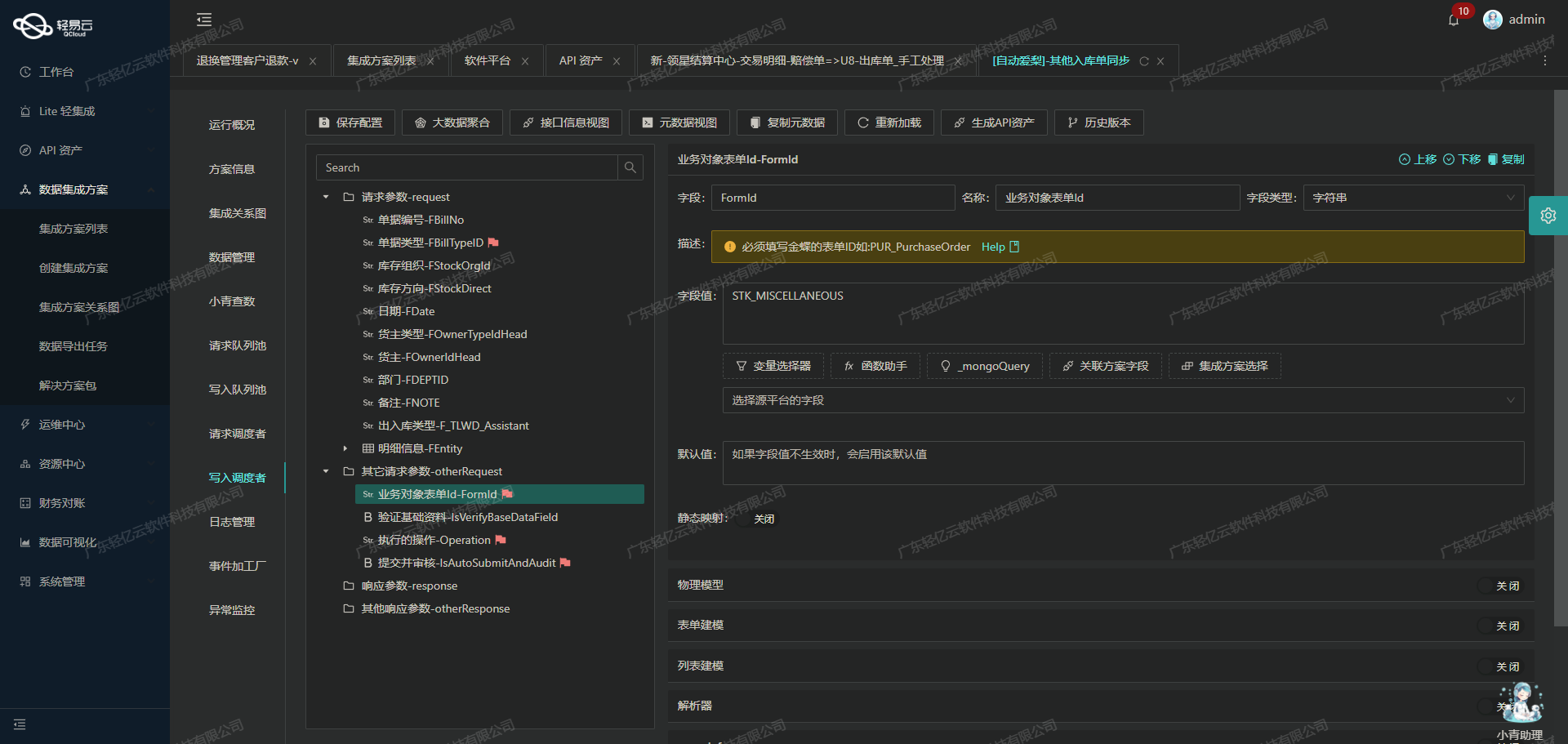

集成平台生命周期的第二步:ETL转换与MySQLAPI接口对接

在数据集成过程中,ETL(Extract, Transform, Load)转换是一个关键步骤,尤其是在将吉客云采购入库的数据对接到MySQL数据库时。通过轻易云数据集成平台,我们能够高效地实现这一过程,将源平台的数据提取、转换为目标格式,并可靠地写入到MySQL中。

数据提取与转换

在这个阶段,首先需要从吉客云接口中获取采购入库相关数据。为了确保数据的完整性和一致性,我们需处理分页和限流问题,通过定时任务定期抓取接口数据。使用配置的元数据,可以准确地映射吉客云的数据结构到我们需要的目标格式。

例如,对于日期字段,我们使用FROM_UNIXTIME函数将时间戳转换为MySQL所需的日期格式:

date: _function FROM_UNIXTIME( ( {inOutDate} / 1000 ) ,'%Y-%m-%d %T' )这种方式确保了日期时间数据能够被正确解析并存储。

数据写入与API对接

在完成数据转换后,接下来是将其写入到MySQL数据库。为此,我们利用MySQLAPI接口进行批量插入操作,以提高效率和吞吐量。元数据中的SQL语句配置指导了这一过程:

INSERT INTO `lehua`.`wh_purchase_in` (`bill_no`, `date`, ...) VALUES (<{bill_no: }>, <{date: CURRENT_TIMESTAMP}>, ...)这段配置展示了如何将经过转换后的字段值插入到目标表中。

在实际应用中,需特别注意MySQLAPI接口对接时的一些细节,例如异常处理和错误重试机制,以保证数据写入的可靠性。一旦出现错误,系统会自动重试指定次数,或发出告警以便人工介入。

扩展参数与详细信息

为了支持更复杂的数据结构,我们还可以利用扩展参数,将详细的物料信息一同写入关联表中。这部分通过extend_params_1实现,其中包括物料编码、仓库、实收数量等详细字段:

INSERT INTO `lehua`.`wh_purchase_in_detail` (`order_id`, `material_id`, ...) VALUES (<{lastInsertId: }>, <{material_id: }>, ...)这种设计确保了主表与明细表之间的关联,并提供了更全面的数据记录能力。

数据质量监控与优化

在整个ETL过程中,实时监控和日志记录是不可或缺的部分。通过集成平台提供的集中监控系统,我们可以实时跟踪每个任务的状态和性能,一旦发现异常情况,可及时进行处理。此外,自定义的数据转换逻辑允许我们根据业务需求灵活调整数据结构,以适应不同场景下的特定要求。

总之,通过精确配置元数据和合理设计ETL流程,我们能够有效地将吉客云采购入库的数据转化并存储到MySQL数据库中,实现不同系统间的数据无缝对接,为企业提供高效、可靠的数据集成解决方案。