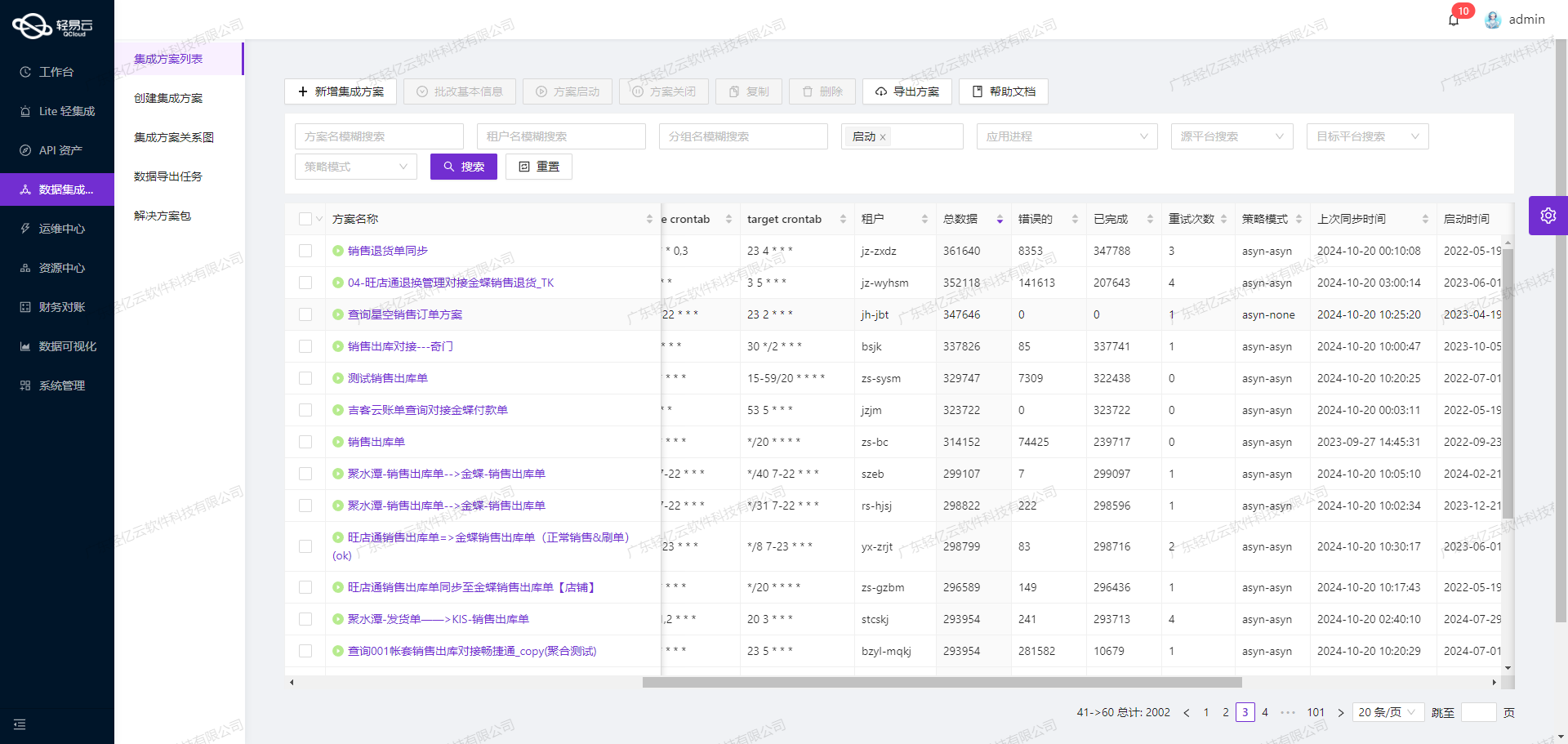

BDS班牛退换补发=> 吉客云退换补发:高效数据集成案例分享

在本次技术案例中,我们将探讨如何通过轻易云数据集成平台,将班牛系统中的退换补发数据无缝对接到吉客云平台。此方案不仅提升了数据处理的时效性,还确保了数据的准确性和完整性。

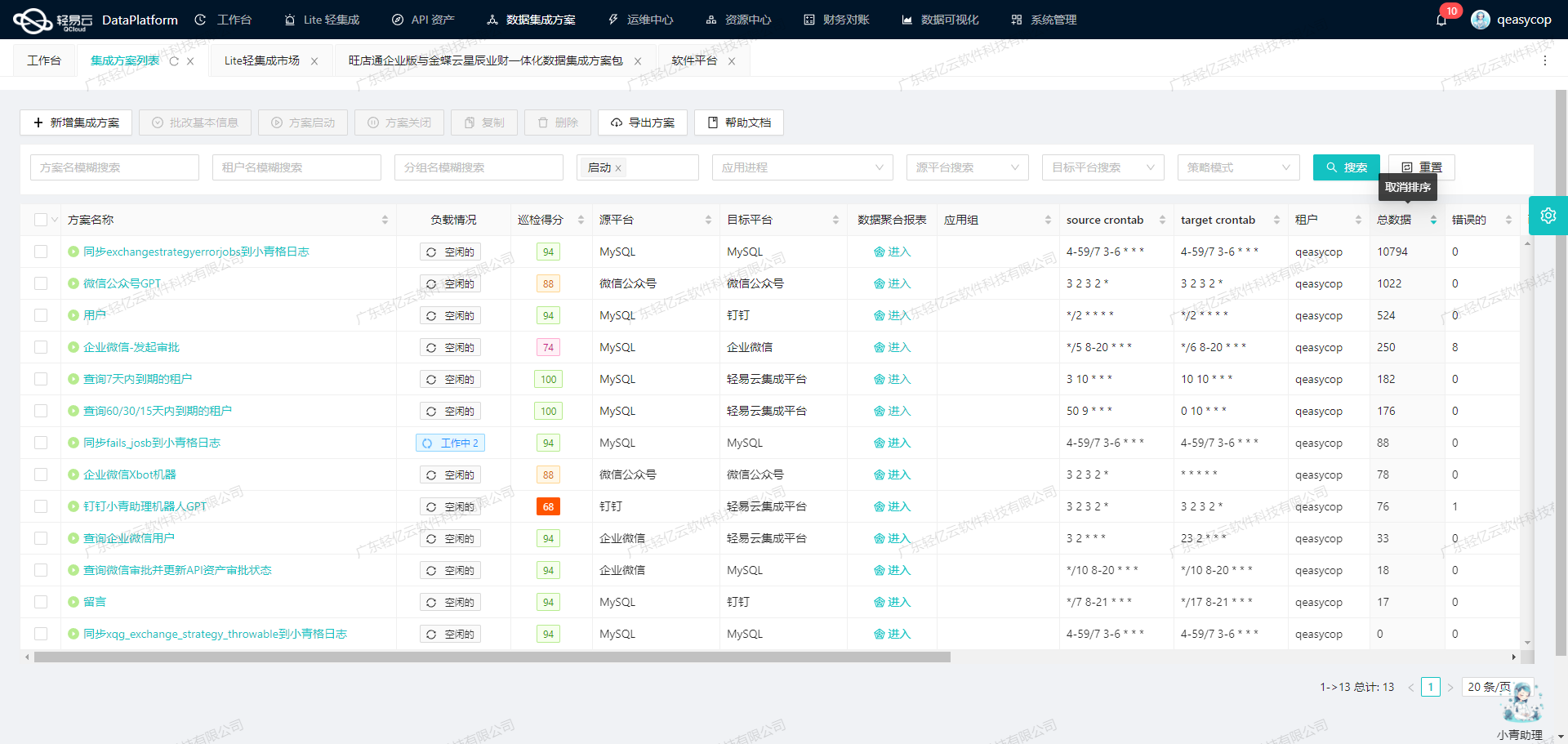

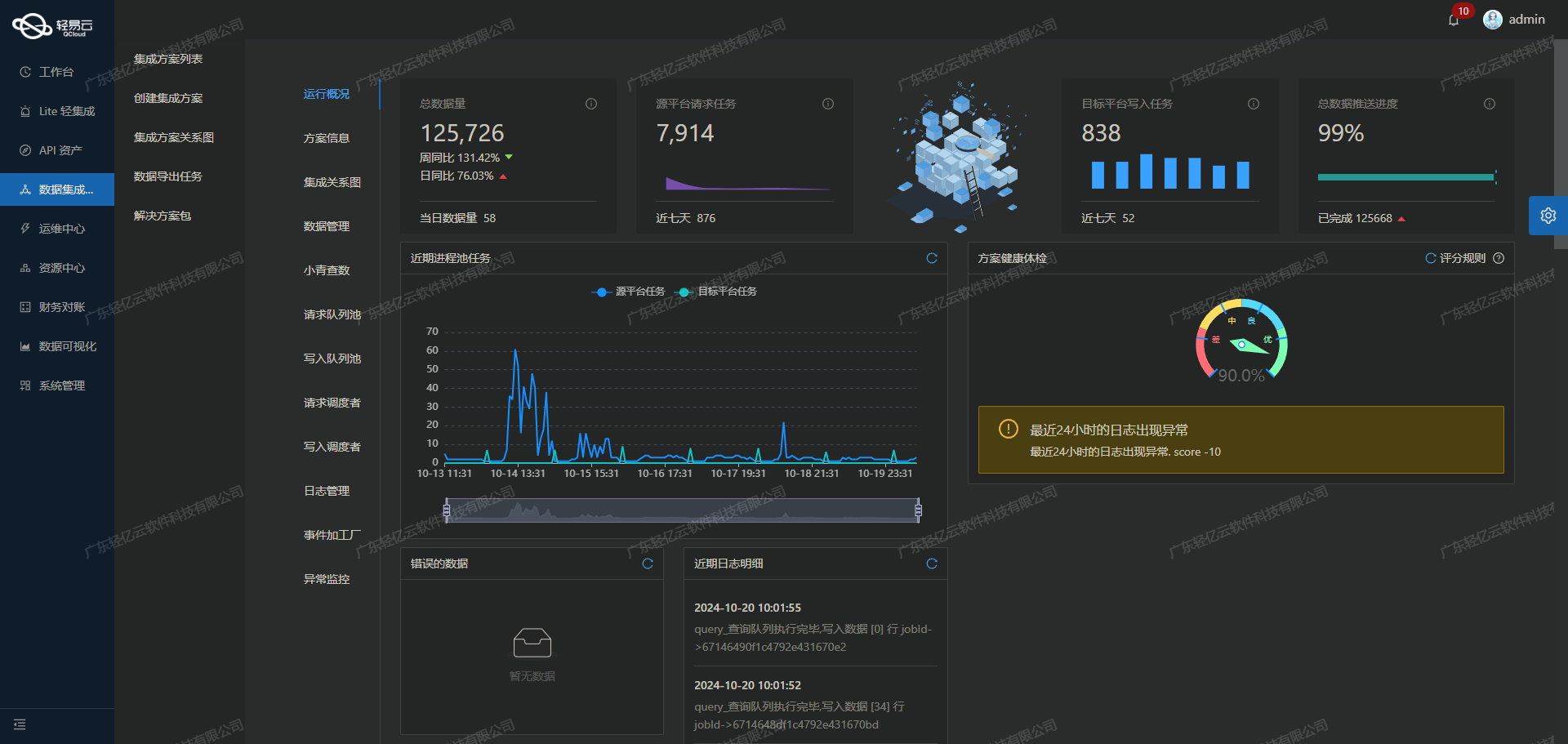

首先,班牛系统作为数据源平台,通过其API接口task.list提供了丰富的数据获取能力。为了实现高吞吐量的数据写入,我们利用轻易云平台的集中监控和告警系统,实时跟踪数据集成任务的状态和性能。这种机制不仅提高了业务透明度,还能及时发现并处理潜在问题。

在具体实施过程中,我们特别关注以下几个关键技术点:

- 定时可靠的数据抓取:通过定时任务,定期调用班牛接口

task.list,确保所有待处理的退换补发订单都能被及时抓取,不漏单。 - 批量数据集成:为了应对大量订单数据,我们设计了一套批量处理机制,将获取到的数据快速写入到吉客云目标平台中。

- 分页与限流处理:由于班牛接口存在分页和限流限制,我们采用了智能分页策略和限流控制,确保每次请求都能高效完成,同时避免触发API调用限制。

- 自定义数据转换逻辑:针对班牛与吉客云之间的数据格式差异,我们设计了灵活的自定义转换逻辑,以适应不同业务需求和数据结构。

- 异常处理与错误重试机制:在对接过程中,如果出现任何异常情况,例如网络故障或API调用失败,我们设置了完善的错误重试机制,确保最终所有数据都能成功写入吉客云。

通过上述技术手段,本方案不仅实现了高效、稳定的数据集成,还为企业提供了一套可视化、易管理的数据流设计工具,使得整个过程更加直观明了。在后续章节中,我们将详细介绍每个步骤的具体实现方法及注意事项。

调用班牛接口task.list获取并加工数据

在轻易云数据集成平台的生命周期中,第一步至关重要,即调用源系统班牛接口task.list以获取并加工数据。此步骤不仅是整个数据集成过程的起点,还决定了后续数据处理和写入的质量与效率。

接口调用配置

首先,我们需要明确如何正确配置和调用班牛接口task.list。以下是元数据配置中的关键参数:

- api:

task.list - method:

GET - request:

project_id: 群组ID,固定值为25821page_size: 每页记录数,固定值为50page_num: 页码,初始值为1star_created: 起始时间end_created: 结束时间task_status: 工单状态,固定值为2star_modified: 修改时间起始时间,动态计算过去24小时内的数据end_modified: 修改时间结束时间,为当前时间

这些参数确保我们能够准确地从班牛系统中提取所需的数据,并进行分页处理,以应对大规模数据集成需求。

数据请求与清洗

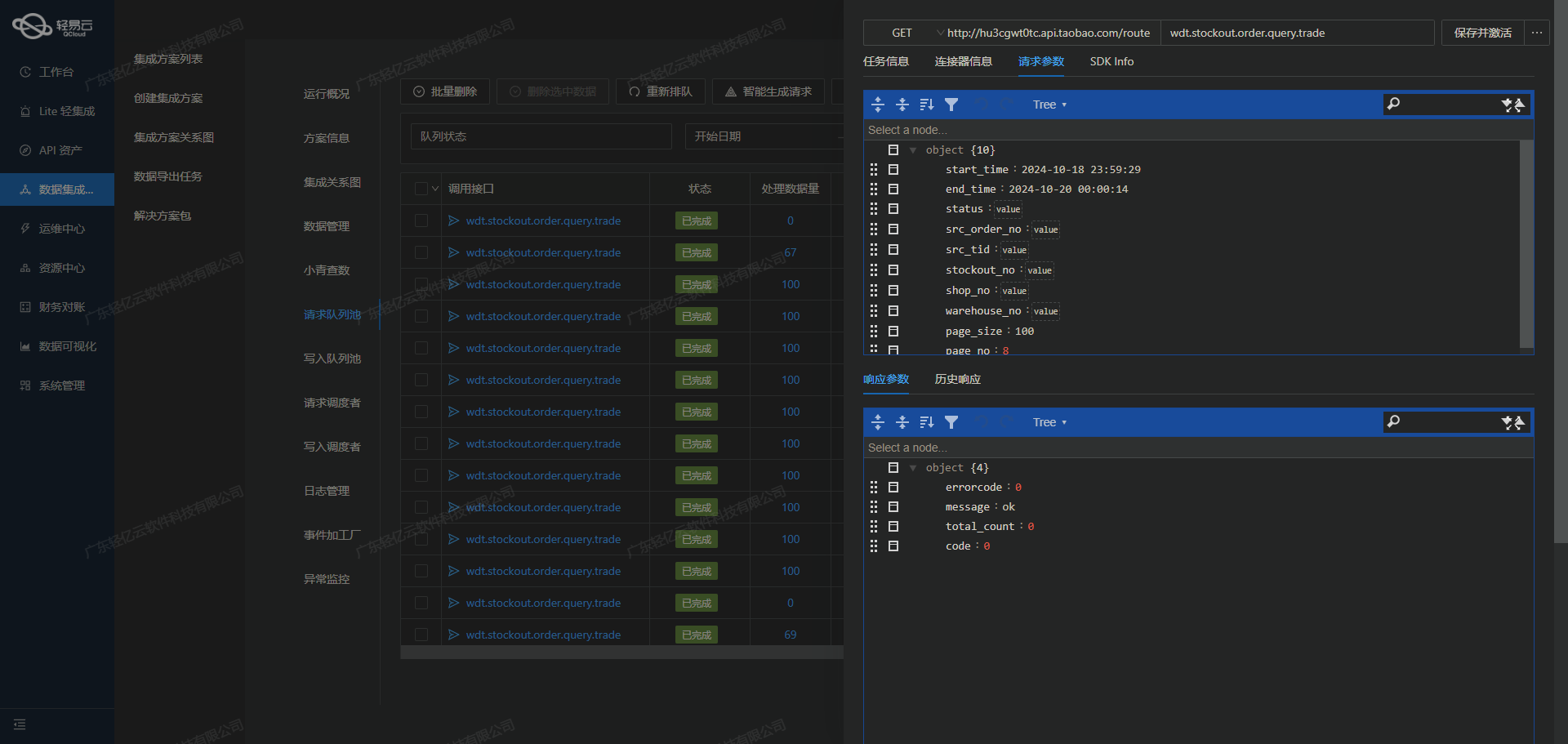

在实际操作中,我们会通过轻易云平台发起HTTP GET请求来调用上述API。为了保证高效的数据抓取和清洗,需要注意以下几点:

- 分页处理:由于每次请求只能返回有限数量的数据(如每页50条),我们需要实现分页逻辑,通过递增

page_num参数逐页获取所有符合条件的数据。 - 限流控制:考虑到API可能有访问频率限制,应设置适当的延时或重试机制,以避免触发限流策略。

- 动态时间窗口:使用动态计算的修改时间范围(如过去24小时)来确保抓取最新更新的数据。这可以通过函数

_function DATE_FORMAT(DATE_ADD(NOW(),INTERVAL - 24 HOUR),'%Y-%m-%d %H:%i:%s')实现。

数据转换与写入准备

在成功获取原始数据后,需要对其进行必要的清洗和转换,以适应目标系统吉客云的要求。具体包括:

- 字段映射与转换:根据吉客云的字段要求,对班牛返回的数据字段进行映射和格式转换。例如,将日期格式统一为ISO标准。

- 异常检测与处理:利用轻易云平台提供的数据质量监控功能,实时检测并处理异常数据,如缺失字段、格式错误等。

- 批量处理优化:为了提高效率,可以将多条记录打包成批量进行处理和写入,而不是逐条操作。

实时监控与日志记录

整个过程中,通过轻易云平台提供的集中监控和告警系统,可以实时跟踪任务状态和性能指标。一旦出现问题,如网络超时或数据不一致等,可以及时触发告警并采取相应措施。此外,详细的日志记录功能也有助于后续问题排查和性能优化。

总结

通过合理配置和调用班牛接口task.list,结合轻易云平台强大的数据清洗、转换及监控能力,我们能够高效、可靠地完成从班牛到吉客云的数据集成第一步。这不仅为后续的数据写入奠定了坚实基础,也极大提升了整体业务流程的透明度和效率。

数据ETL转换与写入吉客云的技术实现

在数据集成生命周期的第二步,我们需要将从源平台(如班牛)获取的数据进行ETL(Extract, Transform, Load)转换,使其符合目标平台吉客云API接口的要求,并最终写入到吉客云系统中。以下将详细探讨这一过程中的关键技术点和实现方法。

1. 数据抽取(Extract)

从班牛系统中抽取数据时,通常会使用其提供的API接口,例如task.list接口。这一步骤需要处理分页和限流问题,以确保数据完整性和系统稳定性。可以通过设定合理的分页大小和重试机制来应对这些挑战。

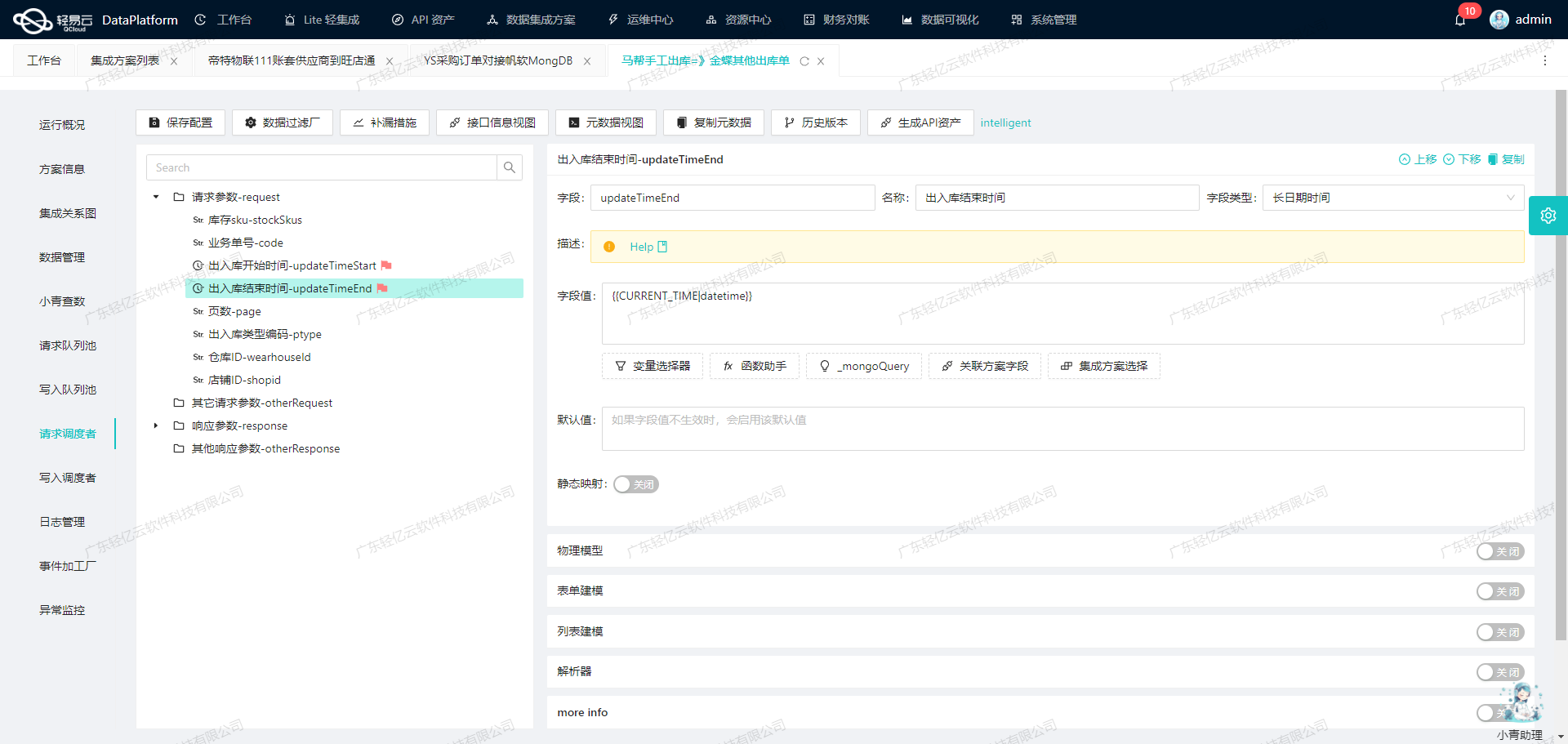

2. 数据转换(Transform)

在数据转换阶段,我们需要将从班牛系统中获取的数据转化为吉客云API所能接收的格式。这一过程中,元数据配置起到了至关重要的作用。以下是一些关键字段及其处理方式:

- 退换单号(returnChangeNo):直接从班牛系统中获取。

- 系统订单编号(tradeNo):通过映射规则,将班牛订单编号转化为吉客云所需格式。

- 销售渠道名称(shopName):使用MongoDB查询,根据提供的options_id获取对应的渠道名称。

- 物流公司(logisticName):同样使用MongoDB查询,根据options_id获取物流公司名称。

- 客户信息处理:例如客户名称、收货人、手机等字段,使用字符串处理函数

substring_index提取相关信息。

{

"field": "customerName",

"value": "_function substring_index( '{{38001}}' , ',' , 1)"

}上述配置示例展示了如何通过字符串处理函数提取客户名称。

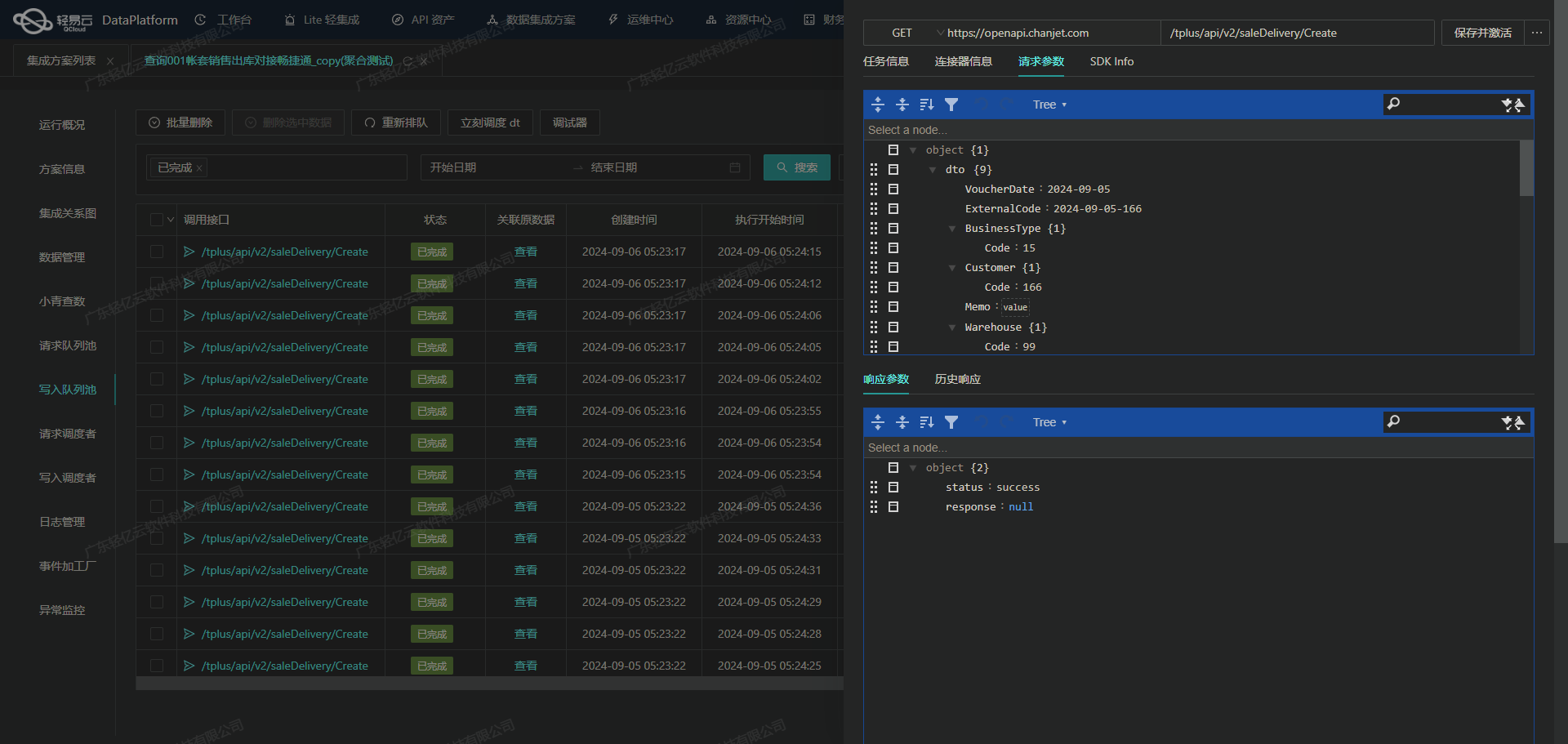

3. 数据加载(Load)

在完成数据转换后,需要将数据加载到吉客云。此时,我们需要调用吉客云的API接口,例如ass-business.returnchange.create,并以POST方法提交转换后的数据。

为了确保高效的数据加载,可以利用轻易云平台支持的大量数据快速写入能力。在实际操作中,通过批量处理和并发请求来提升数据写入效率。

4. 异常处理与错误重试机制

在数据加载过程中,可能会遇到各种异常情况,如网络问题、API限流等。为此,需要设计可靠的异常处理与错误重试机制。例如,在检测到网络超时或API返回错误码时,可以设置重试次数和间隔时间,以确保最终成功将数据写入目标平台。

5. 实时监控与日志记录

为了确保整个ETL过程的顺利进行,需要对每一步骤进行实时监控,并记录详细日志。这不仅有助于及时发现并解决问题,还能为后续优化提供有价值的数据支持。轻易云平台提供了集中的监控和告警系统,可以实时跟踪任务状态和性能指标。

示例:退换补发单新增

以下是一个简化后的元数据配置示例,展示了如何将班牛退换补发单的数据转换并写入吉客云:

{

"api": "ass-business.returnchange.create",

"method": "POST",

"request": [

{

"field": "returnChange",

"children": [

{"field": "returnChangeNo", "type": "string"},

{"field": "tradeNo", "type": "string", "value": "{{80981}}"},

{"field": "shopName", "type": "string",

"value":"_mongoQuery c5097f70-e562-3216-a453-a6e43d360c3c findField=content.options_title where={\"content.options_id\":{\"$eq\":\"{{26388}}\"}}"}

]

}

],

"effect": "EXECUTE"

}该配置说明了如何通过MongoDB查询获取销售渠道名称,并将其与其他字段一起构建请求体,最终调用吉客云API接口完成退换补发单新增操作。

总结

通过上述步骤,我们能够有效地实现从班牛到吉客云的数据ETL转换和加载。在这一过程中,合理利用元数据配置、异常处理机制以及实时监控手段,可以大幅提升数据集成的效率和可靠性。