MySQL数据集成案例分享:user-获取MOM用户信息-新增_修改

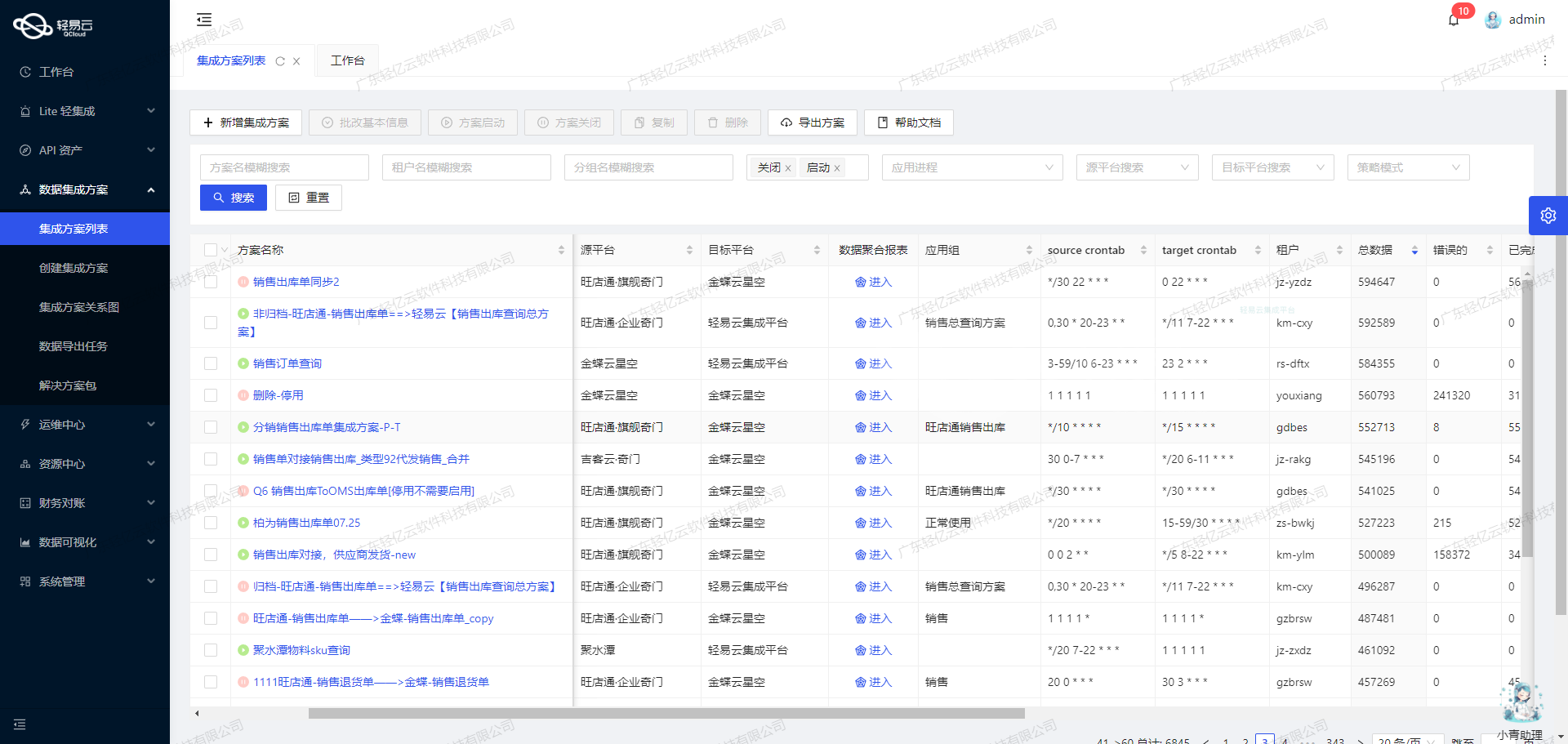

在本技术案例中,我们将深入探讨如何通过轻易云平台实现MySQL到MySQL的数据对接,具体场景是从一个MySQL数据库获取MOM用户信息并将其新增或修改到另一个MySQL数据库中。该操作方案命名为user-获取MOM用户信息-新增_修改。

首先,这个集成任务需要确保数据的高可靠性和一致性,为此我们采用了select API进行数据抓取,并通过execute API完成数据写入。为了解决大规模数据处理的问题,系统支持高吞吐量的数据写入能力,从而保证大量的用户信息能够快速、准确地被同步到目标数据库。

除了基本的数据传输功能外,该方案还具备以下几个关键技术特性:

-

实时监控与告警:

- 通过集中化的监控系统,我们可以实时跟踪每个数据集成任务的状态和性能。一旦发生异常情况,系统会立即发出告警,以便及时排查和解决问题。

-

自定义转换逻辑:

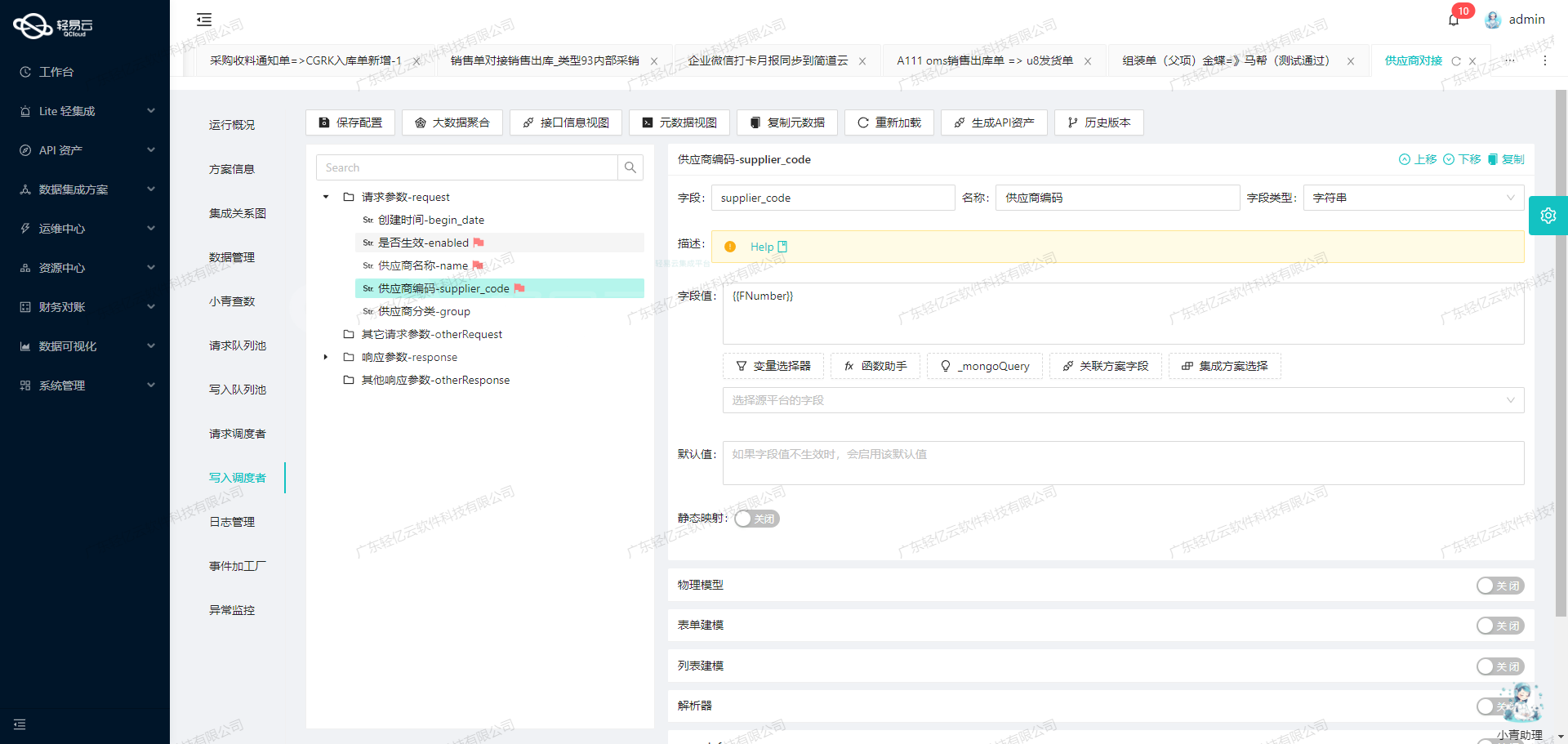

- 在实际应用中,不同业务模块可能有不同的数据格式要求。使用轻易云的平台,我们可以灵活设置自定义的数据转换逻辑,以满足特定业务需求。例如,在MOM用户信息字段匹配时,可以根据需求调整字段映射规则,确保双方数据库的一致性。

-

批量处理与优化配置:

- 为提升效率,该方案支持批量集成功能,将多条记录打包后一同处理。这不仅提高了处理速度,还减少了网络通信开销。此外,通过统一视图管理API资产,可以更好地优化资源配置,实现智能化调度。

-

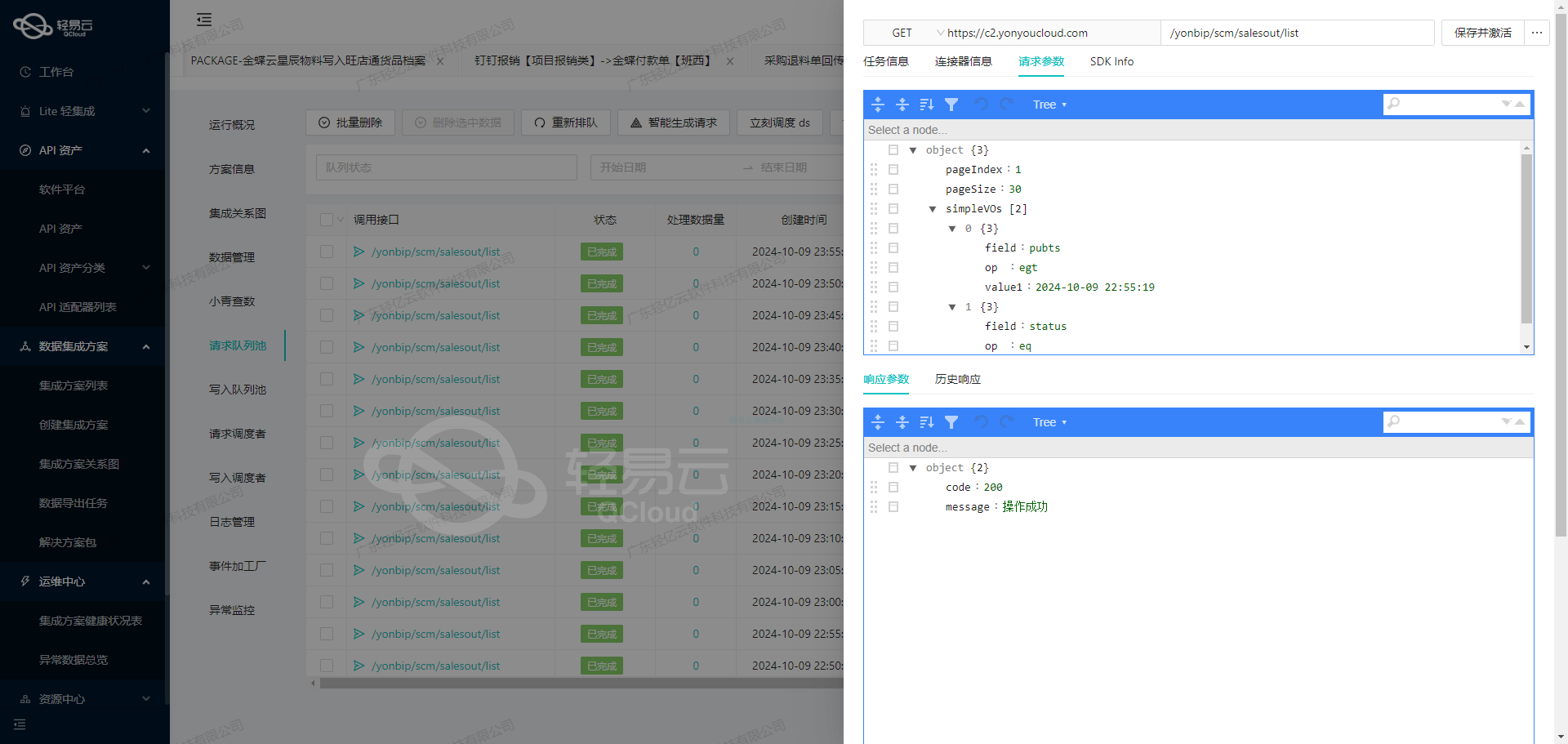

错误重试机制与异常处理:

- 数据对接过程中难免会遇到各种异常,如暂时性的网络故障或目标服务器未响应等。为了保持任务的稳定运行,我们制定了一套完善的错误重试机制,当一次传输失败后会自动重新尝试多次直至成功,大幅降低因单点故障导致整体任务失败的概率。

在后续内容中,我们将详细介绍如何实施上述方案,包括具体API调用示例、参数配置以及全生命周期管理策略等。

调用MySQL接口获取并加工数据

在数据集成的生命周期中,第一步是从源系统获取数据。本文将详细探讨如何通过轻易云数据集成平台调用MySQL接口select来获取并加工数据。

元数据配置解析

元数据配置是实现数据请求与清洗的关键。以下是我们使用的元数据配置:

{

"api": "select",

"effect": "QUERY",

"method": "POST",

"number": "real_name",

"id": "login_name",

"request": [

{

"field": "main_params",

"label": "主参数",

"type": "object",

"describe": "对应其它请求字段内SQL语句的主参数,必须一一对应。",

"value": "1",

"children": [

{

"field": "limit",

"label": "限制结果集返回的行数",

"type": "int",

"describe": "必要的参数!LIMIT 子句用于限制查询结果返回的行数。它指定了查询应该返回的最大行数。例如,LIMIT 10 表示查询结果只包含最多 10 行数据。这对于分页查询非常有用,可以在每次查询中返回一定数量的结果。",

"value": 2000

},

{

"field": "offset",

"label": "偏移量",

"type": "int",

"describe": "OFFSET 子句用于指定查询结果的起始位置或偏移量。它表示查询应该从结果集的哪一行开始返回数据。例如,OFFSET 20 表示查询应该从结果集的第 21 行开始返回数据。结合 LIMIT 子句使用时,OFFSET 指定了查询结果的起始行数。"

}

]

}

],

...

}主SQL语句解析

主SQL语句如下:

select a.login_name, a.real_name, a.phone, a.is_enabled, a.is_locked, a.attribute1,

if(b.role_id = 42, 1, 0) as isSupplier

from hzero_platform.iam_user a

left join hzero_platform.iam_member_role b on a.id = b.member_id and b.role_id = 42

where a.organization_id=7

limit :limit offset :offset该SQL语句主要用于从hzero_platform.iam_user表中获取用户信息,并通过左连接hzero_platform.iam_member_role表来判断用户是否为供应商(role_id=42)。

参数绑定与优化

为了确保动态语法字段与请求参数一一对应,我们采用参数绑定的方法:

- 将主SQL查询语句中的动态字段

:limit和:offset替换为占位符(例如?)。 - 在执行查询之前,使用参数绑定的方法,将请求参数的值与占位符进行对应绑定。

优化后的SQL语句如下:

select a.login_name, a.real_name, a.phone, a.is_enabled, a.is_locked, a.attribute1,

if(b.role_id = 42, 1, 0) as isSupplier

from hzero_platform.iam_user a

left join hzero_platform.iam_member_role b on a.id = b.member_id and b.role_id = 42

where a.organization_id=7

limit ? offset ?在执行时,通过代码将具体的limit和offset值绑定到占位符上。

实际调用示例

假设我们需要获取第21到第40条记录(每页20条),可以这样设置请求参数:

{

...

"main_params": {

...

"limit": 20,

...

"offset": 20

...

}

}然后通过POST方法调用API接口:

POST /api/select HTTP/1.1

Host: example.com

Content-Type: application/json

{

...

// 请求体内容,包括上述main_params等信息

}这样,我们就能成功获取分页后的用户信息,并且可以根据业务需求进一步加工处理这些数据。

数据清洗与转换

在获取到原始数据后,下一步是对其进行清洗和转换。比如,我们可以根据业务规则对某些字段进行格式化处理,或者过滤掉不需要的数据。这一步骤通常涉及复杂的数据处理逻辑,可以借助轻易云平台提供的数据处理工具来实现。

通过以上步骤,我们完成了从MySQL源系统获取并初步加工数据,为后续的数据转换与写入打下了坚实基础。在实际应用中,这种方式不仅提高了查询效率,还确保了数据的一致性和安全性。

使用轻易云数据集成平台进行ETL转换并写入MySQL API接口

在数据集成生命周期的第二步,我们需要将已经集成的源平台数据进行ETL(Extract, Transform, Load)转换,并将其转为目标平台 MySQL API 接口所能够接收的格式,最终写入目标平台。以下将详细探讨这一过程中的技术细节和实现方法。

元数据配置解析

在进行ETL转换之前,首先需要理解元数据配置。以下是一个典型的元数据配置示例:

{

"api": "execute",

"effect": "EXECUTE",

"method": "POST",

"idCheck": true,

"request": [

{

"field": "main_params",

"label": "main_params",

"type": "object",

"describe": "111",

"value": "1",

"children": [

{"field": "login_name", "label": "login_name", "type": "string", "value": "{login_name}"},

{"field": "real_name", "label": "real_name", "type": "string", "value": "{real_name}"},

{"field": "phone", "label": "phone", "type": "string", "value": "{phone}"},

{"field": "is_enabled", "label": "is_enabled", "type":"string","value":"{is_enabled}"},

{"field":"is_locked","label":"is_locked","type":"string","value":"{is_locked}"},

{"field":"attribute1","label":"attribute1","type":"string","value":"{attribute1}"},

{"field":"isSupplier","label":"isSupplier","type":"string","value":"{isSupplier}"}

]

}

],

...

}该配置文件定义了如何将源数据映射到目标API接口所需的字段。每个字段都有明确的类型和标签,确保数据在转换过程中不会出错。

数据请求与清洗

在开始ETL过程之前,首先需要从源系统获取原始数据并进行清洗。假设我们已经完成了这一阶段,现在我们有一组清洗后的用户信息数据,如下所示:

{

"login_name": ["user1", ...],

...

}数据转换与写入

接下来,我们需要将这些清洗后的数据按照目标API接口的要求进行转换,并通过POST请求写入MySQL数据库。

构建请求体

根据元数据配置,我们构建请求体:

{

'main_params': {

'login_name': 'user1',

'real_name': 'User One',

'phone': '1234567890',

'is_enabled': 'Y',

'is_locked': 'N',

'attribute1': 'Value1',

'isSupplier': 'N'

}

}SQL语句生成

根据元数据配置中的 main_sql 字段,我们生成相应的SQL语句:

INSERT INTO mom_user (login_name, real_name, phone, is_enabled, is_locked, attribute1, isSupplier)

VALUES (:login_name, :real_name, :phone, :is_enabled, :is_locked, :attribute1, :isSupplier)

ON DUPLICATE KEY UPDATE

real_name = VALUES(real_name),

phone = VALUES(phone),

is_enabled = VALUES(is_enabled),

is_locked = VALUES(is_locked),

attribute1 = VALUES(attribute1),

isSupplier = VALUES(isSupplier);执行POST请求

最后,通过POST方法将构建好的请求体发送到目标API接口:

import requests

url = "<MySQL_API_Endpoint>"

headers = {'Content-Type': 'application/json'}

data = {

...

}

response = requests.post(url, json=data, headers=headers)

if response.status_code == 200:

print("Data successfully written to MySQL.")

else:

print(f"Failed to write data: {response.text}")通过上述步骤,我们完成了从源平台获取数据、进行ETL转换并最终写入目标MySQL数据库的全过程。这一过程充分利用了轻易云数据集成平台提供的全异步、多种异构系统集成能力,实现了高效的数据处理和无缝对接。