易仓数据集成到金蝶云星空:TF调拨单-直接调拨单(调入调拨仓)方案解析

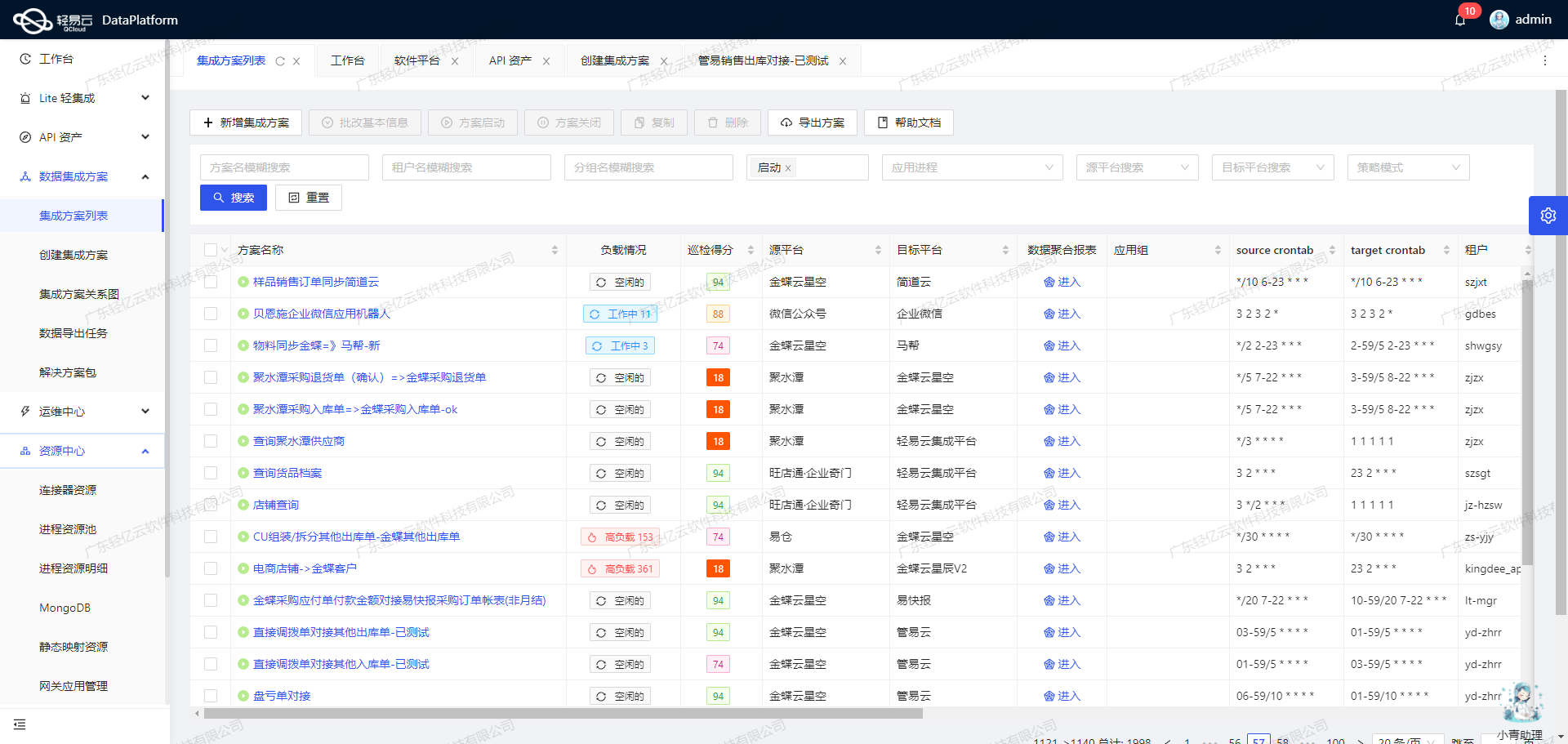

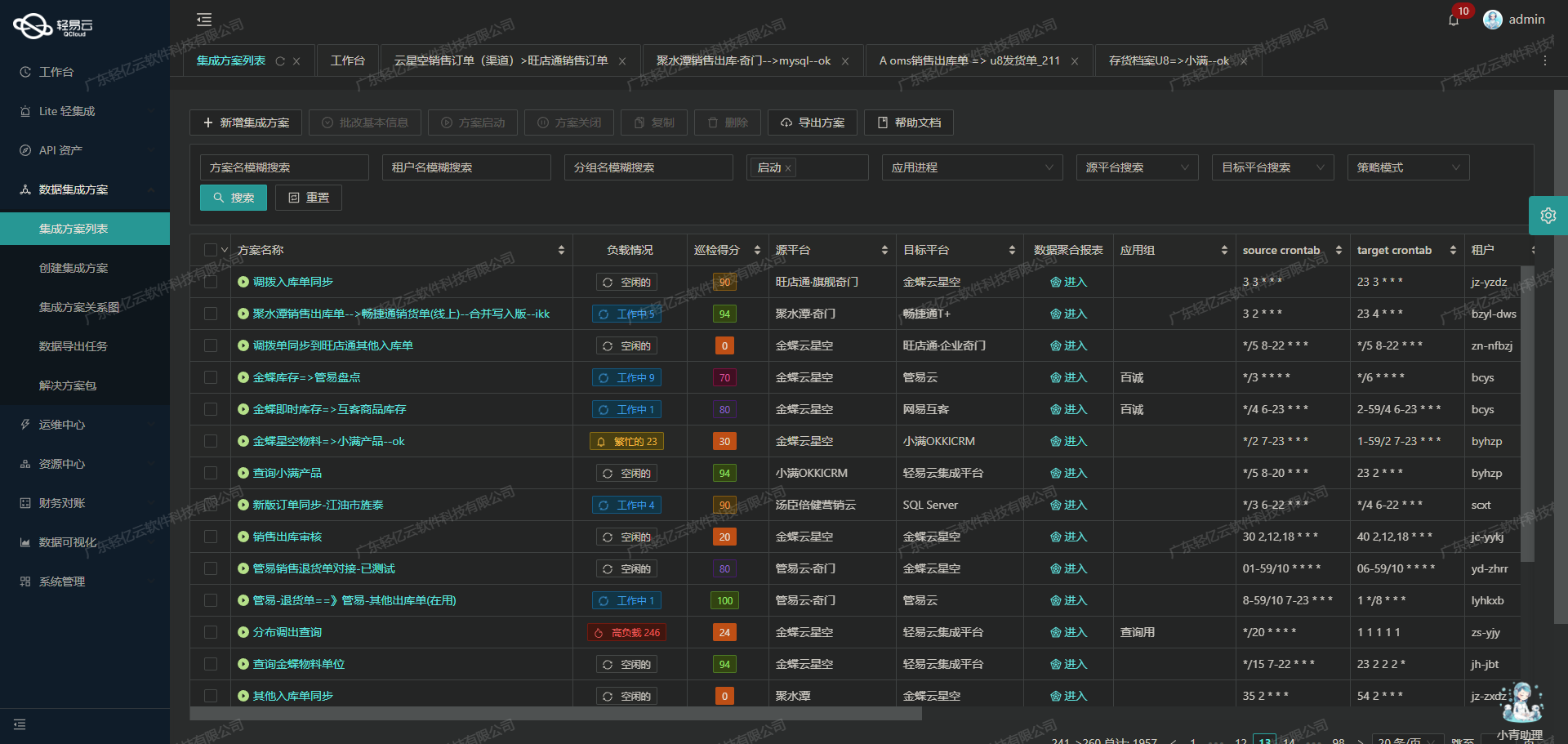

在企业的供应链管理中,数据的高效流转和准确对接至关重要。本文将聚焦于一个具体的系统对接集成案例,即如何将易仓的数据无缝集成到金蝶云星空平台中,特别是针对TF调拨单-直接调拨单(调入调拨仓)的处理。

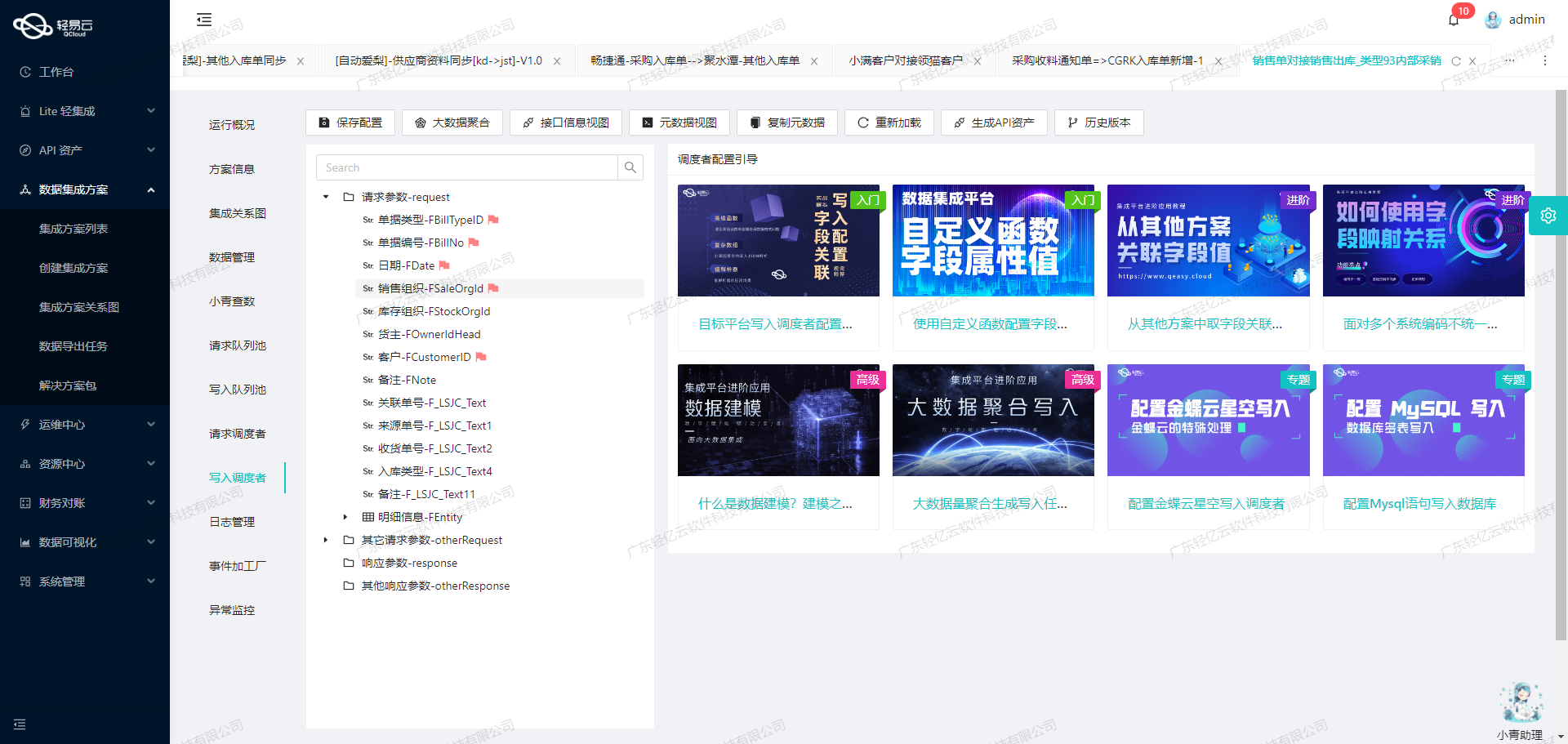

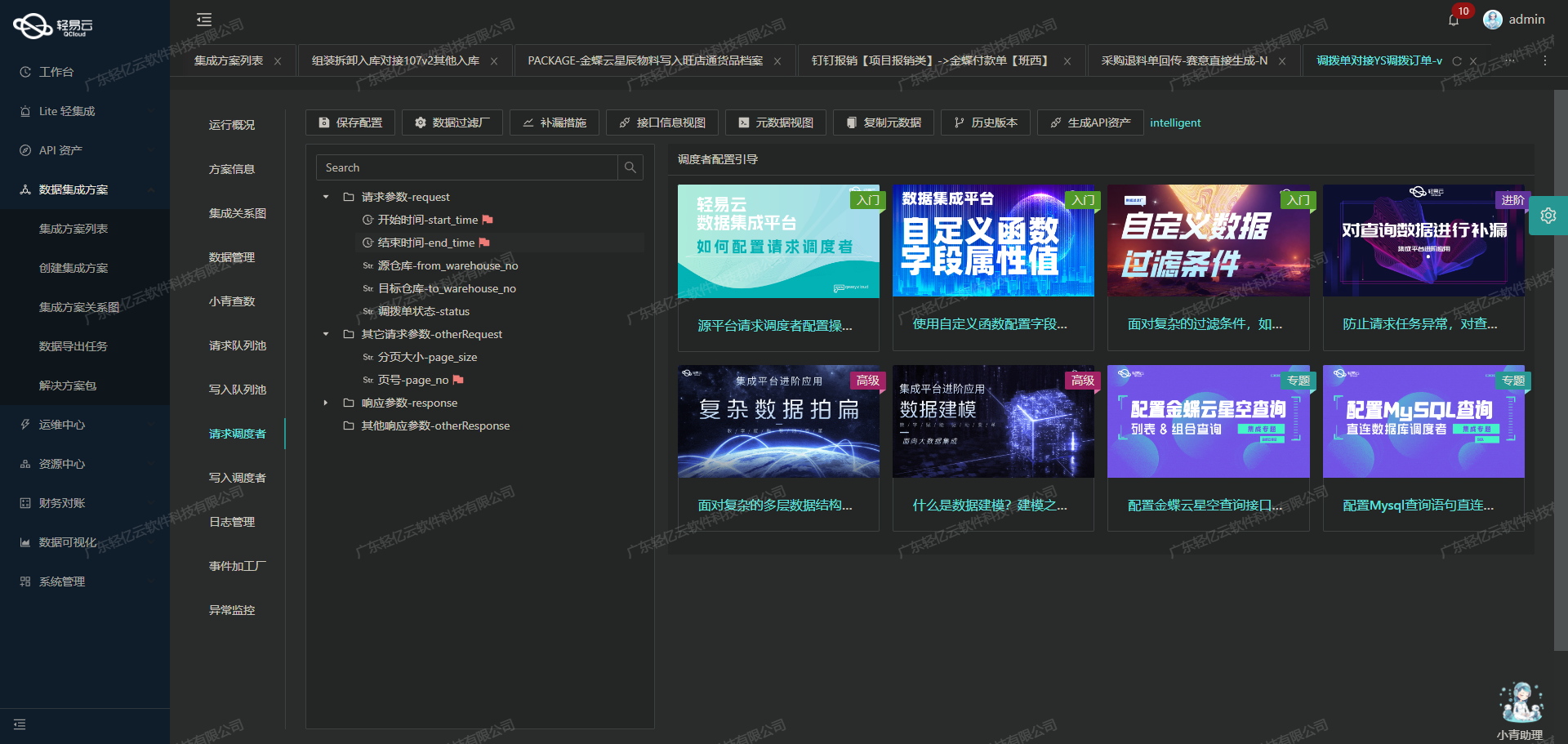

为了实现这一目标,我们利用了轻易云数据集成平台强大的功能特性。首先,通过调用易仓的getTransferOrders API接口,我们能够定时可靠地抓取所需的数据。这一过程不仅确保了数据获取的及时性,还通过分页和限流机制有效避免了接口调用过载的问题。

在数据写入方面,金蝶云星空提供了batchSave API接口,使得大量数据能够快速批量写入目标系统。这种高吞吐量的数据写入能力极大提升了数据处理的效率,确保业务流程不受延误。此外,为了应对两者之间的数据格式差异,我们设计并实现了自定义的数据转换逻辑,以适应特定业务需求。

整个集成过程中,实时监控与日志记录功能发挥了关键作用。通过集中监控和告警系统,我们可以实时跟踪每个数据集成任务的状态和性能,及时发现并处理潜在问题,从而保证数据不漏单。同时,对于可能出现的异常情况,我们还建立了一套完善的错误重试机制,以确保数据传输的可靠性。

总之,通过这一系列技术手段,我们成功实现了易仓与金蝶云星空之间的数据无缝对接,为企业提供了一套高效、可靠的数据集成解决方案。

调用易仓接口getTransferOrders获取并加工数据

在轻易云数据集成平台的生命周期中,调用源系统接口是至关重要的一步。本文将深入探讨如何通过调用易仓接口getTransferOrders来获取调拨单数据,并进行必要的数据加工处理。

接口调用配置

首先,我们需要配置元数据以便正确调用getTransferOrders接口。以下是关键的元数据配置:

{

"api": "getTransferOrders",

"method": "POST",

"number": "toCode",

"id": "toCode",

"idCheck": true,

"request": [

{"field":"page","label":"页数","type":"string"},

{"field":"pageSize","label":"页码","type":"string"},

{"field":"status","label":"调拨单状态","type":"string","value":"4"},

{"field":"rollbackFlag","label":"退回标志","type":"string"},

{"field":"warehouseReceipt","label":"目的仓收货","type":"string"},

{"field":"warehouseId","label":"调拨仓库","type":"string"},

{"field":"targetWarehouseId","label":"目的仓库","type":"string"},

{"field":"shippingMethod","label":"运输方式","type":"string"},

{"field":"trackingNumber","label":"跟踪单号","type":"string"},

{"field": "toCode", "label": "调拨单号", "type": "string" },

{"field": "productSku", "label": "产品SKU", "type": "string" },

{"field": "productSkuLike", "label": "产品SKU模糊查询", "type": "string" },

{

"field": “dateCreateFor”,

“label”: “创建时间开始”,

“type”: “string”,

“value”: "_function DATE_SUB(now(),INTERVAL 5 DAY)"

},

{

“field”: “dateCreateTo”,

“label”: “创建时间结束”,

“type”: “string”,

“value”: "{{CURRENT_TIME|datetime}}"

},

{“field”:“dataLastModifyFor”,“label”:“更新时间开始”,“type”:“string”},

{“field”:“dataLastModifyTo”,“label”:“更新时间结束”,“type”:“string”}

]

}数据请求与清洗

在实际操作中,首先需要通过POST方法向易仓系统发送请求,以获取指定条件下的调拨单数据。这里特别注意分页和限流问题,通过设置page和pageSize参数,可以有效控制每次请求的数据量,避免超出系统负荷。

示例请求参数:

- 页数(page):当前请求的页码。

- 页码(pageSize):每页返回的数据条数。

- 调拨单状态(status):固定值4,表示已完成状态。

- 创建时间范围(dateCreateFor, dateCreateTo):用于限定查询的时间范围。

这些参数确保了我们能够精确地获取所需的数据,并且可以根据业务需求进行动态调整。

数据转换与写入

获取到原始数据后,需要对其进行清洗和转换。例如,将日期格式统一、去除无效字段等。这一步骤可以通过轻易云平台提供的自定义数据转换逻辑来实现,以适应特定业务需求和目标系统的数据结构。

示例转换逻辑:

- 日期格式统一:将所有日期字段转换为标准ISO格式。

- 字段映射:将源系统中的字段名映射为目标系统中的对应字段名,例如,将

toCode映射为目标系统中的订单编号字段。 - 数据过滤:去除无效或重复的数据记录,确保最终写入的数据质量。

实时监控与日志记录

在整个过程中,通过轻易云平台提供的集中监控和告警系统,可以实时跟踪任务状态和性能。一旦发现异常情况,如网络延迟或API响应错误,可以及时采取措施进行处理。同时,通过日志记录功能,可以详细记录每一次API调用及其结果,为后续问题排查提供依据。

异常处理与重试机制

为了保证数据集成过程的可靠性,需要设计健全的异常处理机制。例如,当API调用失败时,可以设置自动重试策略,并在多次重试仍失败后触发告警通知相关人员进行人工干预。此外,还可以利用平台提供的数据质量监控功能,及时发现并处理潜在的问题。

综上所述,通过合理配置元数据、精确控制请求参数、实施有效的数据清洗与转换,以及借助实时监控和异常处理机制,可以高效地完成从易仓接口获取并加工调拨单数据这一关键步骤,为后续的数据集成奠定坚实基础。

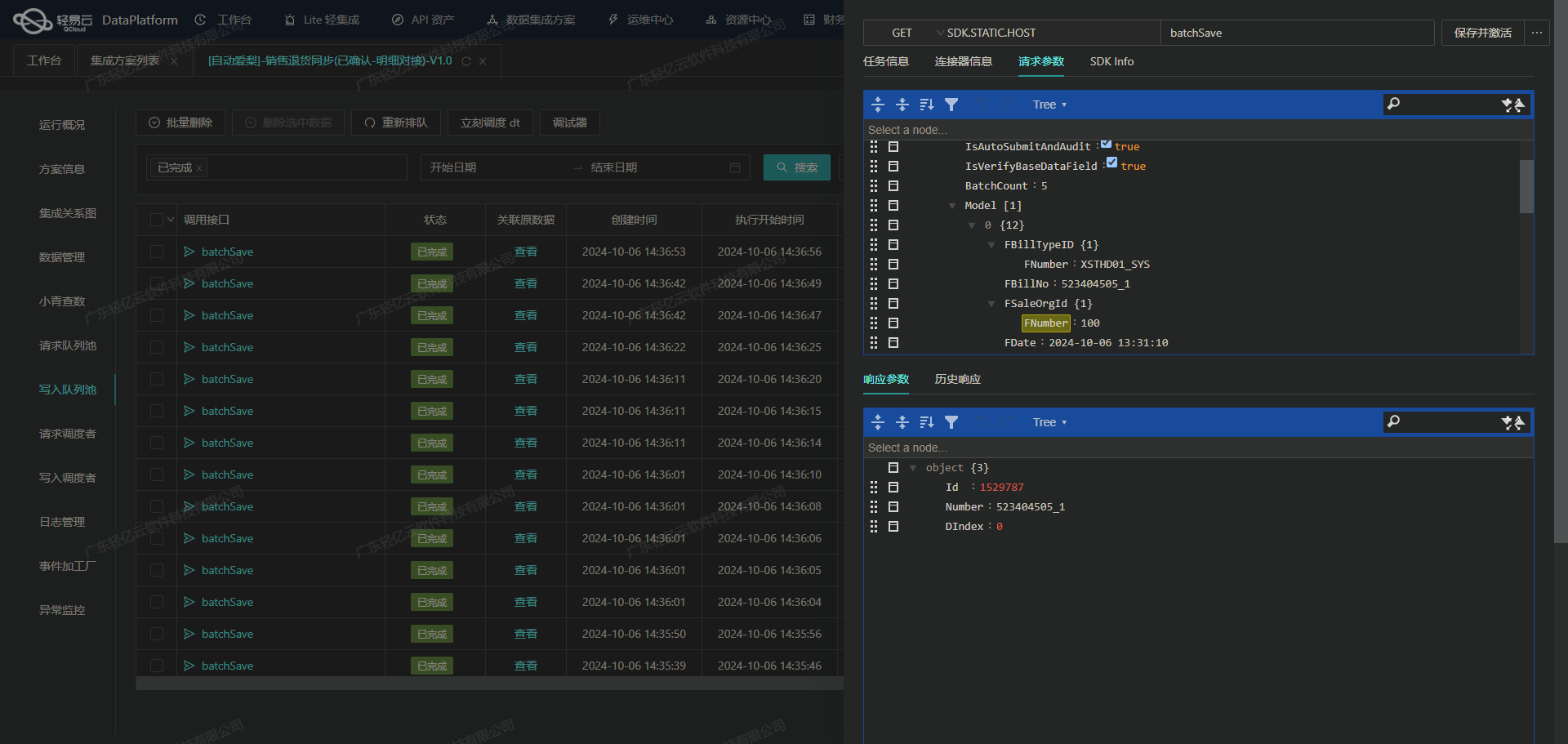

将源平台数据转换为金蝶云星空API格式并写入目标平台

在数据集成生命周期的第二步,关键任务是将已经集成的源平台数据进行ETL转换,使其符合金蝶云星空API接口所能接收的格式,并最终写入目标平台。以下内容详细描述了这一过程。

数据转换与映射

首先,我们需要根据金蝶云星空API的要求,对源数据进行转换和映射。元数据配置中提供了详细的字段映射规则,以下是几个关键字段的处理方式:

- 单据编号(FBillNo):直接映射为源数据中的

toCode。 - 单据类型(FBillTypeID):固定值为

ZJDB01_SYS,通过ConvertObjectParser进行解析。 - 业务类型(FBizType):固定值为

NORMAL。 - 调拨方向(FTransferDirect):固定值为

GENERAL。

组织和仓库信息的处理

对于涉及组织和仓库的信息,需要通过特定的查询和解析逻辑来获取对应的值:

- 调出库存组织(FStockOutOrgId)、调出货主(FOwnerOutIdHead)、调入库存组织(FStockOrgId)、调入货主(FOwnerIdHead)等字段,通过

_findCollection find warehouseCode from de1387a4-c479-35db-9bcb-c73858fcb2b1 where warehouseId={warehouseId}查询语句获取对应仓库代码,并通过ConvertObjectParser进行解析。

数据批量处理

为了提高效率,我们采用批量处理方式,将多个记录一次性写入金蝶云星空。元数据配置中的 operation.rowsKey 为 array,每次批量处理20条记录,通过 batchArraySave 方法实现。

{

"api": "batchSave",

"method": "POST",

"operation": {

"rowsKey": "array",

"rows": 20,

"method": "batchArraySave"

}

}明细信息处理

对于明细信息部分,例如物料编码、调拨数量、调出仓库等字段,通过嵌套数组结构进行处理,每个明细项包含多个子字段。示例如下:

- 物料编码(FMaterialId):通过

_findCollection find FNumber from 32df639a-9c45-3823-8a92-1e2ceb30649e where FOldNumber={{transferOrderDetails.productSku}}获取物料编码,并使用ConvertObjectParser解析。 - 调拨数量(FQty):直接映射为

transferOrderDetails.quantity。

提交与审核

在所有数据准备好后,通过设置 IsAutoSubmitAndAudit 参数,可以自动提交并审核单据:

{

"IsAutoSubmitAndAudit": false

}异常处理与重试机制

在实际操作中,可能会遇到各种异常情况,例如网络问题或接口限流等。为了确保数据可靠性,需要实现错误重试机制。可以通过捕捉异常并记录日志,在一定时间间隔后重新尝试提交未成功的数据。

{

"IsVerifyBaseDataField": true,

"Operation": "Save"

}实时监控与日志记录

为了确保整个ETL过程的透明度和可追溯性,需要实时监控数据流动情况,并记录详细日志。这不仅有助于快速发现问题,还能为后续优化提供依据。

综上所述,通过以上步骤,我们能够高效地将源平台的数据转化为金蝶云星空API接口所需的格式,并成功写入目标平台,实现不同系统之间的数据无缝对接。这一过程不仅提高了数据处理效率,还确保了数据的一致性和准确性。