金蝶云星空数据集成到MySQL的技术案例分享

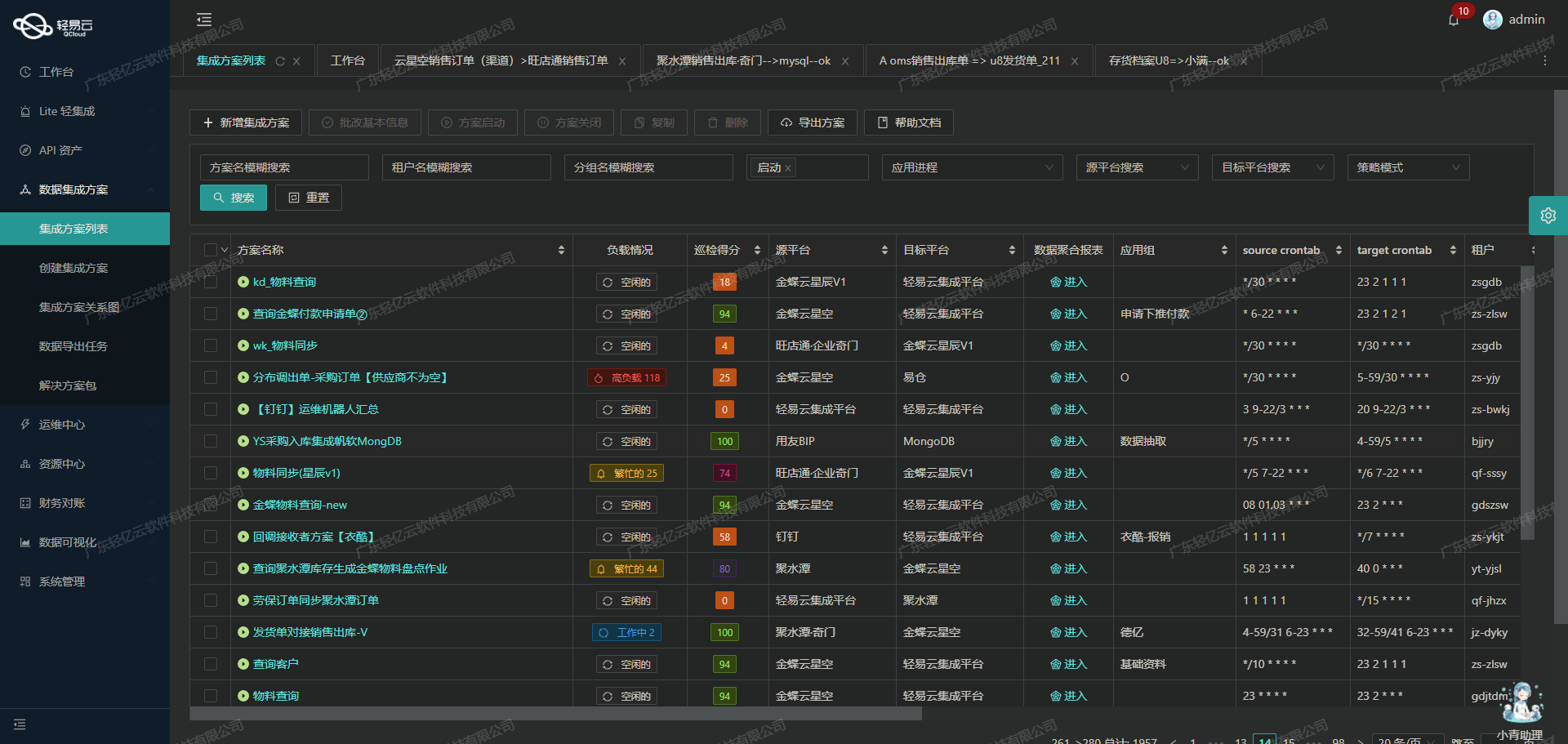

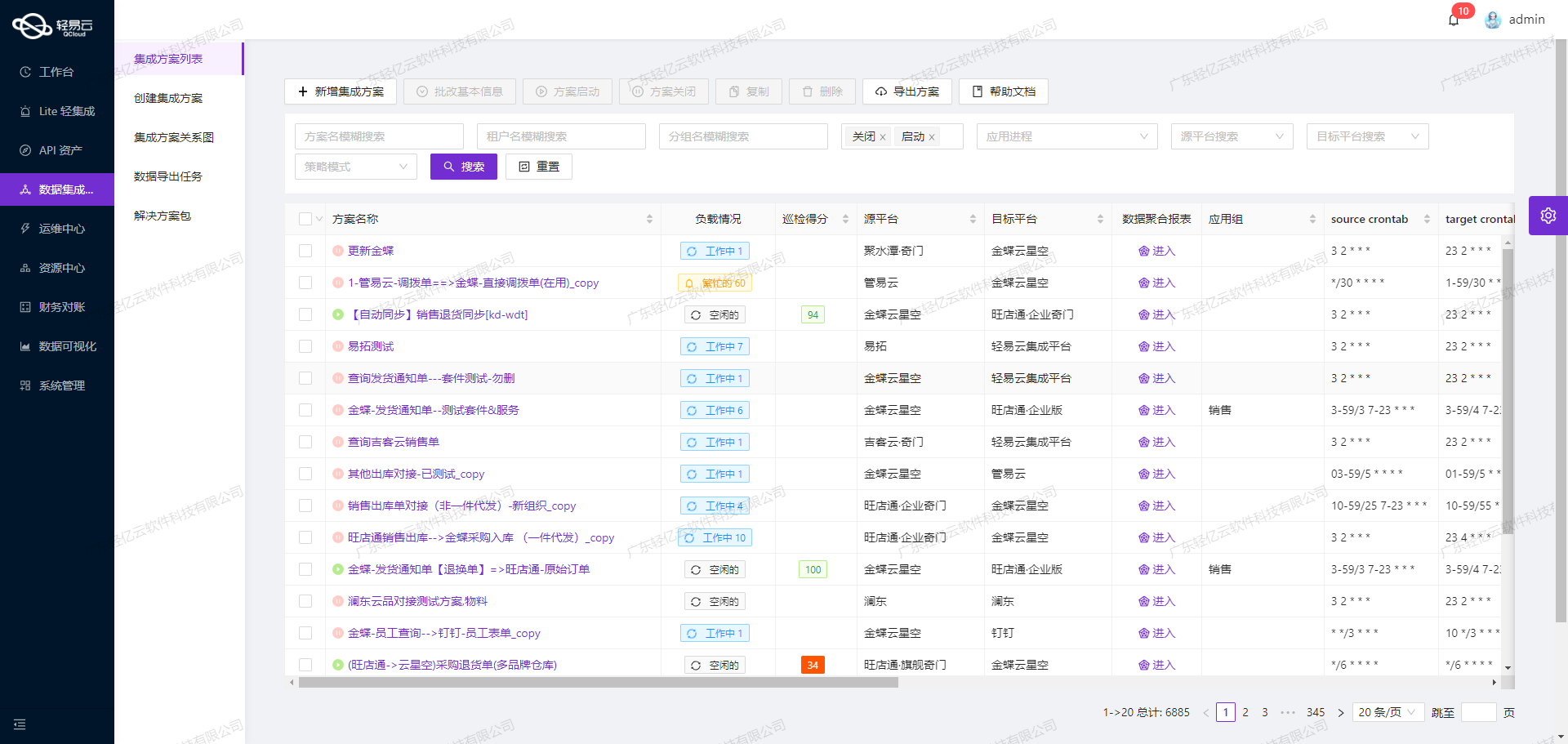

在现代企业的数据管理中,系统间的数据集成是确保业务流程顺畅运行的重要环节。本文将聚焦于一个具体的系统对接集成案例:金蝶云星空数据集成到MySQL,方案名称为MOM-XSCK-T02.01销售出库审核中数据拉取-表头测试。

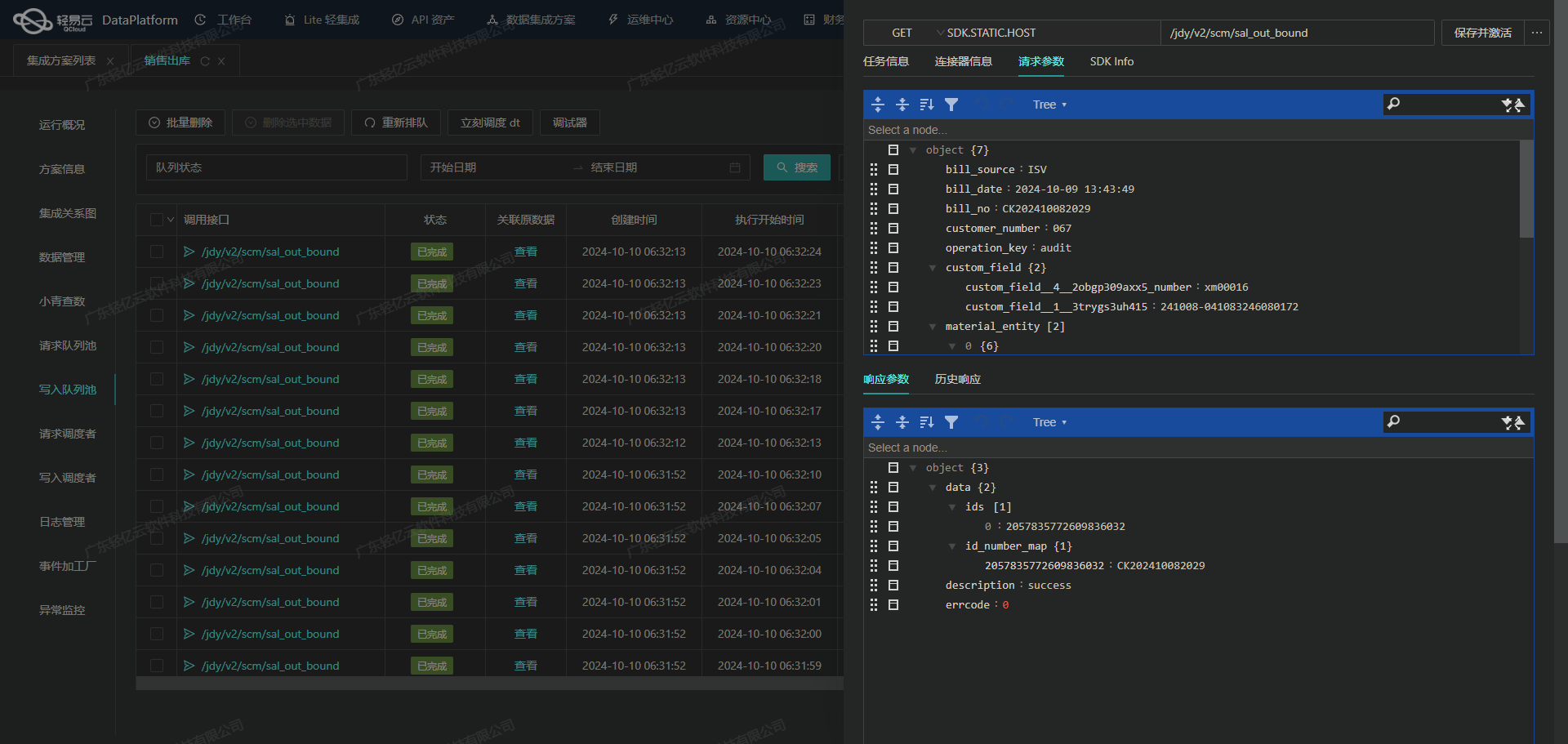

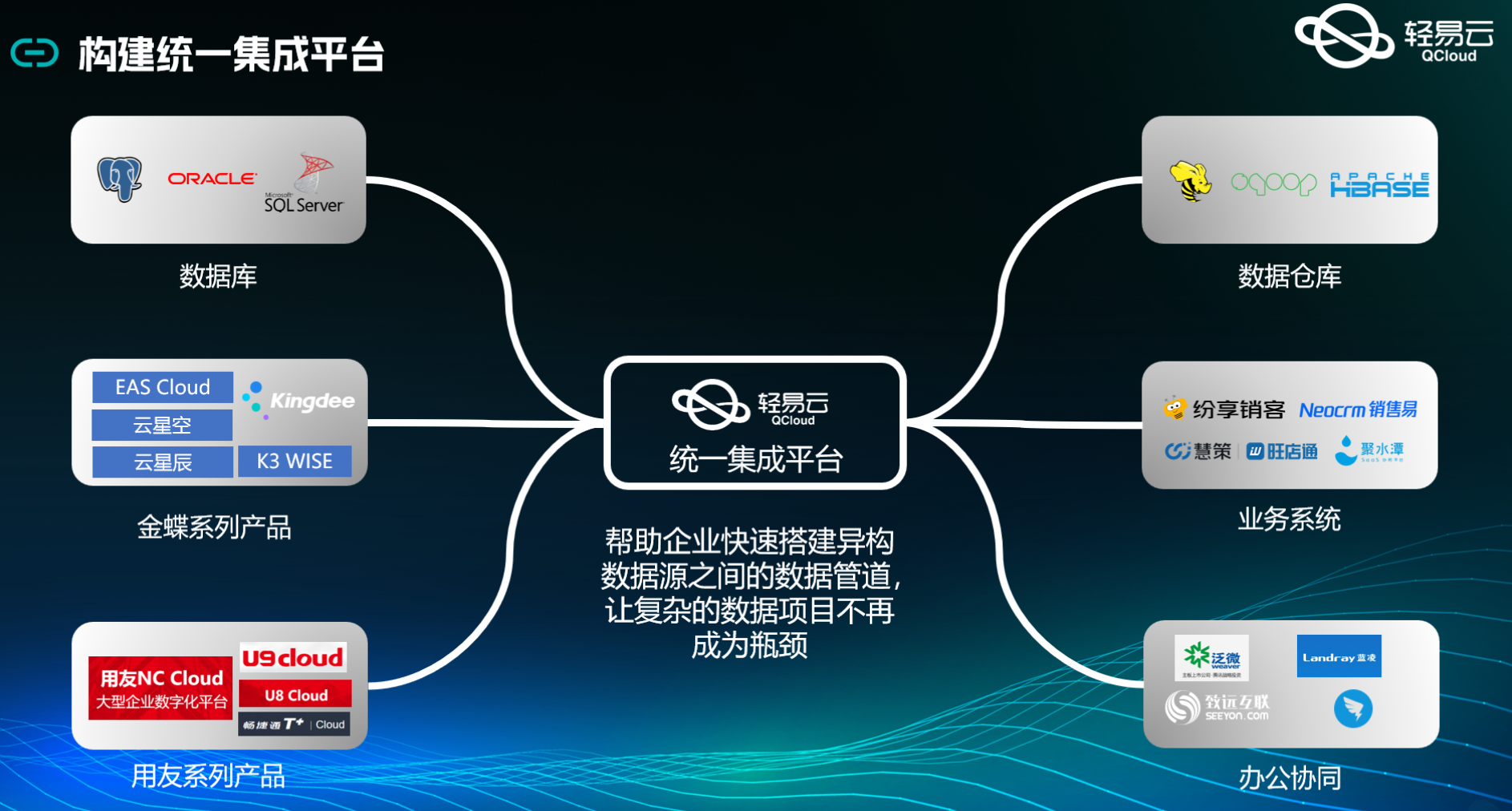

在这个案例中,我们利用轻易云数据集成平台,实现了从金蝶云星空获取销售出库审核中的数据,并将其高效地写入到MySQL数据库。整个过程不仅需要处理大量数据,还要确保数据的准确性和实时性。

首先,通过调用金蝶云星空提供的API接口executeBillQuery,我们能够定时可靠地抓取销售出库审核中的相关数据。这一过程需要特别注意接口的分页和限流问题,以避免因请求过多导致的性能瓶颈或服务不可用情况。同时,为了适应特定业务需求,我们还支持自定义的数据转换逻辑,以处理金蝶云星空与MySQL之间的数据格式差异。

在数据写入方面,MySQL作为目标平台,其高吞吐量的数据写入能力使得大量数据能够快速被集成,从而提升整体处理效率。通过使用MySQL的API接口execute,我们可以批量将从金蝶云星空获取的数据写入到数据库中。在此过程中,需要特别关注异常处理与错误重试机制,以确保每条记录都能成功存储,不漏单。

此外,为了全面掌握任务执行情况,我们提供了集中监控和告警系统,实时跟踪每个数据集成任务的状态和性能。一旦发现任何异常情况,可以及时进行处理,保障系统稳定运行。

总之,通过这一技术方案,我们实现了从金蝶云星空到MySQL的数据无缝对接,不仅提高了业务透明度和效率,也为企业提供了更强大的数据管理能力。后续章节将详细介绍具体实施步骤及技术细节。

调用金蝶云星空接口executeBillQuery获取并加工数据

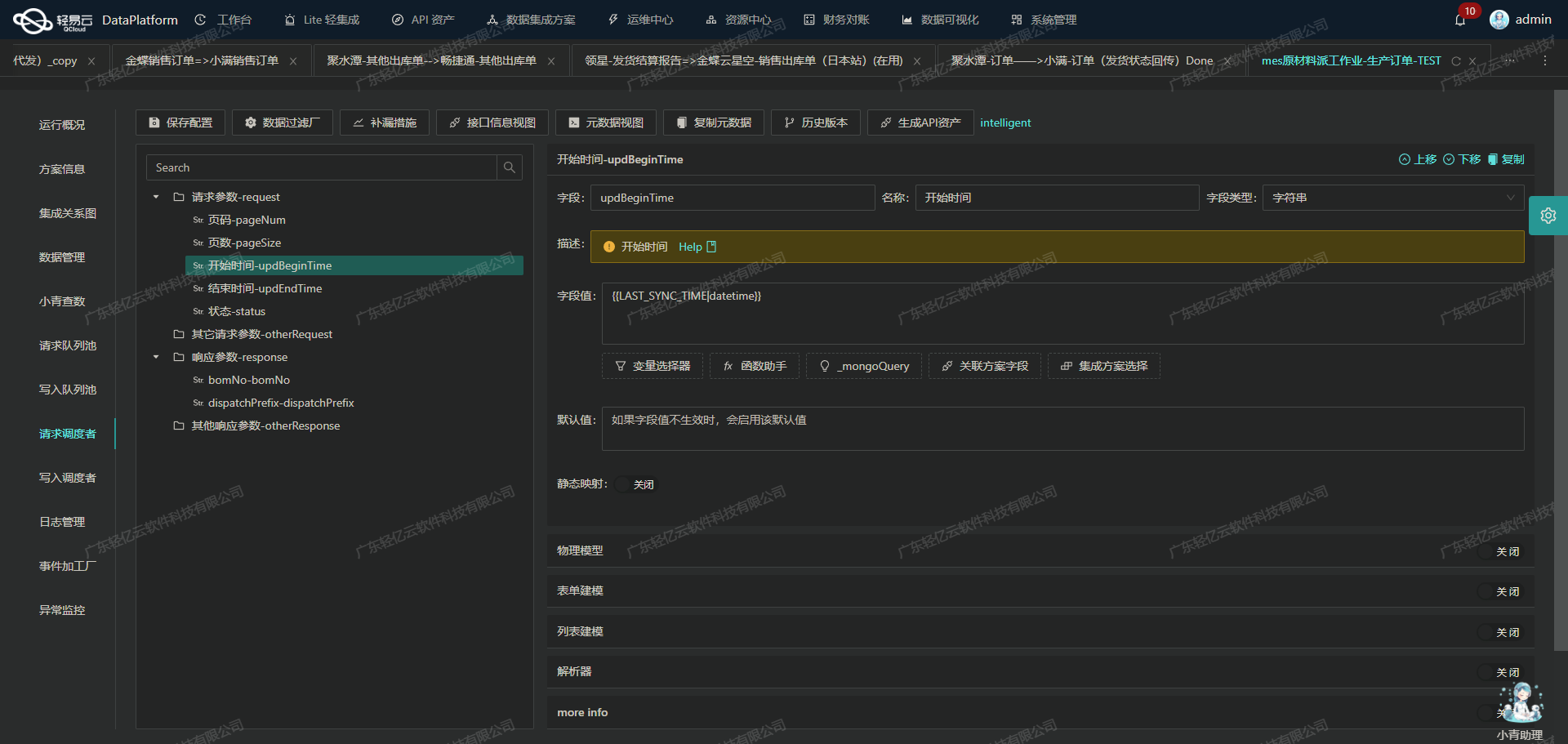

在轻易云数据集成平台的生命周期中,调用源系统接口是至关重要的一步。本文将详细探讨如何通过调用金蝶云星空接口executeBillQuery来获取销售出库审核中的数据,并进行初步加工处理。

配置元数据

首先,我们需要配置元数据,以确保能够正确调用金蝶云星空的API接口。以下是关键的元数据配置项:

- api:

executeBillQuery - method:

POST - number:

fbillno - id:

FEntity_FENTRYID - request字段:

- 主键:

fid - 销售出库单号:

fbillno - 状态:

FDocumentStatus(B审核中C已审核D重新审核) - 销售组织:

FSaleOrgId.fnumber - 日期:

fdate - 发货组织:

FStockOrgId.fnumber - 客户代码:

FCustomerID.fnumber - 客户名称:

FCustomerID.fname - 承运商:

FCarrierID.fnumber - 运输单号:

FCarriageNO - 销售员:

FSalesManID.fname

- 主键:

这些字段定义了我们需要从金蝶云星空系统中提取的数据内容。

构建请求参数

为了成功调用API,我们需要构建合适的请求参数。以下是一个示例:

{

"FormId": "SAL_OUTSTOCK",

"FieldKeys": ["fid", "fbillno", "FDocumentStatus", "FSaleOrgId.fnumber", "fdate", "FStockOrgId.fnumber", "FCustomerID.fnumber", "FCustomerID.fname", "FCarrierID.fnumber", "FCarriageNO", "FSalesManID.fname"],

"FilterString": "FStockOrgId.fnumber='T02.01' and FDocumentStatus='B' and Fbillno='TYCKD202405240107' and F_FSYNCMOM=0 and FModifyDate>='{{LAST_SYNC_TIME|datetime}}'",

"Limit": 2000,

"StartRow": "{PAGINATION_START_ROW}"

}其中,FilterString用于筛选特定条件下的数据,例如状态为“B”(审核中)的记录。

调用API并处理分页问题

由于可能存在大量数据,我们需要处理分页问题。通过设置分页参数,如Limit和StartRow,可以分批次拉取数据,确保不会遗漏任何记录。

在每次请求后,需要检查返回结果是否达到Limit值,如果是,则继续下一页的请求,直到所有数据都被拉取完毕。

数据清洗与转换

获取到原始数据后,需要对其进行清洗与转换,以适应目标系统的数据结构。例如,将日期格式转换为标准格式,对客户代码和名称进行匹配等。这一步骤可以通过自定义脚本或内置的数据转换工具来实现。

数据写入与监控

完成数据清洗与转换后,将处理后的数据写入目标数据库(如MySQL)。轻易云平台支持高吞吐量的数据写入能力,使得大量数据能够快速被集成到目标系统中。同时,通过提供实时监控和告警系统,可以及时跟踪任务状态和性能,确保整个过程顺利进行。

异常处理与重试机制

在实际操作过程中,难免会遇到各种异常情况,如网络波动、接口超时等。因此,需要设计健全的异常处理与重试机制。例如,当某次请求失败时,可以自动重试一定次数,并记录日志以便后续排查问题。

通过以上步骤,我们可以高效地调用金蝶云星空接口获取销售出库审核中的数据,并进行必要的加工处理,为后续的数据集成奠定坚实基础。

数据集成平台生命周期第二步:ETL转换与MySQLAPI接口写入

在数据集成平台的生命周期中,第二步是将已经集成的源平台数据进行ETL(提取、转换、加载)转换,转为目标平台MySQLAPI接口能够接收的格式,并最终写入目标平台。本文将详细探讨这一过程中的关键技术和注意事项。

数据请求与清洗

首先,我们需要从源系统中提取数据。这一步通常通过调用源系统的API接口来实现。以金蝶云星空为例,可以使用executeBillQuery接口来抓取销售出库审核中的数据。在这个过程中,需要处理分页和限流问题,以确保数据提取的稳定性和完整性。

{

"api": "execute",

"method": "POST",

"idCheck": true,

"request": [

{

"field": "main_params",

"type": "object",

"children": [

{"field": "INSTRUCTION_DOC_ID", "type": "string", "value": "{fid}"},

{"field": "TENANT_ID", "type": "string", "value": "7"},

{"field": "INSTRUCTION_DOC_NUM", "type": "string", "value": "{fbillno}"}

// 更多字段...

]

}

]

}数据转换与映射

在数据提取完成后,需要对数据进行转换和映射,以适应目标平台的格式要求。例如,将金蝶云星空的数据转换为MySQL数据库能够接受的格式。这里需要特别关注字段类型和值的匹配问题。

{

"main_sql": {

"value":

`INSERT INTO ty_mes.mt_instruction_doc (

INSTRUCTION_DOC_ID, TENANT_ID, INSTRUCTION_DOC_NUM, INSTRUCTION_DOC_TYPE,

INSTRUCTION_DOC_STATUS, SITE_ID, SUPPLIER_ID, SUPPLIER_SITE_ID,

CUSTOMER_ID, CUSTOMER_SITE_ID, SOURCE_ORDER_TYPE, SOURCE_ORDER_ID,

COST_CENTER_ID, PERSON_ID, IDENTIFICATION, REMARK, REASON,

SOURCE_SYSTEM, LATEST_HIS_ID, CID, CREATION_DATE, LAST_UPDATE_DATE

) VALUES (

:INSTRUCTION_DOC_ID, :TENANT_ID, :INSTRUCTION_DOC_NUM,

:INSTRUCTION_DOC_TYPE, :INSTRUCTION_DOC_STATUS, :SITE_ID,

(SELECT supplier_id FROM tarzan_model.mt_supplier WHERE supplier_code = :SUPPLIER_ID),

:SUPPLIER_SITE_ID,

(SELECT customer_id FROM tarzan_model.mt_customer WHERE customer_code = :CUSTOMER_ID),

:CUSTOMER_SITE_ID, :SOURCE_ORDER_TYPE, :SOURCE_ORDER_ID,

:COST_CENTER_ID, :PERSON_ID, :IDENTIFICATION,

:REMARK, :REASON,

:SOURCE_SYSTEM, :LATEST_HIS_ID,

:CID,:CREATION_DATE,:LAST_UPDATE_DATE)`

}

}数据写入与异常处理

完成数据转换后,将其写入MySQL数据库。在此过程中,需特别注意高吞吐量的数据写入能力,以确保大量数据能够快速被集成到目标系统中。此外,还需要实现异常处理与错误重试机制,确保数据写入过程的稳定性和可靠性。

{

"extend_sql_1": {

"value":

`INSERT INTO ty_mes.mt_instruction_doc_attr (

TENANT_ID, INSTRUCTION_DOC_ID,

ATTR_NAME, ATTR_VALUE,

OBJECT_VERSION_NUMBER,

CREATED_BY,

CREATION_DATE,

LAST_UPDATED_BY,

LAST_UPDATE_DATE

) VALUES (

:TENANT_ID,:INSTRUCTION_DOC_ID,:ATTR_NAME,:ATTR_VALUE,:OBJECT_VERSION_NUMBER,:CREATED_BY,:CREATION_DATE,:LAST_UPDATED_BY,:LAST_UPDATE_DATE)`

}

}实时监控与日志记录

在整个ETL过程中,实时监控和日志记录是必不可少的。通过集中的监控和告警系统,可以实时跟踪数据集成任务的状态和性能,及时发现并处理潜在的问题。此外,详细的日志记录有助于后续的数据审计和问题排查。

自定义数据转换逻辑

为了适应特定业务需求,可以自定义数据转换逻辑。例如,在某些情况下,需要对特定字段进行复杂的计算或转换。这可以通过编写自定义函数来实现,并在ETL过程中调用这些函数。

综上所述,利用轻易云数据集成平台可以高效地实现源平台到MySQLAPI接口的数据集成。在这一过程中,需要重点关注数据提取、转换、映射、写入以及异常处理等环节,通过合理配置元数据,实现稳定、高效的数据集成。