钉钉数据集成到金蝶云星空的技术案例分享

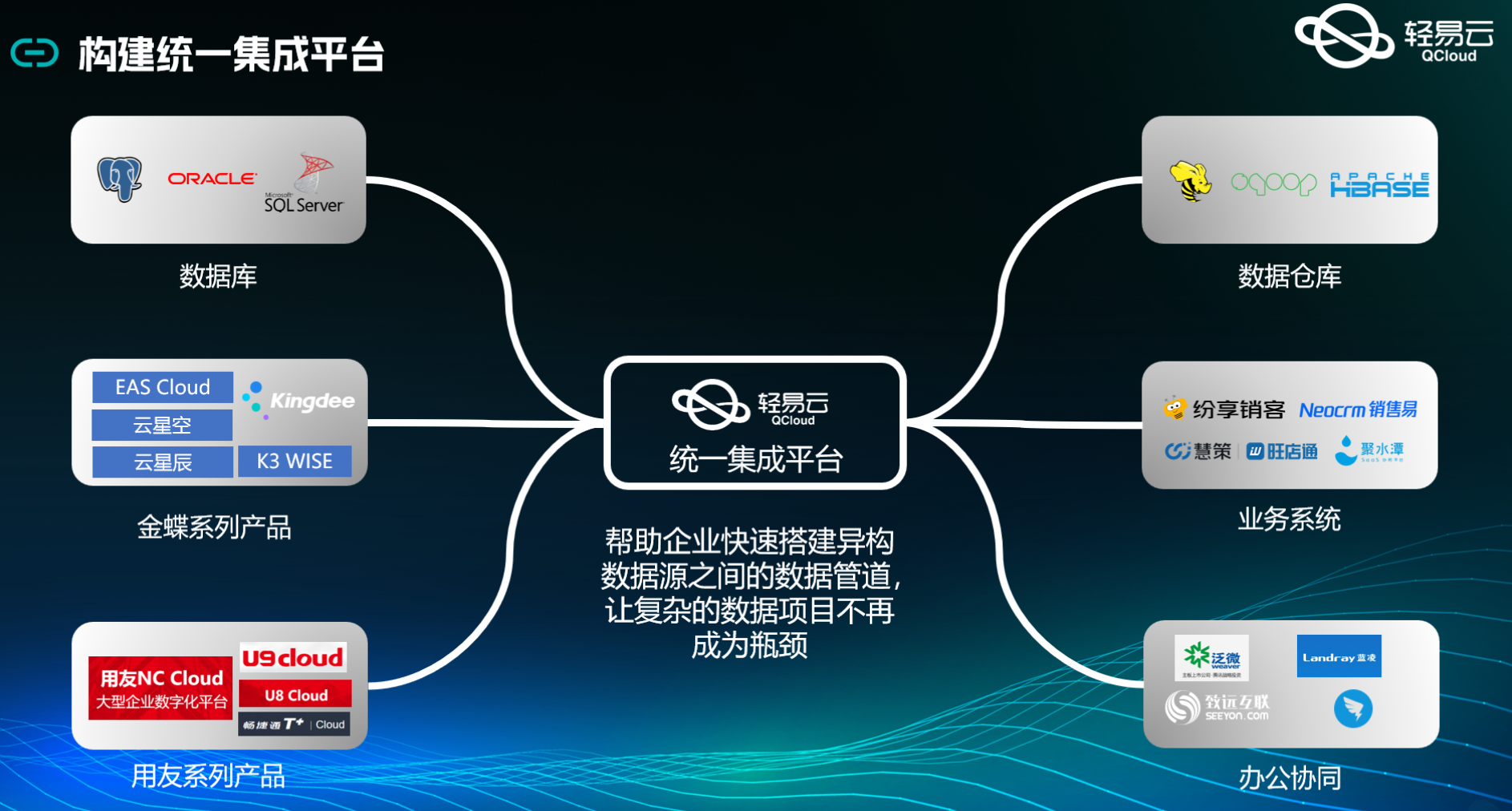

在企业信息化管理中,数据的高效流转和准确对接是实现业务流程自动化的重要环节。本文将分享一个具体的系统对接集成案例:如何通过轻易云数据集成平台,将钉钉的数据无缝集成到金蝶云星空,实现薪金单(非工资)的自动化处理。

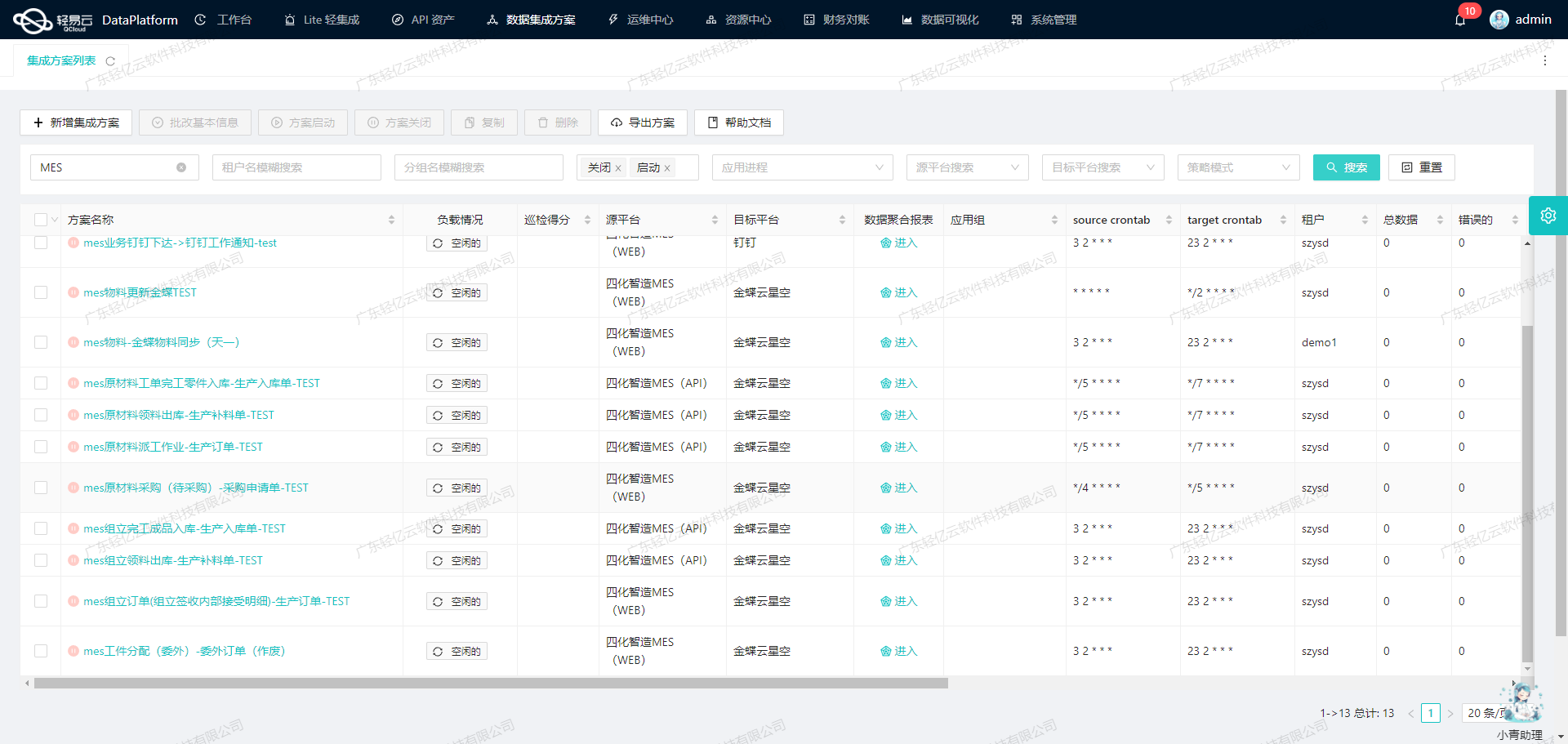

本次集成方案命名为“salary-新薪金单(非工资) 3.2”,主要涉及两个核心平台:钉钉作为数据源平台,负责提供原始薪金单数据;金蝶云星空作为目标平台,负责接收并处理这些数据。为了确保整个过程的高效和可靠,我们利用了轻易云数据集成平台的一系列特性。

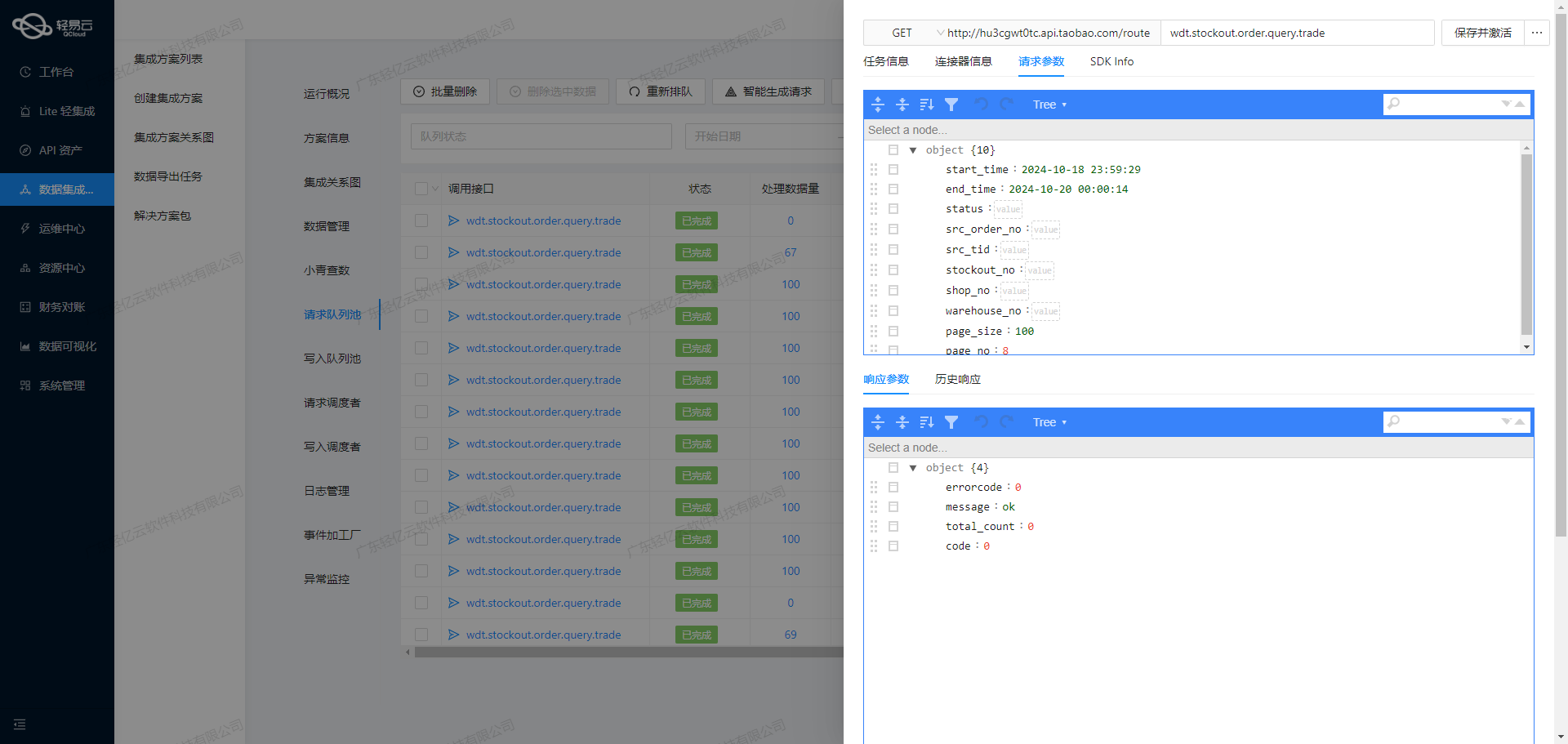

首先,通过调用钉钉API接口v1.0/yida/processes/instances,我们能够定时可靠地抓取所需的数据。这一过程不仅保证了数据获取的及时性,还能有效处理分页和限流问题,确保不会漏单。同时,为了适应不同业务需求和数据结构,我们支持自定义的数据转换逻辑,使得从钉钉获取的数据能够顺利映射到金蝶云星空所需的格式。

在写入阶段,我们使用了金蝶云星空提供的batchSave API接口,实现大量数据快速写入。这一特性极大提升了数据处理的时效性,使得企业能够更快地完成薪金单的生成与发放。此外,通过集中监控和告警系统,我们可以实时跟踪每个数据集成任务的状态和性能,一旦出现异常情况,可以及时进行错误重试机制,从而保障整个流程的稳定运行。

最后,为了确保整个集成过程透明可视,并且便于管理,我们采用了可视化的数据流设计工具。这不仅使得配置元数据更加直观,也方便技术人员随时调整和优化流程,提高工作效率。

通过上述技术手段,本次“salary-新薪金单(非工资) 3.2”方案成功实现了钉钉与金蝶云星空之间的数据无缝对接,为企业提供了一套高效、可靠、可扩展的数据集成解决方案。

调用钉钉接口v1.0/yida/processes/instances获取并加工数据

在轻易云数据集成平台的生命周期中,调用源系统接口是至关重要的第一步。本文将详细探讨如何通过调用钉钉接口v1.0/yida/processes/instances来获取并加工数据,以实现高效的数据集成。

钉钉接口配置与调用

首先,我们需要配置和调用钉钉的API接口。以下是关键的元数据配置:

{

"api": "v1.0/yida/processes/instances",

"method": "POST",

"number": "title",

"id": "processInstanceId",

"idCheck": true,

...

}该配置定义了API的基本信息,包括请求方法、唯一标识字段等。在实际操作中,我们需要特别注意分页处理、限流问题以及数据格式转换。

分页处理与限流

由于可能涉及大量数据,分页处理是必不可少的一环。我们可以通过设置pageNumber和pageSize参数来控制每次请求的数据量:

{

"field": "pageNumber",

"label": "分页页码",

...

},

{

"field": "pageSize",

"label": "分页大小",

...

}确保合理设置分页参数,可以有效避免一次性请求过多数据导致的性能问题。同时,针对API限流问题,可以在代码中加入重试机制,以应对因超出限制而导致的请求失败。

数据过滤与条件查询

为了提高数据获取的精准度,我们可以利用条件查询功能。例如,通过以下字段筛选特定类型的数据:

{

"field": "searchFieldJson",

...

}在这个字段下,可以进一步细化查询条件,如根据发起人、创建时间等进行过滤。这不仅能减少无效数据,还能提升后续处理效率。

数据清洗与转换

获取到原始数据后,需要进行清洗和转换,以符合目标系统(如金蝶云星空)的要求。这一步骤包括但不限于:

- 格式转换:将日期格式统一为目标系统所需格式。

- 字段映射:将源系统中的字段映射到目标系统对应字段。

- 异常处理:对缺失或异常值进行补全或修正。

例如,将创建时间从UTC格式转换为本地时间,并确保所有必填字段都有有效值。

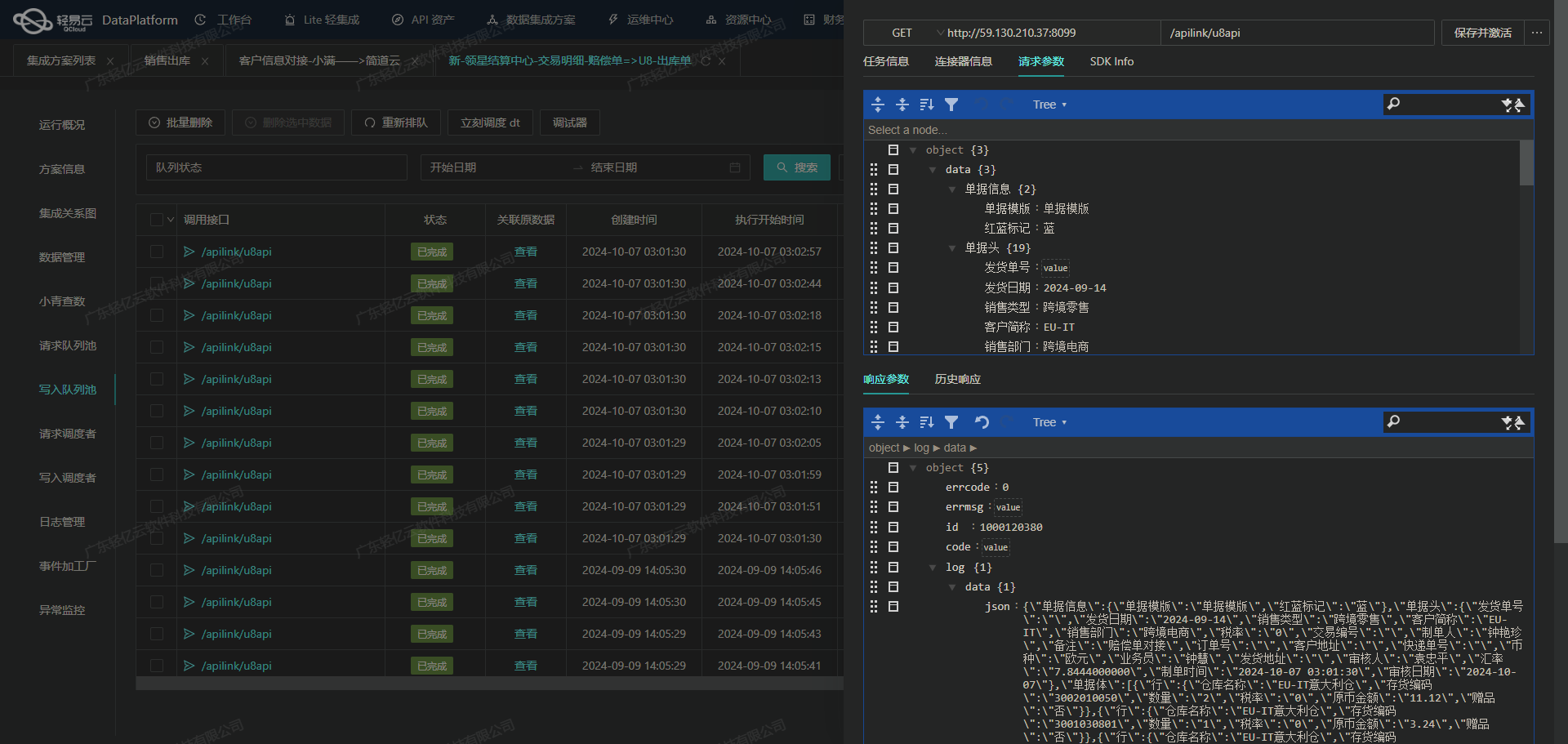

实时监控与日志记录

为了确保整个过程顺利进行,实时监控和日志记录是不可或缺的一部分。通过轻易云平台提供的集中监控和告警系统,可以实时跟踪任务状态,并在出现异常时及时响应。此外,详细的日志记录有助于问题排查和性能优化。

高效写入与批量处理

最后,将清洗后的数据高效写入目标系统。在大规模数据集成场景下,支持高吞吐量的数据写入能力尤为重要。同时,通过批量处理技术,可以显著提升整体效率,减少单次操作带来的开销。

综上所述,通过合理配置和调用钉钉接口,并结合轻易云平台强大的数据处理能力,我们能够实现高效、可靠的数据集成,为企业业务提供坚实的数据支撑。

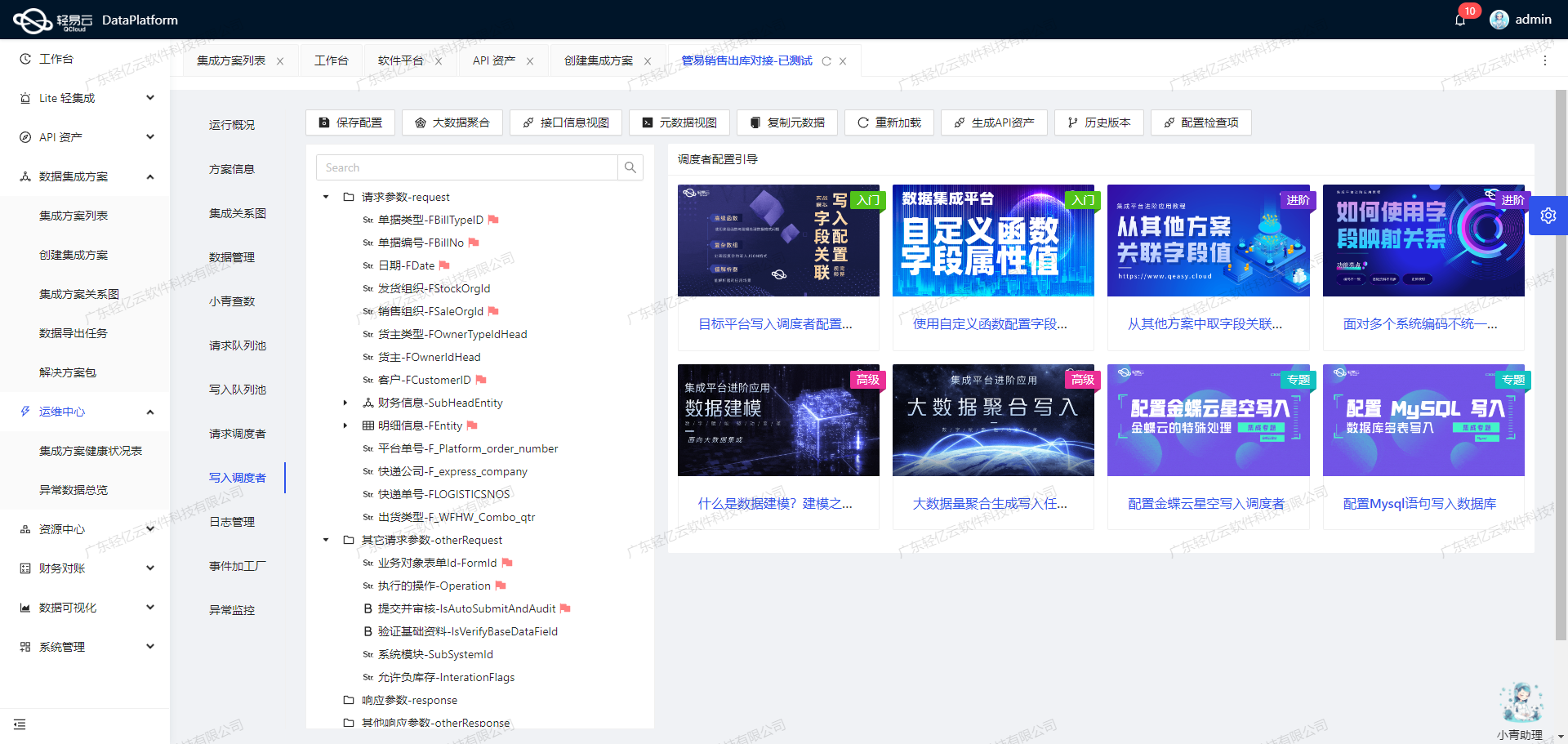

集成数据写入金蝶云星空API接口

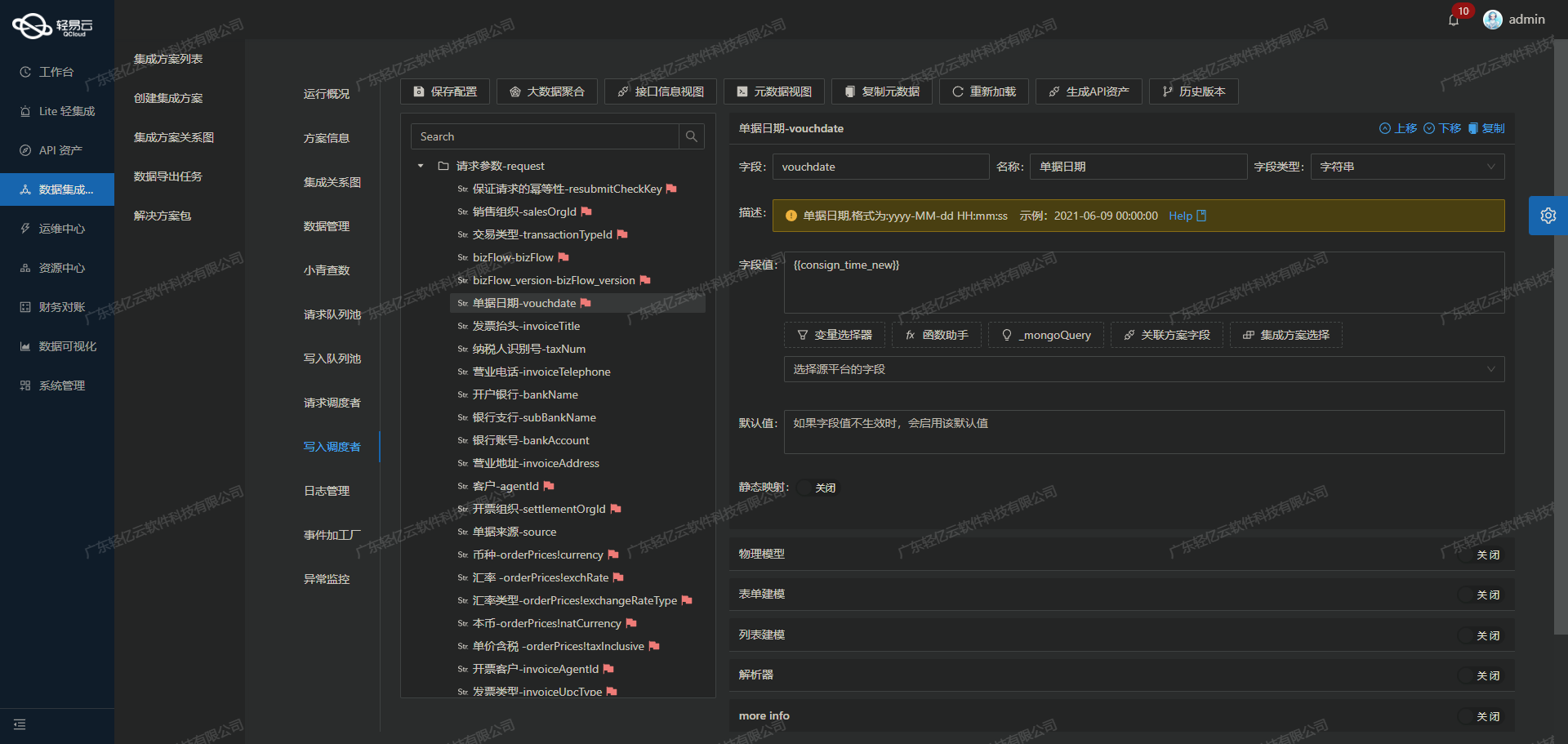

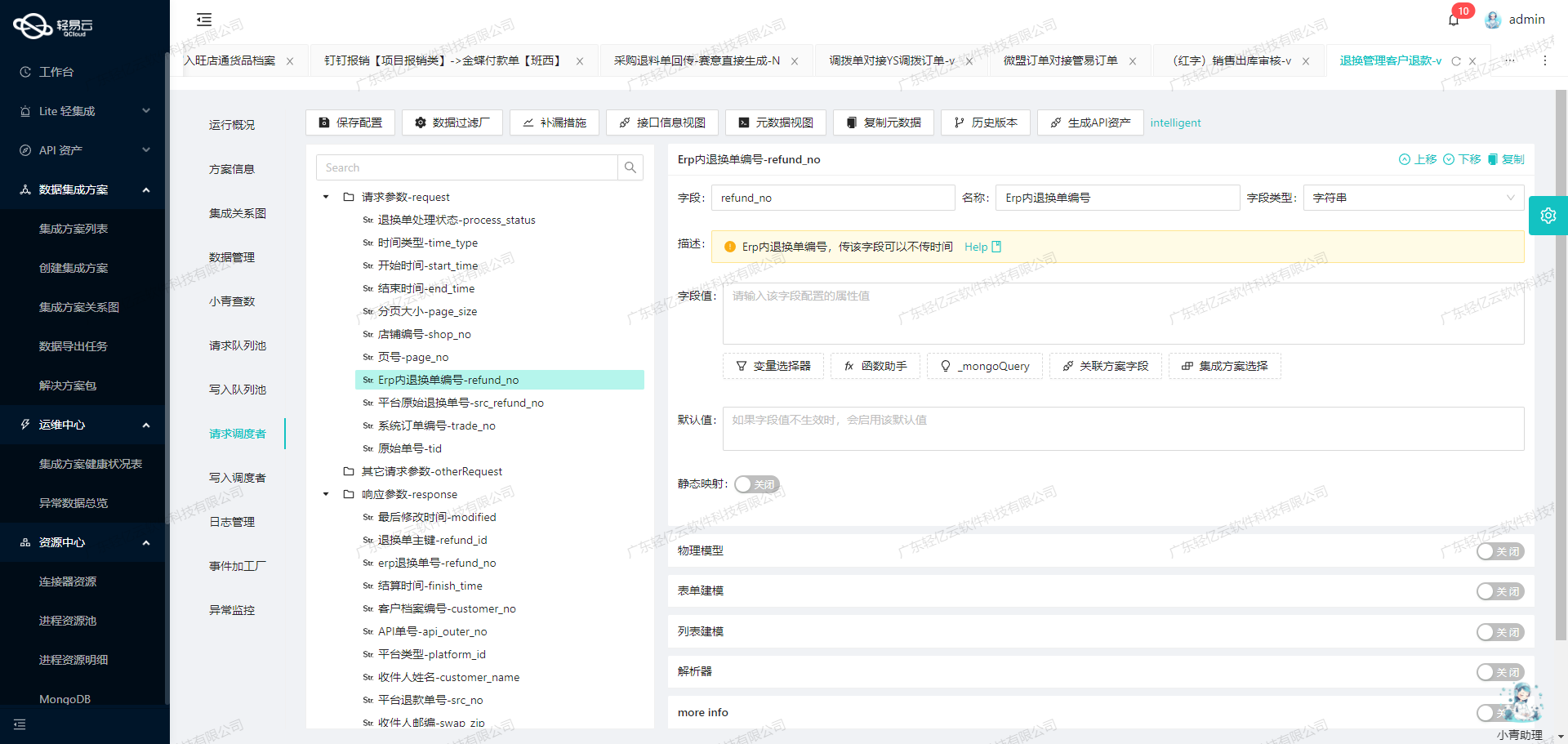

在数据集成生命周期的第二步中,核心任务是将已经集成的源平台数据进行ETL转换,使其符合目标平台金蝶云星空API接口所能接收的格式,并最终写入到目标平台。以下将详细探讨这一过程中的技术实现。

API接口配置与调用

我们使用batchSave API接口来完成数据的批量保存操作。该接口采用HTTP POST方法,支持高吞吐量的数据写入能力,确保大量数据能够快速被集成到金蝶云星空系统中。具体配置如下:

{"api":"batchSave","method":"POST"}数据字段映射与转换

在进行ETL转换时,需要特别注意源数据字段与目标平台字段的映射关系。以下是关键字段的转换示例:

- 单据编号(FBillNo):从源数据字段

{textField_kspd9fet}提取,并附加固定后缀(FKD)。 - 币别(FCURRENCYID):直接映射为固定值

PRE001。 - 业务日期(FDATE):通过函数处理,将Unix时间戳转换为标准日期格式。

{"field":"FDATE","label":"业务日期","type":"string","value":"_function FROM_UNIXTIME( ( {dateField_kzdsyb61} \/ 1000 ) ,'%Y-%m-%d' )"}嵌套结构与数组处理

对于复杂的嵌套结构和数组,例如付款单明细(FPAYBILLENTRY),需要逐个字段进行处理,并确保每个子字段都正确映射:

- 结算方式(FSETTLETYPEID):从源数据字段

{textField_ksgsok7n}提取,并通过解析器转换为目标平台接受的编码。 - 我方银行账号(FACCOUNTID):同样使用解析器进行编码转换。

{"field":"FPAYBILLENTRY","label":"付款单明细","type":"array","children":[

{"field":"FSETTLETYPEID","label":"结算方式","type":"string","parser":{"name":"ConvertObjectParser","params":"FNumber"},"value":"{textField_ksgsok7n}"},

{"field":"FACCOUNTID","label":"我方银行账号","type":"string","value":"{selectField_kq97ayh5}","parser":{"name":"ConvertObjectParser","params":"FNumber"}}

]}异常处理与重试机制

在实际操作过程中,可能会遇到各种异常情况,如网络故障、数据格式错误等。为了保证数据完整性和操作的可靠性,需要实现异常处理和错误重试机制。例如,当API调用失败时,可以设置自动重试策略,以确保数据最终成功写入。

数据质量监控与日志记录

为了实时监控数据处理过程并及时发现问题,轻易云平台提供了集中监控和告警系统。这些功能允许用户实时跟踪集成任务的状态和性能,并记录详细日志,以便事后分析和问题排查。

自定义转换逻辑

根据具体业务需求,可以自定义数据转换逻辑。例如,对于特定业务类型的数据,可以增加额外的校验规则或转换步骤,以确保所有数据符合目标平台的要求。

调用示例

最后,通过HTTP请求库(如axios或fetch)调用配置好的API接口,将处理后的数据发送到金蝶云星空:

axios.post('https://api.kingdee.com/batchSave', transformedData, {

headers: {

'Content-Type': 'application/json'

}

}).then(response => {

console.log('Data successfully saved:', response.data);

}).catch(error => {

console.error('Error saving data:', error);

});通过上述步骤,我们可以高效地将源平台的数据进行ETL转换,并准确写入到金蝶云星空系统中,实现不同系统间的数据无缝对接。