测试-查询销售渠道信息-dange:吉客云数据集成到MySQL技术案例

在实际的业务系统中,数据集成是实现不同平台之间高效联动的基础。本文分享一个具体的技术案例,展示如何使用轻易云数据集成平台将吉客云的数据无缝对接到MySQL数据库。

项目背景及需求分析

公司需要定期从吉客云获取最新的销售渠道信息,并将这些数据快速、批量地写入到内部的MySQL数据库中,以支持后续的数据分析和业务决策。为了满足这一需求,我们选择了API接口erp.sales.get来抓取吉客云中的销售渠道数据,并通过轻易云平台实现与MySQL API execute 的无缝衔接。

主要解决方案

- 高效的数据写入:为应对大量数据传输,我们确保每次导入操作能承载高吞吐量,从而大幅提升处理时效性。

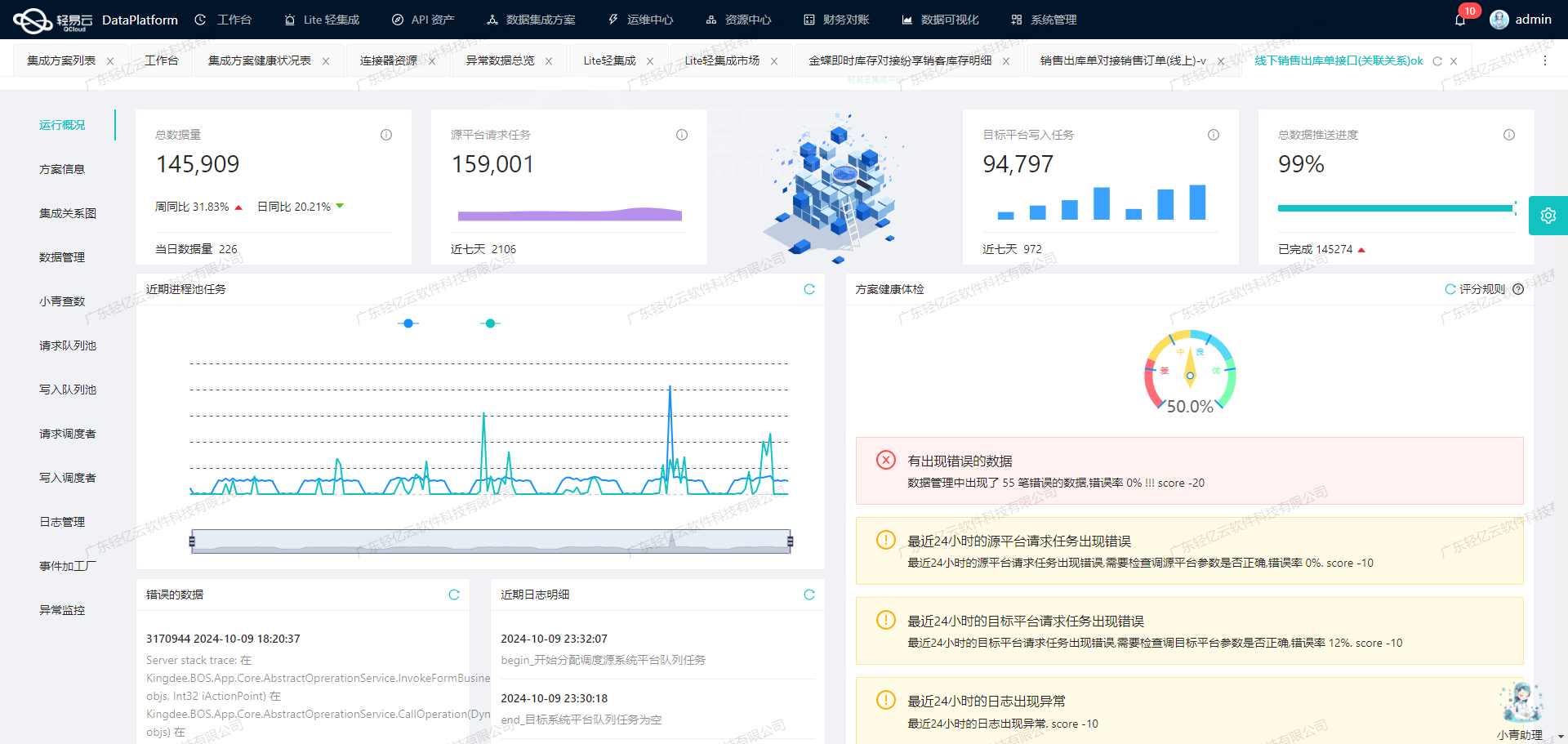

- 实时监控与告警:利用集中式监控和告警系统,实时跟踪每个任务状态和性能,有助于快速定位并解决潜在问题。

- 定制化数据转换逻辑:针对不同的数据结构与业务需求,对获取自吉客云的数据进行必要转换,以适配目标MySQL表结构。

- 异常处理机制:设计完善的错误重试机制,当遇到网络不稳定或服务响应延迟等问题时,保证任务能够顺利完成。

数据流设计与实施细节

首先,通过可视化工具定义整体的数据流过程,包括从调用API接口获取原始数据,到经过格式转换、清洗等步骤,再批量写入至MySQL。在此过程中,将特别关注以下几点:

- 分页处理策略:由于API返回结果可能较大,需要考虑分页逻辑,以避免单次请求超出限制。同时,还需设置合理速率控制限流,避免触发API调用频率上限。

- 一致性校验机制:(如是否漏单)在每次执行完一次全量拉取后,通过比对日志记录确保没有遗漏任何一条关键销售渠道信息。

以上就是此次项目开头部分相关技术点介绍。后续我们将详细讲解具体配置步骤以及各环节涉及的重要参数设置。

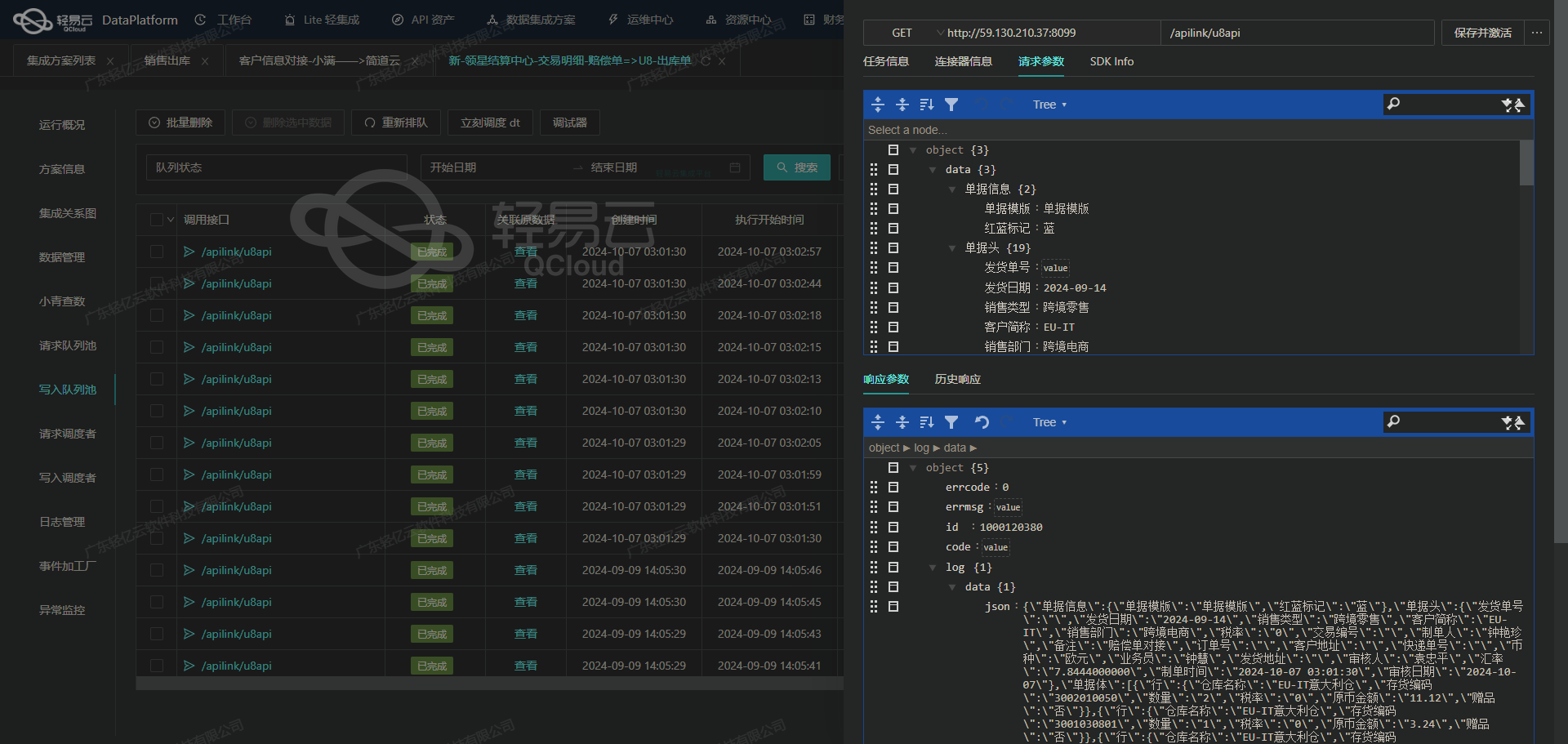

调用吉客云接口erp.sales.get获取并加工数据

在轻易云数据集成平台中,调用源系统接口是数据处理生命周期的第一步。本文将详细探讨如何通过调用吉客云接口erp.sales.get来获取并加工数据。

接口概述

吉客云提供的erp.sales.get接口用于查询销售渠道信息。该接口采用POST方法,主要参数包括分页信息、编号、名称、修改时间范围以及是否停用和删除等标志位。以下是元数据配置的详细内容:

{

"api": "erp.sales.get",

"effect": "QUERY",

"method": "POST",

"number": "channelCode",

"id": "channelId",

"request": [

{"field": "pageIndex", "label": "页码(默认0)", "type": "int"},

{"field": "pageSize", "label": "每页页数(默认50)", "type": "int", "value": "50"},

{"field": "code", "label": "编号", "type": "string"},

{"field": "name", "label": "名称", "type": "string"},

{"field": "gmtModifiedStart", "label": "起始修改时间", "type": "string",

"value":"{{LAST_SYNC_TIME|datetime}}"},

{"field": "gmtModifiedEnd",

"label":"结束修改时间","type":"string","value":"{{CURRENT_TIME|datetime}}"},

{"field":"isBlockup","label":"是否停用,1-是,0-否","type":"int"},

{"field":"isDelete","label":"是否删除,1-是,0-否","type":"int"}

],

"autoFillResponse": true

}数据请求与清洗

在调用该接口时,我们需要根据业务需求设置请求参数。以下是一个典型的请求示例:

{

"pageIndex": 0,

"pageSize": 50,

// 可选参数,根据实际需求填写

// 如需过滤特定编号或名称,可添加如下字段

// “code”: “渠道编号”,

// “name”: “渠道名称”,

// 时间范围通常用于增量同步

“gmtModifiedStart”: “2023-01-01T00:00:00Z”,

“gmtModifiedEnd”: “2023-10-01T23:59:59Z”,

// 是否停用和删除标志位

“isBlockup”: 0,

“isDelete”: 0

}在这个请求中,pageIndex和pageSize用于控制分页,确保每次请求的数据量适中,避免一次性加载过多数据导致性能问题。gmtModifiedStart和gmtModifiedEnd字段用于指定查询时间范围,便于实现增量同步。

数据转换与写入

获取到原始数据后,需要对其进行清洗和转换,以符合目标系统的要求。例如,将日期格式统一、去除无效字段等。轻易云平台支持自动填充响应(autoFillResponse),简化了这一过程。

以下是一个简单的数据转换示例:

def transform_data(raw_data):

transformed_data = []

for item in raw_data:

transformed_item = {

'channelId': item['id'],

'channelCode': item['code'],

'channelName': item['name'],

'lastModified': item['gmtModified']

}

transformed_data.append(transformed_item)

return transformed_data通过上述函数,我们将原始数据中的字段重新映射为目标系统所需的格式,并去除了不必要的信息。

实际应用案例

假设我们需要定期同步销售渠道信息,可以设置一个定时任务,每天调用一次该接口,并将获取的数据存储到目标数据库中。以下是一个简单的工作流示例:

- 定时任务触发:每天凌晨执行。

- 调用接口:使用上述请求参数获取当天所有修改过的销售渠道信息。

- 数据清洗与转换:通过自定义函数处理原始数据。

- 写入目标数据库:将处理后的数据批量插入到目标数据库中。

通过这种方式,可以确保销售渠道信息在各个系统间保持一致,提高了数据管理的效率和准确性。

总结来说,通过轻易云平台调用吉客云接口erp.sales.get,可以高效地获取并加工销售渠道信息,为后续的数据处理和分析奠定坚实基础。

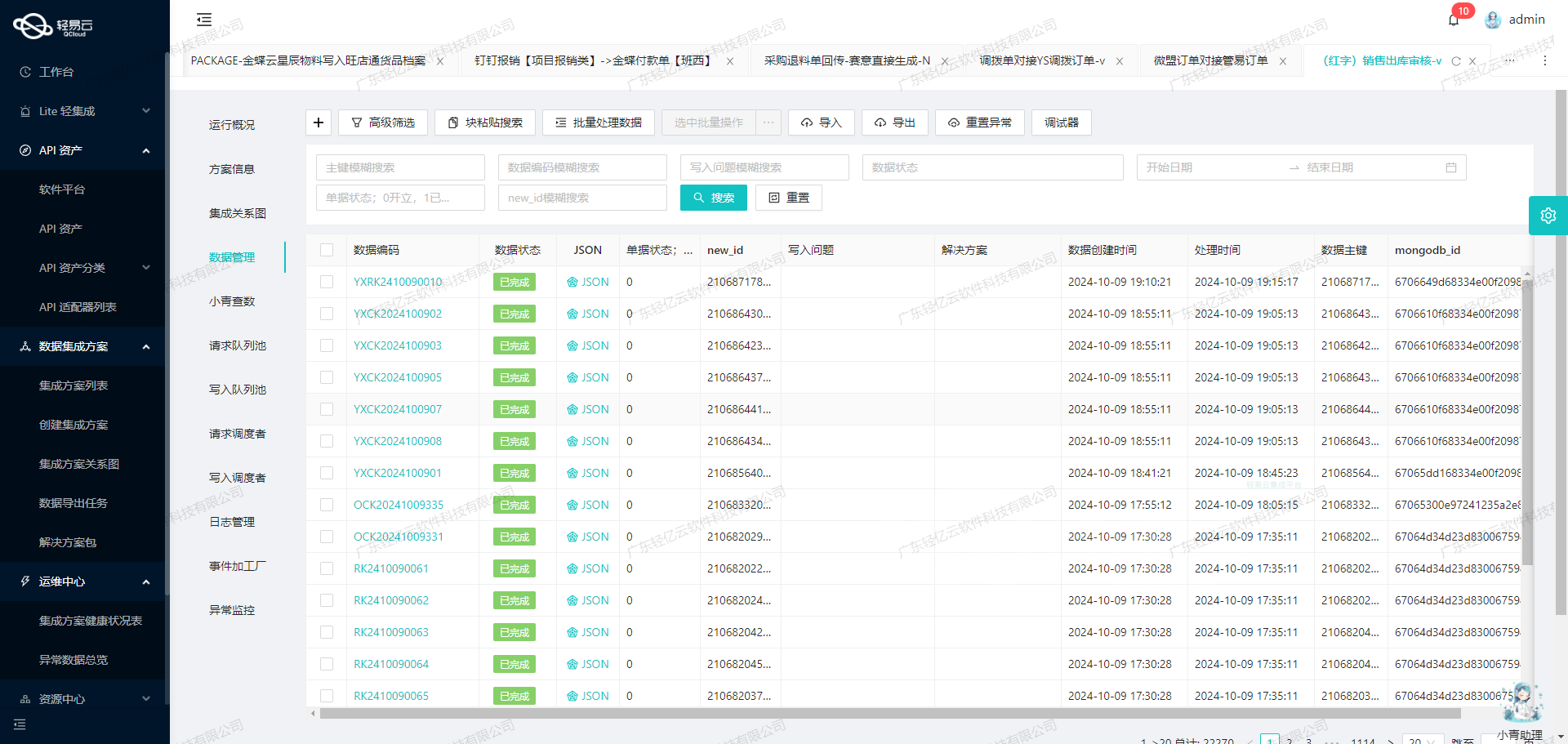

使用轻易云数据集成平台进行ETL转换并写入MySQLAPI接口

在数据集成的生命周期中,ETL(提取、转换、加载)是关键的一步。本文将深入探讨如何使用轻易云数据集成平台,将已经集成的源平台数据进行ETL转换,并最终写入目标平台MySQLAPI接口。

数据请求与清洗

首先,我们从源系统获取销售渠道信息。这些信息可能包括多个字段,如销售渠道ID、渠道编码、销售渠道名称等。在获取这些数据后,需要进行初步的清洗和验证,确保数据的准确性和完整性。

数据转换与写入

在完成数据请求与清洗后,接下来就是将这些数据转换为目标平台能够接受的格式,并通过API接口写入MySQL数据库。以下是详细步骤:

- 定义API接口元数据配置

根据提供的元数据配置,我们需要定义一个POST请求,包含主要参数

main_params和主语句main_sql。这些参数将用于构建最终的SQL插入语句。

{

"api": "execute",

"effect": "EXECUTE",

"method": "POST",

"idCheck": true,

"request": [

{

"field": "main_params",

"label": "主参数",

"type": "object",

"describe": "111",

"value": "1",

"children": [

{"field": "id", "label": "销售渠道id", "type": "int", "value": "{channelId}"},

{"field": "channel_code", "label": "渠道编码", "type": "string", "value": "{channelCode}"},

{"field": "channel_name", "label": "销售渠道名称", "type": "string", "value": "{channelName}"},

{"field": "channel_type", "label": "渠道类型",

...

}

]

}

],

...

}- 构建SQL插入语句

使用元数据中的

main_sql字段,我们可以构建一个REPLACE INTO语句,将清洗后的数据插入到目标表中。

REPLACE INTO `lehua`.`sc_sale_channel`

(

`id`,

`channel_code`,

`channel_name`,

`channel_type`,

`plat_code`,

`plat_name`,

`depart_name`,

`link_man`,

`link_tel`,

`office_address`,

`company_name`,

...

)

VALUES

(

<{id: }>,

<{channel_code: }>,

<{channel_name: }>,

<{channel_type: }>,

<{plat_code: }>,

<{plat_name: }>,

<{depart_name: }>,

...

);- 执行API请求 将构建好的SQL语句通过POST请求发送到MySQLAPI接口。此时需要确保所有字段都已正确映射,并且符合目标数据库的要求。

{

...

{

field: 'main_sql',

label: '主语句',

type: 'string',

describe: '111',

value: 'REPLACE INTO ...'

}

}- 处理响应 在发送请求后,需要处理响应结果。如果成功,则表示数据已成功写入目标数据库;如果失败,则需要根据返回的错误信息进行调试和修正。

技术要点

- 异步处理:确保所有操作都是异步执行,避免阻塞主线程,提高系统性能。

- 错误处理:在每一步操作中加入错误处理机制,确保即使某一步失败,也不会影响整体流程。

- 日志记录:记录每一次操作的详细日志,包括请求参数、响应结果等,以便于后续问题排查和优化。

通过以上步骤,我们可以高效地将源平台的数据进行ETL转换,并通过API接口写入到目标MySQL数据库中。这不仅提高了数据处理效率,也确保了数据的一致性和准确性。