案例分享:[联动]-聚水潭供应商查询

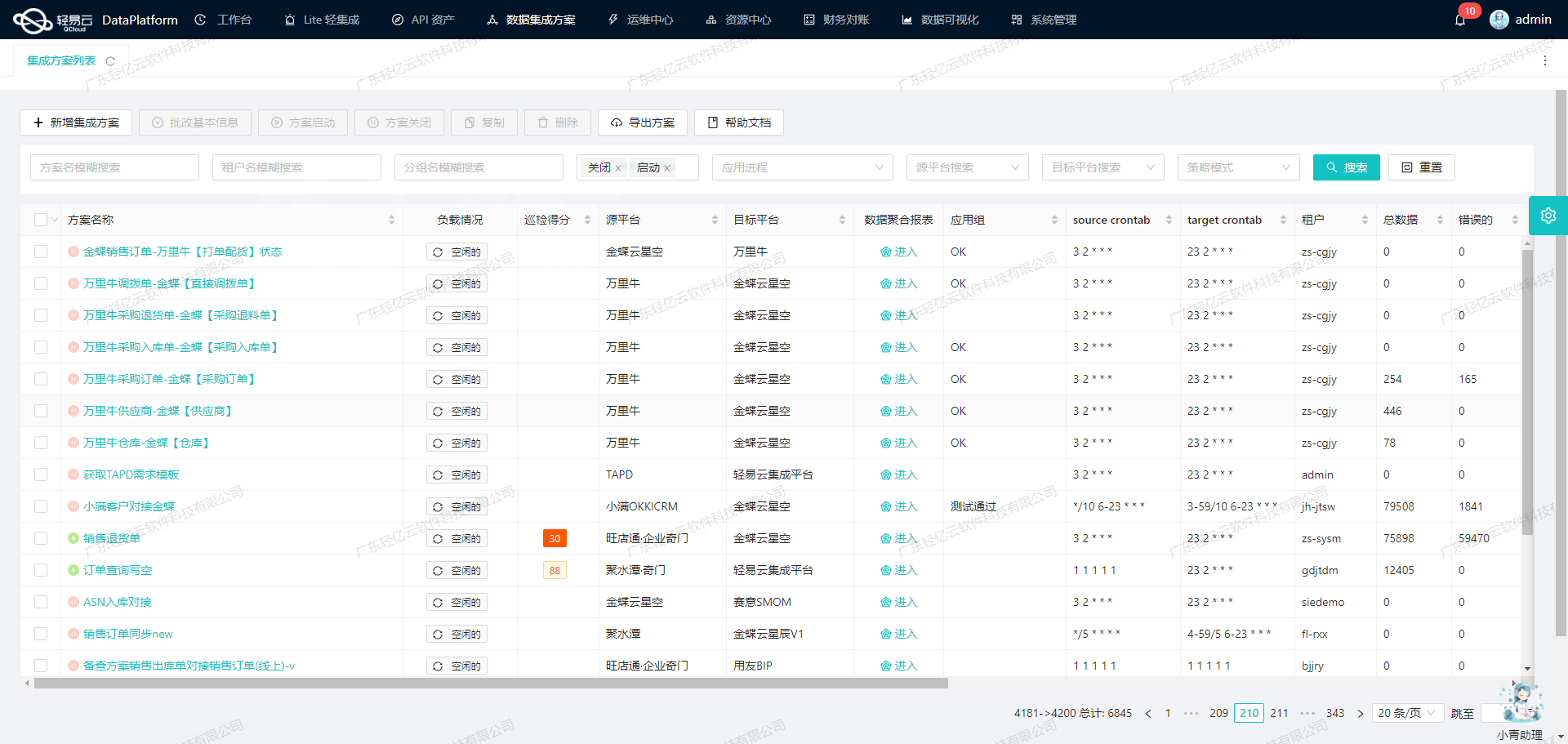

在本文中,我们将探讨如何通过轻易云数据集成平台实现对聚水潭供应商信息的高效抓取和写入。具体来说,我们将详细分析在[联动]-聚水潭供应商查询方案中的技术要点,用以确保数据从聚水潭接口成功获取并无缝传输到轻易云平台。

首先,让我们看一下如何调用聚水潭提供的数据获取接口/open/supplier/query,并处理返回的结果。在这个过程中,必须解决好分页和限流问题,以保证系统稳定性与请求效率。对此,我们采用了分批次抓取方式,通过配置定时任务来可靠地从API端实时拉取最新的数据。这不仅能够防止漏单,还极大提升了数据同步的准确性。

接下来是大量数据快速写入轻易云集成平台的问题。在实际操作中,为确保性能与稳定性,我们选择使用批量提交机制,也就是说,将抓取到的大量供应商信息进行有效打包后,再统一写入目标系统。同时,通过轻易云提供的全透明可视化界面,可以实时监控这些数据流动状态,及时发现及解决潜在异常,提高业务运行效率。

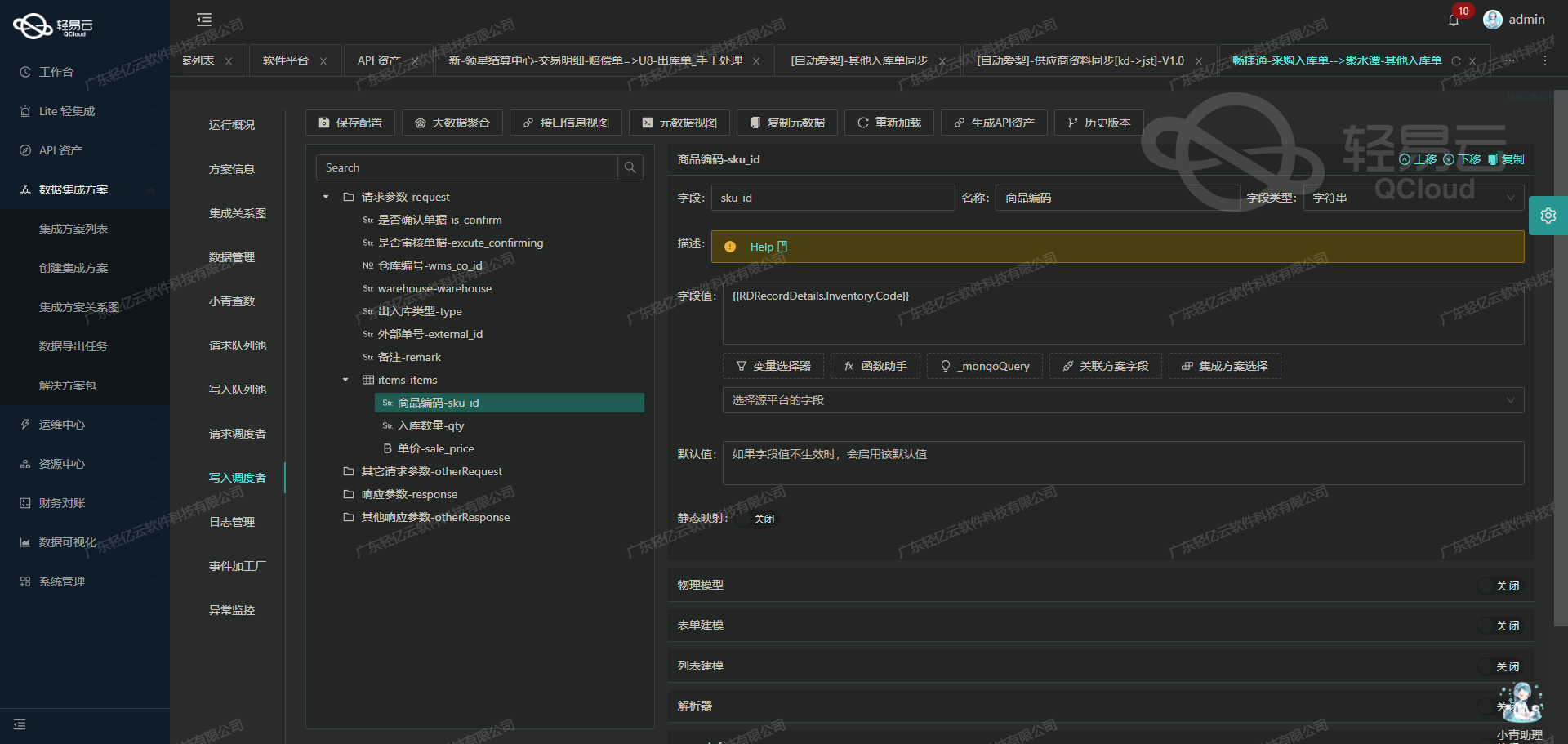

此外,两套系统之间数据格式差异也是一个需要重点考虑的问题。为了应对这一挑战,在整合过程中,对比两者的数据结构,并利用定制化的数据映射功能,将原始JSON格式转为符合目标需求的数据模型,不仅降低了开发难度,也显著提升了转换率和精度。

总体而言,在本案例中,充分发挥了轻易云平台对于实时监控、自动重试机制以及日志记录功能,从而使得整个对接过程更加稳健且高效。在后续章节中会深入剖析每个环节的配置细节及最佳实践方法,为读者提供全面而详细的技术指导。

调用聚水潭接口/open/supplier/query获取并加工数据的技术案例

在轻易云数据集成平台中,调用源系统接口是数据处理生命周期的第一步。本文将深入探讨如何通过调用聚水潭的供应商查询接口/open/supplier/query来获取并加工数据。

接口调用配置

首先,我们需要配置元数据以便正确调用聚水潭的供应商查询接口。以下是元数据配置的详细内容:

{

"api": "/open/supplier/query",

"effect": "QUERY",

"method": "POST",

"number": "supplier_id",

"id": "supplier_id",

"name": "name",

"request": [

{

"field": "page_size",

"label": "默认 30,最大不超过 500",

"type": "string",

"describe": "供应商编码",

"value": "100"

},

{

"field": "page_index",

"label": "第几页,从1 开始",

"type": "string",

"describe": "供应商内部编码",

"value": "1"

},

{

"field": "modified_begin",

"label": "修改起始时间",

"type": "string",

"describe": "供应商名称",

"value": "{{LAST_SYNC_TIME|datetime}}"

},

{

"field": "modified_end",

{

{

label: '修改结束时间',

type: 'string',

value: '{{CURRENT_TIME|datetime}}'

}

}

]

}请求参数解析

page_size: 每页返回的数据条数,默认为30,最大不超过500。page_index: 当前请求的页码,从1开始。modified_begin: 数据修改的起始时间,使用模板变量{{LAST_SYNC_TIME|datetime}}来动态获取上次同步时间。modified_end: 数据修改的结束时间,使用模板变量{{CURRENT_TIME|datetime}}来动态获取当前时间。

这些参数确保了我们可以灵活地分页获取最新修改的数据。

数据请求与清洗

在实际操作中,我们会通过POST方法向/open/supplier/query接口发送请求。以下是一个示例请求体:

{

'page_size': '100',

'page_index': '1',

'modified_begin': '2023-10-01T00:00:00Z',

'modified_end': '2023-10-02T00:00:00Z'

}发送请求后,我们会接收到一个包含供应商信息的数据集。为了确保数据质量和一致性,需要对接收到的数据进行清洗和验证。例如:

- 字段验证:检查每个供应商记录是否包含必要字段,如

supplier_id和name。 - 数据格式化:确保日期、数值等字段符合预期格式。

- 去重处理:如果存在重复记录,需要进行去重操作。

数据转换与写入

经过清洗后的数据需要进行转换,以适应目标系统的数据结构。例如,将聚水潭中的字段映射到目标系统中的相应字段:

{

'supplier_id': 'id',

'name': 'supplier_name',

// 更多字段映射...

}完成转换后,将数据写入目标系统。这一步通常涉及调用目标系统的API或数据库操作。

实时监控与日志记录

在整个过程中,实时监控和日志记录是确保数据集成顺利进行的重要手段。通过轻易云平台提供的可视化界面,可以实时查看数据流动和处理状态,并及时发现和解决潜在问题。

总结来说,通过正确配置元数据并调用聚水潭接口,我们可以高效地获取并加工供应商数据。这一过程不仅提高了业务透明度,还为后续的数据处理打下了坚实基础。

数据集成生命周期中的ETL转换:将源平台数据写入目标平台

在数据集成的生命周期中,ETL(Extract, Transform, Load)转换是至关重要的一步。本文将深入探讨如何利用轻易云数据集成平台,将已经集成的源平台数据进行ETL转换,转为目标平台API接口所能够接收的格式,并最终写入目标平台。

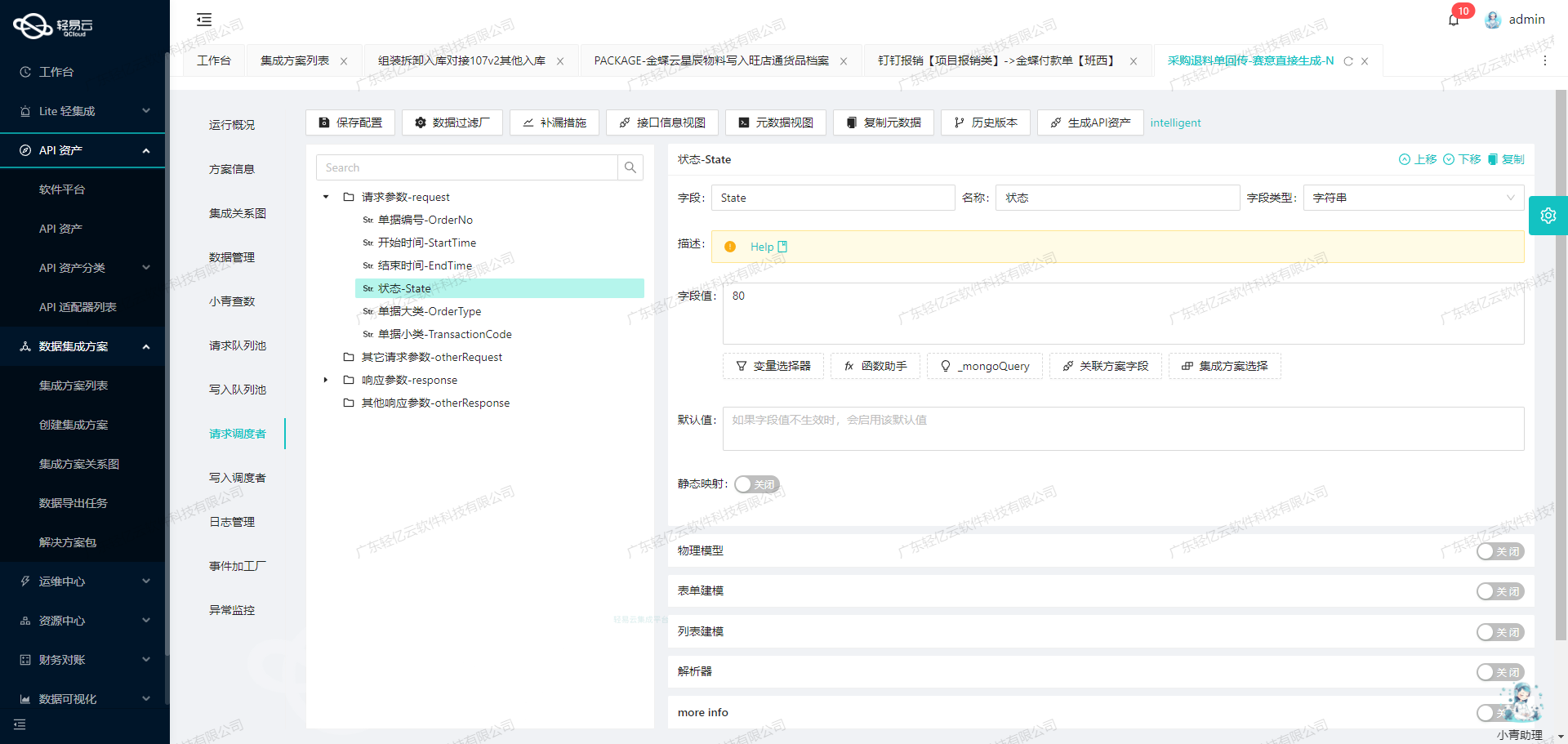

元数据配置解析

在本次技术案例中,我们使用的元数据配置如下:

{

"api": "写入空操作",

"effect": "EXECUTE",

"method": "POST",

"number": "number",

"id": "id",

"name": "编码",

"idCheck": true

}该元数据配置定义了API接口的基本参数和行为。以下是对各个字段的详细解释:

api: 指定API操作名称,这里为“写入空操作”。effect: 定义操作效果,这里为“EXECUTE”,表示执行操作。method: HTTP请求方法,这里为“POST”。number,id,name: 对应API接口所需的字段映射,分别对应于源数据中的number、id和编码。idCheck: 布尔值,表示是否需要进行ID检查,这里设置为true。

数据转换与写入流程

-

数据提取(Extract): 从源平台提取原始数据。假设我们从聚水潭供应商查询接口获取到以下原始数据:

[ {"number": "001", "id": "1001", "编码": "A001"}, {"number": "002", "id": "1002", "编码": "A002"} ] -

数据清洗与转换(Transform): 根据元数据配置,将提取的数据进行清洗和转换,以符合目标平台API接口的要求。在这个过程中,需要确保每条记录都包含必要的字段,并且字段名称与目标API一致。

转换后的数据示例:

[ {"number": "001", "id": "1001", "name": "A001"}, {"number": "002", "id": "1002", "name": "A002"} ] -

ID检查: 在执行写入操作之前,根据

idCheck字段进行ID检查,以确保没有重复或冲突。如果发现重复ID,可以选择更新已有记录或跳过该条记录。 -

数据加载(Load): 使用HTTP POST方法将转换后的数据写入目标平台。根据元数据配置中的API信息,构建HTTP请求:

请求URL:

https://example.com/api/写入空操作请求体示例:

{ "data": [ {"number": "001", "id": "1001", "name": "A001"}, {"number": "002", "id": "1002", "name": "A002"} ] } -

执行操作: 发送HTTP请求并处理响应。确保每次请求都成功执行,并处理可能出现的错误。例如,如果返回状态码不是200,则需要记录错误日志并重试。

实际案例应用

在实际应用中,我们可以通过编写脚本或使用轻易云提供的工具来自动化上述过程。以下是一个简单的Python示例,用于演示如何将转换后的数据通过HTTP POST方法写入目标平台:

import requests

import json

# 转换后的数据

data = [

{"number": '001', 'id': '1001', 'name': 'A001'},

{"number": '002', 'id': '1002', 'name': 'A002'}

]

# API URL

url = 'https://example.com/api/写入空操作'

# HTTP POST请求头

headers = {'Content-Type': 'application/json'}

# 构建请求体

payload = {'data': data}

# 发送请求并处理响应

response = requests.post(url, headers=headers, data=json.dumps(payload))

if response.status_code == 200:

print('Data successfully written to the target platform.')

else:

print(f'Failed to write data. Status code: {response.status_code}, Response: {response.text}')通过以上步骤,我们实现了从源平台到目标平台的数据ETL转换和加载。这不仅提高了系统间的数据一致性,还简化了复杂的数据处理流程,为业务决策提供了可靠的数据支持。