聚水潭·奇门数据集成到MySQL的技术实施案例

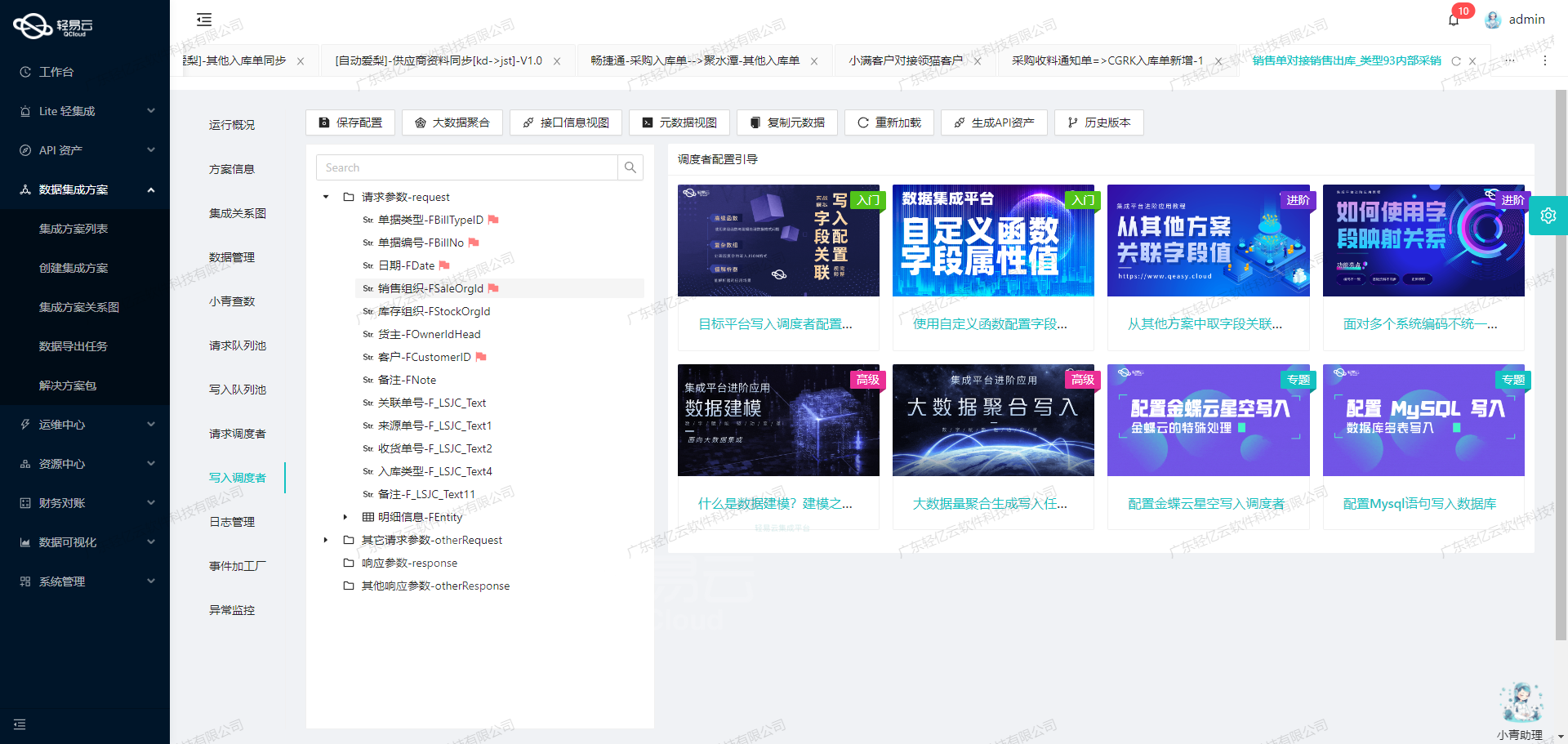

在数据驱动业务决策的过程中,高效、准确的数据集成显得尤为重要。本文将分享一个实际运行的系统对接集成方案:聚水潭-销售出库单-->BI崛起-销售出库表_copy,通过这个案例探讨如何利用轻易云数据集成平台,将聚水潭·奇门中的销售出库单数据快速、安全地写入到MySQL数据库中。

背景描述

在此次项目中,我们需要从聚水潭·奇门获取销售出库单,并将这些数据批量插入到MySQL数据库中,以便后续进行深入的数据分析和业务智能化应用。整个过程涉及API调用、分页处理、限流机制、自定义转换逻辑以及可靠的数据质量监控等多个技术要点。

技术实现要点

-

API调用与接口管理

- 获取数据API: 我们使用

jushuitan.saleout.list.query接口从聚水潭·奇门系统提取销售出库单信息。 - 写入数据API: 使用MySQL提供的

batchexecute接口,实现高效的大量数据插入操作。

- 获取数据API: 我们使用

-

分页处理与限流机制 数据抓取过程中,为了避免性能瓶颈和超时问题,我们设计了合理的分页策略。同时,通过设置请求速率限制,确保不会因为过度频繁访问而导致服务不可用或响应失败。

-

自定义转换逻辑 由于源端和目标端的数据格式有所不同,我们制定了一套自定义转换规则,使得每条记录能够无缝匹配MySQL表结构。在此过程中,还需特别注意日期格式、数值类型及特殊字符等字段细节的处理,以保证导入后的数据一致性和完整性。

-

实时监控与告警系统 集成任务期间,通过轻易云平台提供的集中监控功能,对各个环节进行实时追踪。一旦发现异常情况,如网络故障或API返回错误,即可触发相应告警,并启动重试机制以最大程度降低失败率。

-

批量写入能力 MySQL数据库支持高吞吐量的数据写入,这使我们能高效解决大量订单同步的问题,在短时间内完成大规模交易记录更新,提高系统整体运行效率。此外,还借助轻易云平台提供的一些辅助工具,如日志记录及自动化脚本,进一步提升任务执行成功率并简化运维工作流程。

通过逐步解析上述关键技术要点,本案例详细展示了如何利用当下先进的数据集成工具,有效打通企业内部异构系统之间的信息壁

调用聚水潭·奇门接口获取并加工数据的技术案例

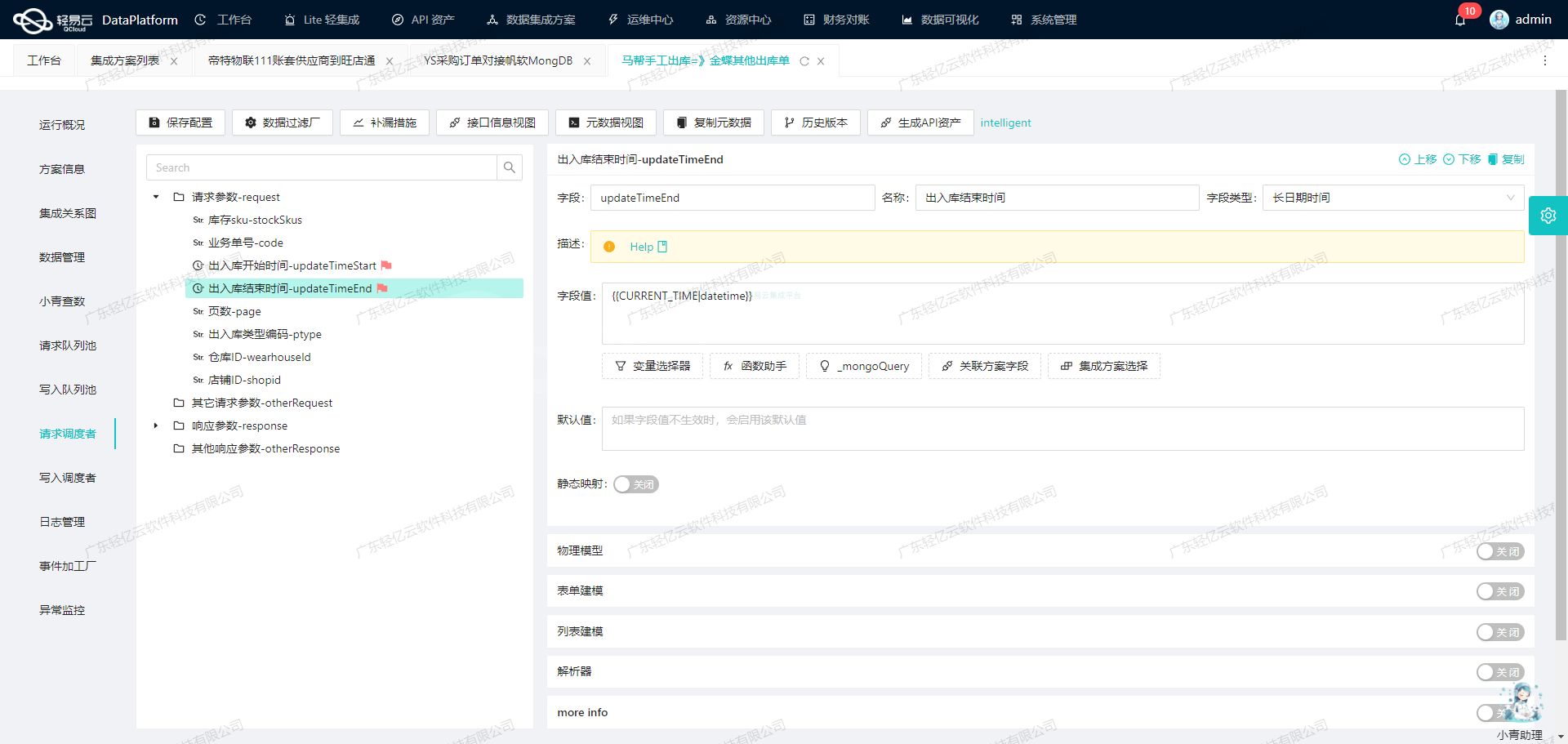

在数据集成生命周期的第一步,我们需要调用聚水潭·奇门接口 jushuitan.saleout.list.query 来获取销售出库单数据,并对其进行初步加工。以下是详细的技术实现过程。

接口调用配置

首先,我们需要配置接口调用的元数据。根据提供的元数据配置,我们可以看到该接口采用 POST 方法进行请求,主要参数包括页数、每页行数、修改开始时间、修改结束时间、单据状态和时间类型等。

{

"api": "jushuitan.saleout.list.query",

"effect": "QUERY",

"method": "POST",

"number": "io_id",

"id": "{io_id}{modified}",

"name": "name",

"idCheck": true,

"request": [

{"field": "page_index", "label": "页数", "type": "string", "describe": "第几页,从第一页开始,默认1", "value": "1"},

{"field": "page_size", "label": "每页行数", "type": "string", "describe": "每页多少条,默认25,最大50", "value": "100"},

{"field": "start_time", "label": "修改开始时间", "type": "string",

"describe": "修改起始时间,和结束时间必须同时存在,时间间隔不能超过七天,与线上单号不能同时为空",

"value":"_function LEFT( '{{DAYS_AGO_1|datetime}}' , 10)"},

{"field": "end_time",

"label":"修改结束时间","type":"string","describe":"修改结束时间,和起始时间必须同时存在,时间间隔不能超过七天,与线上单号不能同时为空","value":"_function LEFT( '{{CURRENT_TIME|datetime}}' , 10)"},

{"field":"status","label":"单据状态","type":"string","describe":"单据状态: WaitConfirm=待出库; Confirmed=已出库; Cancelled=作废"},

{"field":"date_type","label":"时间类型","type":"string"}

],

"autoFillResponse": true,

"beatFlat":["items"]

}数据请求与清洗

在实际操作中,我们需要根据业务需求设置请求参数,例如分页信息、时间范围和单据状态等。以下是一个示例请求:

{

"_api_name_": "/jushuitan/saleout/list/query",

"_method_": "/POST",

"_params_":{

"page_index":"1",

"page_size":"100",

"start_time":"2023-09-01",

"end_time":"2023-09-07",

"status":"Confirmed"

}

}在这个请求中,我们设置了分页信息为第一页,每页100条记录,并且查询2023年9月1日至9月7日期间已确认的销售出库单。

数据转换与写入

获取到原始数据后,需要对其进行清洗和转换,以便后续写入目标系统。在轻易云平台中,可以通过自定义脚本或内置函数来实现数据清洗。例如,将日期格式统一转换为目标系统所需的格式,或者过滤掉不必要的字段。

def clean_data(raw_data):

cleaned_data = []

for record in raw_data:

cleaned_record = {

'order_id': record['io_id'],

'order_date': record['modified'],

'customer_name': record['name'],

# 添加其他必要字段

}

cleaned_data.append(cleaned_record)

return cleaned_data上述代码示例展示了如何将原始数据中的 io_id 和 modified 字段提取并重命名为 order_id 和 order_date,以符合目标系统的数据格式要求。

自动填充响应

在元数据配置中,我们设置了 autoFillResponse: true 和 beatFlat: ["items"]。这意味着平台会自动处理嵌套结构的数据,将其扁平化并填充到响应中。这一步骤极大简化了开发者的工作量,使得数据处理更加高效。

通过上述步骤,我们完成了从聚水潭·奇门接口获取销售出库单数据并进行初步加工的全过程。在实际项目中,还可以根据具体需求进一步优化和扩展这些操作,以满足复杂的数据集成需求。

数据集成平台生命周期中的ETL转换与写入MySQL

在数据集成平台的生命周期中,ETL(Extract, Transform, Load)是至关重要的一环。本文将重点探讨如何将已经集成的源平台数据通过ETL转换为目标平台MySQL API接口所能接收的格式,并最终写入目标平台。

1. 数据请求与清洗

在进行ETL转换之前,我们首先需要从源系统请求数据并进行初步清洗。这一步骤确保了数据的完整性和一致性,为后续的转换和写入奠定基础。

2. 数据转换与写入

在数据清洗完成后,我们进入数据转换与写入阶段。此阶段主要涉及将清洗后的数据转化为目标平台所需的格式,并通过API接口写入MySQL数据库。

2.1 元数据配置解析

根据提供的元数据配置,我们需要将源系统的数据字段映射到目标系统的字段。以下是元数据配置中的关键部分:

{

"api": "batchexecute",

"effect": "EXECUTE",

"method": "SQL",

"number": "id",

"id": "id",

"name": "id",

"idCheck": true,

...

}该配置表明我们将使用batchexecute API,通过执行SQL语句来批量插入或更新数据。effect字段指定了操作类型为执行(EXECUTE),而method字段则表明我们将使用SQL语句进行操作。

2.2 字段映射与转换

元数据配置中详细列出了每个字段的映射关系。例如:

{

"field": "id",

"label": "主键",

"type": "string",

"value": "{o_id}-{items_ioi_id}-{modified}"

},

{

"field": "co_id",

"label": "公司编号",

"type": "string",

"value": "{co_id}"

},

...这些字段定义了从源系统到目标系统的数据映射关系。我们需要根据这些定义,将源系统的数据字段转换为目标系统所需的格式。

2.3 SQL语句生成

根据元数据配置中的main_sql字段,我们可以生成用于插入或更新数据的SQL语句:

REPLACE INTO saleout_list_query(

id, co_id, shop_id, io_id, o_id, so_id, created, modified, status,

invoice_title, shop_buyer_id, receiver_country, receiver_state,

receiver_city, receiver_district, buyer_message, remark,

is_cod, pay_amount, l_id, io_date, lc_id, stock_enabled,

labels, paid_amount, free_amount, freight, weight,

warehouse, drp_co_id_from, f_weight, order_type,

open_id, is_print_express, is_print,

drp_info,buyer_tax_no,

logistics_company,sns_sku_id,sns_sn,

merge_so_id,wms_co_id,

items_i_id,

items_sale_base_price,

items_is_gift,

items_oi_id,

items_outer_oi_id,

items_raw_so_id,

items_pay_amount,

items_combine_sku_id,

items_ioi_id,

items_sku_id,

items_qty,

items_name,

items_properties_value,

items_sale_price,

items_sale_amount,

shop_name,f_freight,business_staff,currency,node,pay_date,seller_flag,wave_id

) VALUES (?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?)在实际操作中,我们会用具体的数据值替换上述SQL语句中的占位符(?)。

2.4 批量执行与限制

为了提高效率,通常会采用批量执行的方法。元数据配置中的limit字段指定了每次批量操作的数据条数:

{

"field":"limit",

"label":"limit",

"type":"string",

"value":"1000"

}这意味着每次批量操作最多处理1000条记录,以避免一次性处理过多数据导致性能问题。

实际案例分析

假设我们从源系统获取了一批销售出库单的数据,需要将其写入到MySQL数据库中。以下是一个具体的操作步骤:

- 获取源系统数据:通过API或数据库查询获取销售出库单的数据。

- 清洗与预处理:对获取的数据进行清洗,去除无效或重复的数据。

- 字段映射与转换:根据元数据配置,将源系统的数据字段转换为目标系统所需的格式。

- 生成SQL语句:根据转换后的数据生成相应的SQL插入或更新语句。

- 批量执行:通过API接口批量执行生成的SQL语句,将数据写入MySQL数据库。

通过上述步骤,我们可以高效地完成从源系统到目标系统的数据集成,实现不同系统间的数据无缝对接。这不仅提高了业务流程的透明度和效率,也确保了数据的一致性和准确性。