聚水潭·奇门数据集成到金蝶云星空的技术实践分享

在当前数字化转型背景下,企业对系统之间的无缝数据流动需求愈发迫切。本次我们将聚焦于一个实际运行的系统集成案例,即将聚水潭·奇门中的销售出库数据高效同步至金蝶云星空平台。具体方案名称为:[自动]-04销售出库同步(BAMGSYL内衣)。本文旨在分享这一过程中的关键技术实现与注意点。

项目概述

本项目主要任务是通过轻易云数据集成平台,将聚水潭·奇门中获取的销售出库信息写入到金蝶云星空,实现业务数据从订单处理到财务管理的一体化。此过程中,我们使用了jushuitan.saleout.list.query接口来定时抓取聚水潭·奇门的数据,同时调用金蝶云星空的batchSave接口进行批量写入。

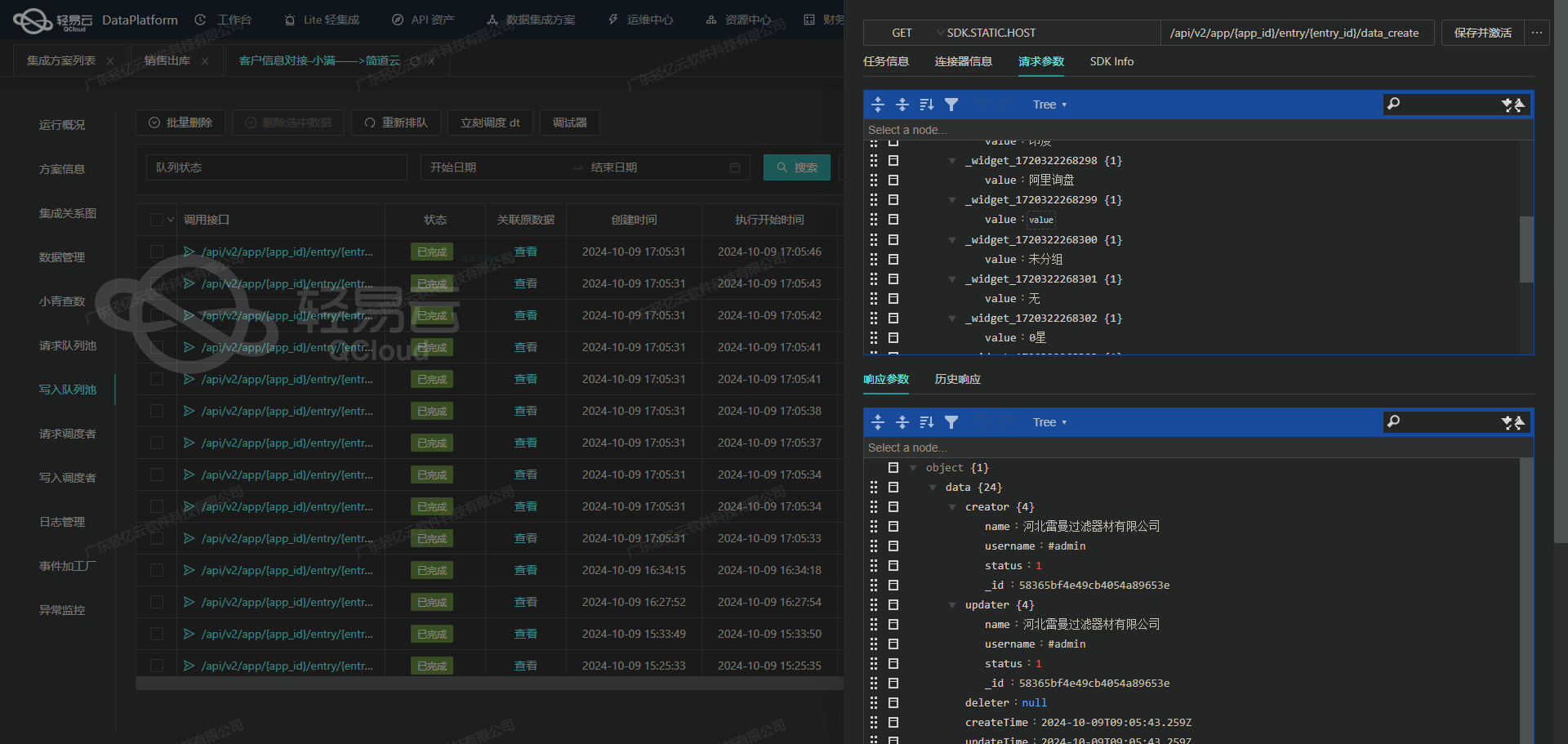

数据不漏单保障机制

为了确保每一条销售记录都能被成功同步,避免出现漏单问题,我们设置了一系列防护措施。轻易云提供了实时监控和日志记录功能,使得整个流程透明可视,并且能够准确定位任意环节可能存在的问题。当调用jushuitan.saleout.list.query接口进行分页抓取时,我们利用限流策略来保证接口稳定性,并在每一次请求完成后核对返回结果,确保所有数据都已正确获取。

批量快速写入与错误处理机制

针对大量数据需快速写入至金蝶云星空,我们采用了有效的批量操作策略。在调用batchSave API时,通过分批次提交大幅提升性能。此外,为提高可靠性,每个批次操作均嵌入重试和失败回滚逻辑,以应对临时性的网络或服务异常。这使得即便遇到突发问题,也能最大限度保证整体流程顺利进行。

数据格式差异及映射定制化实施

由于两个平台间的数据结构差异较大,需要提前设计好字段映射关系并进行适当的数据转换。例如,在接收到聚水潭·奇门返回的数据后,根据预定义规则调整字段类型、名称以及对应值范围,再按照金蝶云星空所要求的格式构建最终上传报文,以确保目标系统能够正确识别并存储这些信息。同时,为应对复杂场景下的一些特例情况,还引入了自定义映射配置以求灵活适用不同业务需求。

以上为我们此次项目开篇介绍部分,接下来会进一步详细阐述各模块具体实现步骤及相关代码示例,希望能为从事类似工作的开发者提供有价值参考与借鉴

调用聚水潭·奇门接口jushuitan.saleout.list.query获取并加工数据

在数据集成生命周期的第一步中,调用源系统接口获取数据是至关重要的环节。本文将详细探讨如何通过轻易云数据集成平台调用聚水潭·奇门接口jushuitan.saleout.list.query来获取销售出库数据,并进行初步加工。

接口调用配置

首先,我们需要配置API调用的元数据。以下是具体的元数据配置:

{

"api": "jushuitan.saleout.list.query",

"method": "POST",

"number": "io_id",

"id": "io_id",

"pagination": {

"pageSize": 25

},

"idCheck": true,

"request": [

{

"field": "page_index",

"label": "页数",

"type": "string",

"describe": "第几页,从第一页开始,默认1",

"value": "1"

},

{

"field": "page_size",

"label": "每页行数",

"type": "string",

"describe": "每页多少条,默认25,最大25",

"value": "50"

},

{

"field": "start_time",

"label": "修改开始时间",

"type": "string",

"describe": "修改起始时间,和结束时间必须同时存在,时间间隔不能超过七天,与线上单号不能同时为空",

"value": "{{LAST_SYNC_TIME|datetime}}"

},

{

"field": "end_time",

{

...请求参数解析

page_index: 页数,从第一页开始。默认值为1。page_size: 每页行数,默认25条,最大25条。这里我们设置为50以便一次性获取更多数据。start_time和end_time: 修改的起始和结束时间。这两个字段必须同时存在,并且时间间隔不能超过七天。通过使用模板变量{{LAST_SYNC_TIME|datetime}}和{{CURRENT_TIME|datetime}}动态设置这两个时间参数。status: 单据状态,这里我们选择已出库状态(Confirmed)。shop_id: 店铺ID,用于指定具体店铺的数据。

数据请求与清洗

在完成API调用配置后,我们可以通过轻易云平台发起请求并获取返回的数据。以下是一个示例请求体:

{

...

{

...

{

...

...

...

...

...

...

...

...数据转换与写入

一旦成功获取到销售出库数据,需要对其进行必要的清洗和转换,以便后续写入目标系统。在这个过程中,可以利用轻易云平台提供的各种工具和功能,如字段映射、数据格式转换等。

例如,将返回的数据结构化为目标系统所需的格式:

{

...

}异常处理与补偿机制

在实际操作中,可能会遇到各种异常情况,如网络问题、接口超时等。为了确保数据集成过程的可靠性,可以设置定时任务(如crontab)来定期检查并补偿遗漏的数据请求。

{

...

}通过上述步骤,我们可以高效地调用聚水潭·奇门接口获取销售出库数据,并进行必要的数据清洗和转换,为后续的数据写入做好准备。这不仅提高了业务流程的透明度和效率,也确保了数据的一致性和完整性。

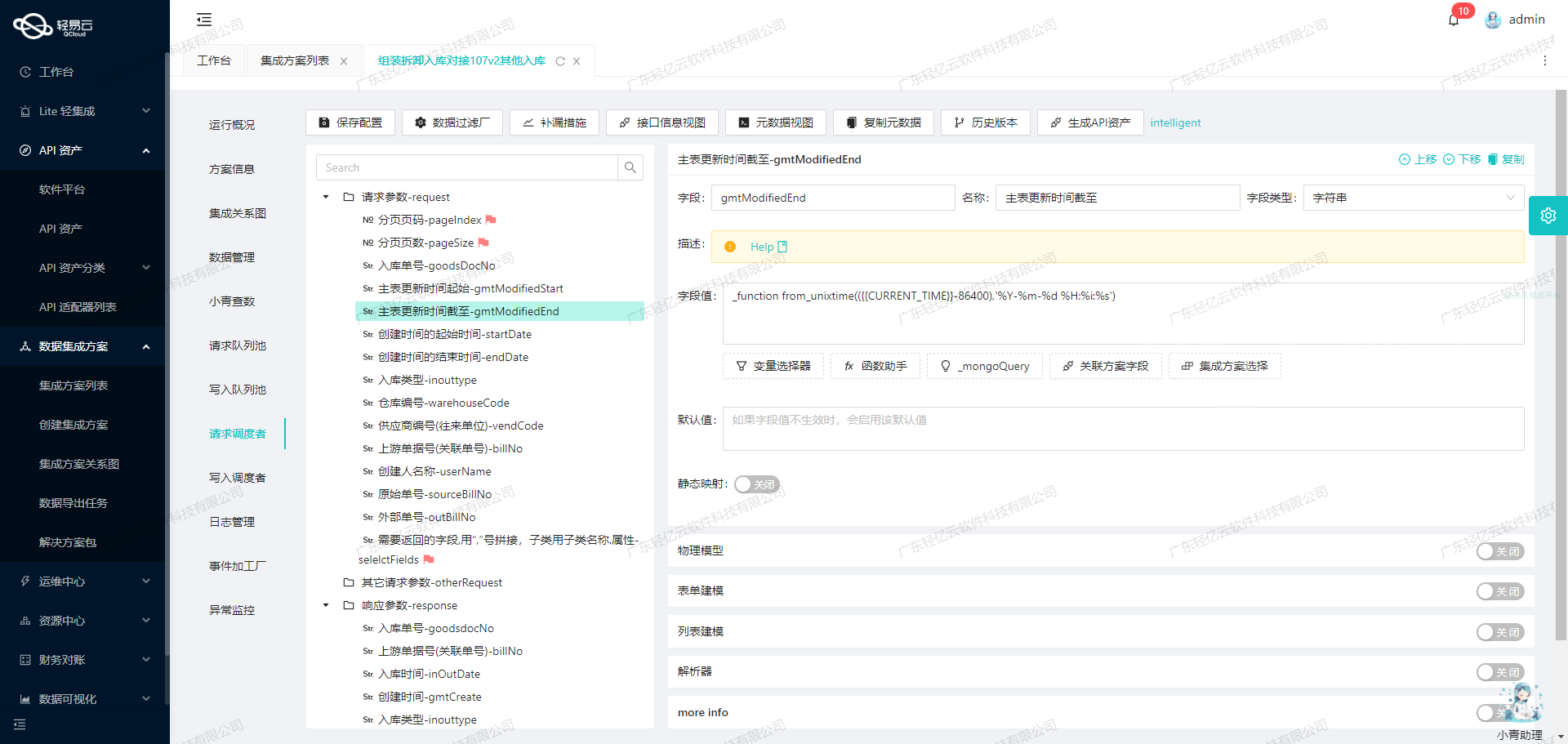

使用轻易云数据集成平台进行ETL转换并写入金蝶云星空API接口

在轻易云数据集成平台中,完成数据请求与清洗后,下一步便是将这些源数据进行ETL转换,并转为目标平台——金蝶云星空API接口所能接收的格式,最终写入目标平台。本文将详细探讨这一过程中涉及的技术细节和配置方法。

元数据配置解析

首先,我们需要理解元数据配置中的各个字段及其含义。以下是一个典型的元数据配置示例:

{

"api": "batchSave",

"method": "POST",

"idCheck": true,

"operation": {

"rowsKey": "array",

"rows": 40,

"method": "batchArraySave"

},

"request": [

{

"field": "FBillTypeID",

"label": "单据类型",

...

},

...

],

...

}- API和Method:

api字段指定了调用的金蝶云API接口名称,这里是batchSave。method字段指定了HTTP请求方法,这里使用的是POST。 - ID检查:

idCheck字段为布尔值,用于指示是否需要对ID进行检查。 - 操作参数:

operation字段定义了批量操作的参数,包括数组键、每批次处理的行数等。

请求参数详解

在request数组中,每个对象代表一个需要传递给金蝶云API的字段。以下是几个关键字段及其配置:

-

单据类型 (FBillTypeID):

{ "field": "FBillTypeID", "label": "单据类型", "type": "string", ... "value": "XSCKD01_SYS" }此字段用于指定单据类型,固定值为“XSCKD01_SYS”。

-

单据编号 (FBillNo):

{ "field": "FBillNo", ... "value": "{io_id}" }单据编号使用占位符

{io_id},将在运行时替换为实际值。 -

日期 (FDate):

{ "field": "FDate", ... "value": "{io_date}" }日期同样使用占位符

{io_date}动态替换。 -

销售组织 (FSaleOrgId):

{ ... "value": "_function case '{shop_id}' when '10593320' then '100' else '101' end" }销售组织根据店铺ID (

{shop_id}) 动态映射到具体组织代码。

明细信息处理

明细信息 (FEntity) 是一个数组,每个元素包含多个子字段,如物料编码、含税单价、实发数量等:

-

物料编码 (FMaterialID):

{ ... "value": "{{items.sku_id}}" }使用占位符

{{items.sku_id}}动态替换。 -

含税单价 (FTaxPrice):

{ ... "value": "{{items.sale_price}}" } -

实发数量 (FRealQty):

{ ... "value": "{{items.qty}}" }

财务信息处理

财务信息 (SubHeadEntity) 包含整单折扣额等字段:

- 整单折扣额 (FAllDisCount):

{ ... "value": "{free_amount}" }

执行操作

最后,通过其他请求参数 (otherRequest) 配置执行操作:

-

业务对象表单Id:

{ ... "value":"SAL_OUTSTOCK" } -

提交并审核:

{ ... "value":"true" }

数据转换与写入流程

- 数据准备:首先,将源平台的数据通过轻易云的数据请求与清洗功能获取并预处理。

- ETL转换:根据上述元数据配置,将预处理后的数据进行ETL转换,映射到金蝶云星空API所需的格式。

- API调用:使用HTTP POST方法,将转换后的数据批量发送至金蝶云星空API接口。

- 结果处理:实时监控API调用结果,并根据返回状态进行相应处理,如提交并审核操作。

通过以上步骤,我们可以高效地将源平台的数据转换并写入目标平台,实现不同系统间的数据无缝对接。这一过程不仅提高了数据集成的效率,还确保了业务流程的透明度和准确性。