钉钉数据集成到MySQL的技术实践

在企业信息化应用中,数据的高效流动和及时处理是提升业务竞争力的重要环节。本案例分享的是通过轻易云数据集成平台,将钉钉系统中的付款单数据无缝对接至MySQL数据库,实现dd-新付款单(其他业务付款单)-->mysql(鸿巢付款单)的自动化处理。

此次实施主要关注以下几个方面:

-

定时可靠的数据抓取:定期从钉钉API

v1.0/yida/processes/instances获取最新的付款单据,确保不漏掉任何重要数据。我们采用了批量抓取机制,有效应对接口分页和限流问题。 -

高吞吐量的数据写入能力:使用MySQL提供的

executeAPI,在保证性能稳定前提下,快速将大量付款单信息写入至指定表中。这种方式不仅加快了处理速度,也确保了大规模并发传输环境下的数据一致性。 -

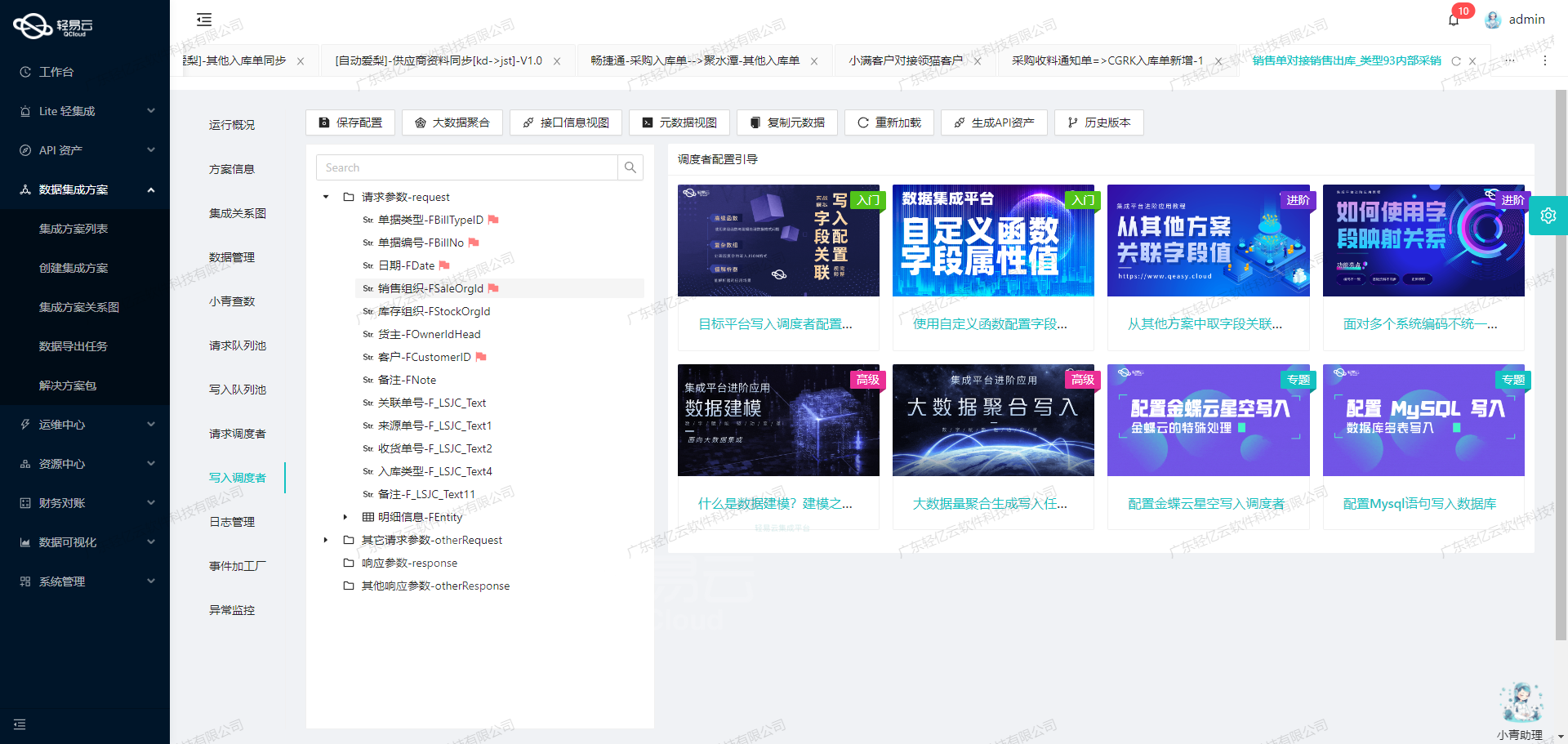

可视化设计与自定义转换逻辑:借助轻易云平台提供的直观工具,我们针对特定业务需求,自定义了从钉钉到MySQL的数据映射逻辑。这包括字段格式转换、必要的数据清洗及规范校准等操作,使得两者之间的数据连接更加顺畅规范。

-

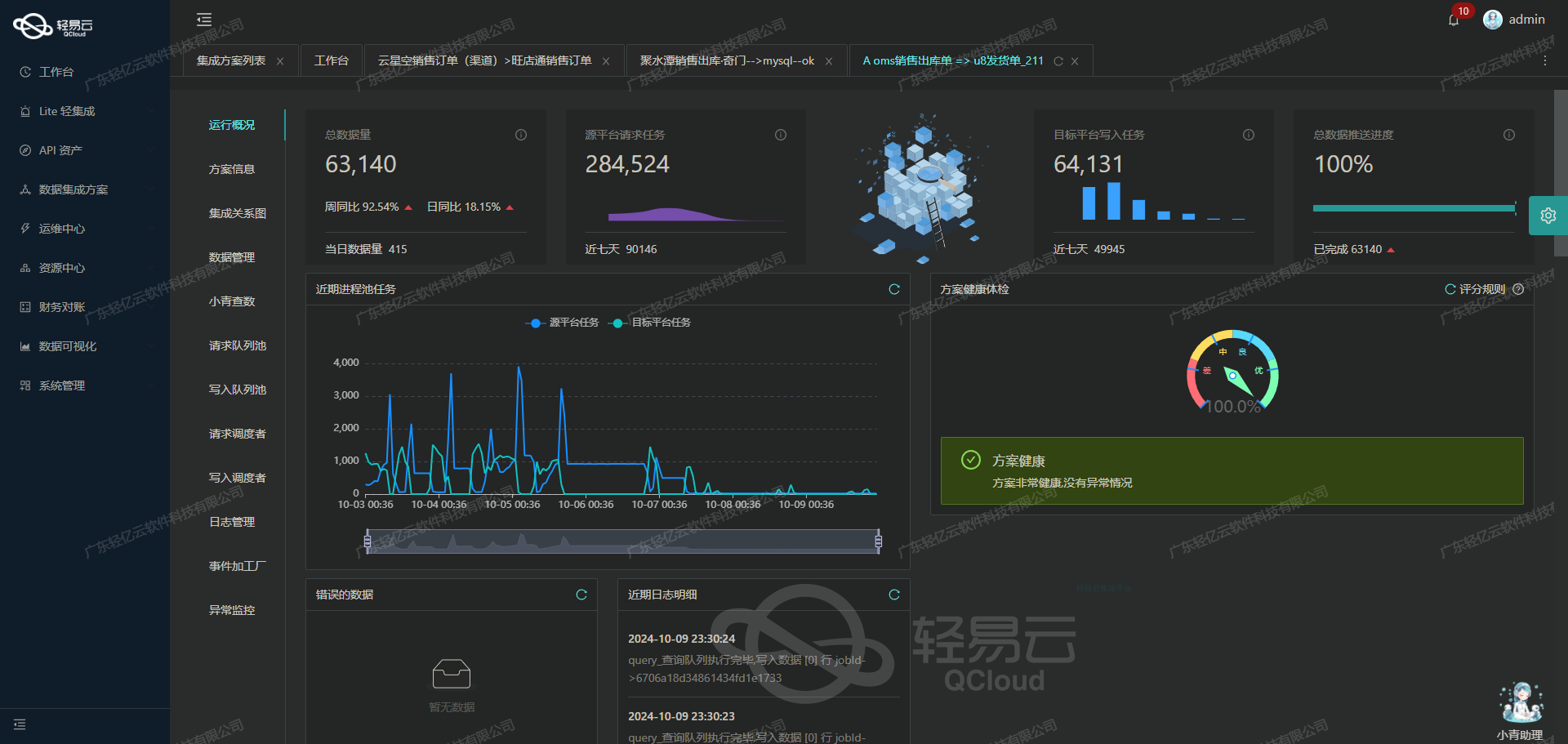

实时监控与异常处理:项目设置了一套完整的监控和告警系统,对任务执行情况进行全面跟踪。一旦检测到异常,如网络超时或接口报错,即触发重试机制,以最大限度减少人为干预,提高整体流程稳定性和可靠性。

该方案在实际应用中的表现证明了其高效、高可靠性的优越特性,为企业关键业务系统间的数据交互提供了一条安全稳妥之路。后续章节将详细讲解具体实现步骤及关键技术点。

调用钉钉接口获取并加工数据的技术案例

在数据集成过程中,调用源系统接口是至关重要的一步。本文将详细探讨如何通过轻易云数据集成平台调用钉钉接口v1.0/yida/processes/instances,获取并加工数据,以实现数据的无缝对接和高效处理。

接口调用配置

首先,我们需要配置API调用的元数据。以下是具体的元数据配置:

{

"api": "v1.0/yida/processes/instances",

"method": "POST",

"number": "title",

"id": "processInstanceId",

"beatFlat": ["tableField_lgm25d9j"],

"pagination": {"pageSize": 100},

"idCheck": true,

"formatResponse": [

{"old": "dateField_lgn3helb", "new": "datetime_new", "format": "date"},

{"old": "serialNumberField_lgm25d8r", "new": "order_no_new", "format": "string"}

],

"request": [

{"field": "pageSize", "label": "分页大小", "type": "string", "describe":"分页大小", "value":"50"},

{"field": "pageNumber", "label":"分页页码", "type":"string", "describe":"分页页码", "value":"1"},

{"field":"appType","label":"应用ID","type":"string","describe":"应用ID","value":"APP_WTSCMZ1WOOHGIM5N28BQ"},

{"field":"systemToken","label":"应用秘钥","type":"string","describe":"应用秘钥","value":"IS866HB1DXJ8ODN3EXSVD750RBTK2X72R8MELL4"},

{"field":"userId","label":"用户的userid","type":"string","describe":"用户的userid","value":"16000443318138909"},

{"field":"language","label":"语言","type":"string","describe":"语言,取值:zh_CN:中文(默认值)en_US:英文"},

{"field":"formUuid","label":"表单ID","type":"string","describe":"表单ID","value":"FORM-UX866Q61RUV939TLEWG9H4HX25523ZRQNXLGLW"},

{

"field": "searchFieldJson",

"label": "条件",

"type": "object",

...

},

...

],

...

}请求参数详解

在上述配置中,request字段定义了API请求所需的参数,包括分页大小、分页页码、应用ID、应用秘钥、用户ID、语言、表单ID等。以下是几个关键参数的解释:

- pageSize: 每次请求返回的数据条数,这里设置为50。

- pageNumber: 当前请求的页码,从1开始。

- appType: 应用ID,用于标识具体的钉钉应用。

- systemToken: 应用秘钥,用于验证API请求的合法性。

- userId: 用户ID,用于标识具体的用户。

- language: 请求返回的数据语言,这里默认为中文(zh_CN)。

- formUuid: 表单ID,用于指定要查询的数据表单。

条件过滤与格式化响应

在searchFieldJson字段中,我们可以定义查询条件。例如,可以根据费用分类、流水号和申请人等字段进行过滤。同时,通过condition字段,可以进一步细化查询条件,如费用分类必须属于特定范围且日期字段不能为空。

为了便于后续处理,我们还可以对响应数据进行格式化。在formatResponse字段中,定义了两个格式化规则:

- 将原始日期字段

dateField_lgn3helb转换为新的日期字段datetime_new。 - 将原始流水号字段

serialNumberField_lgm25d8r转换为新的订单号字段order_no_new。

数据请求与清洗

通过上述配置,我们可以发起API请求并获取原始数据。接下来,需要对数据进行清洗和转换,以便写入目标系统(如MySQL数据库)。清洗过程包括:

- 去重:根据唯一标识符(如

processInstanceId)去除重复记录。 - 格式转换:根据预定义规则,将日期和字符串等字段进行格式转换。

- 结构调整:将嵌套结构的数据平铺展开,以便后续处理。

实例代码示例

以下是一个使用Python发起API请求并处理响应数据的示例代码:

import requests

import json

from datetime import datetime, timedelta

# 定义API URL和请求头

url = 'https://api.dingtalk.com/v1.0/yida/processes/instances'

headers = {

'Content-Type': 'application/json',

'Authorization': 'Bearer YOUR_ACCESS_TOKEN'

}

# 定义请求参数

payload = {

'pageSize': '50',

'pageNumber': '1',

'appType': 'APP_WTSCMZ1WOOHGIM5N28BQ',

'systemToken': 'IS866HB1DXJ8ODN3EXSVD750RBTK2X72R8MELL4',

'userId': '16000443318138909',

'language': 'zh_CN',

'formUuid': 'FORM-UX866Q61RUV939TLEWG9H4HX25523ZRQNXLGLW',

# 添加其他必要参数...

}

# 发起POST请求

response = requests.post(url, headers=headers, data=json.dumps(payload))

# 检查响应状态码

if response.status_code == 200:

data = response.json()

# 数据清洗与格式化

for item in data['data']:

item['datetime_new'] = datetime.strptime(item['dateField_lgn3helb'], '%Y-%m-%d %H:%M:%S')

item['order_no_new'] = str(item['serialNumberField_lgm25d8r'])

# 打印或保存处理后的数据

print(item)

else:

print(f"Error: {response.status_code}, {response.text}")通过以上步骤,我们成功地调用了钉钉接口,获取并加工了所需的数据,为后续的数据写入和分析奠定了基础。

使用轻易云数据集成平台进行ETL转换并写入MySQL API接口

在数据集成的生命周期中,第二步是将已经集成的源平台数据进行ETL(提取、转换、加载)转换,使其符合目标平台MySQL API接口所能接收的格式,并最终写入目标平台。以下将详细探讨这一过程中的技术细节和实现方法。

数据请求与清洗

在进行ETL转换之前,首先需要从源平台获取原始数据,并对其进行必要的清洗和预处理。这一步骤确保数据的准确性和一致性,为后续的转换和加载打下基础。假设我们已经完成了这一阶段,接下来我们重点关注如何将清洗后的数据转换并写入MySQL。

数据转换与写入

元数据配置解析

根据提供的元数据配置,我们需要将源平台的数据字段映射到目标平台MySQL表中的相应字段。以下是元数据配置的详细解析:

{

"api": "execute",

"effect": "EXECUTE",

"method": "POST",

"idCheck": true,

"request": [

{

"field": "main_params",

"label": "main_params",

"type": "object",

"describe": "111",

"children": [

{"field": "extend_processInstanceId", "label": "明细id", "type": "string", "value":"{bfn_id}"},

{"field": "order_no_new", "label": "单号", "type": "string", "value":"{order_no_new}(FKD)"},

{"field": "datetime_new", "label": "时间", "type": "date", "value":"{datetime_new}"},

{"field": "qty_count", "label": "数量", "type":"string","value":"1"},

{"field":"sales_count","label":"金额","type":"string","value":"{{tableField_lgm25d9j_numberField_lgm25d9r}}"},

{"field":"status","label":"状态","type":"string"},

{"field":"Document_Type","label":"单据类型","type":"string","value":"付款单"}

]

}

],

...

}数据映射与转换

-

字段映射:将源平台的数据字段映射到目标MySQL表中的相应字段。

extend_processInstanceId映射到bfn_idorder_no_new映射到order_no_new(FKD)datetime_new映射到datetime_newqty_count固定值为1sales_count映射到{tableField_lgm25d9j_numberField_lgm25d9r}status保持不变Document_Type固定值为付款单

-

SQL语句生成:根据映射关系生成插入语句。

INSERT INTO hc_dd_fkd (

extend_processInstanceId,

order_no_new,

datetime_new,

qty_count,

sales_count,

status,

Document_Type

) VALUES (

:extend_processInstanceId,

:order_no_new,

:datetime_new,

:qty_count,

:sales_count,

:status,

:Document_Type

);API请求配置

为了将转换后的数据写入MySQL,我们需要配置API请求。根据元数据配置,API请求使用POST方法,并包含以下参数:

- API路径:

execute - 请求方法:POST

- 参数结构:

{

main_params: {

extend_processInstanceId: "{bfn_id}",

order_no_new: "{order_no_new}(FKD)",

datetime_new: "{datetime_new}",

qty_count: '1',

sales_count: "{{tableField_lgm25d9j_numberField_lgm25d9r}}",

status: "{status}",

Document_Type: '付款单'

}

}实际操作步骤

- 准备数据:从源平台获取并清洗后的数据。

- 字段映射:根据元数据配置,将源平台的数据字段映射到目标字段。

- 生成SQL语句:根据映射关系生成插入语句。

- 发送API请求:通过POST方法,将生成的SQL语句和参数发送至MySQL API接口。

以下是一个示例代码片段,展示如何使用Python实现上述步骤:

import requests

# 源平台清洗后的数据

source_data = {

'bfn_id': '12345',

'order_no_new': 'ORD67890',

'datetime_new': '2023-10-01T12:00:00Z',

'tableField_lgm25d9j_numberField_lgm25d9r': '1000',

'status': 'active'

}

# 构建请求参数

params = {

'main_params': {

'extend_processInstanceId': source_data['bfn_id'],

'order_no_new': f"{source_data['order_no_new']}(FKD)",

'datetime_new': source_data['datetime_new'],

'qty_count': '1',

'sales_count': source_data['tableField_lgm25d9j_numberField_lgm25d9r'],

'status': source_data['status'],

'Document_Type': '付款单'

}

}

# API请求URL

url = "<Your MySQL API Endpoint>"

# 发起POST请求

response = requests.post(url, json=params)

# 检查响应状态

if response.status_code == 200:

print("Data successfully written to MySQL")

else:

print(f"Failed to write data to MySQL: {response.status_code}")通过以上步骤,我们成功地将源平台的数据经过ETL转换后写入了目标平台MySQL。这一过程不仅确保了数据的一致性和准确性,还大大提升了系统间的数据交互效率。