销售出库源数据-抓取速度测试:聚水潭·奇门数据集成到MySQL

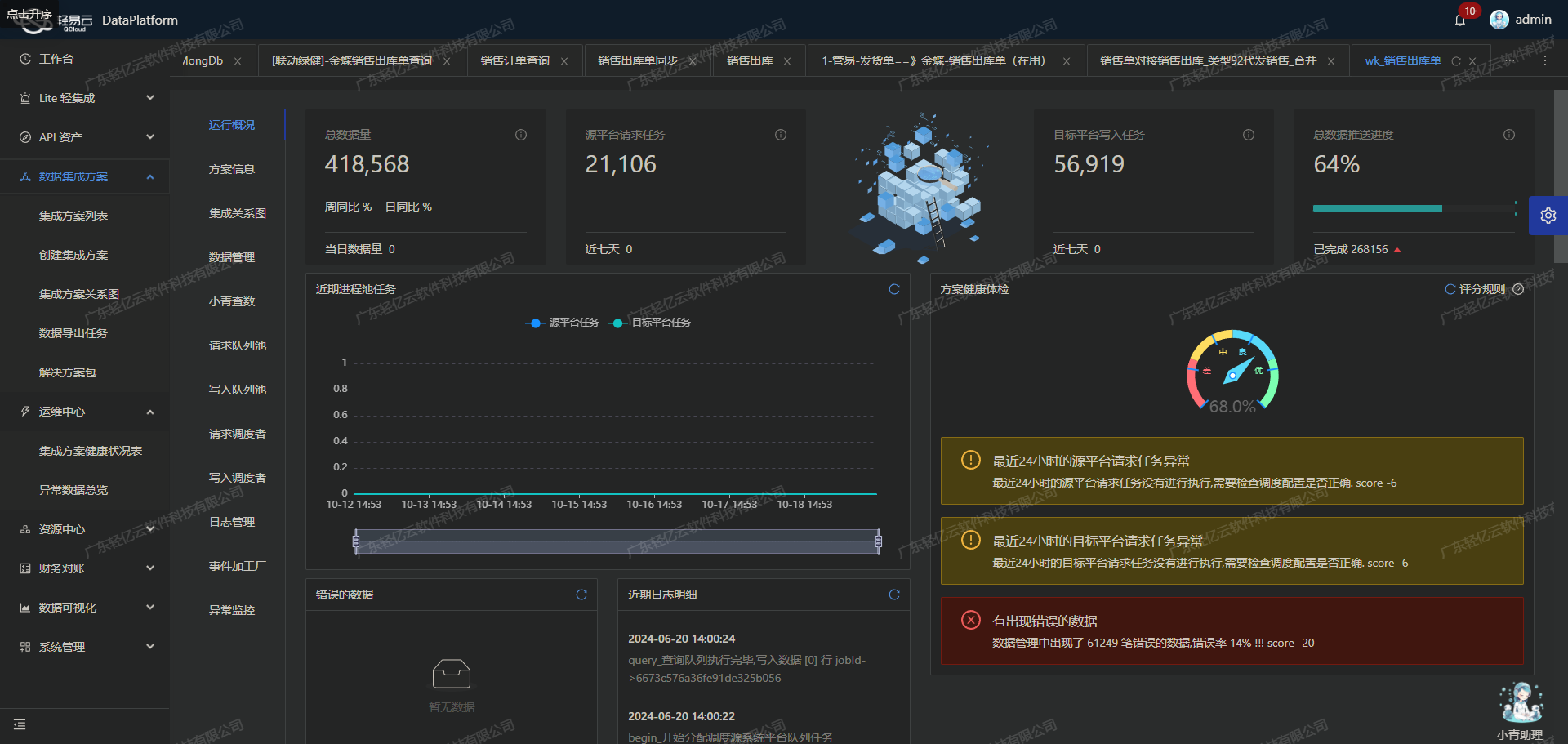

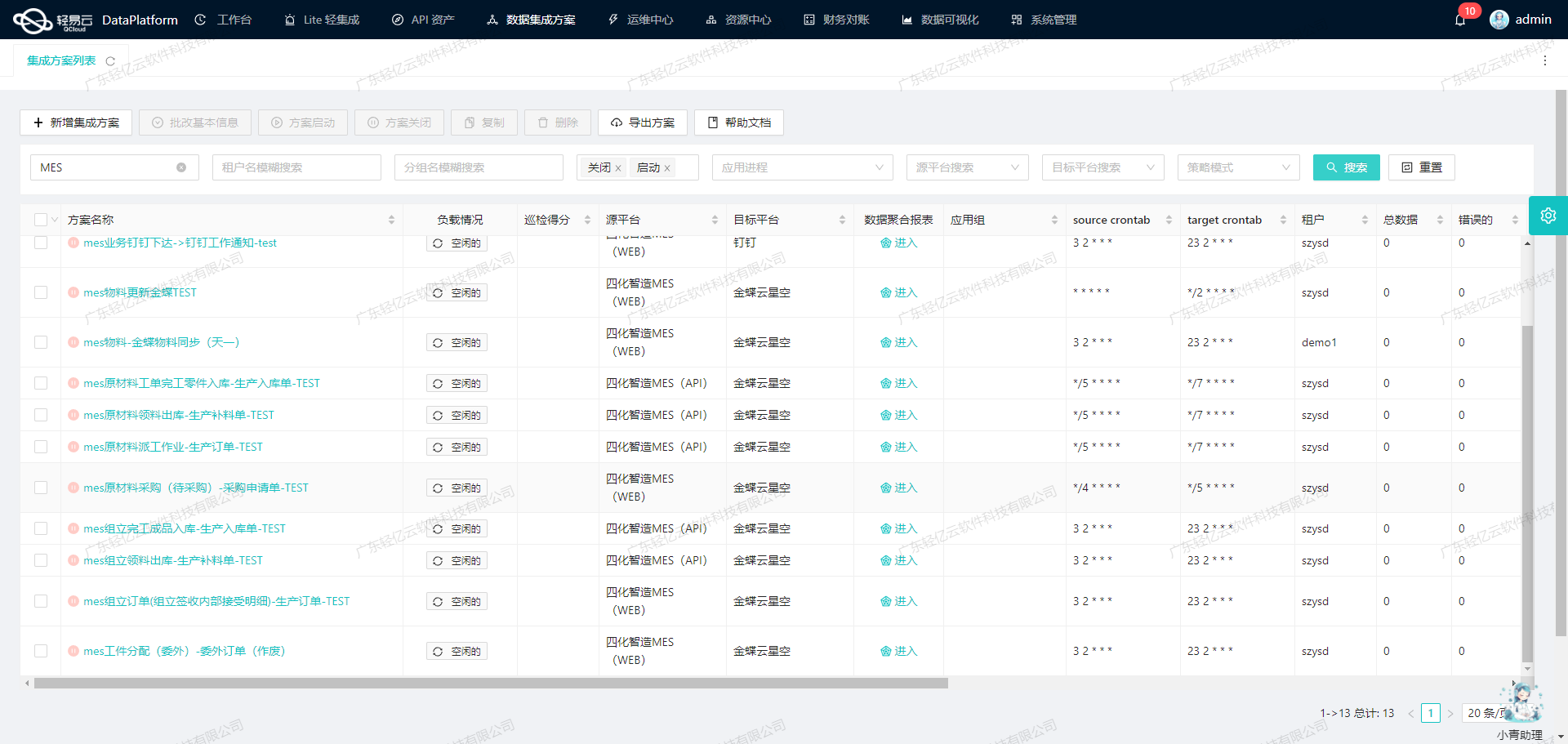

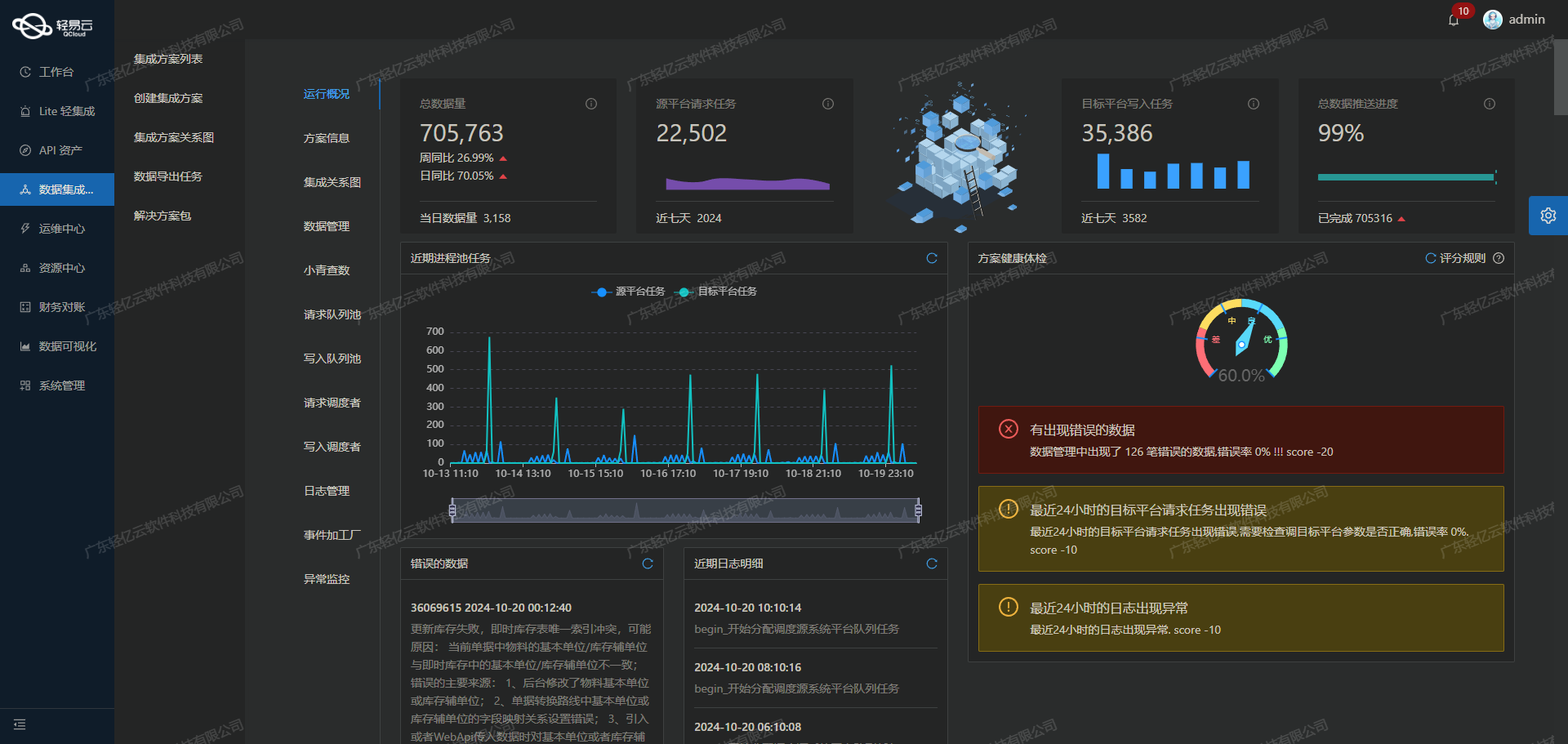

在现代企业的数据管理中,快速且高效地集成不同系统的数据是实现业务流畅运行的关键。本文将分享一个具体的技术案例,展示如何通过轻易云数据集成平台,将聚水潭·奇门的销售出库源数据高效地集成到MySQL数据库中。本次方案名为“销售出库源数据-抓取速度测试”,旨在验证和优化数据抓取与写入的性能。

首先,我们需要解决的是如何调用聚水潭·奇门提供的API接口jushuitan.saleout.list.query来获取销售出库数据。该接口支持分页查询,这意味着我们必须处理分页和限流问题,以确保所有数据能够完整无误地被抓取。此外,为了保证数据质量,我们还需要实时监控和异常检测机制,及时发现并处理任何潜在的问题。

接下来,在将这些数据写入MySQL时,我们利用了轻易云平台强大的高吞吐量写入能力。这不仅提升了大批量数据快速写入MySQL的效率,还确保了整个过程中的稳定性和可靠性。同时,通过定制化的数据映射对接功能,我们可以灵活地适应特定业务需求,对不同的数据结构进行转换。

为了全面掌握API资产的使用情况,轻易云提供了统一视图和控制台,使得资源管理更加高效。此外,集中监控和告警系统实时跟踪每个集成任务的状态和性能,为我们的技术团队提供了有力保障。

总之,通过这一系列技术手段,我们成功实现了聚水潭·奇门与MySQL之间的数据无缝对接,并显著提升了销售出库源数据的抓取速度。在后续章节中,我们将详细探讨每个步骤中的具体实现方法及其技术要点。

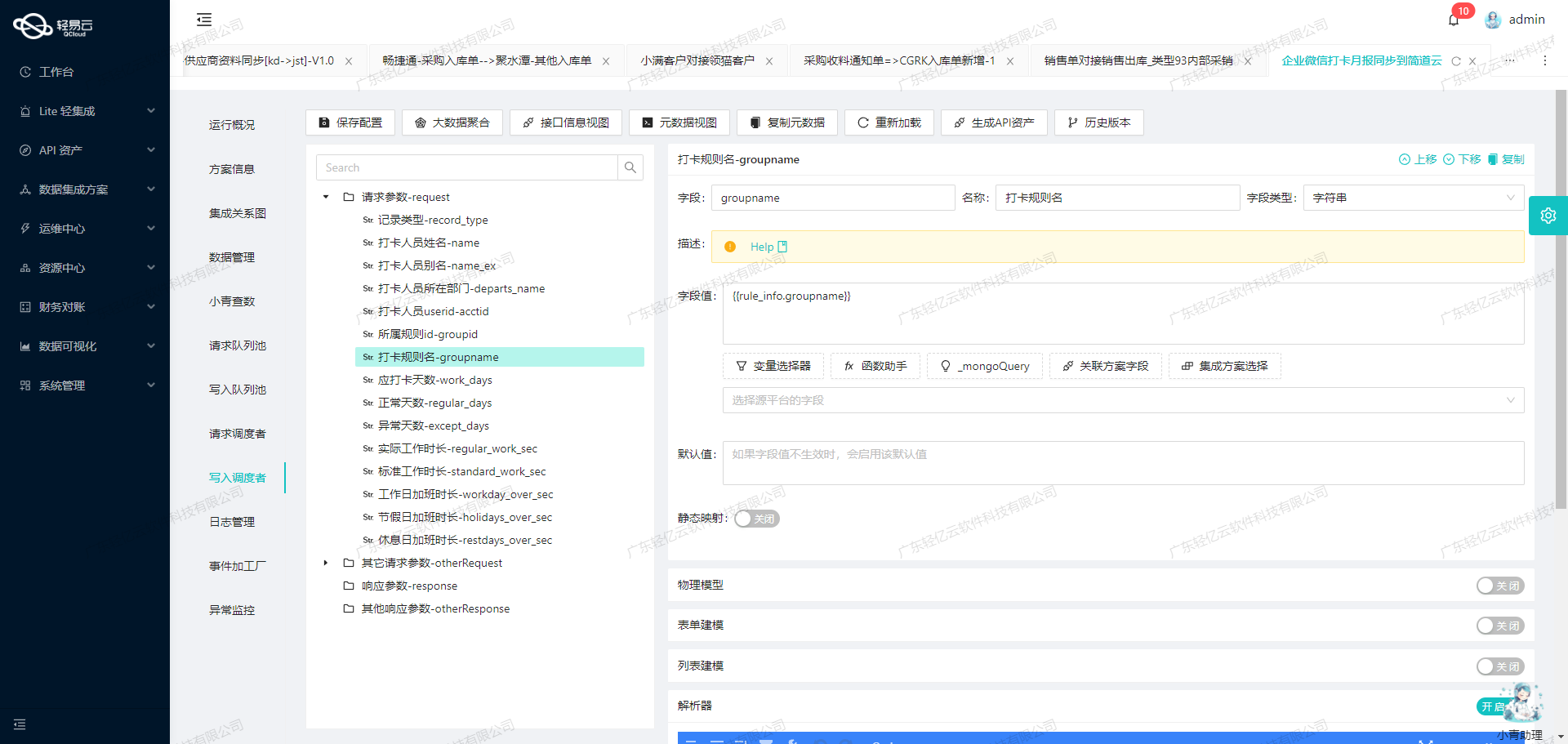

调用聚水潭·奇门接口jushuitan.saleout.list.query获取并加工数据

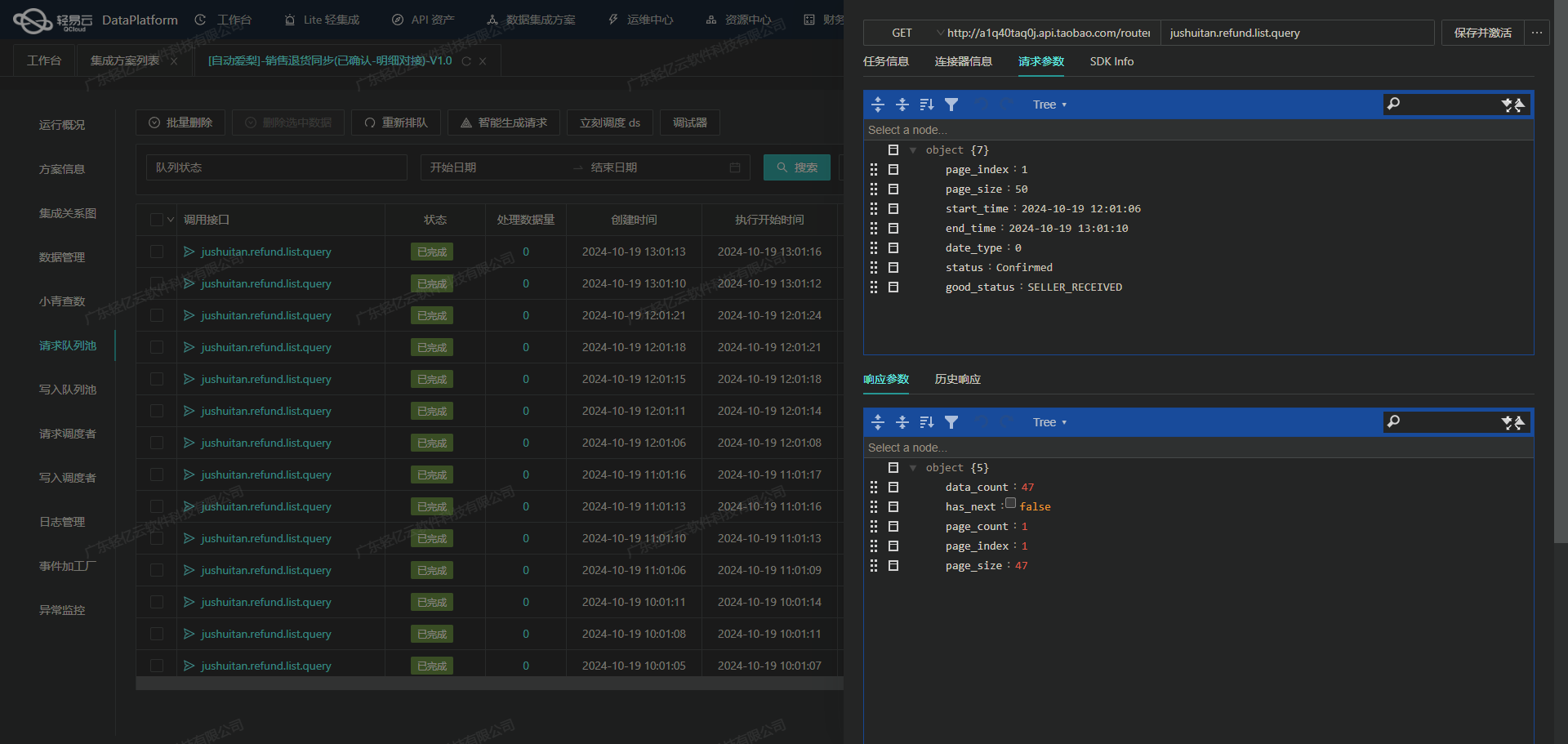

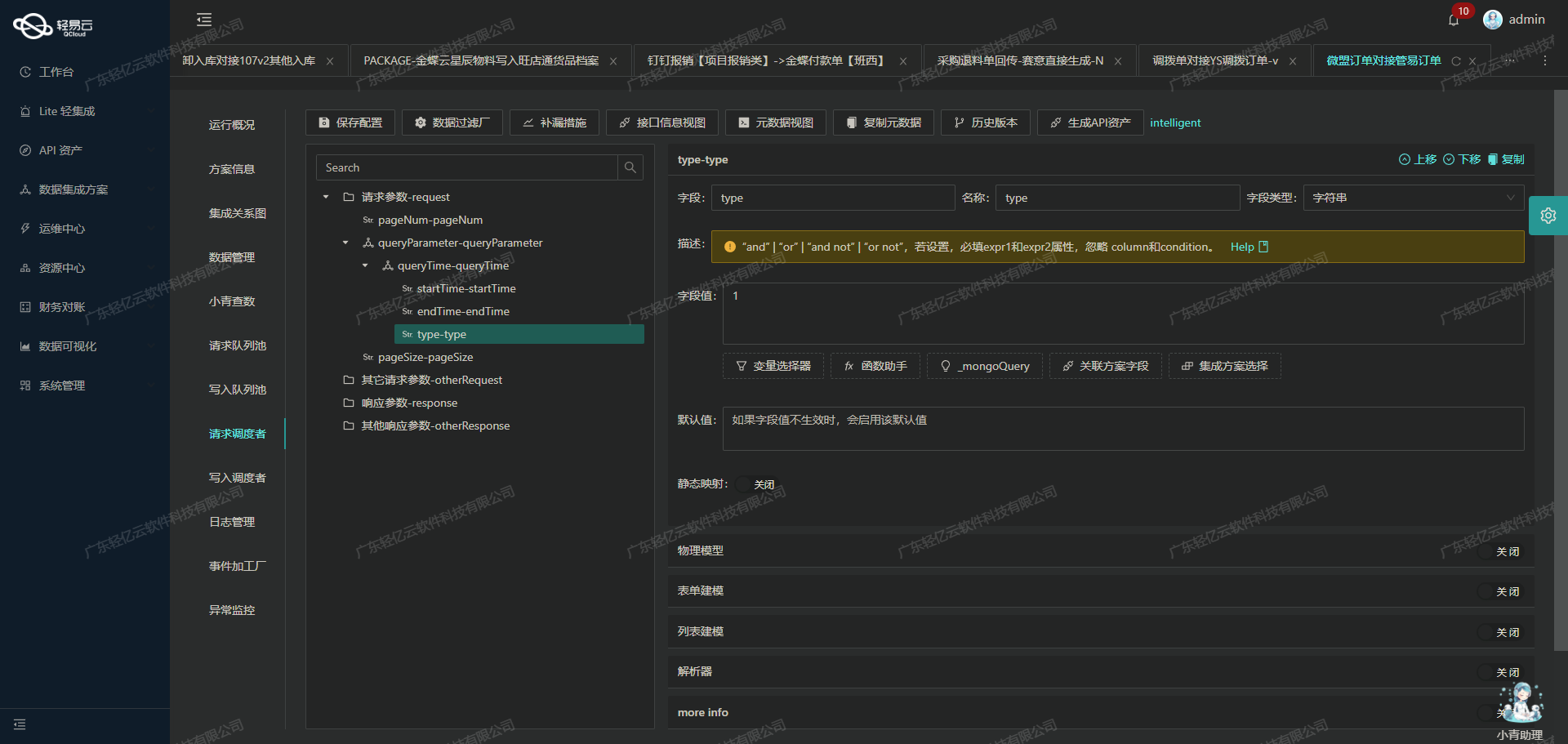

在数据集成的生命周期中,调用源系统接口是至关重要的一步。本文将详细探讨如何通过轻易云数据集成平台调用聚水潭·奇门接口jushuitan.saleout.list.query来获取销售出库数据,并进行初步的数据加工处理。

接口配置与请求参数

首先,我们需要配置API接口及其请求参数。根据元数据配置,jushuitan.saleout.list.query接口采用POST方法,请求参数包括页数、每页行数、开始时间、结束时间等。以下是部分关键参数的说明:

page_index: 页数,从第一页开始。page_size: 每页行数,最大值为50。start_time: 修改起始时间,必须与结束时间同时存在。end_time: 修改结束时间,必须与起始时间同时存在。status: 单据状态,如待出库、已出库等。

这些参数确保了我们能够分页获取指定时间段内的销售出库数据。

数据抓取与分页处理

为了高效地抓取大量数据,我们需要处理分页逻辑。每次请求返回的数据量有限,因此需要循环调用API以获取所有页面的数据。在实际操作中,可以使用如下伪代码实现分页抓取:

page_index = 1

while True:

response = call_api({

"page_index": page_index,

"page_size": 50,

"start_time": "2023-09-01 00:00:00",

"end_time": "2023-09-02 00:00:00"

})

if not response['data']:

break

process_data(response['data'])

page_index += 1这种方式确保了在不遗漏任何记录的情况下,逐页获取完整的数据集。

数据清洗与转换

在成功获取原始数据后,需要对其进行清洗和转换,以满足目标系统(如MySQL)的要求。这一步骤可能涉及字段重命名、格式转换以及过滤无效或重复记录。例如,将聚水潭·奇门中的字段名映射到MySQL数据库中的相应字段:

def transform_record(record):

return {

"order_id": record["so_id"],

"customer_id": record["o_id"],

# 更多字段映射...

}此外,还需注意处理日期格式差异以及其他特定业务逻辑。例如,将字符串日期转换为标准的ISO格式:

from datetime import datetime

def convert_date(date_str):

return datetime.strptime(date_str, "%Y-%m-%d %H:%M:%S").isoformat()异常处理与重试机制

在调用API过程中,不可避免地会遇到网络波动或服务端限制(如限流)。因此,需要设计健壮的异常处理和重试机制,以提高数据抓取的可靠性。例如,当遇到HTTP错误时,可以设置指数退避策略进行重试:

import time

def call_api_with_retry(params, retries=5):

for i in range(retries):

try:

return call_api(params)

except Exception as e:

if i < retries - 1:

time.sleep(2 ** i)

else:

raise e这种方式可以有效减少因临时故障导致的数据抓取失败,提高整体任务的稳定性。

实时监控与日志记录

为了确保整个数据集成过程透明可控,需要实时监控任务状态并记录日志。通过轻易云平台提供的集中监控和告警系统,可以及时发现并解决潜在问题。此外,通过详细的日志记录,可以追踪每个请求和响应,为后续调试提供依据。

综上所述,通过合理配置API接口、实现高效的数据抓取与分页处理、执行必要的数据清洗和转换,并结合健壮的异常处理机制和实时监控,我们能够高效稳定地完成从聚水潭·奇门系统到目标数据库的数据集成任务。这一系列步骤不仅保证了数据质量,也提升了整体业务流程的效率。

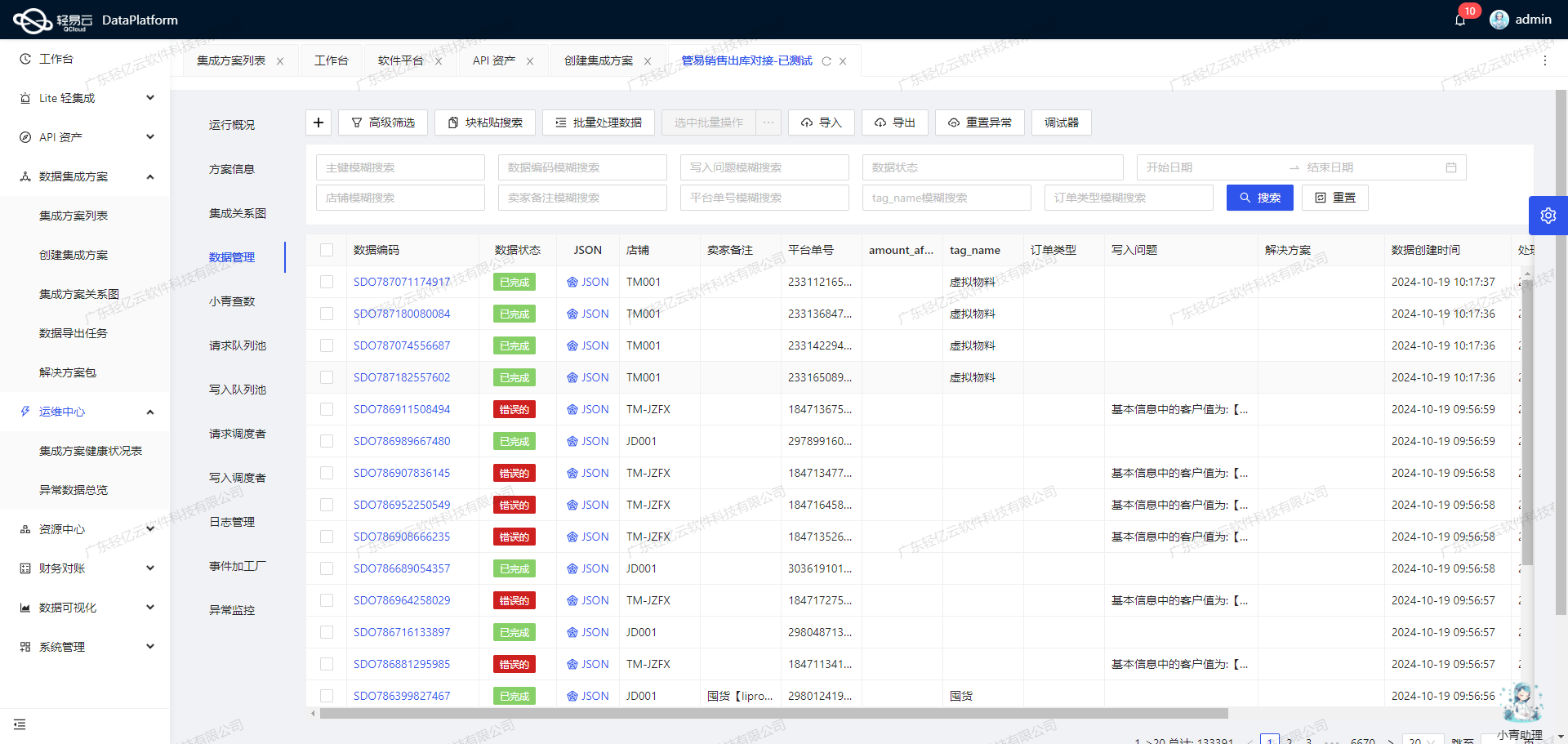

将源数据转换为MySQLAPI接口格式并写入目标平台

在数据集成生命周期的第二步,我们需要将已经集成的源平台数据进行ETL转换,转为目标平台 MySQLAPI接口所能够接收的格式,最终写入目标平台。以下是具体技术步骤及注意事项。

数据清洗与转换

首先,我们需要对从聚水潭·奇门接口jushuitan.saleout.list.query获取的销售出库源数据进行清洗和转换。源数据可能包含多种格式和结构,需要根据目标MySQL数据库的要求进行规范化处理。

例如,聚水潭·奇门返回的数据字段可能是嵌套的JSON对象,我们需要提取并重新组织这些字段,以便与MySQL数据库中的表结构相匹配。

{

"main_params": {

"created": "2023-10-01",

"free_amount": "10.00",

"freight": "5.00",

...

},

"extend_params_2": [

{

"io_id": "12345",

"i_id": "67890",

...

}

]

}数据映射配置

我们使用元数据配置来定义从源数据到目标MySQL表的映射关系。以下是一个主要参数和扩展参数的映射示例:

{

"field":"main_sql",

"value":"INSERT INTO `聚水潭原始销售数据` (`线上单号`,`内部单号`,`创建时间`,`优惠金额`,`运费`,`出库时间`,`出库单号`,`物流单号`,`标记|多标签`,`物流公司名称`,`单据类型`,`实付金额`,`应付金额`,`付款日期`,`市`,`国家`,`区`,`省`,`店铺编号`,`店铺名称`,`预估重量`,`分仓编码`,`单据状态`) VALUES (:so_id,:o_id,:created,:free_amount,:freight,:io_date,:io_id,:l_id,:labels,:logistics_company,:order_type,:paid_amount,:pay_amount,:pay_date,:receiver_city,:receiver_country,:receiver_district,:receiver_state,:shop_id,:shop_name,:weight,:wms_co_id,:status)"

},

{

"field":"extend_sql_2",

"value":"INSERT INTO `MergerOutstockBill` (`出库单号`,`商品编码`,`商品名称`,`颜色规格`,`数量`,`金额`,`原价`,`单价`,`子单号`, `是否赠品`, `款式编码`) VALUES (:io_id, :sku_id, :name, :properties_value, :qty, :sale_amount, :sale_base_price, :sale_price, :ioi_id, :is_gift, :i_id)"

}批量写入与高吞吐量支持

为了确保大量数据能够快速写入到MySQL,我们采用批量插入技术,并利用轻易云提供的高吞吐量支持。在执行批量插入时,需要特别注意事务处理,确保操作的原子性和一致性。

START TRANSACTION;

-- 批量插入主表记录

INSERT INTO `聚水潭原始销售数据` (...) VALUES (...), (...), ...;

-- 批量插入子表记录

INSERT INTO `MergerOutstockBill` (...) VALUES (...), (...), ...;

COMMIT;异常处理与错误重试机制

在数据写入过程中,可能会遇到网络中断、数据库锁定等异常情况。我们需要实现健壮的异常处理和错误重试机制,确保任务能够可靠完成。

- 捕获异常:在每次数据库操作后捕获可能发生的异常。

- 记录日志:详细记录每次操作和异常信息,以便后续分析和处理。

- 重试机制:对于可恢复的错误(如网络问题),可以设置重试次数和间隔时间,通过循环重试保证任务成功。

try:

# 执行批量插入操作

except Exception as e:

log.error(f"Data insertion failed: {e}")

retry_count = 0

while retry_count < MAX_RETRIES:

try:

# 重试插入操作

break

except Exception as retry_e:

log.error(f"Retry {retry_count} failed: {retry_e}")

retry_count += 1实时监控与告警

通过轻易云提供的集中监控和告警系统,可以实时跟踪数据集成任务的状态和性能。一旦出现问题,系统会及时发出告警通知,以便迅速响应和解决。

数据质量监控与异常检测

为了确保数据质量,我们需要对每个步骤的数据进行监控,包括:

- 数据完整性检查:确保所有必填字段都有值。

- 数据一致性检查:确保相关联的数据在不同表中保持一致。

- 异常值检测:识别并处理超出合理范围的数据,如负数或极端值。

通过上述步骤,我们可以高效地将聚水潭·奇门接口的数据转换为MySQLAPI接口所能接收的格式,并可靠地写入到目标平台。这一过程不仅提高了数据处理效率,还保障了数据的一致性和完整性。