BDS班牛退换补发=> 吉客云退换补发(补单)集成案例分享

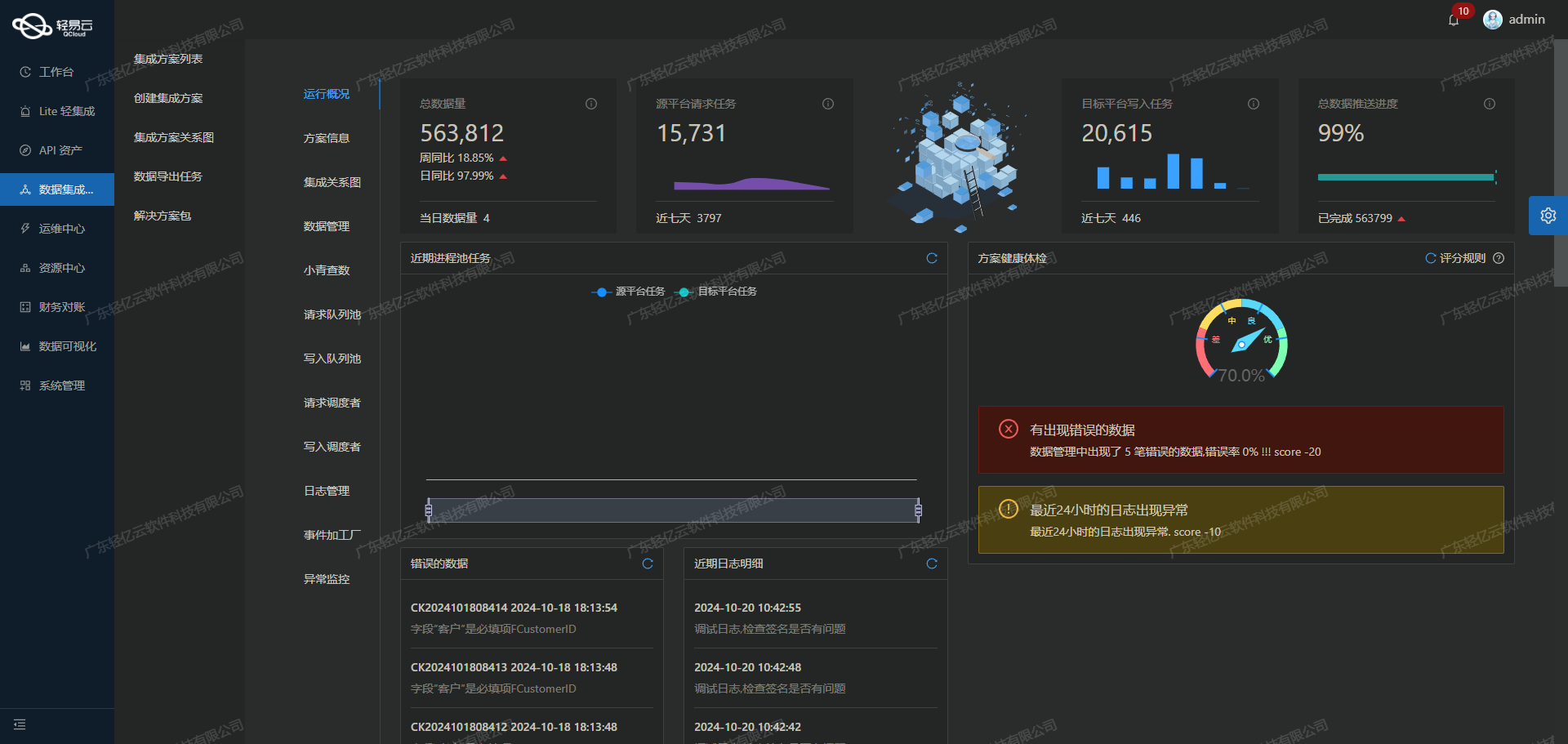

在本次技术案例中,我们将详细探讨如何通过轻易云数据集成平台,将BDS班牛的退换补发数据高效地集成到吉客云系统中。该方案不仅需要处理大量的数据,还需确保数据的准确性和实时性,以满足业务需求。

首先,班牛系统提供了一个名为task.list的API接口,用于获取退换补发相关的数据。为了实现高效的数据抓取,我们采用了定时任务机制,确保能够可靠地从班牛接口定期获取最新数据,并处理分页和限流问题,以避免因请求过多导致的接口阻塞。

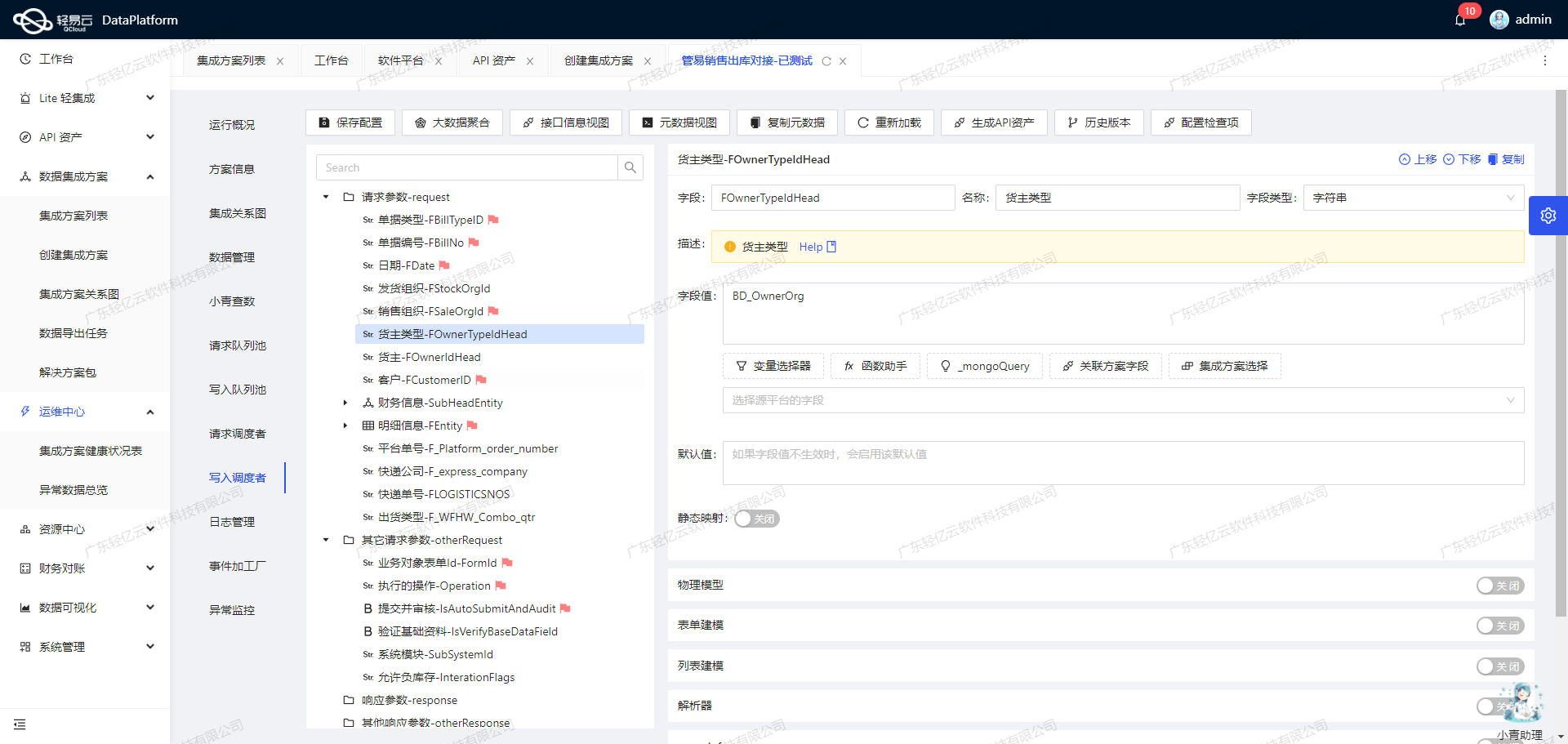

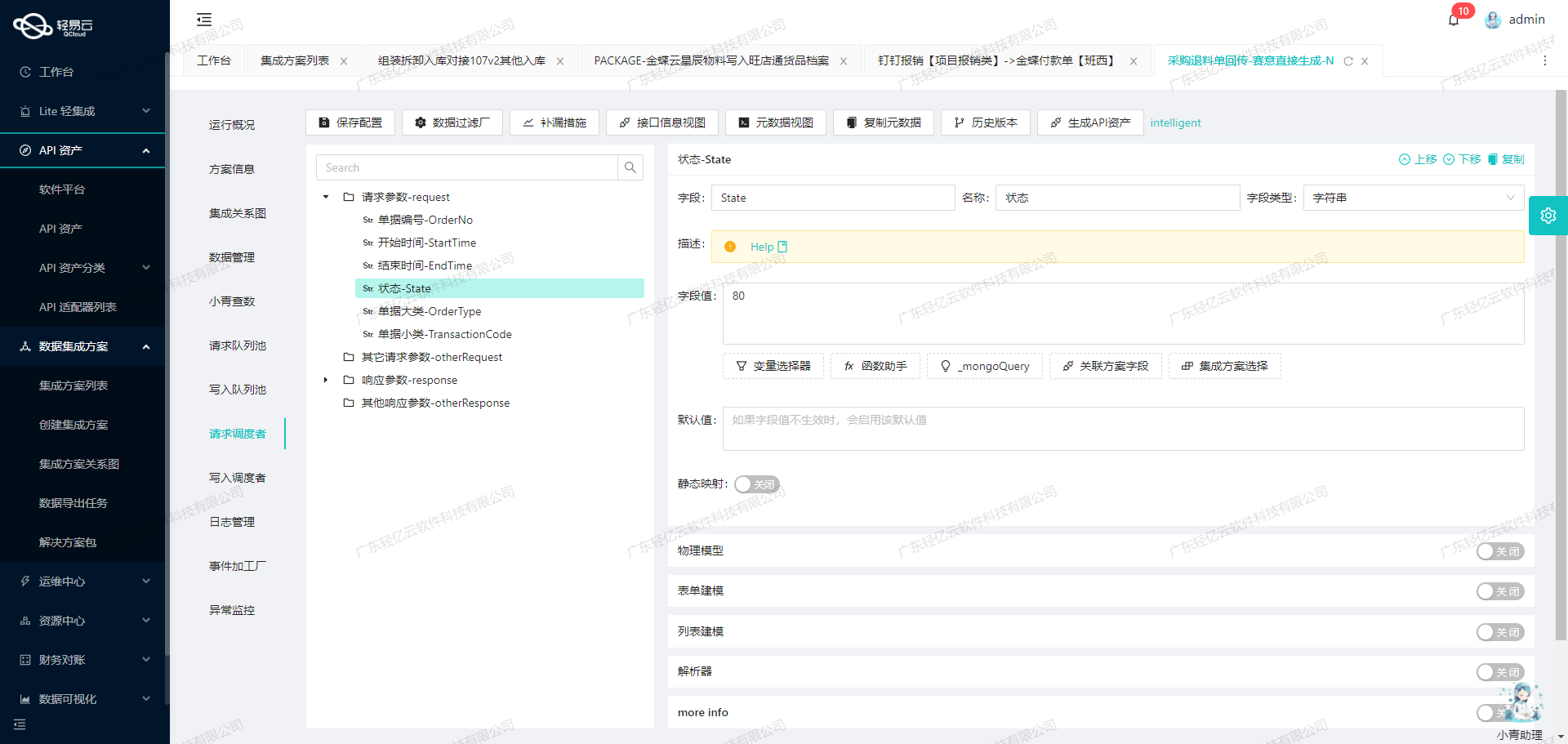

接下来,针对从班牛获取的数据,我们利用轻易云平台提供的自定义数据转换逻辑功能,对数据进行必要的格式转换和清洗。这一步骤至关重要,因为班牛与吉客云之间存在数据结构差异,需要通过映射规则来统一格式,从而保证数据在目标系统中的正确解析。

在完成数据转换后,我们使用吉客云提供的ass-business.returnchange.create API接口,将处理后的数据批量写入到吉客云系统中。得益于轻易云平台支持高吞吐量的数据写入能力,即使面对大规模的数据集成任务,也能快速、高效地完成操作,显著提升了整体处理时效性。

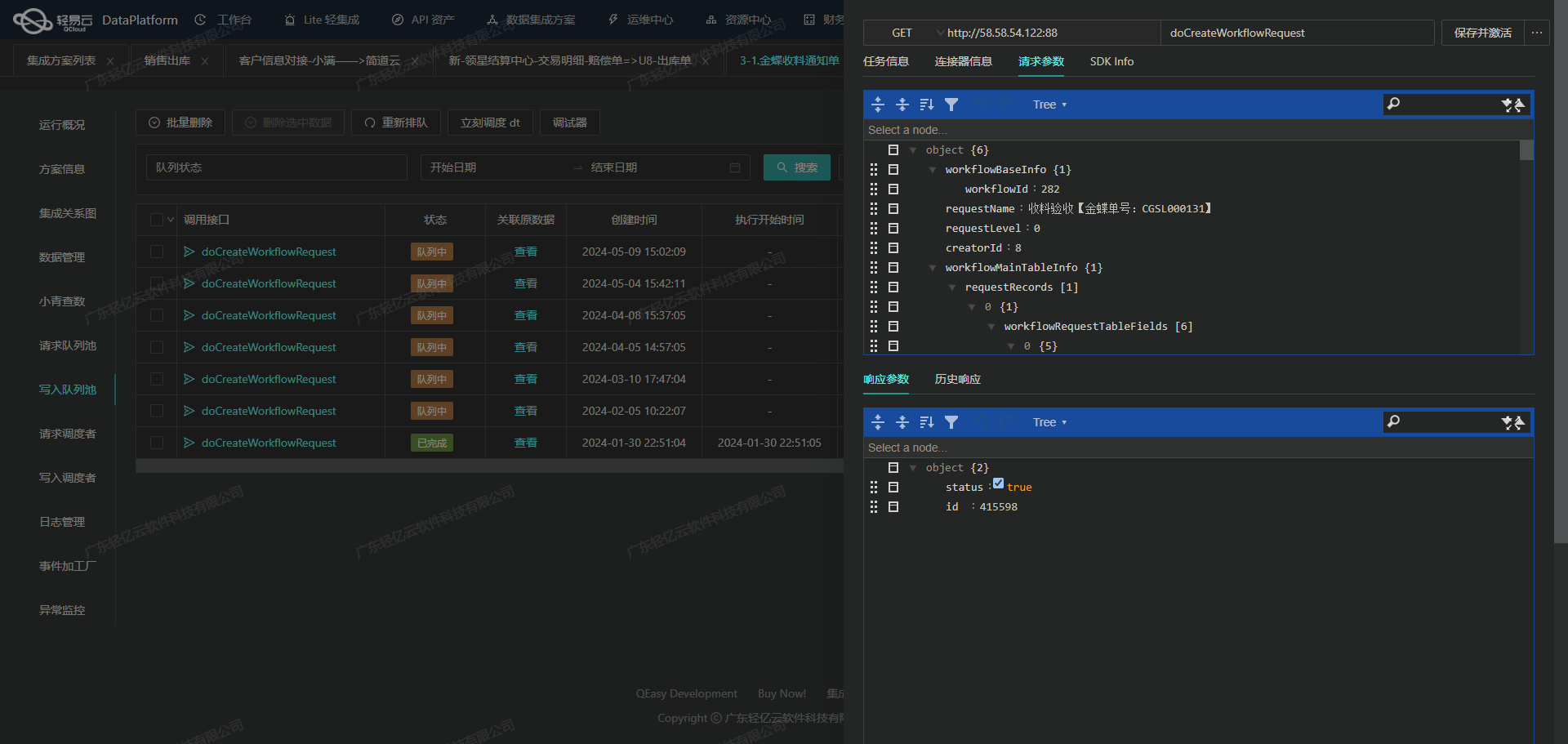

此外,为了确保整个集成过程的稳定运行,我们还配置了集中监控和告警系统。该系统能够实时跟踪每个数据集成任务的状态和性能,一旦发现异常情况,立即触发告警并记录日志,便于后续排查和解决问题。同时,通过吉客云定制化的数据映射对接功能,可以灵活调整映射规则,以适应不断变化的业务需求。

综上所述,本次BDS班牛退换补发到吉客云退换补发(补单)的集成方案,不仅实现了高效、可靠的数据传输,还通过一系列技术手段保障了数据质量和系统稳定性。在接下来的章节中,我们将进一步深入探讨具体实施步骤及关键技术细节。

调用班牛接口task.list获取并加工数据

在轻易云数据集成平台的生命周期中,第一步是调用源系统班牛接口task.list获取数据,并进行初步加工处理。以下将详细探讨如何通过配置元数据来实现这一过程。

配置元数据

首先,我们需要配置元数据,以便正确调用班牛的API接口。以下是我们使用的元数据配置:

{

"api": "task.list",

"effect": "QUERY",

"method": "GET",

"number": "-1",

"id": "-1",

"idCheck": true,

"request": [

{"field":"project_id","label":"群组ID","type":"string","value":"25821"},

{"field":"page_size","label":"page_size","type":"string","value":"20"},

{"field":"page_num","label":"page_num","type":"string","value":"1"},

{"field":"star_created","label":"起始时间","type":"string"},

{"field":"end_created","label":"结束时间","type":"string"},

{"field":"task_status","label":"工单状态","type":"string","value":"2"},

{"field":"star_modified","label":"修改时间起始时间","type":"string", "value": "2024-09-04 16:53:18"},

{"field": "end_modified", "label": "修改时间结束时间", "type": "string", "value": "2024-09-05 16:53:18"}

],

...

}调用API获取数据

通过上述配置,我们可以发起对班牛接口task.list的请求。该接口主要用于查询任务列表,支持分页和多种过滤条件。为了确保高效的数据抓取,我们设置了分页参数page_size为20,并指定了查询条件如项目ID、工单状态等。

在实际操作中,需要注意以下几点:

- 分页处理:由于可能存在大量数据,需要通过循环请求每一页的数据,直到没有更多记录为止。

- 限流问题:如果遇到API限流,需要实现重试机制,以确保所有数据都能成功抓取。

- 时间范围过滤:根据业务需求,可以动态调整查询的起始和结束时间,以避免遗漏或重复抓取。

数据清洗与转换

获取到原始数据后,需要对其进行初步清洗和转换。这一步骤包括但不限于:

- 字段映射:将班牛返回的数据字段映射到吉客云所需的字段格式。例如,将班牛中的任务ID映射为吉客云中的订单ID。

- 格式转换:根据吉客云的数据结构要求,对日期、数值等字段进行格式转换。

- 异常处理:对于缺失或异常的数据进行标记或修正,以确保后续处理的准确性。

例如,对于一个典型的任务记录,可以进行如下转换:

{

// 班牛返回的数据

{

"task_id": "...",

...

}

// 转换后的吉客云格式

{

"order_id": "...",

...

}

}实时监控与日志记录

为了确保整个过程顺利进行,轻易云平台提供了实时监控和日志记录功能。通过这些工具,可以随时跟踪每个步骤的执行情况,并及时发现和解决潜在问题。

具体来说,可以设置告警规则,当某些关键指标(如请求失败率、响应延迟等)超过阈值时,自动触发告警通知。同时,通过详细的日志记录,可以追溯每一次API调用及其结果,为故障排查提供依据。

总结

通过以上步骤,我们完成了轻易云数据集成平台生命周期中的第一步,即调用源系统班牛接口task.list获取并加工处理数据。在这个过程中,合理配置元数据、有效处理分页与限流问题、以及实时监控与日志记录,是确保集成任务顺利完成的重要保障。

集成BDS班牛退换补发数据到吉客云的ETL转换与写入

在数据集成生命周期的第二步中,重点在于将源平台的数据进行ETL(提取、转换、加载)处理,使其符合目标平台API接口的要求,最终成功写入吉客云。以下是详细的技术实现过程及关键点。

1. 数据提取与清洗

首先,从班牛系统中提取退换补发单的数据。通过调用班牛接口task.list,可以获取到所需的订单数据。需要注意的是,在提取过程中,要处理分页和限流问题,以确保数据完整性和系统稳定性。

{

"field": "returnChangeNo",

"label": "退换单号",

"type": "string"

}2. 数据转换

在数据转换过程中,需要将班牛系统中的字段映射到吉客云API所需的字段格式。以下是主要字段的映射及转换逻辑:

- 订单编号映射:将班牛系统中的

tradeNo映射为吉客云中的systemOrderNumber。 - 物流信息转换:通过MongoDB查询,将物流公司名称和物流单号进行匹配和填充。

- 客户信息处理:使用函数处理器对客户地址等信息进行解析和拆分,例如:

{

"field": "receiverName",

"label": "收货人",

"type": "string",

"value": "_function substring_index('{{38001}}', ',', 1)"

}3. 数据质量监控与异常检测

在数据转换过程中,必须实时监控数据质量,确保每个字段都能正确映射并符合目标平台的格式要求。同时,设置异常检测机制,当发现数据问题时能够及时告警并处理。例如:

{

"field": "state",

"label": "省",

"type": "string",

"value": "_function substring_index(substring_index('{{38001}}', ',', 3), ',', -1)"

}4. 批量数据写入

为了提升数据处理效率,采用批量写入方式,将转换后的数据批量提交给吉客云API接口ass-business.returnchange.create。需要特别注意的是,确保每次提交的数据包大小在API允许范围内,并且处理好错误重试机制。

{

"api": "ass-business.returnchange.create",

"method": "POST",

...

}5. 吉客云对接注意事项

在对接吉客云时,需要特别关注以下几点:

- 接口调用频率控制:避免因频繁调用导致的限流问题。

- 数据格式差异处理:确保所有字段都经过正确转换,并符合吉客云API的要求。

- 错误重试机制:实现自动重试机制,当出现网络或其他异常时能够自动重试提交。

实现实时监控与日志记录

通过轻易云提供的集中监控和告警系统,可以实时跟踪每个数据集成任务的状态和性能。在任务执行过程中记录详细日志,以便后续分析和排查问题。

{

...

}总结来说,通过上述步骤,可以高效地将班牛系统中的退换补发单数据成功集成到吉客云,实现了两个异构系统之间的数据无缝对接。