快麦数据集成到MySQL的技术案例分享

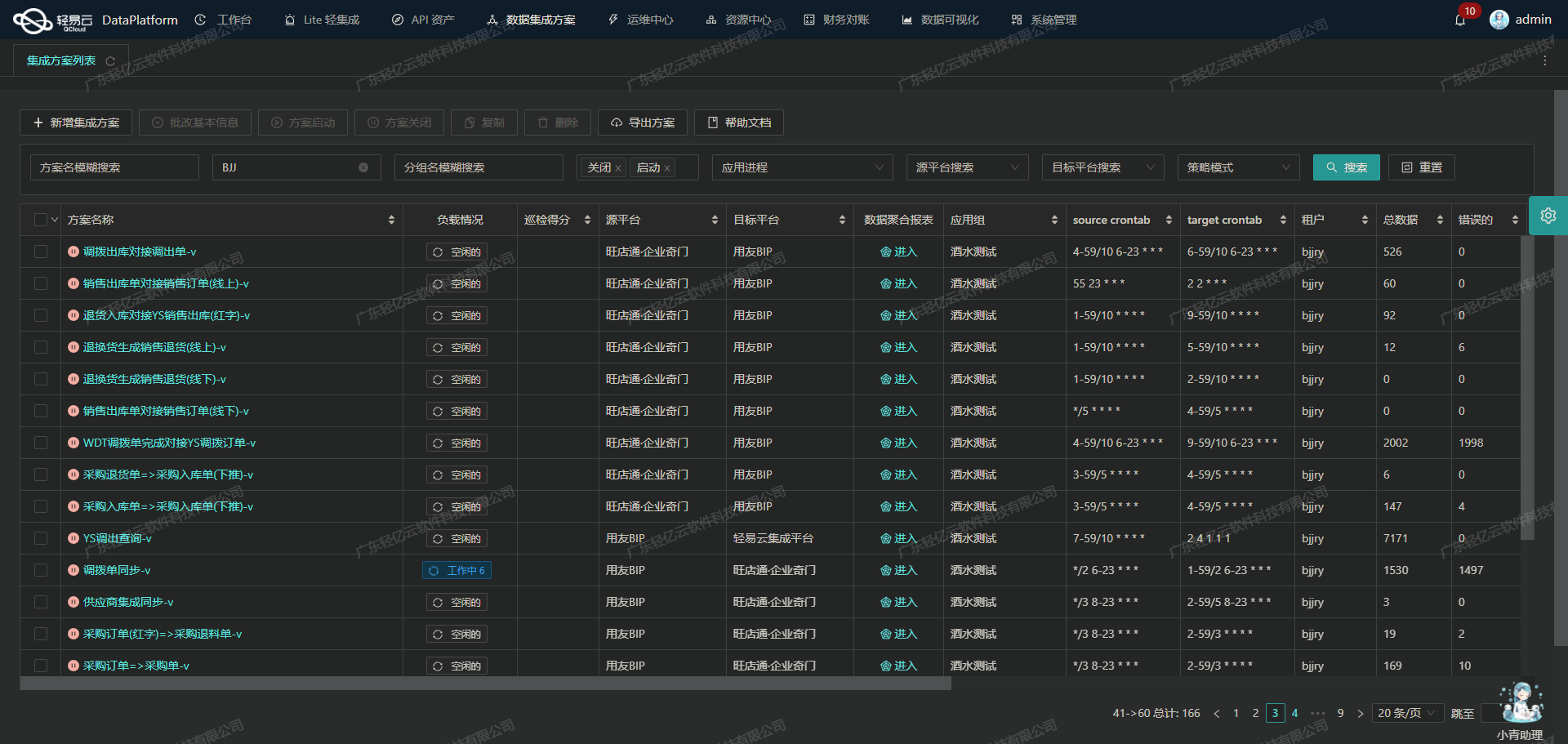

在本次技术案例中,我们将探讨如何通过轻易云数据集成平台,将快麦系统中的销售出库单数据高效、安全地集成到MySQL数据库中。具体的集成方案命名为“快麦-销售出库单-->BI刊安-销售出库表_copy”。

首先,快麦系统提供了一个名为erp.trade.outstock.simple.query的API接口,用于获取销售出库单的数据。为了确保数据不漏单,我们需要定时可靠地抓取该接口的数据,并处理分页和限流问题,以保证数据的完整性和实时性。

在数据写入方面,MySQL作为目标平台,通过其批量执行API batchexecute,能够支持高吞吐量的数据写入能力。这使得大量的销售出库单数据能够快速被集成到MySQL中,大大提升了数据处理的时效性。

为了实现这一过程,我们利用了轻易云平台提供的一系列特性:

- 集中监控和告警系统:实时跟踪整个数据集成任务的状态和性能,确保任何异常情况都能及时发现并处理。

- 自定义数据转换逻辑:适应特定业务需求和数据结构,实现快麦与MySQL之间的数据格式差异处理。

- 可视化的数据流设计工具:使得整个数据集成过程更加直观、易于管理,从而减少配置错误,提高工作效率。

- 异常处理与错误重试机制:在对接过程中,如果出现网络波动或其他异常情况,可以自动进行错误重试,确保最终的数据一致性。

通过上述技术手段,我们不仅实现了快麦销售出库单到MySQL数据库的无缝对接,还保障了整个过程中的高效、稳定和安全。在后续章节中,我们将详细介绍具体的实施步骤及注意事项。

调用快麦接口erp.trade.outstock.simple.query获取并加工数据

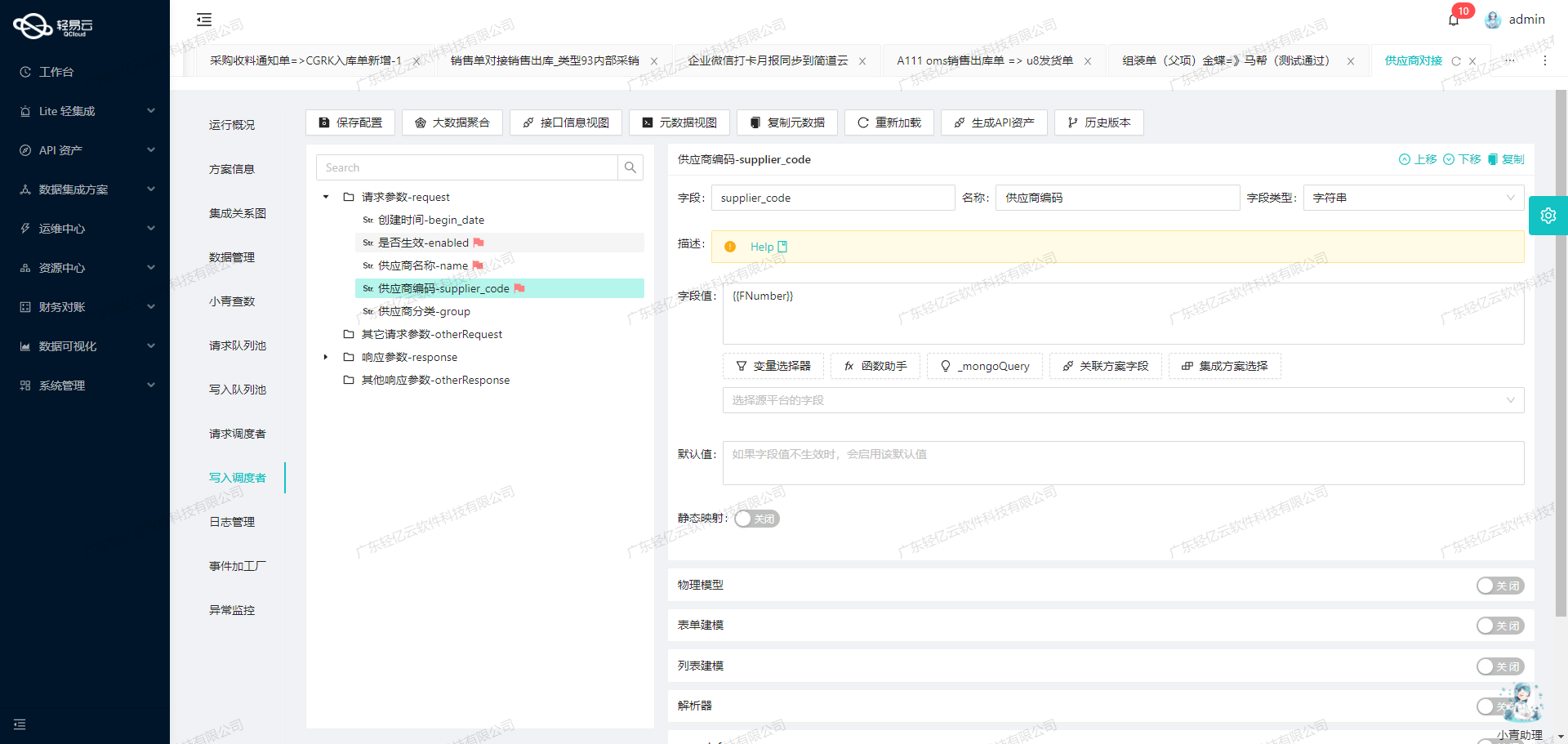

在数据集成的生命周期中,调用源系统接口是至关重要的一步。本文将详细探讨如何通过轻易云数据集成平台调用快麦接口erp.trade.outstock.simple.query来获取销售出库单数据,并进行初步的数据加工处理。

快麦接口配置与请求参数

首先,我们需要配置快麦接口的元数据,以便正确地发起API请求。以下是该接口的元数据配置:

{

"api": "erp.trade.outstock.simple.query",

"effect": "QUERY",

"method": "POST",

"number": "tid",

"id": "sid",

"name": "tid",

"request": [

{"field":"pageNo","label":"页码","type":"string","value":"1"},

{"field":"pageSize","label":"每页多少条","type":"string","value":"200"},

{"field":"status","label":"系统状态","type":"string"},

{"field":"types","label":"订单类型","type":"string"},

{"field":"timeType","label":"时间类型","type":"string","value":"upd_time"},

{"field":"startTime","label":"开始时间","type":"string","value":"{{LAST_SYNC_TIME|datetime}}"},

{"field":"endTime","label":"结束时间","type":"string","value":"{{CURRENT_TIME|datetime}}"},

{"field": "queryType", "label": "查询类型", "type": "string"}

],

"autoFillResponse": true,

"beatFlat":["orders"],

...

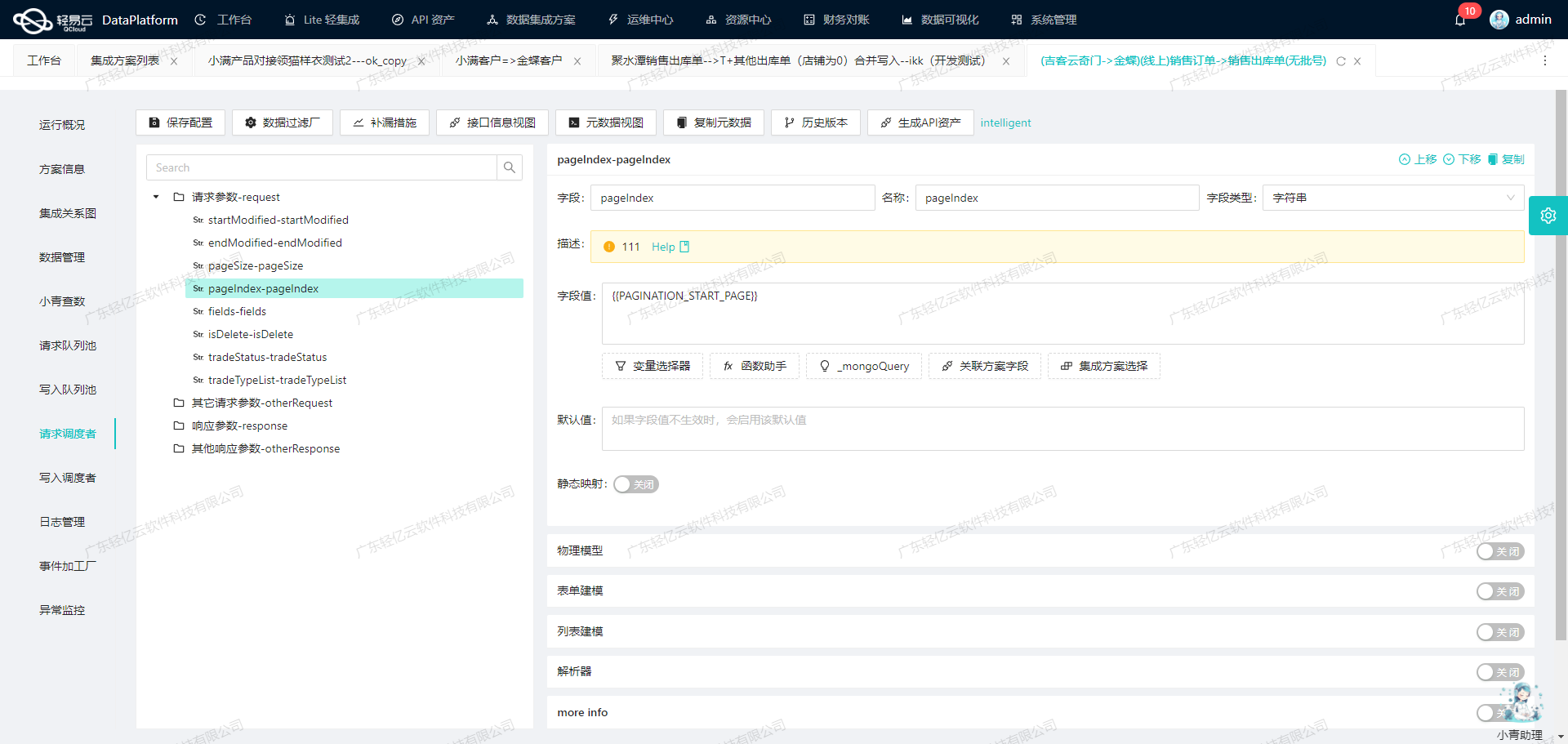

}数据请求与分页处理

为了确保能够高效地抓取大量销售出库单数据,我们需要处理分页和限流问题。通过设置pageNo和pageSize参数,可以控制每次请求返回的数据量。例如,每次请求200条记录,并逐页递增以获取所有数据。

{

"pageNo": "{{PAGE_NO}}",

"pageSize": "{{PAGE_SIZE}}"

}在实际操作中,可以使用循环或递归方式来实现分页抓取,直到没有更多的数据返回为止。

数据清洗与转换

在获取到原始数据后,需要对其进行清洗和转换,以适应目标系统的需求。轻易云平台提供了强大的自定义数据转换功能,可以根据业务需求编写转换逻辑。例如,将日期格式统一、字段重命名、过滤无效记录等。

{

// 示例:将日期格式从"yyyy-MM-dd HH:mm:ss"转换为"yyyyMMddHHmmss"

{

"$dateFormat":{

"$sourceFieldName": ["startTime", ...],

"$targetFieldName":["formattedStartTime", ...],

"$formatPattern":["yyyyMMddHHmmss"]

}

},

// 示例:过滤掉状态为“已取消”的订单

{

"$filter":{

"$sourceFieldName":["status"],

"$condition":[{"$ne":["cancelled"]}]

}

}

}实时监控与异常处理

为了确保集成过程的可靠性,实时监控和异常处理机制必不可少。轻易云平台提供了集中监控和告警系统,可以实时跟踪任务状态。一旦发现异常,如网络超时或API限流错误,可以自动触发重试机制或发送告警通知。

{

// 示例:设置重试机制

{

"$retryPolicy":{

"$maxRetries":[3],

"$delayBetweenRetries":[5000] // 毫秒

}

},

// 示例:设置告警通知

{

"$alertPolicy":{

"$onError":[{"$sendEmail":{"to":["admin@example.com"],"subject":["API Error Alert"],"body":["An error occurred while calling the API."]}}],

...

}

}

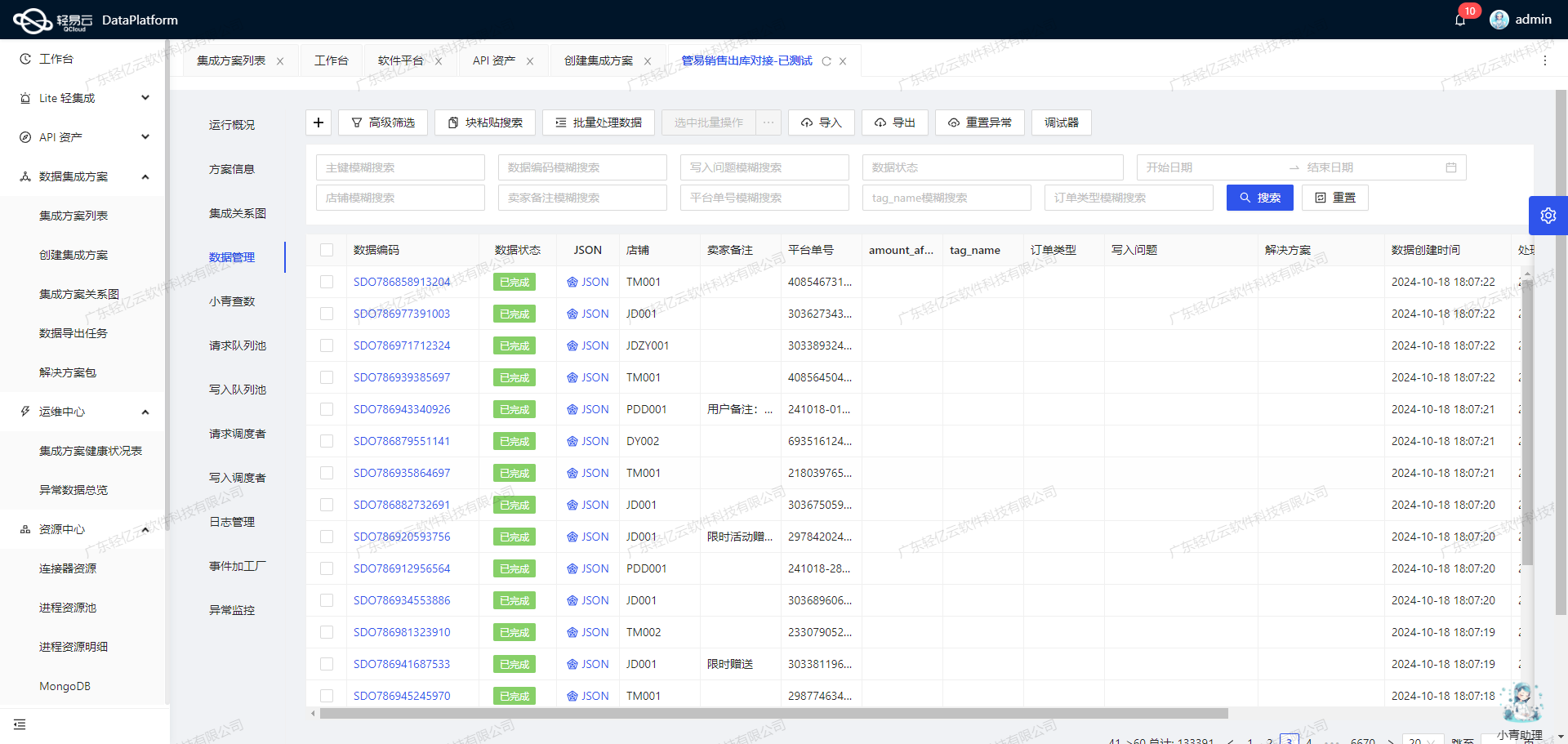

}数据写入与存储

经过清洗和转换后的数据可以批量写入到MySQL数据库中。在此过程中,需要注意MySQL表结构与源系统字段之间的映射关系,以及可能存在的数据格式差异。轻易云平台支持定制化的数据映射对接,确保数据准确无误地存储到目标数据库中。

{

// 示例:字段映射关系配置

{

"$mapping":{

"$sourceFieldName":["tid", ...],

"$targetFieldName":["order_id", ...]

}

},

// 示例:批量写入MySQL数据库

{

"$batchInsert":{

...

}

}

}通过上述步骤,我们可以高效地调用快麦接口获取销售出库单数据,并进行必要的数据加工处理,为后续的数据分析和业务决策提供坚实基础。

快麦销售出库单数据ETL转换与写入MySQLAPI接口的技术实现

在数据集成过程中,ETL(Extract, Transform, Load)是关键步骤之一。本文将详细探讨如何使用轻易云数据集成平台,将快麦销售出库单的数据进行ETL转换,并最终写入目标平台MySQLAPI接口。

数据提取与清洗

首先,从快麦系统中提取销售出库单数据。为了确保数据完整性和准确性,需要处理分页和限流问题。例如,通过调用快麦接口erp.trade.outstock.simple.query,可以获取批量订单数据。在提取过程中,应注意处理异常和错误重试机制,以防止数据遗漏。

数据转换

接下来,对提取的数据进行转换,使其符合目标平台MySQLAPI的格式要求。以下是一些关键字段的转换示例:

paymentDiff:订单差额,需要计算系统实付金额与平台实收金额的差值。buyerNick:平台订单上的买家昵称。threePlTiming:3PL有时效订单标识,值为true或false。type:订单类型,根据不同业务需求进行分类。

利用自定义数据转换逻辑,可以适应特定业务需求。例如,将快麦系统中的时间字段格式化为MySQLAPI所需的datetime格式:

SELECT

DATE_FORMAT(ptConsignTime, '%Y-%m-%d %H:%i:%s') AS ptConsignTime,

DATE_FORMAT(payTime, '%Y-%m-%d %H:%i:%s') AS payTime,

DATE_FORMAT(consignTime, '%Y-%m-%d %H:%i:%s') AS consignTime

FROM source_table;数据写入

最后,将转换后的数据写入目标平台MySQLAPI接口。为了实现高效的数据写入,可以采用批量插入方式。以下是一个批量插入的SQL语句示例:

REPLACE INTO erp_trade_outstock_simple_query (

paymentDiff, buyerNick, threePlTiming, type, receiverCity, invoiceRemark, poNos,

packmaCost, receiverPhone, expressCode, expressCompanyName, payment,

adjustFee, isExcep, receiverZip, isTmallDelivery, buyerTaxNo,

isHalt, warehouseId, isRefund, receiverState, expressCompanyId,

status, isUrgent, theoryPostFee, warehouseName

) VALUES (?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?);通过设置合理的批量大小(例如1000条记录),可以提升数据处理效率。同时,利用集中监控和告警系统,实时跟踪数据写入任务的状态和性能,确保任务顺利完成。

数据质量监控与异常检测

在整个ETL过程中,实时监控数据质量至关重要。通过设置各种监控指标和告警机制,可以及时发现并处理数据问题。例如,对比源平台和目标平台的数据条数,确保没有遗漏或重复。

SELECT COUNT(*) FROM source_table;

SELECT COUNT(*) FROM erp_trade_outstock_simple_query;如果发现异常情况,可以自动触发告警,并执行相应的错误重试机制。例如,对于网络中断或数据库连接失败等情况,可以设置重试策略,以保证数据最终一致性。

自定义映射与优化配置

为了适应不同业务场景,可以对字段进行自定义映射。例如,将快麦系统中的字段receiverCity映射到MySQLAPI中的对应字段,并根据业务需求进行必要的转换。

SELECT

receiverCity AS city,

invoiceRemark AS remark

FROM source_table;通过统一视图和控制台管理API资产,可以全面掌握API使用情况,实现资源高效利用和优化配置。

结语

通过以上步骤,我们实现了从快麦系统到MySQLAPI接口的数据ETL转换与写入。在实际操作中,需要根据具体业务需求,不断调整和优化每个环节,以确保数据集成过程高效、可靠、稳定。