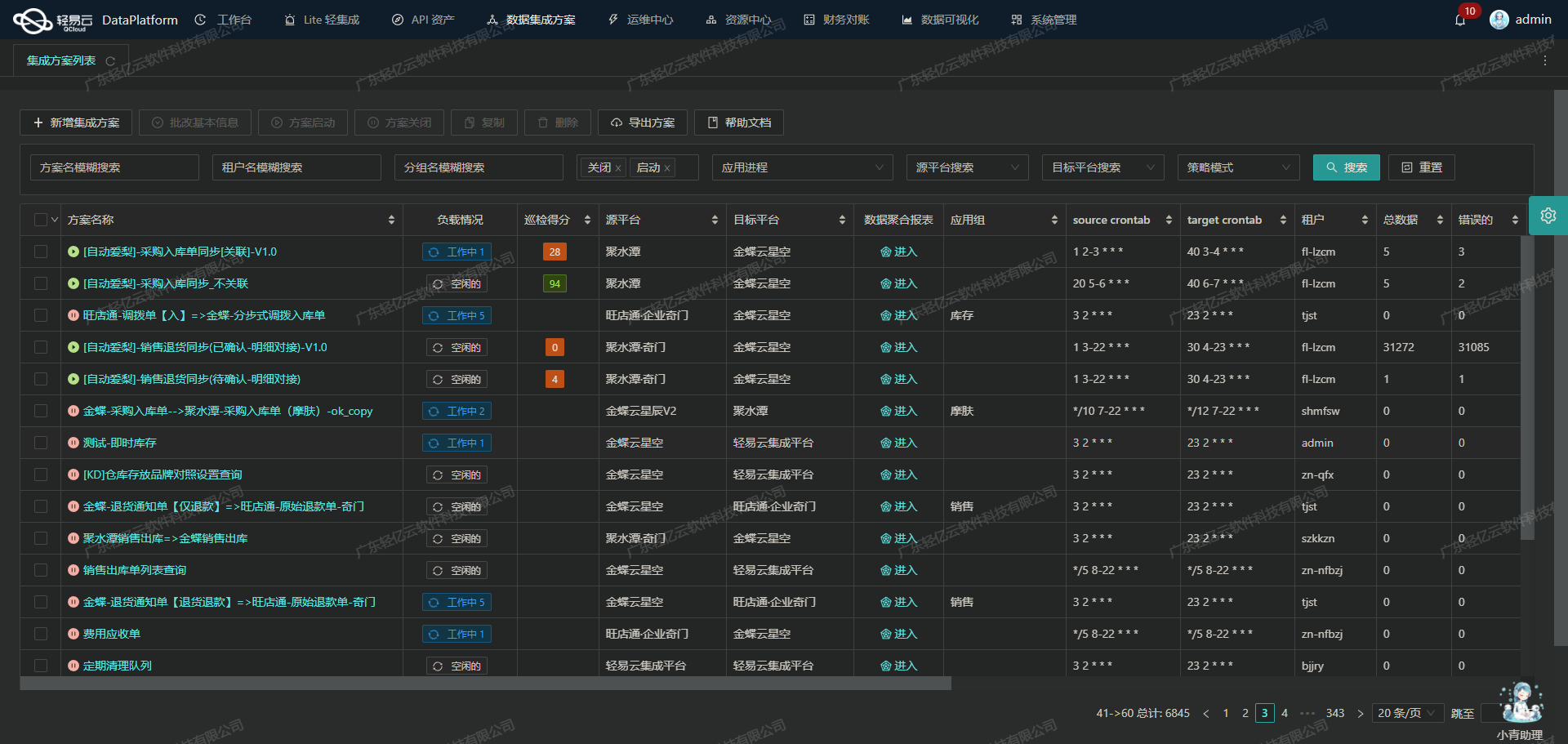

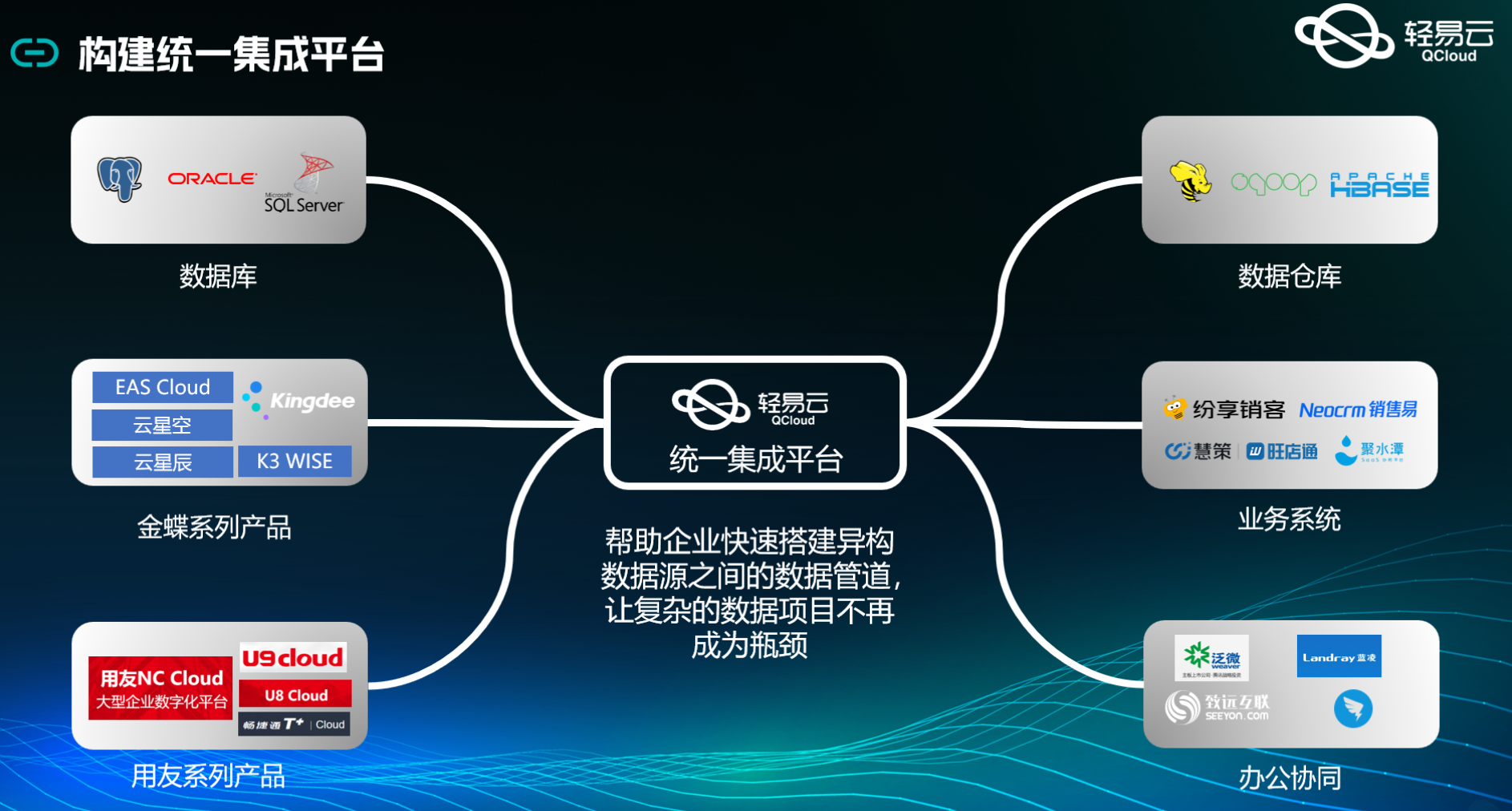

畅捷通T+与吉客云的数据集成案例分享

在企业的日常运营中,数据的高效流转和准确处理至关重要。本文将聚焦于一个具体的系统对接集成案例:如何将畅捷通T+中的产成品入库单(红字)数据无缝集成到吉客云,并创建相应的出库单。

集成背景

本次集成任务旨在实现从畅捷通T+到吉客云的数据传输,确保产成品入库单(红字)能够及时、准确地转换为吉客云中的出库单。通过这一集成方案,我们不仅提升了数据处理的时效性,还确保了业务流程的连贯性和透明度。

技术要点

-

高吞吐量的数据写入能力: 为了应对大量数据的快速写入需求,我们利用轻易云平台强大的数据写入能力,使得来自畅捷通T+的大量产成品入库单能够迅速被处理并传输至吉客云。这极大地提升了整体数据处理效率。

-

实时监控与告警系统: 在整个数据集成过程中,实时监控和告警系统发挥了关键作用。通过集中监控,我们可以随时跟踪每个数据集成任务的状态和性能,及时发现并解决潜在问题,确保数据传输过程顺利进行。

-

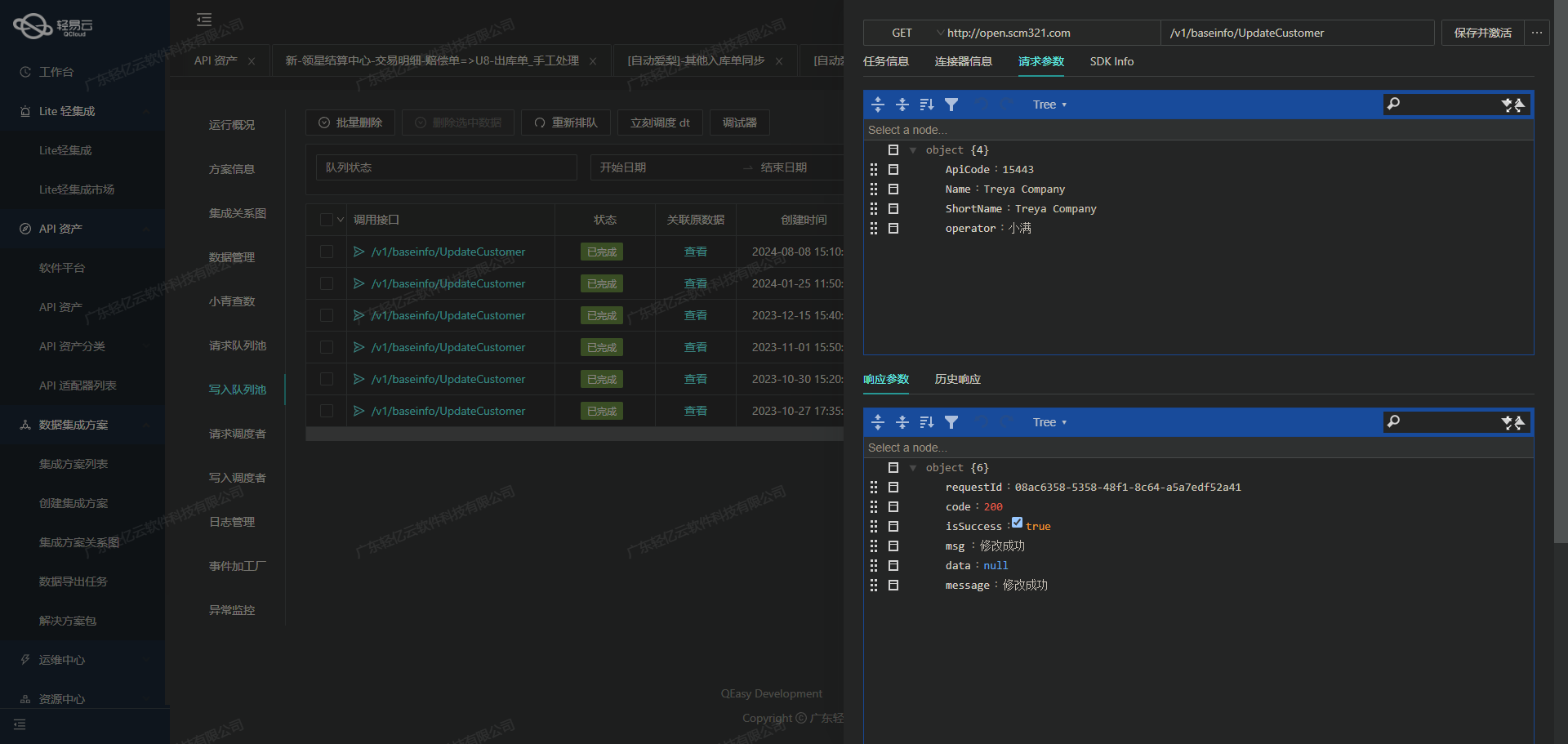

API接口调用: 数据获取方面,我们使用畅捷通T+提供的API接口

/tplus/api/v2/ProductReceiveOpenApi/FindVoucherList来定时抓取最新的产成品入库单(红字)。而在目标平台吉客云上,通过调用其API接口erp.storage.stockoutcreate实现出库单的创建。 -

自定义数据转换逻辑: 由于两个系统之间的数据结构存在差异,我们设计了一套自定义的数据转换逻辑,以适应特定业务需求。这不仅保证了数据格式的一致性,还提高了整体业务流程的自动化程度。

-

异常处理与错误重试机制: 在实际运行中,不可避免会遇到各种异常情况。我们特别设计了一套完善的异常处理与错误重试机制,以确保即使在出现问题时,也能最大限度地减少对业务流程的影响,并保证最终的数据一致性。

通过上述技术手段,本次集成方案成功实现了从畅捷通T+到吉客云的数据无缝对接,为企业提供了一套高效、可靠的数据流转解决方案。在后续章节中,我们将详细探讨具体实施步骤及技术细节。

调用畅捷通T+接口获取并加工数据

在数据集成过程中,调用源系统的API接口是关键的一步。本文将详细探讨如何通过轻易云数据集成平台调用畅捷通T+接口/tplus/api/v2/ProductReceiveOpenApi/FindVoucherList获取产成品入库单【红字】的数据,并进行初步加工处理。

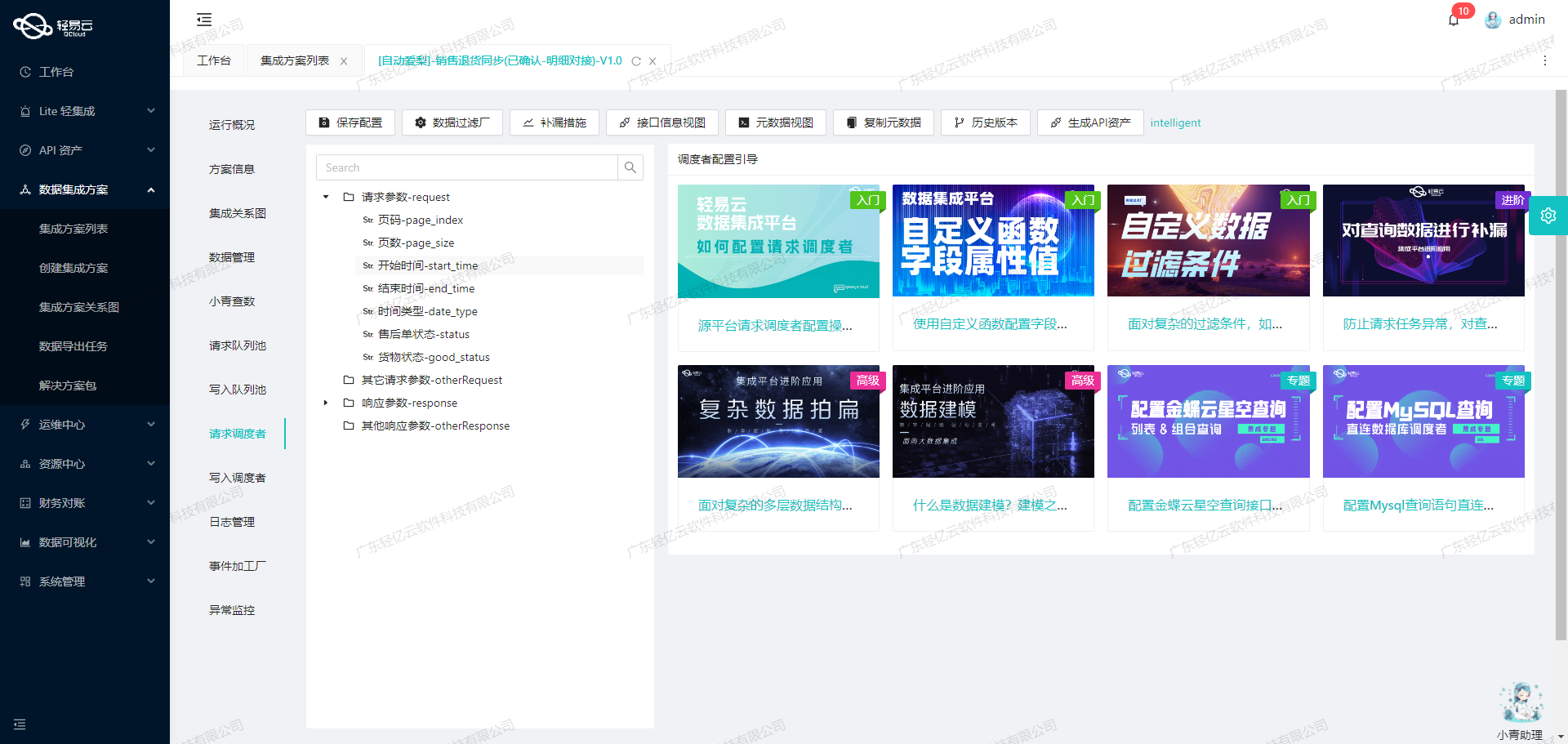

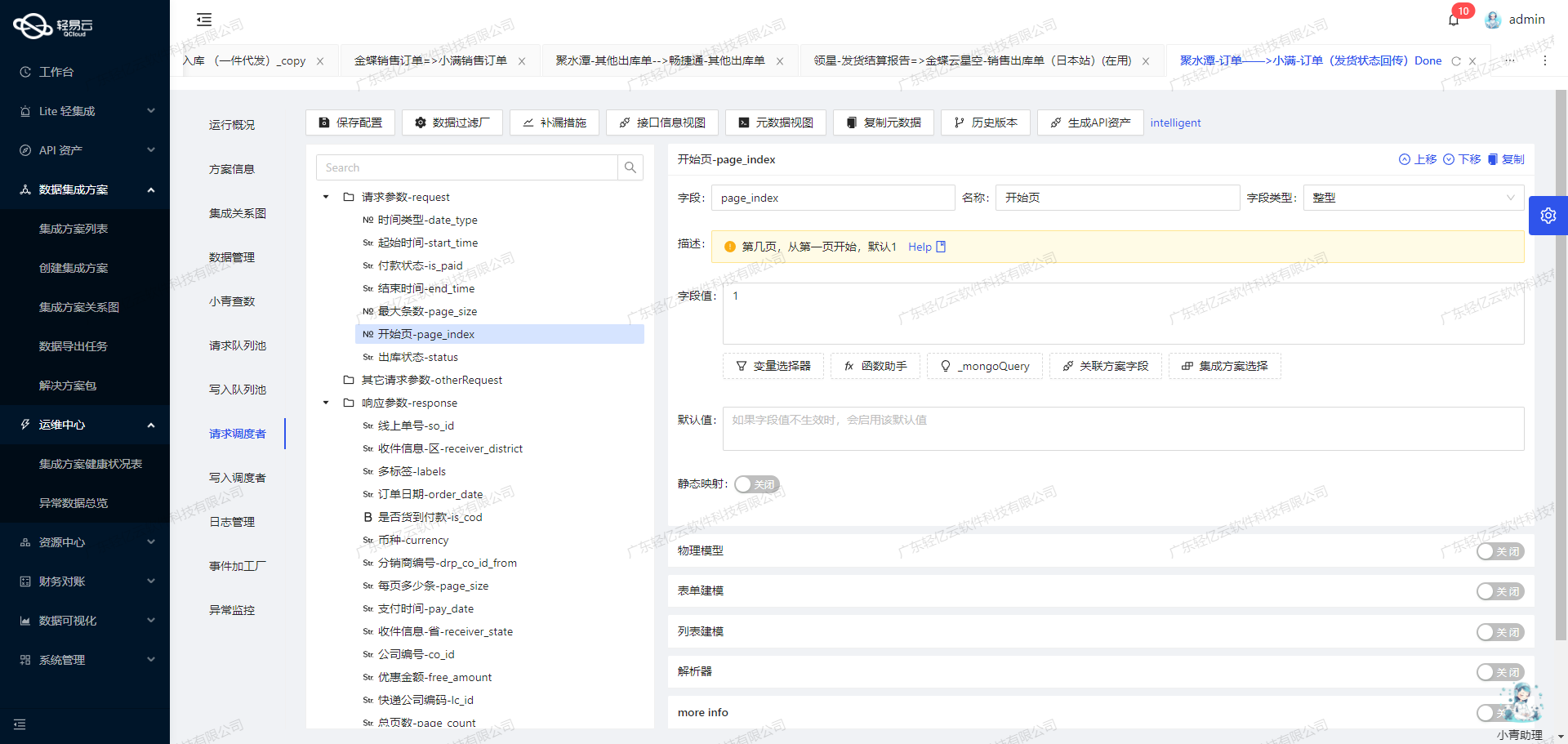

配置元数据

首先,我们需要配置元数据来定义API请求的参数和响应格式。以下是一个典型的元数据配置:

{

"api": "/tplus/api/v2/ProductReceiveOpenApi/FindVoucherList",

"effect": "QUERY",

"method": "POST",

"number": "Code",

"id": "Code",

"idCheck": true,

"request": [

{

"field": "selectFields",

"label": "查询字段",

"type": "string",

"describe": "部门编码",

"value": "VoucherCode,CustomerCode,WarehouseCode,Inventory,InventoryCode,Specification,Unit,Quantity"

},

{

"field": "pageIndex",

...

}

],

...

}请求参数详解

- selectFields: 指定需要查询的字段,包括

VoucherCode,CustomerCode,WarehouseCode,Inventory,InventoryCode,Specification,Unit, 和Quantity。 - pageIndex 和 pageSize: 用于分页请求,确保能够处理大量数据而不会超时或失败。

- paramDic_1 和 paramDic_2: 自定义参数,用于进一步过滤和指定查询条件。例如,

paramDic_1中的RDRecord__AuditedDate用于指定审核日期范围。

数据请求与清洗

在发送请求后,系统会返回包含多个产成品入库单【红字】的数据列表。此时,需要对这些原始数据进行清洗和初步加工,以便后续的数据转换与写入操作。

清洗步骤:

- 过滤无效记录:根据业务需求,只保留符合特定条件的记录。例如,仅保留数量小于0且库存代码在指定范围内的记录。

- 字段映射与重命名:将原始字段映射到目标系统所需的字段名称,并进行必要的重命名。例如,将

VoucherCode映射为目标系统中的凭证编号。 - 异常检测与处理:实时监控返回的数据质量,检测异常值或缺失值,并采取相应措施,如记录日志或触发告警。

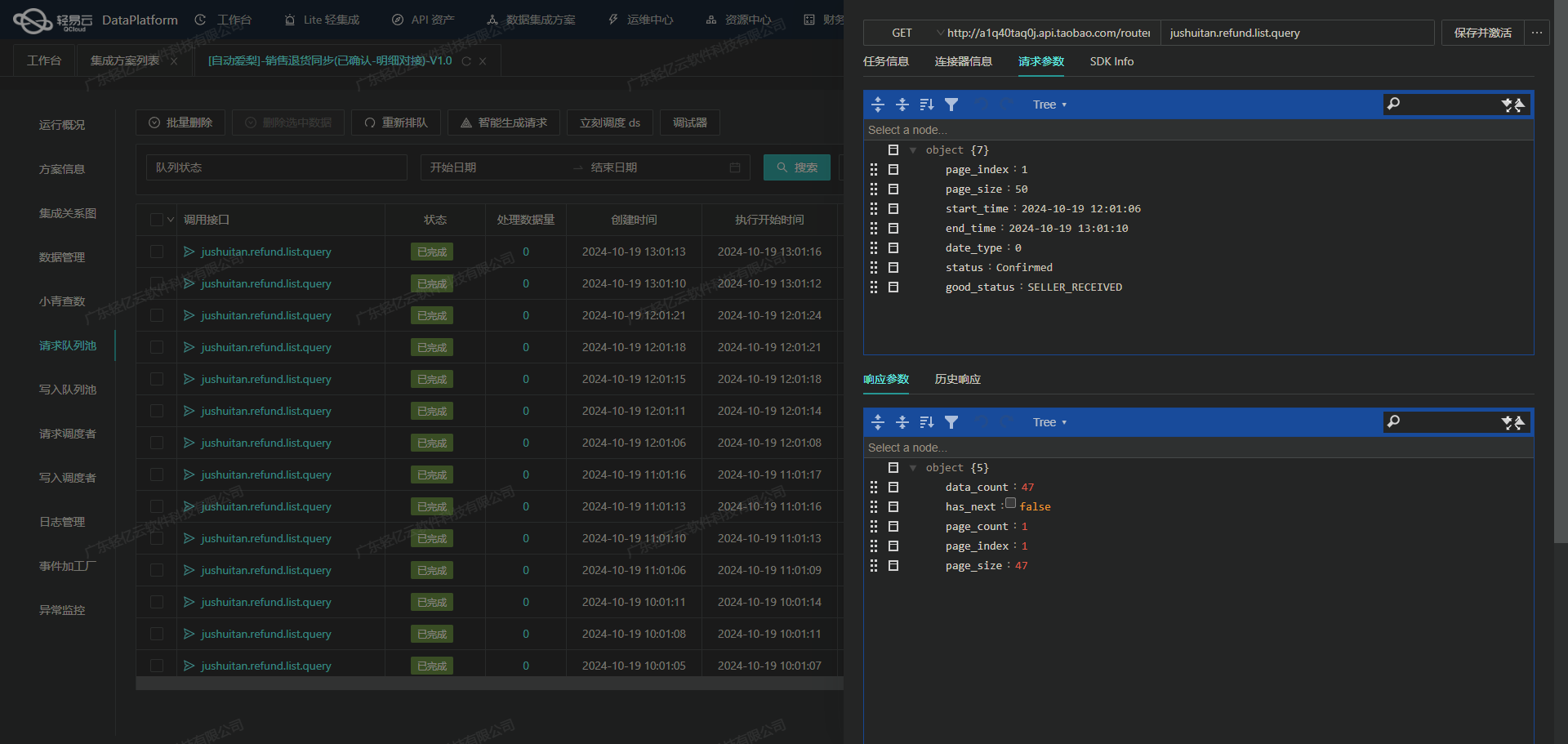

分页与限流处理

由于畅捷通T+接口可能存在分页和限流限制,在实际操作中需要特别注意以下几点:

- 分页处理:通过设置合理的

pageIndex和pageSize参数,分批次获取数据。每次请求后更新页码以获取下一批数据,直到所有数据被完全提取。 - 限流控制:如果遇到接口限流问题,可以实现自动重试机制或调整请求频率,以避免因过多请求导致服务不可用。

数据转换与写入准备

完成初步清洗后,需要将整理好的数据转换为目标系统(如吉客云)所需的格式。这包括但不限于:

- 字段类型转换,例如将字符串类型的数量转换为数值类型。

- 数据结构调整,例如将平铺结构的数据转化为嵌套结构,以适应目标系统的数据模型。

最后,通过轻易云平台提供的数据写入功能,将处理后的数据高效地写入到吉客云中,实现完整的数据集成流程。

总结

通过上述步骤,我们成功地调用了畅捷通T+接口获取产成品入库单【红字】的数据,并进行了必要的清洗和初步加工。这一过程不仅确保了高质量的数据输入,还为后续的数据转换与写入打下了坚实基础。在整个过程中,轻易云平台提供了强大的支持,使得复杂的数据集成任务变得更加简洁高效。

将T+产成品入库单【红字】数据转换并写入吉客云

在数据集成的生命周期中,ETL(Extract, Transform, Load)转换是至关重要的一步。本文将详细探讨如何将畅捷通T+系统中的产成品入库单【红字】数据进行ETL转换,并通过吉客云API接口写入目标平台。

数据提取与清洗

首先,从畅捷通T+系统中提取产成品入库单【红字】的数据。在提取阶段,确保数据的完整性和准确性是关键。通过调用畅捷通T+的API接口 /tplus/api/v2/ProductReceiveOpenApi/FindVoucherList,可以获取所需的数据。

{

"Code": "RD20231010",

"Warehouse": {

"Code": "WH001"

},

"AuditedDate": "2023-10-10",

"RDRecordDetails": [

{

"InventoryCode": "INV001",

"ArrivalQuantity": -100,

"Batch": "BATCH001",

"ProductionDate": "2023-09-01",

"ExpiryDate": "2024-09-01",

"InventoryExpiredUnit": "月"

}

]

}数据转换

在清洗完毕后,需要将数据转换为吉客云API接口所能接收的格式。根据元数据配置,我们需要将提取的数据字段映射到吉客云API erp.storage.stockoutcreate 的请求参数中。

- 仓库编码 (

outWarehouseCode):直接映射Warehouse.Code。 - 出库类型 (

outType):固定值205。 - 关联单据编号 (

relDataId):映射Code。 - 申请出库时间 (

applyDate):映射AuditedDate。 - 备注信息 (

memo):拼接字符串产成品入库单红字-{Code}。 - source:固定值

OPEN。 - 出库明细 (

stockOutDetailViews):处理嵌套数组,逐项映射RDRecordDetails中的字段。

{

"api": "erp.storage.stockoutcreate",

"effect": "EXECUTE",

"method": "POST",

"idCheck": true,

"request": [

{

"field": "outWarehouseCode",

...

},

{

...

},

{

...

},

{

...

},

{

...

},

{

...

},

{

...

}

]

}数据写入

完成数据转换后,通过POST请求将数据写入吉客云。以下是一个简化后的请求示例:

{

"outWarehouseCode": "{{Warehouse.Code}}",

...

"stockOutDetailViews": [

{

...

"_function '{{RDRecordDetails.ArrivalQuantity}}'*(-1)"

...

}

]

}异常处理与重试机制

在实际操作过程中,可能会遇到网络延迟、API限流等问题。为了确保数据可靠性,需要实现异常处理与重试机制。一旦检测到错误,可以记录日志并进行重试,直到成功为止。

实时监控与日志记录

为了确保整个ETL过程的透明度和可追溯性,必须实现实时监控和日志记录。通过轻易云平台提供的集中监控和告警系统,可以实时跟踪数据集成任务的状态和性能,并及时发现和处理潜在问题。

总结

通过上述步骤,我们可以高效地将畅捷通T+系统中的产成品入库单【红字】数据进行ETL转换,并通过吉客云API接口成功写入目标平台。这一过程不仅提升了数据处理的时效性,还确保了数据的一致性和完整性,为企业的数据管理提供了坚实保障。