金蝶云星空数据集成到MySQL的技术案例分享

在现代企业的数据管理中,系统间的数据集成是确保业务流程高效运转的关键环节。本文将聚焦于一个具体的系统对接集成案例:金蝶云星空数据集成到MySQL,方案名称为MOM-XSCK-T02.01销售出库-表体-测试环境。

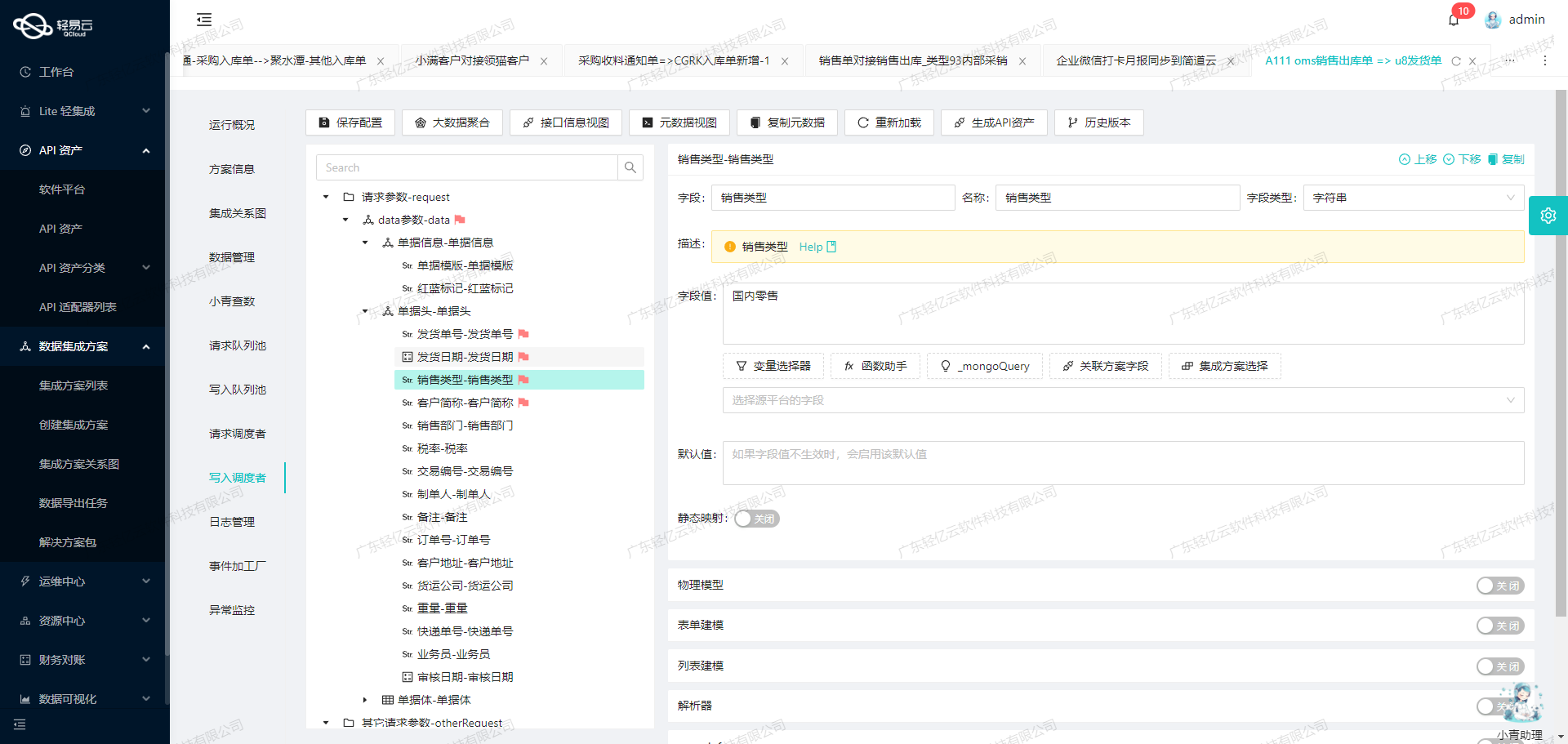

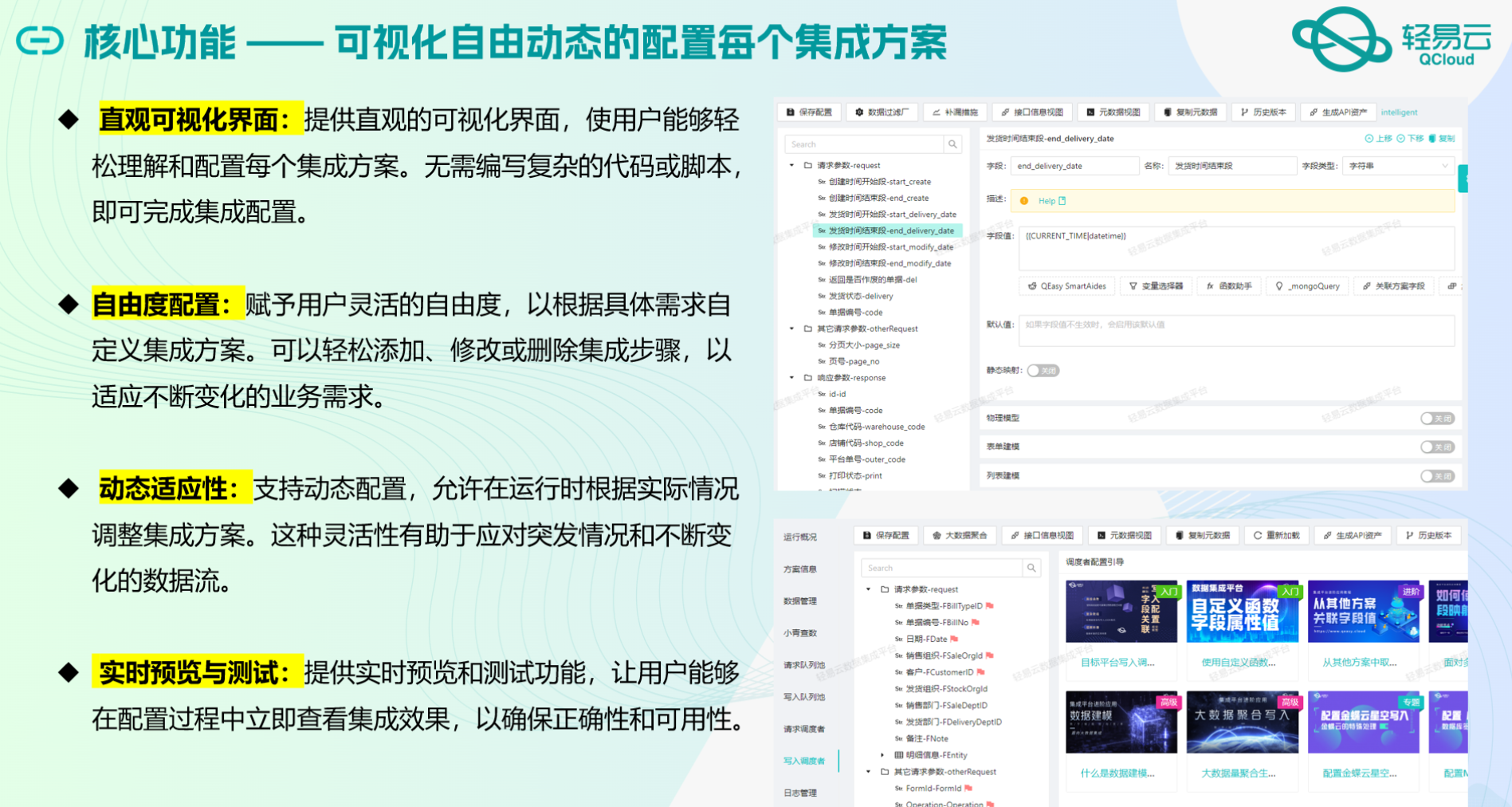

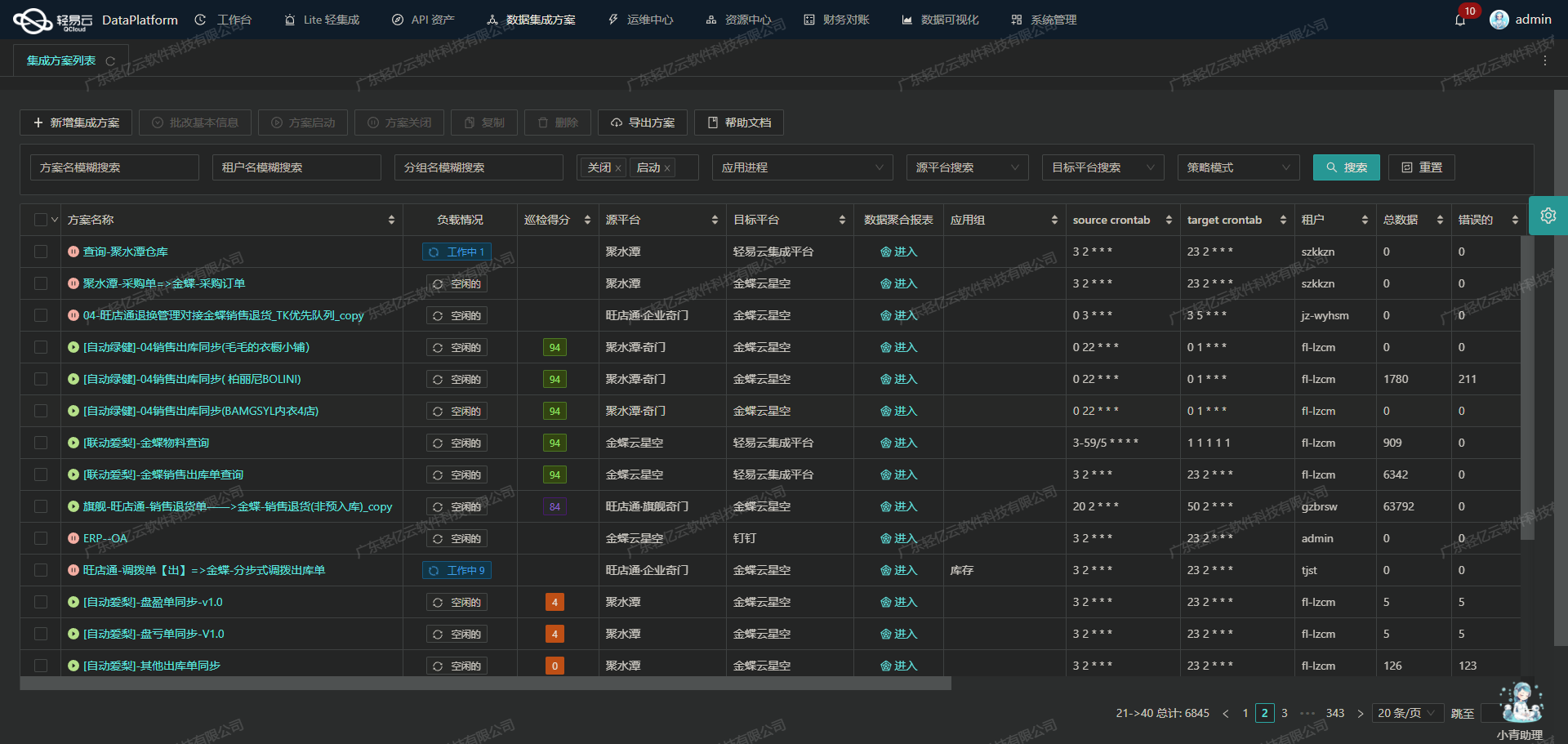

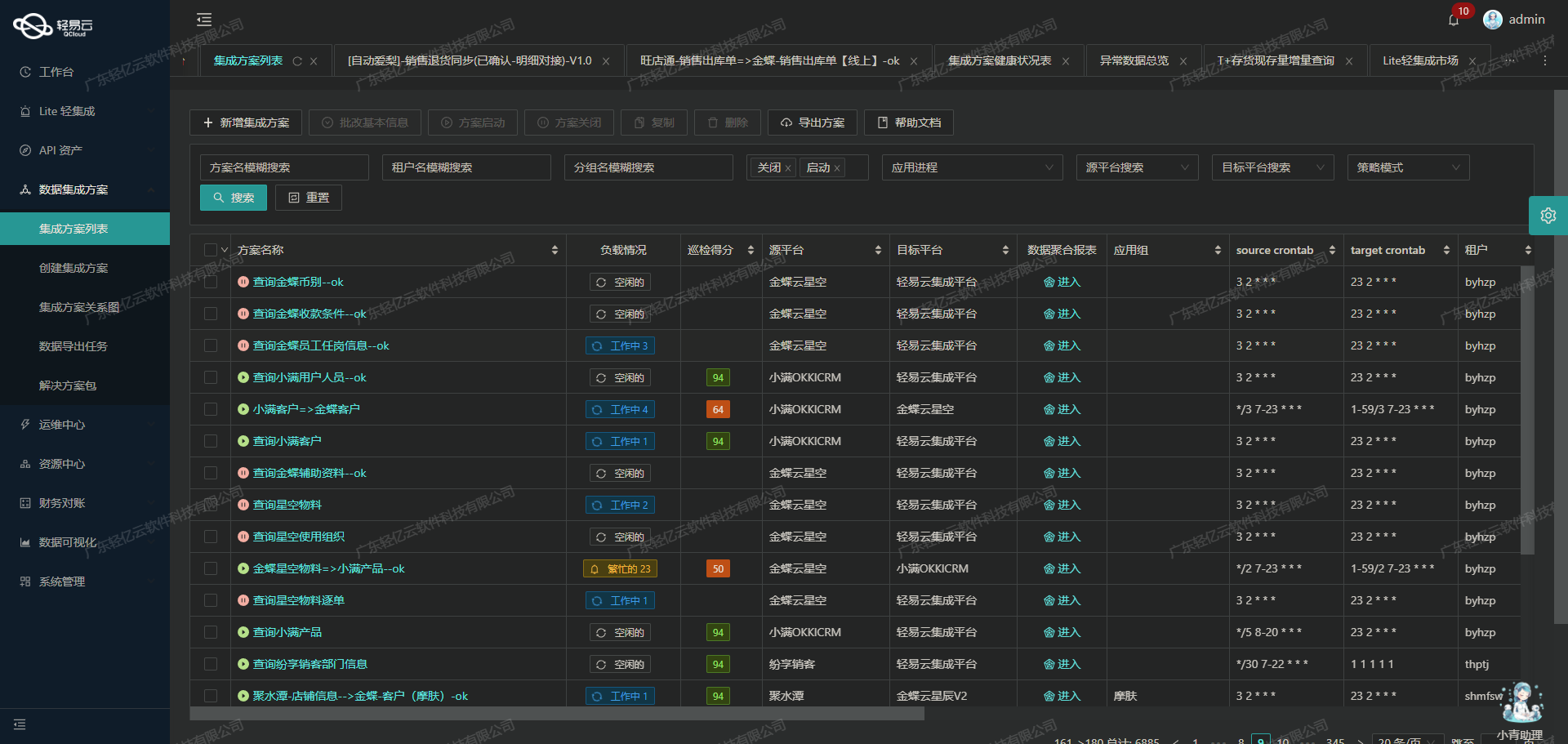

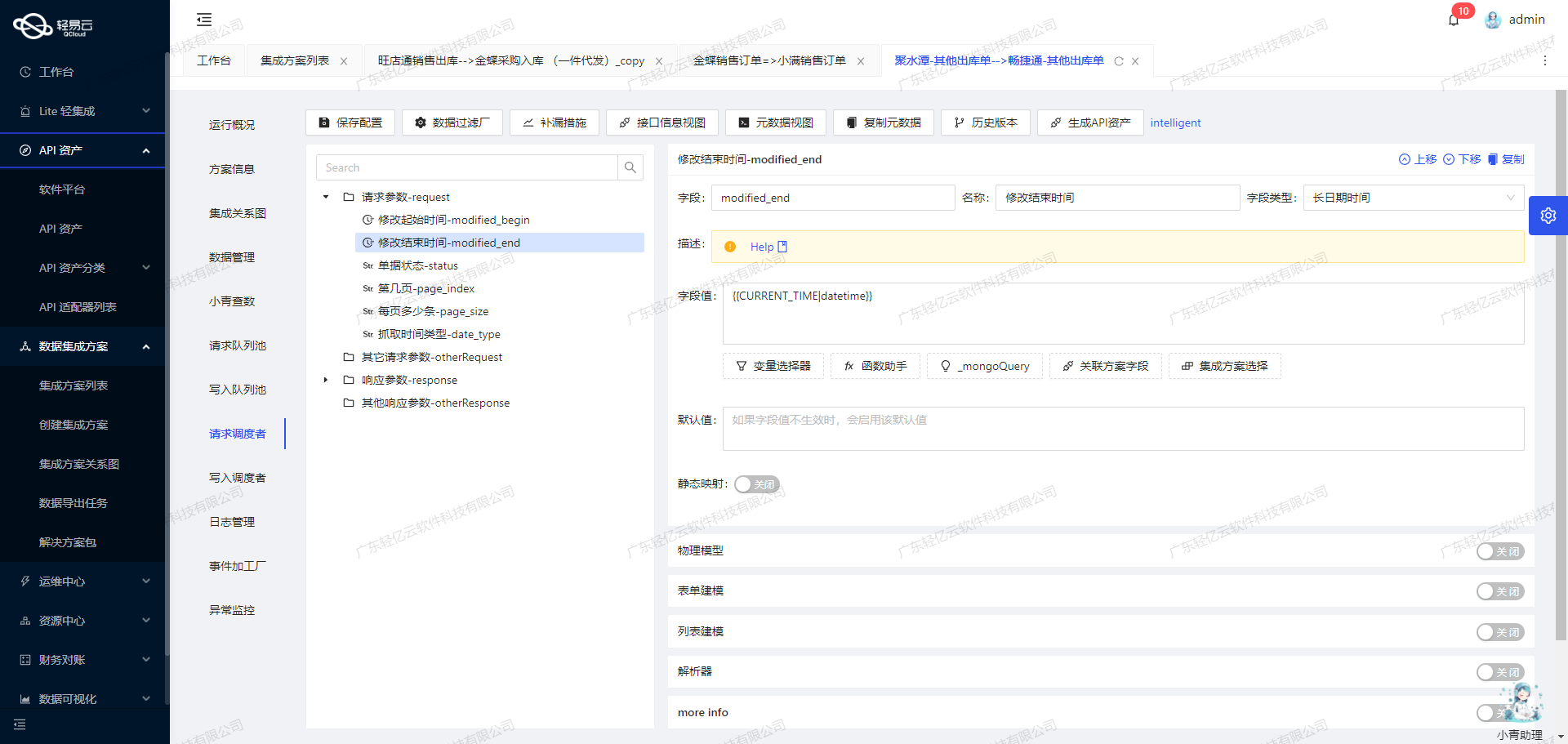

在这个案例中,我们利用轻易云数据集成平台,实现了金蝶云星空与MySQL之间的数据无缝对接。通过调用金蝶云星空的executeBillQuery API接口,我们能够定时可靠地抓取销售出库相关数据,并批量写入到MySQL数据库中。为了确保数据处理的时效性和准确性,我们特别关注了以下几个技术要点:

- 高吞吐量的数据写入能力:大量销售出库数据需要快速写入到MySQL,这要求我们的解决方案具备高效的数据传输和处理能力。

- 实时监控与告警系统:我们提供了集中化的监控和告警机制,实时跟踪数据集成任务的状态和性能,以便及时发现并处理潜在问题。

- 自定义数据转换逻辑:由于金蝶云星空与MySQL之间存在数据格式差异,我们设计了灵活的数据转换逻辑,以适应特定业务需求,确保数据的一致性和完整性。

- 分页与限流处理:在调用金蝶云星空接口时,为了避免因大批量请求导致系统性能下降,我们实现了分页抓取和限流控制机制。

- 异常处理与错误重试机制:针对可能出现的网络波动或其他异常情况,我们设计了一套完善的错误重试机制,确保每一条记录都能成功传输并存储。

通过这些技术手段,我们不仅实现了金蝶云星空与MySQL之间的数据无缝对接,还提升了整体业务流程的透明度和效率。在后续章节中,将详细介绍具体实施步骤及技术细节。

调用金蝶云星空接口executeBillQuery获取并加工数据

在轻易云数据集成平台的生命周期中,第一步是调用源系统金蝶云星空接口executeBillQuery以获取并加工数据。这一步骤至关重要,因为它确保了从源系统提取的数据准确无误,并为后续的数据处理和写入奠定了基础。

接口配置与调用

金蝶云星空提供的executeBillQuery接口用于查询销售出库单表体数据。该接口采用POST请求方式,支持多种查询条件和分页参数,以满足不同业务场景下的数据提取需求。

元数据配置如下:

{

"api": "executeBillQuery",

"effect": "QUERY",

"method": "POST",

"id": "FEntity_FENTRYID",

"idCheck": true,

...

}其中,api字段指定了要调用的接口名称,method字段定义了请求方法为POST,idCheck表示是否进行主键检查。

请求参数详解

请求参数分为两部分:基本请求参数和其他请求参数。

-

基本请求参数

基本请求参数包括销售出库单号、状态、日期等关键字段。例如:

{ "field": "fbillno", "label": "销售出库单号", "type": "string", ... } -

其他请求参数

其他请求参数主要用于控制分页和过滤条件。例如:

{ "field": "Limit", "label": "Limit", ... }, { "field": "FilterString", ... }

其中,分页参数如Limit, StartRow, TopRowCount可以有效控制每次查询的数据量,而过滤条件则通过SQL语法来实现复杂的筛选逻辑。

数据清洗与转换

在获取到原始数据后,需要对其进行清洗与转换,以确保数据符合目标系统的要求。以下是几个关键步骤:

-

字段映射

将源系统中的字段映射到目标系统对应的字段。例如,将金蝶云星空中的客户代码(FCustomerID.fnumber)映射到目标系统中的客户代码字段。

-

数据类型转换

根据目标系统的要求,对某些字段的数据类型进行转换。例如,将日期字符串转换为标准日期格式。

-

异常处理

对于可能出现的异常情况,如缺失值或格式错误,需要进行相应的处理,以保证数据质量。可以设置默认值或跳过异常记录,并记录日志以便后续分析。

分页与限流处理

由于金蝶云星空接口对每次查询返回的数据量有限制,因此需要通过分页机制来逐步获取全部数据。在实际操作中,可以使用以下策略:

-

设置分页大小

根据业务需求设置合理的分页大小(如100条记录),以平衡性能和效率。

-

循环查询

使用循环结构,通过调整分页起始行(StartRow)逐页查询,直到所有数据被提取完毕。例如:

{ field: 'StartRow', value: '{PAGINATION_START_ROW}' } -

限流控制

在高并发场景下,为避免对源系统造成过大压力,可以设置限流策略,如延迟一定时间再发起下一次查询。

实时监控与日志记录

为了确保整个过程透明可控,需要对每个环节进行实时监控,并记录详细日志。这样不仅有助于及时发现问题,还能为后续优化提供依据。轻易云平台提供了集中的监控和告警功能,可以实时跟踪任务状态和性能指标,并在发生异常时及时通知相关人员。

综上所述,通过合理配置和调用金蝶云星空接口executeBillQuery,结合有效的数据清洗、转换、分页及限流策略,以及完善的监控与日志机制,可以高效地完成从源系统到目标系统的数据集成过程。这一过程中,每一个细节都至关重要,需要精心设计和实施,以确保最终集成效果达到预期。

数据集成平台生命周期第二步:数据ETL转换与写入MySQL

在数据集成的过程中,第二步是将已经集成的源平台数据进行ETL(Extract-Transform-Load)转换,并转为目标平台MySQL API接口所能够接收的格式,最终写入目标平台。这个过程不仅需要处理数据格式的转换,还需要确保数据质量和一致性。以下是具体操作步骤及其技术要点。

1. 数据提取(Extract)

首先,从源系统中提取原始数据。这一步通常通过API调用来实现。在本案例中,我们使用executeBillQuery接口从金蝶云星空系统中获取销售出库单据表体的数据。提取的数据包括多个字段,如INSTRUCTION_DOC_LINE_ID、MATERIAL_ID、QUANTITY等。

2. 数据转换(Transform)

在数据转换阶段,需要将提取的数据按照目标平台MySQL API接口要求的格式进行转换。这里涉及到字段名的映射、数据类型的转换以及业务逻辑的处理。例如:

- 字段映射:将源系统中的字段名映射到目标系统中的字段名,例如将FEntity_FENTRYID映射为INSTRUCTION_DOC_LINE_ID。

- 数据类型转换:确保源系统中的数据类型与目标系统中的数据类型一致,例如将字符串类型的数据转换为目标系统需要的数值类型。

- 业务逻辑处理:根据业务需求对数据进行处理,例如计算某些字段的值或根据条件填充字段。

以下是部分元数据配置示例,用于展示如何进行字段映射和业务逻辑处理:

{

"field": "INSTRUCTION_DOC_LINE_ID",

"label": "INSTRUCTION_DOC_LINE_ID*",

"type": "string",

"value": "{FEntity_FENTRYID}"

},

{

"field": "FROM_SITE_ID",

"label": "来源站点id*",

"type": "string",

"value": "_function case '{FStockOrgId}' when 'T02.01' then '11001' when 'T02' then '8001' else '' end"

}在上述配置中,FEntity_FENTRYID被映射为INSTRUCTION_DOC_LINE_ID,而FROM_SITE_ID则通过一个函数根据不同条件赋值。

3. 数据加载(Load)

在完成数据转换后,下一步是将数据加载到目标平台MySQL中。这一步通常通过API调用或数据库连接来实现。在本案例中,我们使用MySQL API接口执行存储过程,将转换后的数据写入MySQL数据库。

存储过程调用示例如下:

call ty_mes.XSCK1(:ATTRIBUTE10, :BUSINESS_TYPE_1, :BUSINESS_TYPE_2, :CID, :CID_2, :CREATION_DATE, :CUSTOMER_ID, :CUSTOMER_SITE_ID, :DEMAND_TIME, :DIS_ROUTER_ID, :EO_ID, :FROM_LOCATOR_ID, :FROM_LOCATOR_ID_1, :FROM_SITE_ID, :IDENTIFICATION, :IDENTIFICATION_1, :IDENTIFICATION_2, :INSTRUCTION_DOC_ID, :INSTRUCTION_DOC_LINE_ID, :INSTRUCTION_ID_1, :INSTRUCTION_ID_2, :INSTRUCTION_NUM_1, :INSTRUCTION_NUM_2, :INSTRUCTION_STATUS, :INSTRUCTION_TYPE_1, :INSTRUCTION_TYPE_2, :LAST_UPDATE_DATE, ...以上存储过程调用包含了所有需要写入MySQL数据库的字段,通过参数传递实现动态赋值。

4. 数据质量监控与异常处理

为了确保数据质量和一致性,需要对整个ETL过程进行监控,并及时处理异常情况。可以通过以下措施实现:

- 实时监控:利用轻易云平台提供的集中监控和告警系统,实时跟踪数据集成任务的状态和性能。

- 异常检测与重试机制:设置异常检测规则,一旦发现异常立即记录日志并触发重试机制。例如,对于网络故障导致的数据写入失败,可以设置一定次数的重试,以确保最终成功写入。

- 日志记录:详细记录每次API调用和存储过程执行情况,包括输入参数、返回结果和执行时间等,以便后续分析和排查问题。

5. 性能优化

在大量数据集成场景下,性能优化尤为重要。可以通过以下方法提升性能:

- 批量处理:对于大批量的数据,可以采用批量处理方式,一次性提交多个记录,减少API调用次数,提高效率。

- 并行处理:利用多线程或多进程技术,实现并行处理,提高吞吐量。

- 索引优化:在MySQL数据库中,为关键字段建立索引,加快查询速度和写入效率。

综上所述,通过以上步骤和技术手段,可以有效地将源平台的数据进行ETL转换,并高效地写入目标平台MySQL,实现不同系统间的数据无缝对接。