金蝶云星空数据集成案例分享:其他入库单--销售退货单(虚拟客户1元)-箱包TW

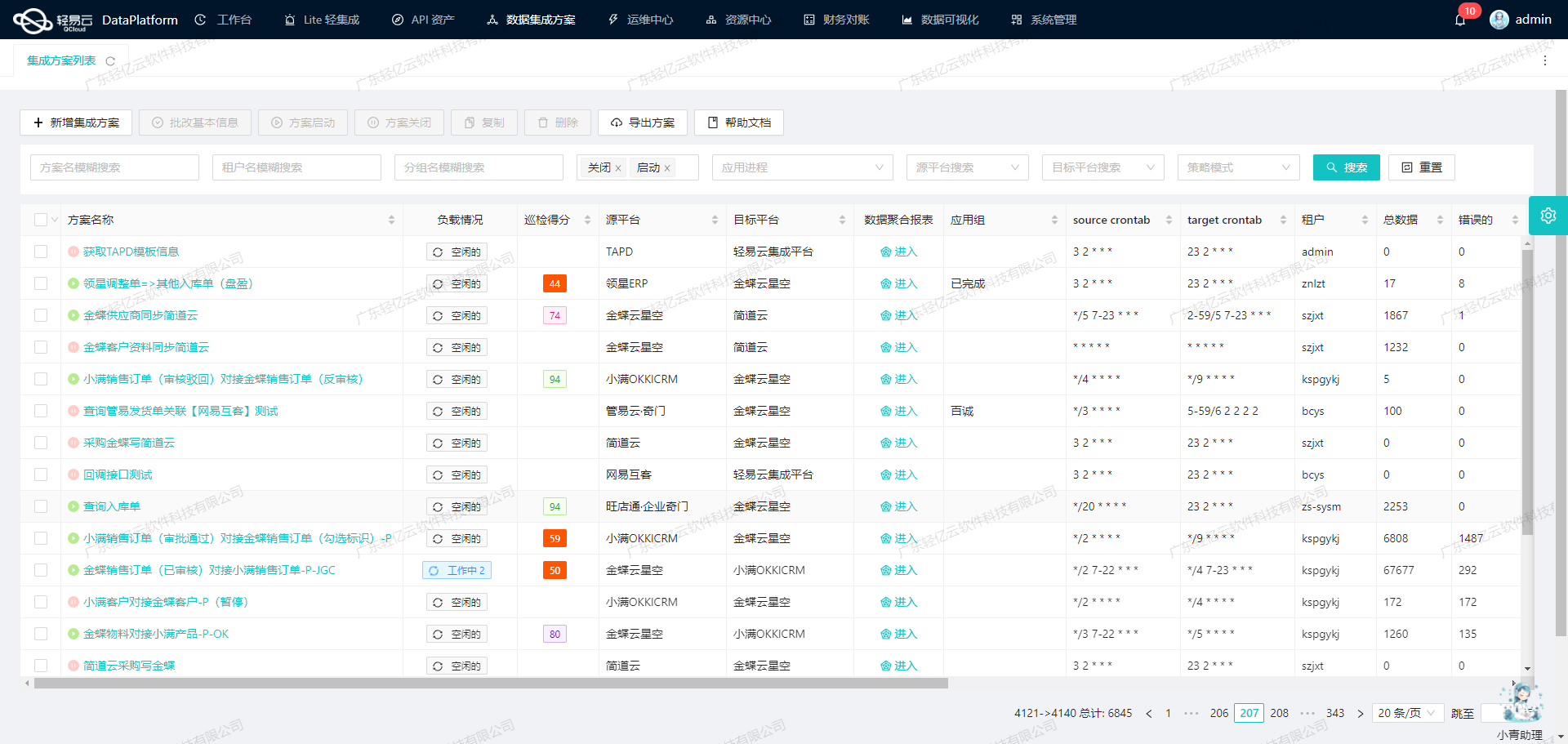

在企业日常运营中,数据的高效流动和准确处理是确保业务顺畅运行的关键。本文将聚焦于一个具体的系统对接集成案例,即如何将“其他入库单--销售退货单(虚拟客户1元)-箱包TW”数据从金蝶云星空平台集成到同一平台内,实现数据的无缝对接与高效处理。

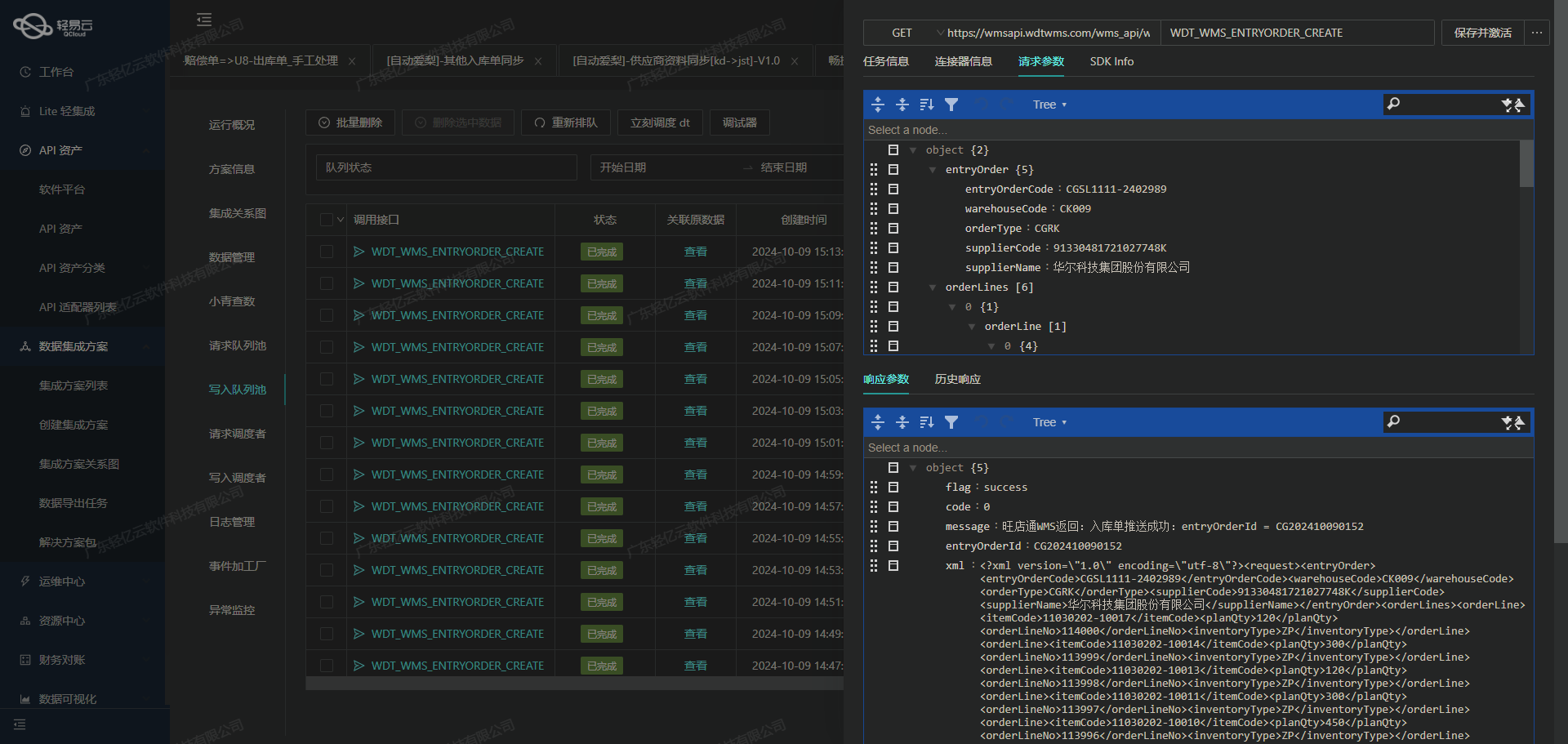

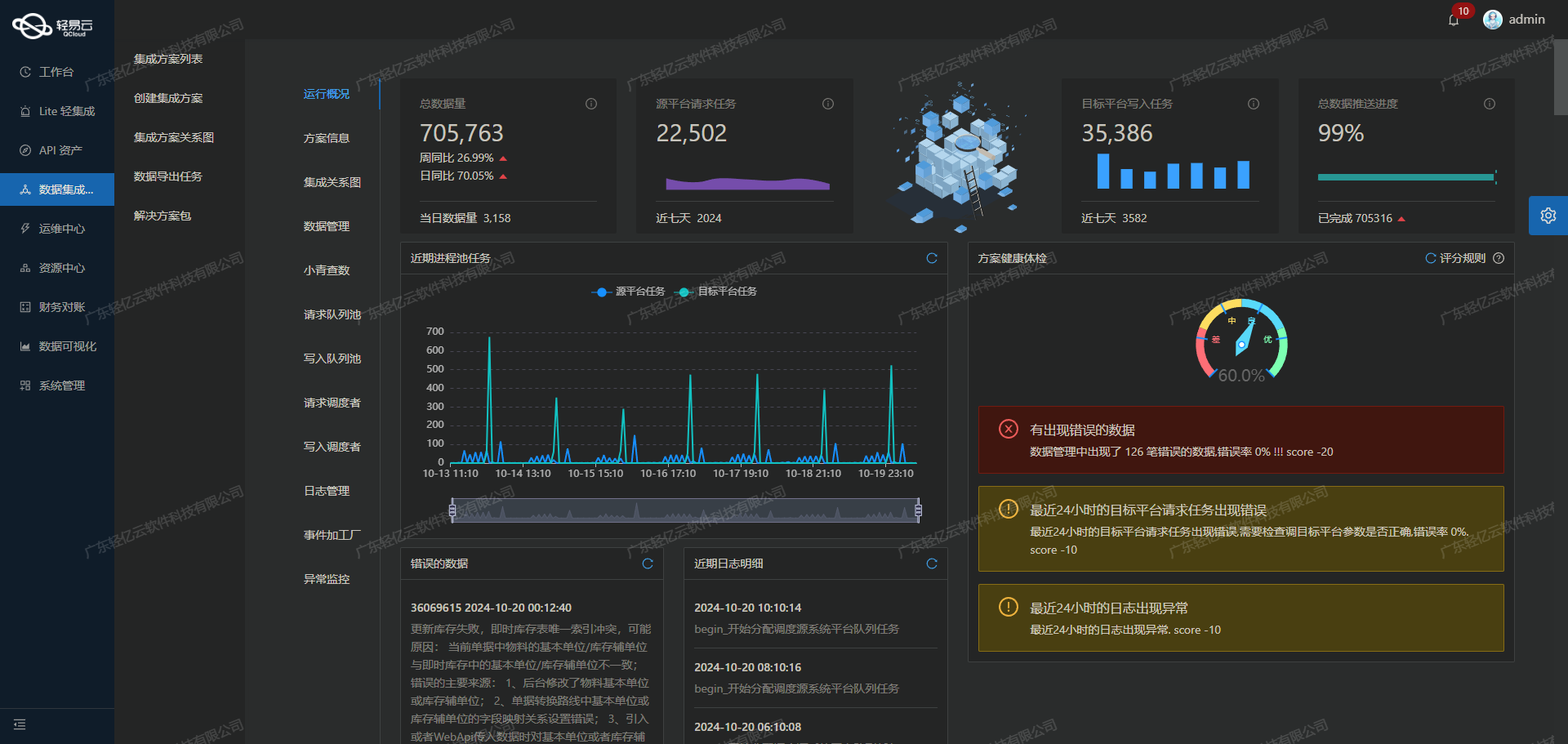

本次集成方案利用了金蝶云星空强大的API接口功能,通过executeBillQuery获取源数据,并使用batchSave进行目标平台的数据写入。为了确保整个过程的高效性和可靠性,我们采用了一系列技术手段:

-

高吞吐量的数据写入能力:通过优化批量写入策略,使得大量“其他入库单--销售退货单”数据能够快速被集成到目标系统中,大幅提升了数据处理的时效性。

-

实时监控与告警系统:在集成过程中,实时跟踪每个任务的状态和性能,一旦出现异常情况,系统会立即发出告警通知,从而及时采取措施,避免业务中断。

-

自定义数据转换逻辑:针对不同业务需求和数据结构差异,我们设计了灵活的数据转换规则,以确保源数据在写入目标平台前能够满足特定要求。

-

分页与限流处理:为应对金蝶云星空API接口的分页和限流问题,我们制定了合理的数据抓取策略,确保在不影响系统性能的前提下,高效完成大批量数据的获取与写入。

-

异常处理与错误重试机制:在实际操作中,不可避免地会遇到各种异常情况。我们通过建立健全的错误重试机制,有效提高了任务成功率,保障了数据的一致性和完整性。

-

集中化监控与日志记录:整个集成过程中的每一步操作都被详细记录并集中监控,这不仅有助于问题排查,还能为后续优化提供宝贵的数据支持。

通过上述技术手段,本次“其他入库单--销售退货单(虚拟客户1元)-箱包TW”的集成方案不仅实现了高效、稳定的数据对接,还显著提升了业务透明度和管理效率。在接下来的章节中,我们将详细探讨具体实施步骤及相关技术细节。

调用金蝶云星空接口executeBillQuery获取并加工数据

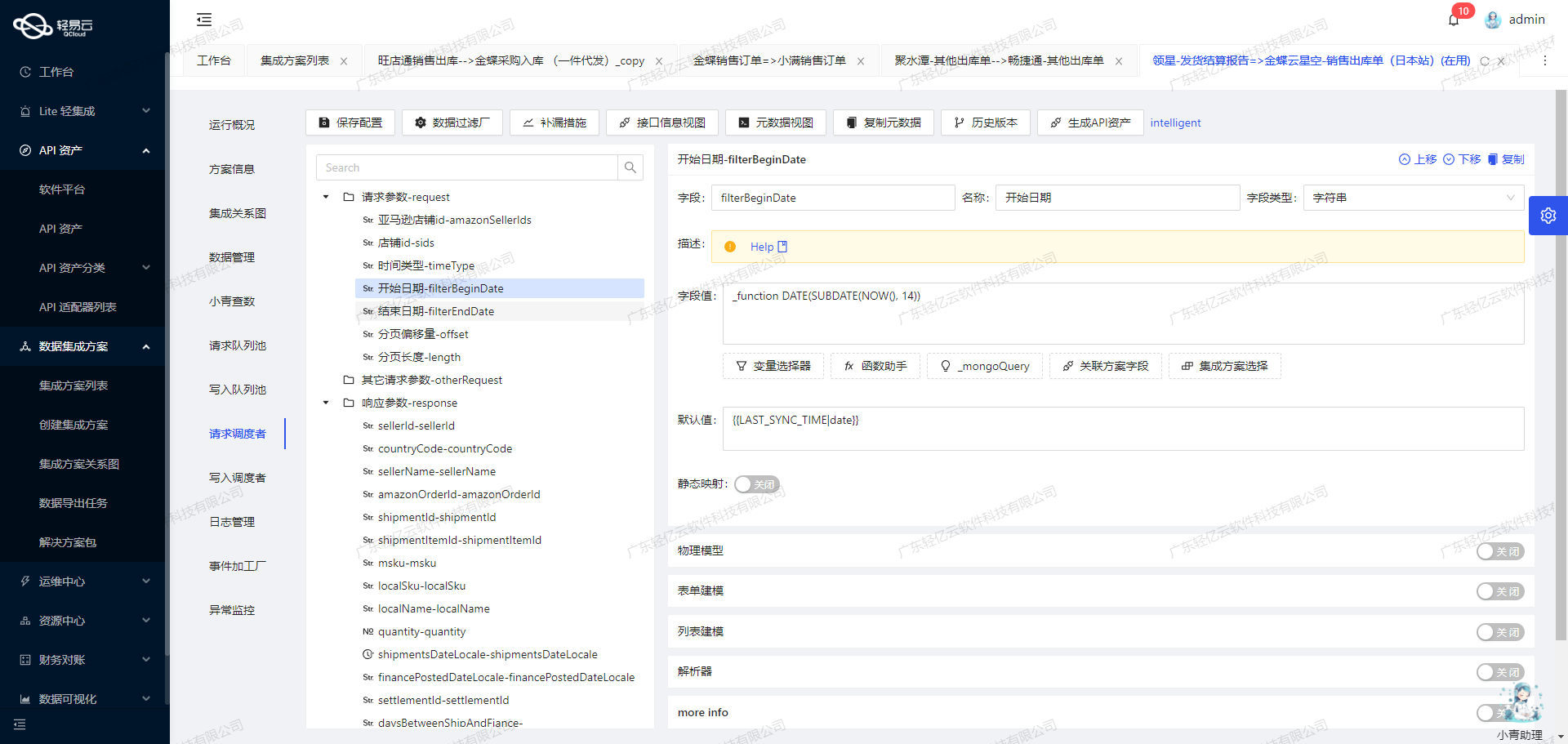

在轻易云数据集成平台的生命周期中,调用源系统接口是至关重要的一步。本文将详细探讨如何通过金蝶云星空的executeBillQuery接口获取并加工数据,以实现其他入库单到销售退货单(虚拟客户1元)的集成。

接口调用配置

首先,需要配置调用金蝶云星空API的相关参数。根据提供的元数据配置,我们需要以下关键字段:

api: "executeBillQuery"method: "POST"number: "FBillNo"id: "FEntity_FEntryID"

这些字段定义了我们要查询的数据类型和方法。

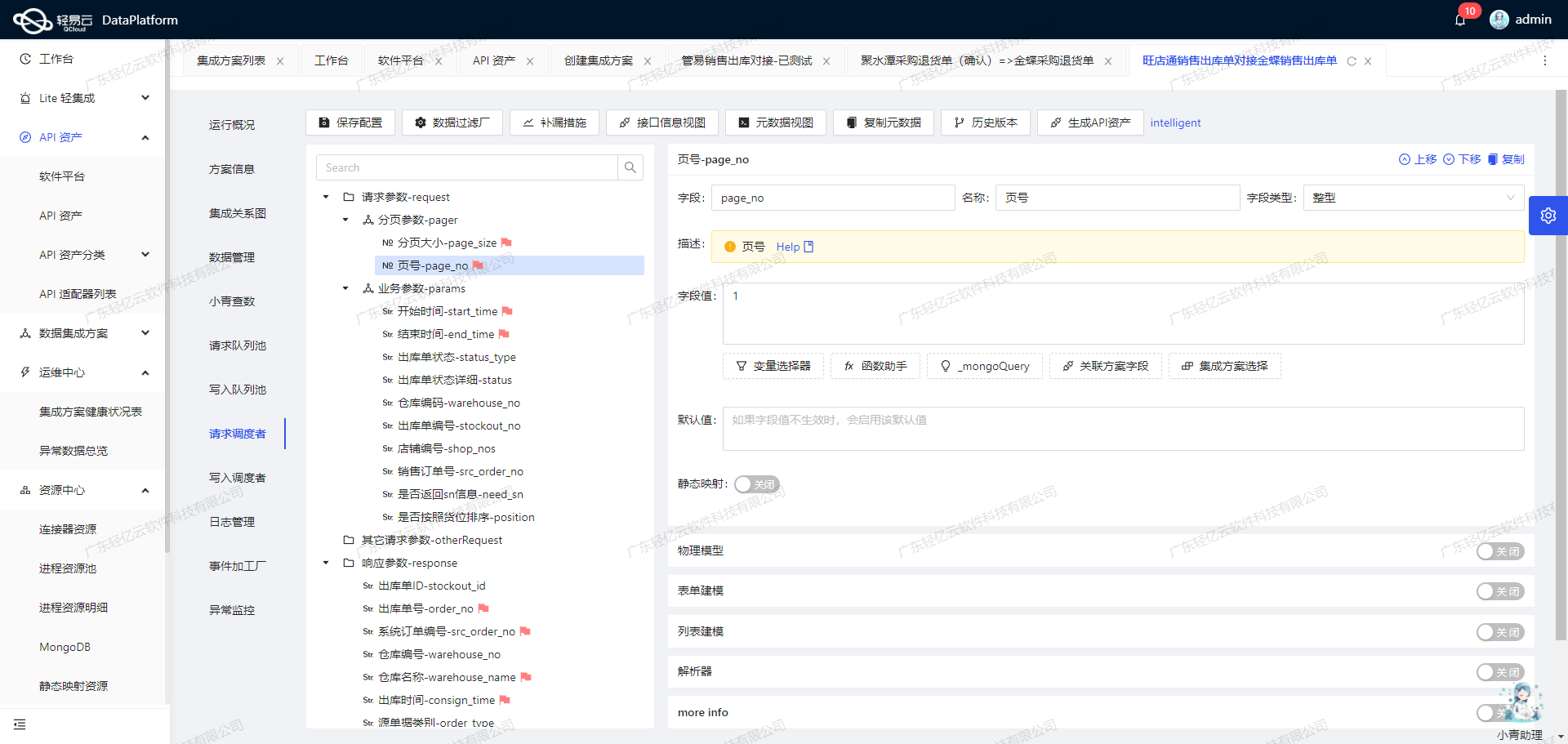

请求参数设置

为了确保请求能够正确执行,我们需要设置具体的请求参数。这些参数包括分页信息、过滤条件以及需要查询的字段集合等。

{

"Limit": "{PAGINATION_PAGE_SIZE}",

"StartRow": "{PAGINATION_START_ROW}",

"TopRowCount": 0,

"FilterString": "FDate >='{{LAST_SYNC_TIME|date}}' and FBillTypeID.FNumber='QTRKD07_SYS' and FStockOrgId.FNumber= '202'",

"FieldKeys": [

"FEntity_FEntryID",

...

// 省略其他字段

],

"FormId": "STK_MISCELLANEOUS"

}上述配置中的FilterString用于筛选特定条件下的数据,例如日期范围和单据类型等。FieldKeys则指定了我们感兴趣的数据字段,如单据编号、库存组织、物料编码等。

数据清洗与转换

在获取到原始数据后,下一步是对其进行清洗与转换。这一步骤非常关键,因为它直接影响到后续的数据写入和业务逻辑处理。在轻易云平台上,可以利用自定义数据转换逻辑来适应特定业务需求。例如:

- 日期格式转换:将不同格式的日期统一为标准格式。

- 单位换算:如数量单位从“箱”转为“个”。

- 状态映射:将金蝶云星空中的状态码映射为本地系统可识别的状态码。

分页处理与限流机制

由于金蝶云星空API可能会返回大量数据,因此分页处理显得尤为重要。通过设置分页参数(如Limit和StartRow),可以有效控制每次请求的数据量,从而避免超时或内存溢出问题。同时,限流机制也需考虑,以防止过多请求导致API服务不可用。

{

"pagination": {

"pageSize": 500

}

}上述配置确保每次请求最多返回500条记录,并通过循环递增StartRow值来实现全量数据抓取。

异常处理与重试机制

在实际操作中,网络波动或服务器故障可能导致API调用失败。因此,必须设计可靠的异常处理与重试机制。例如,当检测到请求失败时,可以自动重试三次,并记录错误日志以便后续分析和排查。

{

// 错误重试配置示例

}实时监控与日志记录

为了确保整个数据集成过程透明可控,实时监控和日志记录必不可少。轻易云平台提供了集中监控和告警系统,可以实时跟踪每个任务的状态和性能。一旦发现异常情况,系统会立即发出告警通知,从而快速响应并解决问题。

综上所述,通过合理配置金蝶云星空接口调用参数、实施有效的数据清洗与转换策略,以及完善的分页处理、异常处理和实时监控机制,可以高效完成其他入库单到销售退货单(虚拟客户1元)的集成任务。这不仅提升了业务流程的自动化程度,也极大提高了数据处理效率和准确性。

集成方案:其他入库单--销售退货单(虚拟客户1元)-箱包TW

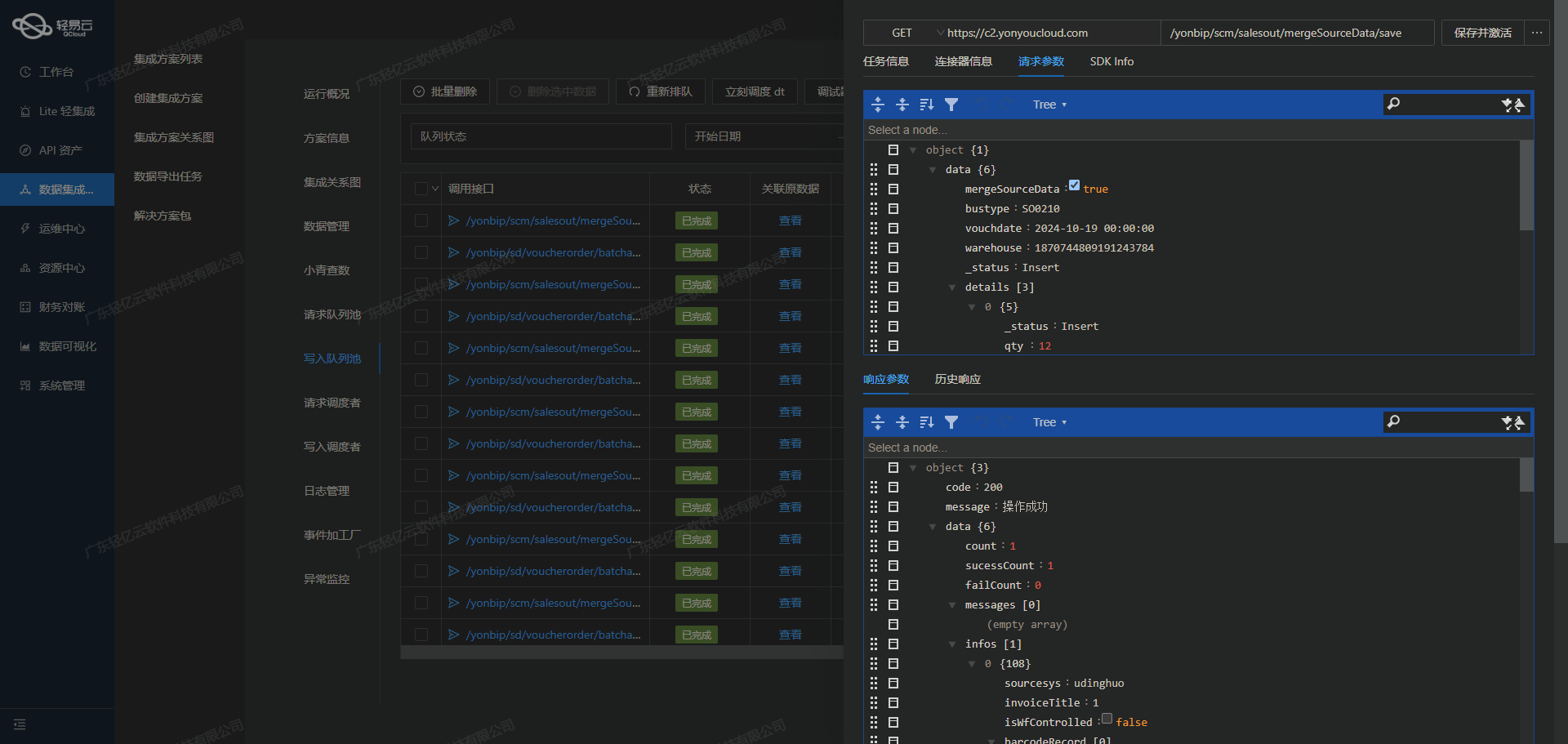

在数据集成的生命周期中,ETL(Extract, Transform, Load)过程至关重要。本文将探讨如何利用轻易云数据集成平台,将源平台的数据进行转换,并通过金蝶云星空API接口写入目标平台。

数据转换与写入

在ETL流程中,转换(Transform)和加载(Load)是核心步骤。我们需要将源平台的数据转换为目标平台金蝶云星空API能够接收的格式,并最终写入目标系统。以下是详细的步骤和技术细节。

配置API请求

首先,我们需要配置API请求。根据提供的元数据配置,我们使用batchSave API,通过POST方法将数据发送到金蝶云星空。

{

"api": "batchSave",

"method": "POST",

"idCheck": true,

...

}数据映射与转换

为了确保数据能够被正确解析和处理,我们需要对字段进行映射和转换。以下是关键字段及其配置:

-

单据类型 (FBillTypeID):

{ "field": "FBillTypeID", "label": "单据类型", "type": "string", "parser": { "name": "ConvertObjectParser", "params": "FNumber" }, "value": "XSTHD01_SYS" }单据类型字段通过

ConvertObjectParser解析,将其转换为金蝶云星空可识别的格式。 -

单据编号 (FBillNo):

{ "field": "FBillNo", "label": "单据编号", "type": "string", "value": "{FBillNo}" }单据编号直接从源数据中提取,无需额外转换。

-

日期 (FDate):

{ "field": "FDate", "label": "日期", "type": "string", "value": "{FDate}" }日期字段同样直接映射,无需复杂处理。

-

明细信息 (FEntity): 明细信息包含多个子字段,需要逐一配置。例如:

-

物料编码 (FMaterialId):

{ "field": "FMaterialId", "label": "物料编码", ... "value":"{{details.FMATERIALID_FNumber}}" } -

实退数量 (FRealQty):

{ ... "value":"{{details.FQty}}" }

-

这些字段通过模板语言进行动态替换,确保每个明细项的数据都能正确映射到目标平台。

批量处理与高吞吐量支持

轻易云数据集成平台支持高吞吐量的数据写入能力,使得大量数据能够快速被集成到金蝶云星空系统中。这一特性在批量处理销售退货单时尤为重要。通过批量请求,我们可以一次性将多个退货单的数据发送到目标系统,极大提升了处理效率。

实时监控与异常处理

为了确保数据集成的可靠性,实时监控与异常处理机制必不可少。轻易云提供了集中的监控和告警系统,可以实时跟踪数据集成任务的状态和性能。一旦发现异常,例如网络故障或数据格式错误,系统会自动触发告警,并尝试重试操作,确保数据不漏单、不重复。

调用金蝶云星空接口executeBillQuery

在某些情况下,我们需要调用金蝶云星空的executeBillQuery接口来验证数据是否成功写入。这一步通常在数据加载完成后进行,用于二次确认。例如:

{

...

// 调用executeBillQuery接口获取已保存的单据信息

}通过这种方式,我们可以确保每一笔交易都被准确记录,并及时发现并处理潜在问题。

分页与限流处理

对于大规模的数据集成任务,分页与限流是必须考虑的问题。我们可以通过设置分页参数,分批次发送请求,避免一次性传输过多数据导致的性能问题。同时,通过限流机制控制请求频率,防止触发目标系统的安全策略或超负荷运行。

总结

通过上述步骤,我们可以高效地将源平台的数据转换并写入到金蝶云星空系统中。在这一过程中,合理配置API请求、精确进行字段映射、支持高吞吐量批量处理、实时监控与异常处理,以及分页与限流策略都是关键技术点。这些措施共同保障了整个ETL流程的顺利进行和数据的一致性、完整性。