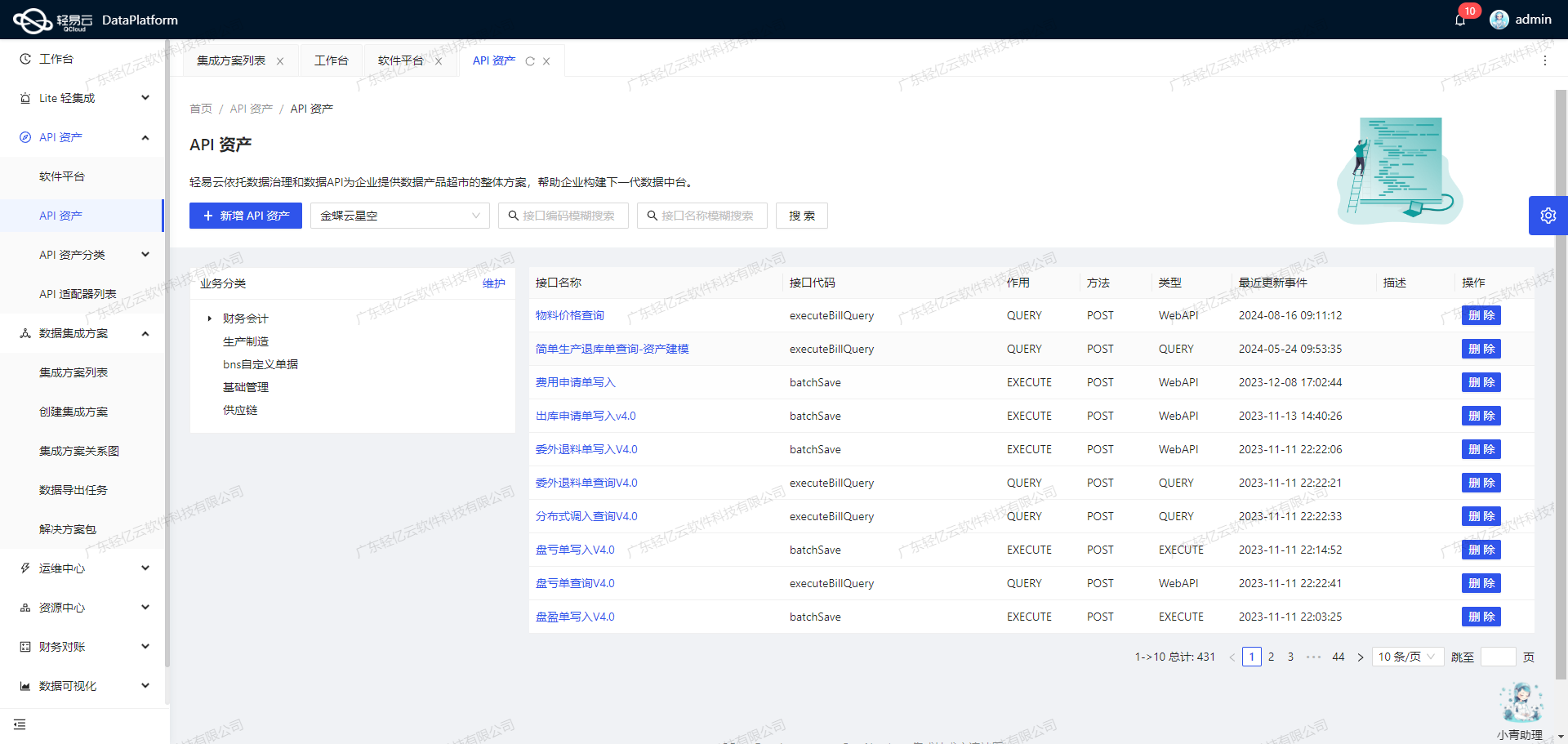

聚水潭数据集成到MySQL的技术案例分享

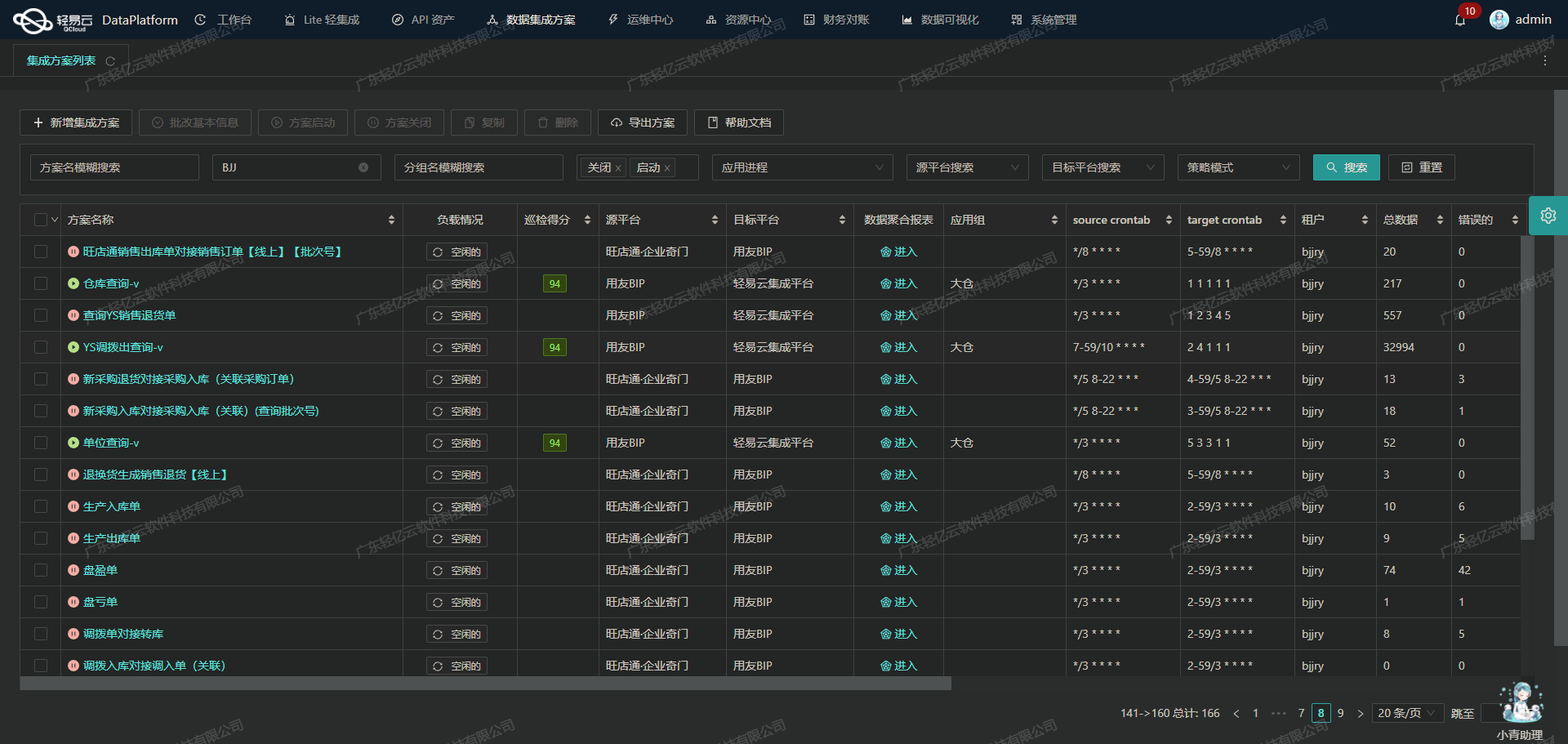

在本次技术案例中,我们将探讨如何通过轻易云数据集成平台,将聚水潭的仓库查询单数据高效地集成到MySQL数据库中的BI花花尚仓库表。这个过程不仅需要处理大量的数据,还要确保数据的完整性和实时性。

首先,聚水潭提供了一个强大的API接口/open/wms/partner/query,用于获取仓库查询单的数据。为了实现高效的数据传输,我们利用了轻易云平台的高吞吐量数据写入能力,使得大量数据能够快速被集成到目标系统中。这极大提升了数据处理的时效性。

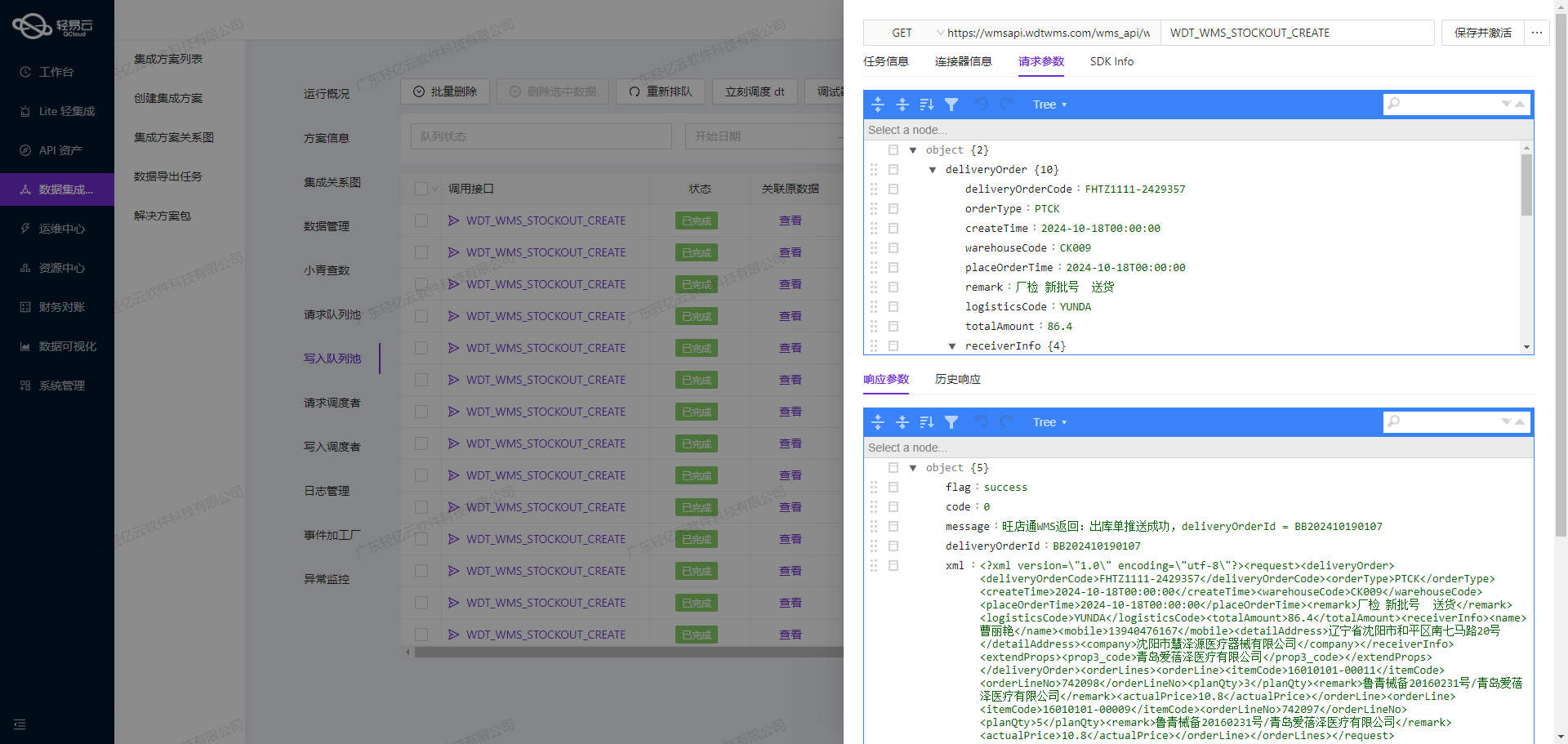

在整个集成过程中,实时监控和告警系统发挥了重要作用。通过集中监控,我们可以实时跟踪每个数据集成任务的状态和性能,及时发现并解决潜在问题。此外,为了确保每一条记录都能准确无误地传输,我们还采用了异常检测和错误重试机制。这些措施有效地避免了漏单现象,提高了整体数据质量。

另一个关键点是处理聚水潭接口的分页和限流问题。由于API调用次数有限制,我们设计了一套可靠的抓取策略,通过定时任务分批次获取数据,并将其批量写入到MySQL数据库中。这不仅保证了系统稳定运行,还优化了资源利用率。

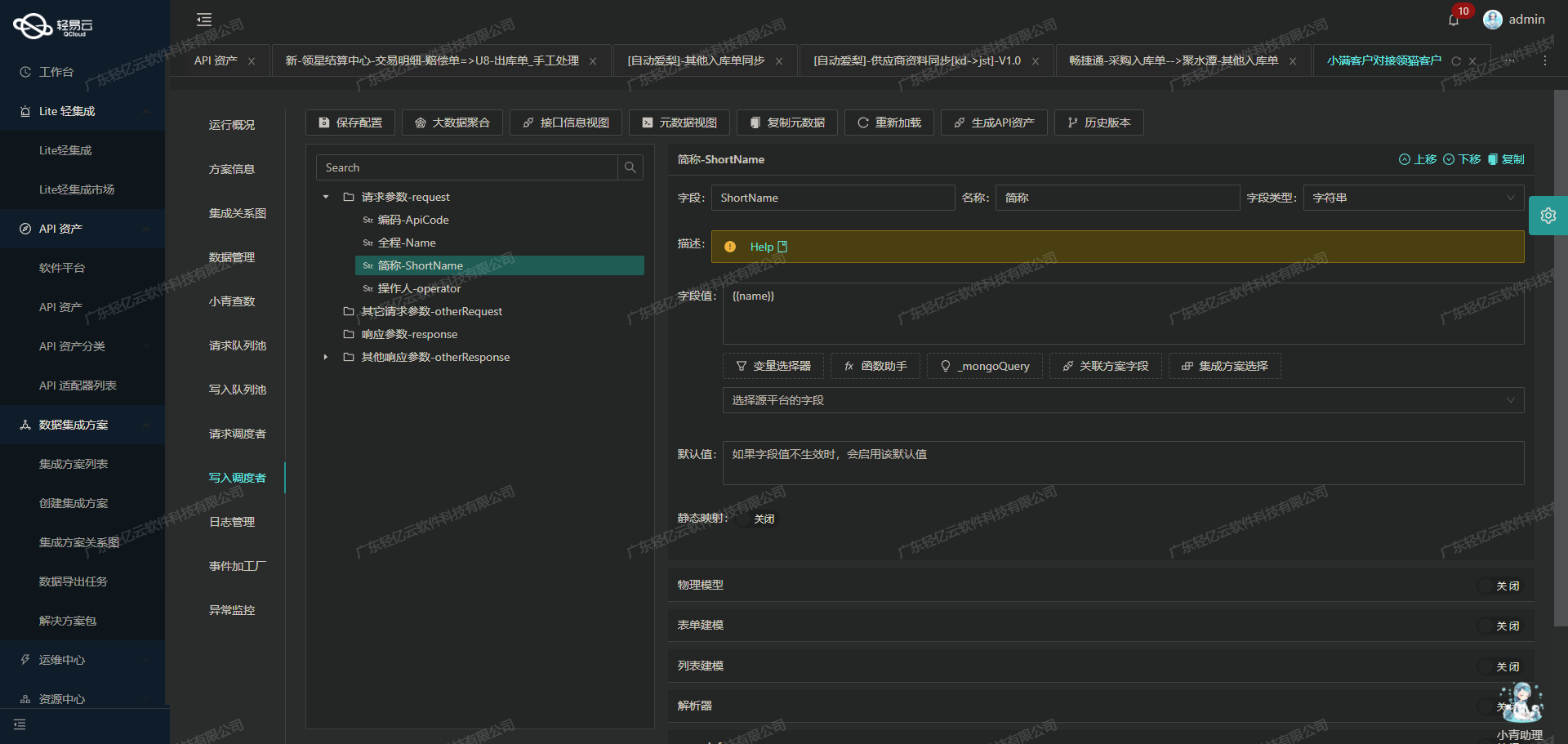

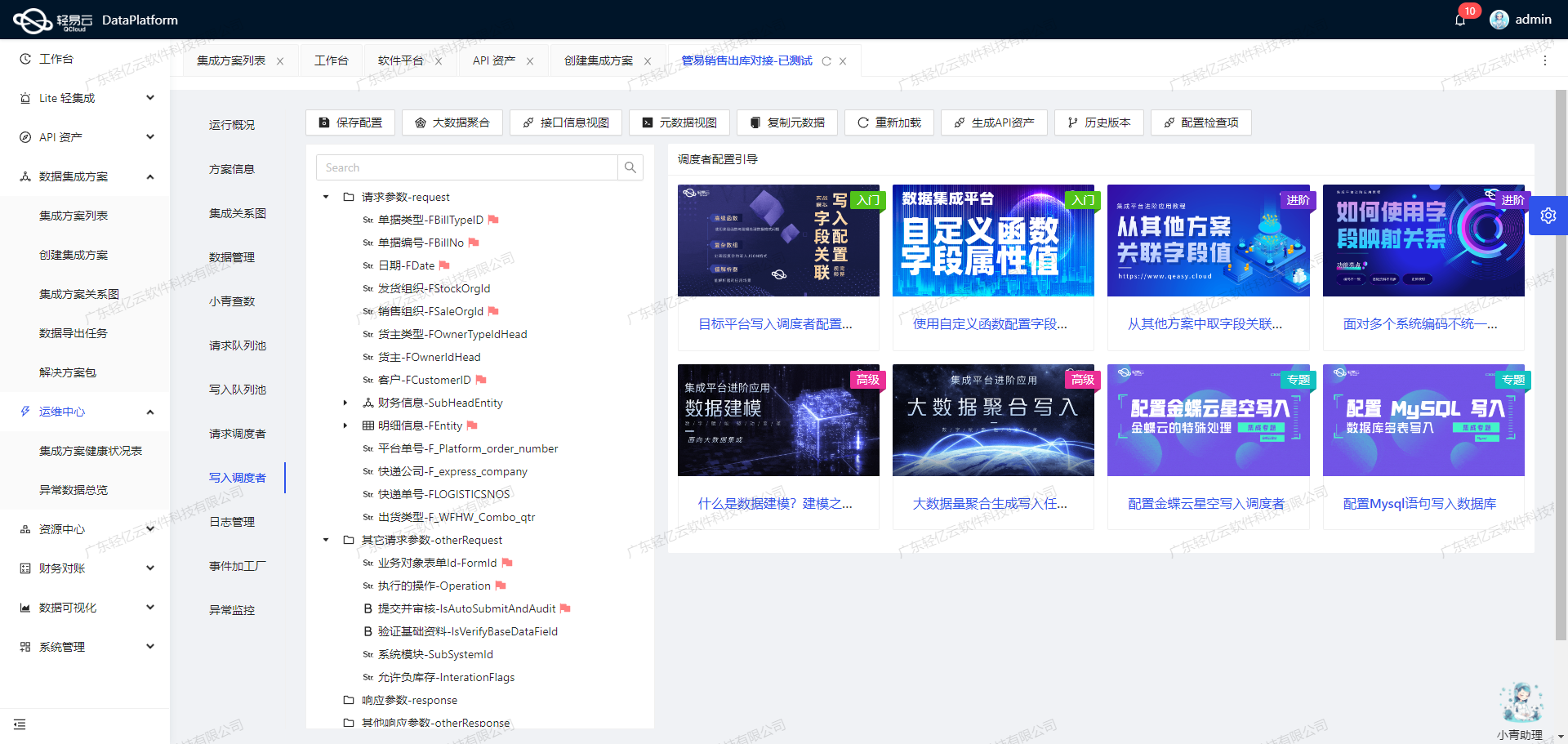

最后,为了解决聚水潭与MySQL之间的数据格式差异,我们使用自定义的数据转换逻辑,对获取的数据进行必要的转换和映射。在此过程中,可视化的数据流设计工具使得整个配置过程更加直观和易于管理。

通过以上技术手段,本方案成功实现了从聚水潭到MySQL的高效、可靠的数据集成,为企业提供了一套完善的数据管理解决方案。

调用聚水潭接口获取并加工数据的技术实现

在数据集成过程中,调用源系统接口获取原始数据是至关重要的一步。本文将详细探讨如何通过轻易云数据集成平台调用聚水潭接口/open/wms/partner/query,并对获取的数据进行初步加工处理。

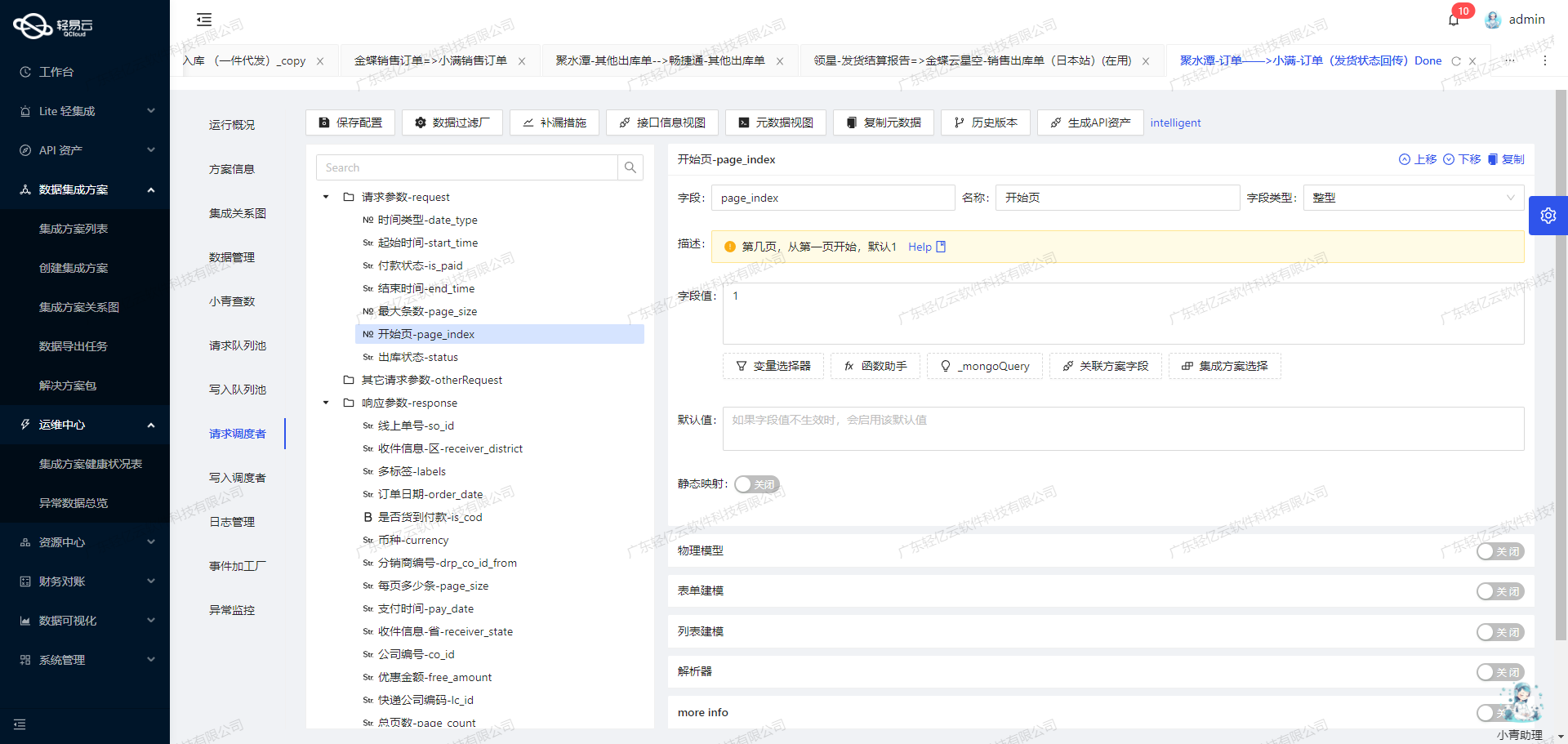

聚水潭接口调用配置

首先,我们需要配置元数据以便正确地调用聚水潭的API。根据提供的元数据配置,可以看到该接口使用POST方法,并且需要传递分页参数:

{

"api": "/open/wms/partner/query",

"effect": "QUERY",

"method": "POST",

"number": "name",

"id": "wms_co_id",

"name": "name",

"idCheck": true,

"request": [

{"field":"page_index","label":"第几页","type":"string","value":"1"},

{"field":"page_size","label":"每页多少条","type":"string","value":"30"}

],

"autoFillResponse": true

}数据请求与清洗

在实际操作中,我们需要确保分页参数的正确性,以避免漏单或重复抓取。以下是关键步骤:

- 设置分页参数:根据业务需求设定合理的分页大小(如每页30条)。

- 发送请求:通过轻易云平台发送POST请求到指定API。

- 接收响应:解析返回的数据,检查是否有下一页。

示例代码片段:

import requests

url = 'https://api.jushuitan.com/open/wms/partner/query'

payload = {

'page_index': '1',

'page_size': '30'

}

response = requests.post(url, json=payload)

data = response.json()数据转换与写入准备

在接收到原始数据后,需要对其进行初步清洗和转换,以便后续写入目标系统。在这个过程中,需要注意以下几点:

- 字段映射:将聚水潭返回的数据字段映射到目标系统所需的字段。例如,将

wms_co_id映射为目标系统中的仓库ID。 - 格式转换:处理日期、数值等不同格式的数据,使其符合目标系统要求。

- 异常处理:捕获并记录可能出现的异常情况,如网络错误、数据格式不匹配等。

示例代码片段:

def transform_data(raw_data):

transformed_data = []

for item in raw_data:

transformed_item = {

'warehouse_id': item['wms_co_id'],

'warehouse_name': item['name']

}

transformed_data.append(transformed_item)

return transformed_data

cleaned_data = transform_data(data['result'])实时监控与日志记录

为了确保整个过程的可靠性和可追溯性,轻易云平台提供了实时监控和日志记录功能。这些功能可以帮助我们及时发现并解决问题,提高整体效率。

- 监控任务状态:通过平台提供的集中监控工具,实时跟踪每个数据集成任务的执行状态。

- 日志记录:详细记录每次API调用及其结果,包括成功和失败的信息,以便后续分析和排查问题。

综上所述,通过合理配置元数据、精确设置分页参数、进行必要的数据清洗与转换,以及利用实时监控和日志记录功能,可以高效地完成从聚水潭接口获取并加工处理数据这一关键步骤,为后续的数据写入打下坚实基础。

将聚水谭仓库查询单数据ETL转换并写入MySQL

在数据集成的生命周期中,第二步是至关重要的一环,即将已经集成的源平台数据进行ETL转换,转为目标平台 MySQLAPI接口所能够接收的格式,并最终写入目标平台。本文将详细探讨如何通过轻易云数据集成平台实现这一过程。

数据请求与清洗

首先,从聚水谭接口获取仓库查询单数据。通过调用/open/wms/partner/query接口,可以获取到包含多个字段的仓库信息。这些字段包括分仓名称、主仓公司编号、分仓编号、是否为主仓、状态以及备注信息等。

数据转换与写入

在数据清洗完成后,需要将这些数据转换为MySQLAPI所能接收的格式。以下是元数据配置中的关键字段:

{

"api": "batchexecute",

"effect": "EXECUTE",

"method": "POST",

"idCheck": true,

"request": [

{"field": "name", "label": "分仓名称", "type": "string", "value": "{name}"},

{"field": "co_id", "label": "主仓公司编号", "type": "string", "value": "{co_id}"},

{"field": "wms_co_id", "label": "分仓编号", "type": "string", "value": "{wms_co_id}"},

{"field": "is_main", "label": "是否为主仓,true=主仓", "type": "string", "value": "{is_main}"},

{"field": "status", "label": "状态", "type": "string", "value": "{status}"},

{"field": "remark1", "label":