聚水潭数据集成到MySQL的技术案例分享

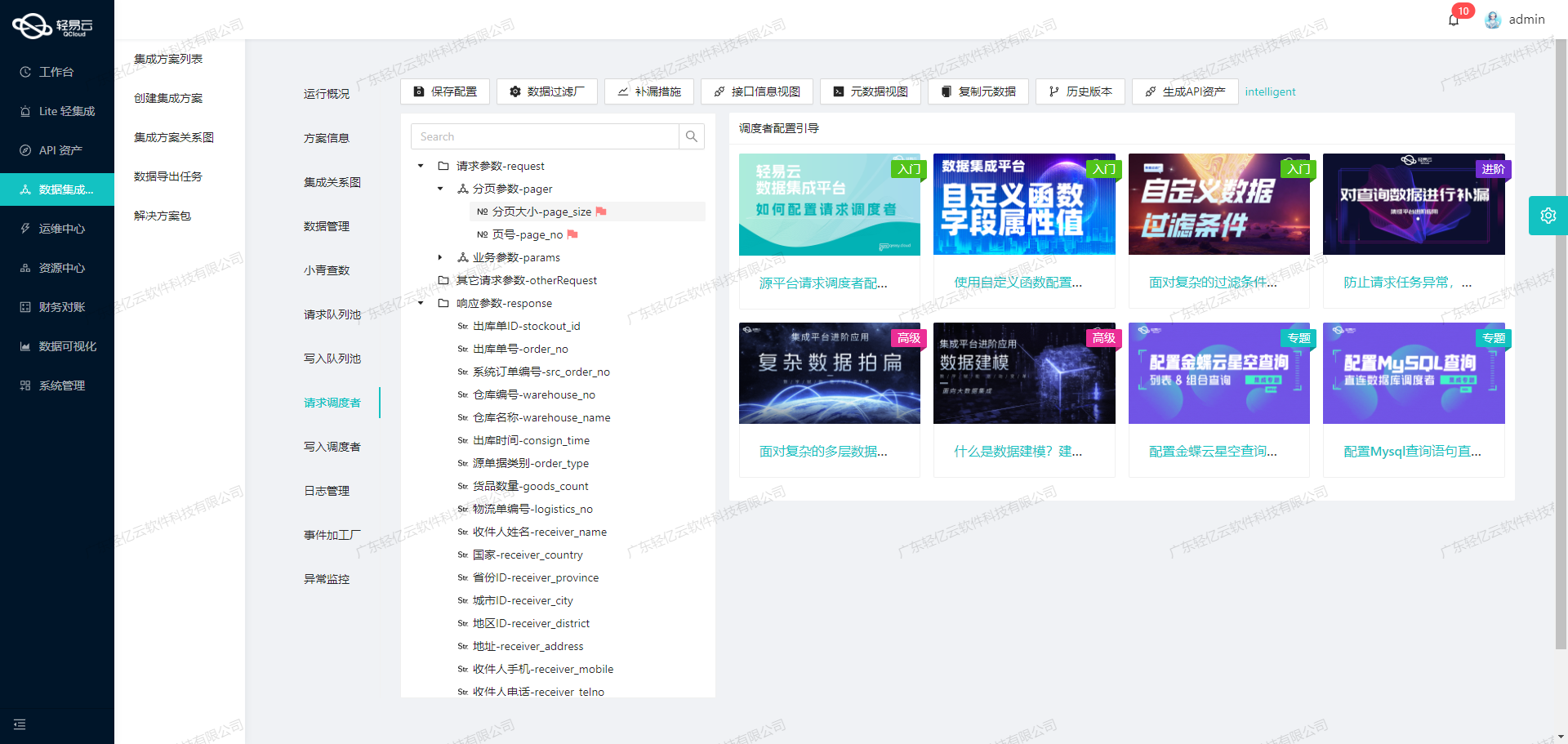

在本次技术案例中,我们将探讨如何通过轻易云数据集成平台,将聚水潭系统中的“其他出入库单”数据高效地集成到MySQL数据库中。具体的集成方案为:聚水潭-其他出入库单-->BI初本-其他出入库表_copy。

首先,聚水潭作为一个强大的电商ERP系统,其API接口提供了丰富的数据访问能力。在本案例中,我们主要使用的是聚水潭的/open/other/inout/query接口来获取“其他出入库单”数据。为了确保数据不漏单,我们设置了定时任务,可靠地抓取聚水潭接口的数据,并处理分页和限流问题,以保证数据的完整性和一致性。

在对接目标平台方面,MySQL数据库以其高吞吐量的数据写入能力,使得大量来自聚水潭的数据能够快速被写入。这不仅提升了数据处理的时效性,还确保了业务决策所需的数据能够及时更新。此外,通过MySQL提供的批量执行API batchexecute,我们可以实现大规模数据的快速导入,从而进一步优化性能。

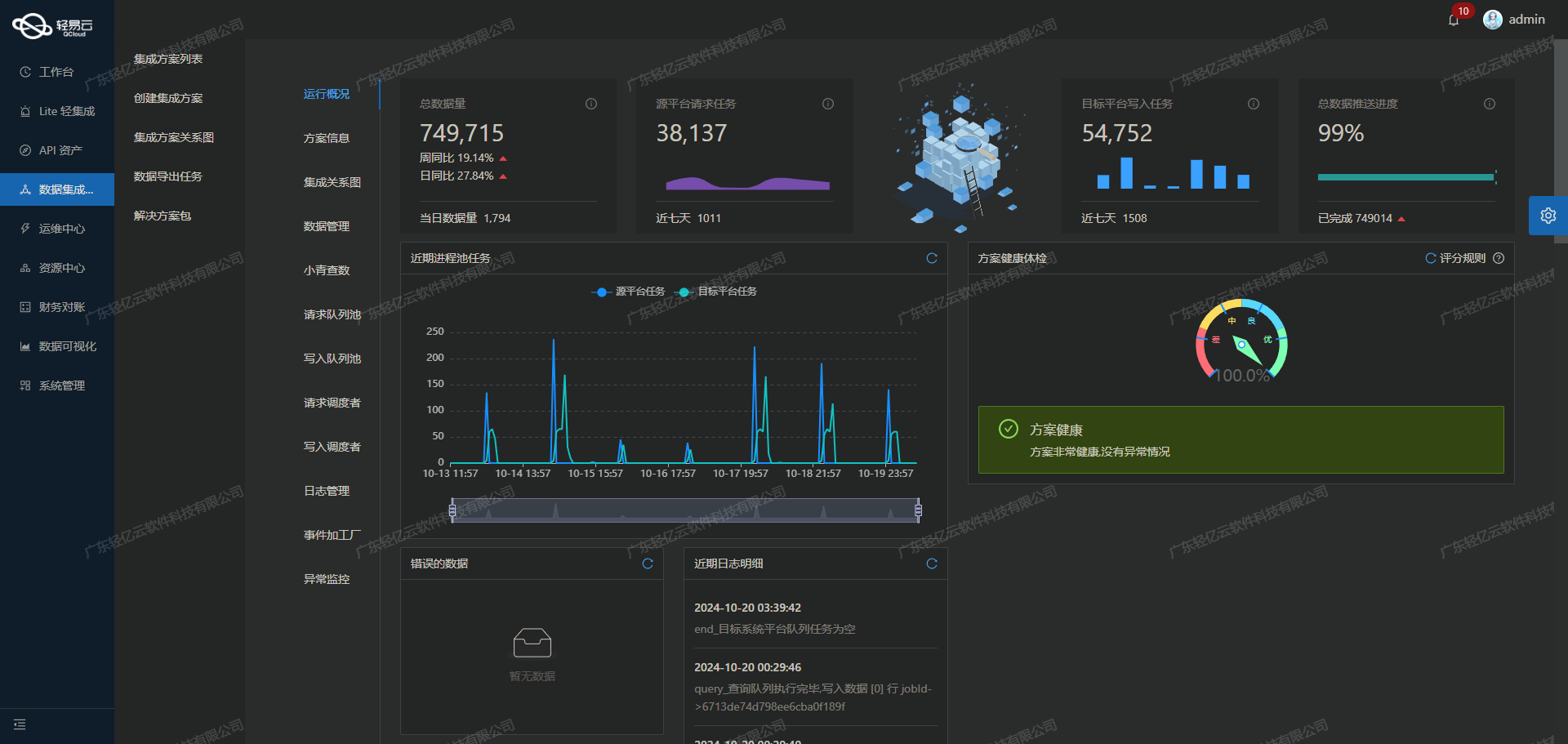

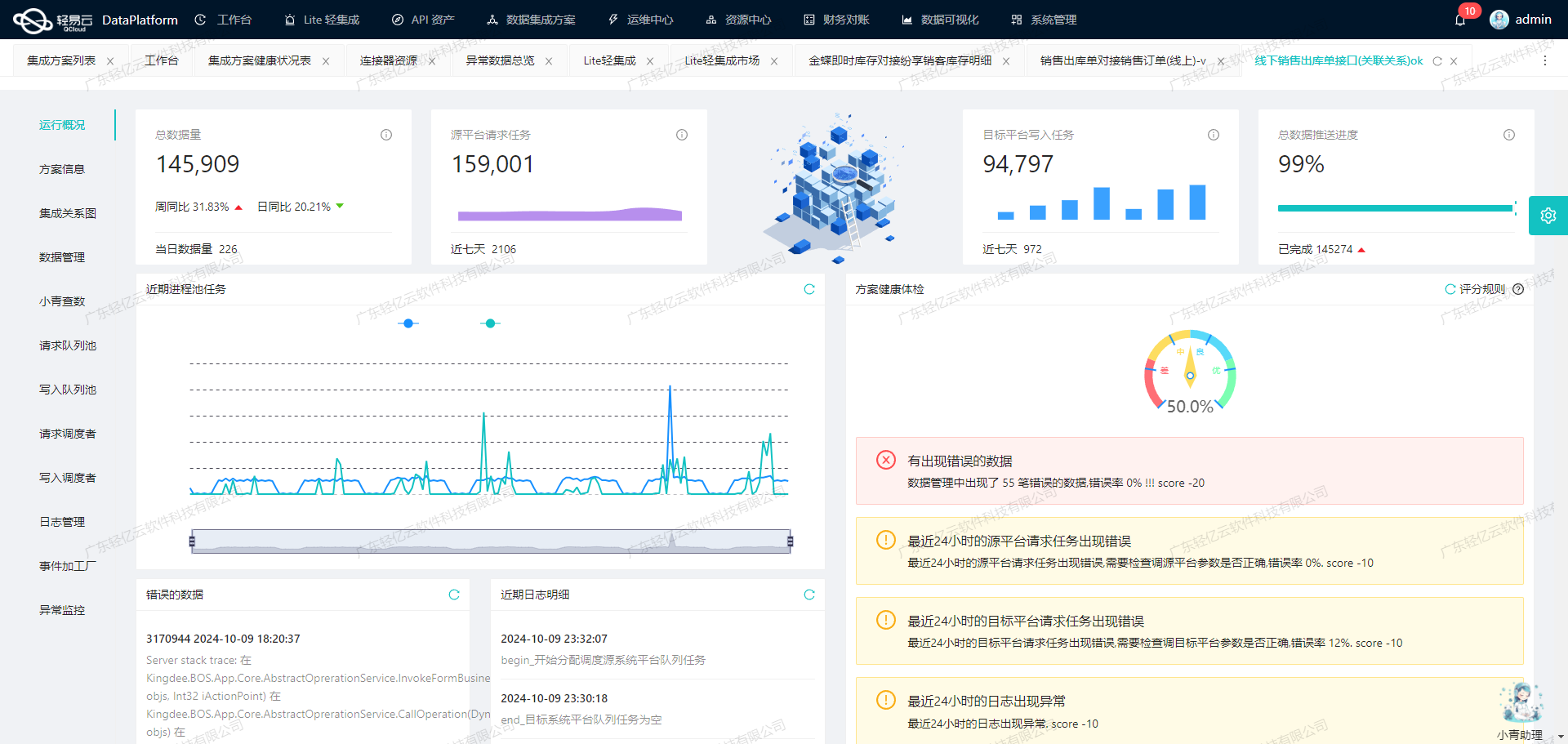

为了适应特定业务需求和数据结构,我们利用轻易云平台提供的自定义数据转换逻辑,对从聚水潭获取的数据进行必要的格式转换和映射。这一步骤至关重要,因为它确保了源系统与目标系统之间的数据兼容性。同时,为了实时监控整个数据处理过程,我们启用了集中监控和告警系统,实时跟踪每个集成任务的状态和性能,一旦发现异常情况,可以立即采取措施进行处理。

在实际操作过程中,还需要特别注意MySQL对接时可能遇到的问题,例如异常处理与错误重试机制。通过设计合理的错误重试策略,可以有效减少因网络波动或临时故障导致的数据丢失风险。此外,为了全面掌握API资产的使用情况,实现资源高效利用和优化配置,我们还借助轻易云平台提供的统一视图和控制台功能,对整个API调用过程进行了详细记录和分析。

综上所述,本次技术案例展示了如何通过轻易云数据集成平台,将聚水潭中的“其他出入库单”高效、可靠地集成到MySQL数据库中。接下来,我们将详细介绍具体实施步骤及相关技术细节。

调用聚水潭接口获取并加工数据的技术方案

在轻易云数据集成平台中,调用聚水潭接口/open/other/inout/query是实现数据集成生命周期的第一步。该步骤至关重要,因为它确保了从源系统获取的数据准确无误,并为后续的数据处理和写入奠定了基础。

聚水潭接口配置与调用

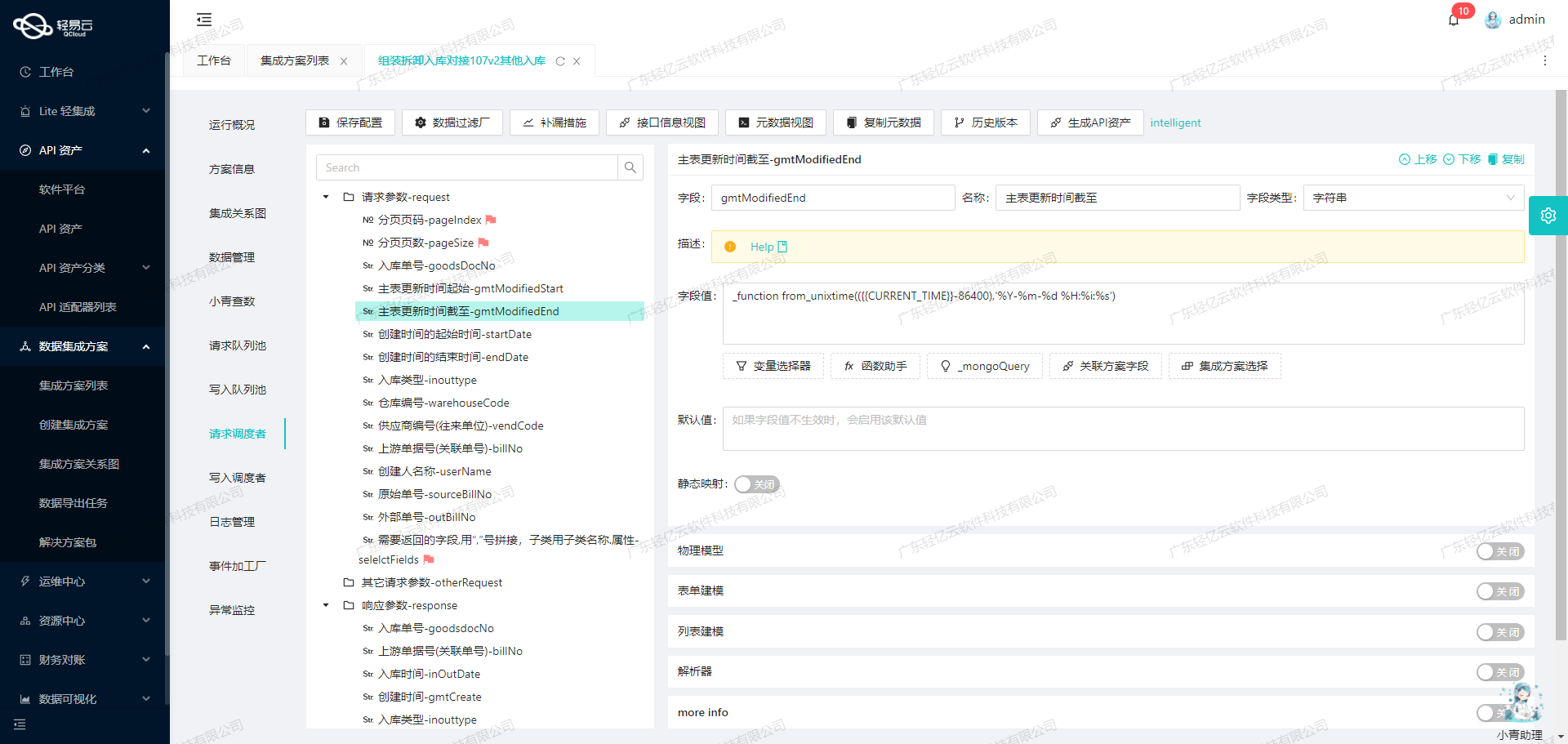

首先,我们需要了解如何配置和调用聚水潭的API接口。根据提供的元数据配置,以下是关键参数及其作用:

- api:

/open/other/inout/query - method:

POST - number 和 id:

io_id,用于唯一标识每条记录。 - request: 包含多个字段,用于定义请求参数,如修改起始时间、结束时间、单据状态等。

具体请求参数如下:

[

{"field":"modified_begin","label":"修改起始时间","type":"datetime","value":"{{LAST_SYNC_TIME|datetime}}"},

{"field":"modified_end","label":"修改结束时间","type":"datetime","value":"{{CURRENT_TIME|datetime}}"},

{"field":"status","label":"单据状态","type":"string","value":"Confirmed"},

{"field":"date_type","label":"时间类型","type":"string","value":"2"},

{"field":"page_index","label":"第几页","type":"string","value":"1"},

{"field":"page_size","label":"每页多少条","type":"string","value":"30"}

]这些参数确保我们能够精确地控制数据抓取的范围和粒度。例如,通过设置modified_begin和modified_end,可以限定只抓取特定时间段内的数据;通过分页参数(如page_index和page_size),可以有效处理大批量数据。

数据清洗与转换

在成功调用API并获取到原始数据后,需要进行必要的数据清洗与转换,以适应目标系统(如BI初本)的需求。这一步骤通常包括以下几个方面:

- 字段映射与重命名:将源系统中的字段名称映射到目标系统中的对应字段。例如,将聚水潭中的

io_id映射为BI初本中的相应字段。 - 数据格式转换:根据业务需求,对日期、数值等字段进行格式转换。例如,将日期格式从YYYY-MM-DD HH:mm:ss转换为目标系统所需的格式。

- 过滤无效或冗余数据:根据业务逻辑,过滤掉不符合条件的数据,例如未确认的单据或重复记录。

分页与限流处理

由于聚水潭接口可能返回大量数据,为避免超时或性能问题,需要对分页和限流进行处理。通过设置合理的分页大小(如每页30条),并在每次请求后更新分页索引,可以逐步获取所有需要的数据。此外,还需考虑API限流策略,在达到请求限制时进行适当的等待或重试。

异常处理与错误重试机制

在实际操作中,不可避免会遇到各种异常情况,如网络故障、API响应超时等。为了保证数据集成过程的稳定性,需要设计健全的异常处理机制,包括但不限于:

- 捕获并记录所有异常信息,以便后续分析和排查。

- 针对特定错误(如网络超时)实施自动重试策略,并设置最大重试次数以防止无限循环。

- 在严重错误发生时,及时告警通知相关人员进行人工干预。

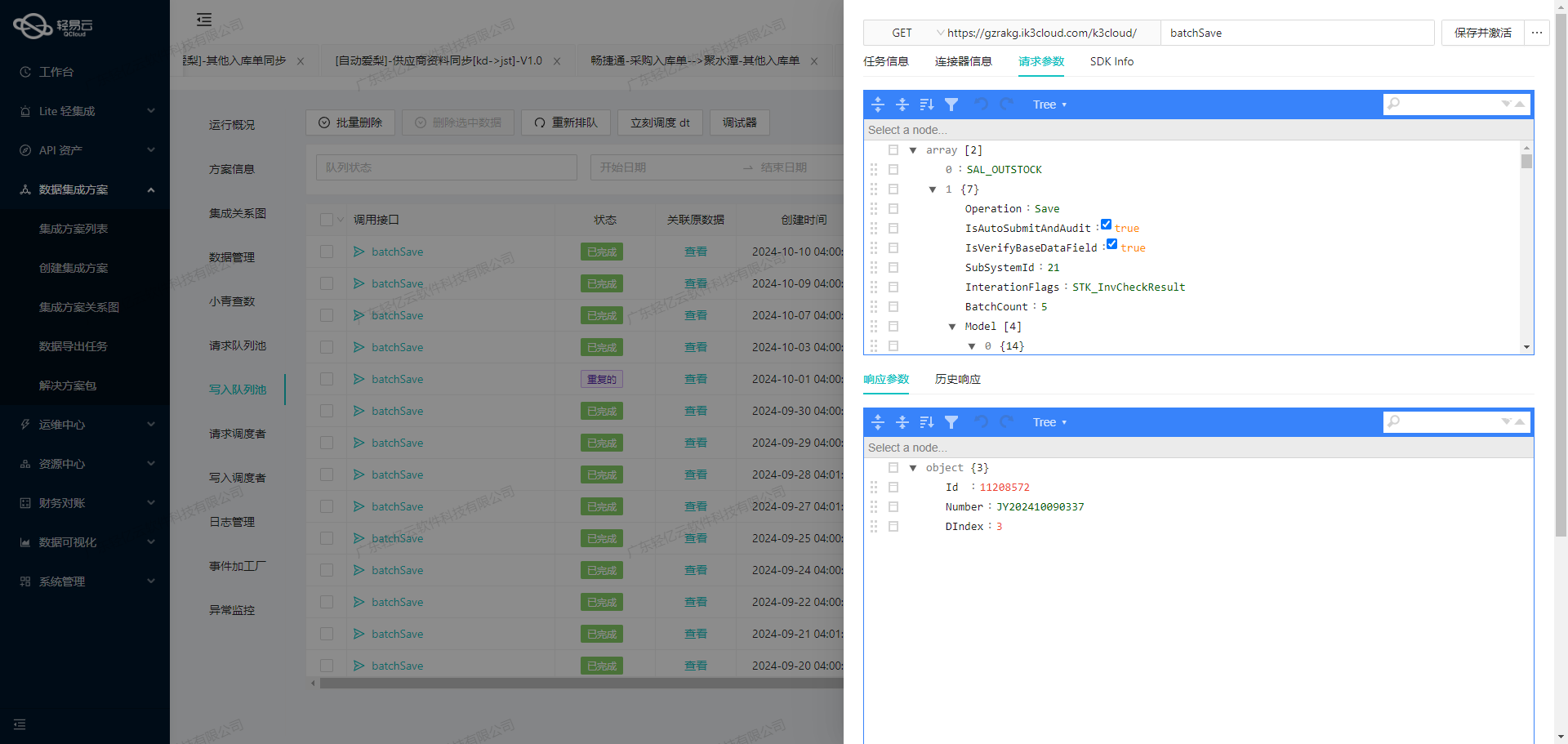

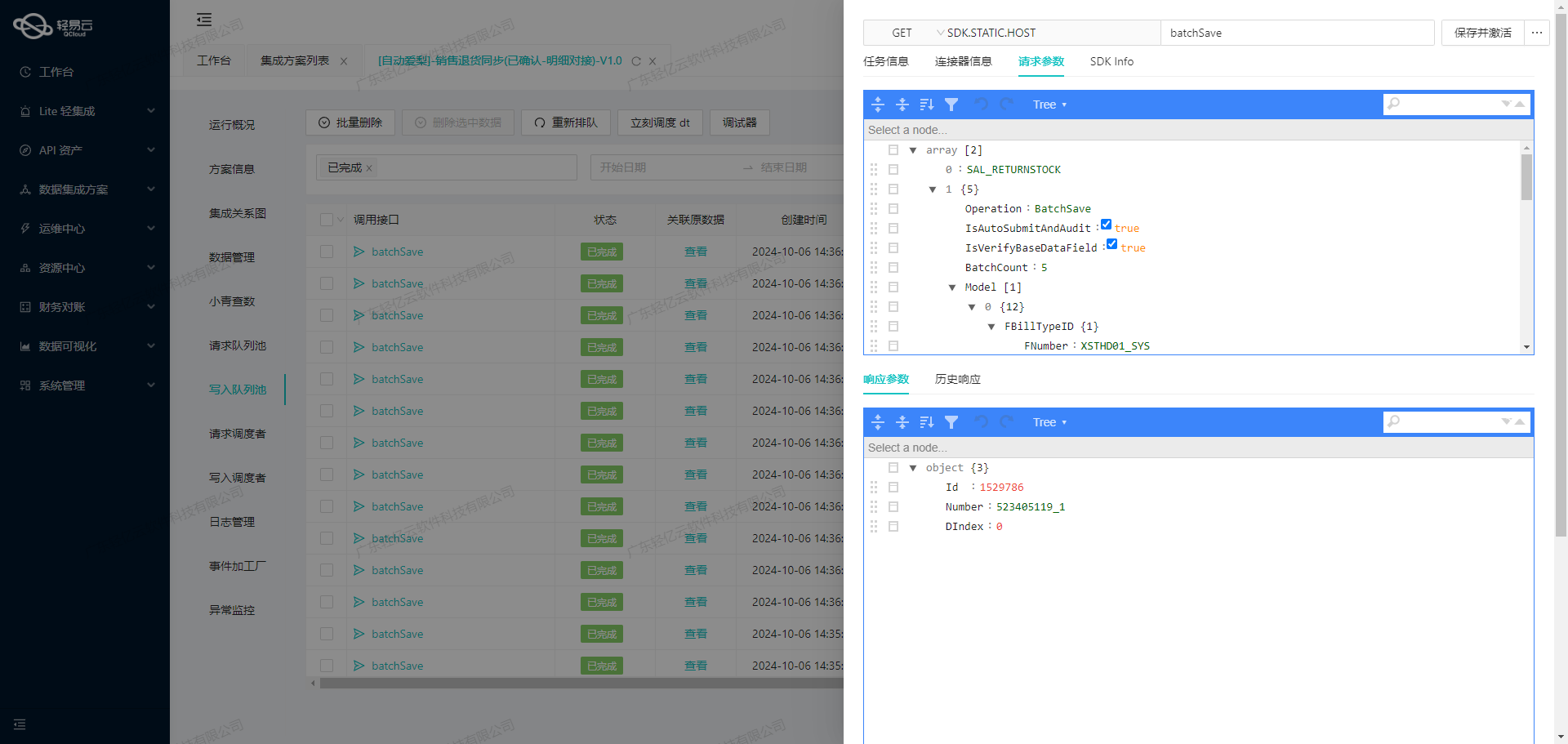

实时监控与日志记录

为了确保整个数据集成过程透明可控,需要实现实时监控与日志记录功能。通过轻易云平台提供的集中监控和告警系统,可以实时跟踪每个任务的执行状态,并在出现异常情况时及时发出告警。同时,通过详细日志记录,每个步骤都能被追溯,从而方便问题定位和解决。

综上所述,通过合理配置聚水潭接口、精细化的数据清洗与转换、有效的分页限流策略,以及健全的异常处理机制,我们能够高效且可靠地完成从聚水潭到BI初本的数据集成任务。这不仅提升了业务透明度,也为后续的数据分析和决策提供了坚实基础。

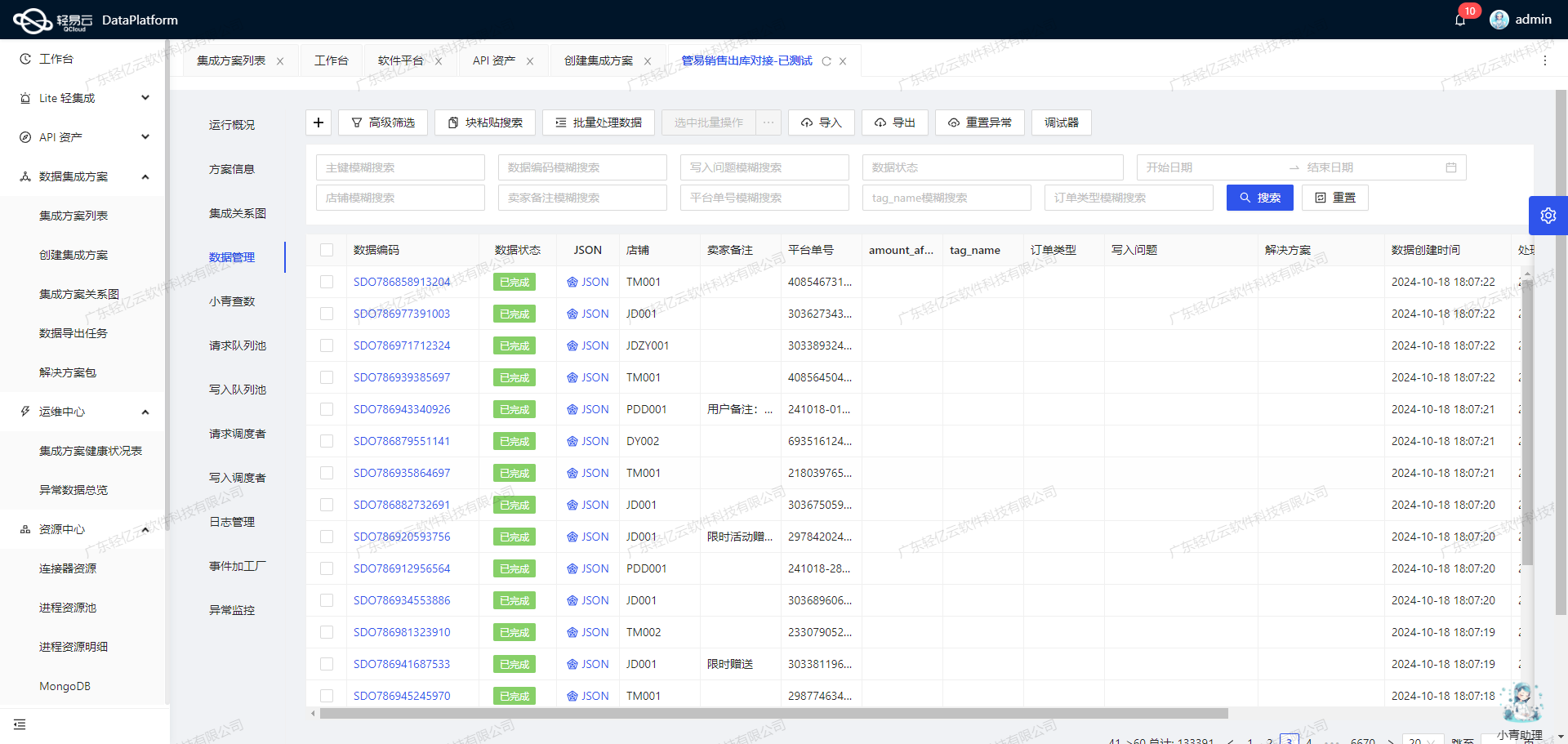

数据转换与写入:将聚水潭数据集成到MySQL

在轻易云数据集成平台的生命周期中,第二步是将已经集成的源平台数据进行ETL转换,并转为目标平台 MySQL API接口所能够接收的格式,最终写入目标平台。这个过程涉及多个技术环节,需要特别注意数据格式转换、批量处理、分页处理以及异常处理等问题。

数据格式转换

在进行数据写入之前,我们首先需要对从聚水潭系统获取的数据进行格式转换,使其符合MySQL API接口的要求。元数据配置提供了一个详细的字段映射表,通过这些字段映射,可以确保每个字段都能正确地从源数据中提取并转换为目标格式。例如:

{"field":"id","label":"主键","type":"string","value":"{io_id}-{items_ioi_id}"}这里的id字段是通过拼接io_id和items_ioi_id生成的,这种自定义的数据转换逻辑能够灵活应对复杂的业务需求。

批量处理与高吞吐量写入

为了提升数据处理效率,轻易云平台支持高吞吐量的数据写入能力。通过批量处理可以显著减少API调用次数,从而提高系统性能。在元数据配置中,limit字段定义了每次批量处理的数据条数:

{"field":"limit","label":"limit","type":"string","value":"1000"}这意味着每次批量操作最多处理1000条记录,保证了高效的数据传输和写入。

分页处理与限流机制

聚水潭接口通常会返回大量数据,因此需要分页处理来逐步获取完整的数据集。同时,为了避免API调用过于频繁导致限流问题,可以设置适当的延时策略。在实际操作中,需要根据API文档及实际情况调整分页参数和限流策略,以确保稳定性和可靠性。

异常处理与错误重试机制

在数据集成过程中,可能会遇到各种异常情况,如网络故障、API调用失败等。为了保证数据完整性和一致性,需要实现异常处理与错误重试机制。当某次操作失败时,可以记录错误信息并进行重试:

{"effect":"EXECUTE","method":"SQL","number":"id","idCheck":true}上述配置确保在执行SQL语句时,如果主键冲突或其他错误发生,将会触发相应的错误处理逻辑。

实时监控与日志记录

轻易云平台提供了实时监控和日志记录功能,可以帮助我们随时跟踪数据集成任务的状态和性能。一旦发现异常情况,可以及时采取措施进行修复。这对于保证系统稳定运行至关重要。

MySQL定制化数据映射对接

为了适应特定业务需求,可以对MySQL数据库进行定制化的数据映射。例如,在插入数据时,可以使用REPLACE INTO语句来避免重复插入:

{"field":"main_sql","label":"主语句","type":"string","describe":"SQL首次执行的语句,将会返回:lastInsertId","value":"REPLACE INTO other_inout_query(id,io_id,io_date,status,so_id,type,f_status,warehouse,receiver_name,receiver_mobile,receiver_state,receiver_city,receiver_district,receiver_address,wh_id,remark,modified,created,labels,wms_co_id,creator_name,wave_id,drop_co_name,inout_user,l_id,lc_id,logistics_company,lock_wh_id,lock_wh_name,items_ioi_id,items_sku_id,items_name,items_unit,items_properties_value,items_qty,items_cost_price,items_cost_amount,items_i_id,items_remark,items_io_id...这种方式不仅能够防止重复记录,还能保持数据库的一致性。

通过以上几个方面的技术实现,我们能够高效地将聚水潭系统中的数据转换并写入到MySQL数据库中,实现不同系统间的数据无缝对接。