Done-金蝶-部门查询——>空操作:实现高效数据集成

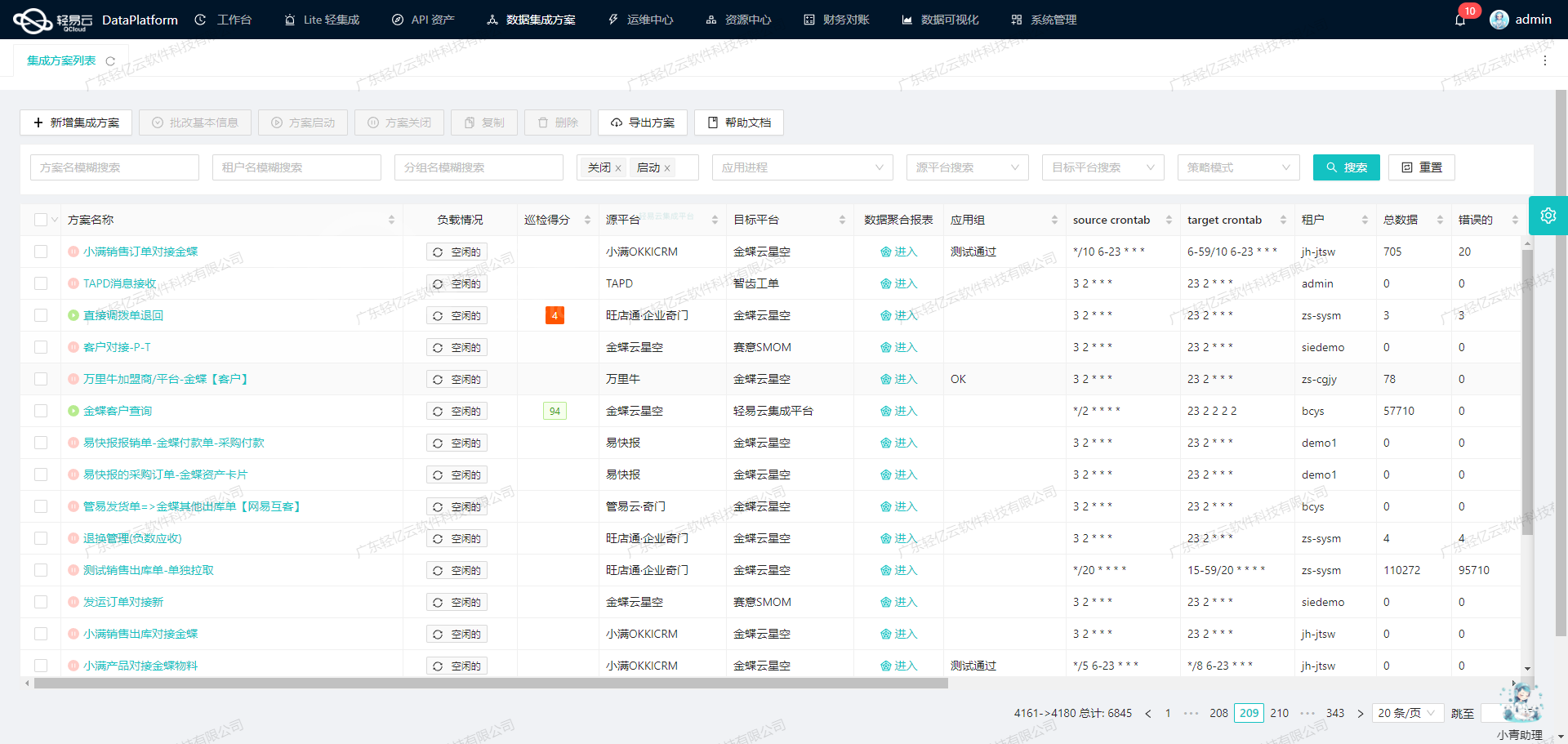

本案例将详细介绍如何通过轻易云数据集成平台,实现金蝶云星空的数据无缝对接,确保关键业务信息及时、准确地传输和处理。以实际运行的方案“Done-金蝶-部门查询——>空操作”为核心,我们探讨了在系统对接过程中所遇到的技术挑战及解决思路。

首先,为了保证从金蝶云星空获取的数据不遗漏,我们调用了其接口API executeBillQuery进行定时抓取。这个接口支持灵活配置条件,从而精准定位需要同步的数据。而为了应对大量数据的快速写入需求,轻易云提供了一套高效的批量处理机制,通过使用内部API 写入空操作,大幅提升了数据传输速率。

分页与限流是另外一个不可忽视的问题。在应对这些挑战时,需合理设计请求频率,并结合重试机制来保障数据读取过程中的稳定性。轻易云柔性的调度系统能够自动调整任务执行策略,以适应多变的网络环境,从而减少因网络波动引起的数据丢失和重复。

此外,在实施跨平台的数据整合中,两者之间可能存在格式差异。例如,日期时间格式、数值精度等方面的不一致,都需要通过定制化映射规则来进行转换。这些细节会直接影响到后续处理和分析工作的有效性,因此必须格外注意。在这方面,轻易云丰富的匹配规则库为我们提供了极大的便利,使得各种复杂转换都能简单而快捷地完成。

最后,为确保整个集成流程的透明度与可靠性,我们还启用了实时监控与日志记录功能。不论是成功还是失败,每一步操作都会被详细记录下来,这不仅便于诊断问题,也为未来优化提供宝贵依据。如果出现异常情况,如超时或连接失败,可以自动触发错误重试机制,将潜在风险降至最低。

以上内容仅涵盖了整个项目的一部分核心技术要点。在随后的章节中,我们将进一步详述具体实施步骤及更多技术细节。

调用金蝶云星空接口executeBillQuery获取并加工数据

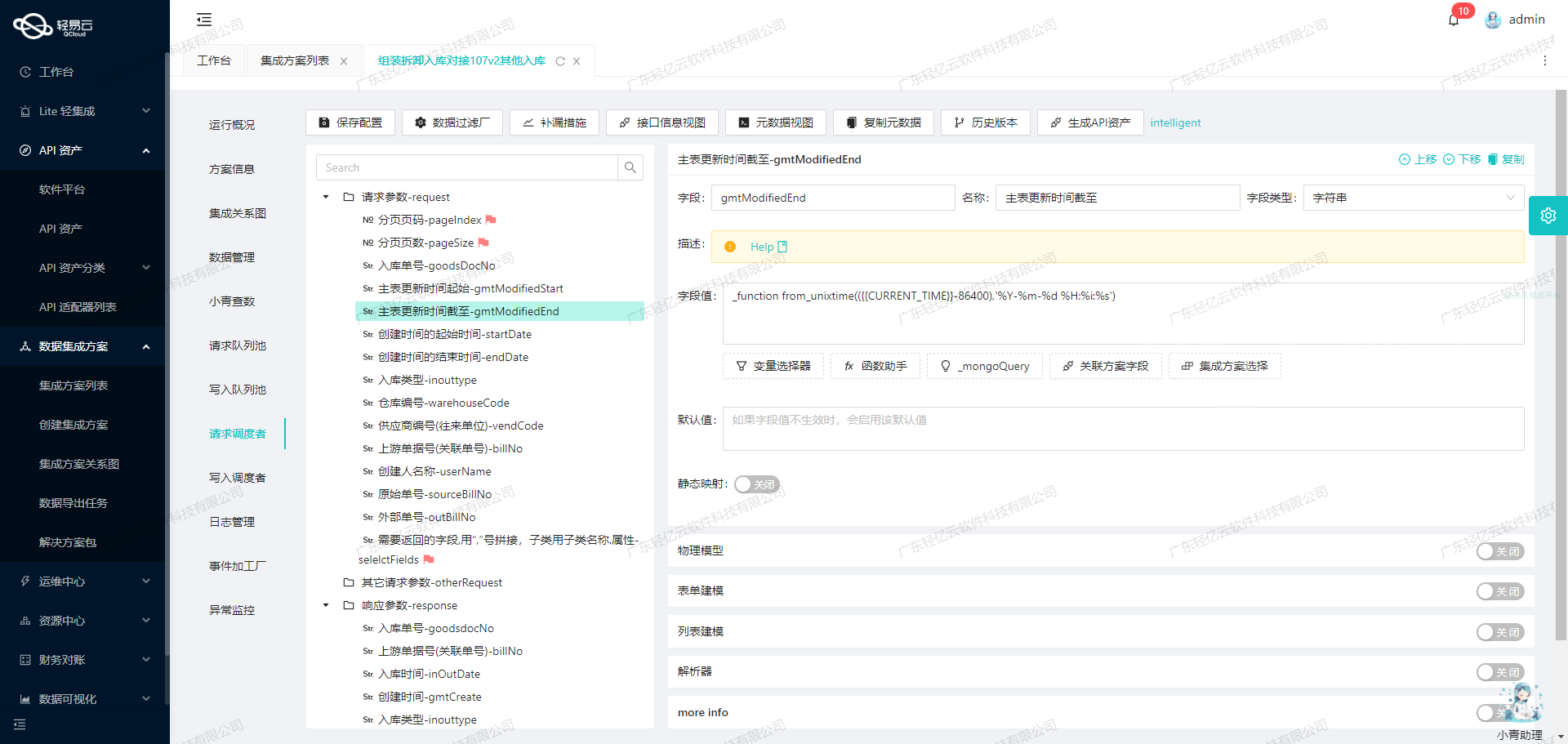

在数据集成过程中,调用源系统接口是关键的一步。本文将深入探讨如何通过轻易云数据集成平台调用金蝶云星空的executeBillQuery接口来获取并加工数据。

接口配置与调用

首先,我们需要了解executeBillQuery接口的基本配置。根据提供的元数据配置,以下是该接口的主要参数:

- API:

executeBillQuery - Method:

POST - Effect:

QUERY - FormId:

BD_Department

请求参数包括:

- FDEPTID(部门ID)

- FNumber(编码)

- FName(名称)

- FUseOrgId.FNumber(使用组织)

- FCreateOrgId(创建组织)

- FCreatorId(创建人)

- FCreateDate(创建日期)

- FGroup(部门分组)

- FFullName(部门全称)

分页参数包括:

- Limit(最大行数)

- StartRow(开始行索引)

- TopRowCount(返回总行数)

过滤条件和字段集合:

- FilterString

- FieldKeys

请求示例

为了更好地理解如何调用该接口,以下是一个具体的请求示例:

{

"FormId": "BD_Department",

"FieldKeys": "FDEPTID,FNumber,FName,FUseOrgId.FNumber,FCreateOrgId,FCreatorId,FCreateDate,FGroup,FFullName",

"FilterString": "FAuditDate>='2023-01-01'",

"Limit": 100,

"StartRow": 0

}在这个请求中,我们指定了要查询的字段、过滤条件以及分页参数。

数据清洗与转换

获取到数据后,需要对其进行清洗和转换,以便后续处理。以下是一个简单的数据清洗和转换示例:

import pandas as pd

# 假设我们已经从接口获取到数据并存储在data变量中

data = [

{"FDEPTID": "1001", "FNumber": "D001", "FName": "财务部", "FUseOrgId.FNumber": "ORG001", ...},

{"FDEPTID": "1002", "FNumber": "D002", "FName": "人事部", "FUseOrgId.FNumber": "ORG002", ...},

# 更多数据...

]

# 将数据转换为DataFrame

df = pd.DataFrame(data)

# 清洗和转换操作,例如去除空值、格式化日期等

df.dropna(inplace=True)

df['FCreateDate'] = pd.to_datetime(df['FCreateDate'])

# 输出清洗后的数据

print(df)通过上述代码,我们可以将原始数据进行清洗和格式化,以便后续的数据处理步骤。

自动填充响应

在轻易云平台中,可以通过配置autoFillResponse来自动填充响应。这意味着我们不需要手动处理每个字段的映射,平台会根据元数据配置自动完成这一过程。

{

"autoFillResponse": true

}此配置极大地简化了开发工作,使得我们可以专注于业务逻辑而非繁琐的数据映射操作。

实时监控与调试

为了确保数据集成过程顺利进行,实时监控和调试是必不可少的。轻易云平台提供了全透明可视化的操作界面,可以实时监控数据流动和处理状态。

通过以上步骤,我们可以高效地调用金蝶云星空的executeBillQuery接口,获取并加工所需的数据,为后续的数据处理奠定坚实基础。

基于轻易云数据集成平台的ETL转换与写入技术案例

在数据集成的生命周期中,将源平台的数据进行ETL转换并写入目标平台是至关重要的一步。本文将详细探讨如何利用轻易云数据集成平台完成这一过程,重点关注API接口的配置和数据处理。

数据请求与清洗

在数据集成的第一阶段,我们已经从金蝶系统中成功获取了部门查询的数据。此时,数据经过初步清洗,确保其完整性和一致性。接下来,我们需要将这些数据进行转换,以符合目标平台轻易云集成平台API接口的要求。

数据转换

数据转换是ETL过程中的核心环节。我们需要根据目标平台的需求,对源数据进行格式化处理。这一过程中涉及到字段映射、数据类型转换以及必要的数据校验。

- 字段映射:将源平台的数据字段与目标平台的API字段进行对应。例如,金蝶系统中的部门名称字段可能需要映射为目标平台中的

departmentName字段。 - 数据类型转换:确保源数据类型与目标API接口所需的数据类型一致。例如,将字符串类型的日期格式化为标准的ISO 8601日期格式。

- 数据校验:对关键字段进行校验,确保其符合目标平台的业务规则。例如,检查部门ID是否为有效的UUID格式。

API接口配置

在完成数据转换后,我们需要将其通过API接口写入目标平台。以下是元数据配置示例:

{

"api": "写入空操作",

"effect": "EXECUTE",

"method": "POST",

"idCheck": true

}- API路径:

api字段指定了目标API接口的路径。在本例中为“写入空操作”。 - 执行效果:

effect字段表明该操作是一个执行操作(EXECUTE)。 - HTTP方法:

method字段指定了HTTP请求的方法,这里使用的是POST方法。 - ID校验:

idCheck字段设置为true,表示在写入之前需要对ID进行校验,以确保唯一性和有效性。

数据写入

通过配置好的API接口,我们可以将转换后的数据发送到目标平台。以下是一个简化的Python代码示例,用于展示如何通过HTTP POST请求将数据写入轻易云集成平台:

import requests

import json

# 配置API接口信息

api_url = "https://api.qingyiyun.com/write_empty_operation"

headers = {

'Content-Type': 'application/json'

}

# 准备要写入的数据

data = {

"departmentId": "123e4567-e89b-12d3-a456-426614174000",

"departmentName": "研发部"

}

# 发送POST请求

response = requests.post(api_url, headers=headers, data=json.dumps(data))

# 检查响应状态码

if response.status_code == 200:

print("Data written successfully")

else:

print(f"Failed to write data: {response.status_code}")在上述代码中,我们首先定义了API URL和请求头信息,然后准备好要写入的数据,并通过POST请求发送到目标平台。如果响应状态码为200,则表示数据成功写入。

实时监控与异常处理

为了确保整个ETL过程的顺利进行,实时监控和异常处理是必不可少的。在轻易云数据集成平台中,可以利用内置的监控工具实时跟踪每个环节的数据流动和处理状态。一旦发现异常,例如网络超时或数据格式错误,应及时记录日志并发出警报,以便迅速采取纠正措施。

通过上述步骤,我们实现了从源平台到目标平台的数据无缝对接,并保证了整个过程的高效性和可靠性。这不仅提升了业务透明度,也极大地提高了工作效率。