聚水潭数据集成到MySQL的技术案例分享

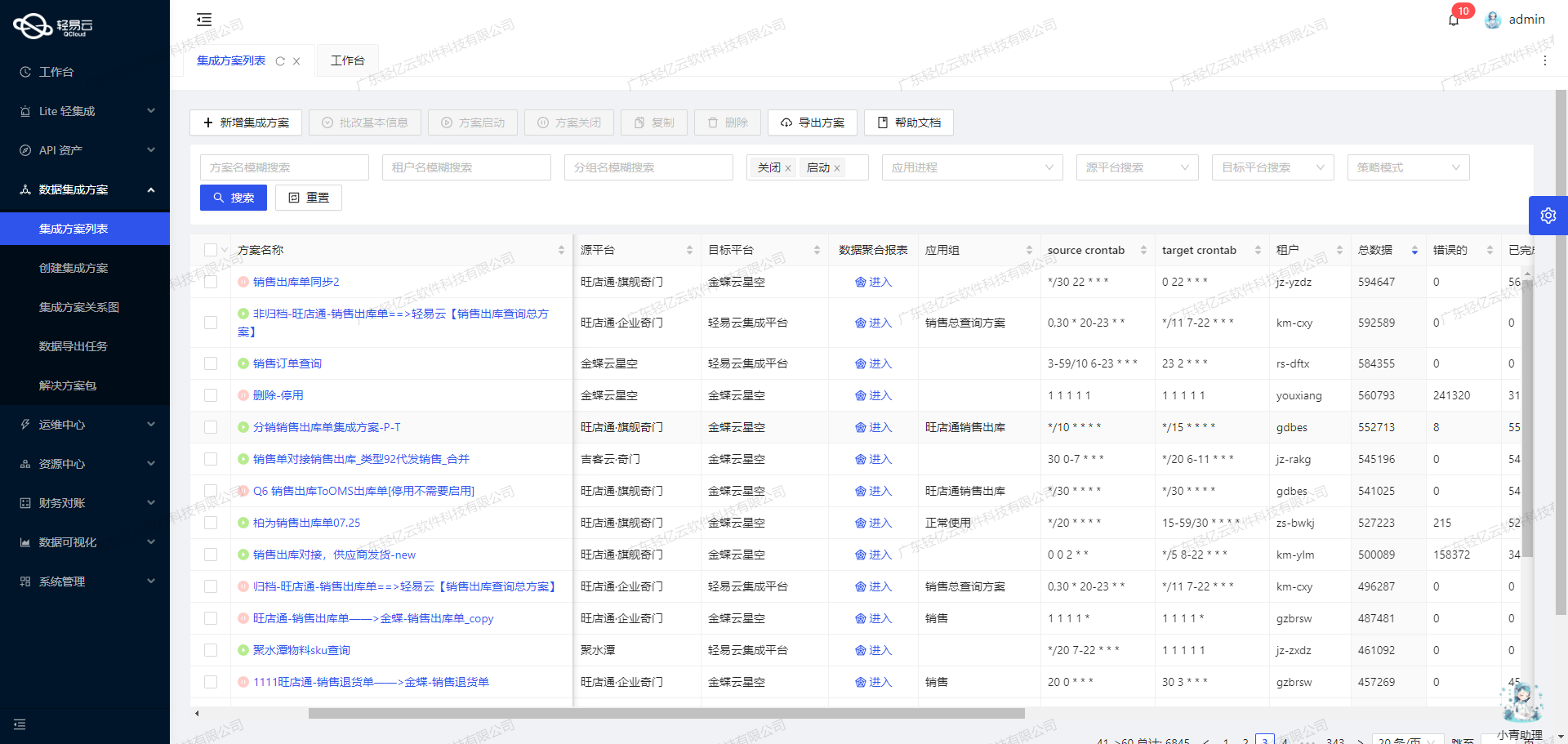

在本次技术案例中,我们将探讨如何通过轻易云数据集成平台,将聚水潭的商品信息高效地集成到MySQL数据库中。具体方案为“聚水潭-商品信息查询-->BI彩度-商品信息表”。这一过程不仅需要处理大量数据,还需确保数据的准确性和实时性。

首先,聚水潭作为一个强大的电商ERP系统,其API接口/open/sku/query提供了丰富的商品信息查询功能。为了实现高效的数据集成,我们利用轻易云平台支持高吞吐量的数据写入能力,使得大量商品数据能够快速被抓取并写入到MySQL数据库中。这极大提升了数据处理的时效性,确保业务运营中的数据始终保持最新。

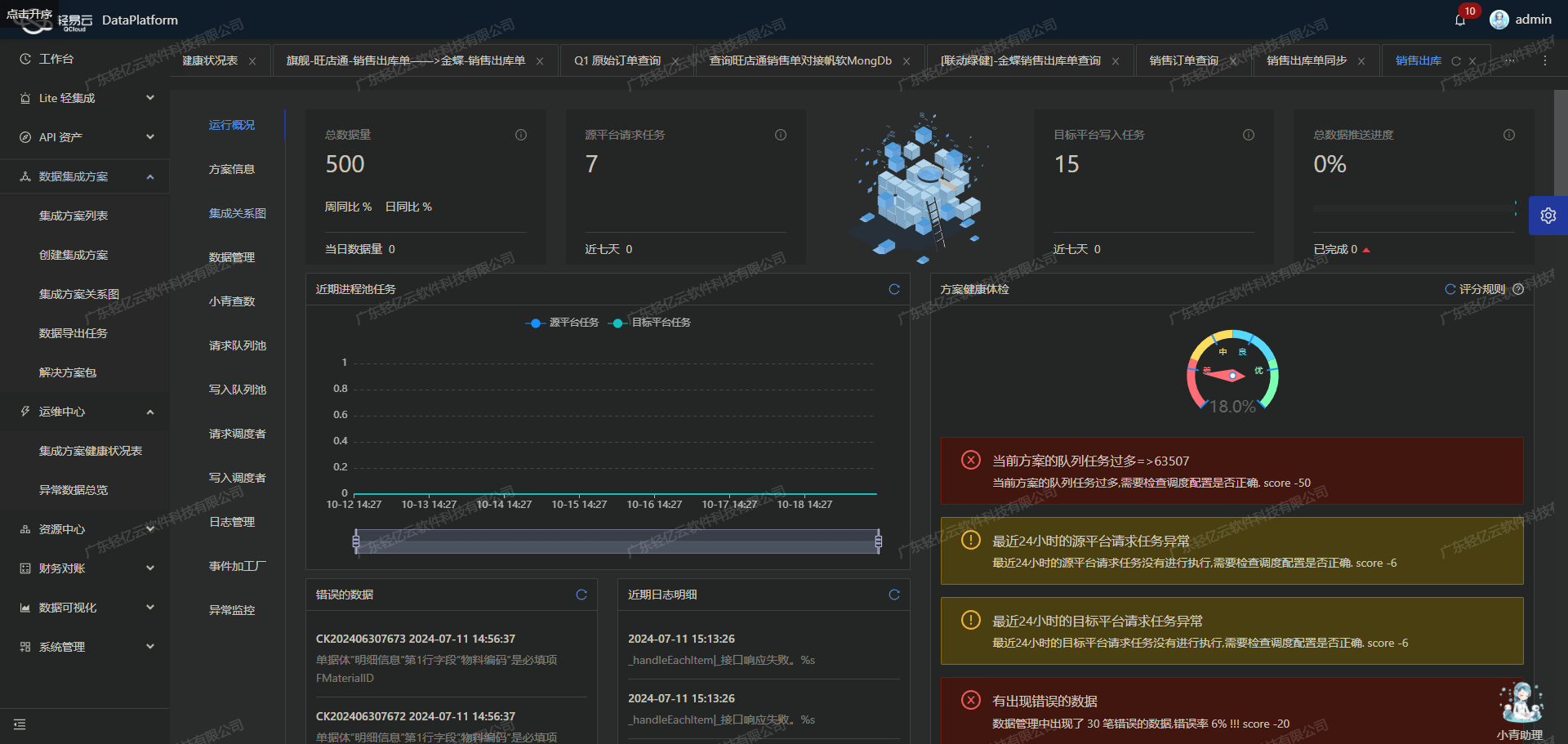

在整个集成过程中,定时可靠地抓取聚水潭接口的数据是关键一环。我们通过设置定时任务,确保在预设时间间隔内自动调用聚水潭API接口,获取最新的商品信息。同时,为了应对可能出现的数据质量问题和异常情况,轻易云平台提供了强大的监控和告警系统,可以实时跟踪每个数据集成任务的状态和性能。一旦发现异常情况,如网络延迟或接口限流等问题,系统会立即发出告警,并触发相应的错误重试机制,以保证数据传输的稳定性和连续性。

此外,在处理聚水潭与MySQL之间的数据格式差异时,我们利用轻易云平台提供的自定义数据转换逻辑功能,对原始数据进行必要的转换和映射,以适应目标数据库表结构。这一步骤不仅简化了开发工作,还提高了整体解决方案的灵活性和可维护性。

最后,通过轻易云平台提供的可视化数据流设计工具,我们可以直观地设计和管理整个数据集成流程。从源头抓取、转换、到最终写入MySQL,每个步骤都清晰可见,并且可以随时进行调整优化。这种全透明可视化操作界面,不仅让技术人员更容易上手,也使得项目管理更加高效。

综上所述,本次案例展示了如何利用轻易云平台,将聚水潭的数据无缝、高效地集成到MySQL数据库中,为企业的数据分析与决策提供坚实基础。在接下来的章节中,我们将详细介绍具体实施步骤及相关技术细节。

调用聚水潭接口获取商品信息并加工处理数据

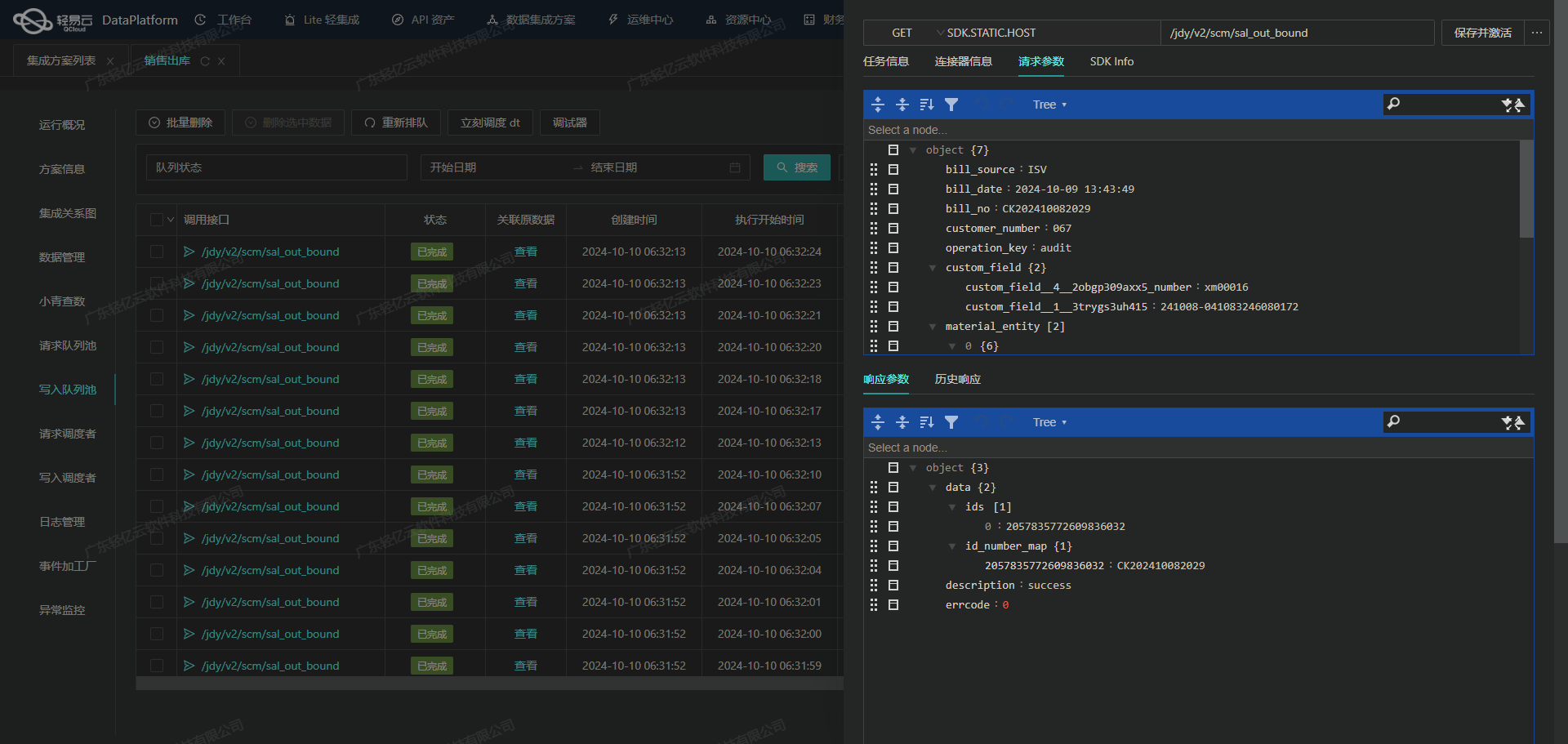

在数据集成过程中,调用源系统的API接口是关键的一步。本文将详细探讨如何通过轻易云数据集成平台调用聚水潭接口 /open/sku/query 获取商品信息,并对数据进行初步加工处理。

聚水潭接口配置与请求参数

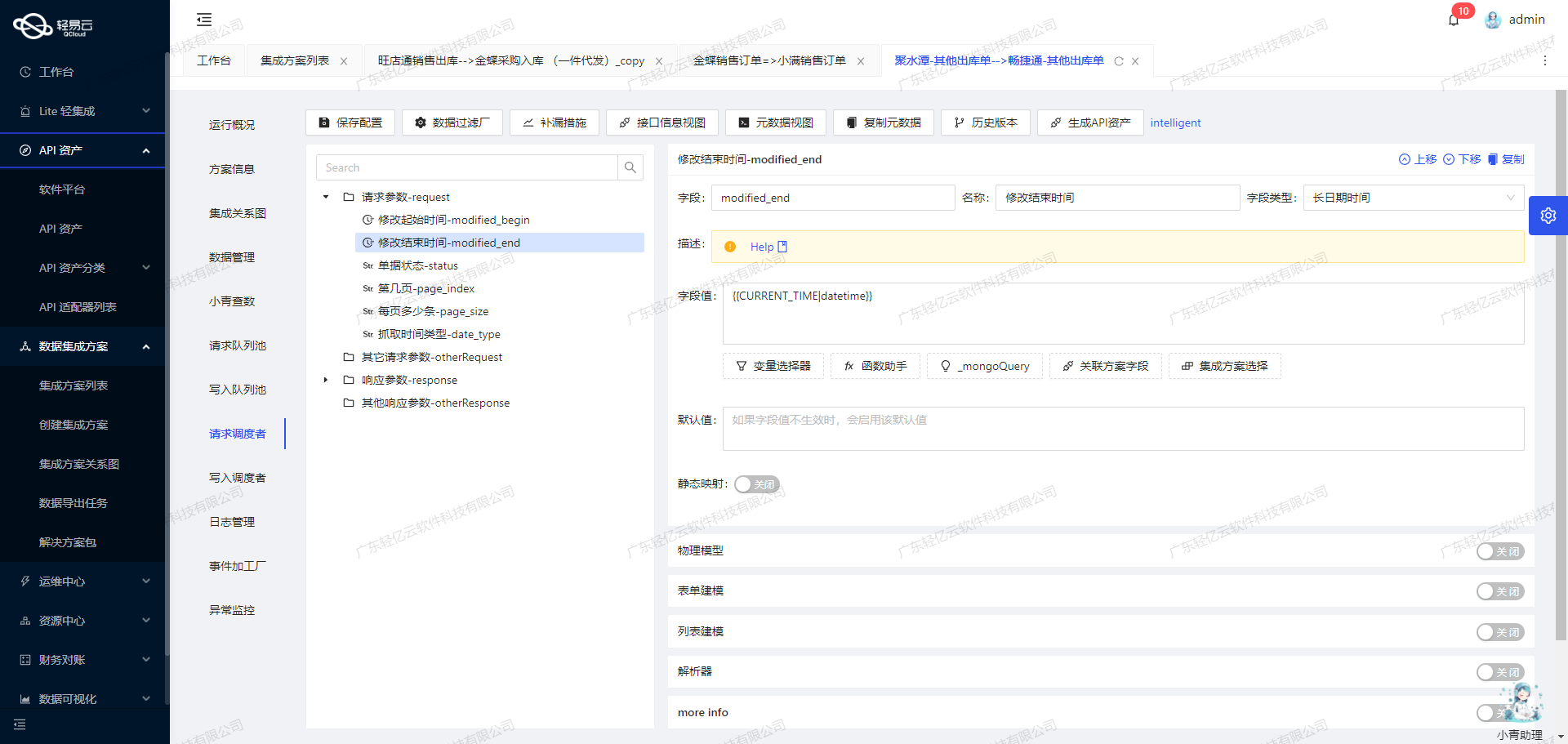

首先,我们需要配置聚水潭的API接口。根据元数据配置,聚水潭提供了一个POST请求的商品信息查询接口 /open/sku/query。该接口支持分页查询和时间范围过滤,具体请求参数如下:

page_index: 开始页,从第一页开始,默认值为1。page_size: 每页条数,默认30条,最大50条。modified_begin: 修改起始时间,与结束时间必须同时存在,时间间隔不能超过七天。modified_end: 修改结束时间,与起始时间必须同时存在。

这些参数确保我们能够灵活地控制查询范围和结果数量,从而高效地获取所需的数据。

数据请求与清洗

在实际操作中,我们需要设置合适的分页和时间范围,以避免遗漏或重复数据。这一步骤可以通过以下方式实现:

- 初始化分页参数:从第一页开始,每次请求50条记录。

- 设置时间范围:使用上次同步时间(

LAST_SYNC_TIME)作为起始时间,本次同步时刻(CURRENT_TIME)作为结束时间。

示例请求参数配置如下:

{

"page_index": "1",

"page_size": "50",

"modified_begin": "{{LAST_SYNC_TIME|datetime}}",

"modified_end": "{{CURRENT_TIME|datetime}}"

}通过这种方式,可以确保每次同步的数据都是最新修改过的,有效避免了漏单问题。

数据转换与写入

获取到原始数据后,需要对其进行清洗和转换,以便后续写入目标系统。在这个过程中,需要注意以下几点:

- 字段映射:将聚水潭返回的数据字段映射到BI彩度系统中的相应字段。例如,将

sku_id映射到目标表中的product_id。 - 格式转换:根据目标系统要求,对日期、数值等字段进行格式转换。例如,将日期格式从

YYYY-MM-DD HH:MM:SS转换为标准ISO格式。 - 异常处理:对于缺失或异常数据,需要进行补全或标记,以保证数据质量。

批量写入MySQL

为了提高效率,可以采用批量写入的方式,将处理后的数据一次性插入到MySQL数据库中。轻易云平台支持高吞吐量的数据写入能力,使得大量数据能够快速被集成到目标系统中。此外,还可以利用平台提供的定制化数据映射功能,实现复杂业务逻辑下的数据转换需求。

实时监控与日志记录

在整个过程中,通过轻易云平台提供的集中监控和告警系统,可以实时跟踪每个任务的状态和性能。一旦出现异常情况,如网络故障或API限流问题,可以及时触发告警并执行重试机制,确保任务顺利完成。同时,通过日志记录功能,可以详细记录每次操作,为后续排查问题提供依据。

总结来说,通过合理配置聚水潭API接口、精细化控制请求参数、有效的数据清洗与转换,以及高效的批量写入机制,可以实现稳定可靠的数据集成过程。这不仅提升了业务透明度,也极大提高了整体效率。

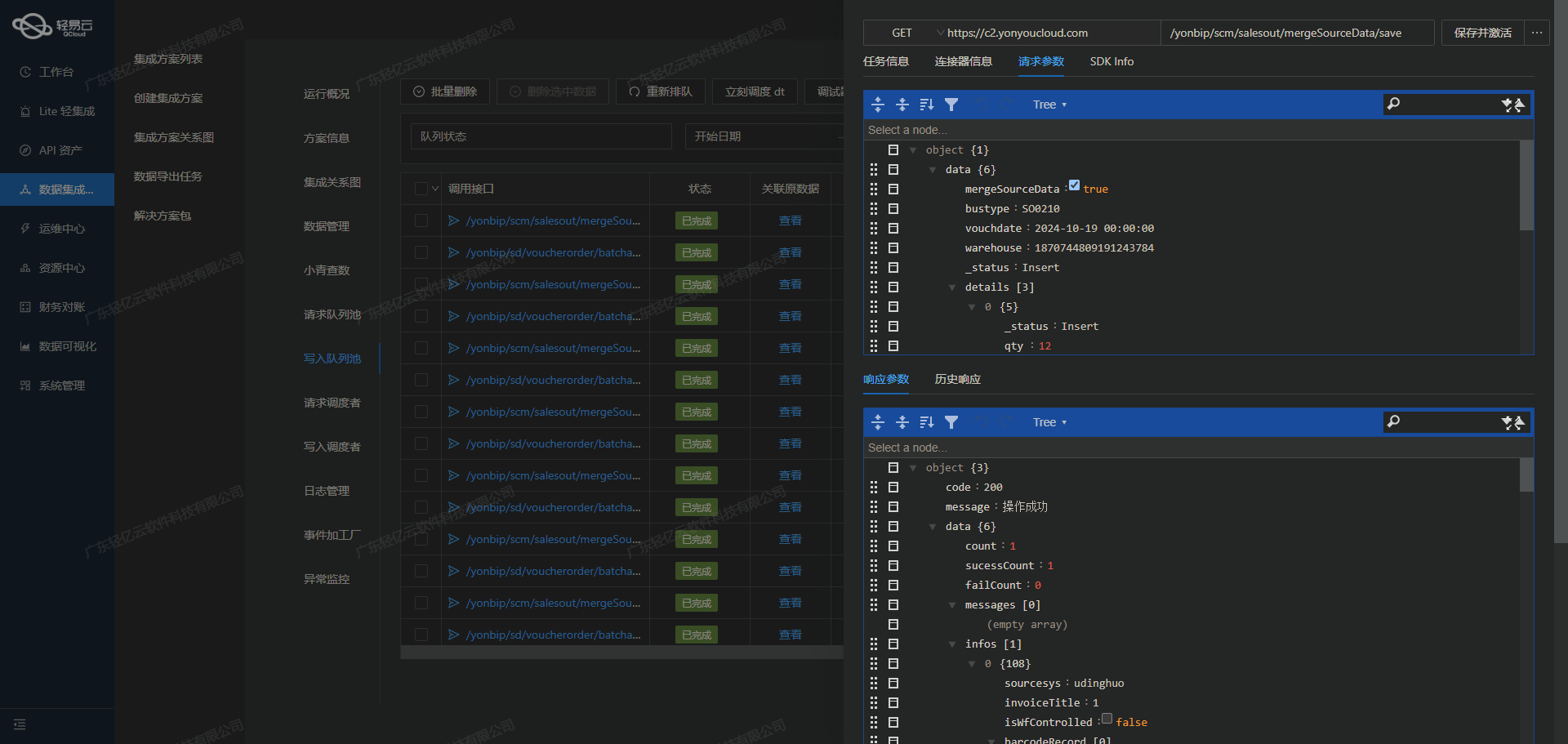

集成平台生命周期第二步:ETL转换与MySQL数据写入

在数据集成的过程中,第二步至关重要,即将已经集成的源平台数据进行ETL(提取、转换、加载)转换,使其符合目标平台MySQL API接口所能够接收的格式,并最终写入到目标平台。本文将详细探讨这一过程中的技术细节和关键步骤。

数据提取与清洗

首先,从源系统(如聚水潭)中提取商品信息。通过调用聚水潭的/open/sku/query接口获取原始数据。此接口返回的数据通常为JSON格式,包含多个字段,如商品编码、名称、价格等。

{

"sku_id": "12345",

"name": "商品A",

"sale_price": "100.00",

...

}在提取数据后,需要进行初步清洗,包括去除冗余字段、修正格式错误以及处理空值等。这一步确保了后续的转换和加载过程更加顺利。

数据转换

接下来是数据转换阶段,将清洗后的数据转换为目标平台MySQL API接口能够接受的格式。这里需要特别注意字段映射和类型匹配问题。例如,聚水潭返回的数据中,sale_price是字符串类型,而MySQL表中的对应字段可能是浮点数类型,因此需要进行类型转换。

根据提供的元数据配置,我们可以看到需要将多个字段进行映射和转换:

{

"field": "main_params",

"children": [

{"field": "sku_id", "value": "{sku_id}"},

{"field": "name", "value": "{name}"},

{"field": "sale_price", "value": "{sale_price}"},

...

]

}在此过程中,还需要处理一些复杂的逻辑。例如,将is_series_number字段根据条件进行计算:

{

"field": "is_series_number",

"value": "_function CASE {is_series_float} WHEN ' ' THEN 'false' ELSE 'true' END"

}这种自定义逻辑确保了数据能够准确地反映业务需求。

数据加载

完成数据转换后,将其加载到目标平台MySQL中。这里使用了REPLACE INTO语句,以确保如果记录已存在则更新,否则插入新记录:

REPLACE INTO sku_query (sku_id, name, sale_price, ...)

VALUES (:sku_id, :name, :sale_price, ...);通过轻易云的数据集成平台,可以配置自动执行上述SQL语句,并将参数替换为实际值。这一步骤确保了数据能够高效且准确地写入到MySQL数据库中。

高吞吐量与批量处理

为了应对大规模数据集成需求,轻易云平台支持高吞吐量的数据写入能力。这意味着可以在短时间内处理大量的数据请求,并将其快速写入到MySQL中。此外,通过批量处理机制,可以一次性处理多个记录,进一步提升效率。

实时监控与异常处理

在整个ETL过程中,实时监控和异常处理至关重要。轻易云平台提供集中的监控和告警系统,可以实时跟踪数据集成任务的状态和性能。一旦检测到异常情况,例如网络故障或数据格式错误,可以立即触发告警并执行重试机制,以确保数据集成过程的可靠性。

自定义映射与优化配置

为了适应特定业务需求,可以通过自定义映射逻辑对接MySQL。例如,对于某些特殊字段,可以根据业务规则进行转换或计算。此外,通过统一视图和控制台,企业可以全面掌握API资产的使用情况,实现资源的高效利用和优化配置。

综上所述,在轻易云数据集成平台上进行ETL转换并写入MySQL涉及多个关键步骤,包括数据提取与清洗、数据转换、加载、高吞吐量与批量处理,以及实时监控与异常处理。这些技术特性确保了整个过程的高效性和可靠性,为企业提供了强有力的数据支持。