查询班牛售后补发代发店铺的系统对接集成案例分享

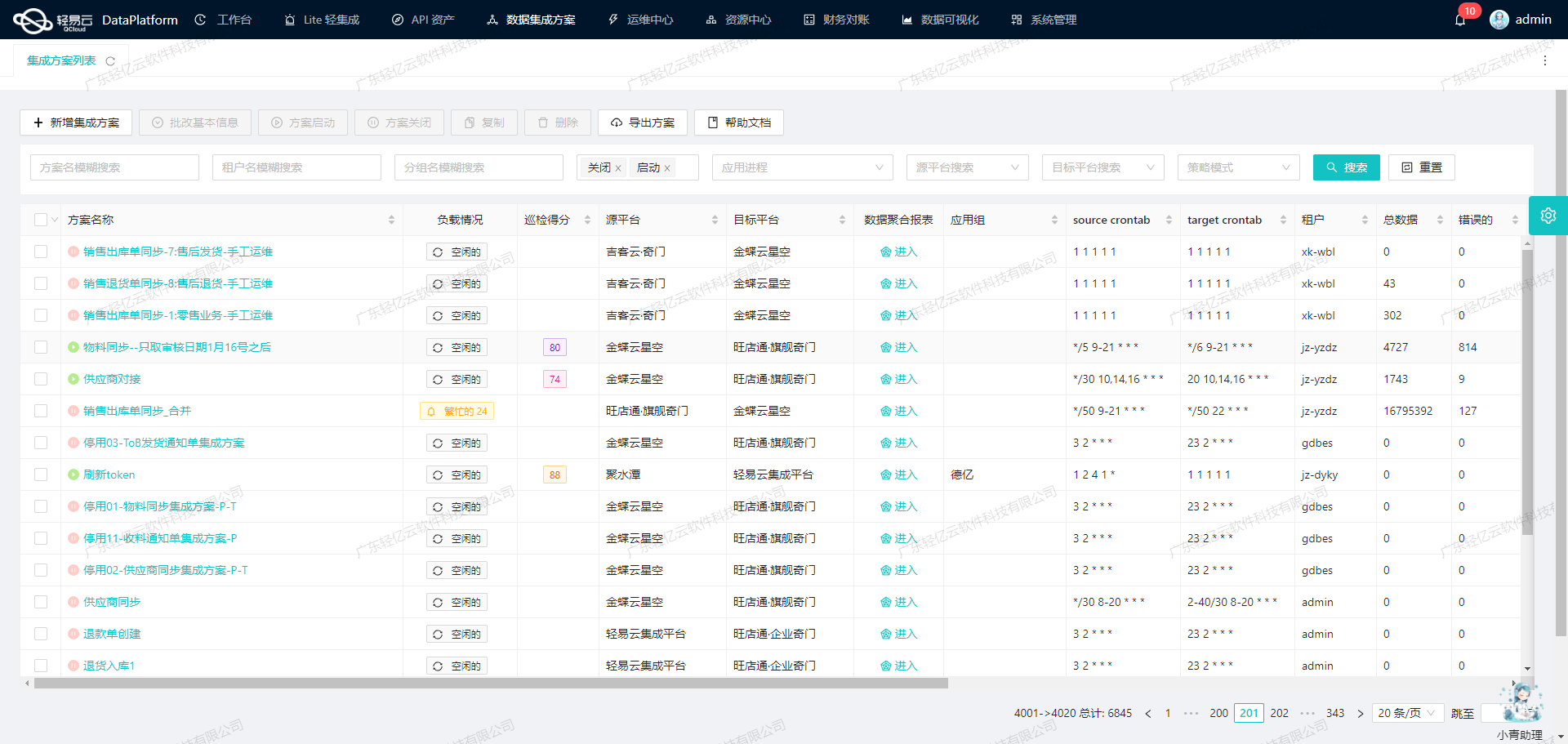

在现代数据驱动的业务环境中,如何高效、准确地实现数据集成是每个企业面临的重要挑战。本文将聚焦于一个具体的系统对接集成案例:如何通过轻易云数据集成平台,将班牛的数据无缝集成到班牛系统中,以实现查询售后补发代发店铺的功能。

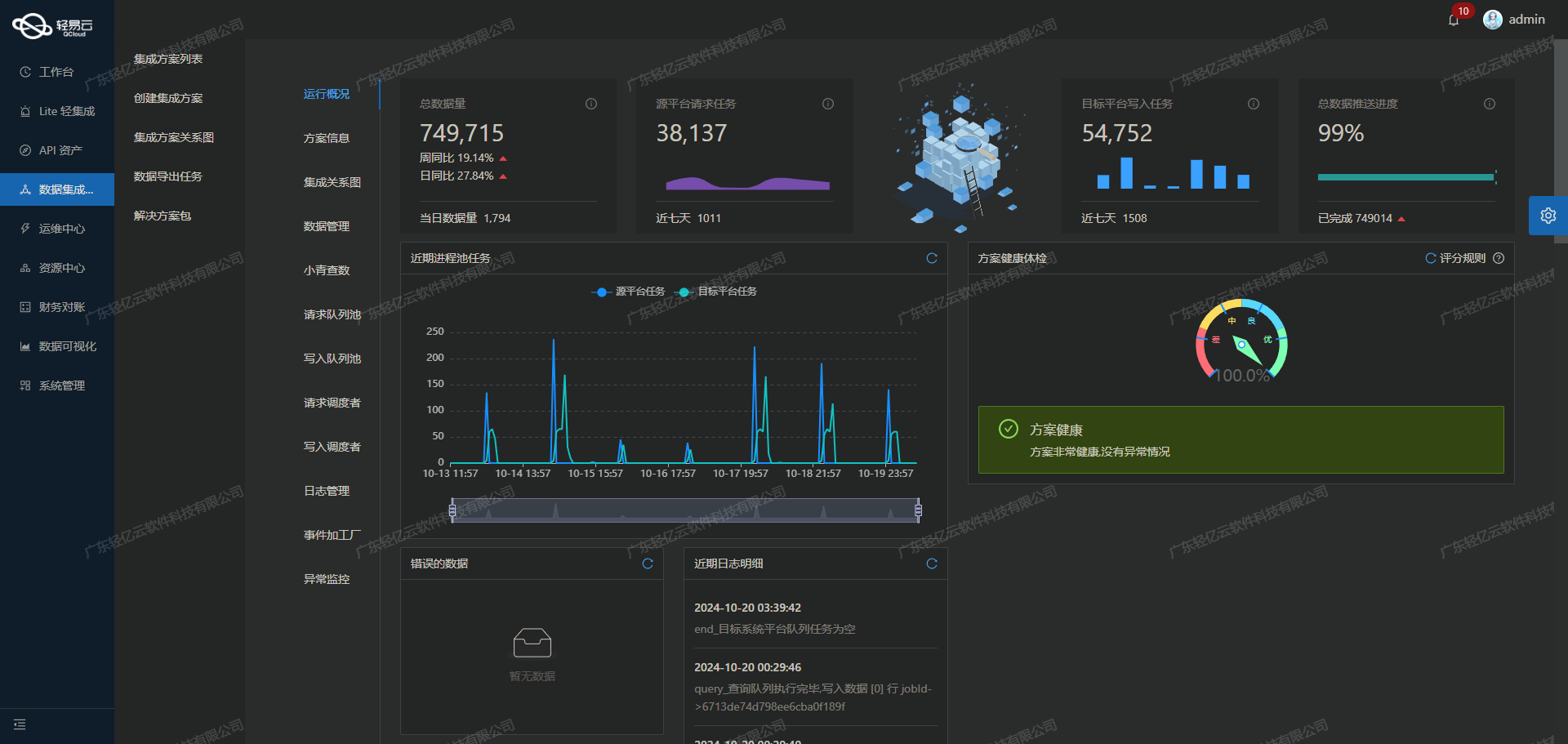

为了确保数据集成过程中的高效性和可靠性,我们利用了轻易云平台的一系列特性,包括支持高吞吐量的数据写入能力、集中监控和告警系统以及自定义数据转换逻辑等。这些特性不仅提升了数据处理的时效性,还保证了整个流程的透明度和可控性。

在本次案例中,我们主要使用了班牛提供的两个关键API接口:column.list用于获取所需的数据,workflow.task.create用于将处理后的数据写入目标系统。通过这些API接口,我们能够定时可靠地抓取班牛接口的数据,并批量集成到目标平台。

此外,为了应对可能出现的数据质量问题和异常情况,轻易云平台提供了强大的数据质量监控和异常检测功能。这使得我们可以及时发现并处理任何潜在的问题,从而确保整个数据集成过程的稳定运行。

接下来,我们将详细介绍具体的技术方案和实施步骤,包括如何调用班牛接口、处理分页与限流问题,以及实现定制化的数据映射对接等内容。

调用班牛接口column.list获取并加工数据

在轻易云数据集成平台的生命周期中,调用源系统接口是至关重要的一步。本文将详细探讨如何通过调用班牛接口column.list来获取和加工数据,以实现查询售后补发代发店铺的需求。

接口概述

班牛提供了丰富的API接口,其中column.list用于查询特定列的数据。该接口支持多种查询条件和分页参数,能够灵活地满足不同业务场景下的数据请求需求。

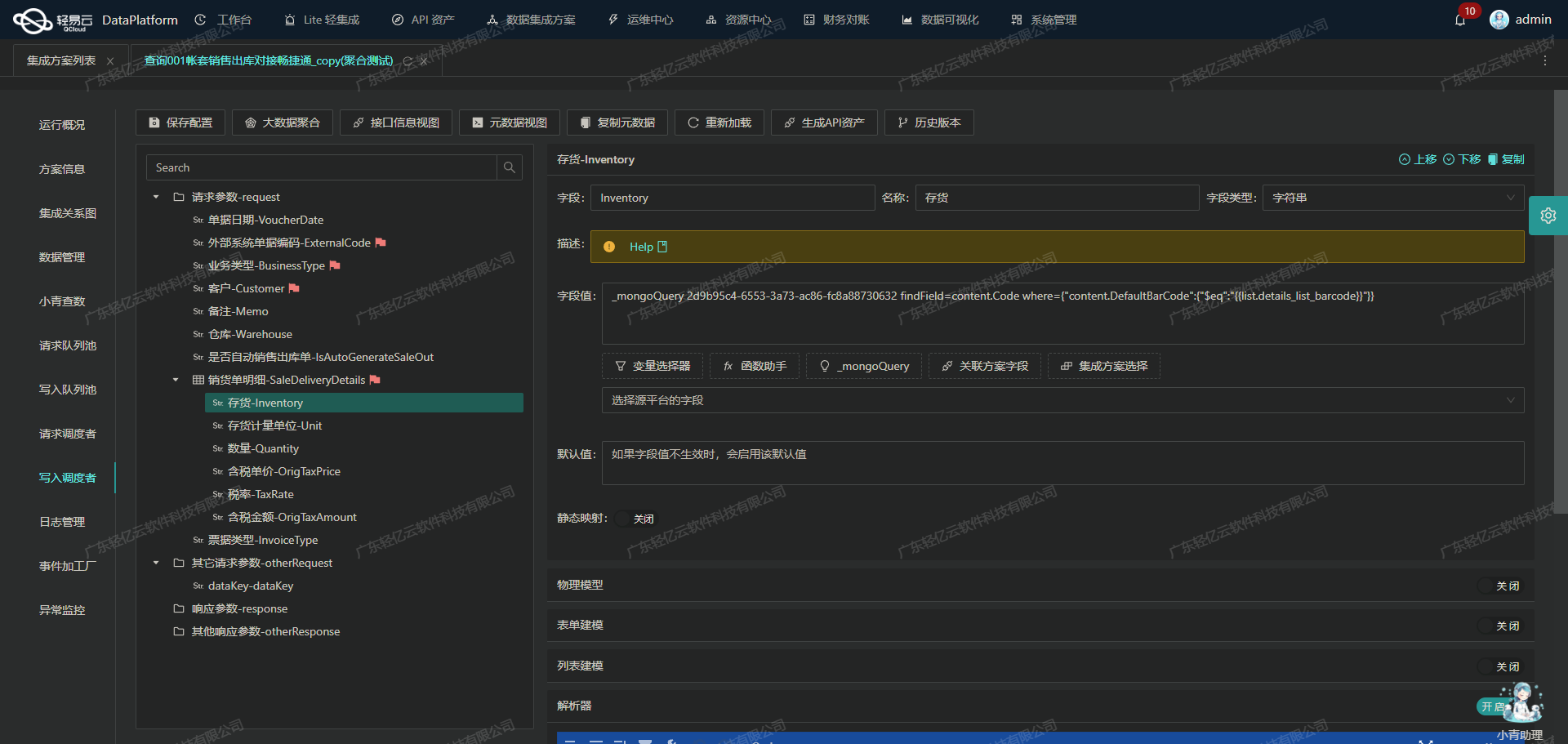

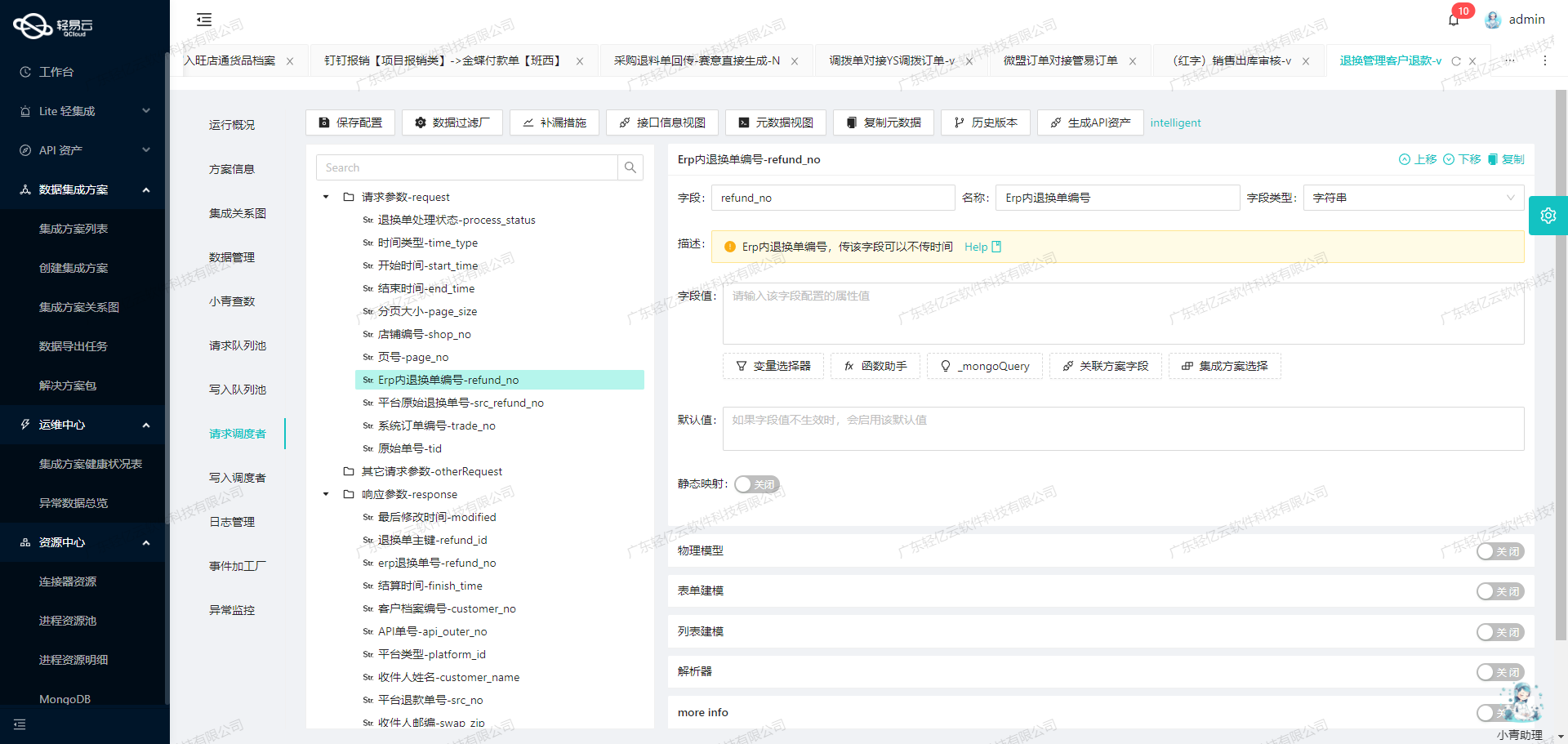

元数据配置解析

在轻易云数据集成平台中,我们需要配置元数据来定义如何调用和处理班牛的API。以下是关键配置项:

- api:

column.list - effect:

QUERY - method:

GET - number:

column_id - id:

column_id - request:

project_id: 固定值为77206

- condition:

- 查询条件:

column_id like '77214'

- 查询条件:

这些配置项定义了我们要调用的API、请求方法、主要字段以及查询条件等。

数据请求与清洗

首先,通过GET方法向班牛API发送请求,获取原始数据。在这个过程中,需要特别注意以下几点:

- 分页处理:由于可能存在大量数据,必须处理好分页问题。可以通过设置适当的分页参数(如page、size)来逐页获取数据。

- 限流机制:为了避免对班牛服务器造成过大压力,应遵循其限流策略。如果遇到限流,可以实现重试机制,在一定时间间隔后重新发送请求。

- 异常处理:任何网络请求都可能遇到异常情况,如超时或服务器错误。应设计健壮的异常处理逻辑,包括记录日志、告警通知以及重试机制。

数据转换与写入

在成功获取到原始数据后,需要进行必要的数据清洗和转换,以便符合目标系统的要求。这一步通常包括:

- 字段映射与转换:根据业务需求,将原始数据中的字段映射到目标系统所需的字段,并进行必要的数据类型转换。例如,将字符串类型的日期转换为标准日期格式。

- 去重与过滤:如果原始数据中存在重复或无效记录,应进行去重和过滤操作,以确保最终写入的数据质量。

- 自定义逻辑应用:根据具体业务需求,可以应用一些自定义逻辑,如计算新字段值、合并多个字段等。

实现高效的数据写入

轻易云平台支持高吞吐量的数据写入能力,使得大量数据能够快速被集成到目标系统中。在实际操作中,可以采用批量写入方式,提高效率并减少网络开销。同时,通过实时监控和告警系统,可以及时发现并处理潜在问题,确保整个过程顺利进行。

实时监控与日志记录

为了确保整个集成过程透明可控,轻易云平台提供了集中监控和日志记录功能。通过这些工具,可以实时跟踪每个任务的状态和性能指标,并在出现异常时及时采取措施。例如,当某个任务失败时,可以自动触发告警通知相关人员,并生成详细日志以供排查分析。

总结

通过合理配置元数据并利用轻易云平台强大的功能,我们可以高效地调用班牛接口column.list获取所需数据,并经过清洗、转换后写入目标系统。这不仅提高了业务透明度和效率,还确保了数据质量,为企业决策提供可靠支持。

集成方案:查询班牛售后补发代发店铺

在数据集成过程中,将源平台的数据转换为班牛API接口所能接受的格式是关键的一步。本文将深入探讨如何利用轻易云数据集成平台的特性,完成这一任务。

数据请求与清洗

首先,从源平台提取原始数据,并进行初步的清洗和规范化。这一步主要包括去除冗余字段、标准化数据格式以及处理缺失值等操作。确保源数据质量是成功实现ETL转换的前提。

数据转换与写入

接下来,进入数据转换阶段。我们需要根据班牛API接口的要求,将清洗后的数据进行格式转换。以下是一些关键步骤:

1. 数据映射与转换逻辑

利用轻易云平台的自定义数据转换功能,可以针对不同字段进行精细化映射。例如,源平台中的某些字段可能需要合并或拆分,以符合班牛API的格式要求。在这个过程中,使用可视化的数据流设计工具,可以直观地管理和调整数据映射关系。

# 示例:将源平台字段A、B合并为目标字段C

源平台: { "fieldA": "value1", "fieldB": "value2" }

目标平台: { "fieldC": "value1_value2" }2. 调用班牛API接口

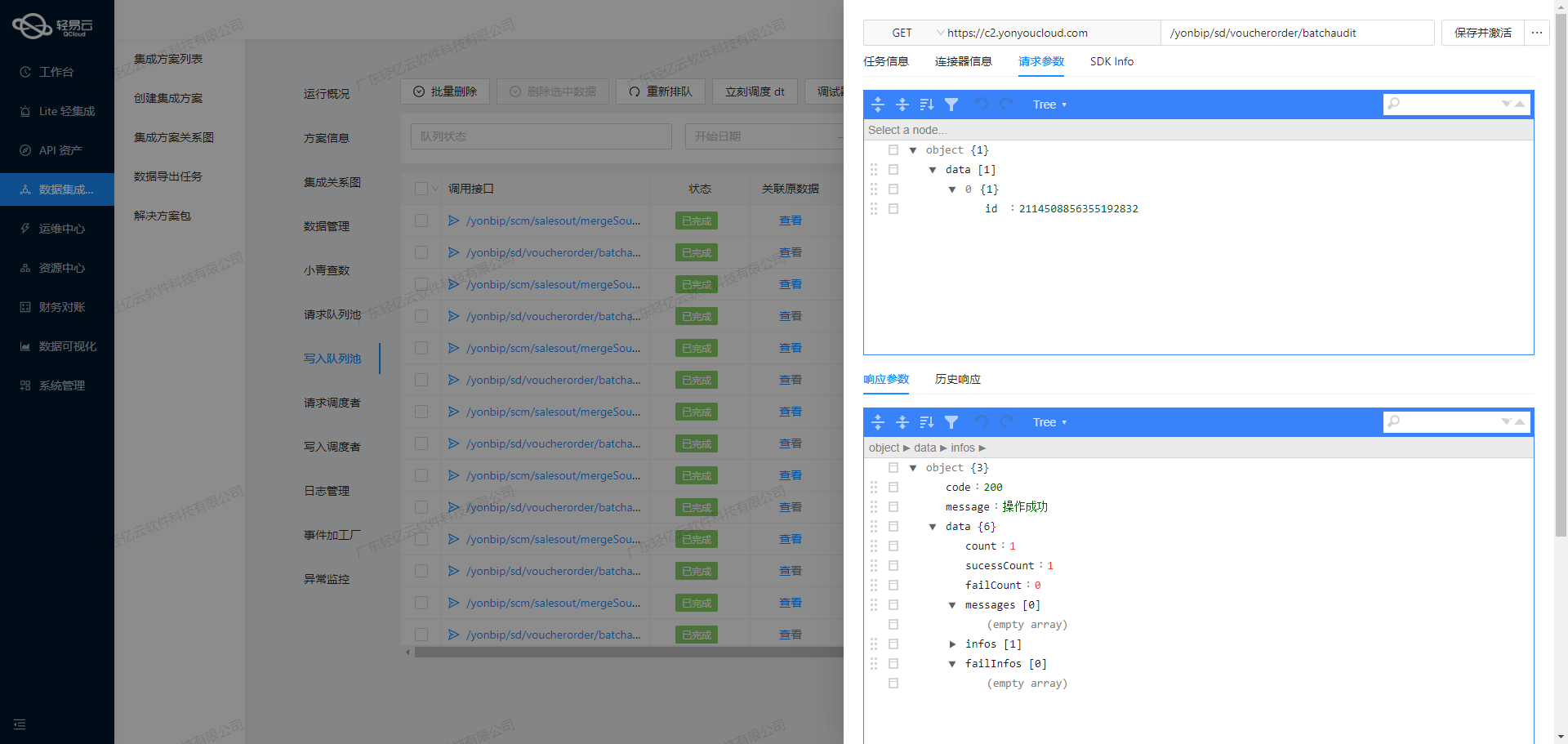

在完成数据转换后,通过调用班牛API接口,将处理好的数据写入目标平台。这里以workflow.task.create API为例,该接口支持POST方法,并且需要进行ID检查(idCheck: true)。

POST /api/workflow.task.create

{

"fieldC": "value1_value2",

...

}3. 批量处理与高吞吐量支持

为了提高效率,可以利用轻易云平台的高吞吐量支持功能,实现批量数据写入。这不仅能加快处理速度,还能减少API调用次数,降低系统负载。

4. 分页与限流处理

在处理大规模数据时,需要注意分页和限流问题。通过合理设置分页参数,以及使用限流机制,可以避免API调用过于频繁导致的性能问题。

# 示例:分页请求

GET /api/data?page=1&limit=100实时监控与异常处理

为了确保集成过程的稳定性和可靠性,轻易云提供了实时监控和告警系统。可以通过监控任务状态和性能指标,及时发现并处理潜在问题。同时,异常处理机制和错误重试策略也是必不可少的。当出现网络异常或其他意外情况时,系统能够自动重试,确保数据不丢失、不漏单。

# 示例:错误重试机制

{

"retryPolicy": {

"maxRetries": 3,

"interval": 5000

}

}数据质量监控

最后,通过轻易云的数据质量监控功能,可以对集成后的数据进行验证和校验,确保其符合预期标准。任何发现的数据问题,都可以及时记录并反馈,以便后续修正。

总结

通过上述步骤,我们可以高效地将已经集成的源平台数据转化为班牛API能够接收的格式,并成功写入目标平台。轻易云提供的一系列特性,如自定义数据转换、批量处理、高吞吐量支持、实时监控和异常处理等,为这一过程提供了强有力的保障。