聚水潭数据集成到金蝶云星空的技术案例分享

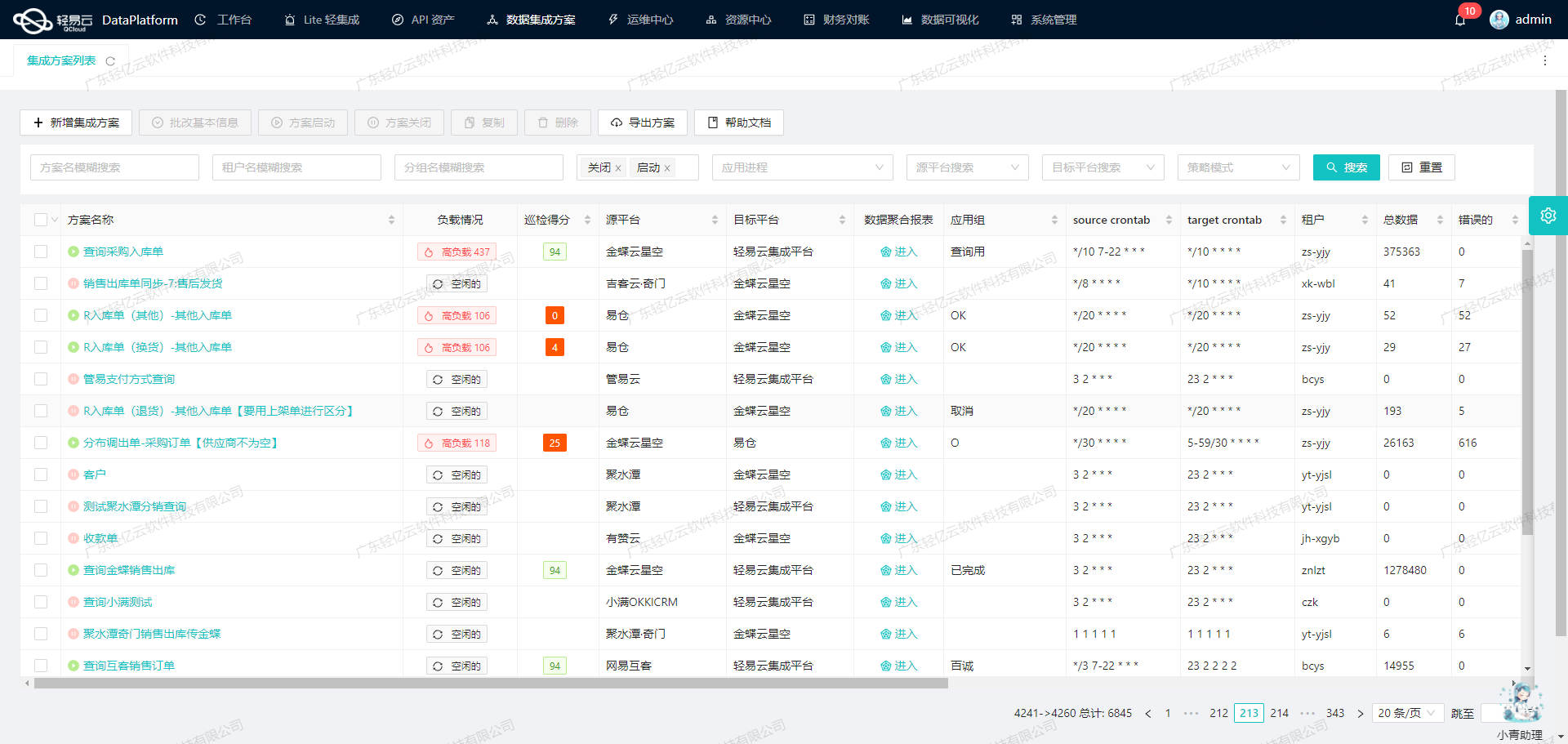

在企业信息化系统中,数据的高效流转和准确同步是确保业务顺畅运行的关键。本文将聚焦于一个具体的系统对接集成案例:[自动]-其他入库单同步,通过轻易云数据集成平台实现聚水潭与金蝶云星空的数据无缝对接。

本次集成任务主要涉及两个核心API接口:聚水潭获取数据的API /open/other/inout/query 和金蝶云星空写入数据的API batchSave。为了确保整个过程高效、可靠,我们利用了轻易云平台的一系列特性:

-

高吞吐量的数据写入能力:在处理大量入库单数据时,能够快速将其从聚水潭系统中提取并写入到金蝶云星空,极大提升了数据处理的时效性。

-

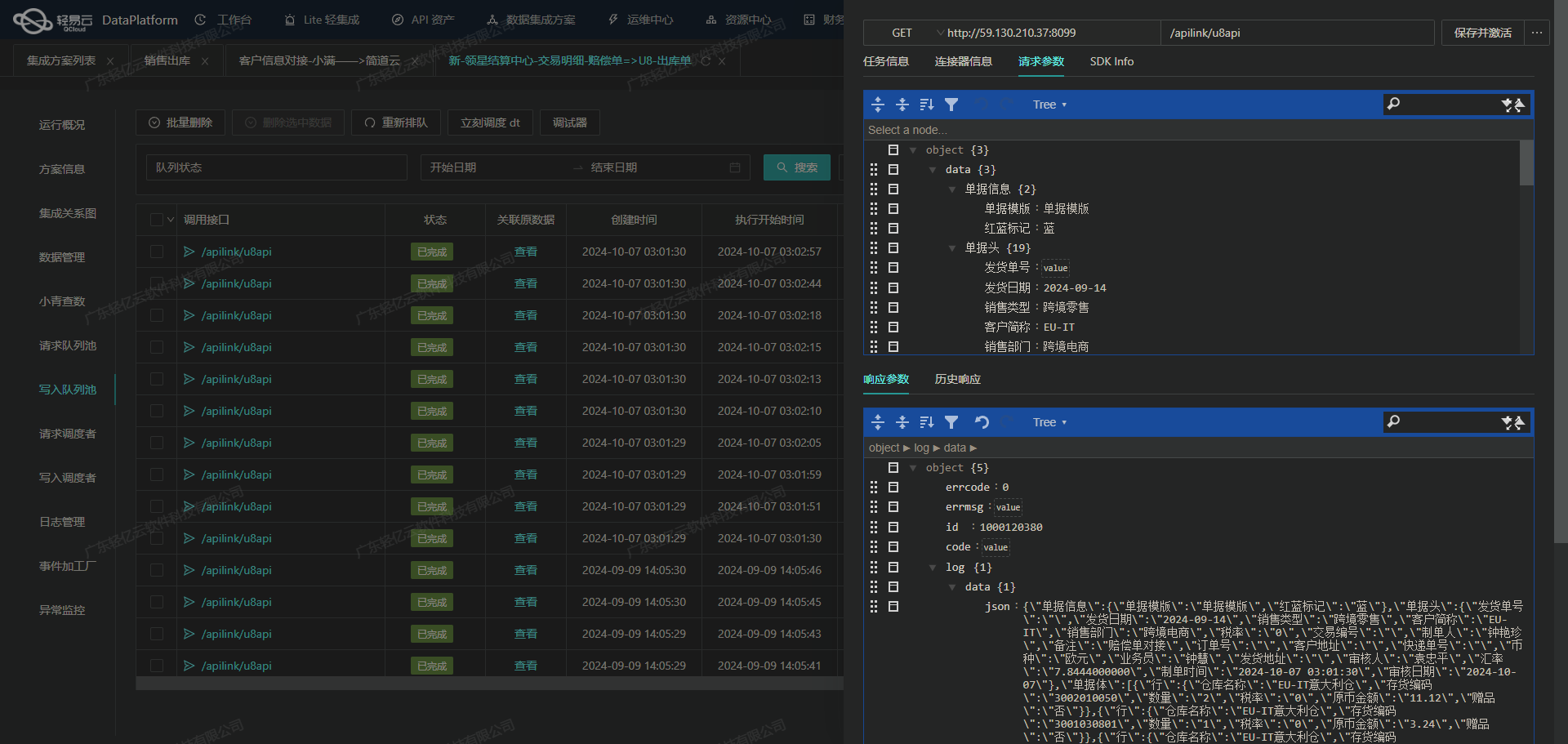

集中监控和告警系统:实时跟踪每个数据集成任务的状态和性能,一旦出现异常情况,立即触发告警机制,确保问题能够被及时发现和解决。

-

自定义数据转换逻辑:针对聚水潭与金蝶云星空之间的数据格式差异,我们设计了灵活的数据转换规则,以适应不同业务需求和复杂的数据结构。

-

分页和限流处理:由于聚水潭接口存在分页和限流限制,我们通过优化抓取策略,实现了定时可靠地获取接口数据,并批量集成到目标平台。

-

异常处理与错误重试机制:在对接过程中可能遇到各种异常情况,如网络波动或接口响应超时。我们设计了一套完善的错误重试机制,确保即使在不稳定环境下,也能保证数据不漏单、不重复。

通过上述技术手段,本次[自动]-其他入库单同步方案不仅实现了高效、稳定的数据对接,还为后续类似项目提供了宝贵经验。在接下来的章节中,我们将详细探讨具体实施步骤及技术细节。

调用聚水潭接口获取并加工数据的技术实现

在数据集成过程中,调用源系统接口是关键的一步。本文将详细探讨如何通过轻易云数据集成平台调用聚水潭接口/open/other/inout/query,并对获取的数据进行初步加工处理。

接口调用配置

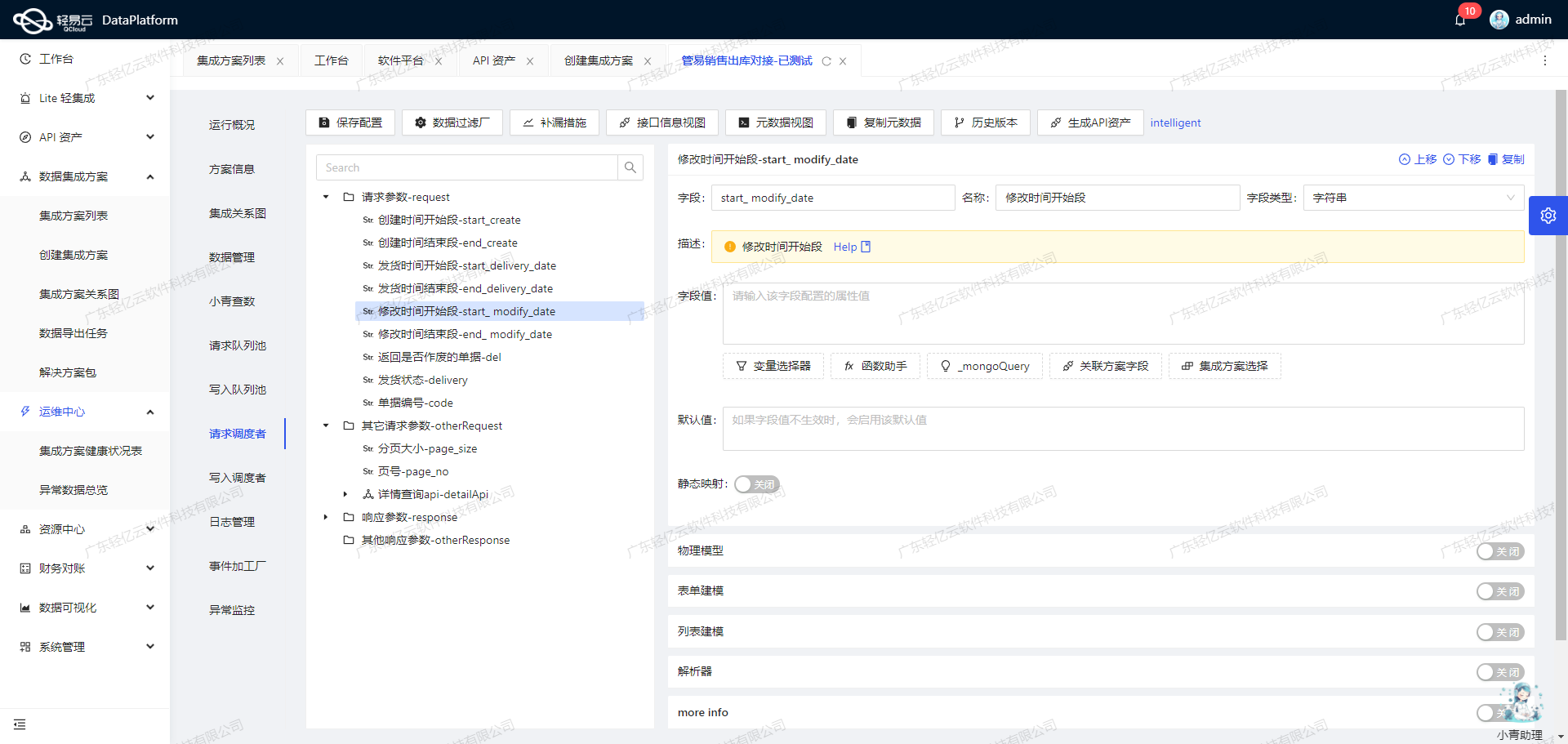

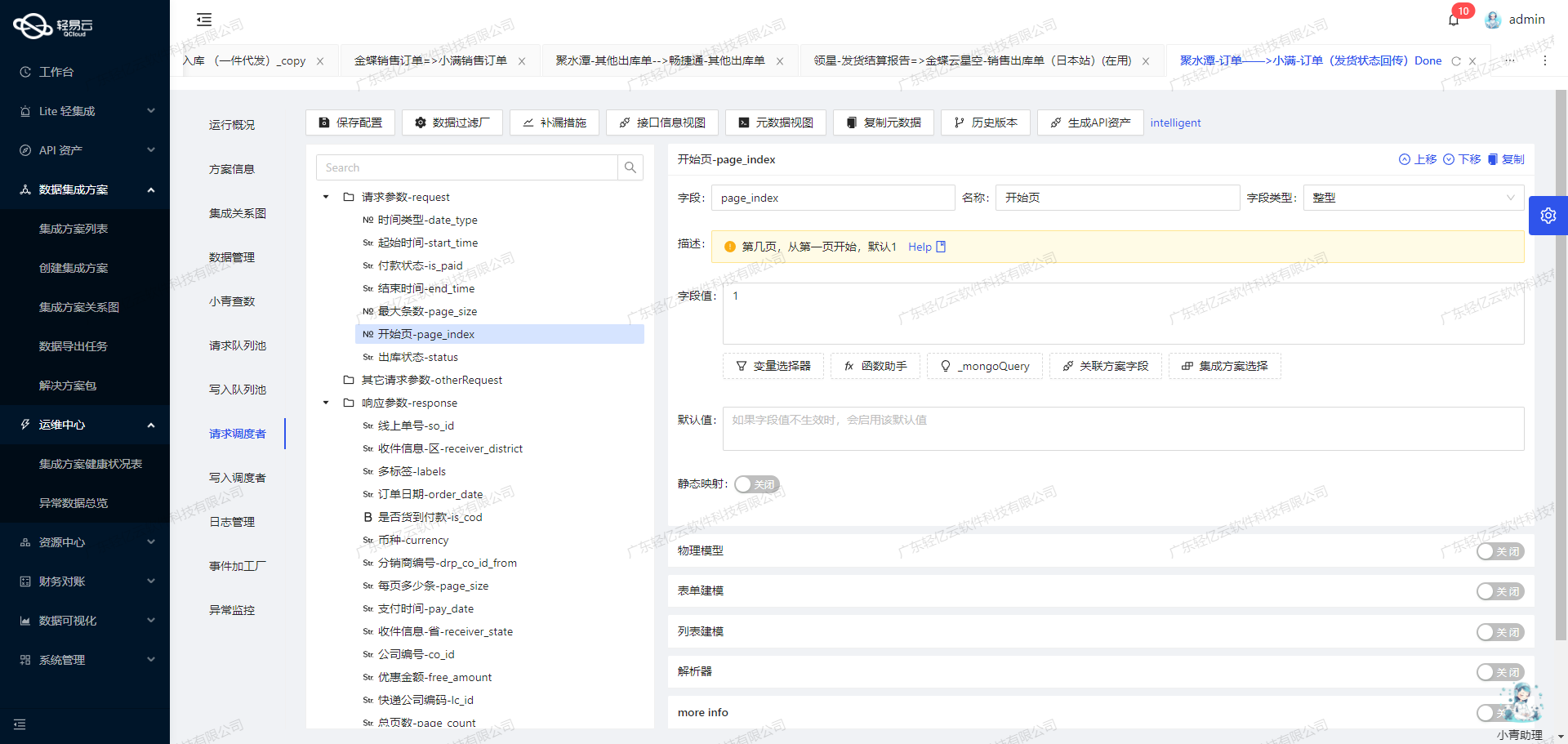

首先,我们需要配置API请求参数。根据元数据配置,接口使用POST方法,主要参数包括:

modified_begin和modified_end:用于指定查询的时间范围。types:单据类型,包括"其它进仓"和"其它退货"。status:单据状态,仅查询已生效的单据。- 分页参数:

page_index和page_size。

这些参数确保我们能够精准地获取所需的数据,并且支持分页处理以应对大数据量场景。

{

"api": "/open/other/inout/query",

"method": "POST",

"number": "io_id",

"id": "io_id",

"pagination": {

"pageSize": 50

},

"request": [

{"field":"modified_begin","value":"{{LAST_SYNC_TIME|datetime}}"},

{"field":"modified_end","value":"{{CURRENT_TIME|datetime}}"},

{"field":"types","value":"其它进仓,其它退货"},

{"field":"status","value":"Confirmed"},

{"field":"page_index","value":"1"},

{"field":"page_size","value":"{PAGINATION_PAGE_SIZE}"}

]

}数据清洗与转换

在获取到原始数据后,需要进行清洗和转换,以便后续处理。以下是几个关键步骤:

-

时间格式转换: 将时间字段统一转换为标准格式,确保一致性。例如,将字符串格式的时间转为ISO8601格式。

-

字段映射: 根据业务需求,将聚水潭返回的数据字段映射到目标系统所需的字段。例如,将聚水潭中的

io_id映射为目标系统中的订单ID。 -

数据过滤: 根据条件过滤不需要的数据。例如,只保留“Confirmed”状态的单据。

-

异常处理: 实现异常检测与处理机制,例如对于缺失或错误的数据进行标记或丢弃,并记录日志以便后续分析。

分页与限流处理

由于可能存在大量数据,我们需要实现分页和限流机制,以确保稳定性和性能。每次请求时,通过调整分页参数来逐页获取数据,并设置合理的限流策略避免过载。

{

"pagination": {

"pageSize": 50,

"currentPage": "{{CURRENT_PAGE}}"

}

}在实际操作中,可以利用轻易云平台提供的定时任务功能,定期抓取新数据,并结合增量同步策略(例如使用上次同步时间作为起始时间),确保数据不漏单且高效更新。

实时监控与告警

为了保证整个过程顺利进行,需要实时监控任务状态。一旦出现异常,如网络故障或接口响应超时,应及时触发告警并自动重试。这可以通过轻易云平台内置的监控和告警系统实现,确保问题能够被快速发现和解决。

自定义转换逻辑

根据具体业务需求,可以自定义复杂的数据转换逻辑。例如,对于某些特定类型的单据,需要额外计算某些字段值或合并多个字段信息。这可以通过编写自定义脚本或规则来实现,使得最终输出的数据完全符合目标系统要求。

综上,通过合理配置API请求、实施有效的数据清洗与转换、以及完善的分页与限流机制,我们能够高效地从聚水潭系统获取并加工所需数据,为后续集成奠定坚实基础。同时,通过实时监控与告警、自定义转换逻辑等手段,进一步提升了整个流程的可靠性和灵活性。

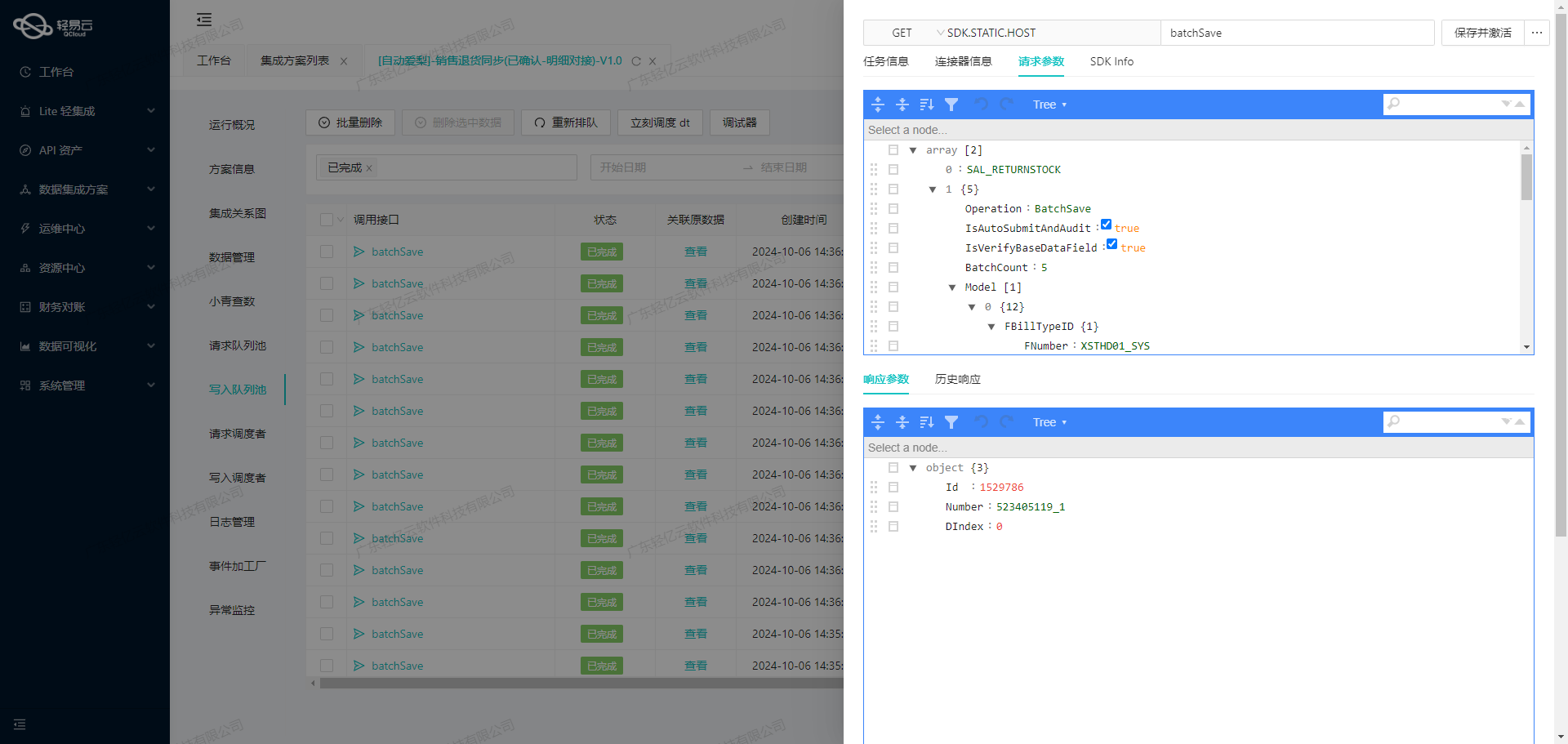

自动-其他入库单同步:ETL转换与写入金蝶云星空

在轻易云数据集成平台上,实现将源平台数据转换并写入到金蝶云星空的过程,关键在于ETL(Extract, Transform, Load)转换。以下是如何通过ETL转换,将聚水潭系统中的“其他入库单”数据,转为金蝶云星空API接口所能够接收的格式,并最终写入目标平台的技术方案。

数据提取与清洗

首先,从聚水潭系统中提取“其他入库单”数据。数据提取的接口通常为/open/other/inout/query,需要处理分页和限流问题,以确保大批量数据不会遗漏。通过定时任务可靠地抓取这些接口数据,可以保证数据的完整性和及时性。

数据转换

在数据转换阶段,我们需要根据金蝶云星空API接口的要求,将提取的数据进行格式转换。以下是一些关键字段及其转换逻辑:

-

单据编号 (FBillNo):

{"field":"FBillNo","value":"{io_id}"}直接映射聚水潭的

io_id字段。 -

单据类型 (FBillTypeID):

{"field":"FBillTypeID","value":"QTRKD01_SYS"}固定值设置为

QTRKD01_SYS。 -

库存组织 (FStockOrgId):

{"field":"FStockOrgId","value":"_function case '{wms_co_id}' when '13328244' then '101' else '100' end"}根据

wms_co_id字段进行条件判断和转换。 -

日期 (FDate):

{"field":"FDate","value":"{io_date}"}直接映射聚水潭的日期字段。

-

部门 (FDEPTID):

{"field":"FDEPTID","value":"_function case when '{{items.sku_id}}' like 'A%' then 'LJ006' else 'LJ011' end"}根据SKU ID前缀进行条件判断和转换。

-

明细信息 (FEntity):

- 物料编码 (FMATERIALID):

{"field":"FMATERIALID","value":"{{items.sku_id}}"}映射SKU ID。

- 收货仓库 (FSTOCKID):

{"field":"FSTOCKID","value":"{wms_co_id}"}映射仓库ID。

- 实收数量 (FQty):

{"field":"FQty","value":"{{items.qty}}"}映射数量。

- 成本价 (FPrice):

{"field":"FPrice","value":"{{items.cost_price}}"}映射成本价。

- 物料编码 (FMATERIALID):

数据加载

完成数据转换后,通过调用金蝶云星空API接口,将处理后的数据写入目标平台。具体API调用配置如下:

{

"api": "batchSave",

"method": "POST",

"request": [

// 上述已配置好的请求字段...

],

"otherRequest": [

{"field": "FormId", "value": "STK_MISCELLANEOUS"},

{"field": "IsVerifyBaseDataField", "value": true},

{"field": "Operation", "value": "Save"},

{"field": "IsAutoSubmitAndAudit", "value": true}

]

}异常处理与监控

为了确保整个ETL过程的稳定性,需要实现异常处理与错误重试机制。当发生错误时,系统会记录日志并进行告警通知,同时尝试重试操作。此外,通过轻易云提供的集中监控和告警系统,可以实时跟踪每个数据集成任务的状态和性能,及时发现并解决问题。

数据质量监控

支持自定义的数据质量监控和异常检测功能,确保每条记录都符合预期格式和业务规则。在发现异常数据时,系统会自动标记并发送告警,以便及时处理。

通过上述技术方案,可以高效地将聚水潭系统中的“其他入库单”数据转化为金蝶云星空可接收的格式,并可靠地写入目标平台,实现了两者之间的数据无缝对接。