钉钉数据集成到MySQL的技术案例分享:dd-新薪金单(非工资)-->mysql(鸿巢付款单)

在企业信息化建设中,数据的高效集成和管理是至关重要的一环。本文将聚焦于一个具体的系统对接集成案例,即如何将钉钉平台上的“新薪金单(非工资)”数据集成到MySQL数据库中的“鸿巢付款单”。通过这一案例,我们将探讨如何利用轻易云数据集成平台实现高效、可靠的数据传输和处理。

首先,我们需要解决的是如何从钉钉获取所需的数据。钉钉提供了丰富的API接口,其中v1.0/yida/processes/instances接口可以帮助我们定时可靠地抓取“新薪金单(非工资)”的数据。在实际操作中,我们必须考虑接口调用过程中的分页和限流问题,以确保数据获取的完整性和稳定性。

其次,在数据写入MySQL时,高吞吐量的数据写入能力是关键。轻易云平台支持批量数据快速写入到MySQL,通过execute API,可以有效提升数据处理的时效性。同时,针对不同业务需求,平台还支持自定义的数据转换逻辑,以适应特定的数据结构要求。

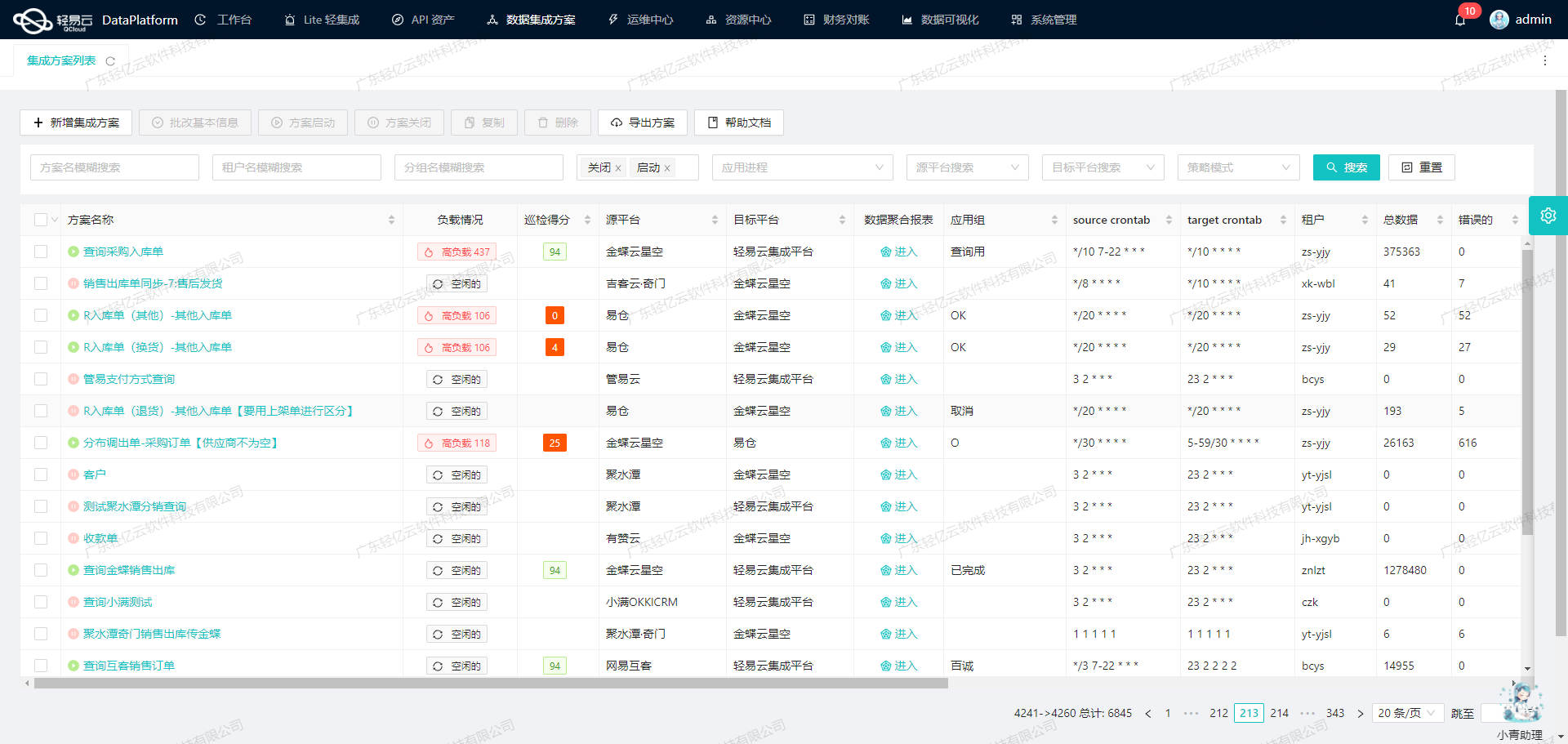

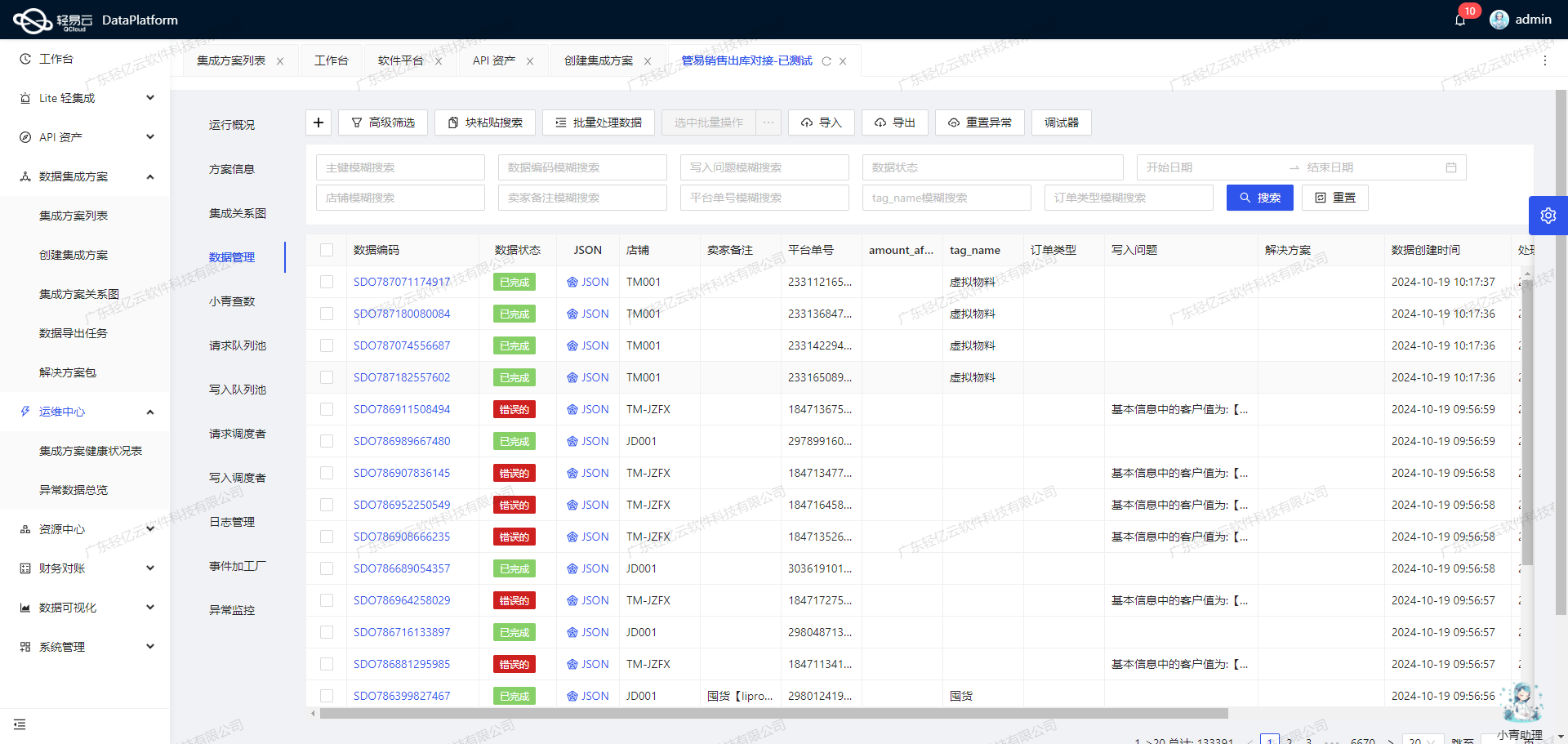

为了确保整个数据集成过程的透明度和可控性,轻易云提供了集中监控和告警系统。这一系统能够实时跟踪每个数据集成任务的状态和性能,并在出现异常时及时发出告警,从而保障了业务运行的连续性。此外,平台还具备强大的数据质量监控与异常检测功能,可以及时发现并处理潜在的数据问题。

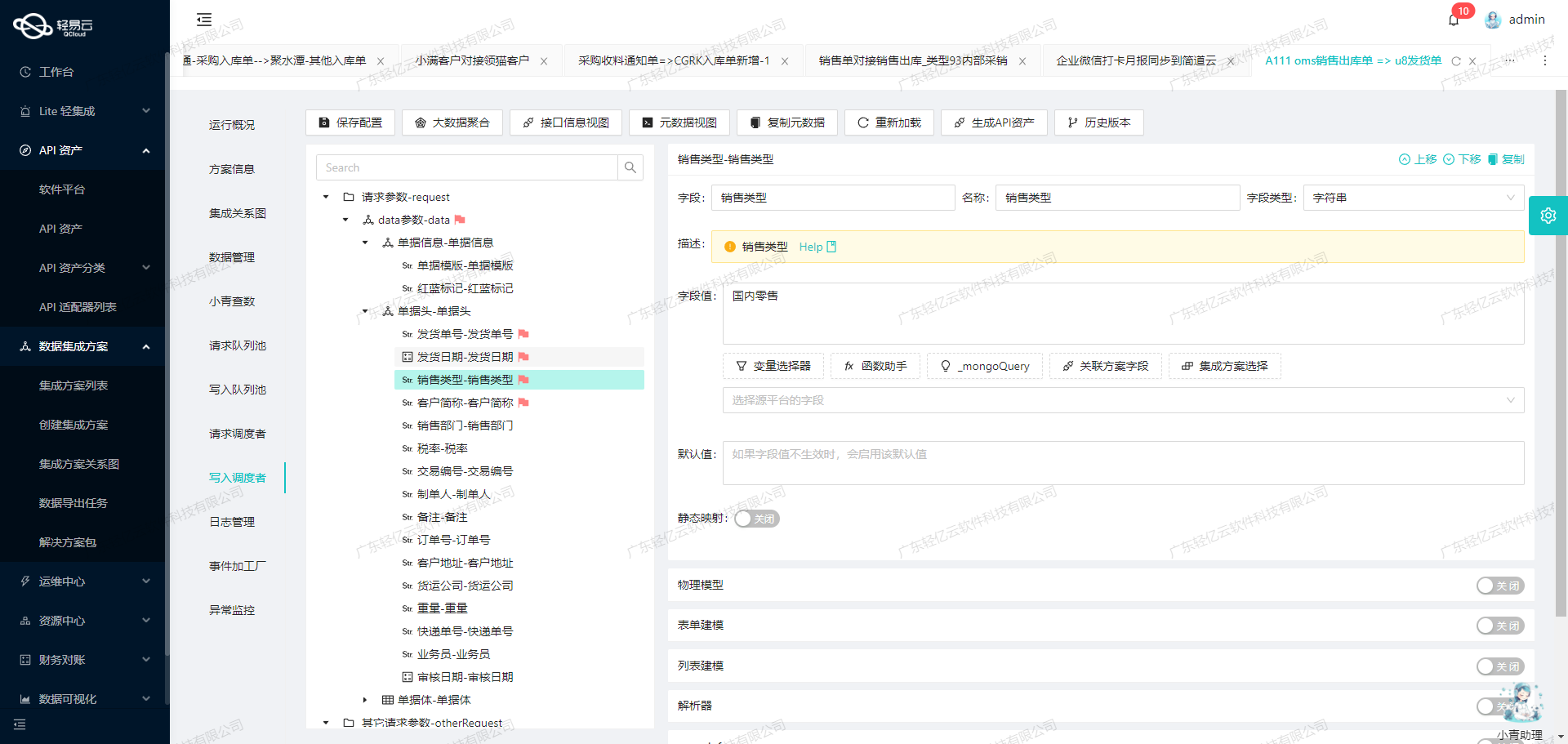

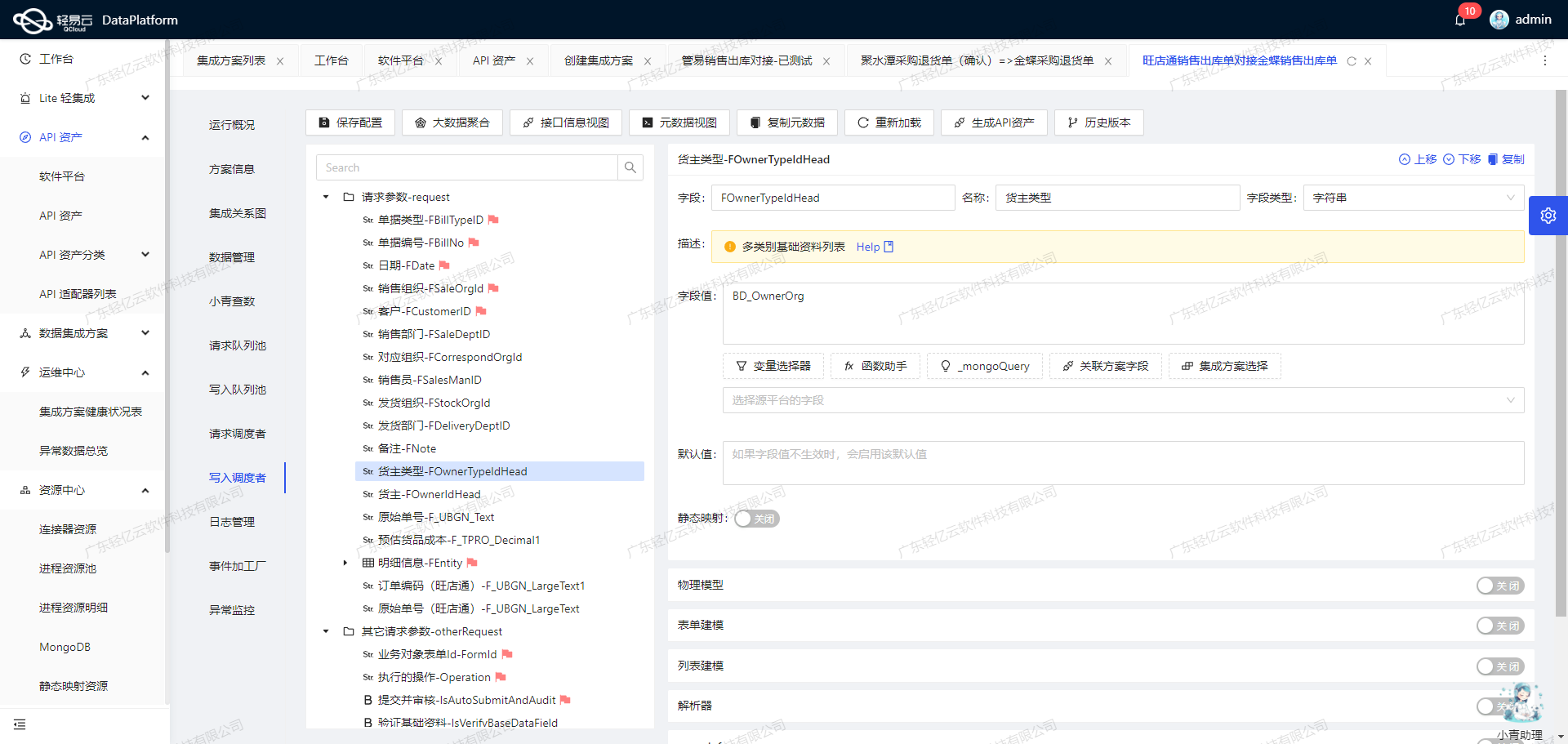

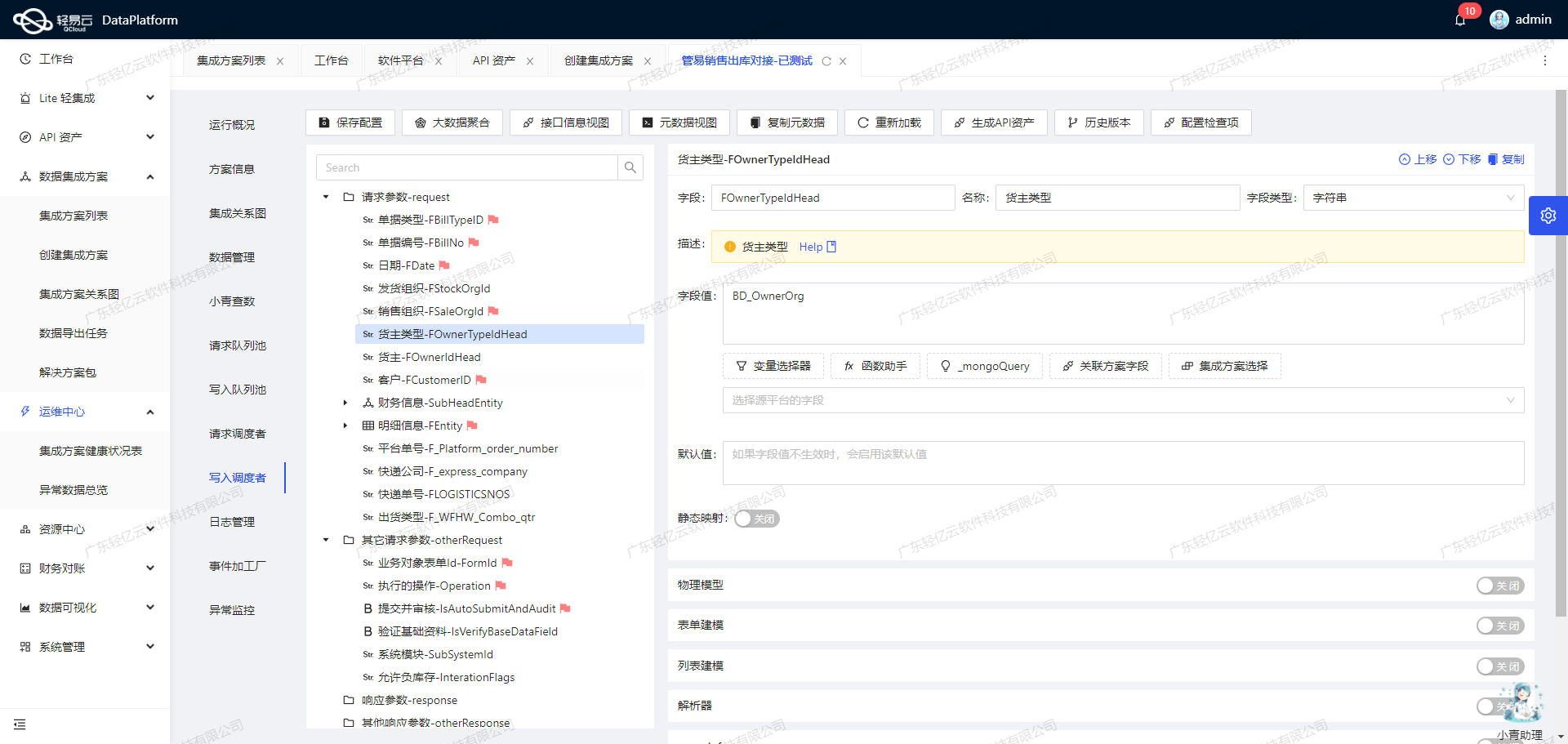

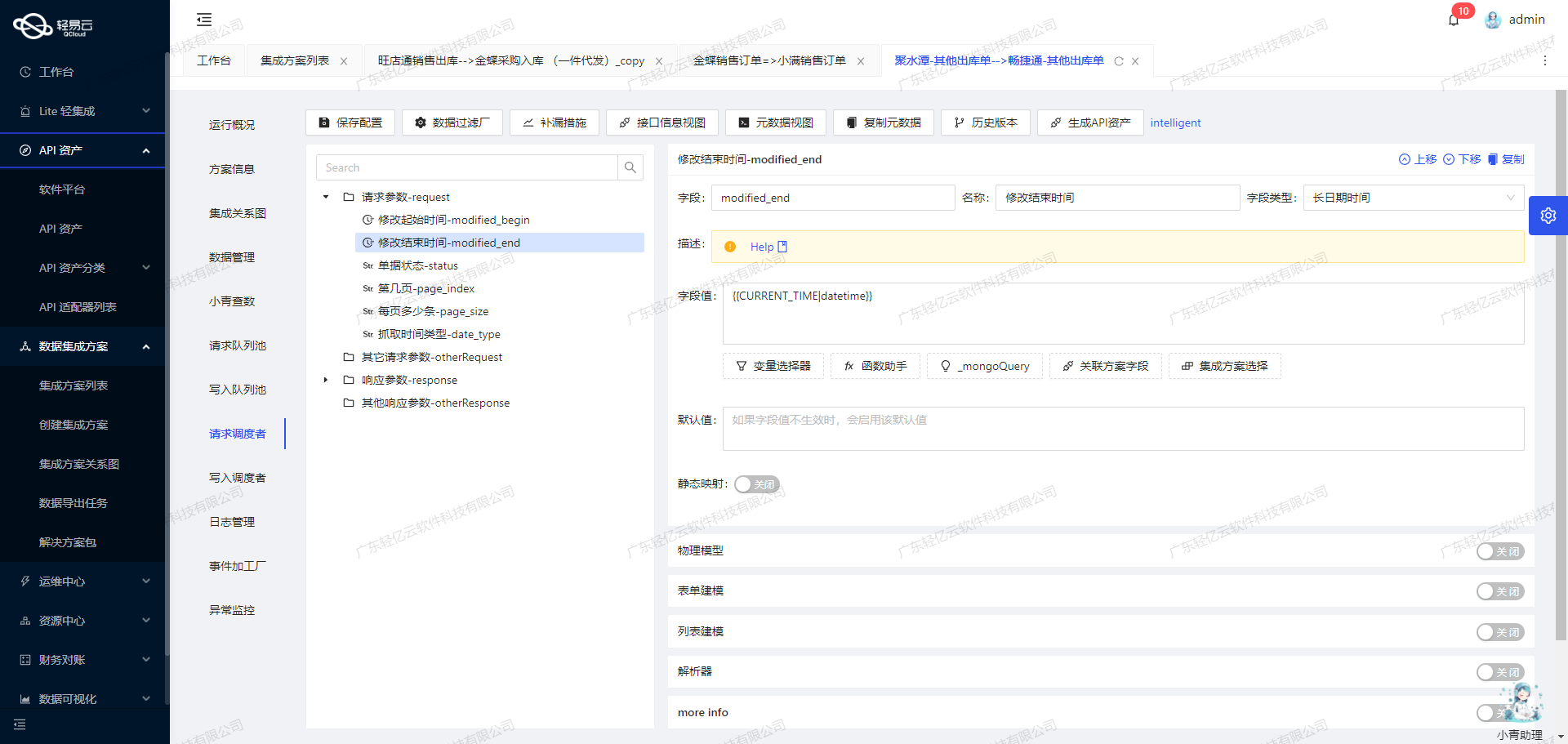

最后,为了实现资源的高效利用和优化配置,轻易云提供了统一视图和控制台来管理钉钉与MySQL之间的API资产。这不仅帮助企业全面掌握API资产的使用情况,还能通过可视化的数据流设计工具,使得整个数据集成过程更加直观、易于管理。

通过以上技术手段,我们可以确保从钉钉到MySQL的数据传输过程高效、可靠且透明,为企业的信息化建设提供坚实保障。在接下来的章节中,我们将详细介绍具体实施步骤及注意事项。

调用钉钉接口v1.0/yida/processes/instances获取并加工数据

在轻易云数据集成平台中,调用源系统钉钉接口v1.0/yida/processes/instances是数据集成生命周期的第一步。该步骤主要涉及从钉钉系统中获取原始数据,并对其进行初步加工处理,以便后续的数据转换和写入操作。

接口调用配置

首先,需要配置API请求参数以确保能够正确地从钉钉系统获取所需的数据。以下是关键的请求参数:

- pageNumber: 分页页码,用于控制数据分页。

- pageSize: 分页大小,定义每次请求返回的数据量。

- appType: 应用ID,用于标识具体的应用。

- systemToken: 应用秘钥,用于身份验证。

- userId: 用户的userid,用于指定用户范围。

- language: 语言设置,支持中文(zh_CN)和英文(en_US)。

- formUuid: 表单ID,用于指定要查询的表单类型。

- searchFieldJson: 查询条件,包括类型和发起人等字段。

这些参数通过POST方法传递给API接口,以实现对特定数据集的精确查询。

数据格式转换

在获取到原始数据后,需要对部分字段进行格式转换,以适应目标数据库MySQL的要求。例如:

"formatResponse": [

{"old": "dateField_lgn2qsju", "new": "datetime_new", "format": "date"},

{"old": "serialNumberField_lgovkejx", "new": "order_no_new", "format": "string"}

]上述配置将dateField_lgn2qsju字段转换为datetime_new,并将其格式化为日期类型;同时,将serialNumberField_lgovkejx字段转换为字符串类型的新字段order_no_new。

数据过滤与清洗

为了确保数据质量,还需要对原始数据进行过滤和清洗。例如,可以通过以下条件筛选出符合要求的数据:

"condition": [

[{"field":"selectField_lgn2qshb","logic":"in","value":"工资发放(临时),活动经费,福利申请,其他"}],

[{"field":"dateField_lgn2qsju","logic":"notnull"}]

]上述条件确保只处理特定类型且日期不为空的数据,从而提高了数据集成过程中的准确性和有效性。

异常处理与重试机制

在调用API接口时,可能会遇到网络波动、限流等问题。因此,需要设计健壮的异常处理与重试机制。例如,当请求失败时,可以记录错误日志并触发重试逻辑,以保证最终能够成功获取所需的数据。

实时监控与日志记录

为了实时跟踪数据集成任务的状态和性能,可以利用轻易云平台提供的集中监控和告警系统。通过实时监控,可以及时发现并解决潜在的问题,提高整体效率。此外,通过详细的日志记录,可以追溯每个操作步骤,为故障排查提供依据。

总结

通过合理配置API请求参数、执行必要的数据格式转换、实施严格的数据过滤与清洗,以及设计健壮的异常处理机制,我们可以高效地从钉钉系统中获取并加工处理所需的数据。这一步骤不仅是整个数据集成生命周期的重要组成部分,也是确保后续数据转换与写入操作顺利进行的重要前提。

数据集成生命周期第二步:ETL转换与写入MySQLAPI接口

在数据集成的生命周期中,ETL(抽取、转换、加载)过程至关重要。本文将深入探讨如何将钉钉系统中的新薪金单(非工资)数据进行ETL转换,最终写入目标平台MySQL。具体操作包括数据请求与清洗、数据转换与写入等。

数据请求与清洗

首先,我们需要从钉钉系统中获取所需的数据。通过调用钉钉接口v1.0/yida/processes/instances,我们可以定时可靠地抓取薪金单数据。为了确保数据不漏单,需要处理分页和限流问题,并结合实时监控与日志记录功能,确保每次请求的数据完整性和准确性。

数据转换

在获取到原始数据后,下一步就是对这些数据进行转换,以符合MySQLAPI接口的要求。以下是一个典型的元数据配置示例:

{

"api": "execute",

"effect": "EXECUTE",

"method": "POST",

"idCheck": true,

"request": [

{

"field": "main_params",

"label": "main_params",

"type": "object",

"describe": "111",

"children": [

{"field": "extend_processInstanceId", "label": "明细id", "type": "string", "value":"{{extend.processInstanceId}}"},

{"field": "order_no_new", "label": "单号", "type": "string", "value":"{order_no_new}(FKD)"},

{"field": "datetime_new", "label": "时间", "type": "date", "value":"{datetime_new}"},

{"field": "qty_count", "label":"数量","type":"string","value":"1"},

{"field":"sales_count","label":"金额","type":"string","value":"{numberField_lgn2qsi6}"},

{"field":"status","label":"状态","type":"string"},

{"field":"Document_Type","label":"单据类型","type":"string","value":"付款单"}

]

}

],

...

}在这个配置中,我们定义了需要从钉钉系统中提取的字段以及它们在目标MySQL表中的映射关系。例如,将extend.processInstanceId映射为extend_processInstanceId,并将其值填充到相应的字段中。

数据写入

完成数据转换后,需要将处理后的数据写入目标平台MySQL。这一步通过执行预定义的SQL语句来实现:

INSERT INTO `hc_dd_fkd`

(`extend_processInstanceId`, `order_no_new`, `datetime_new`, `qty_count`, `sales_count`, `status`, `Document_Type`)

VALUES (:extend_processInstanceId, :order_no_new, :datetime_new, :qty_count, :sales_count, :status, :Document_Type)在执行插入操作时,需特别注意以下几点:

- 高吞吐量:确保大量数据能够快速写入MySQL,提高处理时效性。

- 异常处理与错误重试机制:在写入过程中,如果出现异常,需要有相应的错误重试机制来保证数据最终一致性。

- 自定义数据映射:根据业务需求,可以对特定字段进行定制化映射,以适应不同的数据结构。

实现技术要点

- 实时监控与日志记录:通过集中的监控和告警系统,实时跟踪数据集成任务的状态和性能,及时发现并处理异常情况。

- 分页和限流处理:在调用钉钉接口时,通过合理设置分页参数和限流策略,确保不会因请求过多而导致接口响应超时或失败。

- 批量操作:对于大批量的数据,可以使用批量插入操作,提高效率并减少数据库连接次数。

通过以上步骤,我们实现了从钉钉系统到MySQL的无缝数据集成。在这个过程中,不仅提高了业务透明度和效率,还确保了数据的完整性和准确性,为企业提供了可靠的数据支持。