吉客云数据集成到金蝶云星空:其他出库对接204v2

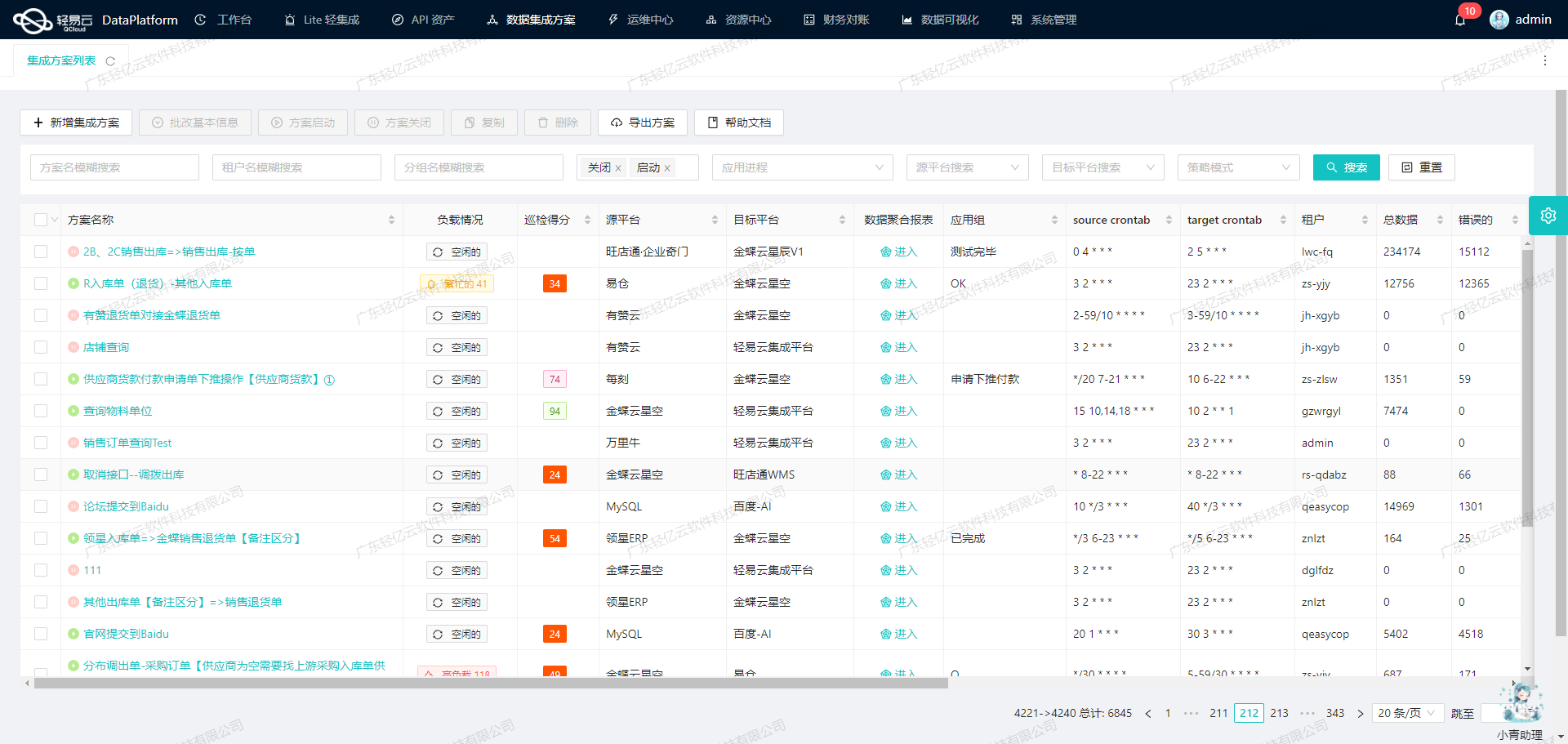

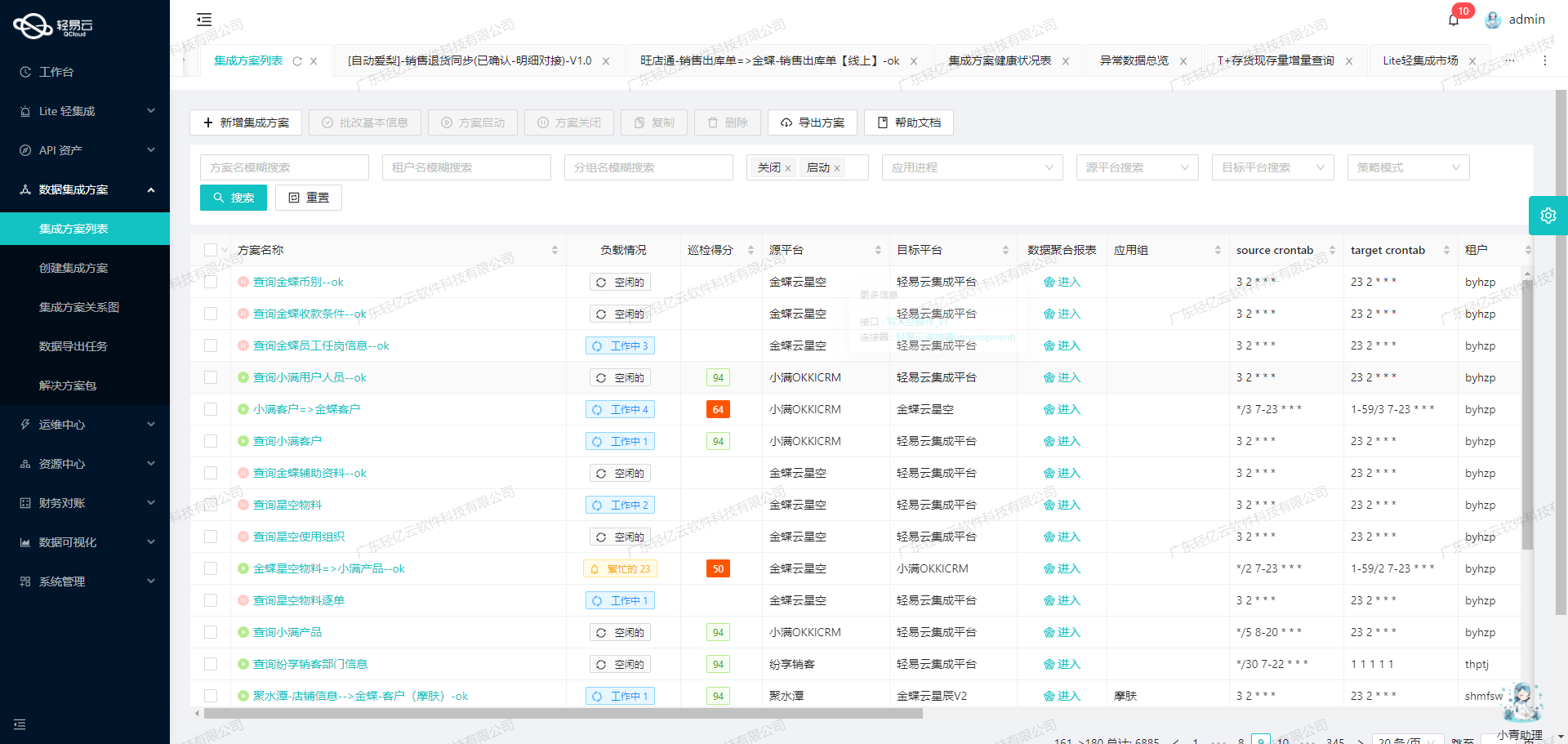

在企业信息化系统中,数据的高效流转和准确对接是业务运作的关键。本文将分享一个实际案例,展示如何通过轻易云数据集成平台,将吉客云的数据无缝对接到金蝶云星空,实现“其他出库对接204v2”方案。

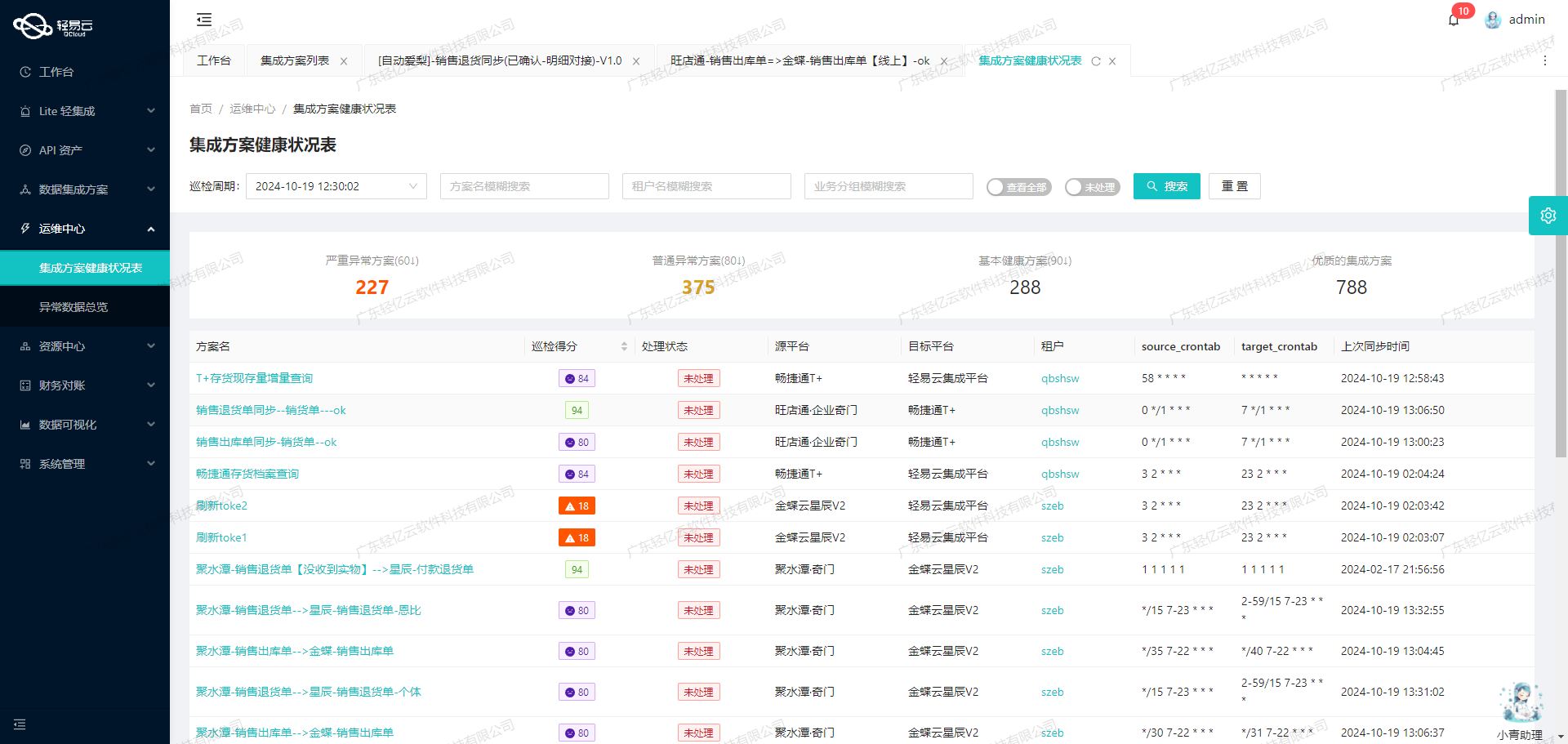

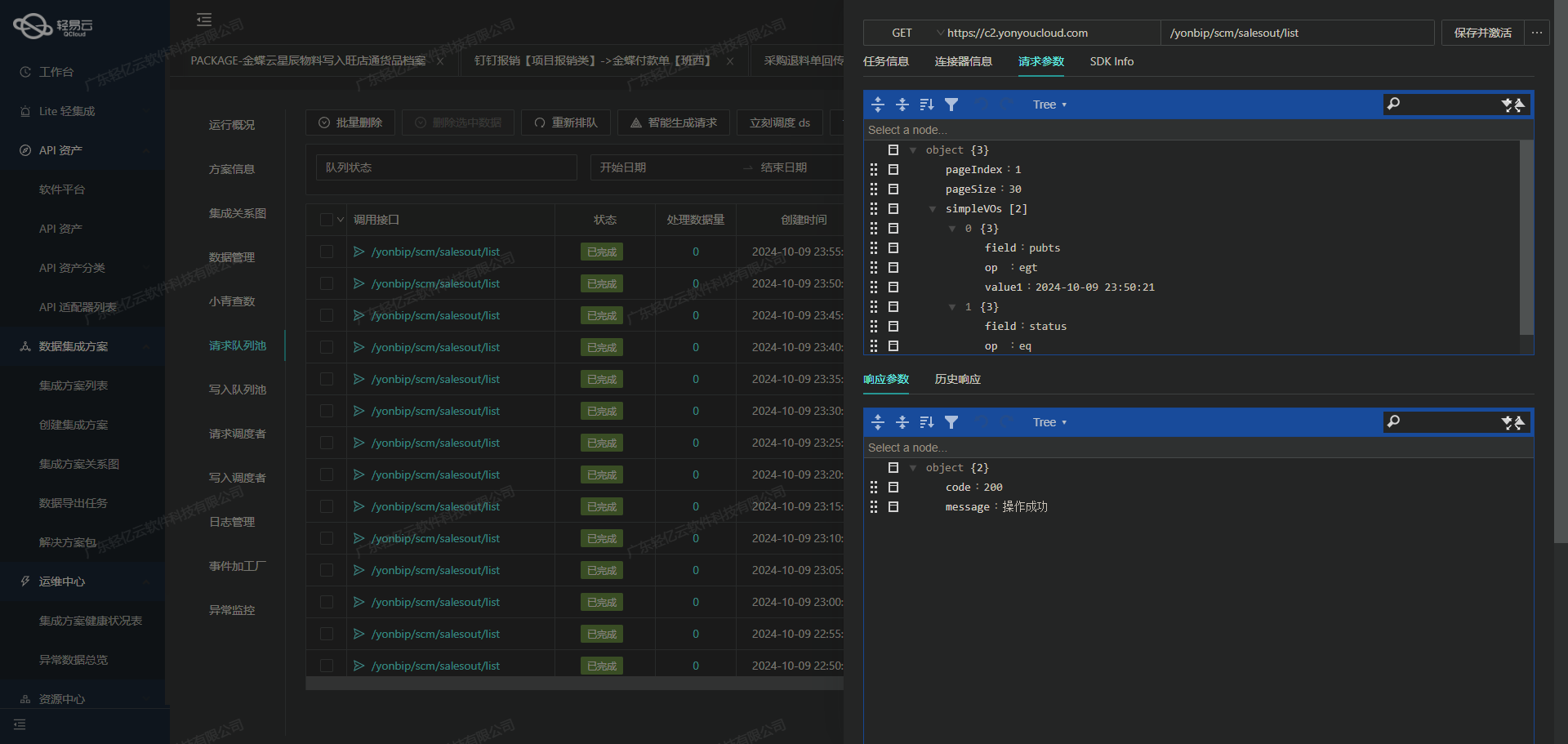

为了确保数据集成过程的高效性和可靠性,我们利用了轻易云平台的一系列特性。首先,通过支持高吞吐量的数据写入能力,使得大量出库数据能够快速被集成到吉客云系统中,大大提升了数据处理的时效性。此外,平台提供的集中监控和告警系统,实时跟踪每个数据集成任务的状态和性能,确保在任何异常发生时能够及时响应。

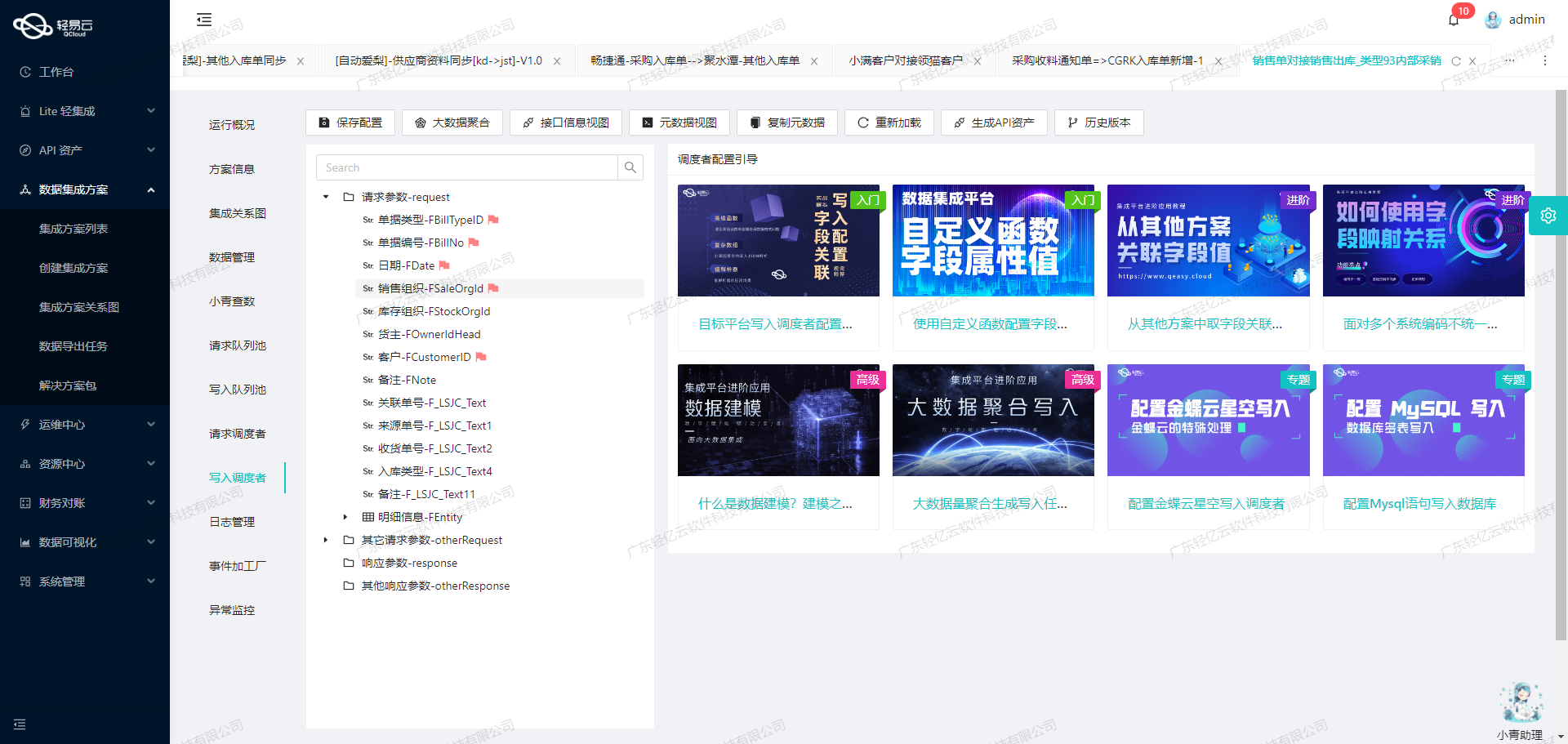

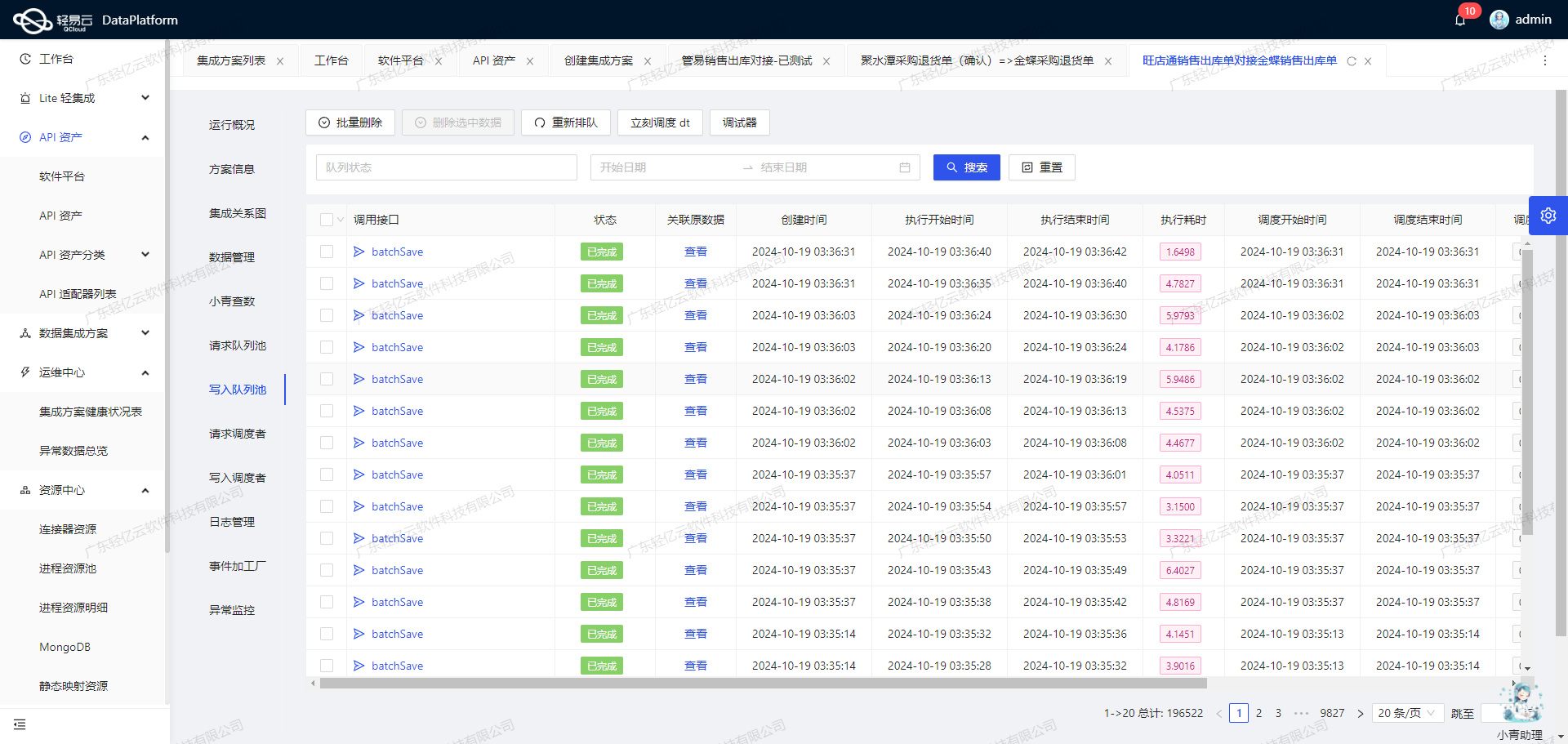

在具体实施过程中,我们调用了吉客云接口erp.storage.goodsdocout.v2来获取出库数据,并使用金蝶云星空的batchSave API进行批量写入。在此过程中,需要特别注意处理分页和限流问题,以保证接口调用的稳定性。同时,为了适应两者之间的数据格式差异,我们自定义了数据转换逻辑,并通过可视化的数据流设计工具,使整个集成过程更加直观和易于管理。

此外,为确保集成过程中的数据质量,我们还引入了实时监控与日志记录机制,对每一条传输的数据进行质量监控和异常检测。一旦发现问题,可以立即进行处理,从而避免漏单现象发生。

通过这些技术手段,不仅实现了吉客云与金蝶云星空之间的数据无缝对接,还极大地提升了业务流程的透明度和效率。后续章节将详细介绍具体实施步骤及技术细节。

调用吉客云接口erp.storage.goodsdocout.v2获取并加工数据

在轻易云数据集成平台的生命周期中,调用源系统接口是关键的第一步。本文将深入探讨如何通过调用吉客云接口erp.storage.goodsdocout.v2来获取并加工数据,以实现高效的数据集成。

接口配置与请求参数

为了成功调用erp.storage.goodsdocout.v2接口,我们需要配置一系列请求参数。这些参数不仅包括分页信息,还涵盖了出库单号、修改时间范围、创建时间范围等关键字段。

{

"api": "erp.storage.goodsdocout.v2",

"method": "POST",

"number": "goodsdocNo",

"id": "recId",

"pagination": {

"pageSize": 50

},

"idCheck": true,

...

}其中,分页页码和分页页数是必需的参数,用于控制每次请求返回的数据量。默认情况下,每页返回50条记录:

{

"field": "pageIndex",

"label": "分页页码",

...

},

{

"field": "pageSize",

"label": "分页页数",

...

}此外,为了确保数据的时效性和完整性,我们还需要设置修改时间和创建时间的起始和结束时间:

{

"field": "gmtModifiedStart",

...

},

{

"field": "gmtModifiedEnd",

...

},

{

"field": "startDate",

...

},

{

"field": "endDate",

...

}这些字段可以通过函数动态生成,例如使用from_unixtime(({LAST_SYNC_TIME}-86400),'%Y-%m-%d %H:%i:%s')来计算前一天的开始时间。

数据清洗与转换

在获取到原始数据后,下一步是对其进行清洗和转换。轻易云平台提供了强大的自定义数据转换逻辑功能,可以根据业务需求对数据进行处理。例如,将不同格式的数据统一为标准格式,或者根据特定规则过滤无效数据。

对于出库类型为204(其他出库)的记录,我们可以通过以下配置来筛选:

{

...

{

field: 'inouttype',

value: '204'

}

...

}这确保了我们只处理符合特定业务需求的数据,从而提高了数据处理效率。

分页与限流处理

由于API接口通常会有访问频率限制,因此在大批量数据请求时,需要特别注意分页和限流问题。轻易云平台支持自动分页机制,通过设置合理的分页大小(如每页50条记录),可以有效避免因单次请求量过大导致的超时或失败。同时,结合限流策略,可以确保在高并发环境下稳定运行。

实时监控与日志记录

为了保证整个数据集成过程的透明度和可追溯性,实时监控与日志记录至关重要。轻易云平台提供了集中式监控系统,可以实时跟踪每个任务的状态和性能,并及时发现异常情况。例如,当某个请求失败时,可以通过日志快速定位问题原因,并采取相应措施进行重试或修复。

异常处理与错误重试机制

在实际操作中,不可避免地会遇到各种异常情况,如网络波动、接口响应超时等。为此,需要设计健壮的异常处理机制。当出现错误时,通过捕获异常并记录详细日志,可以帮助快速诊断问题。此外,还可以设置自动重试机制,在一定次数内尝试重新发送请求,以提高任务成功率。

综上所述,通过合理配置吉客云接口erp.storage.goodsdocout.v2,结合轻易云平台强大的数据清洗、转换、监控及异常处理功能,可以实现高效、可靠的数据集成。这不仅提升了业务透明度,也极大地优化了整体运营效率。

数据集成到金蝶云星空API接口的ETL转换及写入

在进行数据集成过程中,第二步是将已经集成的源平台数据进行ETL(提取、转换、加载)转换,转为目标平台金蝶云星空API接口所能够接收的格式,并最终写入目标平台。本文将详细解析这一过程中的关键技术点和实现细节。

接口配置与元数据解析

在轻易云数据集成平台中,配置API接口是至关重要的一环。通过元数据配置,可以定义如何将源数据映射到目标平台所需的数据格式。以下是一个典型的元数据配置示例:

{

"api": "batchSave",

"method": "POST",

"idCheck": true,

"operation": {

"rowsKey": "array",

"rows": 10,

"method": "batchArraySave"

},

"request": [

{"field":"FBillNo","label":"单据编号","type":"string","value":"{goodsdocNo}"},

{"field":"FBillTypeID","label":"单据类型","type":"string","value":"QTCKD01_SYS"},

{"field":"FStockOrgId","label":"库存组织","type":"string","value":"{companyCode}"},

//...更多字段映射

],

"otherRequest": [

{"field":"FormId","label":"业务对象表单Id","type":"string","value":"STK_MisDelivery"},

{"field":"IsAutoSubmitAndAudit","label":"提交并审核","type":"bool","value":"false"}

]

}上述配置定义了如何将源平台的数据字段映射到金蝶云星空API所需的字段格式。通过这种方式,可以确保数据在传输过程中保持一致性和完整性。

数据转换逻辑

为了适应特定业务需求和数据结构,通常需要自定义数据转换逻辑。例如,将日期格式从源平台的格式转换为目标平台所需的格式:

{"field":"FDate","label":"日期","type":"string","value":"_function DATE_FORMAT('{inOutDate}', '%Y-%m-%d')"}通过这种方式,可以确保日期字段在传输过程中符合目标平台的要求。此外,对于一些复杂的数据结构,如多层级数组或嵌套对象,也可以通过自定义解析器(如ConvertObjectParser)进行转换。

高效批量处理与分页

在处理大量数据时,高效的批量处理和分页机制至关重要。轻易云平台支持高吞吐量的数据写入能力,使得大量数据能够快速被集成到金蝶云星空系统中。例如,可以使用batchArraySave方法一次性提交多个记录,提高处理效率:

{

"operation": {

"rowsKey": "array",

"rows": 10,

"method": "batchArraySave"

}

}对于分页处理,可以根据具体情况设置每页的数据量,并通过循环机制逐页提交,确保所有数据都能成功传输。

异常处理与重试机制

在实际操作中,可能会遇到各种异常情况,如网络故障、接口限流等。因此,设计一个健壮的异常处理和重试机制非常重要。例如,当出现网络故障时,可以自动进行重试,直到成功为止。此外,还可以设置告警系统,实时监控数据传输状态,并在出现异常时及时通知相关人员。

数据质量监控与日志记录

为了确保数据传输过程中的准确性和完整性,需要对数据质量进行监控,并记录详细的日志信息。轻易云平台提供了全面的数据质量监控功能,可以及时发现并处理数据问题。此外,通过日志记录,可以追踪每一步操作的详细信息,为后续排查问题提供依据。

金蝶云星空定制化映射

对于特定业务场景,可能需要对金蝶云星空API进行定制化映射。例如,将某些特定字段映射到目标系统中的自定义字段:

{"field":"F_LSJC_Text1","label":"来源单号","type":"string","value":"{sourceBillNo}"}通过这种方式,可以灵活地适应不同业务需求,实现更精细化的数据管理。

综上所述,通过合理配置元数据、自定义转换逻辑、高效批量处理、健壮的异常处理机制以及全面的数据质量监控,可以有效实现源平台到金蝶云星空API接口的数据ETL转换和写入过程。这不仅提高了数据传输效率,还确保了数据的一致性和完整性。