案例分享:聚水潭·奇门数据集成到MySQL

在本案例中,我们将探讨如何通过轻易云数据集成平台,将聚水潭·奇门的销售订单数据高效地集成到MySQL数据库。具体方案被命名为“聚水潭-销售订单-->BI崛起-销售订单表_原始查询”,旨在实现数据快速、批量写入,确保业务系统的数据更新及时且不漏单。

首先,通过调用聚水潭·奇门API接口jushuitan.order.list.query,定时抓取最新的销售订单信息。这一过程中,需特别注意处理分页和限流问题,以防止API请求超过限制而导致数据遗漏或拉取失败。同时,通过自定义的数据转换逻辑,将获取的数据适配为与MySQL目标表结构一致的格式,并通过MySQL API batchexecute进行批量写入,大幅提升了数据处理效率。

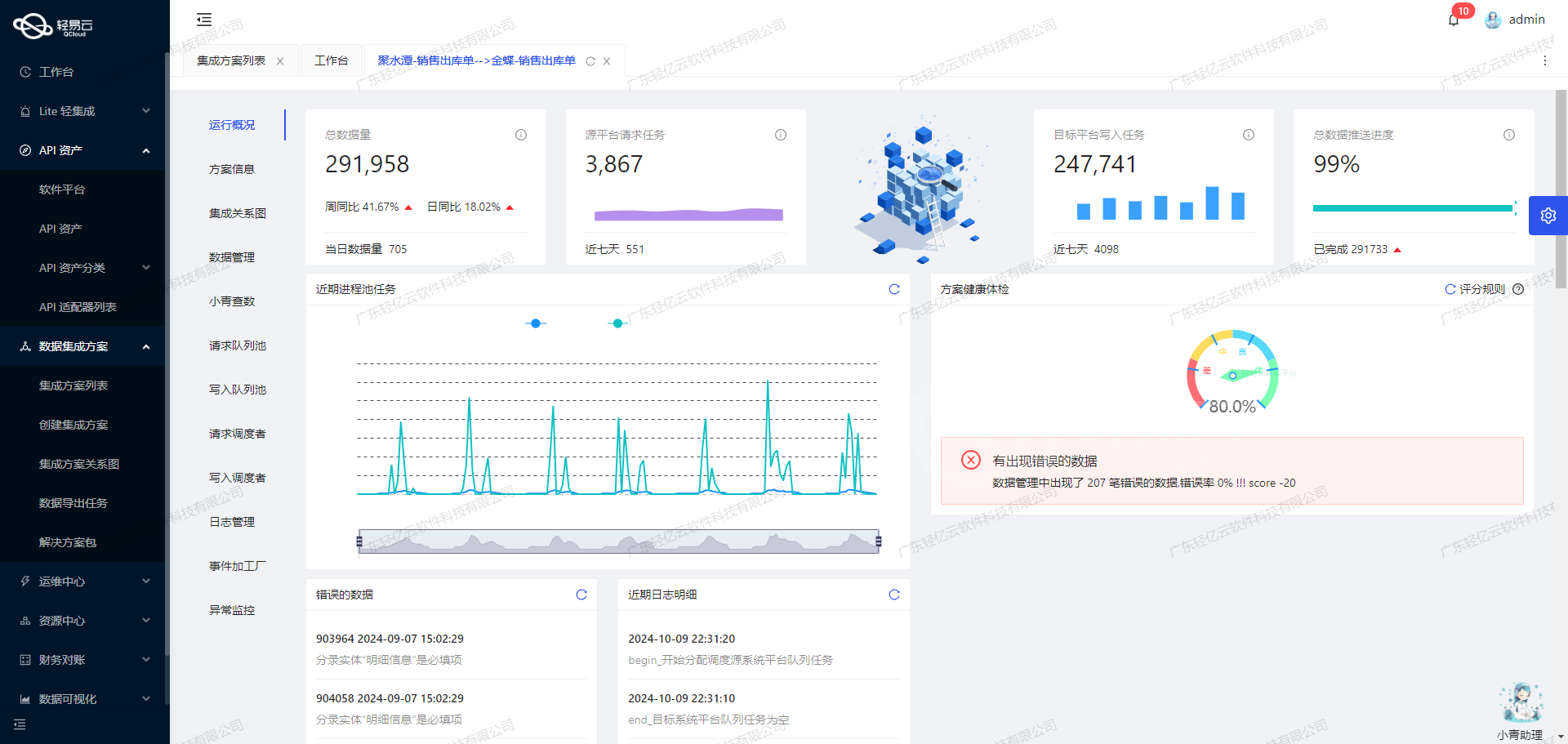

为了保证整个过程的稳定性和可靠性,我们使用了集中监控和告警系统,对每一个任务节点进行实时跟踪。一旦发现异常情况,例如网络波动或者接口响应延迟,则立刻触发重试机制,同时记录详细日志用于后续分析。此外,还引入了异常检测机制,在第一时间识别并修正可能存在的数据质量问题。

接下来,让我们深入了解这一技术方案的具体实施细节。

调用聚水潭·奇门接口jushuitan.order.list.query获取并加工数据

在数据集成的生命周期中,调用源系统接口是至关重要的一步。本文将详细探讨如何通过轻易云数据集成平台调用聚水潭·奇门接口jushuitan.order.list.query来获取销售订单数据,并进行初步加工。

接口配置与请求参数

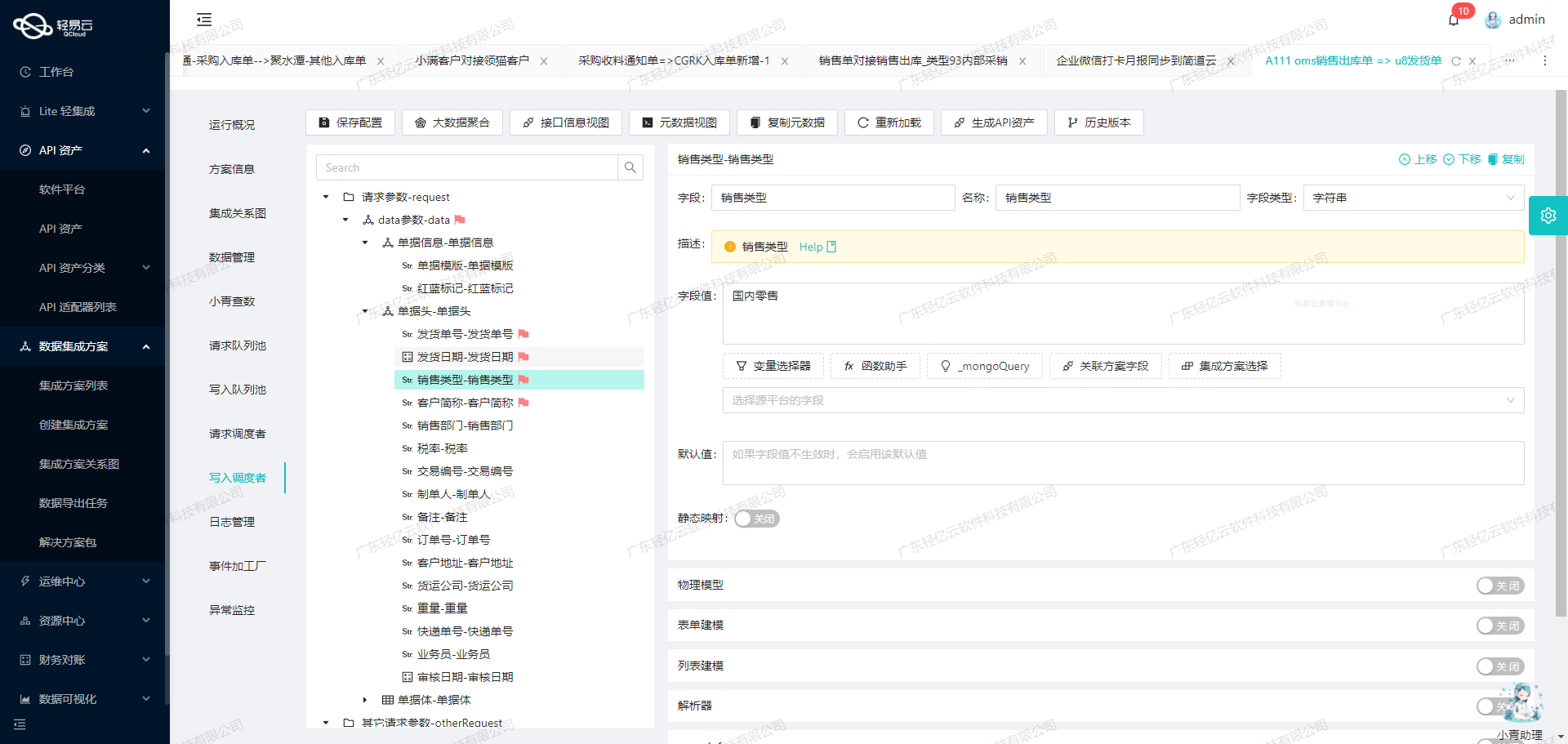

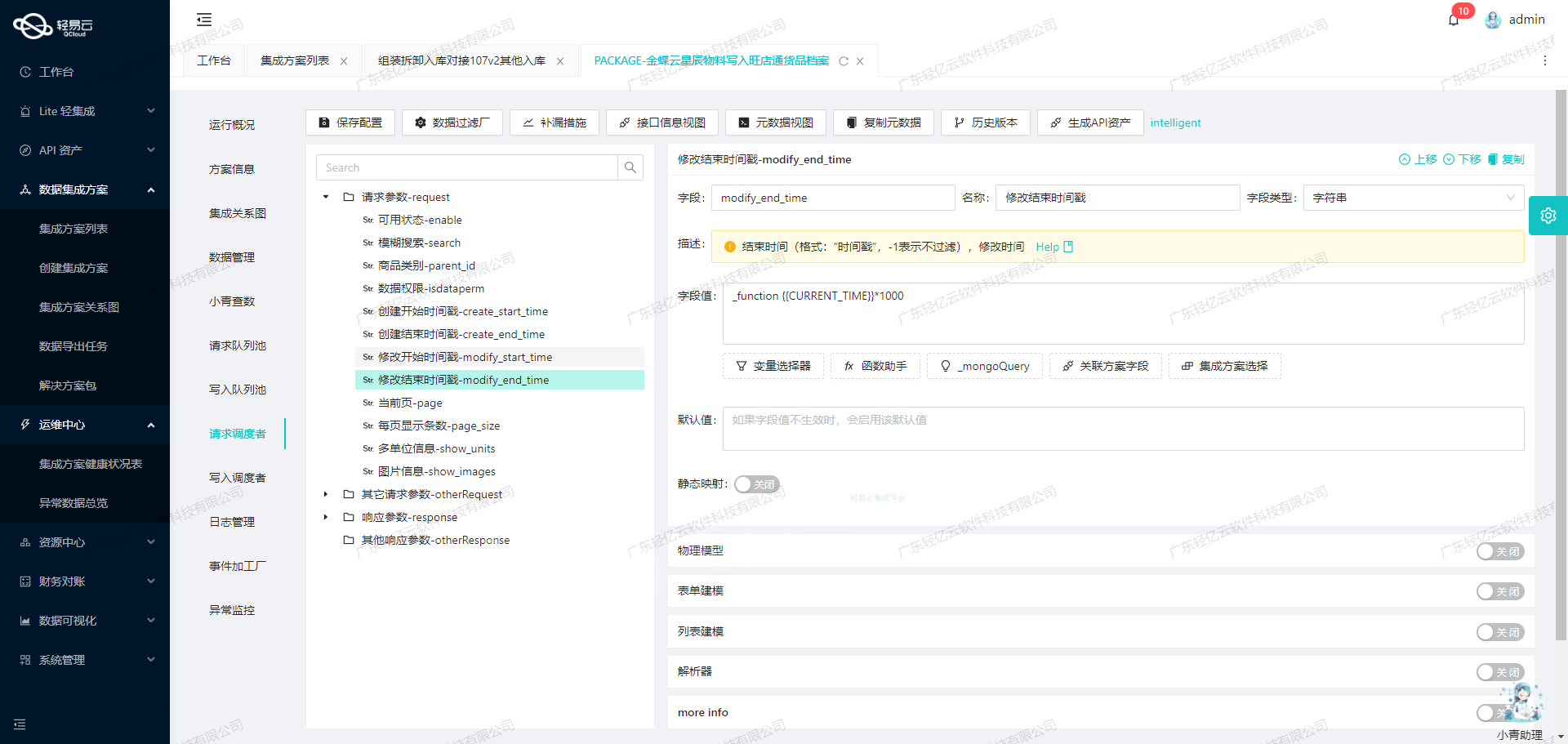

轻易云数据集成平台提供了全透明可视化的操作界面,使得配置API接口变得简单直观。以下是针对jushuitan.order.list.query接口的具体配置:

{

"api": "jushuitan.order.list.query",

"effect": "QUERY",

"method": "POST",

"number": "o_id",

"id": "o_id",

"name": "io_id",

"request": [

{

"field": "page_index",

"label": "页数",

"type": "string",

"describe": "第几页,从第一页开始,默认1",

"value": "1"

},

{

"field": "page_size",

"label": "每页行数",

"type": "string",

"describe": "每页多少条,默认25,最大25",

"value": "100"

},

{

"field": "start_time",

"label": "修改开始时间",

"type": "string",

"describe": "修改起始时间,和结束时间必须同时存在,时间间隔不能超过七天,与线上单号不能同时为空",

"value": "{{LAST_SYNC_TIME|datetime}}"

},

{

"field": "end_time",

"label": "修改结束时间",

"type": "string",

"describe": "(同上)",

...请求参数说明

page_index: 页数,从第一页开始,默认值为1。page_size: 每页行数,默认25条,最大值为100条。start_time和end_time: 修改起始和结束时间,这两个参数必须同时存在且时间间隔不能超过七天。status: 单据状态,可以是待出库、已出库或作废。date_type: 时间类型,默认为0,即按修改时间筛选。

这些参数确保了我们可以灵活地控制查询范围和返回的数据量。

数据清洗与转换

在获取到原始数据后,我们需要对其进行清洗和转换,以便后续的数据处理和分析。以下是一些常见的数据清洗操作:

- 字段映射:将API返回的数据字段映射到目标系统所需的字段。例如,将

o_id映射到目标系统中的订单ID字段。 - 数据过滤:根据业务需求过滤掉不需要的数据。例如,通过条件过滤掉标签包含“线上发货”或“虚拟发货”的订单。

- 格式转换:将日期格式从字符串转换为标准的日期格式,以便于后续处理。

异常处理与重试机制

为了确保数据获取过程的稳定性,我们需要考虑异常处理和重试机制。轻易云平台提供了内置的异常处理功能,例如:

{

...

“omissionRemedy”: {

“crontab”: “2 2 * * *”,

“takeOverRequest”: [

{

“field”: “start_time”,

“value”: “{{DAYS_AGO_1|datetime}}”,

...

}

]

}

}通过设置定时任务(如每天凌晨2点执行),可以自动补偿前一天漏掉的数据请求。

实时监控与日志记录

实时监控和日志记录是确保数据集成过程透明化的重要手段。轻易云平台提供了详细的日志记录功能,可以实时监控每个API请求的状态和返回结果。这有助于快速定位问题并进行修复。

综上所述,通过合理配置聚水潭·奇门接口jushuitan.order.list.query并结合轻易云平台的强大功能,我们可以高效地获取并加工销售订单数据,为后续的数据分析和业务决策提供坚实基础。

轻易云数据集成平台生命周期第二步:ETL转换与数据写入MySQL API接口

在数据集成过程中,ETL(Extract, Transform, Load)是关键的一环。本文将深入探讨如何利用轻易云数据集成平台,将已经集成的源平台数据进行ETL转换,最终写入目标平台MySQL API接口。

数据请求与清洗

在数据集成的第一阶段,我们已经从源平台(如聚水潭)获取了销售订单数据。这些原始数据可能包含多种格式和结构,需要进行清洗和标准化处理,以确保后续步骤的顺利进行。

数据转换

接下来,我们需要将清洗后的数据进行转换,使其符合目标平台MySQL API接口所要求的格式。以下是元数据配置示例,展示了如何将源平台的数据字段映射到目标平台字段:

{

"api": "batchexecute",

"effect": "EXECUTE",

"method": "SQL",

"number": "id",

"id": "id",

"name": "id",

"idCheck": true,

"request": [

{"field":"id","label":"主键","type":"string","value":"{o_id}-{items_oi_id}"},

{"field":"order_date","label":"下单时间","type":"string","value":"{order_date}"},

{"field":"shop_status","label":"线上订单状态","type":"string","value":"{shop_status}"},

{"field":"question_type","label":"异常类型","type":"string","value":"{question_type}"},

{"field":"shop_id","label":"店铺编号","type":"string","value":"{shop_id}"},

// ...省略其他字段

{"field":"items_qyy_amountafter","label":"轻易云分摊后金额","type":"string","value":"{items_qyy_amountafter}"}

],

"otherRequest": [

{

"field": "main_sql",

"label": "主语句",

"type": "string",

"describe": "SQL首次执行的语句,将会返回:lastInsertId",

"value":

`REPLACE INTO order_list_query(

id, order_date, shop_status, question_type, shop_id, question_desc, so_id, status,

receiver_state, receiver_city, receiver_district, send_date, plan_delivery_date,

creator_name, buyer_tax_no, invoice_type, pay_amount, freight, buyer_message,

remark, invoice_title, is_cod, type, paid_amount, pay_date, modified,

order_from, l_id, shop_name, wms_co_id, logistics_company,

free_amount, co_id, drp_co_id_to,end_time,

referrer_id ,invoice_data ,drp_info ,shop_buyer_id ,seller_flag ,

invoice_amount ,oaid ,open_id ,node ,referrer_name ,

shop_site ,drp_co_id_from ,un_lid ,receiver_zip ,

receiver_email ,f_freight ,created ,

receiver_country ,skus ,shipment ,

weight ,sign_time,f_weight,is_split,is_merge,o_id,

items_batch_id ,

items_produced_date ,

items_referrer_id ,

items_item_ext_data ,

items_src_combine_sku_id ,

items_sku_type ,

items_item_pay_amount ,

items_remark ,

items_price ,

items_outer_oi_id ,

items_is_gift ,

items_refund_status ,

items_refund_id ,

items_item_status ,

items_i_id ,

items_shop_i_id ,

items_raw_so_id ,

items_is_presale ,

items_oi_id,

items_properties_value,

items_amount,

items_base_price,

items_qty,

items_name,

items_sku_id,

items_shop_sku_id,

items_buyer_paid_amount,

items_seller_income_amount,

labels,currency,lс_іd,tѕ,mеrgе_ѕо_іd,lіnk_о_іd,sеllеr_іnсоmе_аmоunt,buyеr_pаіd_amоunt,itеms_qyy_amоuntаftеr) VALUES`

},

{

"field": "limit",

"label": "limit",

"type": "string",

"value": "1000"

}

]

}数据写入

在完成数据转换后,我们需要将这些数据写入目标平台MySQL。通过配置batchexecute API,我们可以批量执行SQL语句,将转换后的数据插入到目标表中。

以下是一个典型的SQL插入语句模板:

REPLACE INTO order_list_query(

id, order_date, shop_status, question_type, shop_id,...)

VALUES (?, ?, ?, ?, ?,...);每个字段都对应于元数据配置中的一个request项。例如,id字段由源平台的o_id和items_oi_id拼接而成,而order_date直接映射为源平台的同名字段。

特殊处理逻辑

在某些情况下,我们需要对某些字段进行特殊处理。例如:

items_item_ext_data: 使用LEFT函数截取前20个字符。items_item_pay_amount: 使用CASE WHEN判断条件来处理特定情况。

这些逻辑可以通过在元数据配置中定义相应的函数来实现:

{"field":"items_item_ext_data","label":"商品明细拓展字段","type":"string","value":"_function LEFT( '{items_item_ext_data}' , 20)"},

{"field":"items_item_pay_amount","label":"商品应付金额","type":"string","value":"_function case when '{items_amount}'='0.0' then '0.0' else '{items_item_pay_amount}' end"}批量执行与性能优化

为了提高性能,我们可以设置批量执行的限制参数,例如每次批量处理1000条记录:

{"field": "limit", "label": "limit", "type": "string", "value": "1000"}通过这种方式,可以有效减少数据库连接次数,提高整体处理效率。

综上所述,通过精细化配置元数据和灵活运用ETL技术,可以高效地将源平台的数据转换并写入到目标平台MySQL,为业务提供可靠的数据支持。