钉钉数据集成到MySQL技术案例分享:user-钉钉获取通信录-修改

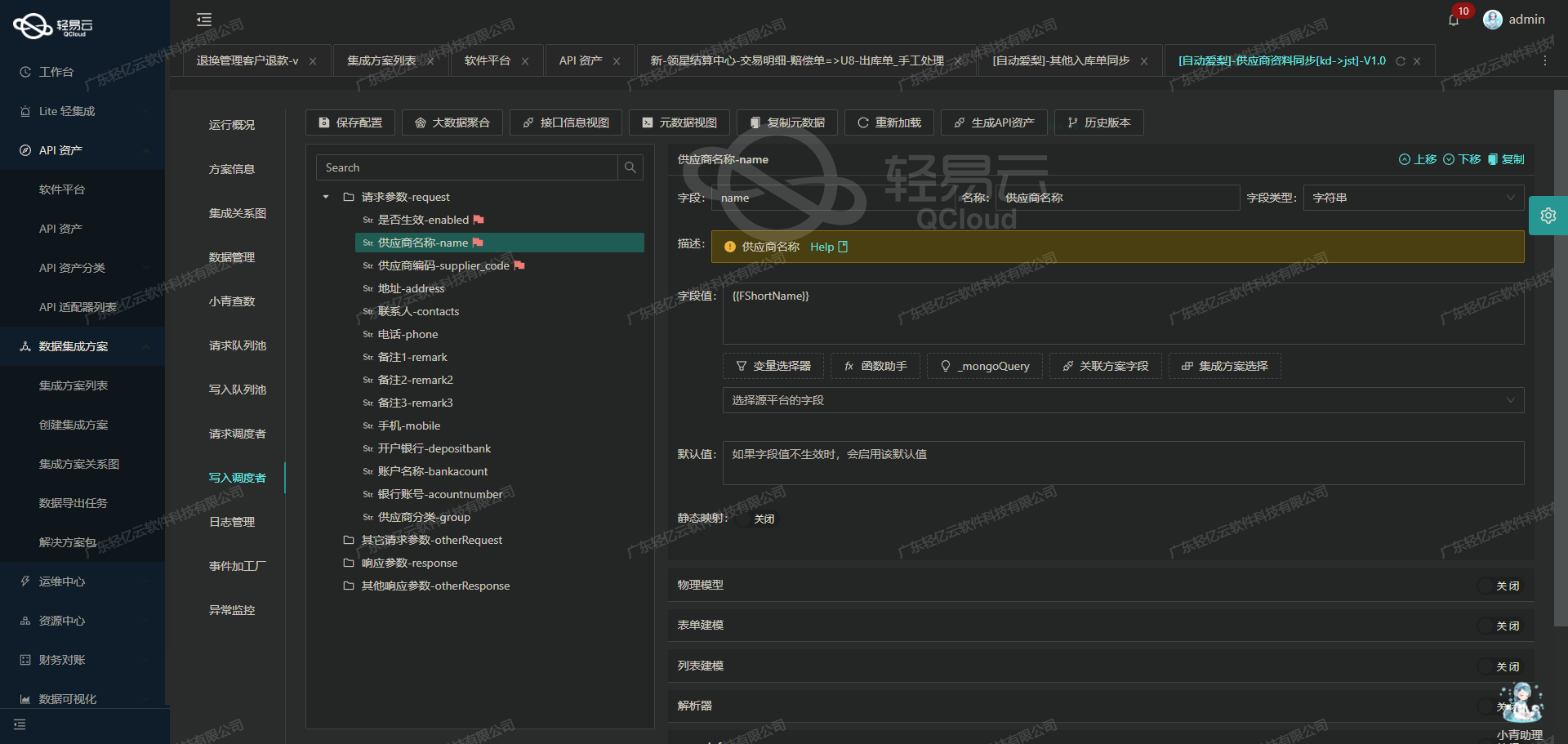

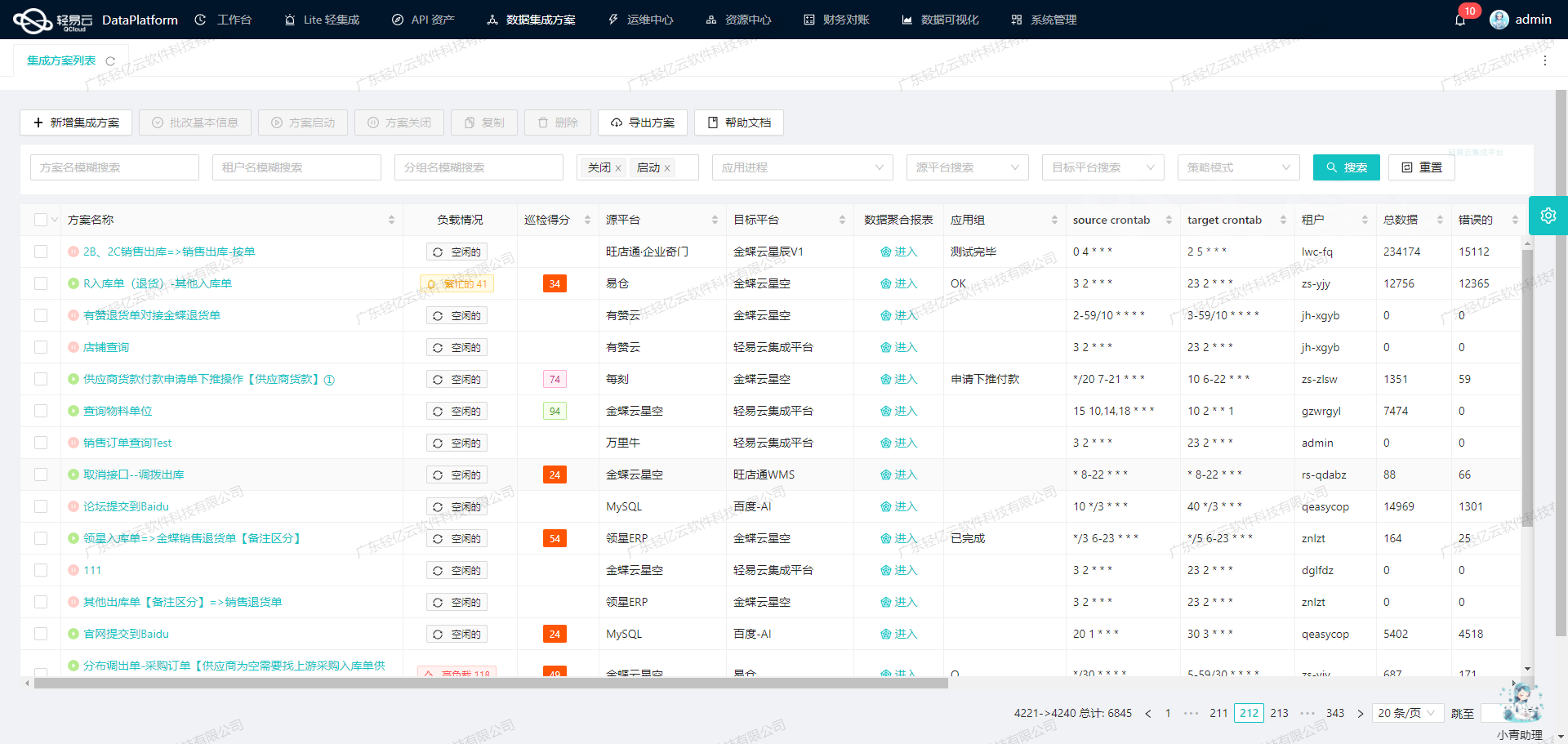

在企业数据管理应用场景中,快速、可靠地将分散的数据源整合起来,是提升业务效率和决策能力的关键之一。本次案例详解我们如何通过“轻易云”平台,将钉钉系统中的用户通信录数据无缝对接到MySQL数据库。具体方案名称为:user-钉钉获取通信录-修改。

为了实现这一目标,我们采取了以下一系列措施:

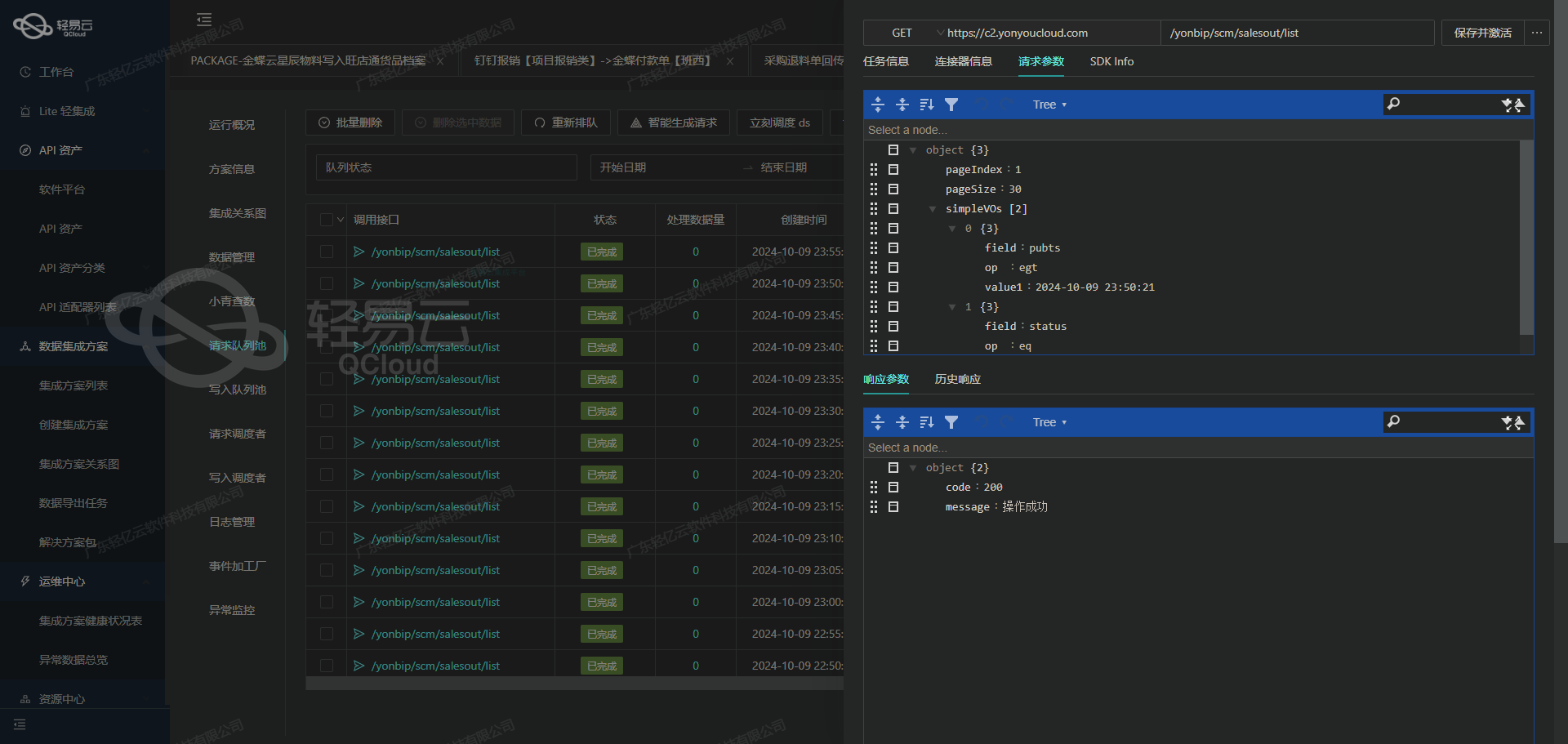

首先,通过调用topapi/v2/user/get接口,从钉钉系统中定时抓取最新的用户通信录数据。这一步骤需要特别关注接口分页及限流问题,以确保全部有效数据都能被成功提取,不会出现任何的数据漏失或遗漏。

随后,在处理过程中,针对从API获取的JSON格式数据,我们自定义了一套转换逻辑,将其映射为适用于MySQL表结构的数据形式。考虑到两者之间可能存在的数据格式差异,经过严格校准和调试,以确保最终写入数据库的数据准确无误。

针对高吞吐量的数据写入需求,我们利用轻易云提供的批量操作能力,使大量数据能够迅速而稳定地导入MySQL中。这不仅显著提高了整体效率,还保证了在大规模并发情况下不影响系统性能。同时,为了应对可能出现的异常状况,如网络故障等因素导致的数据传输失败,构建了一套完善的错误重试机制,对异常进行实时监控并自动重试提交,从而保障整个流程的可靠性与鲁棒性。

最后,通过轻易云的平台特色功能——集中化监控和告警系统,实现对整个任务执行过程中的状态及性能实时跟踪。一旦检测到异常情况,即时触发预警通知相关维护人员,使得潜在问题可以迅速得到响应和解决。另外,对每个步骤生成详细日志记录,有助于后续排查以及优化改进工作。

至此,我们初步完成了从理论到实践的一条完整、可行且高效的数据集成链路。从源头采集,到清洗转换,再至目标库存储,每一环节都采用最合理的方法来确保最终结果符合预期。在接下来的部分内容里,将具体展示如何逐步配置各项参数,以及详细讲解实际代码实现细节。

调用钉钉接口topapi/v2/user/get获取并加工数据的技术实现

在轻易云数据集成平台中,调用钉钉接口topapi/v2/user/get是数据生命周期管理的关键步骤之一。本文将深入探讨如何通过该接口获取并加工数据,以实现高效的数据集成。

API接口配置与调用

首先,我们需要配置API接口的元数据。根据提供的元数据配置,可以看到以下关键参数:

- API路径:

topapi/v2/user/get - 请求方法:

POST - 查询类型:

QUERY - 请求字段:

userid: 用户ID,类型为字符串language: 语言,类型为字符串,默认值为zh_CNdep_strategy: 部门策略,类型为字符串,默认值为40eea1cb-6ac8-332b-ad22-e93b3d8bbde5

这些参数构成了我们请求钉钉API所需的基本信息。

请求参数的准备

在实际操作中,我们需要根据业务需求动态生成请求参数。以下是一个示例代码片段,用于生成请求参数并调用API:

import requests

import json

# 配置请求URL和Headers

url = "https://oapi.dingtalk.com/topapi/v2/user/get"

headers = {

"Content-Type": "application/json",

"Authorization": "Bearer YOUR_ACCESS_TOKEN"

}

# 准备请求体

payload = {

"userid": "123456", # 动态生成或从其他系统获取

"language": "zh_CN",

"dep_strategy": "40eea1cb-6ac8-332b-ad22-e93b3d8bbde5"

}

# 发起POST请求

response = requests.post(url, headers=headers, data=json.dumps(payload))

# 检查响应状态码

if response.status_code == 200:

data = response.json()

# 处理返回的数据

print(data)

else:

print(f"Error: {response.status_code}")在这个示例中,我们使用Python的requests库发起HTTP POST请求,并传递必要的参数。响应成功后,可以对返回的数据进行进一步处理。

数据清洗与转换

获取到原始数据后,需要对其进行清洗和转换,以便后续写入目标系统。假设我们从钉钉API获取到以下JSON响应:

{

"errcode": 0,

"errmsg": "ok",

"result": {

"userid": "123456",

"name": "张三",

"mobile": "+8613800000000",

...

}

}我们可以通过以下步骤进行数据清洗和转换:

- 提取有效字段: 从响应中提取我们需要的字段,如

userid、name、mobile等。 - 格式转换: 根据目标系统要求,对数据格式进行转换。例如,将电话号码格式化为国际标准。

- 字段映射: 将字段名称映射为目标系统中的对应字段名称。

以下是一个示例代码片段,用于清洗和转换数据:

def clean_and_transform(data):

result = data.get("result", {})

cleaned_data = {

"user_id": result.get("userid"),

"full_name": result.get("name"),

"phone_number": format_phone_number(result.get("mobile"))

# 添加更多字段映射和转换逻辑

}

return cleaned_data

def format_phone_number(phone):

# 假设需要将电话号码格式化为国际标准

if phone.startswith("+86"):

return phone.replace("+86", "")

return phone

# 调用清洗和转换函数

transformed_data = clean_and_transform(data)

print(transformed_data)通过上述步骤,我们可以将原始数据转换为符合目标系统要求的数据格式。

自动填充与延迟处理

根据元数据配置中的autoFillResponse和delay属性,我们还可以自动填充响应并处理延迟。例如,在某些场景下,我们可能需要等待一定时间以确保所有依赖的数据都已准备好。

import time

def auto_fill_response(data):

# 自动填充逻辑,例如添加默认值或计算派生字段

data["status"] = data.get("status", "active")

return data

# 延迟处理(单位:秒)

time.sleep(1)

# 自动填充响应数据

final_data = auto_fill_response(transformed_data)

print(final_data)通过以上技术手段,我们可以高效地调用钉钉API获取用户信息,并对其进行清洗、转换和自动填充,从而实现高质量的数据集成。这不仅提升了业务透明度和效率,也确保了数据的一致性和准确性。

使用轻易云数据集成平台进行ETL转换并写入MySQLAPI接口

在数据集成过程中,将源平台的数据转换为目标平台所能接受的格式是至关重要的一步。本文将详细探讨如何使用轻易云数据集成平台,将钉钉获取的通信录数据进行ETL转换,并通过MySQLAPI接口写入目标平台。

元数据配置解析

元数据配置是实现数据转换和写入的关键。以下是我们使用的元数据配置:

{

"api": "execute",

"effect": "EXECUTE",

"method": "POST",

"idCheck": true,

"request": [

{

"field": "main_params",

"label": "main_params",

"type": "object",

"describe": "111",

"value": "1",

"children": [

{"field": "job_number", "label": "job_number", "type": "string", "value": "{job_number}"},

{"field": "name", "label": "name", "type": "string", "value": "{name}"},

{"field": "title", "label": "title", "type": "string", "value": "{title}"},

{"field": "unionid", "label": "unionid", "type":"string", "value":"{unionid}"},

{"field":"userid","label":"userid","type":"string","value":"{userid}"},

{"field":"dept_id_list","label":"dept_id_list","type":"string","value":"_function SUBSTRING_INDEX(CONCAT('{{dept_id_list.0}}',',','{{dept_id_list.1}}',',','{{dept_id_list.2}}',',','{{dept_id_list.3}}',',','{{dept_id_list.4}}',',','{{dept_id_list.5}}',',,'),',,',1)"},

{"field":"leader_in_dept","label":"leader_in_dept","type":"string","value":"_function CASE '{{leader_in_dept.0.leader}}' WHEN true THEN '1' ELSE '0' END"},

{"field":"del_flag","label":"del_flag","type":"string"}

]

}

],

"otherRequest":[

{

"field":"main_sql",

"label":"main_sql",

"type":"string",

"describe":"111",

"value":"update dingtalk_user set job_number=:job_number,name=:name,title=:title,unionid=:unionid,dept_id_list=:dept_id_list,leader_in_dept=:leader_in_dept,del_flag=:del_flag where userid=:userid"

}

]

}数据请求与清洗

在这个阶段,我们从钉钉获取通信录的数据。为了确保数据能够顺利写入MySQL,我们需要对其进行清洗和转换。

- 字段映射:将源数据字段映射到目标字段,例如

job_number、name、title等。 - 部门ID列表处理:使用函数

SUBSTRING_INDEX将多个部门ID拼接成一个字符串,确保符合目标数据库的存储格式。 - 领导标识处理:使用条件表达式将布尔值转换为字符串形式的‘1’或‘0’,以适应目标数据库的需求。

数据转换与写入

在完成数据清洗后,我们需要将其转换为MySQLAPI接口能够接收的格式,并最终写入目标平台。

- API调用:我们使用POST方法调用MySQLAPI接口,确保数据安全传输。

- SQL语句执行:通过元数据配置中的

main_sql字段定义了具体的SQL更新操作,将清洗后的数据插入到相应的表中。

具体步骤如下:

-

构建请求参数: 根据元数据配置,构建包含所有必要字段的请求参数对象。例如:

{ "main_params":{ "job_number":"12345", "name":"张三", "title":"工程师", "unionid":"abc123", "userid":"u12345", "dept_id_list":"1001,1002,1003", "leader_in_dept":"1", "del_flag":"0" } } -

执行SQL更新操作: 将构建好的参数传递给定义好的SQL语句,执行更新操作:

update dingtalk_user set job_number=:job_number,name=:name,title=:title,unionid=:unionid,dept_id_list=:dept_id_list,leader_in_dept=:leader_in_dept,del_flag=:del_flag where userid=:userid

技术要点总结

- 异构系统集成:通过轻易云的数据集成平台,可以轻松实现不同系统间的数据无缝对接。

- 灵活的数据处理:利用函数和条件表达式,可以灵活地处理复杂的数据清洗和转换需求。

- 高效的数据写入:通过API接口和预定义的SQL语句,实现高效、准确的数据写入。

以上内容展示了如何使用轻易云数据集成平台进行ETL转换,并将处理后的数据通过MySQLAPI接口写入目标平台。这一过程不仅提升了业务透明度和效率,还确保了数据处理的准确性和一致性。