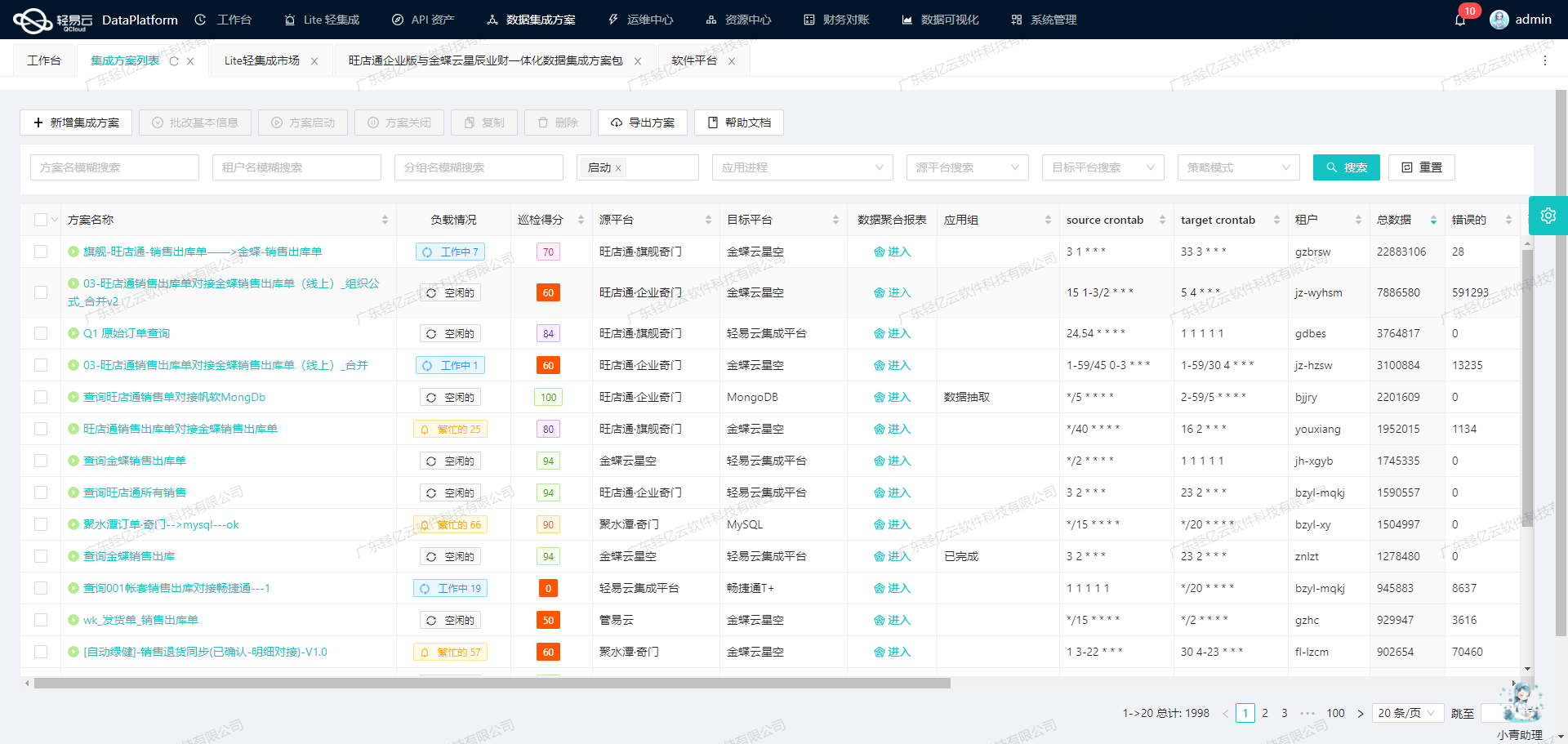

聚水潭数据集成到MySQL:采购退货单的高效对接方案

在企业的数据管理中,如何高效、准确地将业务系统中的数据集成到分析平台是一个关键问题。本案例将分享如何通过轻易云数据集成平台,将聚水潭系统中的采购退货单数据无缝对接至MySQL数据库,实现实时监控和高效处理。

本次集成方案命名为“聚水潭-采购退货单-->BI初本-采购退货表_copy”,旨在确保从聚水潭获取的采购退货单数据能够快速、准确地写入到MySQL中,以支持后续的业务分析和决策。

任务概述

- 数据源平台:聚水潭

- 目标平台:MySQL

- API接口:

- 聚水潭获取数据的API:

/open/purchaseout/query - MySQL写入数据的API:

batchexecute

- 聚水潭获取数据的API:

技术要点

-

高吞吐量的数据写入能力 为了应对大量采购退货单数据的快速处理需求,轻易云提供了高吞吐量的数据写入能力。这使得我们能够在短时间内将大批量的数据从聚水潭系统导入到MySQL数据库中,大幅提升了整体处理效率。

-

实时监控与告警系统 集成过程中,通过集中化的监控和告警系统,我们可以实时跟踪每个数据集成任务的状态和性能。一旦出现异常情况,系统会立即发出告警通知,确保问题能够及时被发现并解决,从而保障了整个流程的稳定性和可靠性。

-

自定义数据转换逻辑 在实际操作中,不同系统之间的数据格式往往存在差异。通过轻易云的平台,我们可以灵活定义自定义的数据转换逻辑,以适应特定业务需求和结构。这不仅简化了开发工作,还提高了数据处理的一致性和准确性。

-

分页与限流处理 聚水潭接口在获取大量数据时需要考虑分页与限流的问题。我们采用了一系列优化策略来有效管理这些限制,确保每次请求都能顺利完成,并且不会因为超出接口限制而导致失败。

-

异常处理与错误重试机制 数据集成过程中难免会遇到各种异常情况,如网络波动或服务不可用等。为了保证任务的连续性,我们设计并实现了一套完善的异常处理与错误重试机制。当某个步骤失败时,系统会自动进行重试,直到成功为止,从而最大程度减少因意外情况导致的数据丢失风险。

通过上述技术手段,本方案不仅实现了聚水潭采购退货单到MySQL数据库的高效对接,还确保了整个过程中的稳定性和可靠性。在接下来的章节中,我们将详细探讨具体实施步骤及相关配置细节。

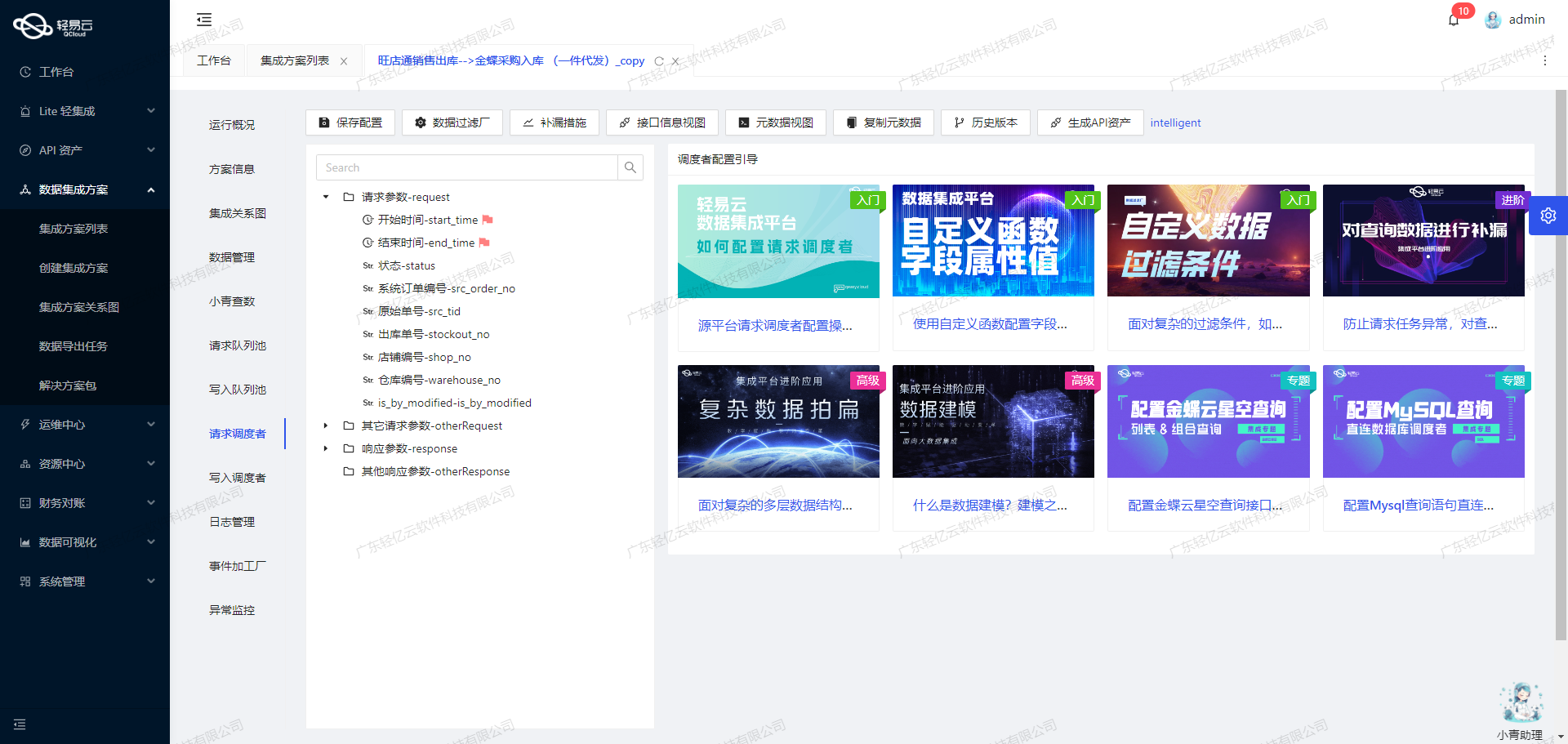

调用聚水潭接口/open/purchaseout/query获取并加工数据

在轻易云数据集成平台的生命周期中,第一步是调用源系统聚水潭接口/open/purchaseout/query来获取采购退货单的数据,并进行初步加工处理。这一步骤至关重要,因为它直接影响到后续的数据转换与写入过程。以下将详细探讨如何高效地调用该接口并处理返回的数据。

接口调用配置

首先,我们需要配置元数据以便正确调用聚水潭的API。根据提供的元数据配置,可以看到该API采用POST方法,主要参数包括分页信息、时间范围、订单状态等。

{

"api": "/open/purchaseout/query",

"method": "POST",

"request": [

{"field": "page_index", "value": "1"},

{"field": "page_size", "value": "30"},

{"field": "modified_begin", "value": "{{LAST_SYNC_TIME|datetime}}"},

{"field": "modified_end", "value": "{{CURRENT_TIME|datetime}}"},

{"field": "status", "value": "Confirmed"}

]

}这些参数确保了我们能够按需分页获取数据,并且限定了查询的时间范围和单据状态,从而提高了查询效率和准确性。

数据请求与清洗

在实际操作中,首先要确保定时可靠地抓取聚水潭接口的数据。通过设置合适的调度策略,可以定期调用API,避免遗漏任何变更记录。例如,每隔一小时执行一次同步任务,并使用上次同步时间作为modified_begin参数,这样可以确保所有新修改或新增的记录都能被及时捕获。

{

"modified_begin":"{{LAST_SYNC_TIME|datetime}}",

"modified_end":"{{CURRENT_TIME|datetime}}"

}为了处理分页问题,需要在每次请求时动态调整page_index参数,并根据返回结果判断是否需要继续请求下一页的数据。这样可以有效应对大批量数据的情况,避免一次性拉取过多数据导致超时或失败。

数据转换与写入准备

在获取到原始数据后,需要进行初步清洗和转换,以便后续写入BI系统。在这一步骤中,可以利用轻易云平台提供的自定义数据转换逻辑,将聚水潭返回的数据格式调整为目标系统所需的格式。例如,将日期格式统一转换为标准ISO格式,或者将某些字段值映射为目标系统中的对应值。

此外,还需要注意处理异常情况,例如网络故障或接口限流。在这种情况下,可以实现错误重试机制,通过捕获异常并延迟重试来保证任务最终完成。同时,为了确保集成过程不漏单,可以启用实时监控和日志记录功能,对每次请求和响应进行详细记录,一旦发现异常立即告警并采取措施。

实现示例

以下是一个简化版的实现示例,用于展示如何调用聚水潭接口并处理返回的数据:

import requests

import datetime

def fetch_purchase_out_data(last_sync_time, current_time):

url = 'https://api.jushuitan.com/open/purchaseout/query'

headers = {'Content-Type': 'application/json'}

page_index = 1

while True:

payload = {

'page_index': str(page_index),

'page_size': '30',

'modified_begin': last_sync_time,

'modified_end': current_time,

'status': 'Confirmed'

}

response = requests.post(url, json=payload, headers=headers)

data = response.json()

if not data['items']:

break

# 数据清洗与转换逻辑

for item in data['items']:

process_item(item)

page_index += 1

def process_item(item):

# 自定义转换逻辑,例如日期格式化、字段映射等

pass

# 示例调用

last_sync_time = (datetime.datetime.now() - datetime.timedelta(hours=1)).strftime('%Y-%m-%d %H:%M:%S')

current_time = datetime.datetime.now().strftime('%Y-%m-%d %H:%M:%S')

fetch_purchase_out_data(last_sync_time, current_time)通过上述步骤,我们可以高效地从聚水潭系统中获取采购退货单数据,并进行必要的预处理,为后续的数据写入做好准备。这不仅提升了数据集成过程的透明度和可靠性,也为业务决策提供了及时准确的数据支持。

数据集成生命周期中的ETL转换与写入

在数据集成的生命周期中,ETL(提取、转换、加载)过程是将源平台的数据转换为目标平台可接受格式的关键步骤。本文将探讨如何利用轻易云数据集成平台,将聚水潭的采购退货单数据转换并写入到目标平台MySQLAPI接口。

数据提取与清洗

首先,我们需要从聚水潭系统中提取采购退货单数据。这一步通常通过调用聚水潭的API接口完成。例如,调用/open/purchaseout/query接口获取相关数据。这里需要特别注意处理分页和限流问题,以确保所有数据完整无误地被提取。

请求参数:

{

"page": 1,

"pageSize": 100

}数据转换逻辑

接下来是将提取到的数据进行转换,使其符合MySQLAPI接口的格式要求。根据元数据配置,我们需要将聚水潭的数据字段映射到MySQL数据库表的相应字段。

元数据配置示例:

{

"field":"id",

"label":"主键",

"type":"string",

"value":"{io_id}-{items_ioi_id}"

}在这个配置中,id字段由io_id和items_ioi_id拼接而成,这样可以确保主键的唯一性。

自定义转换逻辑

为了适应特定业务需求,可能需要自定义一些转换逻辑。例如,将状态字段从聚水潭的多种状态(如Confirmed, WaitConfirm等)映射到MySQL中的相应状态值。这可以通过在轻易云平台上配置自定义脚本或规则来实现。

{

"field":"status",

"label":"状态",

"type":"string",

"describe":"Confirmed:生效,WaitConfirm:待审核,Creating:草拟,Cancelled:作废,OuterConfirming:外部确认中,Delete:取消",

"value":"{status}"

}在这个例子中,可以根据业务需求对不同状态进行重新编码或转换。

数据写入MySQL

完成数据转换后,需要将处理后的数据批量写入MySQL数据库。轻易云平台支持高吞吐量的数据写入能力,可以有效提升数据处理时效性。我们可以使用批量执行的方式,通过调用MySQLAPI接口,将转换后的数据插入到目标表中。

元数据中的主要SQL语句如下:

REPLACE INTO purchaseout_query(id, io_id, io_date, status, so_id, f_status, warehouse, receiver_name, receiver_mobile, receiver_state, receiver_city, receiver_district, receiver_address, wh_id, remark, modified, po_id, wms_co_id, seller_id, labels, wave_id, logistics_company, lc_id, l_id, archived, creator_name, lock_wh_id, lock_wh_name, out_io_id, items_ioi_id)

VALUES (?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?)通过这种方式,可以确保大量数据能够快速、高效地被写入到MySQL数据库中。

数据质量监控与异常处理

在整个ETL过程中,实时监控和异常处理至关重要。轻易云提供了集中的监控和告警系统,可以实时跟踪每个数据集成任务的状态和性能。当出现异常时,系统会自动记录日志并发出告警信息。同时,还支持错误重试机制,以保证任务的可靠性和稳定性。

定制化的数据映射

最后,根据业务需求,还可以对MySQL数据库进行定制化的数据映射。例如,对某些特殊字段进行额外处理或对接。在实际操作中,可以根据具体业务场景灵活调整映射规则,以满足不同需求。

通过以上步骤,我们可以高效地完成从聚水潭系统到MySQL数据库的数据集成过程,实现不同系统间的数据无缝对接,并确保数据质量和时效性。