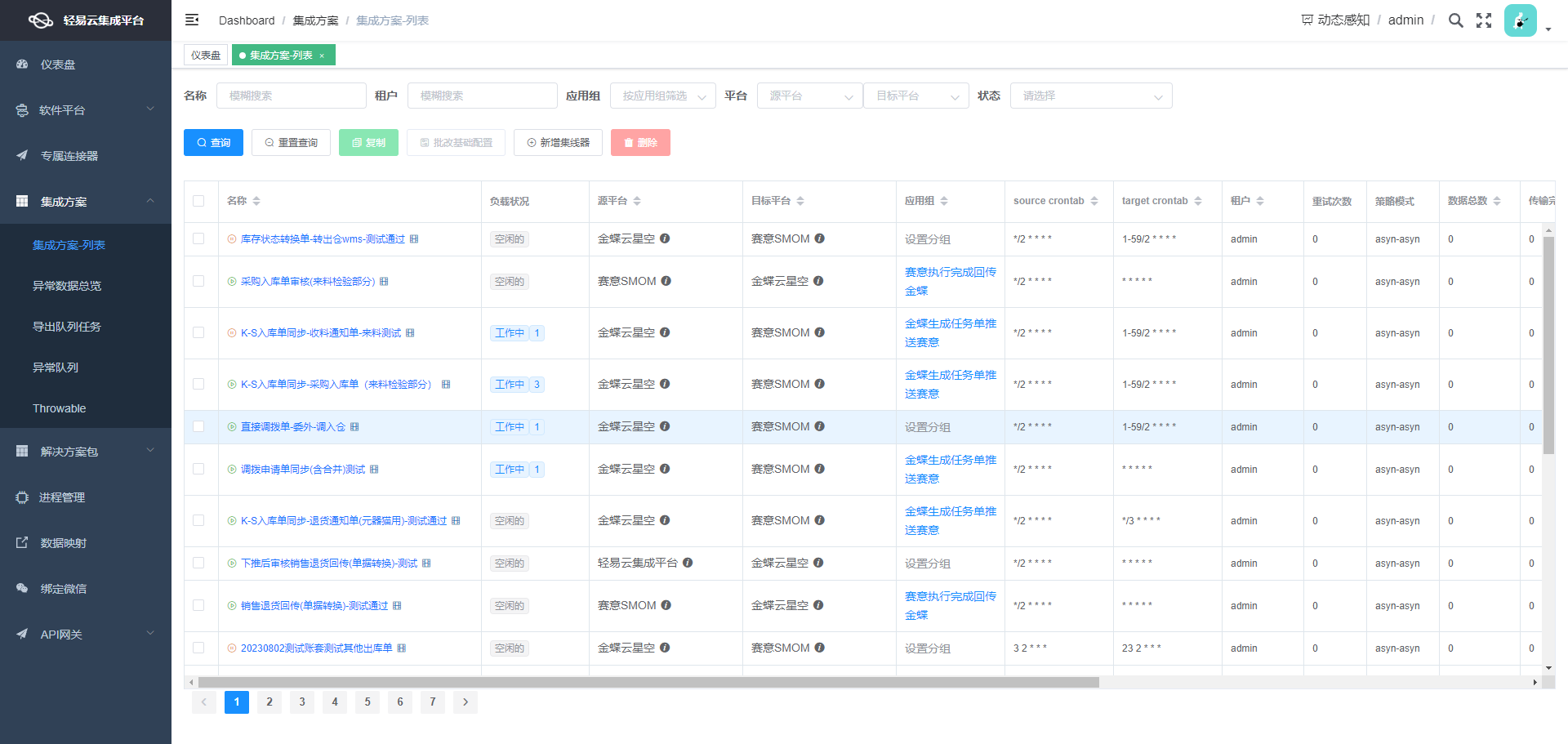

BDS对账班牛返款表:从班牛到MySQL的数据集成案例

在数据驱动的业务环境中,如何高效、准确地实现系统间的数据对接,是每个企业都面临的重要挑战。本文将分享一个具体的技术案例——如何通过轻易云数据集成平台,将班牛系统中的返款数据无缝集成到MySQL数据库中,确保数据不漏单且处理过程透明可控。

任务概述

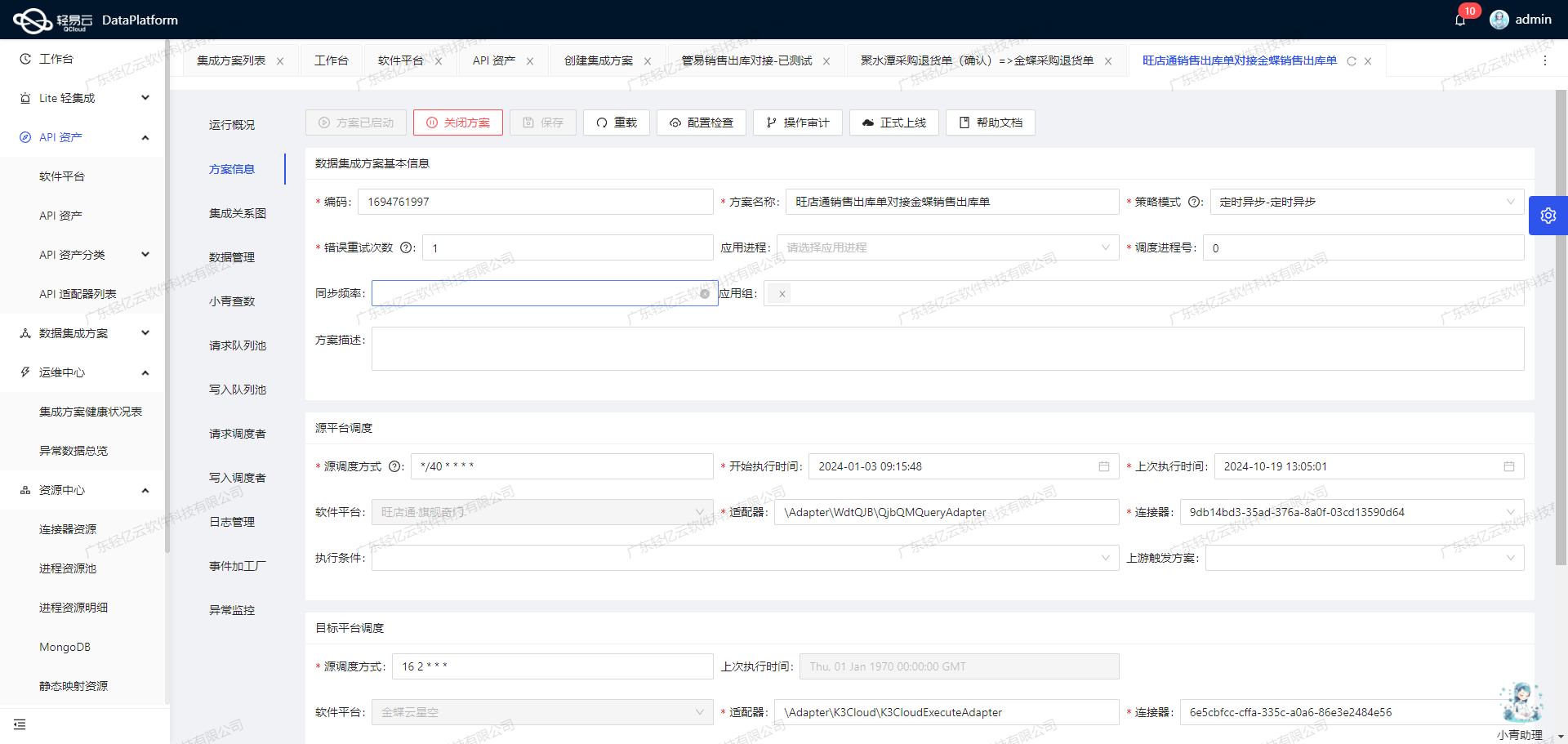

本次集成任务名为“BDS对账班牛返款表”,主要目标是定时可靠地抓取班牛接口task.list提供的返款数据,并批量写入到MySQL数据库中。为了实现这一目标,我们需要解决以下几个关键技术问题:

- 高吞吐量的数据写入能力:确保大量返款数据能够快速、高效地被写入到MySQL数据库中。

- 实时监控与告警系统:通过集中监控和告警系统,实时跟踪数据集成任务的状态和性能,及时发现并处理潜在问题。

- 自定义数据转换逻辑:适应特定业务需求,对从班牛获取的数据进行必要的转换,以匹配MySQL中的数据结构。

- 分页与限流处理:针对班牛接口的分页和限流机制,设计合理的抓取策略,确保所有数据完整无遗漏地被获取。

- 异常处理与错误重试机制:在对接过程中,如果出现任何异常情况,通过预设的重试机制来保证任务最终成功完成。

技术要点

-

调用班牛接口

task.list:- 定时调度任务,从班牛系统中抓取最新的返款记录。

- 处理分页返回结果,确保所有记录都能被完整获取。

-

批量写入到MySQL:

- 使用高效的数据写入API

executeReturn,支持大规模数据快速导入。 - 实现定制化的数据映射,对不同字段进行必要转换和校验。

- 使用高效的数据写入API

-

监控与日志记录:

- 实时监控整个数据处理流程,通过日志记录每一步操作及其结果,为后续分析和问题排查提供依据。

-

异常检测与重试机制:

- 在遇到网络波动或接口响应异常等情况时,通过内置的错误重试机制,提高任务执行成功率。

通过上述技术手段,我们不仅能够实现高效、稳定的数据集成,还能确保整个过程透明可控,为企业决策提供可靠的数据支持。在接下来的章节中,我们将详细介绍每个步骤的具体实现方法及注意事项。

调用班牛接口task.list获取并加工数据

在数据集成的生命周期中,第一步是从源系统获取数据。本文将详细探讨如何通过轻易云数据集成平台调用班牛接口task.list来获取并加工处理数据。

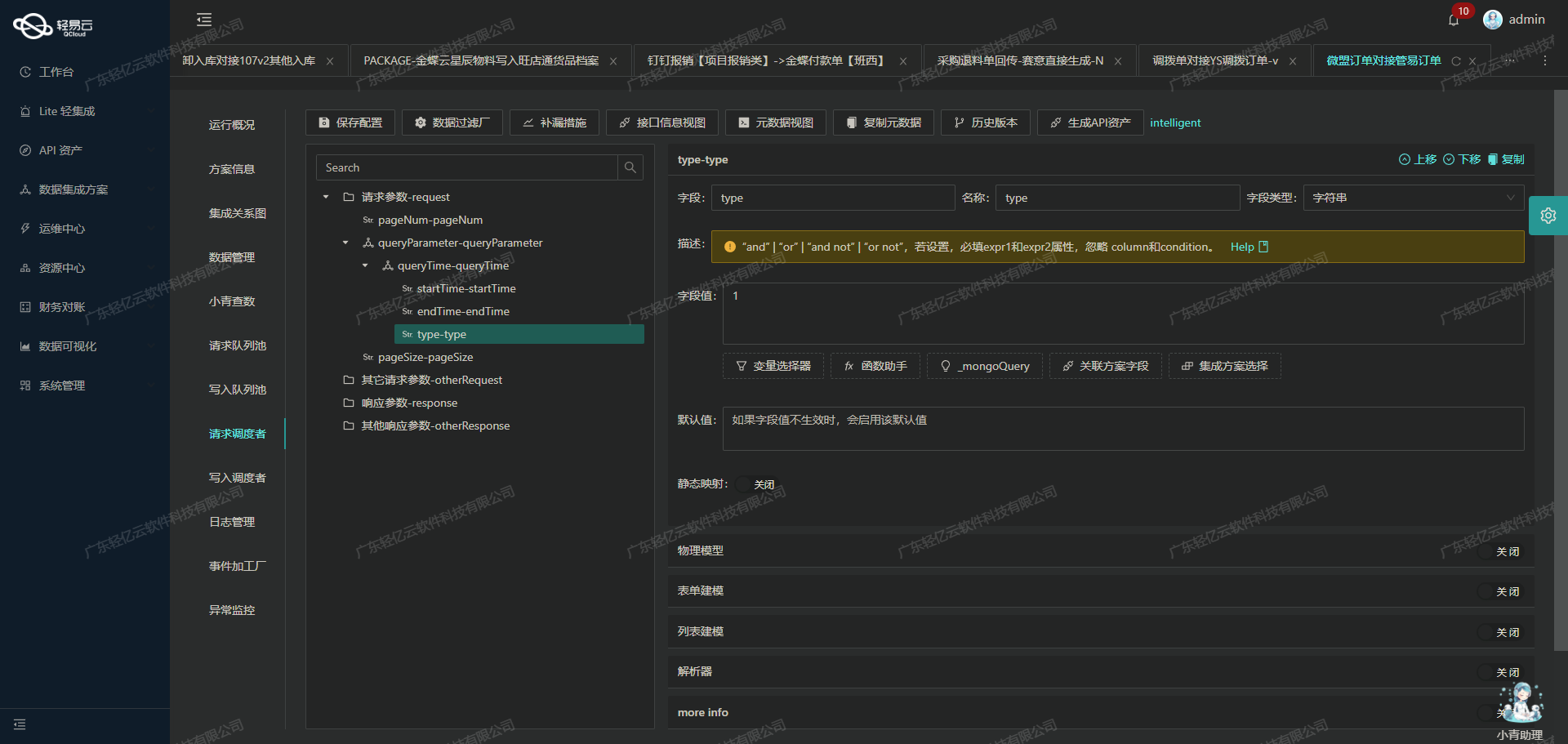

配置元数据

首先,我们需要配置元数据以便正确调用班牛的API接口。以下是关键的元数据配置:

{

"api": "task.list",

"effect": "QUERY",

"method": "GET",

"number": "-1",

"id": "-1",

"idCheck": true,

"request": [

{"field":"project_id","label":"群组ID","type":"string","value":"64028"},

{"field":"page_size","label":"page_size","type":"string","value":"50"},

{"field":"page_num","label":"page_num","type":"string","value":"1"},

{"field":"star_created","label":"起始时间","type":"string"},

{"field":"end_created","label":"结束时间","type":"string"},

{"field":"star_modified","label":"修改时间起始时间","type":"string", "value": "_function DATE_FORMAT(DATE_ADD(NOW(),INTERVAL - 24 HOUR),'%Y-%m-%d %H:%i:%s')"},

{"field":"end_modified","label":"修改时间结束时间", "type": "string", "value": "{{CURRENT_TIME|datetime}}"}

],

"autoFillResponse": true,

"condition_bk":[

[{"field":77212,"logic":"eqv2","value"

### BDS对账班牛返款表数据集成到MySQL的ETL转换

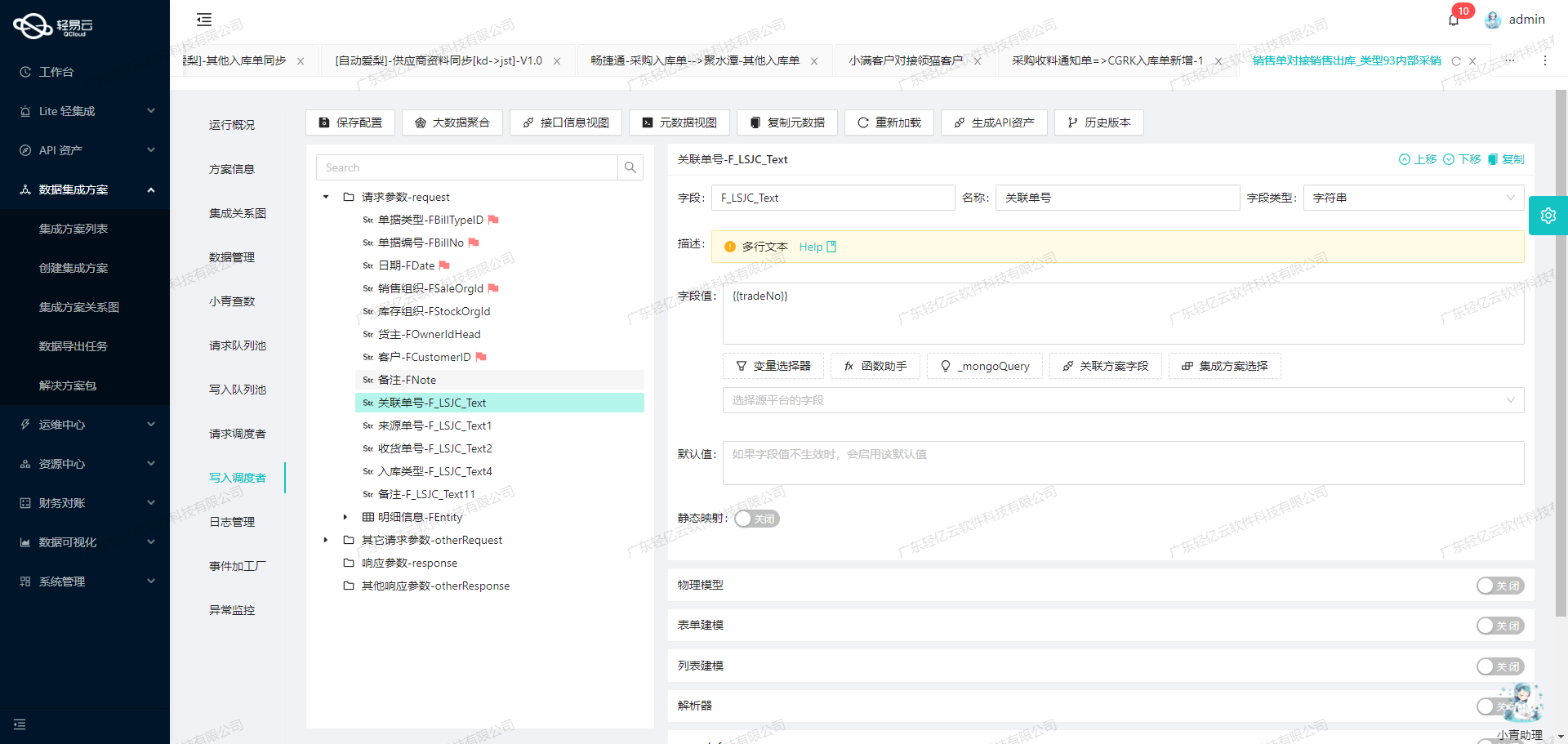

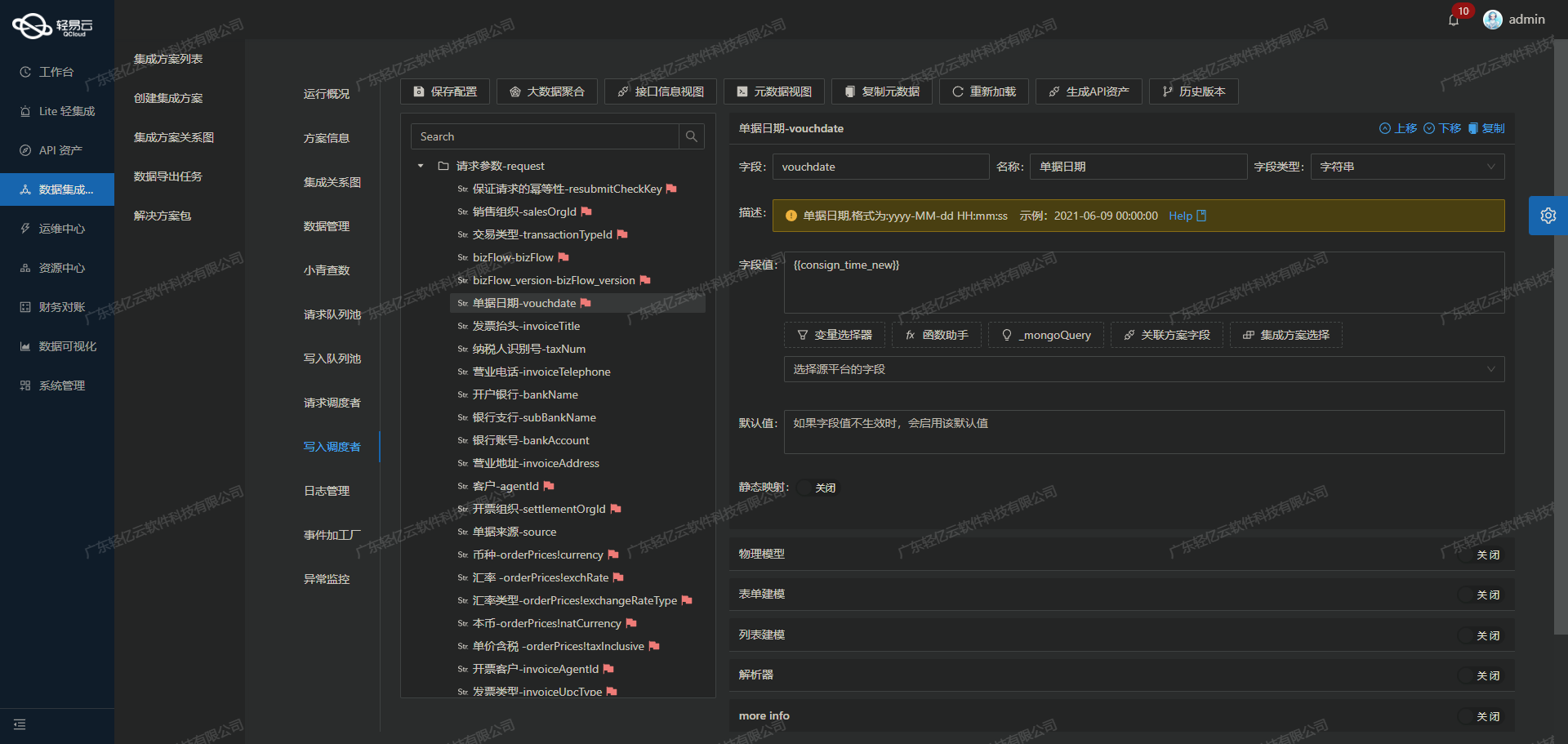

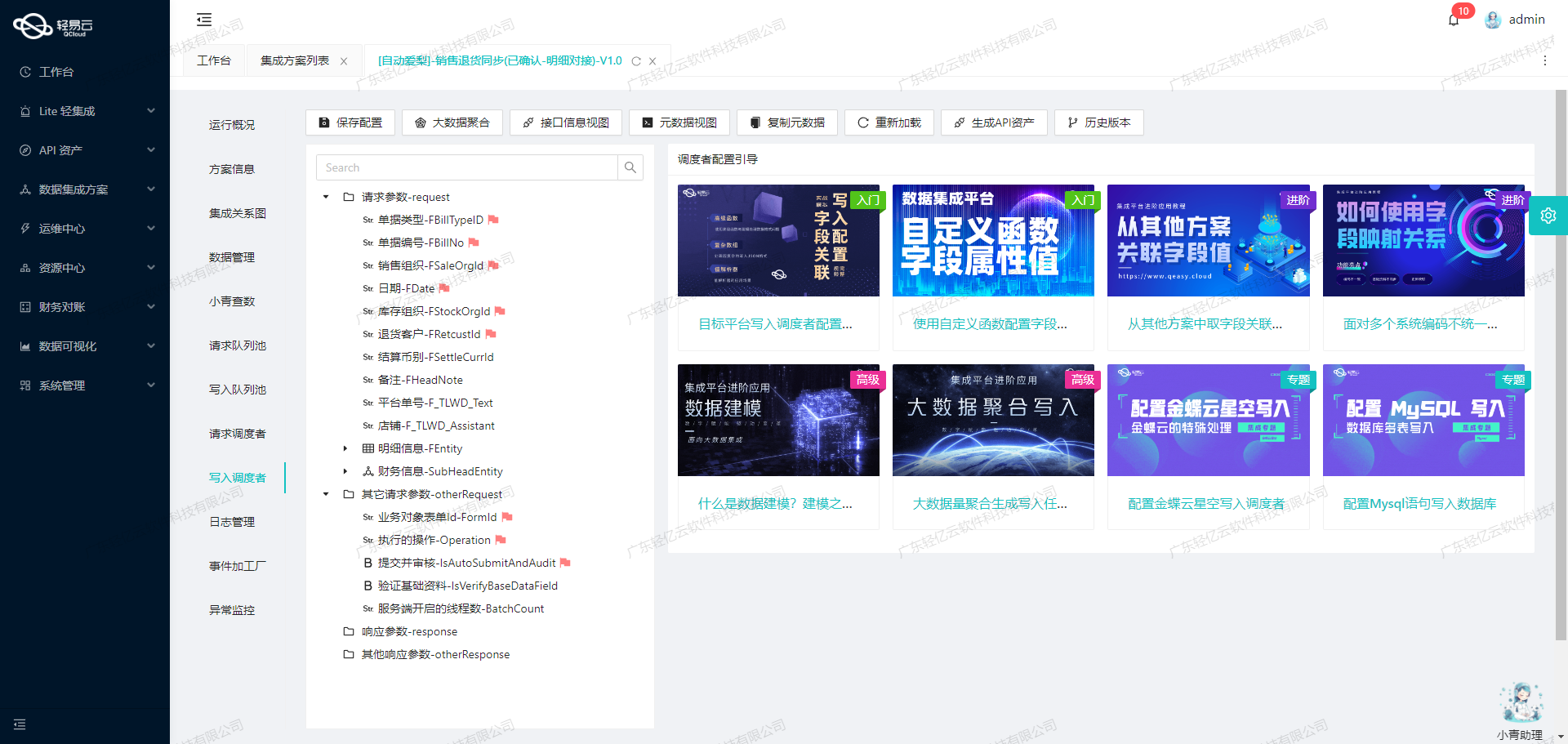

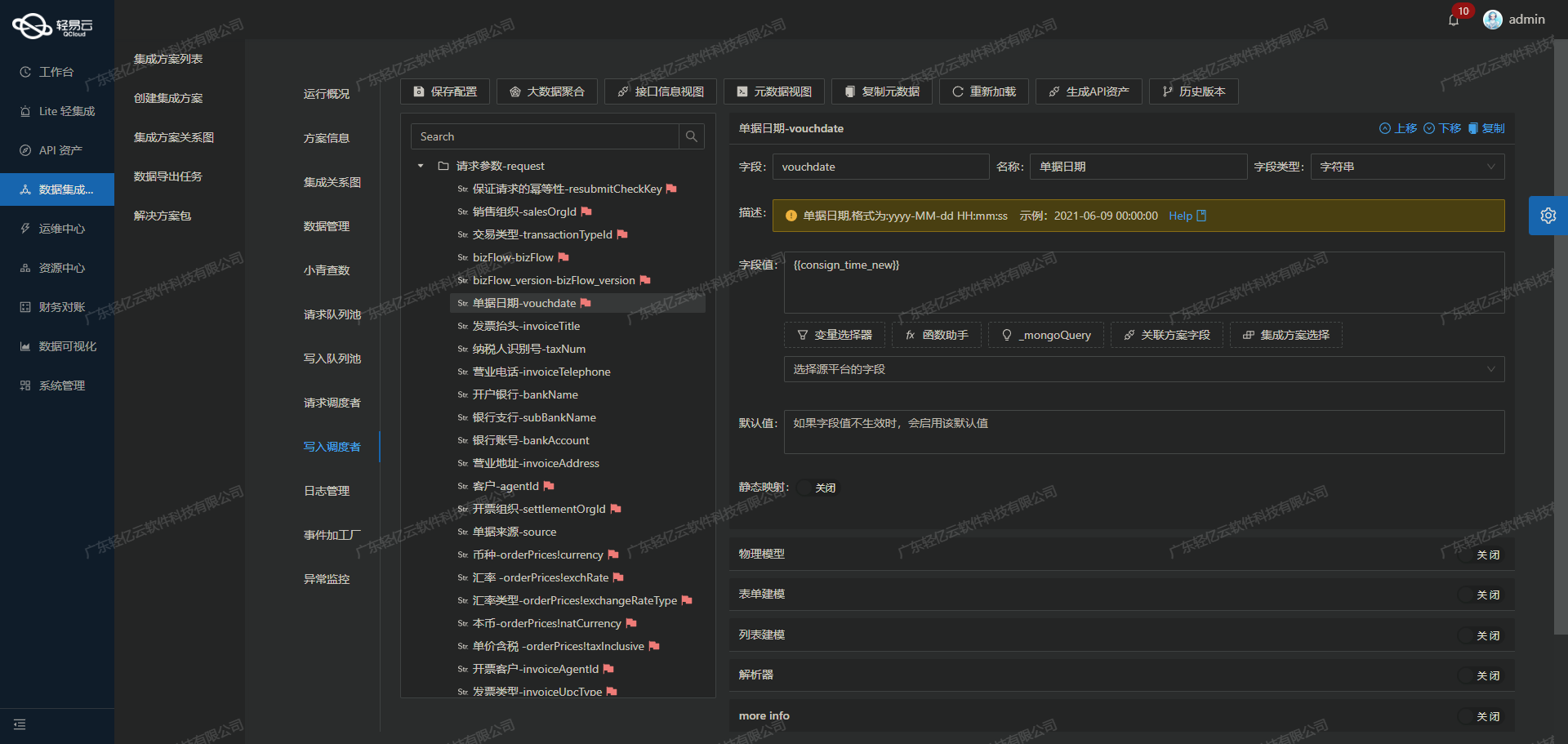

在数据集成的第二步中,关键任务是将源平台的数据进行ETL转换,使其符合目标平台MySQL API接口所能接收的格式,并最终写入目标平台。以下是具体的技术实现过程。

#### 数据请求与清洗

首先,通过调用班牛系统的API接口获取原始数据。在本案例中,我们使用`executeReturn` API接口进行数据请求。该接口支持POST方法,并且需要对ID进行检查。请求参数包括主参数和扩展参数,其中主参数包含了单据编号、订单编号、销售渠道编码等信息,扩展参数则涉及货品编号、品牌、规格名称等详细信息。

```json

{

"api": "executeReturn",

"method": "POST",

"idCheck": true,

"request": [

{

"field": "main_params",

"label": "主参数",

"type": "object",

...

},

{

"field": "extend_params_1",

"label": "1:1扩展参数",

"type": "array",

...

}

]

}数据转换

数据转换是ETL过程中的核心步骤。在这一阶段,我们需要将从班牛系统获取的数据转换为MySQL数据库能够接受的格式。为了实现这一点,需要进行字段映射和数据格式的转换。例如,班牛系统返回的日期时间需要转化为MySQL数据库能够识别的datetime格式。

在配置元数据时,我们定义了两个主要的SQL语句:一个用于插入主表(supplier_rebate),另一个用于插入扩展表(supplier_rebate_detail)。这些SQL语句已经包含了所有必要的字段映射和默认值设定。

INSERT INTO `lhhy_srm`.`supplier_rebate`

(`bill_no`, `trade_no`, `online_trade_no`, `source_bill_no`, `shop_code`,

`shop_name`, `responsible_party`, `responsible_party_detail`, `reason`,

`rebate_receipt`, `status`, `register_date`, `register_seller`,

`trade_account`, `trade_address`, `trade_time`, `logistic_name`,

`main_post_id`, `return_logistic_name`, `return_main_post_id`,

`tranfer_amount`, `tranfer_type`, `tranfer_method`, `bank`,

`tranfer_memo`, `service_charge`, `rebate_person`,

`tranfer_time`,`tranfer_error_reason`,`tranfer_status`,

`seller_memo`,`receiver_info`,`zfb_batch_no`,`zfb_detail_no`,

`suppiler_batch_no`,`remark`,`create_time`,`create_by`)

VALUES

(<{bill_no: }>, <{trade_no: }>, <{online_trade_no: }>, <{source_bill_no: }>,

<{shop_code: }>, <{shop_name: }>, <{responsible_party: }>,

<{responsible_party_detail: }>, <{reason: }>, <{rebate_receipt: }>,

<{status: CURRENT_TIMESTAMP}>, <{register_seller: }>,

<{trade_account: }>, <{trade_address: CURRENT_TIMESTAMP}>,

<{logistic_name: }>, <{main_post_id: }>,

<{return_logistic_name: }>, <{return_main_post_id: }>

...

);数据写入

将转换后的数据写入MySQL数据库是最后一步。在此过程中,确保高吞吐量的数据写入能力至关重要,以便大量数据能够快速被集成到目标平台。通过批量处理和异步写入机制,可以显著提升数据处理效率。

同时,必须处理好分页和限流问题,以防止因一次性请求过多数据而导致接口超时或崩溃。通过合理设置分页参数,可以确保每次请求的数据量在可控范围内,从而提高整体稳定性。

异常处理与监控

在整个ETL过程中,异常处理与实时监控同样重要。对于可能出现的数据格式不匹配或网络问题,需要建立完善的错误重试机制。例如,当某条记录因网络问题未能成功写入时,应自动重试多次直至成功。

此外,通过集中监控和告警系统,可以实时跟踪每个数据集成任务的状态和性能。一旦发现异常情况,例如数据丢失或延迟过长,应及时发出告警通知,并采取相应措施进行处理。

自定义数据转换逻辑

为了适应特定业务需求,有时需要自定义数据转换逻辑。例如,对于复杂的数据结构或特定字段,需要编写自定义脚本进行处理。这些脚本可以在ETL工具中配置,以便在数据导入之前进行预处理,从而确保最终写入的数据符合业务要求。

通过上述步骤,可以实现从班牛系统到MySQL数据库的数据无缝集成,确保数据准确、高效地传输和存储。在实际操作中,根据具体业务需求,还可以进一步优化和调整每个环节,以达到最佳效果。