钉钉数据集成到MySQL:品类即时贡献报表集成方案-推广费更新

在企业的数据处理和管理过程中,常常需要确保不同系统间的数据一致性和实时同步。本文将详细介绍如何利用轻易云数据集成平台,将钉钉中的推广费相关数据高效、安全地写入到MySQL数据库中,从而实现品类即时贡献报表的生成与更新。

技术背景与挑战

对于该项目,我们面临的主要技术挑战包括:

- 定时可靠地抓取钉钉接口数据:我们采用了

/v1.0/yida/forms/instances/ids/{appType}/{formUuid}API,从钓鱼获取特定业务表单实例的数据。 - 处理大批量数据的快速写入:MySQL作为目标数据库,需要支持高吞吐量的数据写入能力,以避免因大量数据积压导致性能瓶颈。

- 保证数据质量和完整性:通过设置全面的数据质量监控体系及异常检测机制,可及时识别并解决潜在问题。

系统对接流程概述

为实现该方案,整个系统对接过程可以分为以下几个步骤:

-

调用钉钉API捕获新提交的表单实例

- 使用统一视图控制台,通过配置调度策略,在固定时间周期内触发HTTP请求获取最新的数据记录。

-

处理分页和限流问题

- 由于实际应用场景可能会涉及大量记录,为防止超出API调用速率限制,我们设计了灵活的分页加载机制,并结合限流策略进行精细化控制。

-

自定义转换逻辑适配业务需求

- 根据具体业务要求,对拉取到的原始JSON格式信息进行解析、转换以适应MySQL数据库结构。这一步骤尤为关键,有助于从源头上保障下游任务顺利进行。

-

安全可靠地批量导入至MySQL

- 借助

executeAPI接口,实现高速率且稳定的大规模插入操作,并使用事务管理来保持整体操作的一致性。同时针对可能出现的问题,还设立了一套完备的错误重试机制,有力保障每笔交易不漏单、不失效。

- 借助

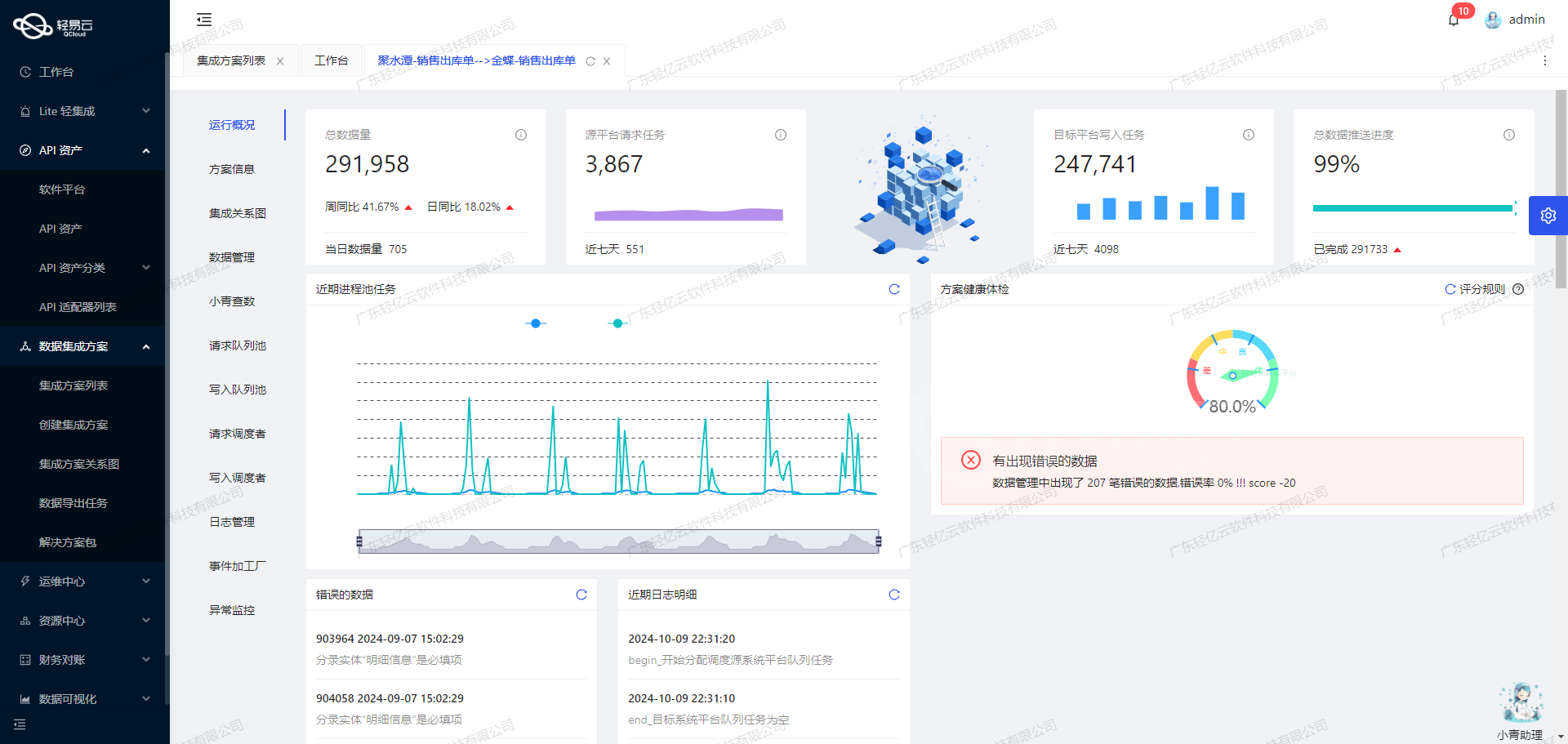

实时监控与告警系统

为了进一步提升运维体验及效率,我们还部署了一整套集中式监控和告警系统,用于全面跟踪各个节点运行状态,包括但不限于资源消耗、网络响应时间等指标。一旦发现异常状况,比如说某次导入失败或是API访问频次过高,都能立即触发相应预案进行处置,大幅降低故障风险。

调用钉钉接口获取并加工数据

在轻易云数据集成平台的生命周期中,调用源系统接口是至关重要的一步。本文将深入探讨如何通过调用钉钉接口v1.0/yida/forms/instances/ids/{appType}/{formUuid}来获取并加工数据,以实现品类即时贡献报表的推广费更新。

接口概述

该接口主要用于查询钉钉应用中的表单实例数据,支持分页查询,并可根据多种条件进行筛选。以下是元数据配置中的关键字段及其含义:

api: 接口路径。effect: 操作类型,此处为查询(QUERY)。method: 请求方法,此处为POST。number: 表单标题字段。id: 表单实例ID字段。

请求参数包括:

appType: 应用编码。formUuid: 表单ID。pageNumber: 分页页码。pageSize: 分页大小。modifiedToTimeGMT: 修改时间终止值。systemToken: 应用秘钥。modifiedFromTimeGMT: 修改时间起始值。language: 语言,默认为中文(zh_CN)。- 其他可选的查询条件,如

searchFieldJson、userId、originatorId等。

数据请求与清洗

在实际操作中,首先需要构建请求体,以便向钉钉接口发送请求。以下是一个示例请求体:

{

"appType": "APP_BNJNRVQ32174RSX3MROF",

"formUuid": "FORM-99D9CFA106C3427F838829938C81D5AAADQ7",

"pageNumber": "1",

"pageSize": "50",

"modifiedToTimeGMT": "{{CURRENT_TIME|datetime}}",

"systemToken": "KYC664C1WR9LODIIAI09I913S0HO2G3YGREWL43",

"modifiedFromTimeGMT": "{{LAST_SYNC_TIME|datetime}}",

"language": "zh_CN"

}在这个请求体中,使用了动态变量{{CURRENT_TIME|datetime}}和{{LAST_SYNC_TIME|datetime}}来分别表示当前时间和上次同步时间。这些变量确保每次请求都能获取到最新的数据。

发送请求后,系统会返回一个包含表单实例数据的响应。此时,需要对返回的数据进行清洗和转换,以便后续处理。例如,可以过滤掉不需要的字段,只保留与推广费更新相关的信息。

数据转换与写入

清洗后的数据需要进行格式转换,以符合目标系统的要求。例如,将日期格式从GMT转换为本地时间,或者将金额字段从字符串转换为数值类型。以下是一个简单的转换示例:

import datetime

def convert_gmt_to_local(gmt_time_str):

gmt_time = datetime.datetime.strptime(gmt_time_str, "%Y-%m-%dT%H:%M:%SZ")

local_time = gmt_time + datetime.timedelta(hours=8) # 假设本地时区为UTC+8

return local_time.strftime("%Y-%m-%d %H:%M:%S")

# 示例数据

data = {

"id": "12345",

"title": "推广费报表",

"modifiedTimeGMT": "2023-10-01T12:00:00Z"

}

# 转换日期格式

data["modifiedTimeLocal"] = convert_gmt_to_local(data["modifiedTimeGMT"])转换后的数据可以通过轻易云平台写入到目标系统,实现无缝对接。

实时监控与调试

为了确保数据集成过程的顺利进行,可以利用轻易云平台提供的实时监控功能,查看每个环节的数据流动和处理状态。如果出现问题,可以通过日志和错误信息进行调试。例如,如果发现某个字段的数据类型不匹配,可以在清洗阶段进行相应的修正。

总之,通过合理配置元数据并调用钉钉接口,可以高效地获取并加工所需的数据,为品类即时贡献报表的推广费更新提供可靠的数据支持。

利用轻易云数据集成平台实现ETL转换并写入MySQLAPI接口

在数据集成的生命周期中,ETL(Extract, Transform, Load)转换是将源平台数据转换为目标平台可接收格式的关键步骤。本文将详细探讨如何利用轻易云数据集成平台,将源平台的数据经过ETL处理后,通过MySQLAPI接口写入目标平台。

配置元数据

在进行ETL转换之前,首先需要配置元数据。以下是一个典型的元数据配置示例:

{

"api": "execute",

"effect": "EXECUTE",

"method": "SQL",

"number": "id",

"id": "id",

"name": "id",

"idCheck": true,

"request": [

{

"field": "main_params",

"label": "主参数",

"type": "object",

"describe": "对应主语句内的动态参数",

"value": "{textField_lx4mftgo}",

"children": [

{"field": "form_instance_id", "label": "源id(实例id)", "type": "string", "value": "{id}"},

{"field": "platform", "label": "平台", "type": "string", "value": "{selectField_lx4mftgl}"},

{"field": "date",

"label": "日期",

"type": "timestamp",

"_function FROM_UNIXTIME( ( {dateField_lx4mftg2} / 1000 ) ,'%Y-%m-%d' )"

},

{"field": "shop_name",

...

}

]

}

],

...

}数据请求与清洗

在这个阶段,我们从源系统中提取数据,并进行初步的清洗和预处理。例如,将时间戳转换为标准日期格式,或者对字符串进行必要的修剪和格式化。

SELECT

form_instance_id,

platform,

FROM_UNIXTIME(dateField_lx4mftg2 / 1000, '%Y-%m-%d') AS date,

shop_name,

shop_code,

type_name,

category,

expense,

DATE_FORMAT(gmtCreate, '%Y-%m-%d %H:%i:%s') AS create_time,

originator AS create_by,

originatorUserId AS create_user_id,

DATE_FORMAT(gmtModified, '%Y-%m-%d %H:%i:%s') AS modify_time

FROM source_table;数据转换与写入

在完成初步清洗后,需要将数据转换为目标系统可接受的格式,并通过MySQLAPI接口写入目标系统。在这个过程中,我们利用元数据配置中的main_sql字段来定义具体的SQL语句。

UPDATE `lehua`.`promotion_expenses`

SET

`platform` = <{platform: }>,

`date` = <{date: }>,

`shop_name` = <{shop_name: }>,

`shop_code` = <{shop_code: }>,

`type` = <{type: }>,

`type_id` = <{type_id: }>,

`type_name` = <{type_name: }>,

...

WHERE `form_instance_id` = <{form_instance_id: }>;在这个SQL语句中,我们使用了占位符来表示动态参数,这些参数将在执行时被实际值替换。例如,<{platform: }>将被替换为具体的平台名称。

动态参数处理

为了确保SQL语句中的动态参数能够正确替换,我们需要在元数据配置中定义这些参数及其对应的值。例如:

{

...

{"field":"platform","label":"平台","type":"string","value":"{selectField_lx4mftgl}"},

{"field":"date","label":"日期","type":"timestamp","value":"_function FROM_UNIXTIME( ( {dateField_lx4mftg2} / 1000 ) ,'%Y-%m-%d' )"},

...

}通过这种方式,我们可以确保每个字段都能正确映射到相应的数据源字段,并在执行SQL语句时自动替换为实际值。

特殊字段处理

有些字段可能需要特殊处理,例如站内推广费和站外推广费。这些字段可以通过函数计算得到:

{

...

{"field":"instation_expense","label":"站内推广费","type":"float","value":"_function IF( (STRCMP('{textField_lx4mftgo}','type17')), {numberField_lx4mftgp} ,0)"},

{"field":"outstation_expense","label":"站外推广费","type":"float","value":"_function IF( (STRCMP('{textField_lx4mftgo}','type17')), 0,{numberField_lx4mftgp})"}

}通过这种方式,可以根据不同条件动态计算出相应的费用值,并写入到目标系统中。

最终执行

完成所有配置后,通过调用API接口执行上述SQL语句,实现数据从源系统到目标系统的完整ETL过程。整个过程透明可视化,确保每个环节都清晰易懂,并实时监控数据流动和处理状态,极大提升业务透明度和效率。

以上就是利用轻易云数据集成平台实现ETL转换并写入MySQLAPI接口的技术细节。希望这些内容能对您有所帮助。