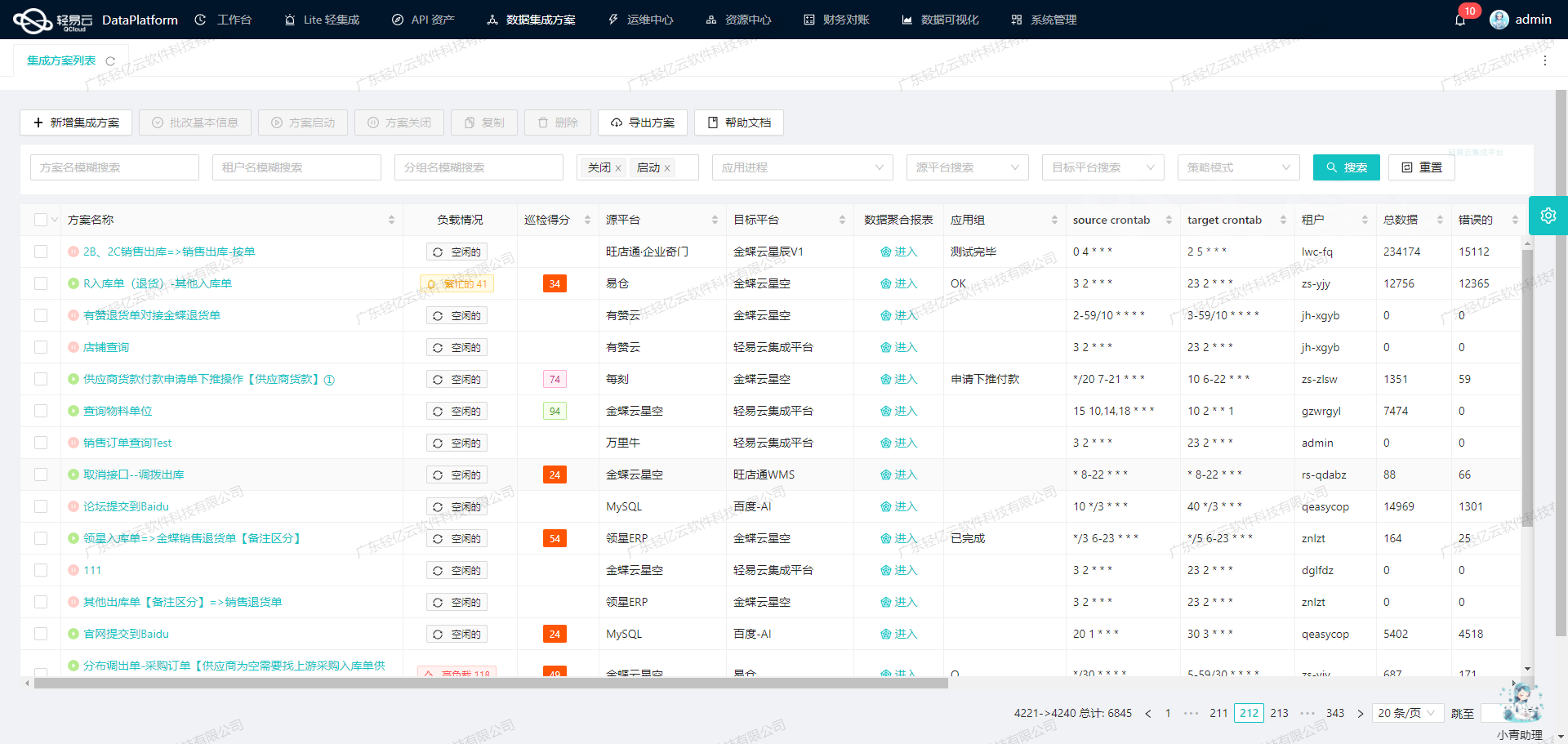

吉客云数据集成到轻易云平台:更新组装拆卸单出库时间技术案例分享

在这篇技术文章中,我们将聚焦于吉客云系统与轻易云数据集成平台的对接实施方案,特别是关于“更新组装拆卸单出库时间”的具体实现。为了确保业务连续性和高效的数据处理,此次集成项目利用了多个关键技术特性,包括高吞吐量的数据写入能力、集中监控和告警系统,以及定制化的数据映射工具。

首先,我们需要解决的是如何从吉客云接口erp.storage.goodsdocout.v2中抓取所需的出库订单数据。由于该接口存在分页和限流问题,因此我们设计了一套可靠的抓取机制,通过定时任务触发API调用,并结合批量处理策略,将大量订单数据快速写入到轻易云集成平台。

为此,我们配置了以下几个核心步骤:

-

API 调用与分页处理: 利用脚本及任务调度程序,按设定频率调用吉客云API,从响应结果中解析并处理分页信息,以确保每一页的数据都准确无误地被获取。这不仅优化了抓取效率,也避免了漏单问题。

-

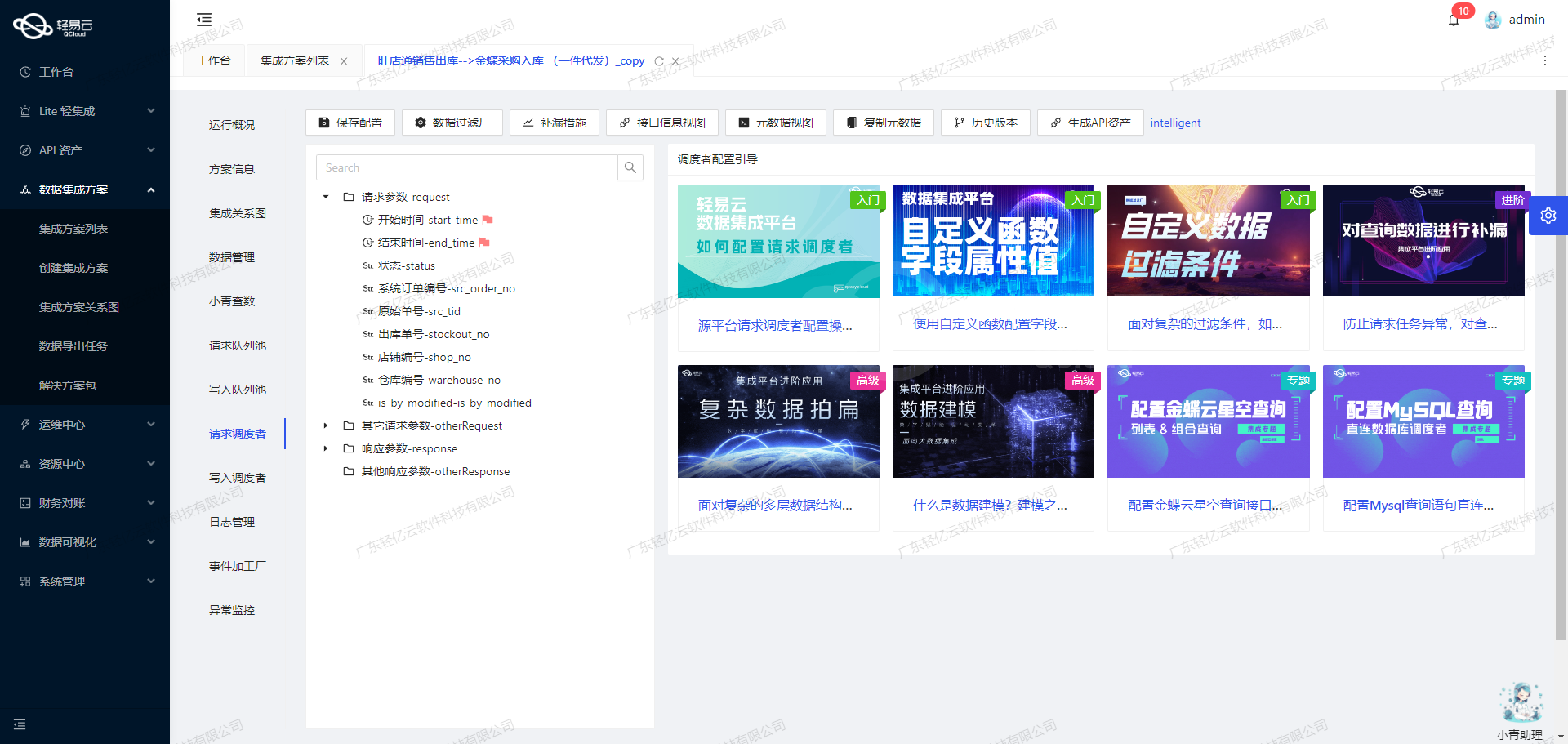

自定义数据转换逻辑: 通过轻易云提供的可视化数据流设计工具,对从吉客云获取的数据进行清洗、转换,适配目标系统要求。所有转换逻辑均根据业务需求进行了精细调整,以保证最终输出符合预期格式。

-

错误重试机制: 在实际操作过程中,不可避免会遇到网络延迟或服务器异常等情况。为此,实现了一套健壮的错误捕获与重试机制,一旦发现某次请求失败,就会自动记录日志并二次尝试直至成功,这极大提高了整体流程的稳定性。

-

实时监控和告警: 利用集中监控系统,对整个数据集成过程进行实时追踪,包括各个环节的状态以及性能指标。一旦检测到异常状况,会立即触发告警通知相关人员及时干预排查,确保不会因小故障而导致全局停摆。

-

统一管理 API 资产: 集合API资产管理功能,通过一个统一视图掌握所有资源使用情况,使得企业能够更加有效地优化配置,实现资源最大化利用,同时简化日常维护工作,提高运营效率。

通过上述步骤及措施,本次对接不仅达到了预期效果,还显著提升了业务部门对于库存动态变化应对能力。在下一部分内容中,将详细介绍具体实现方案,请继续关注后续章节。

调用吉客云接口erp.storage.goodsdocout.v2获取并加工数据

在数据集成的生命周期中,第一步是从源系统获取数据,并对其进行初步加工。本文将详细探讨如何通过轻易云数据集成平台调用吉客云接口erp.storage.goodsdocout.v2,以获取并处理出库单相关的数据。

API接口配置

首先,我们需要了解API接口的基本配置和参数。根据提供的元数据配置,以下是调用该API所需的主要参数:

- api:

erp.storage.goodsdocout.v2 - method:

POST - effect:

QUERY - id:

goodsdocNo - number:

goodsdocNo

请求参数详解

请求参数是调用API的关键部分,它们决定了我们能够获取到哪些数据。以下是主要的请求参数及其配置:

- pageIndex(分页页码)和 pageSize(分页页数):用于控制分页请求,默认每页返回50条记录。

- goodsDocNo(出库单号):用于指定具体的出库单号。

- startDate 和 endDate:分别表示创建时间的起始和结束时间。

startDate使用上次同步时间,而endDate使用当前时间。 - inouttype(类型):固定为“207”,表示组装拆卸出库。

- sourceBillNo(来源单号)、warehouseCode(仓库编号)、vendCode(供应商编号)、billNo(上游单据号)、userName(创建人名称)、outBillNo(外部单号):这些字段用于进一步过滤和细化查询结果。

- gmtModifiedStart 和 gmtModifiedEnd:主表更新时间起始和截至,用于增量更新。

- selelctFields:指定返回参数,包括

goodsdocNo,inOutDate,gmtCreate,sourceBillNo,inouttype,vendCustomerCode,warehouseCode,warehouseName,inOutReason,redStatus,financeBillStatus。 - redStatus:红冲状态,固定值为“1”。

自动填充响应与条件过滤

在元数据配置中,设置了自动填充响应和条件过滤:

- autoFillResponse=true:表示自动填充响应字段,这有助于简化后续的数据处理步骤。

- 条件过滤设置了红冲状态必须为“1”,确保只获取到符合条件的数据。

数据请求与清洗

通过上述配置,我们可以构建一个完整的API请求。以下是一个示例请求体:

{

"pageIndex": "1",

"pageSize": "50",

"startDate": "{{LAST_SYNC_TIME|datetime}}",

"endDate": "{{CURRENT_TIME|datetime}}",

"inouttype": "207",

"selelctFields": "goodsdocNo,inOutDate,gmtCreate,sourceBillNo,inouttype,vendCustomerCode,warehouseCode,warehouseName,inOutReason,redStatus,financeBillStatus",

"redStatus": "1"

}在实际操作中,可以通过轻易云平台的可视化界面进行这些参数的配置,并实时监控数据流动和处理状态。

数据转换与写入

一旦成功获取到数据,需要对其进行必要的转换和清洗。例如,将日期格式统一、字段重命名等。然后,将处理后的数据写入目标系统或数据库中。

在这个过程中,可以利用轻易云平台提供的数据转换工具,如映射、聚合、过滤等功能,以确保数据符合业务需求。

定时任务与增量更新

为了保持数据的一致性和实时性,可以设置定时任务来定期调用该API。例如,通过crontab表达式设置每天凌晨2点9分执行一次:

{

"crontab": "9 2 * * *"

}同时,通过增量更新机制,只获取最近三天内的数据:

{

"takeOverRequest": [

{

"field": "startDate",

"value": "_function FROM_UNIXTIME( unix_timestamp() -259200 , '%Y-%m-%d %H:%i:%s' )"

}

]

}以上内容详细介绍了如何通过轻易云数据集成平台调用吉客云接口erp.storage.goodsdocout.v2,以获取并加工出库单相关的数据。这一步骤是整个数据集成生命周期中的关键环节,为后续的数据转换与写入奠定了基础。

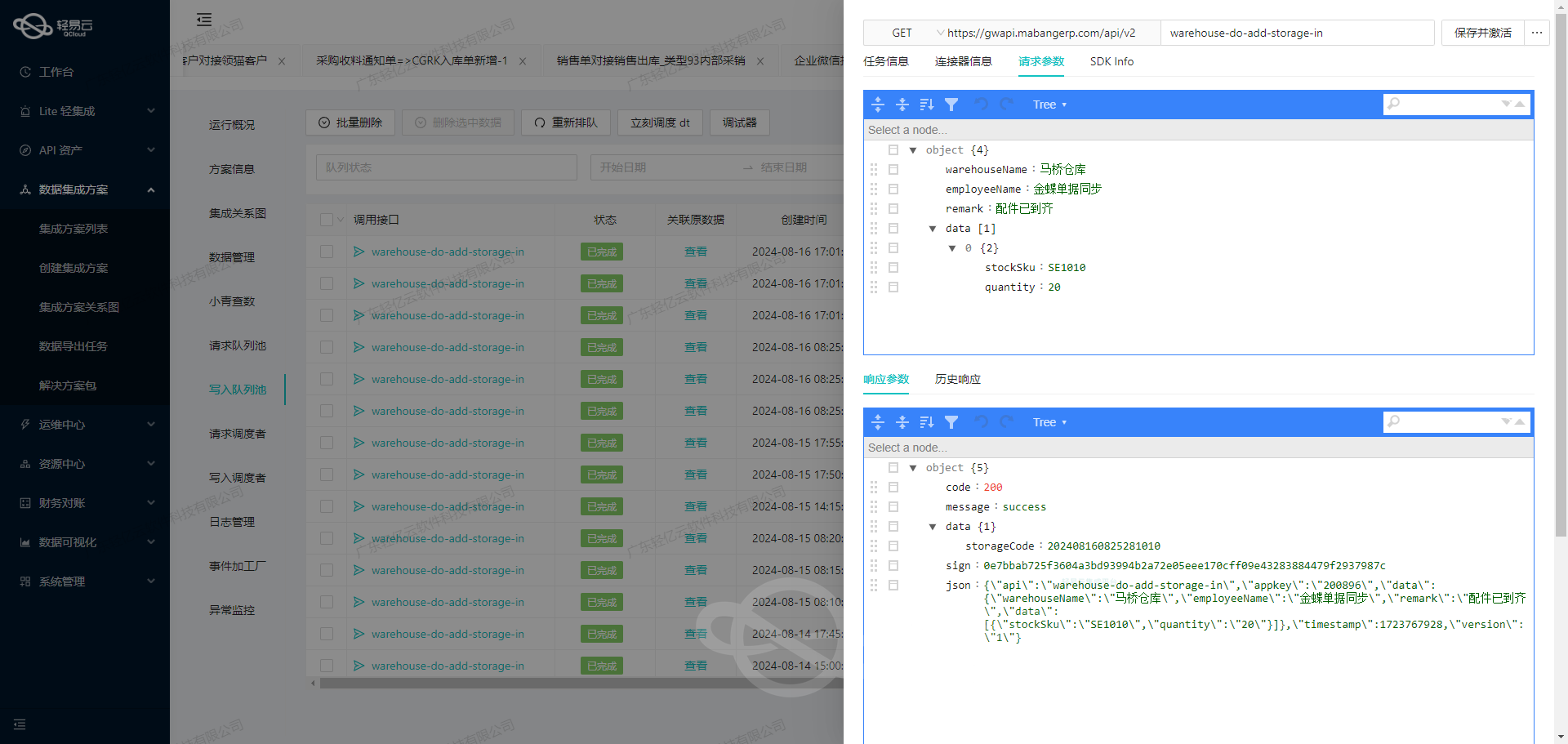

使用轻易云数据集成平台进行ETL转换并写入目标平台

在数据集成过程中,ETL(Extract, Transform, Load)是关键的一步。本文将重点探讨如何利用轻易云数据集成平台,将已经集成的源平台数据进行ETL转换,转为目标平台API接口所能够接收的格式,并最终写入目标平台。

API接口配置

在本案例中,我们的目标是更新组装拆卸单的出库时间。为此,我们需要使用轻易云提供的UpdateStrategyData API接口。以下是该接口的元数据配置:

{

"api": "UpdateStrategyData",

"effect": "EXECUTE",

"method": "POST",

"idCheck": true,

"request": [

{"field": "updateKeys", "label": "updateKeys", "type": "string", "value": "outDatetime"},

{"field": "updateValues", "label": "updateValues", "type": "string", "value": "{inOutDate}"},

{"field": "updateTypes", "label": "updateTypes", "type": "string", "value": "string"}

],

"otherRequest": [

{"field": "strategy_id", "label": "目标方案ID", "type": "string",

"value":"17441eb0-0e8c-3c97-b590-c0cf195d2bec"},

{"field":"whereKeys","label":"whereKeys","type":"string","value":"content.assNo"},

{"field":"whereValues","label":"whereValues","type":"string","value":"{sourceBillNo}"},

{"field":"whereType","label":"whereType","type":"string","value":"string"}

]

}数据请求与清洗

在数据请求阶段,我们从源系统中提取相关数据,如出库时间和单据编号。这些数据通常以JSON或XML格式存储,并通过API或数据库查询获取。

{

"sourceBillNo": ["12345"],

"inOutDate": ["2023-10-01T12:00:00Z"]

}数据转换与写入

-

数据转换:根据元数据配置,将提取的数据转换为目标API所需的格式。在本例中,我们需要将

inOutDate字段映射到updateValues,并将sourceBillNo字段映射到whereValues。 -

构建请求体:根据元数据配置构建HTTP POST请求体。

{

"strategy_id":

"17441eb0-0e8c-3c97-b590-c0cf195d2bec",

"updateKeys":["outDatetime"],

"updateValues":["2023-10-01T12:00:00Z"],

"updateTypes":["string"],

...

}- 发送请求:使用HTTP客户端(如Postman、curl或编程语言中的HTTP库)发送POST请求到目标API。

import requests

url = 'https://api.qingyiyun.com/UpdateStrategyData'

headers = {'Content-Type': 'application/json'}

data = {

'strategy_id': '17441eb0-0e8c-3c97-b590-c0cf195d2bec',

'updateKeys': ['outDatetime'],

'updateValues': ['2023-10-01T12:00:00Z'],

'updateTypes': ['string'],

'whereKeys': ['content.assNo'],

'whereValues': ['12345'],

'whereType': ['string']

}

response = requests.post(url, json=data, headers=headers)

print(response.json())数据验证与监控

为了确保数据正确写入目标平台,需要进行验证和监控。可以通过以下几种方式实现:

- 日志记录:记录每次API调用的请求和响应,以便后续排查问题。

- 状态监控:利用轻易云的数据流监控功能,实时跟踪每个环节的数据流动和处理状态。

- 异常处理:设置异常处理机制,捕获并处理可能出现的错误,如网络超时、数据格式错误等。

通过以上步骤,我们成功地将源平台的数据进行了ETL转换,并写入了目标平台。这一过程不仅提高了业务透明度和效率,也确保了数据的一致性和准确性。