小蜜蜂读写测试:小蜜蜂WMS数据集成案例分享

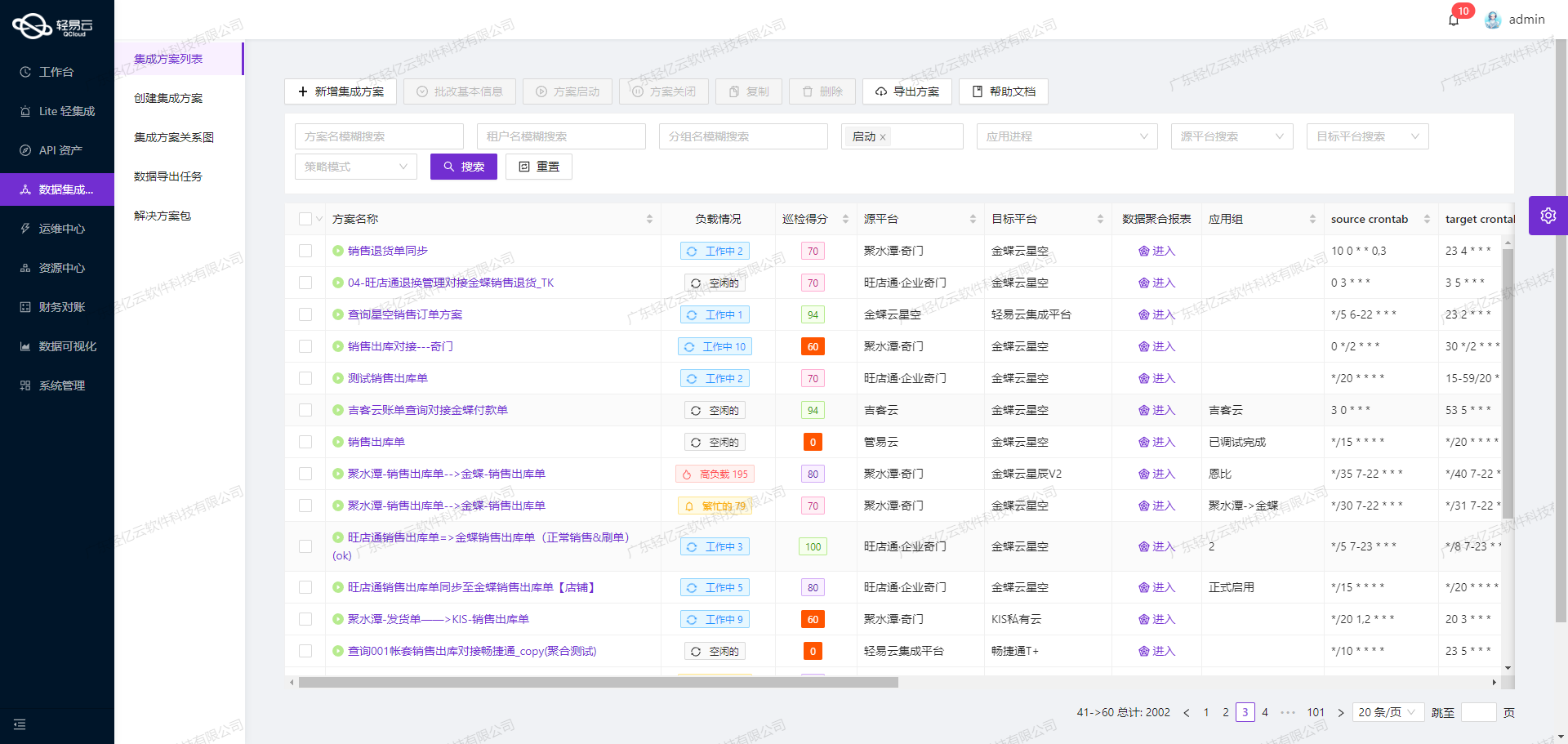

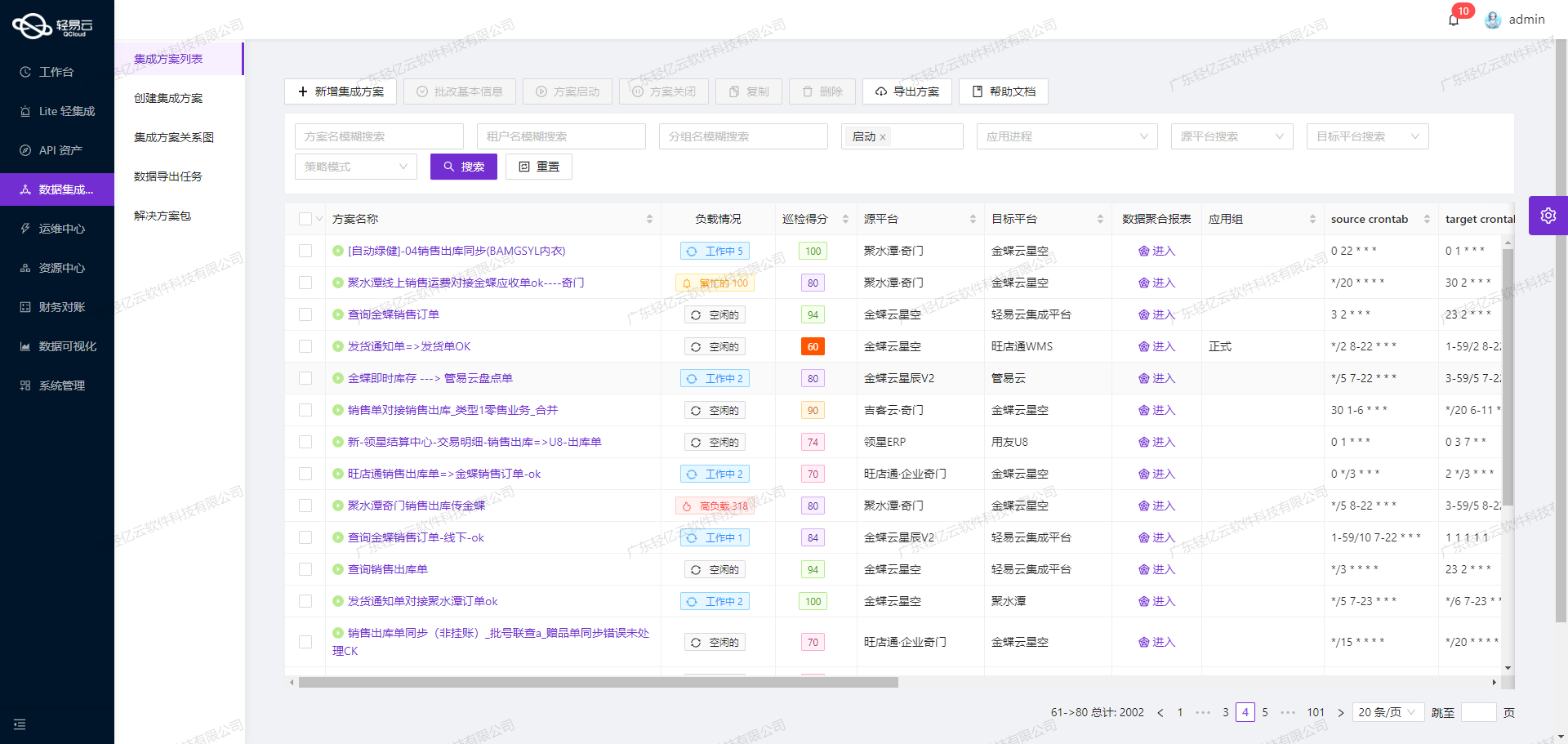

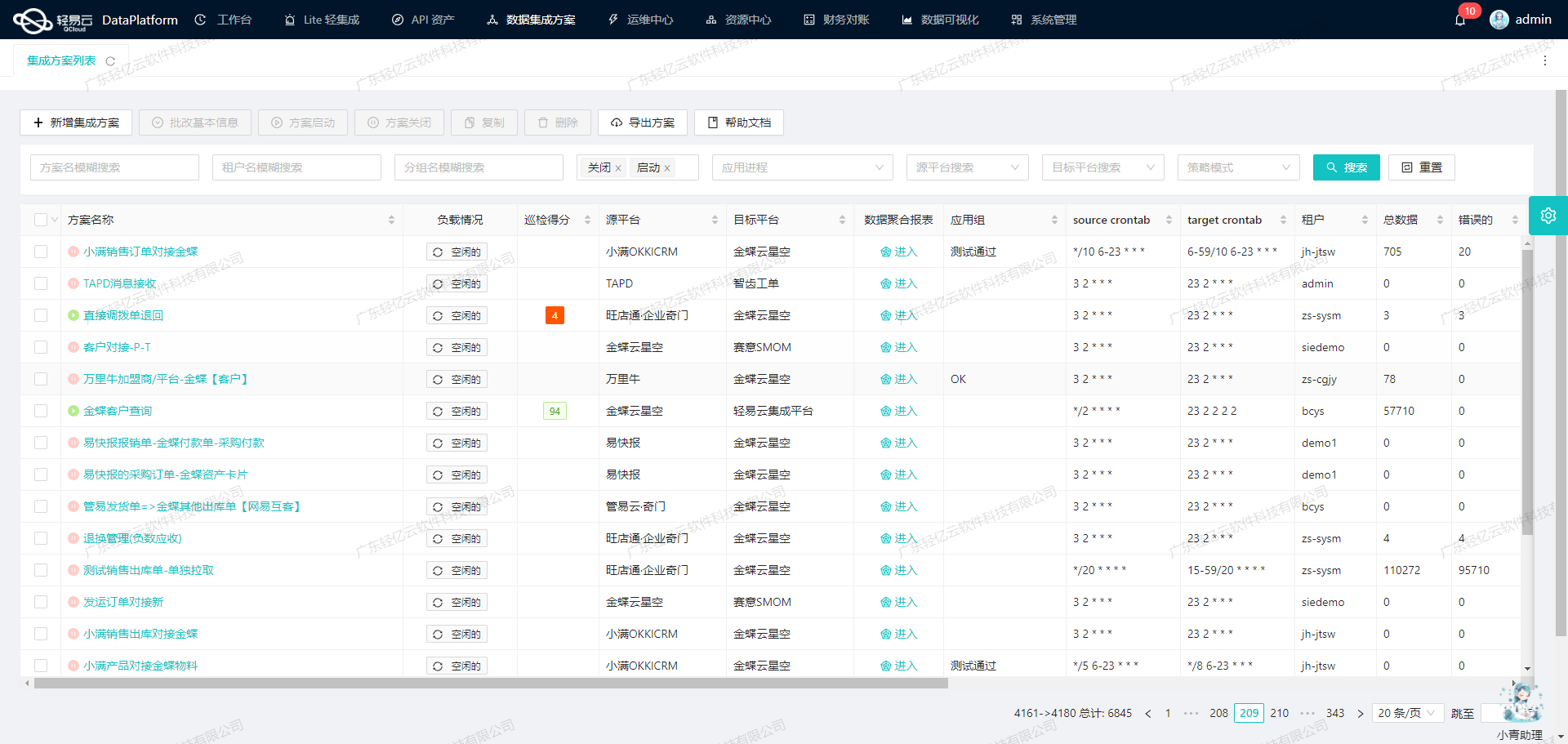

在本次技术案例中,我们将深入探讨如何通过轻易云数据集成平台,实现小蜜蜂WMS系统的数据高效对接与集成。具体来说,我们的目标是将小蜜蜂WMS的数据无缝读取并写入到同一系统中,确保数据处理的时效性和准确性。

数据获取与写入接口

为了实现这一目标,我们主要利用了两个关键API接口:

- 获取数据的API:

/customers/v4/page - 写入数据的API:

/customers/v4

这两个接口分别负责从小蜜蜂WMS系统中抓取客户信息,并将处理后的数据重新写回到系统中。

高吞吐量的数据写入能力

在实际操作过程中,支持高吞吐量的数据写入能力显得尤为重要。通过轻易云平台,我们能够快速地将大量客户信息批量导入到小蜜蜂WMS系统中,大大提升了整体数据处理效率。

实时监控与告警机制

为了确保整个数据集成过程的顺利进行,实时监控和告警机制被充分应用。轻易云平台提供了集中化的监控和告警系统,可以实时跟踪每个数据集成任务的状态和性能。一旦出现异常情况,系统会立即发出告警通知,从而及时采取相应措施,避免因数据问题导致业务中断。

自定义数据转换逻辑

在实际业务场景中,不同系统之间的数据格式往往存在差异。为了解决这一问题,我们利用了自定义数据转换逻辑功能,使得我们能够根据特定业务需求,对获取到的数据进行灵活转换,以适应目标平台的小蜜蜂WMS的数据结构要求。

数据质量监控与异常检测

此外,为了保证最终写入的小蜜蜂WMS中的数据质量,我们还引入了全面的数据质量监控和异常检测机制。这一功能使我们能够及时发现并处理任何潜在的数据问题,确保每一条记录都准确无误地完成迁移。

通过以上几个关键特性的结合应用,本次“小蜜蜂读写测试”方案不仅实现了高效、可靠的小蜜蜂WMS系统内外部数据对接,还为后续更多复杂场景下的数据集成提供了宝贵经验。在接下来的章节中,我们将详细介绍具体实施步骤及技术细节。

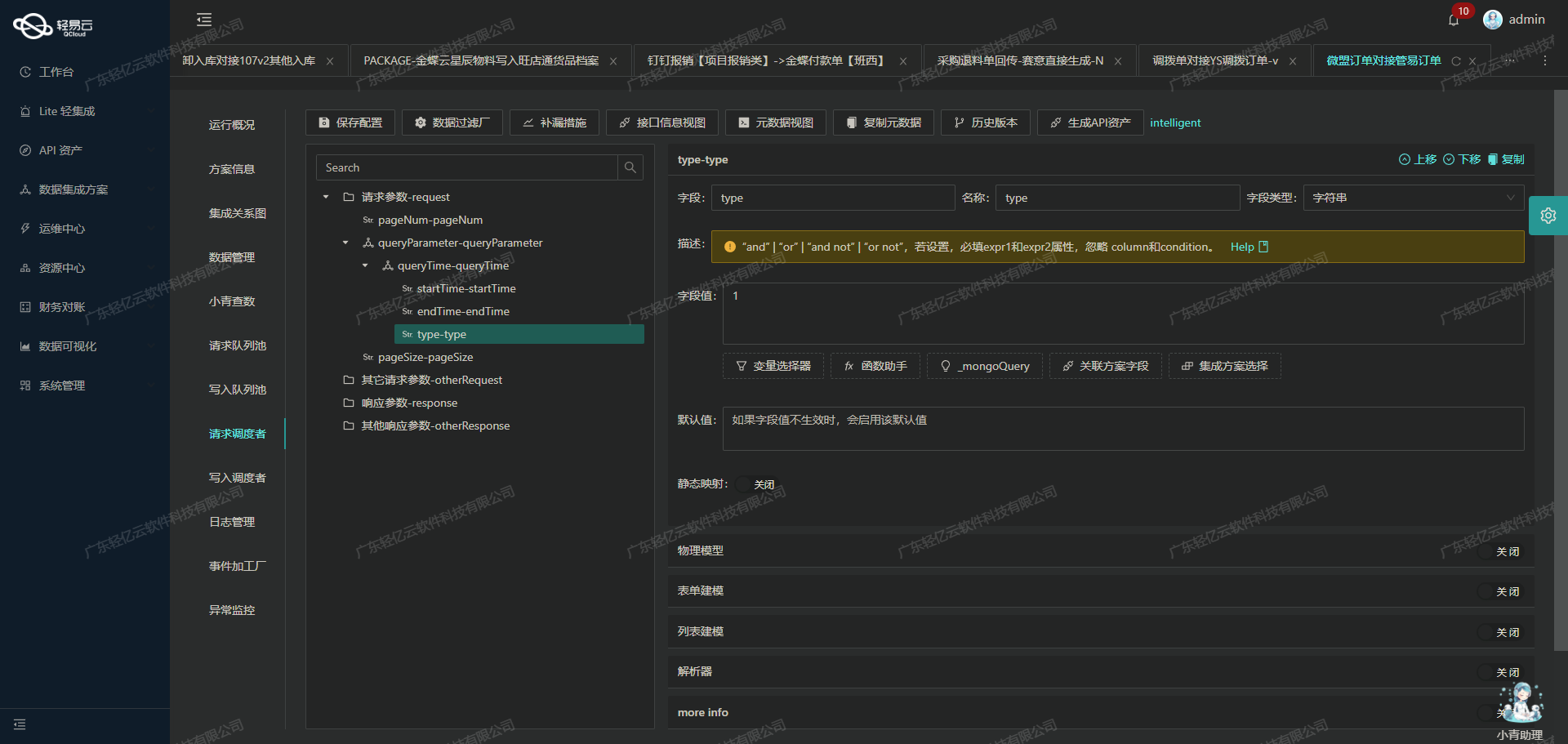

调用小蜜蜂WMS接口/customers/v4/page获取并加工数据

在轻易云数据集成平台的生命周期中,调用源系统接口是至关重要的一步。本文将深入探讨如何通过调用小蜜蜂WMS接口/customers/v4/page来获取并加工数据。

接口配置与调用

首先,我们需要配置元数据以便正确调用小蜜蜂WMS的API。根据提供的元数据配置,可以看到该API使用GET方法,并且支持分页查询。以下是关键参数:

- api:

/customers/v4/page - method:

GET - pagination: 支持分页,每页显示100条记录

- request参数:

page: 当前页码limit: 每页显示条数customerName: 客户名称(可选)customerCode: 客户编码(可选)

这些参数确保了我们能够灵活地控制请求的数据量和内容。

数据请求与清洗

在实际操作中,首先需要构建HTTP请求,包含必要的分页信息和过滤条件。例如:

GET /customers/v4/page?page=1&limit=100&customerName=&customerCode=通过这种方式,我们可以从小蜜蜂WMS系统中批量获取客户信息。在接收到响应后,需要对数据进行初步清洗,以确保其格式和内容符合后续处理要求。这一步通常包括:

- 字段映射与转换:将API返回的数据字段映射到内部标准字段,例如,将

customerId映射为内部使用的ID。 - 数据验证与过滤:检查每条记录是否包含必要的信息,如客户ID和名称。如果缺失,则标记为异常或丢弃。

- 去重处理:如果启用了

idCheck,则需要确保没有重复的客户ID。

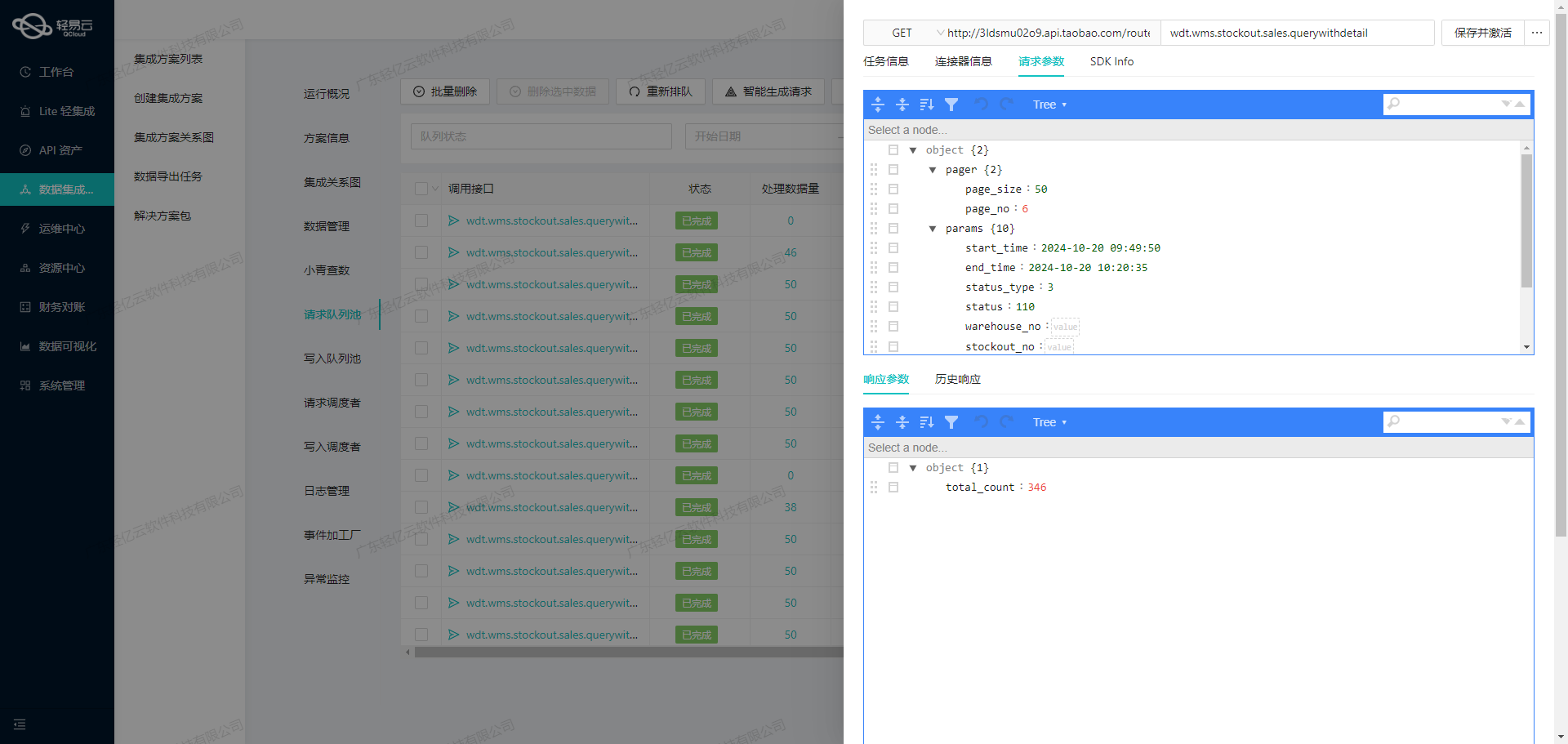

分页处理与限流

由于API支持分页,因此我们需要实现自动化的分页处理机制。在每次请求完成后,根据响应中的总记录数和当前页码计算下一次请求的起始位置。这种方式可以有效避免一次性加载大量数据导致的性能问题。此外,还需考虑限流策略,以防止过多频繁请求导致被封禁。

异常处理与重试机制

在实际操作过程中,不可避免会遇到网络波动或服务端错误。因此,需要设计健壮的异常处理机制,包括但不限于:

- 网络超时重试:当网络超时或连接失败时,自动重试一定次数。

- 错误日志记录:详细记录每次失败的原因,以便后续分析和优化。

- 告警通知:当出现连续多次失败时,通过告警系统通知相关人员及时干预。

数据质量监控

为了确保集成过程中的数据质量,可以利用平台提供的数据质量监控功能。实时跟踪每个步骤的数据状态,及时发现并解决潜在问题。例如,通过设置阈值监控某些关键字段,当超过设定范围时触发告警。

实现高效的数据写入

最后,在完成所有清洗、转换和验证步骤后,将整理好的数据写入目标系统。轻易云平台支持高吞吐量的数据写入能力,使得大量客户信息能够快速、安全地导入到小蜜蜂WMS系统中,从而提升整体业务效率。

通过上述步骤,我们可以高效、可靠地从小蜜蜂WMS接口获取并加工客户数据,为后续的数据集成奠定坚实基础。这不仅提高了业务透明度,也显著提升了整体运营效率。

集成数据写入目标平台:小蜜蜂WMS

在数据集成生命周期的第二步,核心任务是将已经集成的源平台数据进行ETL转换,并最终写入目标平台——小蜜蜂WMS。轻易云数据集成平台提供了一系列工具和特性,确保这一过程高效、可靠且可监控。

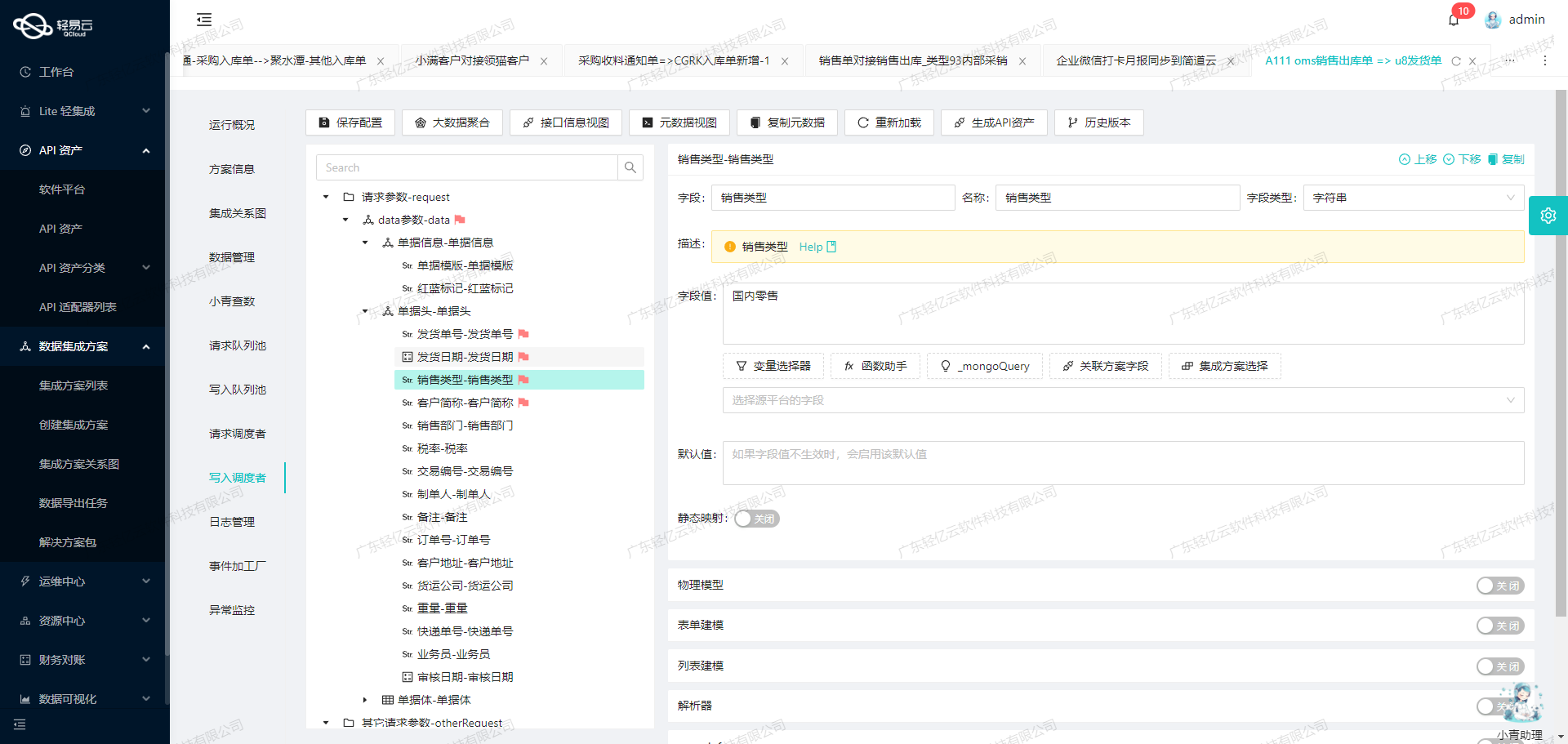

数据转换与映射

为了实现数据从源平台到小蜜蜂WMS的无缝对接,首先需要对数据进行转换和映射。我们利用元数据配置来定义API接口参数及其对应的数据类型和标签。以下是部分元数据配置示例:

{

"api": "/customers/v4",

"method": "POST",

"idCheck": true,

"request": [

{"field": "customerCode", "label": "客户编码", "type": "string", "value": "test"},

{"field": "customerName", "label": "客户名称", "type": "string", "value": "test"},

{"field": "contactName", "label": "联系人", "type": "string", "value": "test"},

{"field": "contactMobilePhone", "label": "联系人手机", "type": "string"}

// 省略其他字段

]

}通过这些配置,我们可以明确每个字段的属性和类型,确保在ETL过程中能够准确地进行数据转换。

数据清洗与质量监控

在进行数据转换之前,需要对原始数据进行清洗,以保证数据的完整性和准确性。轻易云平台支持自定义的数据清洗规则,可以根据业务需求去除冗余信息、修正错误数据以及填补缺失值。同时,内置的数据质量监控功能可以实时检测异常,及时处理潜在问题。

数据转换逻辑

在实际操作中,我们通常需要自定义复杂的数据转换逻辑。例如,将多个源字段组合成一个目标字段,或者根据业务规则对某些字段进行重新计算。以下是一个简单的示例:

def transform_data(source_data):

target_data = {}

target_data['customerCode'] = source_data.get('code', 'default_code')

target_data['customerName'] = source_data.get('name', 'default_name')

target_data['contactName'] = f"{source_data.get('first_name')} {source_data.get('last_name')}"

# 更多逻辑...

return target_data通过这样的转换函数,我们可以灵活地处理各种复杂的业务需求,并确保最终生成的数据符合小蜜蜂WMS API接口的要求。

批量写入与性能优化

为了应对大量数据的写入需求,轻易云平台提供了高吞吐量的数据写入能力。这意味着我们可以一次性将大量转换后的数据批量写入小蜜蜂WMS,而不会影响系统性能。此外,通过设置合理的批处理大小和并发请求数,可以进一步优化写入效率。

异常处理与重试机制

在实际操作中,不可避免会遇到网络波动、接口限流等问题。为此,我们需要设计健壮的异常处理与重试机制。当出现错误时,可以自动记录日志并触发告警,同时尝试多次重试以确保数据最终成功写入。

def write_to_wms(data):

try:

response = api_post('/customers/v4', data)

if response.status_code != 200:

raise Exception("Write failed")

except Exception as e:

log_error(e)

retry_write(data)这种机制能够显著提升系统的稳定性和可靠性,确保业务流程不中断。

实时监控与日志记录

为了全面掌握ETL过程中的各项指标,轻易云平台提供了集中监控和日志记录功能。通过可视化控制台,我们可以实时查看每个任务的状态、性能以及潜在问题,从而快速定位并解决问题。

综上所述,通过合理配置元数据、自定义转换逻辑以及优化写入策略,我们能够高效地将源平台数据转化为小蜜蜂WMS所需格式,并可靠地写入目标系统。这不仅提升了数据处理效率,也为业务决策提供了坚实的数据支持。