查询班牛补发/换货快递的数据集成案例

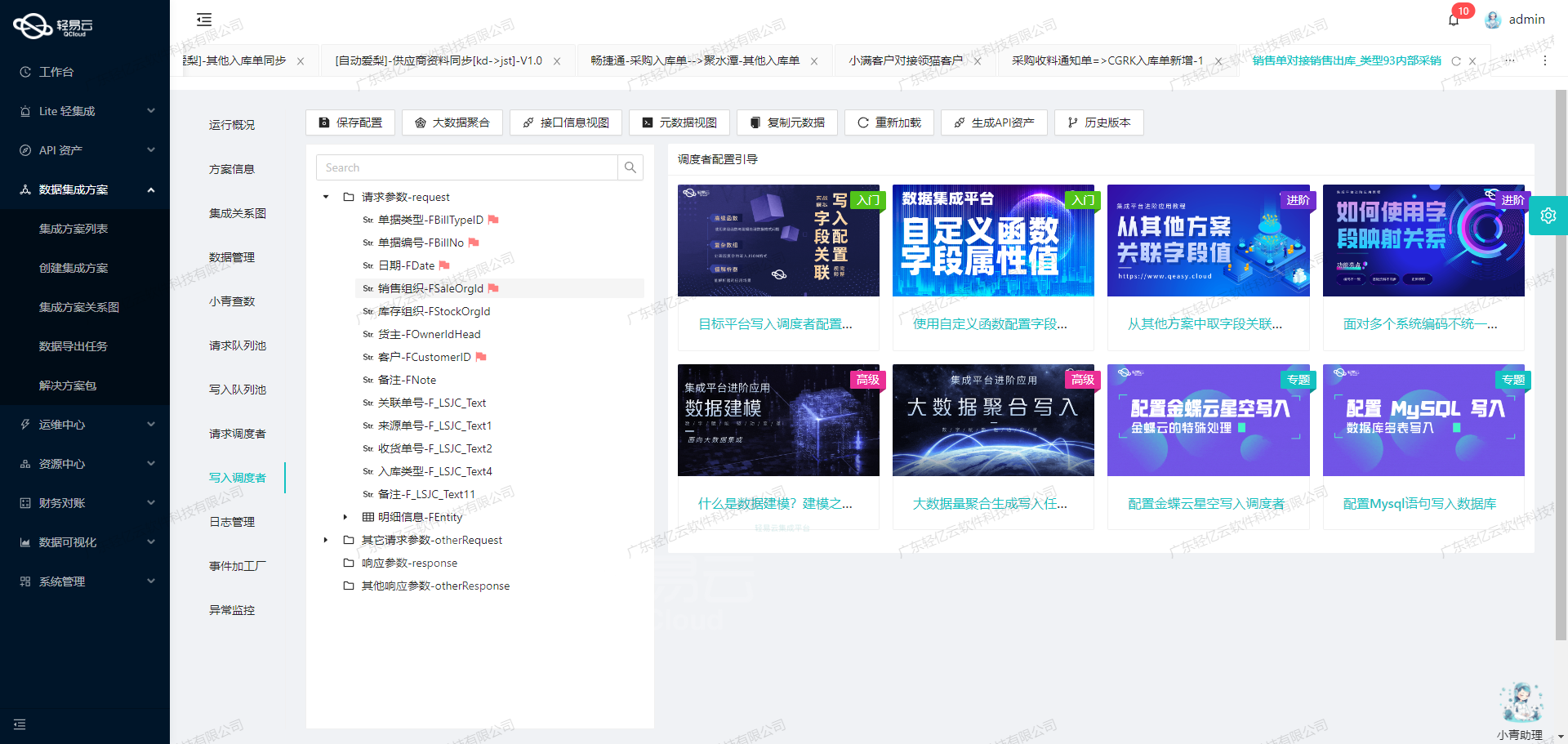

在系统集成领域,如何高效、准确地对接和处理数据是每一个技术顾问面临的核心问题。本次分享将聚焦于如何通过轻易云平台,实现班牛系统内“查询班牛补发/换货快递”的数据集成,并确保整个过程的高效率和可靠性。

这个项目的关键环节在于多个API接口调用与数据转换逻辑设计的精密结合。我们将主要利用两个API接口:用于获取基础数据的column.list API,以及向目标数据库写入处理后的信息,即通过 workflow.task.create API 进行操作。在此过程中,我们还需要解决以下几个具体问题:

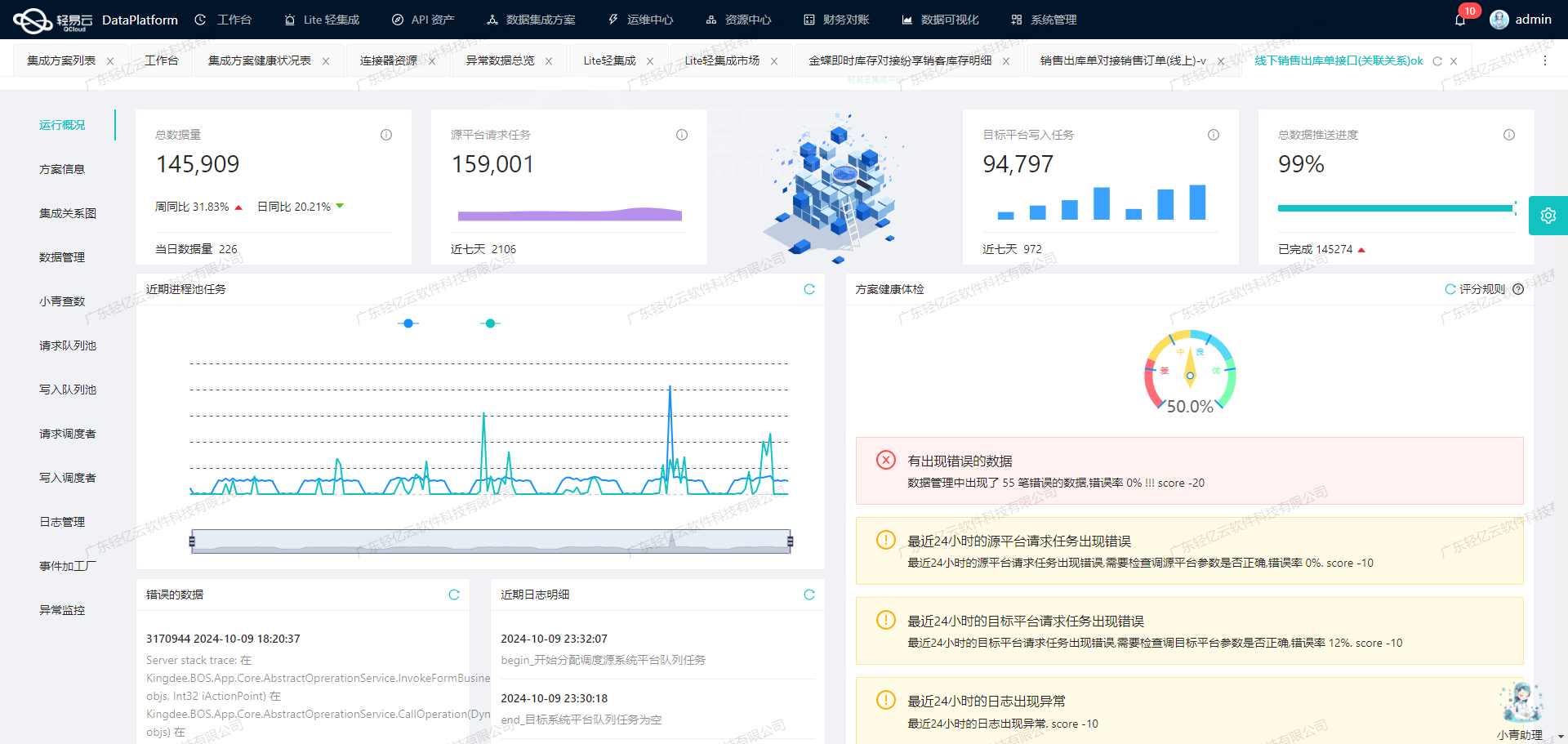

- 批量快速写入: 支持高吞吐量的数据写入能力,使得大量数据能够快速进入到班牛系统中,从而提升整体数据处理时效。

- 实时监控与日志记录: 集中的监控和告警功能,可实时跟踪任务状态并自动生成日志,便于后续排障分析。

- 自定义数据转换逻辑: 为适应特定业务需求,设置灵活且可扩展的数据转换规则,包括处理分页及限流等场景。

- 异常检测及重试机制: 数据质量监控模块能够及时发现并修正潜在问题,同时实现错误重试,提高系统稳健性。

为应对上述挑战,本方案特别注意了几点细节。例如,通过设计合理的数据抓取策略,以定时任务方式稳定地从班牛接口获取所需信息。同时,引入映射机制,将不同系统间的不一致格式进行有效转化。此外,还加入了详细的异常捕获与纠错流程,保证无论发生怎样的问题,都能尽可能减少对业务造成影响。

这只是技术实施的一部分内容,但它描绘了一幅完整的大致框架。在接下来的章节中,我们将深入探讨每个步骤,并提供具体代码示例来说明其实现过程。

调用源系统班牛接口column.list获取并加工数据

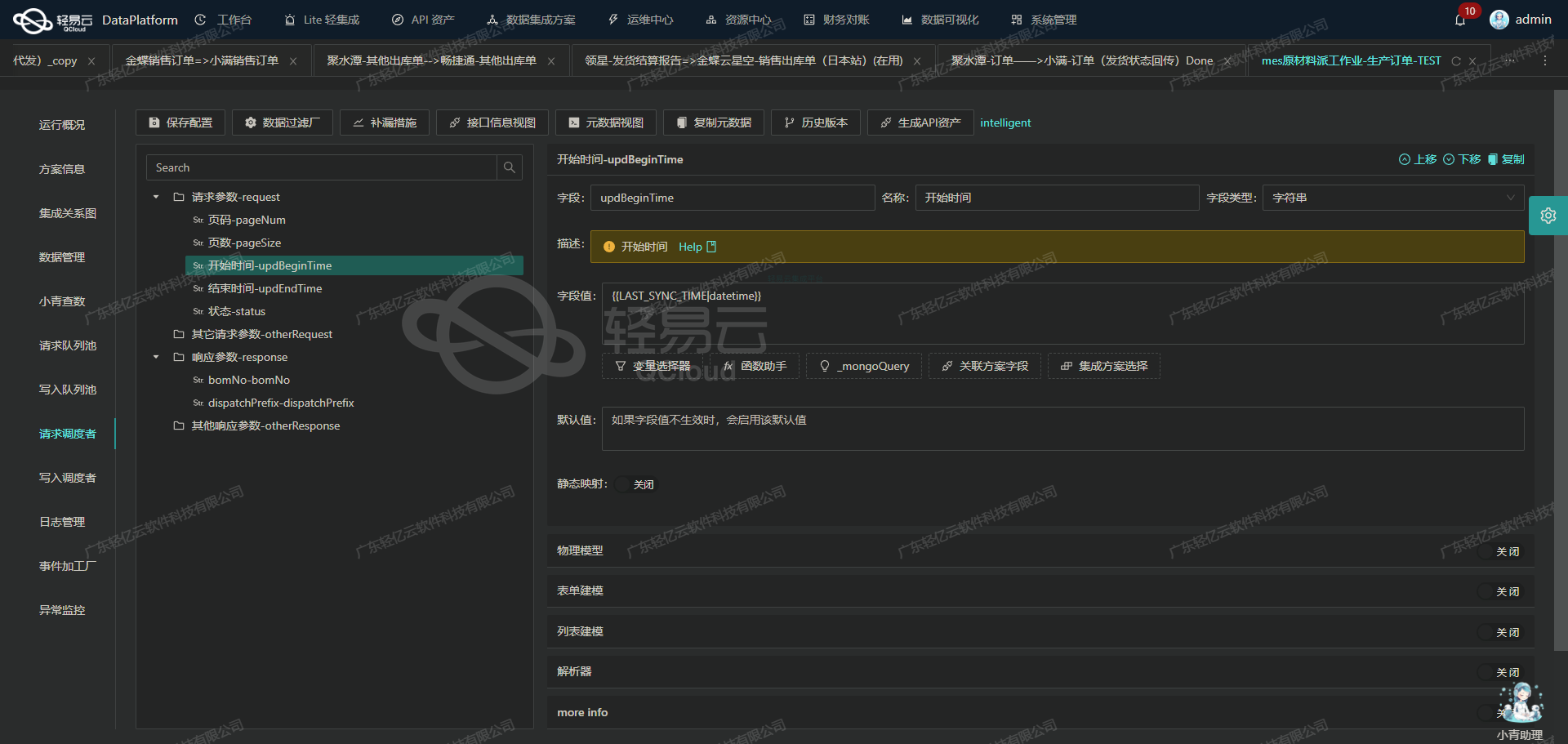

在轻易云数据集成平台的生命周期中,调用源系统接口是数据处理的第一步。本文将深入探讨如何通过调用班牛接口column.list来获取并加工数据,以实现查询班牛补发/换货快递的集成方案。

接口调用配置

首先,我们需要配置元数据以便正确调用班牛的column.list接口。以下是具体的元数据配置:

{

"api": "column.list",

"effect": "QUERY",

"method": "GET",

"number": "column_id",

"id": "column_id",

"idCheck": true,

"request": [

{

"field": "project_id",

"label": "project_id",

"type": "string",

"value": "25821"

}

],

"buildModel": true,

"autoFillResponse": true,

"condition": [

[

{

"field": "column_id",

"logic": "eqv2",

"value": "26644"

}

]

],

"beatFlat": ["options"]

}元数据解析与应用

-

API及方法:

api:column.listmethod:GET

我们将使用GET方法调用班牛的

column.listAPI。 -

请求参数:

project_id: 固定值为25821

请求参数中包含一个固定的项目ID,用于指定我们要查询的数据范围。

-

条件过滤:

-

condition:[ { "field": "column_id", "logic": "eqv2", "value": "26644" } ]条件过滤部分用于筛选出特定的列ID为

26644的数据。

-

-

自动填充响应:

autoFillResponse:true

自动填充响应确保我们可以直接从API响应中提取所需的数据字段。

-

模型构建:

buildModel:true

启用模型构建功能,使得返回的数据可以直接映射到预定义的数据模型中,便于后续处理。

-

扁平化处理:

beatFlat:["options"]

扁平化处理将嵌套结构中的

options字段展开,方便数据清洗和转换。

数据请求与清洗

在完成上述配置后,我们可以通过轻易云平台发起对班牛接口的请求。请求示例如下:

GET /api/column.list?project_id=25821 HTTP/1.1

Host: api.banniu.com假设返回的数据如下:

{

"data": [

{

"column_id": 26644,

"name": "快递信息",

...

// 更多字段

}

// 更多记录

]

}根据配置,平台会自动检查返回的数据是否包含符合条件的记录(即column_id = 26644),并进行必要的数据清洗和转换操作。例如,将嵌套的options字段展开为平铺结构,以便后续处理。

数据转换与写入

经过清洗后的数据将被转换为目标格式,并写入到指定的目标系统中。这一步通常包括以下操作:

- 数据类型转换:确保所有字段类型符合目标系统要求。

- 字段映射:将源系统中的字段映射到目标系统中的相应字段。

- 数据校验:对清洗后的数据进行校验,确保其完整性和准确性。

通过上述步骤,我们实现了从班牛接口获取并加工补发/换货快递信息的数据集成过程。这不仅提高了数据处理效率,还保证了数据的一致性和准确性。

使用轻易云数据集成平台进行ETL转换并写入班牛API接口的技术案例

在数据集成生命周期中,ETL(Extract, Transform, Load)转换是一个关键步骤。本文将深入探讨如何使用轻易云数据集成平台,将已经集成的源平台数据进行ETL转换,并最终写入目标平台班牛的API接口。

数据请求与清洗

首先,我们需要从源平台获取原始数据。这一步通常涉及到通过API调用、数据库查询或文件读取等方式,获取需要处理的数据。假设我们已经成功获取了这些数据,并进行了初步的清洗和标准化处理。

数据转换与写入

接下来,我们进入本文的重点:将清洗后的数据进行转换,以符合班牛API接口所需的格式,并通过API调用将其写入班牛系统。

元数据配置解析

根据提供的元数据配置:

{

"api": "workflow.task.create",

"effect": "EXECUTE",

"method": "POST",

"idCheck": true

}我们可以看到,目标API为workflow.task.create,请求方法为POST,且需要进行ID校验(idCheck: true)。

数据转换过程

-

字段映射:首先,我们需要将源平台的数据字段映射到班牛API所需的字段。例如,源平台的数据结构可能如下:

{ "order_id": "12345", "customer_name": "张三", "product_code": "P001", "quantity": 2, "address": "北京市朝阳区" }而班牛API所需的数据结构可能是:

{ "task_id": "12345", "client_name": "张三", "item_code": "P001", "item_quantity": 2, "delivery_address": "北京市朝阳区" } -

数据转换:我们需要编写一个转换函数,将源平台的数据结构转换为目标结构。示例如下:

def transform_data(source_data): return { "task_id": source_data["order_id"], "client_name": source_data["customer_name"], "item_code": source_data["product_code"], "item_quantity": source_data["quantity"], "delivery_address": source_data["address"] } -

ID校验:根据元数据配置中的

idCheck: true,我们需要确保每个任务ID是唯一且有效的。这可以通过查询目标系统中的现有任务ID来实现。如果发现重复ID,需要生成新的唯一ID。

数据写入过程

-

构建请求:使用转换后的数据构建HTTP POST请求。例如:

import requests def create_task_in_banniu(transformed_data): url = 'https://api.banniu.com/workflow/task/create' headers = {'Content-Type': 'application/json'} response = requests.post(url, json=transformed_data, headers=headers) return response.json() -

发送请求并处理响应:发送HTTP POST请求,并处理响应结果。示例如下:

transformed_data = transform_data(source_data) if id_check(transformed_data["task_id"]): response = create_task_in_banniu(transformed_data) if response.get('status') == 'success': print("Task created successfully") else: print("Failed to create task:", response.get('error')) else: print("Duplicate task ID found, generating new ID...") # Generate new ID and retry...

通过上述步骤,我们实现了从源平台到班牛系统的数据ETL转换和写入。这个过程不仅包括了字段映射和数据格式转换,还涉及到必要的ID校验和HTTP请求构建与发送。通过轻易云数据集成平台的全生命周期管理功能,可以进一步优化和自动化这些步骤,提高整体效率和透明度。