BDS对账班牛售后代发补发单(修正错误货品编码)_update

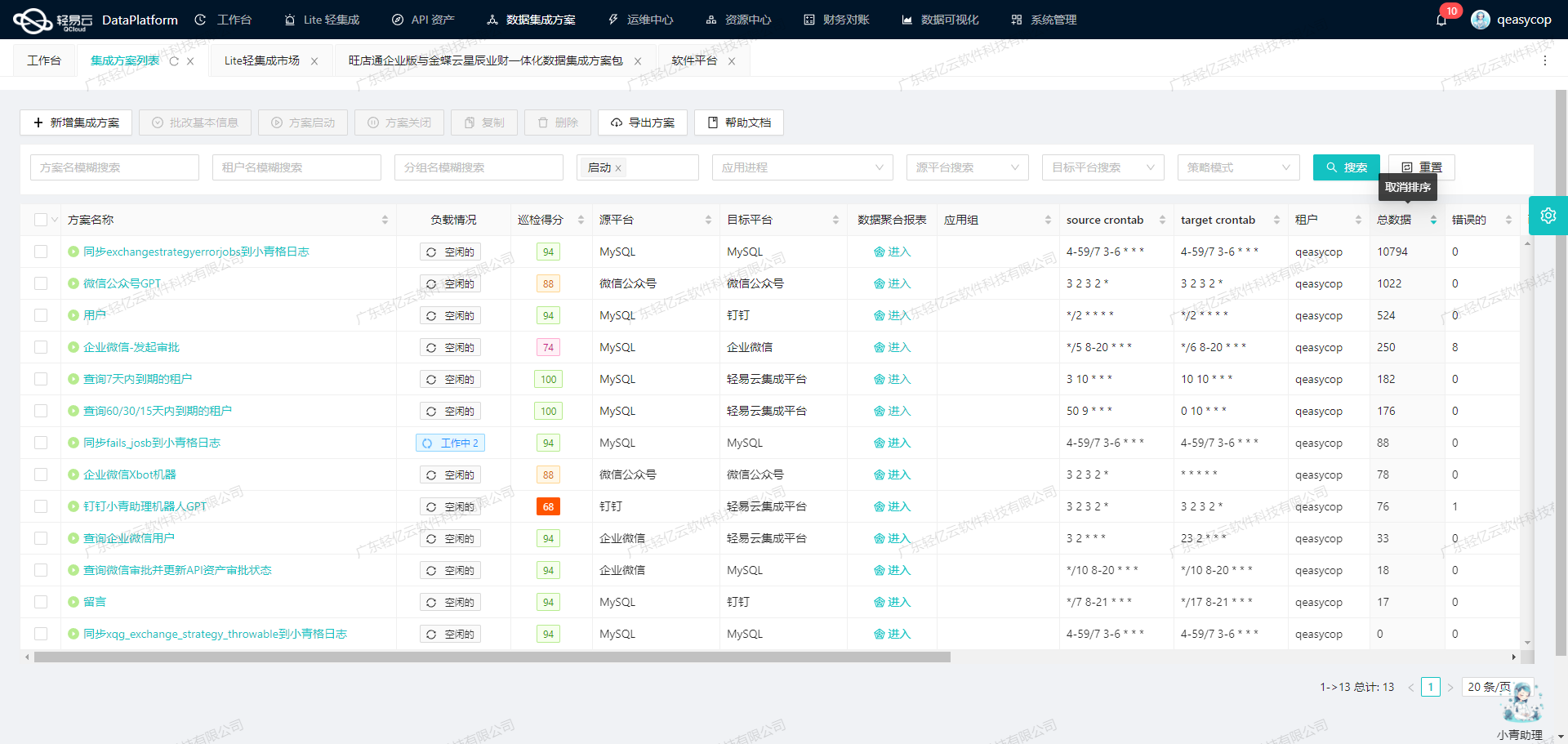

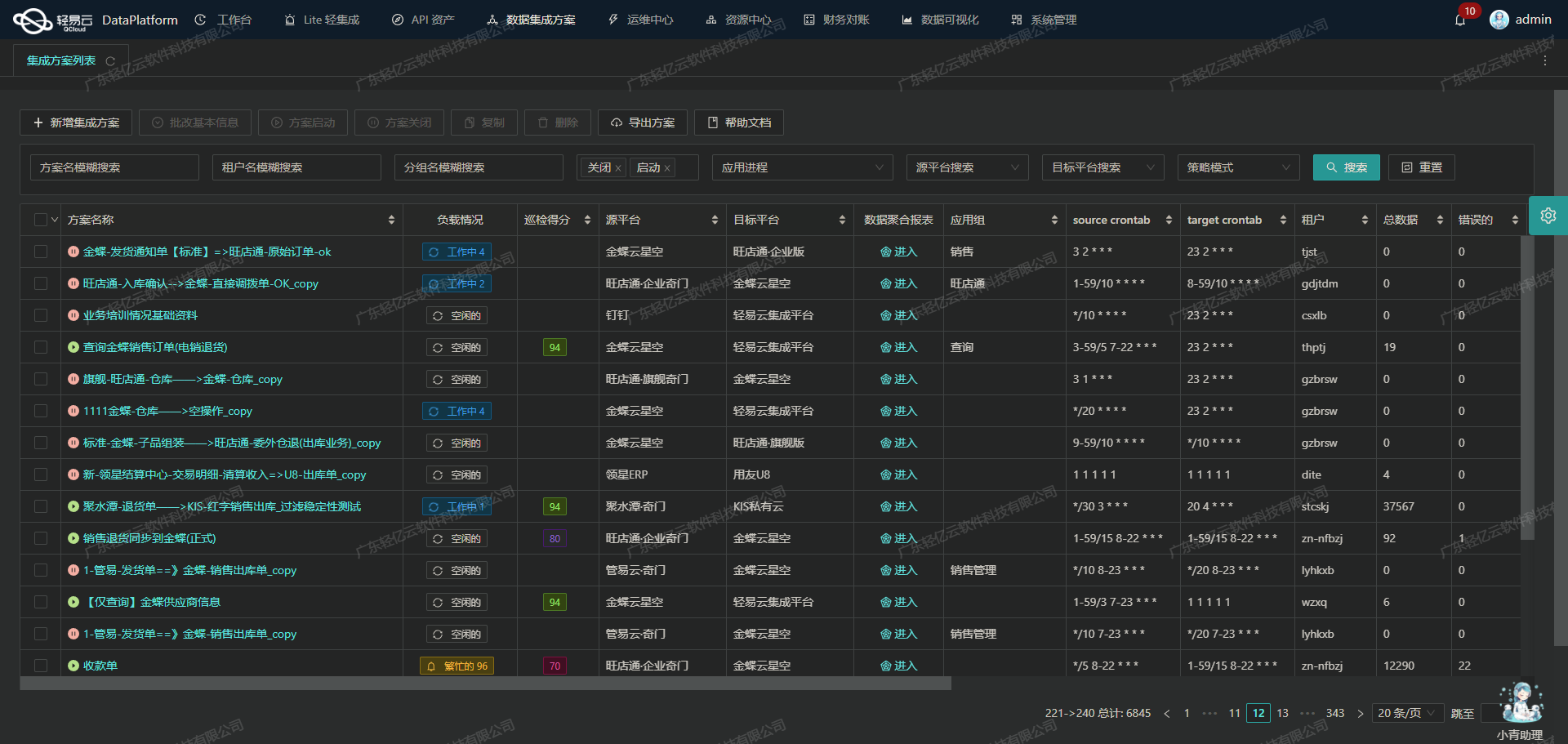

在本次技术案例中,我们将探讨如何通过轻易云数据集成平台,将班牛系统中的售后代发补发单数据高效、准确地集成到MySQL数据库中。该方案名为“BDS对账班牛售后代发补发单(修正错误货品编码)_update”,旨在解决数据对接过程中可能遇到的各种技术挑战。

首先,考虑到班牛系统的数据量大且更新频繁,我们需要确保数据的高吞吐量写入能力,以保证大量数据能够快速被集成到MySQL中,从而提升整体的数据处理时效性。同时,通过定时可靠地抓取班牛接口task.list的数据,可以确保我们获取最新的业务信息,并避免漏单现象的发生。

为了实现这一目标,轻易云平台提供了强大的集中监控和告警系统,实时跟踪每个数据集成任务的状态和性能。这不仅有助于及时发现并处理异常情况,还能通过日志记录功能,对整个数据处理过程进行详细追溯。此外,支持自定义的数据转换逻辑,使得我们可以根据具体业务需求,对原始数据进行灵活调整,以适应MySQL数据库的结构要求。

在实际操作中,我们还需特别注意处理班牛接口的分页和限流问题。通过合理设计API调用策略,可以有效避免因请求过多导致的接口响应延迟或失败。同时,为了确保数据质量,轻易云平台提供了完善的数据质量监控和异常检测机制,帮助我们及时发现并纠正潜在的数据问题。

最后,在MySQL端,我们将利用定制化的数据映射对接功能,实现与班牛系统之间的数据格式差异转换。这不仅简化了复杂的数据处理流程,还提高了整体集成效率。通过上述一系列技术手段,本方案成功实现了班牛售后代发补发单数据的高效、稳定集成,为企业提供了可靠的数据支持。

调用班牛接口task.list获取并加工数据

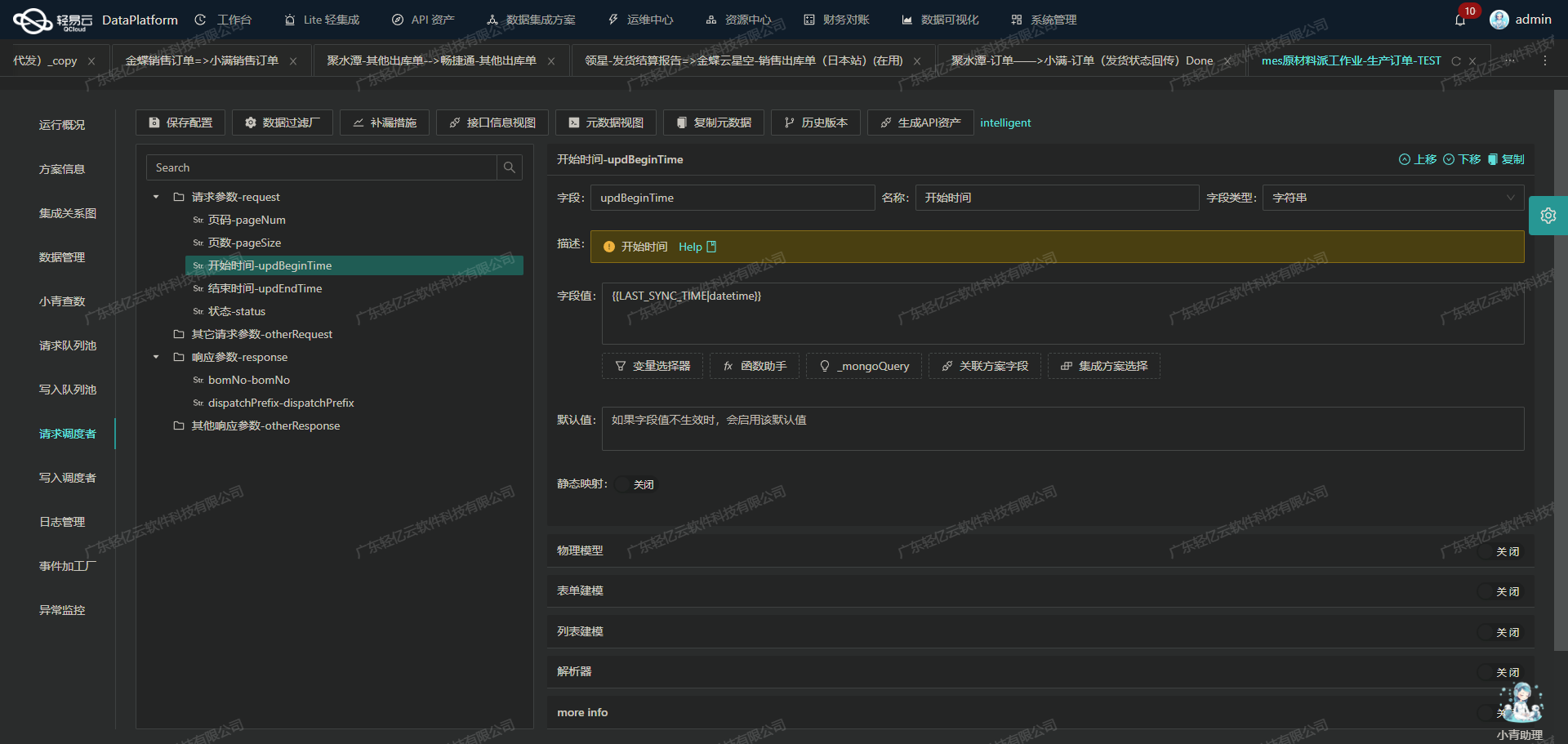

在轻易云数据集成平台的生命周期中,第一步是调用源系统班牛接口task.list来获取并加工数据。这一步骤至关重要,因为它直接影响到后续的数据转换与写入过程。以下将详细探讨如何高效地调用该接口,并处理返回的数据。

接口调用配置

首先,我们需要配置元数据,以便正确地调用班牛的task.list接口。根据提供的元数据配置,可以看到以下关键字段:

project_id: 群组ID,固定值为"77206"。page_size: 每页返回记录数,设置为"50"。page_num: 当前页码,初始值为"1"。star_created和end_created: 数据创建时间范围。star_modified和end_modified: 数据修改时间范围,其中起始时间设定为当前时间前24小时,结束时间为当前时间。

这些参数确保了我们能够分页、分时段地抓取所需的数据。

处理分页和限流问题

由于班牛接口可能会返回大量数据,因此分页处理是必不可少的。通过设置合理的page_size和逐步递增的page_num,可以有效避免一次性请求过多数据导致的性能问题。同时,为了应对API限流,可以在每次请求之间加入适当的延迟或使用重试机制。

{

"field": "page_num",

"label": "page_num",

"type": "string",

"value": "{{CURRENT_PAGE}}"

}上述配置示例展示了如何动态调整页码,以实现分页抓取。

数据清洗与转换

获取到原始数据后,需要进行清洗与转换。例如,对于货品编码错误的问题,可以在清洗过程中进行修正。此外,还可以根据业务需求自定义转换逻辑,将原始数据映射到目标数据库所需格式。

{

"field": "star_modified",

"label": "修改时间起始时间",

"type": "string",

"value": "_function DATE_FORMAT(DATE_ADD(NOW(),INTERVAL - 24 HOUR),'%Y-%m-%d %H:%i:%s')"

}如上所示,通过函数计算得到修改时间起始点,有助于精准抓取最近更新的数据。

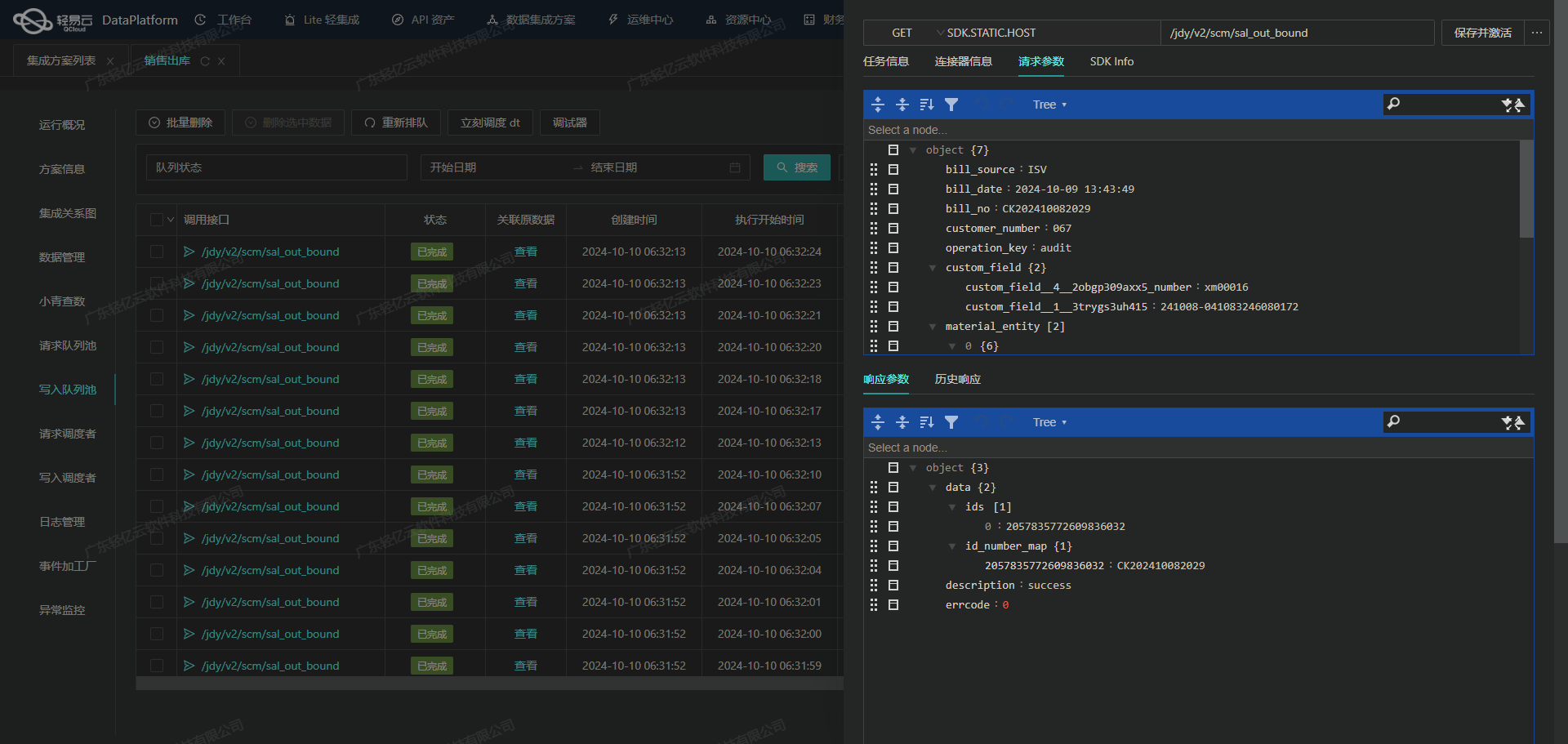

实时监控与日志记录

为了确保整个过程透明可控,轻易云平台提供了实时监控和日志记录功能。在每次API调用以及数据处理过程中,都可以生成详细日志,并通过集中监控系统实时跟踪任务状态。这不仅有助于快速定位问题,还能提高整体效率。

异常处理与重试机制

在实际操作中,不可避免会遇到各种异常情况,如网络波动、API超时等。因此,实现健壮的异常处理机制尤为重要。通过捕获异常并实施重试策略,可以大幅提升任务成功率。例如,当某次请求失败时,可自动重试三次,每次间隔一定时间,以增加成功概率。

{

"retry_count": 3,

"retry_interval": 5000

}以上配置示例展示了简单的重试机制,每次失败后等待5秒再尝试重新请求,共计三次尝试机会。

总结

通过合理配置元数据、有效处理分页和限流、执行必要的数据清洗与转换,以及借助实时监控和健壮的异常处理机制,我们能够高效且可靠地从班牛系统中获取所需数据,为后续的数据集成奠定坚实基础。这一系列技术手段不仅提升了操作效率,也保障了数据质量和一致性。

使用轻易云数据集成平台进行ETL转换并写入MySQL

在数据集成生命周期的第二步中,关键任务是将已经集成的源平台数据进行ETL转换,转为目标平台 MySQL API 接口所能够接收的格式,并最终写入目标平台。以下是具体的技术实现案例。

数据请求与清洗

首先,我们需要从班牛系统中获取原始数据。这里使用了一个名为executeReturn的API接口,通过POST方法请求数据。该接口要求传入一些必要的参数,如单据编号(bill_no)和销售渠道名称(shop_name)。这些参数通过元数据配置文件中的main_params字段指定。

{

"api": "executeReturn",

"method": "POST",

"idCheck": true,

"request": [

{

"field": "main_params",

"label": "主参数",

"type": "object",

"children": [

{

"field": "bill_no",

"label": "单据编号",

"type": "string",

"value": "{{-1}}"

},

{

"field": "shop_name",

"label": "销售渠道名称",

"type": "string",

"value": "_mongoQuery edcc99df-5589-3530-96c3-807e26f3f171 findField=content.options_title where={\"content.options_id\":{\"$eq\":\"{{77214}}\"}}"

}

]

}

]

}在这个配置中,bill_no直接从上下文变量中获取,而shop_name则通过MongoDB查询来动态获取。

数据转换与写入

接下来,我们需要将获取到的数据进行转换,以符合MySQL API接口的要求。这里主要涉及到两个步骤:数据映射和格式转换。

- 数据映射:将从班牛系统获取到的数据字段映射到MySQL数据库中的相应字段。例如,将班牛系统中的

shop_name映射到MySQL中的同名字段。 - 格式转换:确保数据格式符合MySQL API接口的要求,例如字符串类型、日期格式等。

在元数据配置文件中,我们定义了一个SQL更新语句,用于将转换后的数据写入MySQL数据库:

{

"otherRequest": [

{

"field": "main_sql",

"label": "主语句",

"type": "string",

"value": "\nUPDATE `lhhy_srm`.`supplier_after_sale_send`\nSET\n`shop_name` = <{shop_name: }>\nWHERE `bill_no` = <{bill_no}>;\n"

}

],

"buildModel": true

}这里使用了参数化查询,将动态获取的shop_name和bill_no填充到SQL语句中,以确保数据安全和执行效率。

数据写入与监控

在完成ETL转换后,下一步是将处理好的数据写入MySQL数据库。这一步至关重要,需要确保高吞吐量的数据写入能力,以应对大量数据的快速处理需求。同时,集成平台提供了集中监控和告警系统,可以实时跟踪数据集成任务的状态和性能,及时发现并处理异常情况。

为了确保不漏单,我们可以设置定时任务,定期抓取班牛接口的数据,并批量写入MySQL。这不仅提高了数据处理效率,还能有效避免因网络波动或系统故障导致的数据丢失。

异常处理与重试机制

在实际操作中,难免会遇到各种异常情况,如网络超时、数据库连接失败等。为此,我们需要实现异常处理与错误重试机制。在每次执行SQL语句时,都要捕获可能出现的异常,并根据错误类型采取相应的重试策略。例如,对于网络超时,可以设置一定次数的重试;对于数据库连接失败,可以切换到备用数据库节点继续执行。

实时监控与日志记录

最后,为了全面掌握整个ETL过程,我们可以利用轻易云平台提供的实时监控与日志记录功能。通过统一的视图和控制台,可以实时查看每个任务的执行状态、性能指标以及历史日志。这不仅有助于快速定位问题,还能为后续优化提供有力的数据支持。

以上便是使用轻易云数据集成平台进行ETL转换并写入MySQL的一整套流程。从数据请求与清洗,到数据转换与写入,再到异常处理与实时监控,每个环节都至关重要,确保了整个过程高效、可靠地运行。