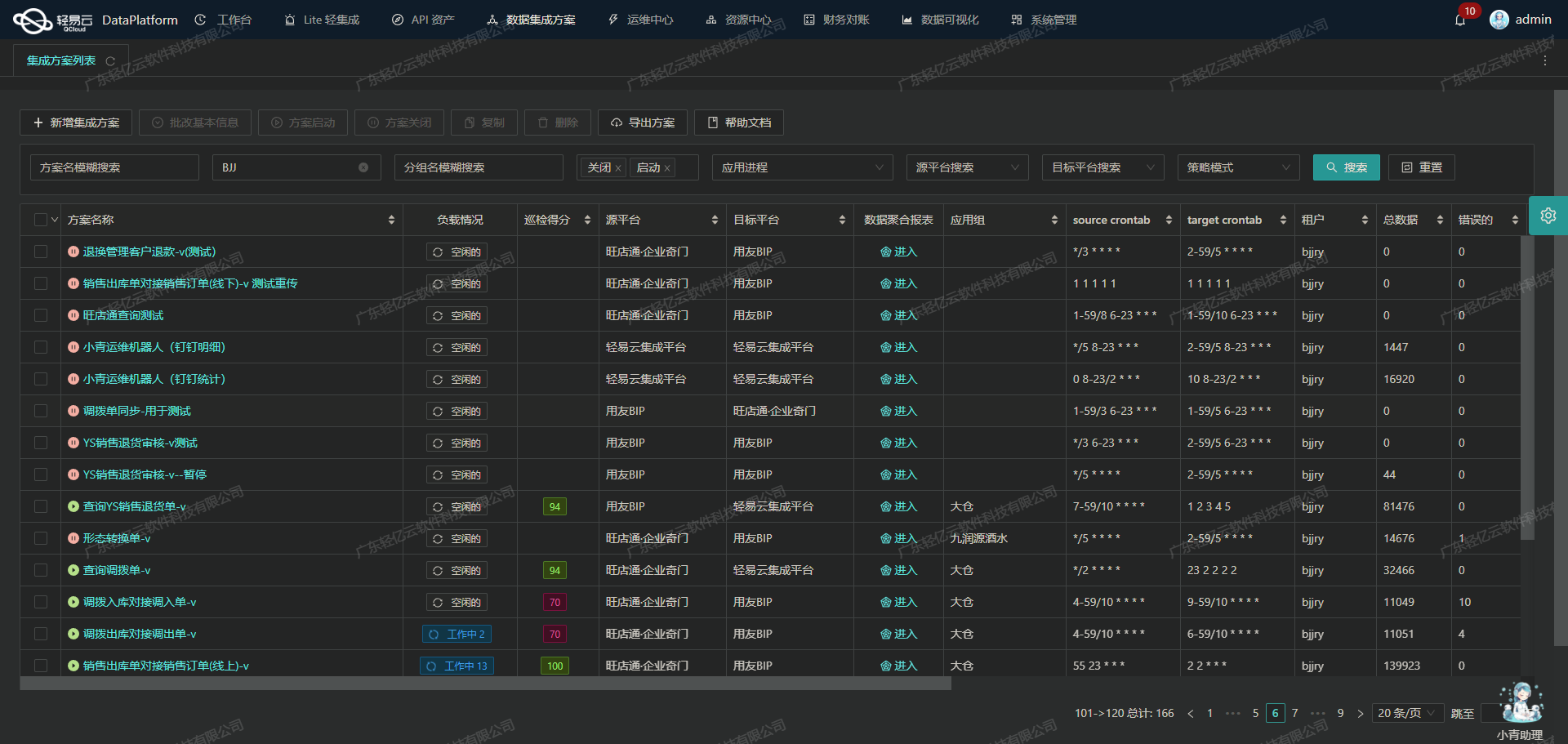

旺店通盘亏数据集成到金蝶云星空的技术实现

在企业日常运营中,数据的高效流转和准确对接是保障业务顺畅的重要环节。本文将聚焦于一个具体的系统对接集成案例:如何将旺店通·企业奇门的数据无缝集成到金蝶云星空平台,实现从盘亏数据到其他出库单的高效转换。

方案概述

本次集成方案名为“旺店通盘亏>云星空其他出库单”,旨在通过轻易云数据集成平台,将旺店通·企业奇门中的盘亏数据(通过API接口wdt.stat.stock.pd.detail.query获取)批量写入到金蝶云星空(使用API接口batchSave),确保数据处理过程透明、可靠且高效。

技术要点

-

高吞吐量的数据写入能力: 为了应对大量盘亏数据的快速写入需求,我们利用轻易云平台支持的高吞吐量特性,使得大规模数据能够迅速被集成到目标系统中,从而提升整体处理时效性。

-

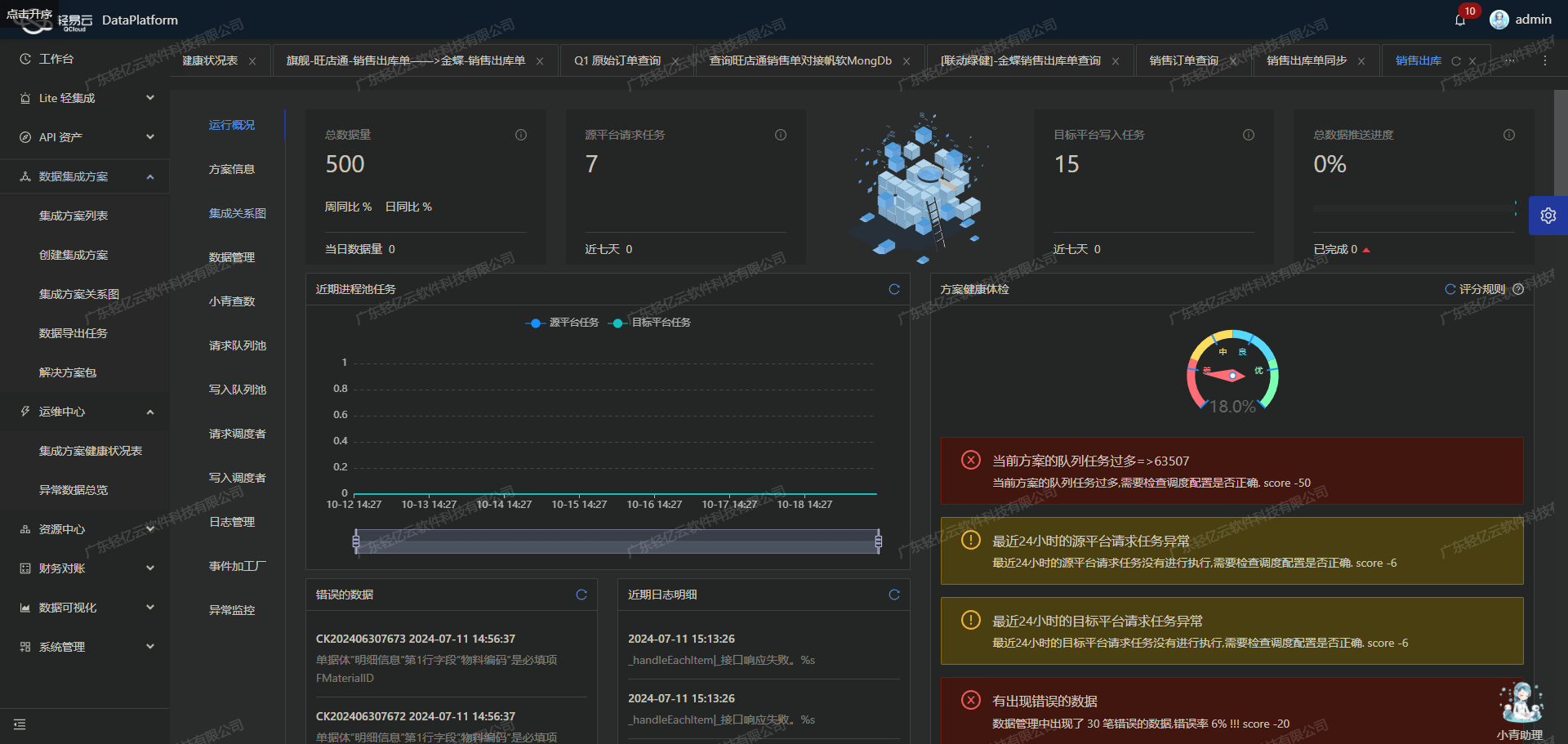

实时监控与告警系统: 集成过程中,通过集中化的监控和告警系统,实时跟踪每个任务的状态和性能。这不仅确保了任务执行过程中的透明度,还能及时发现并处理潜在问题,避免漏单现象发生。

-

自定义数据转换逻辑: 在实际操作中,由于旺店通·企业奇门与金蝶云星空之间的数据结构存在差异,我们设计了自定义的数据转换逻辑,以适应特定业务需求。这一灵活性使得我们能够精准地映射和转换各类字段,确保数据的一致性和完整性。

-

分页与限流处理: 考虑到API接口调用时可能遇到分页和限流问题,我们特别设计了相应机制来处理这些挑战。通过合理设置分页参数和限流策略,保证了数据抓取过程的稳定性和连续性。

-

异常处理与错误重试机制: 在整个对接过程中,为了提高系统的鲁棒性,我们实现了一套完善的异常处理与错误重试机制。当出现网络波动或接口调用失败等情况时,该机制能够自动进行重试操作,确保最终所有有效数据都能成功写入目标平台。

-

可视化的数据流设计工具: 轻易云提供的可视化工具,使得我们能够直观地设计和管理整个数据流。通过拖拽式操作,不仅简化了配置流程,还便于后续维护和优化,提高了整体工作效率。

以上技术要点构成了本次集成方案实施的重要基础。在接下来的章节中,我们将详细探讨每个步骤及其具体实现方法,包括如何调用相关API、处理分页与限流、以及进行异常检测等关键环节。

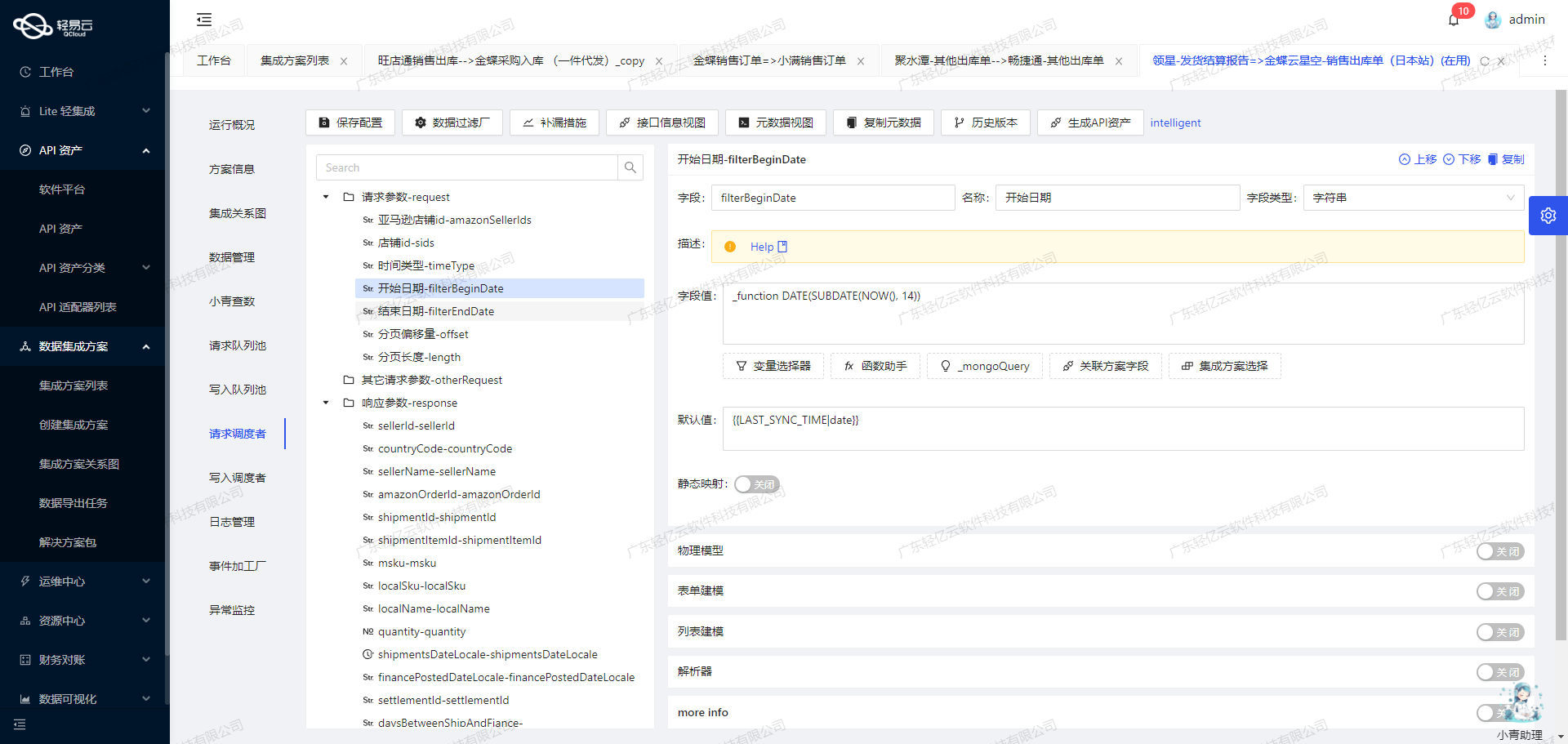

调用旺店通·企业奇门接口wdt.stat.stock.pd.detail.query获取并加工数据

在轻易云数据集成平台中,调用源系统接口是数据处理生命周期的第一步。本文将详细探讨如何通过调用旺店通·企业奇门接口wdt.stat.stock.pd.detail.query来获取盘亏数据,并进行初步加工处理。

接口调用配置

首先,我们需要配置API调用的元数据,以确保能够正确地从旺店通系统中提取所需的数据。以下是关键的元数据配置项:

- API名称:

wdt.stat.stock.pd.detail.query - 请求方法:

POST - 分页大小: 100

- 查询条件: 盘点数量小于0 (

yk_num < 0) - 增量查询时间范围: 从上次同步时间到当前时间

具体的请求参数包括:

pd_no: 盘点单编号start_time: 开始时间(格式:yyyy-MM-dd HH:mm:ss)end_time: 结束时间(格式:yyyy-MM-dd HH:mm:ss)page_no: 页号,从0开始page_size: 每页返回的数据条数,默认为30

这些参数确保了我们可以按需、分批次地获取最新的盘亏数据。

数据请求与清洗

在实际操作中,我们会按照以下步骤进行数据请求与清洗:

-

初始化请求参数:

- 设置

start_time为上次同步时间。 - 设置

end_time为当前时间。 - 初始化分页参数,设置

page_no为0,page_size为100。

- 设置

-

发送API请求: 使用POST方法向接口发送请求,传递上述初始化好的参数。每次请求会返回最多100条记录。

-

处理分页响应:

- 检查响应结果中的总记录数和当前页记录数。

- 如果当前页未满且总记录数大于已获取记录数,则继续发送下一页请求(增加

page_no)。

-

过滤与清洗数据: 对返回的数据进行过滤,只保留符合条件的数据。例如,只保留盘点数量小于0的记录。这一步可以通过设置查询条件实现,如:

"condition":[[{"field":"yk_num","logic":"lt","value":0}]] -

增量更新机制: 为了避免重复抓取和漏抓,需要使用增量更新机制。每次成功抓取后,将本次抓取的结束时间作为下次抓取的开始时间。这可以通过如下配置实现:

{"field":"start_time","value":"{{LAST_SYNC_TIME|datetime}}"} {"field":"end_time","value":"{{CURRENT_TIME|datetime}}"}

异常处理与重试机制

在实际操作过程中,可能会遇到网络波动、接口限流等问题。为了保证数据抓取过程的可靠性,需要设计异常处理与重试机制:

-

限流控制: 旺店通·企业奇门接口有一定的限流策略。在频繁调用时,需要加入限流控制逻辑,例如每分钟不超过一定次数。如果超出限制,可以等待一段时间后再重试。

-

错误重试机制: 当出现网络错误或其他临时性故障时,可以设置自动重试机制。例如,每隔几秒钟重新尝试一次,总共尝试三次。如果仍然失败,则记录日志并告警。

-

日志记录与监控告警: 实时监控API调用状态,并将每次调用结果及异常情况记录到日志中。当发生异常时,通过告警系统通知相关人员及时处理。

数据转换与写入准备

完成上述步骤后,我们已经成功从旺店通·企业奇门系统中获取并清洗了所需的数据。接下来,可以根据业务需求对这些数据进行进一步转换和加工,为后续写入金蝶云星空等目标系统做好准备。

总结来说,通过合理配置API元数据、设计高效的数据请求与清洗流程,以及完善异常处理机制,我们能够高效、可靠地从旺店通·企业奇门系统中提取所需的数据,为整个集成流程奠定坚实基础。

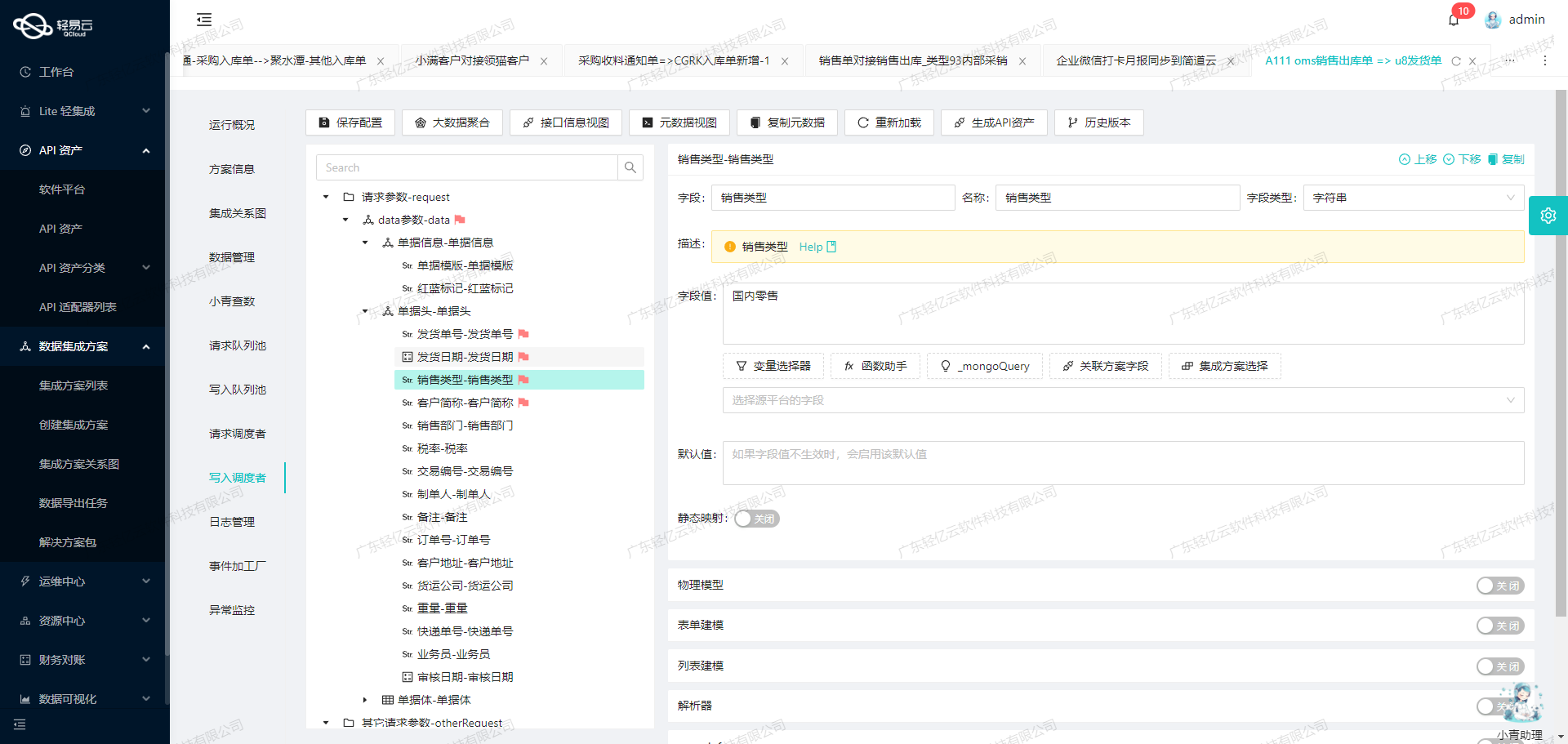

将旺店通盘亏数据ETL转换并写入金蝶云星空

在进行旺店通盘亏数据到金蝶云星空的集成过程中,关键的一步是将已经集成的源平台数据进行ETL(Extract, Transform, Load)转换,使其符合金蝶云星空API接口的要求,并最终写入目标平台。本文将详细探讨这一过程中涉及的技术细节和实现方法。

数据抽取与转换

首先,我们需要从旺店通·企业奇门系统中抽取盘亏数据。这些数据通常包括单据编号、仓库编号、物料编码、数量等信息。在抽取数据之后,接下来就是对这些数据进行必要的转换,以便它们能够被金蝶云星空API接口接受。

在元数据配置中,我们定义了多个字段的转换规则。例如:

{

"field": "FBillNo",

"label": "单据编号",

"type": "string",

"value": "{pd_no}"

}上述配置将旺店通中的pd_no字段映射到金蝶云星空中的FBillNo字段。这种映射确保了字段名称和格式的一致性。

特殊字段处理

有些字段需要根据具体条件进行转换。例如,库存组织和领用组织字段需要根据仓库编号来确定:

{

"field": "FStockOrgId",

"label": "库存组织",

"type": "string",

"value": "_function case when '{warehouse_no}' in ('047','048','051') then '105' when '{warehouse_no}' in ('050','052','049','053','055','057') then '114' else '100' end"

}这种条件判断逻辑使得我们可以根据不同的仓库编号动态设置库存组织和领用组织。

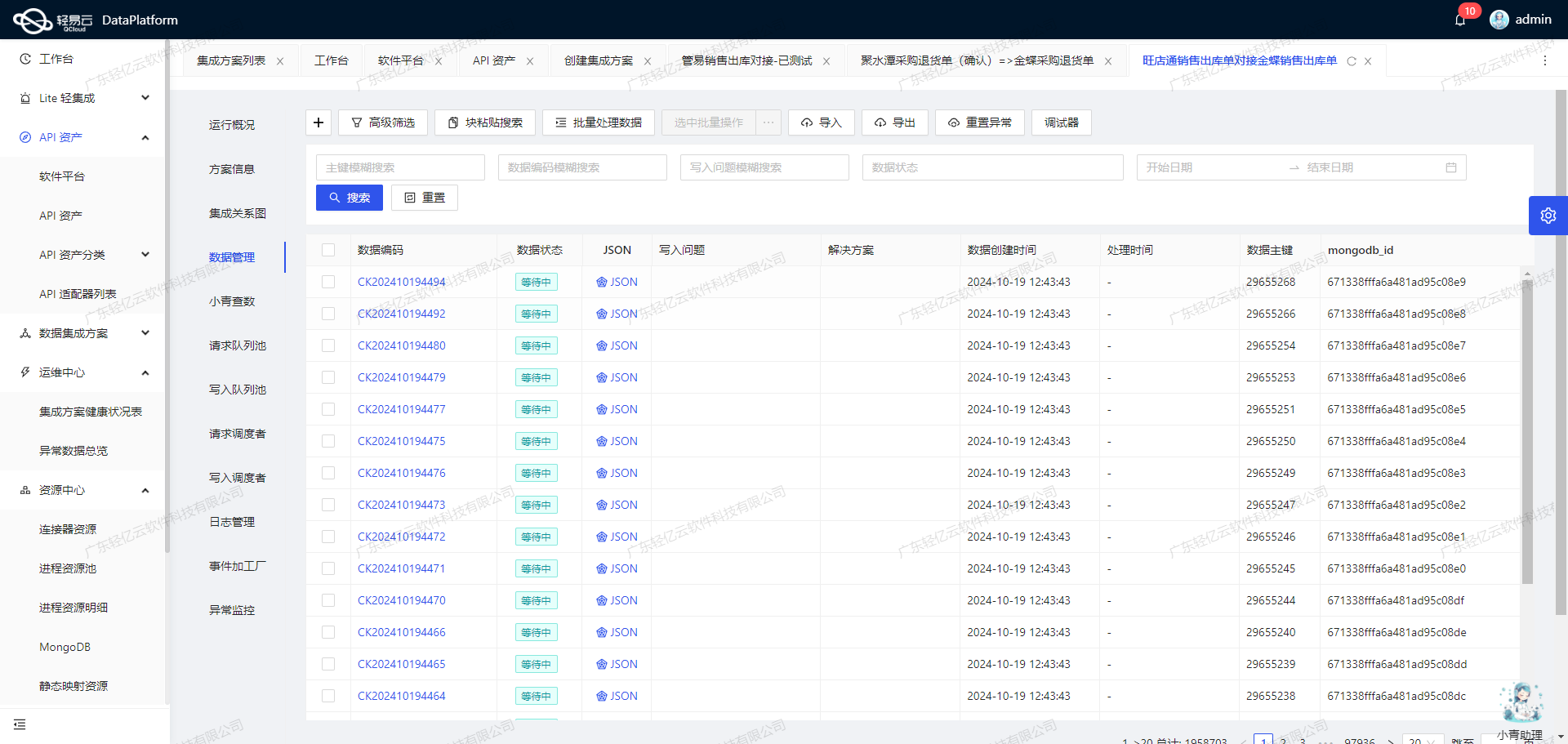

数据质量监控与异常处理

在数据转换过程中,确保数据质量是至关重要的。轻易云平台提供了实时监控和告警系统,可以及时发现并处理数据问题。例如,在批量写入数据到金蝶云星空时,如果某条记录的数据格式不符合要求,系统会自动触发告警,并记录详细日志以供分析。

此外,为了防止因网络或系统故障导致的数据丢失,我们实现了错误重试机制。一旦检测到写入失败,系统会自动重试多次,直到成功为止。这极大地提高了数据集成的可靠性。

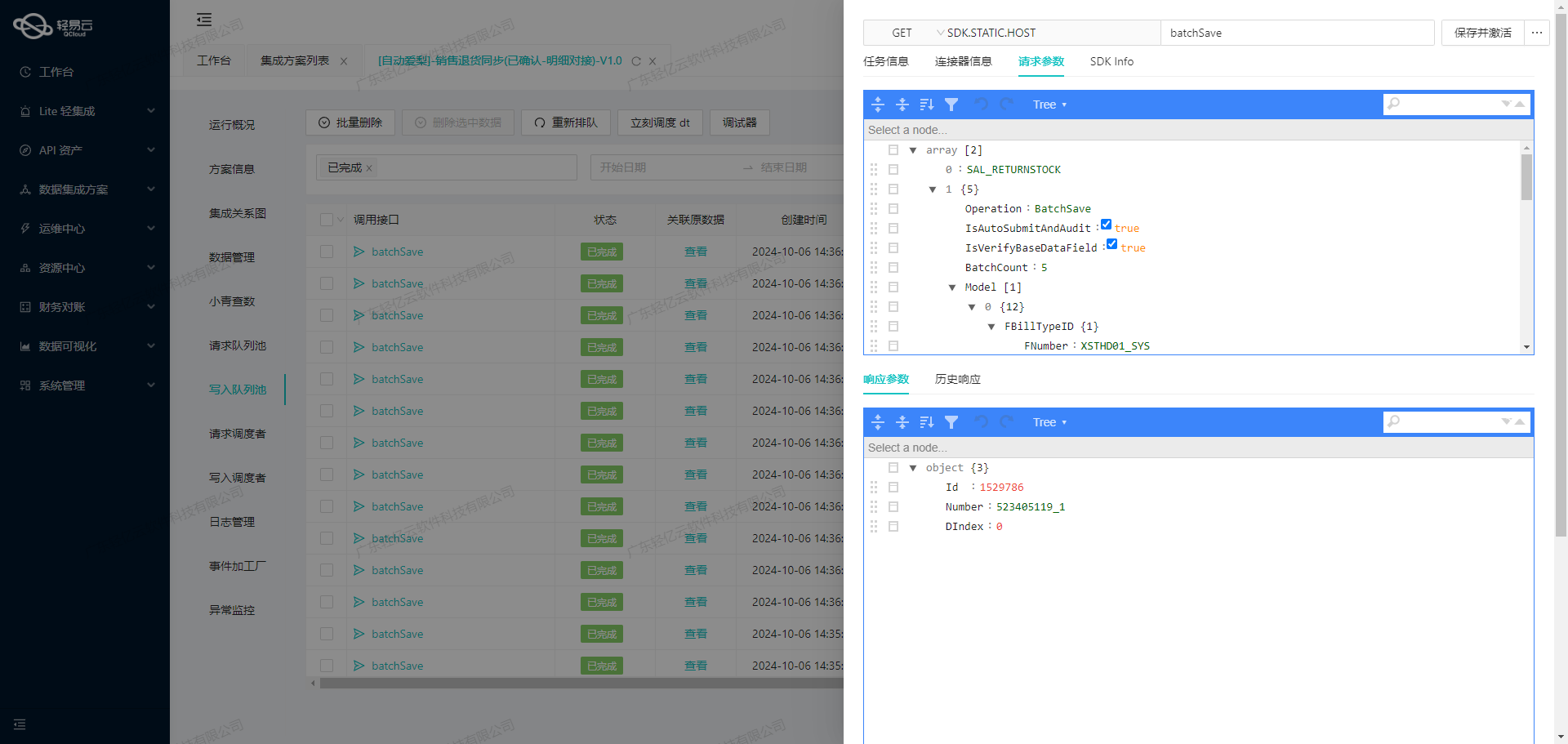

批量写入与性能优化

针对大量数据的快速写入需求,我们采用了批量操作的方法。通过将多个记录打包成一个请求发送给金蝶云星空API,可以显著减少请求次数,提高写入效率。同时,轻易云平台支持高吞吐量的数据处理能力,能够快速处理并传输大量数据。

{

"api": "batchSave",

"method": "POST",

...

}上述配置表明我们采用批量保存的方法,将多个盘亏记录一次性写入到金蝶云星空中。

实时监控与日志记录

为了确保整个ETL过程透明可控,我们利用轻易云平台提供的集中监控功能,对每个步骤进行实时跟踪。从数据抽取、转换到最终写入,每个环节都记录详细日志,一旦出现异常情况,可以迅速定位并解决问题。

自定义数据映射与业务逻辑

在实际业务场景中,不同企业有不同的数据结构和业务需求。因此,我们支持自定义数据映射和转换逻辑。例如,对于物料编码、仓位等字段,可以根据具体需求进行定制化处理:

{

"field": "FMaterialId",

...

},

{

"field": "FStockLocId",

...

}通过灵活配置这些字段,我们可以确保满足各种复杂业务场景下的数据集成需求。

综上所述,通过精细化的数据抽取与转换、严格的数据质量监控、批量写入优化以及实时监控与日志记录,我们能够高效地将旺店通盘亏数据ETL转换并成功写入金蝶云星空。这一过程不仅提高了数据处理效率,还确保了数据的一致性和准确性。