吉客云采购退货数据集成到MySQL的技术案例分享

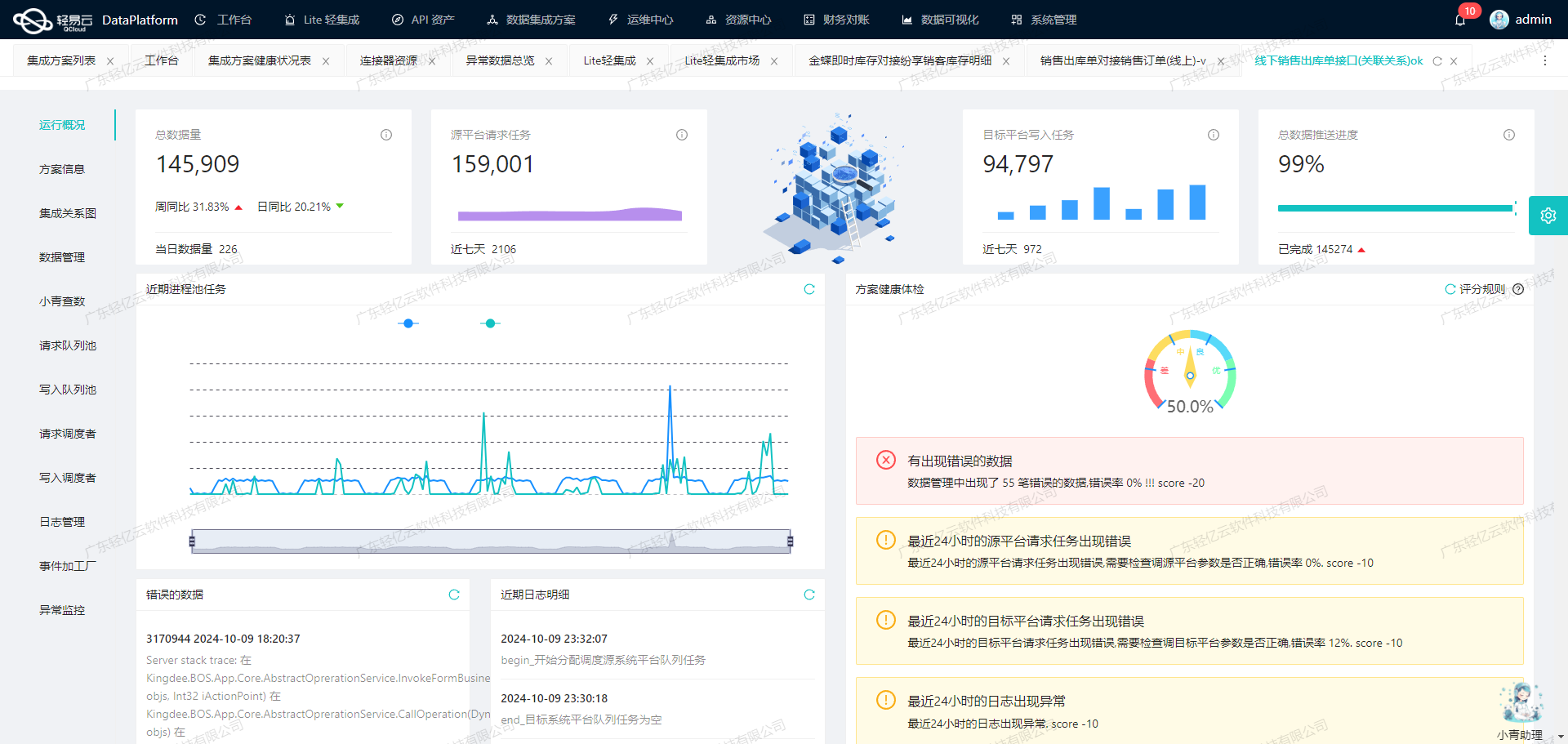

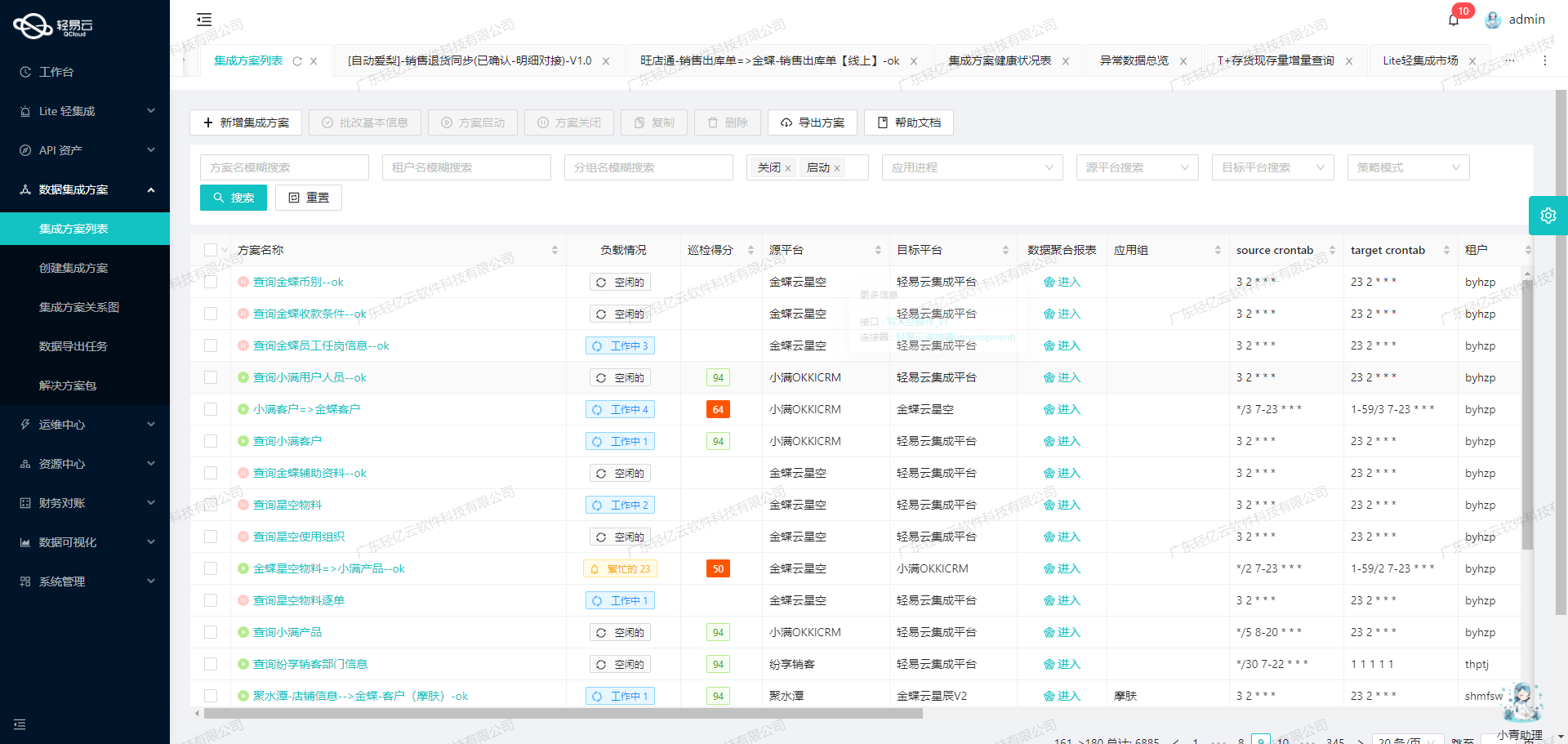

在本次技术案例中,我们将重点探讨如何通过轻易云数据集成平台,将吉客云的采购退货数据高效、可靠地集成到MySQL数据库中。具体方案为“吉客云采购退货-BDSBI_pro_update”,旨在实现大规模数据的快速写入和实时监控。

首先,吉客云提供了丰富的API接口,其中erp.purchreturn.get用于获取采购退货数据。为了确保数据不漏单,我们需要定时可靠地抓取该接口的数据,并处理分页和限流问题,以保证每次调用都能完整获取所需信息。

接着,针对MySQL数据库的写入操作,我们使用executeReturn API来批量插入数据。高吞吐量的数据写入能力是关键,这不仅提升了数据处理的时效性,还确保了大量数据能够迅速被集成到目标系统中。此外,为了应对吉客云与MySQL之间的数据格式差异,我们支持自定义数据转换逻辑,以适应特定业务需求和结构。

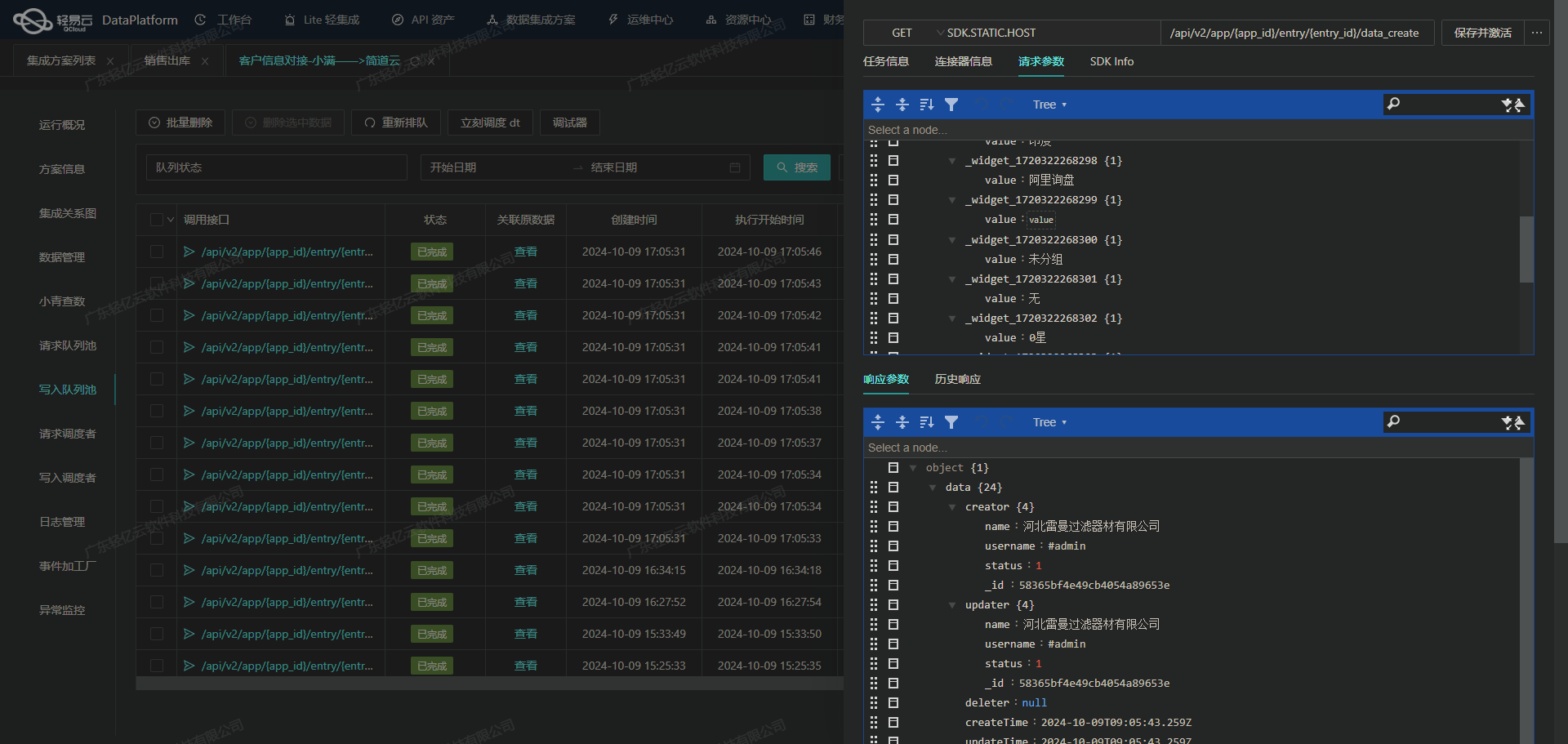

在整个集成过程中,集中监控和告警系统发挥了重要作用。通过实时跟踪任务状态和性能,我们能够及时发现并处理异常情况,确保系统稳定运行。同时,日志记录功能使得每一步操作都可追溯,为后续优化提供了有力支持。

最后,通过可视化的数据流设计工具,使得整个集成过程更加直观和易于管理,从而进一步提升了工作效率。这些技术特性共同保障了“吉客云采购退货-BDSBI_pro_update”方案的成功实施,为企业的数据管理带来了显著提升。

接下来,我们将详细介绍具体的实施步骤及注意事项。

调用吉客云接口erp.purchreturn.get获取并加工数据

在轻易云数据集成平台的生命周期中,第一步是调用源系统吉客云接口erp.purchreturn.get来获取采购退货的数据,并进行初步加工处理。这一步骤至关重要,因为它确保了后续数据处理和写入的准确性和完整性。

接口配置与调用

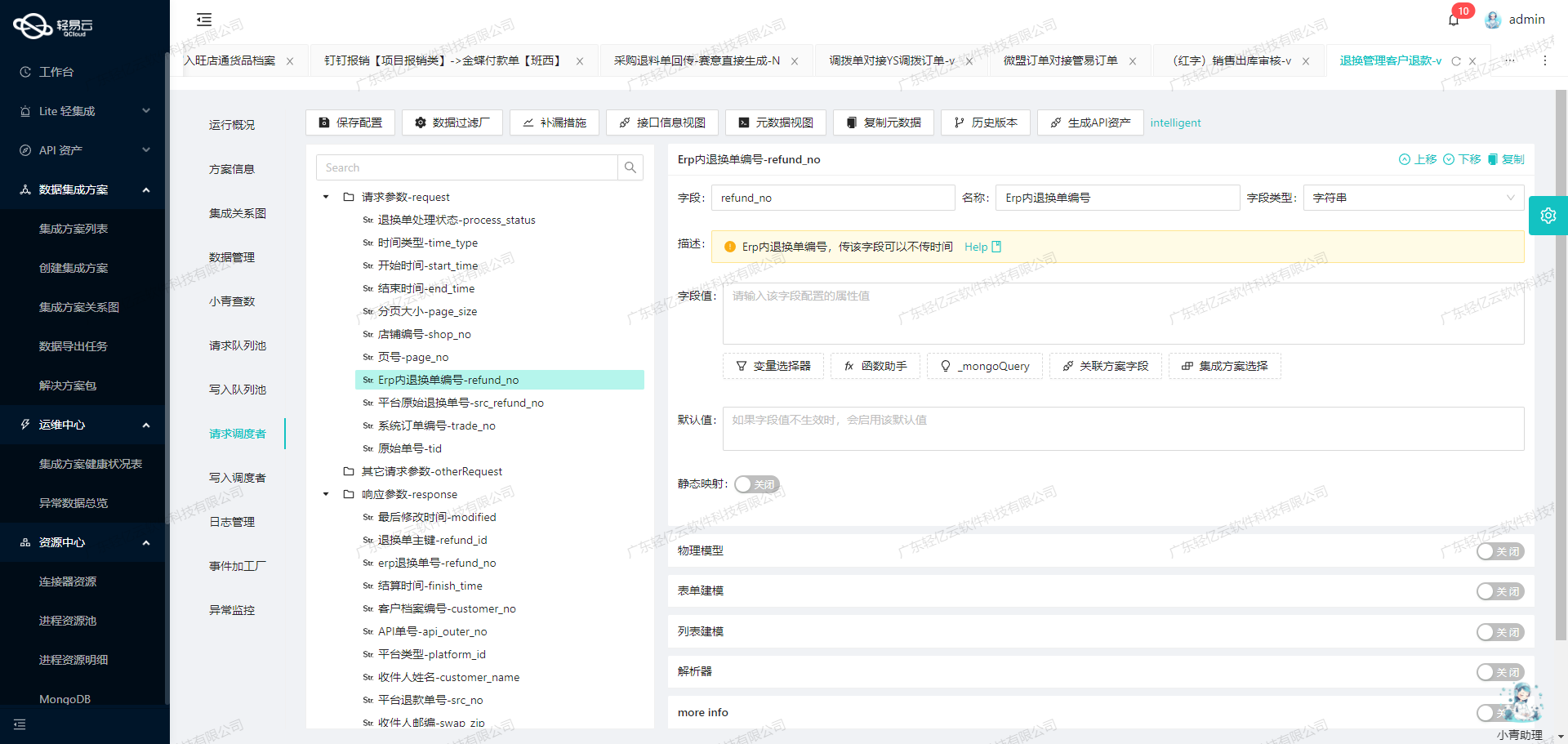

首先,我们需要配置元数据,以便正确调用吉客云接口。根据提供的元数据配置,以下是关键参数:

- API名称:

erp.purchreturn.get - 请求方法:

POST - 分页参数:

pageIndex(分页页码)pageSize(分页页数,默认值为50)

- 时间参数:

startDate(开始创建时间)endDate(结束创建时间)startReturnTime(开始退货时间)endReturnTime(结束退货时间)

这些参数确保我们能够灵活地控制数据请求的范围和数量,从而高效地获取所需的数据。

数据请求与清洗

在实际操作中,我们会通过定时任务来可靠地抓取吉客云接口的数据。为了避免漏单问题,可以设置合理的时间窗口,例如使用上次同步时间作为起始时间({{LAST_SYNC_TIME|datetime}}),当前时间作为结束时间({{CURRENT_TIME|datetime}})。

{

"pageIndex": "1",

"pageSize": "50",

"startDate": "{{LAST_SYNC_TIME|datetime}}",

"endDate": "{{CURRENT_TIME|datetime}}"

}通过这种方式,我们可以确保每次抓取到的数据都是最新且未曾处理过的。同时,为了应对大批量数据,可以利用分页机制逐页获取所有相关记录。

数据转换与写入准备

在获取到原始数据后,需要进行初步清洗和转换,以适应目标数据库MySQL的结构。例如,将日期格式从字符串转换为标准日期类型,或者将某些字段值映射到目标表中的对应字段。

此外,还需要注意处理分页和限流问题。对于大规模数据集成任务,可以实现自动重试机制,以确保在网络波动或其他异常情况下仍能稳定完成数据抓取。

异常处理与监控

为了保证整个过程的可靠性,需要实现全面的异常处理机制。例如,在调用API时,如果出现错误响应或超时情况,应及时记录日志并触发告警,同时尝试重新请求。此外,通过实时监控系统,可以随时跟踪每个集成任务的状态和性能,及时发现并解决潜在问题。

{

"errorCode": "500",

"errorMessage": "Internal Server Error",

"retryCount": 3,

...

}通过以上步骤,我们能够高效、准确地从吉客云接口获取采购退货数据,并为后续的数据转换与写入做好充分准备。这不仅提升了业务透明度,也极大提高了整体效率。

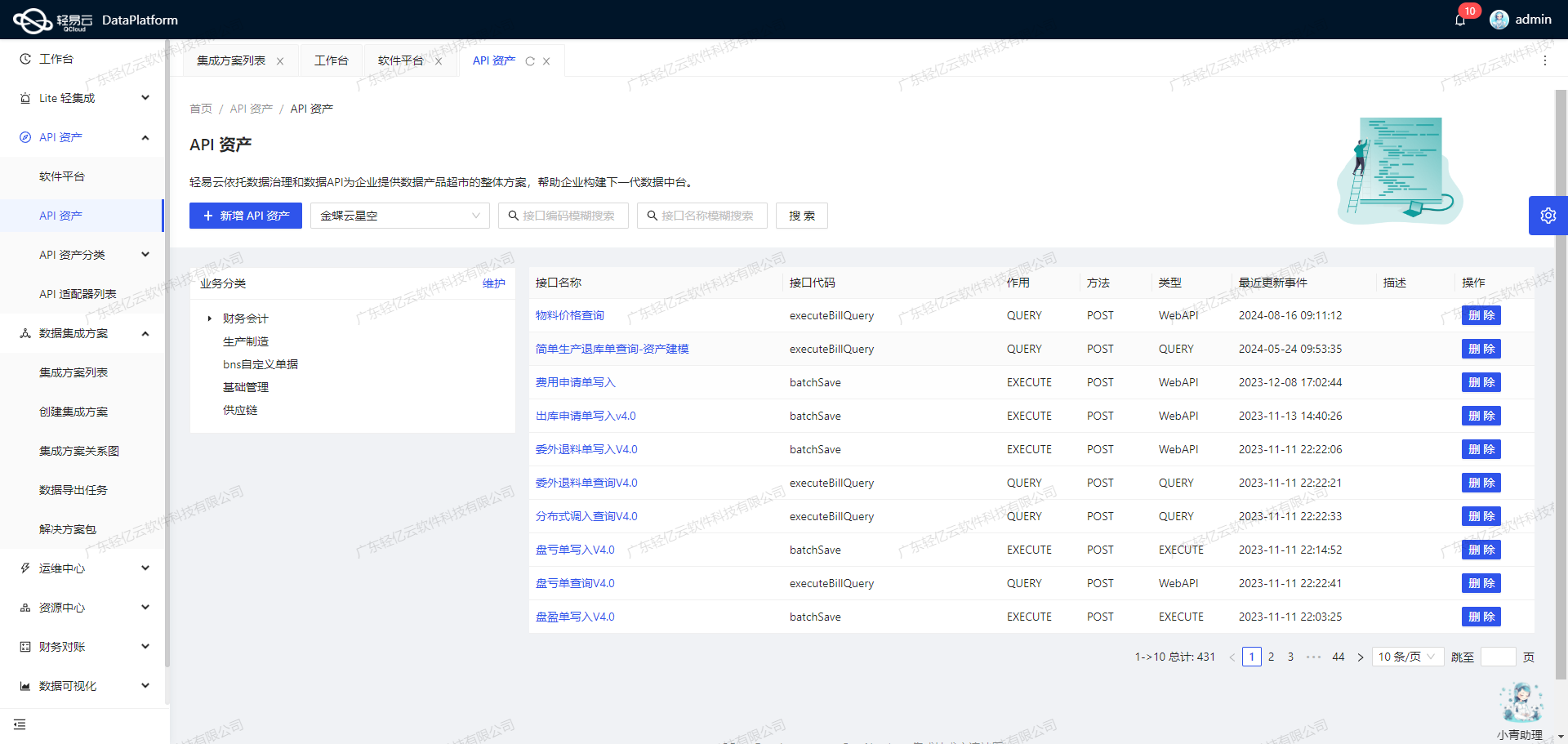

数据集成与ETL转换:吉客云采购退货数据写入MySQL

在数据集成生命周期的第二步,我们需要将已经从源平台(如吉客云)获取的数据进行ETL转换,并将其转化为目标平台MySQLAPI接口所能够接收的格式,最终写入目标平台。这一步骤至关重要,因为它不仅决定了数据能否顺利传输,还关系到数据的准确性和完整性。

数据请求与清洗

首先,我们通过调用吉客云接口erp.purchreturn.get来请求采购退货相关的数据。为了确保数据的完整性和准确性,需要对这些数据进行清洗操作,包括去除冗余字段、修正错误数据以及标准化字段格式等。

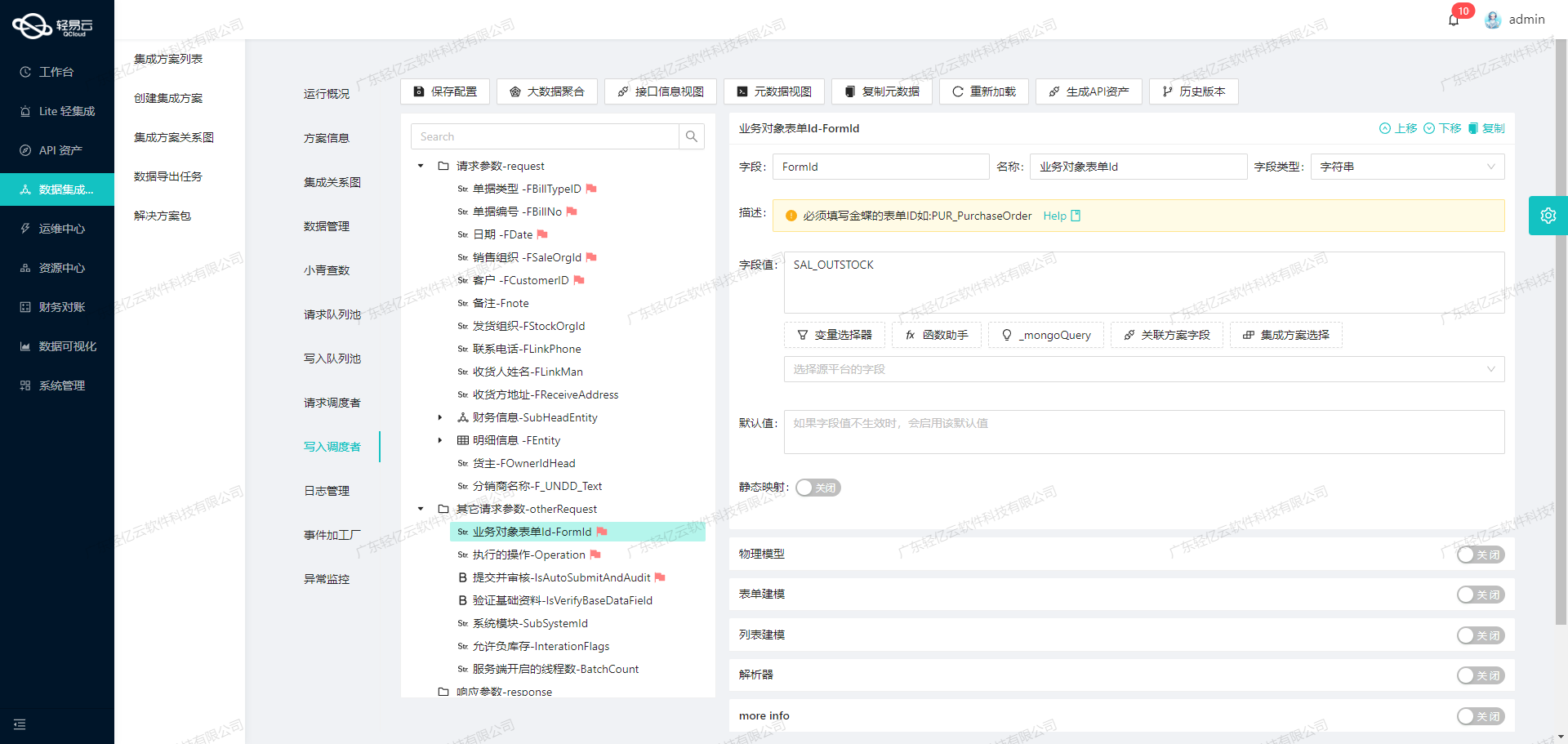

数据转换与映射

接下来,最重要的一步是将清洗后的数据进行转换,使其符合MySQLAPI接口的要求。以下是一些关键字段及其对应的转换逻辑:

order_id(退货单ID):直接映射为MySQL中的订单ID。user_code(工号)、real_name(名称):这些字段需要保持原样传递。gmt_create(创建时间):吉客云返回的时间戳需要转换为MySQL支持的日期时间格式。使用函数_function FROM_UNIXTIME( ( {gmtCreate} \/ 1000 ) ,'%Y-%m-%d %T' )进行转换。currency_code(币种编码)、currency_rate(汇率):直接映射并传递给MySQL。

对于扩展参数部分,例如商品详细信息,需要逐一映射:

goods_id(商品ID)、quantity(退货数量):这些字段需要直接映射到MySQL数据库中相应的表。rec_date(预计出库时间):同样需要进行时间格式转换。price(价格)、amount(总金额):这些数值型字段需要确保精度,并直接映射。

SQL语句生成与执行

根据元数据配置,我们需要生成相应的SQL语句以便将转换后的数据写入MySQL数据库。例如:

UPDATE `lehua`.`purchase_return`

SET

`user_code` = '{userCode}',

`real_name` = '{realName}',

...

WHERE

`order_id` = '{orderId}';对于扩展参数部分,生成类似的更新语句:

UPDATE `lehua`.`purchase_return_detail`

SET

`quantity` = '{quantity}',

...

WHERE

`head_id` = '{headId}' AND `goods_id` = '{goodsId}';数据质量监控与异常处理

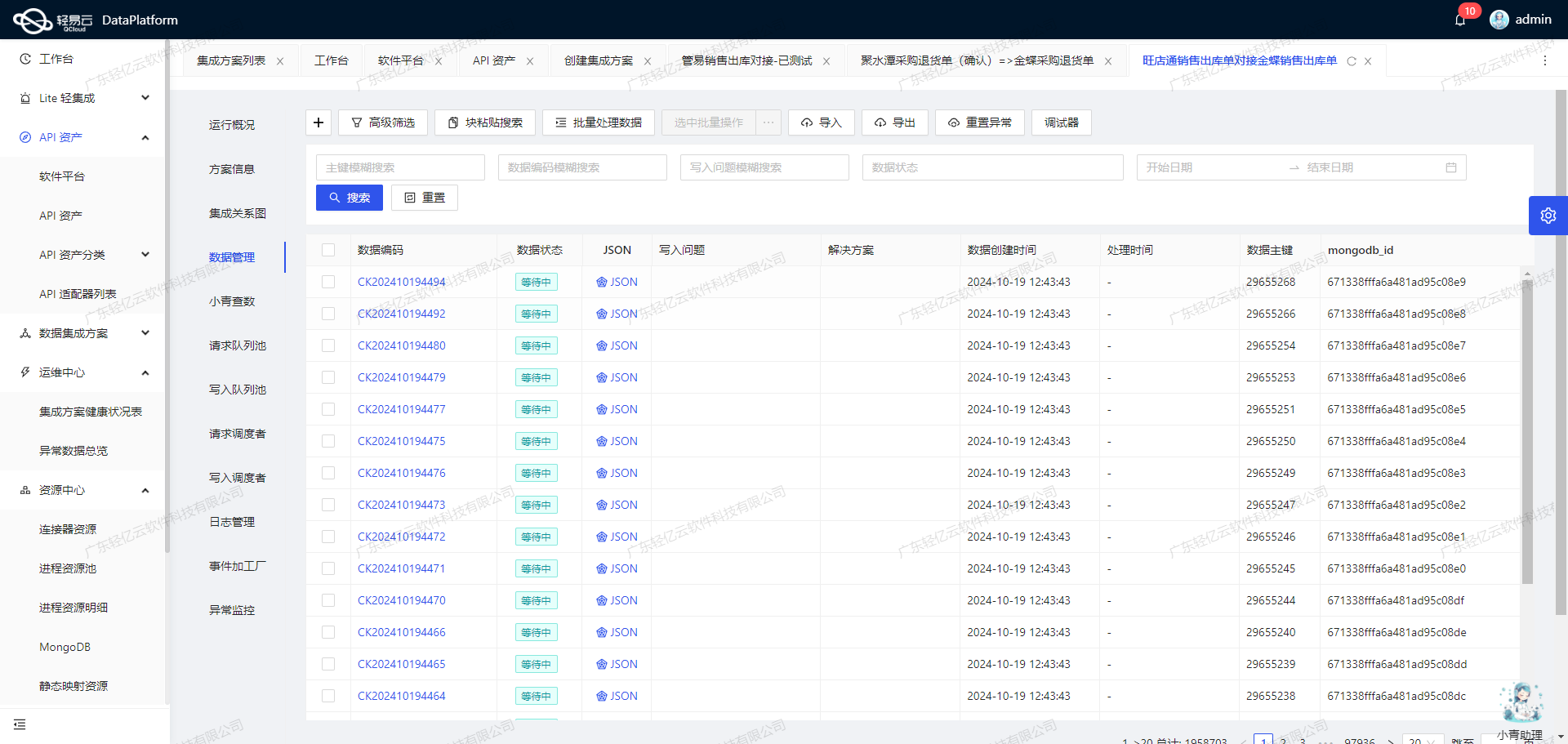

为了确保集成过程不漏单,并能够及时发现和处理异常情况,必须实现实时监控和日志记录功能。通过轻易云提供的集中监控和告警系统,可以实时跟踪每个数据集成任务的状态和性能。一旦发现异常,可以自动触发告警,并执行预定义的错误重试机制,确保数据不丢失、不重复。

批量处理与高效写入

在大规模数据集成场景下,批量处理和高效写入尤为重要。轻易云平台支持高吞吐量的数据写入能力,使得大量数据能够快速被集成到MySQL系统中。同时,通过定时可靠地抓取吉客云接口数据,可以确保每次抓取的数据都是最新且完整的。

自定义转换逻辑与业务适配

根据特定业务需求,可以自定义数据转换逻辑。例如,对于某些复杂业务场景,可能需要在ETL过程中加入额外的数据校验、计算或格式调整步骤,以确保最终写入的数据完全符合业务要求。

综上所述,通过合理配置元数据、生成并执行相应的SQL语句、实施严格的数据质量监控以及灵活应用自定义转换逻辑,可以高效地完成吉客云采购退货数据到MySQLAPI接口的数据集成任务。这不仅提升了数据处理效率,也保障了业务连续性和稳定性。