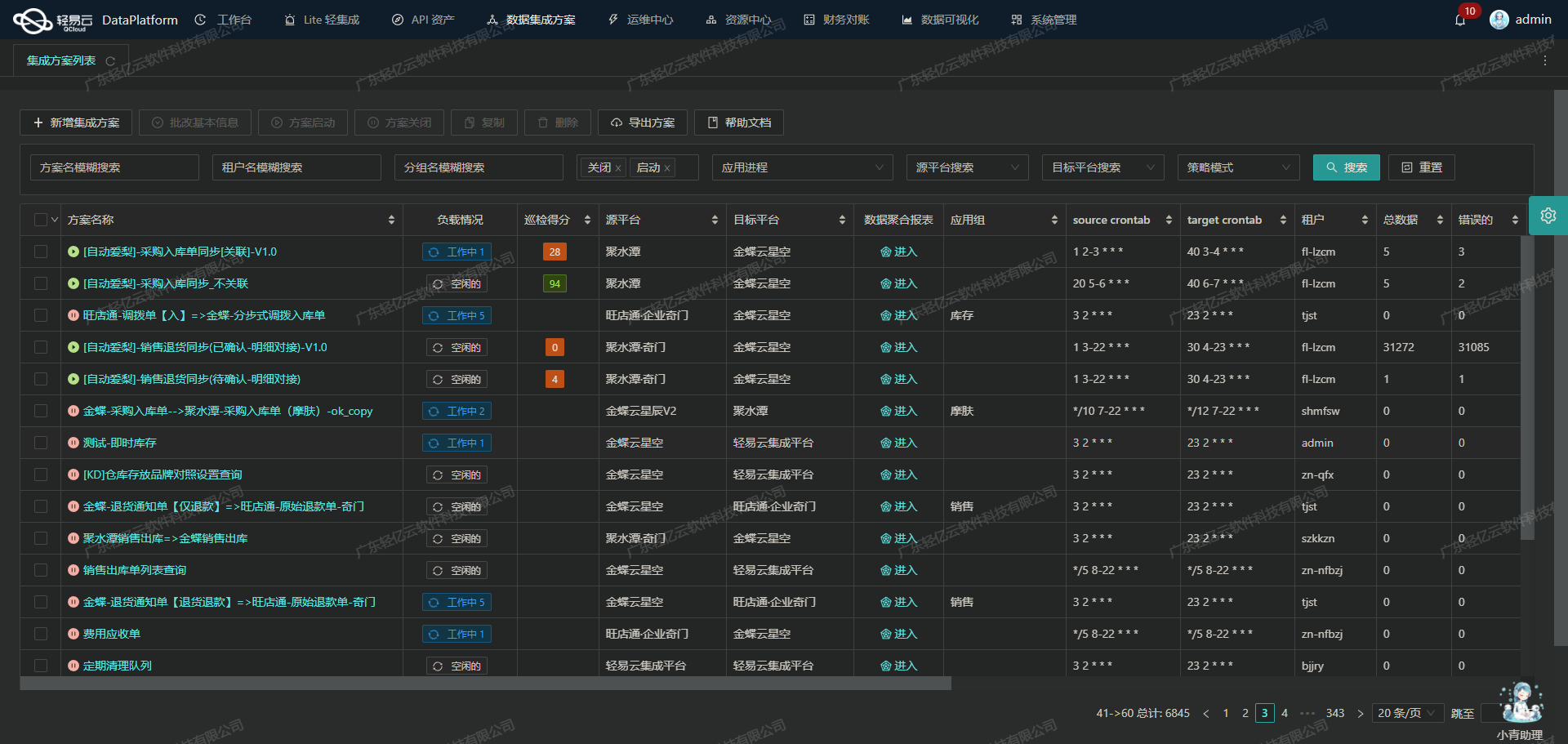

管易云·奇门数据集成到金蝶云星空的技术案例分享

在企业日常运营中,数据的高效流转和准确对接是确保业务顺畅运行的关键。本文将重点分享一个实际运行的系统对接集成案例:管易云·奇门的数据集成到金蝶云星空,方案名称为“1-管易-发货单==》金蝶-销售出库单_copy”。

本次集成任务主要涉及两个核心API接口:管易云·奇门获取发货单数据的gy.erp.trade.deliverys.history.get接口,以及金蝶云星空用于写入销售出库单数据的batchSave接口。通过轻易云数据集成平台,我们实现了从管易云·奇门到金蝶云星空的数据无缝对接。

在这个过程中,我们利用了轻易云平台的一些关键特性:

- 高吞吐量的数据写入能力:确保大量发货单数据能够快速、高效地被写入到金蝶云星空系统中,大幅提升了数据处理的时效性。

- 实时监控与告警系统:通过集中监控和告警功能,实时跟踪每个数据集成任务的状态和性能,及时发现并解决潜在问题。

- 自定义数据转换逻辑:针对管易云·奇门与金蝶云星空之间的数据格式差异,我们设计了灵活的数据转换规则,以适应不同业务需求。

- 分页和限流处理:为了应对管易云·奇门接口可能存在的分页和限流问题,我们制定了相应策略,确保数据抓取过程稳定可靠。

此外,为了保证整个集成过程中的数据质量,我们还引入了异常检测机制,并结合错误重试机制来处理可能出现的问题。这些措施不仅提高了系统对接的可靠性,也为后续的数据维护提供了有力支持。

通过上述技术手段,本次“1-管易-发货单==》金蝶-销售出库单_copy”方案成功实现了两大平台间的数据高效、稳定对接,为企业运营提供了坚实保障。

调用管易云·奇门接口gy.erp.trade.deliverys.history.get获取并加工数据

在数据集成过程中,调用源系统的API接口是至关重要的一步。本文将详细探讨如何通过轻易云数据集成平台调用管易云·奇门接口gy.erp.trade.deliverys.history.get来获取发货单数据,并进行初步的数据清洗和加工处理。

接口配置与请求参数

首先,我们需要配置接口的元数据,以确保能够正确地调用API并获取所需的数据。以下是该接口的主要配置项:

- API名称:

gy.erp.trade.deliverys.history.get - 请求方式:

POST - 分页参数:

- 页号:

page_no - 分页大小:

page_size

- 页号:

请求参数包括时间段、发货状态等信息,这些参数用于筛选符合条件的发货单记录。部分关键字段如下:

{

"start_create": "创建时间开始段",

"end_create": "创建时间结束段",

"start_delivery_date": "{{LAST_SYNC_TIME|datetime}}",

"end_delivery_date": "{{CURRENT_TIME|datetime}}",

"delivery": "1"

}其中,start_delivery_date和end_delivery_date分别表示上次同步时间和当前时间,用于限定查询范围。

数据清洗与转换

在获取到原始数据后,需要对其进行清洗和转换,以确保数据质量并适应目标系统的数据结构。以下是一些常见的数据清洗操作:

- 去除无效记录:根据业务规则过滤掉不需要的记录,例如作废单据。

- 字段映射与转换:将源系统中的字段映射到目标系统中对应的字段,并进行必要的数据类型转换。例如,将字符串类型的日期转换为标准日期格式。

- 异常处理:对于缺失或异常值进行处理,确保不会影响后续的数据写入操作。

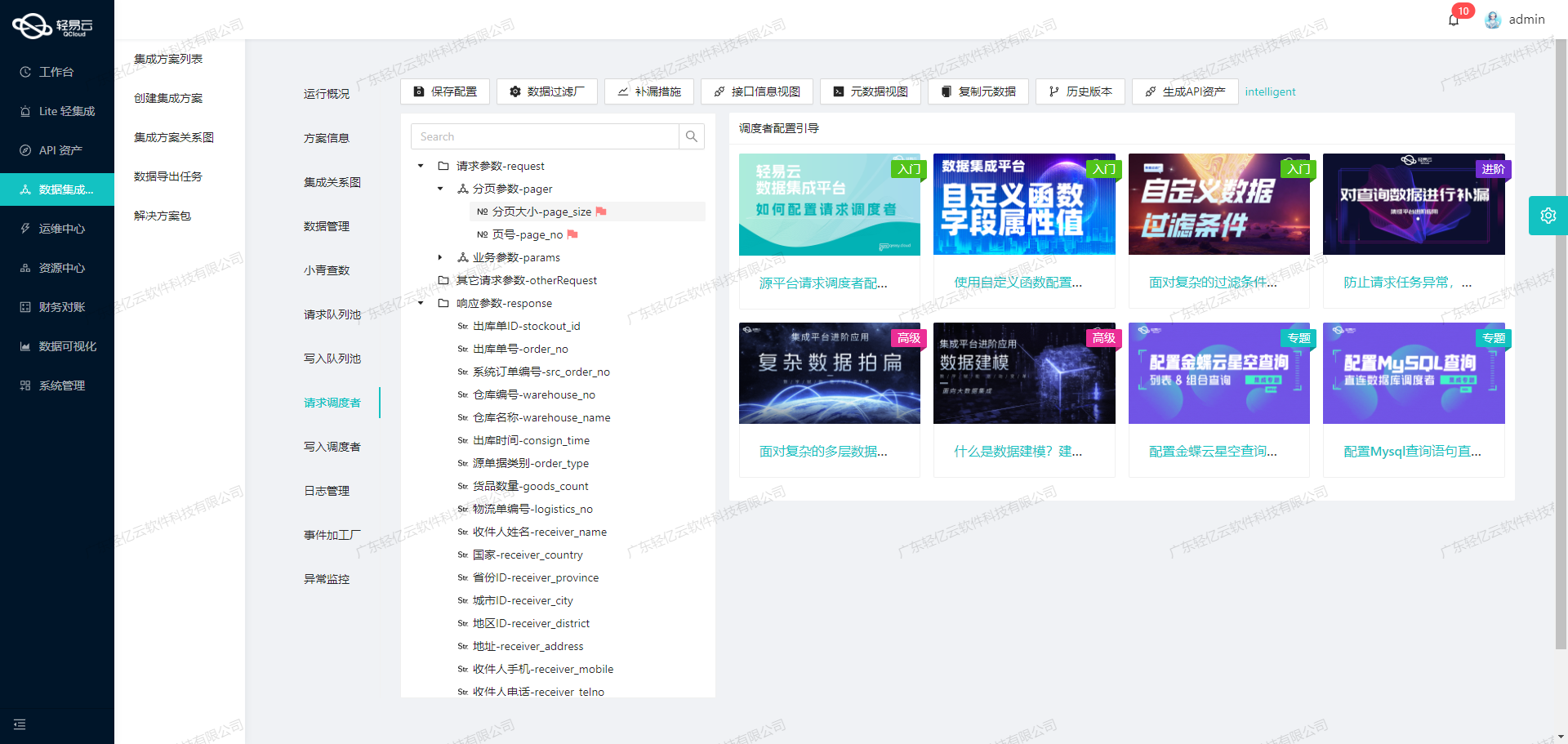

分页与限流处理

由于API接口通常会对每次请求返回的数据量进行限制,因此需要实现分页机制来逐页获取完整数据。同时,为了避免触发源系统的限流策略,可以设置合理的分页大小和请求间隔。

{

"page_no": "{PAGINATION_START_PAGE}",

"page_size": "{PAGINATION_PAGE_SIZE}"

}通过循环递增页号,并结合轻易云平台提供的高吞吐量能力,可以高效地完成大批量数据的抓取任务。

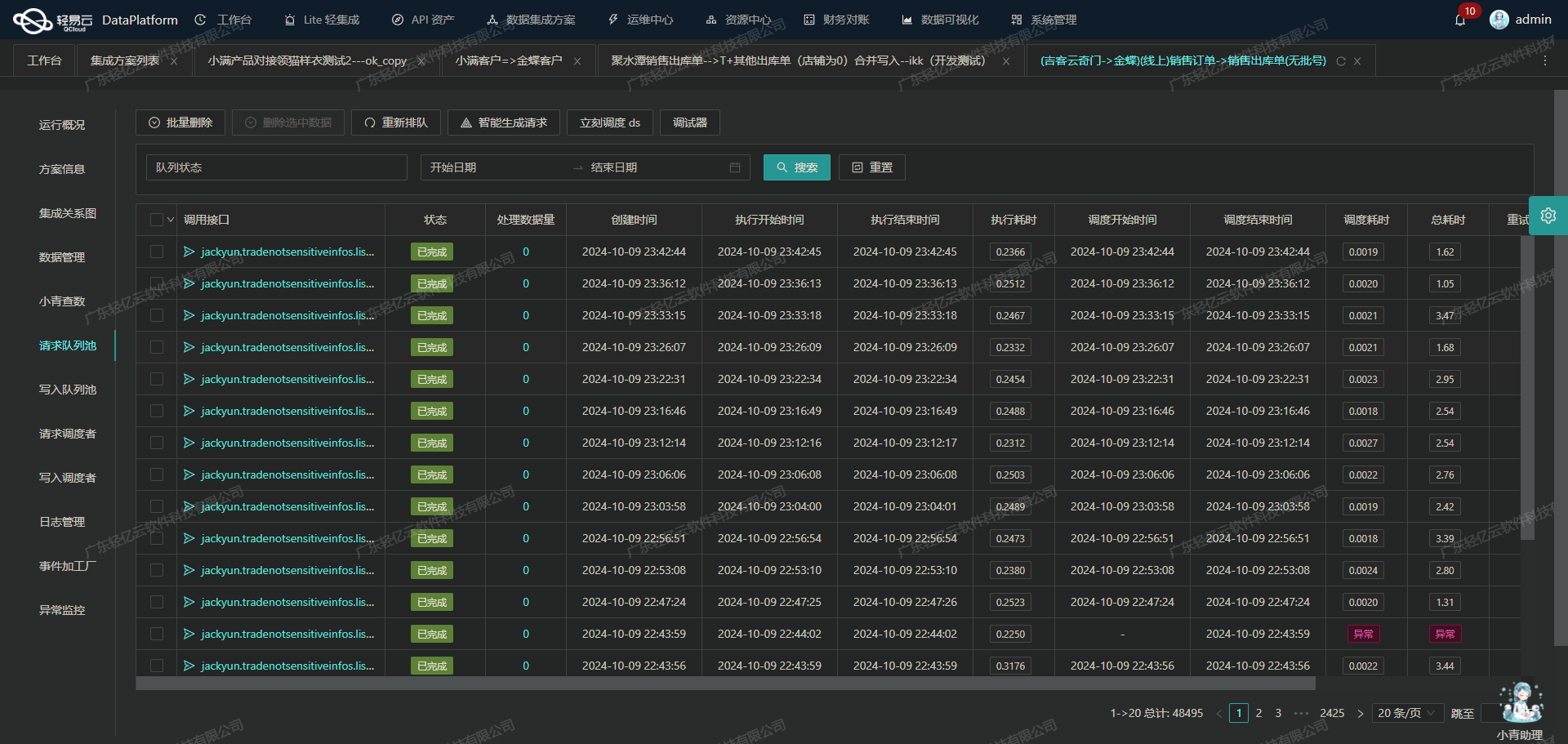

实时监控与日志记录

为了确保整个数据集成过程透明可控,轻易云平台提供了实时监控和日志记录功能。可以实时跟踪每个API调用的状态、响应时间以及返回结果,对于异常情况及时告警并采取措施。这不仅提高了集成过程的可靠性,也便于后续问题排查和优化。

自定义逻辑与扩展性

轻易云平台支持自定义数据转换逻辑,使得用户可以根据具体业务需求灵活调整处理流程。例如,可以在接收到发货单数据后,根据特定规则计算出库数量或生成额外字段。这种灵活性极大地提升了平台适应复杂业务场景的能力。

综上,通过合理配置元数据、实现有效的数据清洗与转换、处理分页与限流问题,以及利用实时监控功能,可以高效稳定地完成从管易云·奇门接口获取发货单历史记录并进行初步加工处理,为后续的数据写入奠定坚实基础。

将管易云·奇门数据转换并写入金蝶云星空

在数据集成生命周期的第二步,我们需要将已经从管易云·奇门获取的数据进行ETL(抽取、转换、加载)处理,最终将数据写入到金蝶云星空API接口中。本文将详细探讨这一过程中涉及的关键技术点和具体实现方法。

数据转换与映射

首先,我们需要对从管易云·奇门获取的数据进行格式转换,以便能够符合金蝶云星空API接口所接受的格式。这一步骤至关重要,因为两个系统之间的数据结构和字段名称可能存在显著差异。

例如,对于“单据类型”字段(FBillTypeID),我们使用了一个固定值“XSCKD01_SYS”,并通过ConvertObjectParser进行解析。类似地,其他字段如“发货组织”(FStockOrgId)和“销售组织”(FSaleOrgId),也需要根据特定规则进行转换和映射。

{

"field": "FBillTypeID",

"label": "单据类型",

"type": "string",

"describe": "单据类型",

"parser": {

"name": "ConvertObjectParser",

"params": "FNumber"

},

"value": "XSCKD01_SYS"

}动态字段处理

有些字段需要根据具体业务逻辑进行动态处理。例如,“销售组织”(FSaleOrgId)字段的值需要根据仓库代码和店铺代码来决定。我们可以使用条件判断语句来实现这一逻辑:

{

"field": "FSaleOrgId",

"label": "销售组织",

"type": "string",

"describe": "组织",

"parser": {

"name": "ConvertObjectParser",

"params": "FNumber"

},

"value": "_function case when '{shop_code}' = 'x01' and '{warehouse_code}' in ('095','0361','001','034','055','017','008') then '107' else '{shop_code}' END"

}明细信息处理

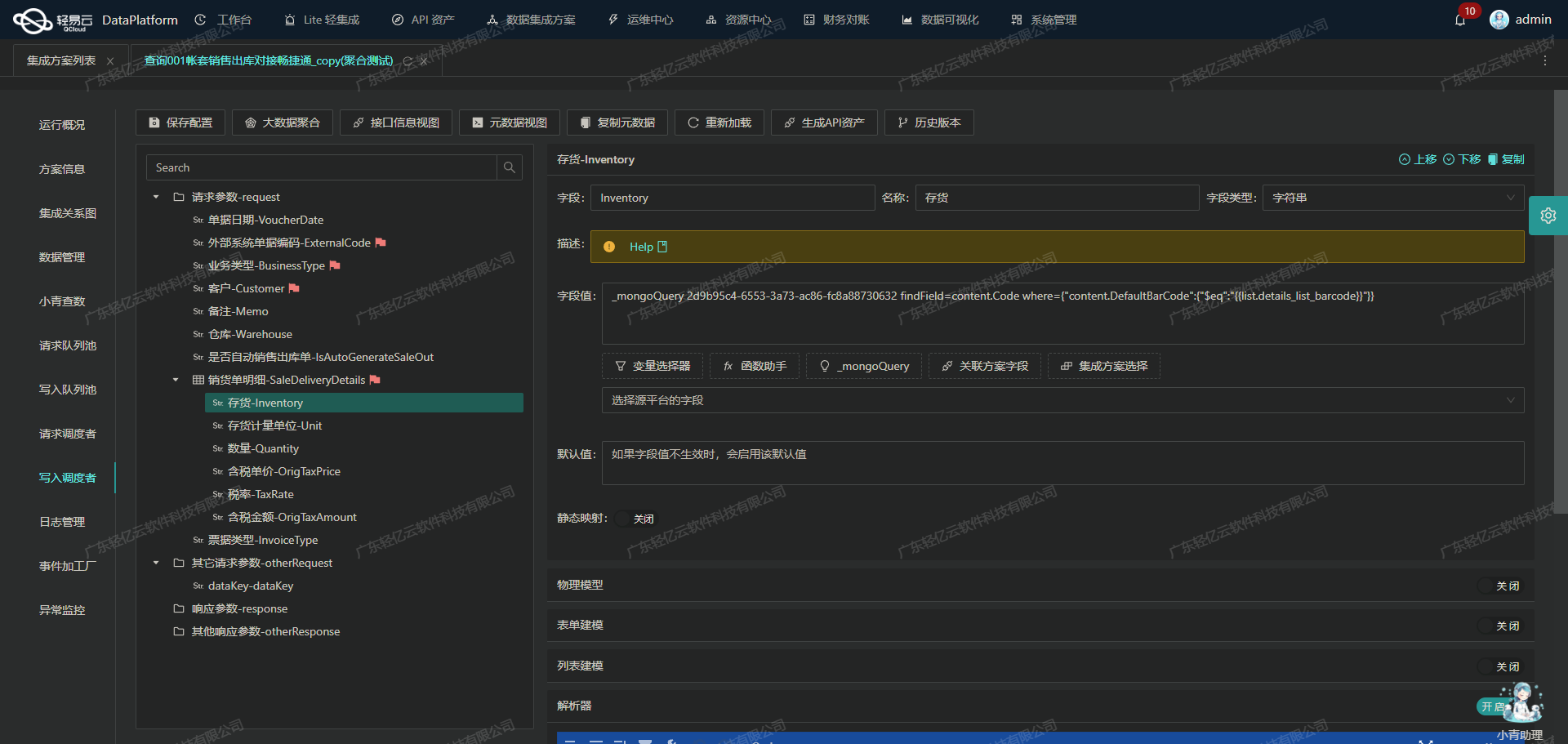

对于明细信息(FEntity)的处理,我们需要对每一条记录进行遍历,并根据具体业务需求进行相应的字段映射。例如,对于物料编码(FMaterialID),我们可以通过查询MongoDB数据库来获取相应的值:

{

"field": "FMaterialID",

"label": "物料编码",

"type": "string",

"describe": "基础资料",

"parser": {

"name": "ConvertObjectParser",

"params": "FNumber"

},

"value": "_mongoQuery findField=content.FNumber where={\"content.FSpecification\":{\"$eq\":\"{details_sku_code}\"}}"

}数据写入金蝶云星空

完成数据转换后,我们将数据通过POST请求写入到金蝶云星空系统中。这里我们使用了batchSave API接口,并设置了相关参数,如表单ID(FormId)、操作类型(Operation)、是否自动提交审核(IsAutoSubmitAndAudit)等。

{

...

{

“api”: “batchSave”,

“method”: “POST”,

“request”: [

...

{

“field”: “FormId”,

“label”: “业务对象表单Id”,

“type”: “string”,

“value”: “SAL_OUTSTOCK”

},

{

“field”: “Operation”,

“label”: “执行的操作”,

“type”: “string”,

“value”: “Save”

},

{

“field”: “IsAutoSubmitAndAudit”,

“label”:”提交并审核”,

”type”:”bool”,

”value”:true

}

]

}

}异常处理与重试机制

在数据写入过程中,可能会遇到各种异常情况,如网络故障、API限流等。为确保数据可靠性,我们需要实现异常处理与重试机制。当请求失败时,可以记录日志并在一定时间间隔后重新尝试提交。

实时监控与日志记录

为了保证整个数据集成过程的透明性和可追溯性,我们可以利用平台提供的实时监控和日志记录功能,跟踪每个数据集成任务的状态和性能,及时发现并解决问题。

综上所述,通过上述步骤,我们能够有效地将管易云·奇门的数据转换为金蝶云星空API接口所能接受的格式,并顺利地将数据写入目标平台。这一过程不仅提升了数据处理的效率,也确保了数据的一致性和准确性。