手工补客户数据--运维:有赞云数据集成到敦煌种业先锋

在现代企业的数据管理中,系统间的数据集成是确保业务流程顺畅运行的关键环节。本文将分享一个实际案例,展示如何通过轻易云数据集成平台,将有赞云的数据高效、安全地集成到敦煌种业先锋系统中。

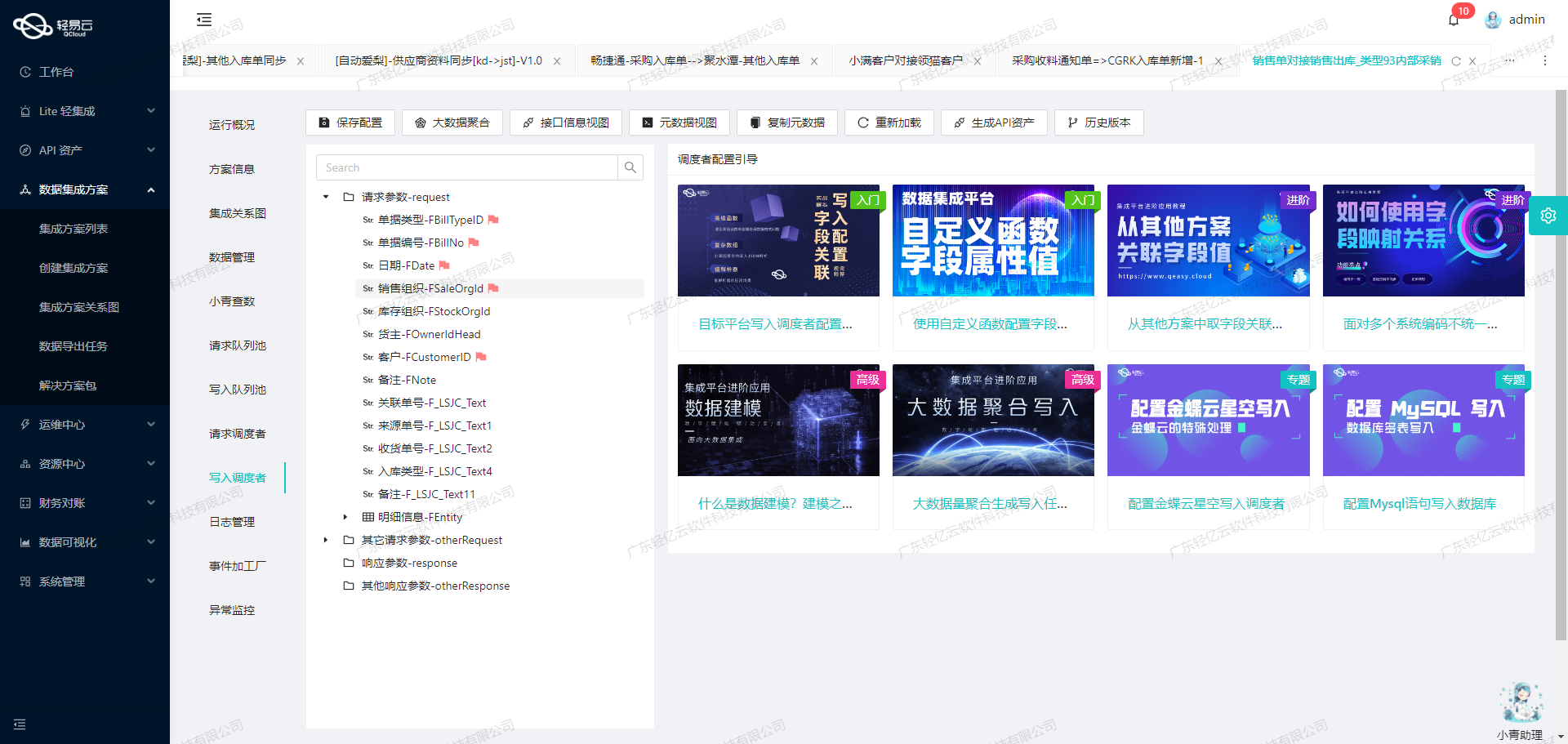

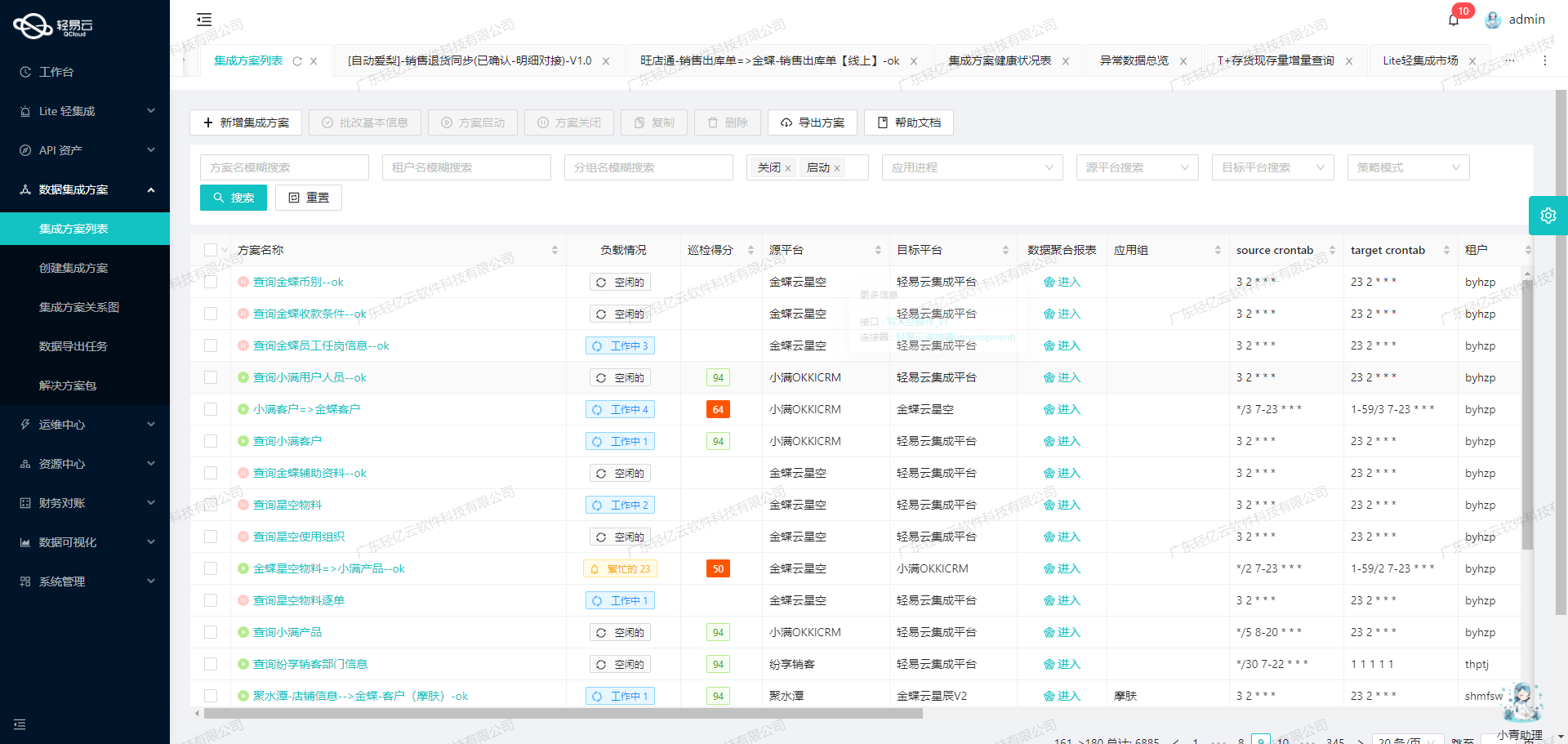

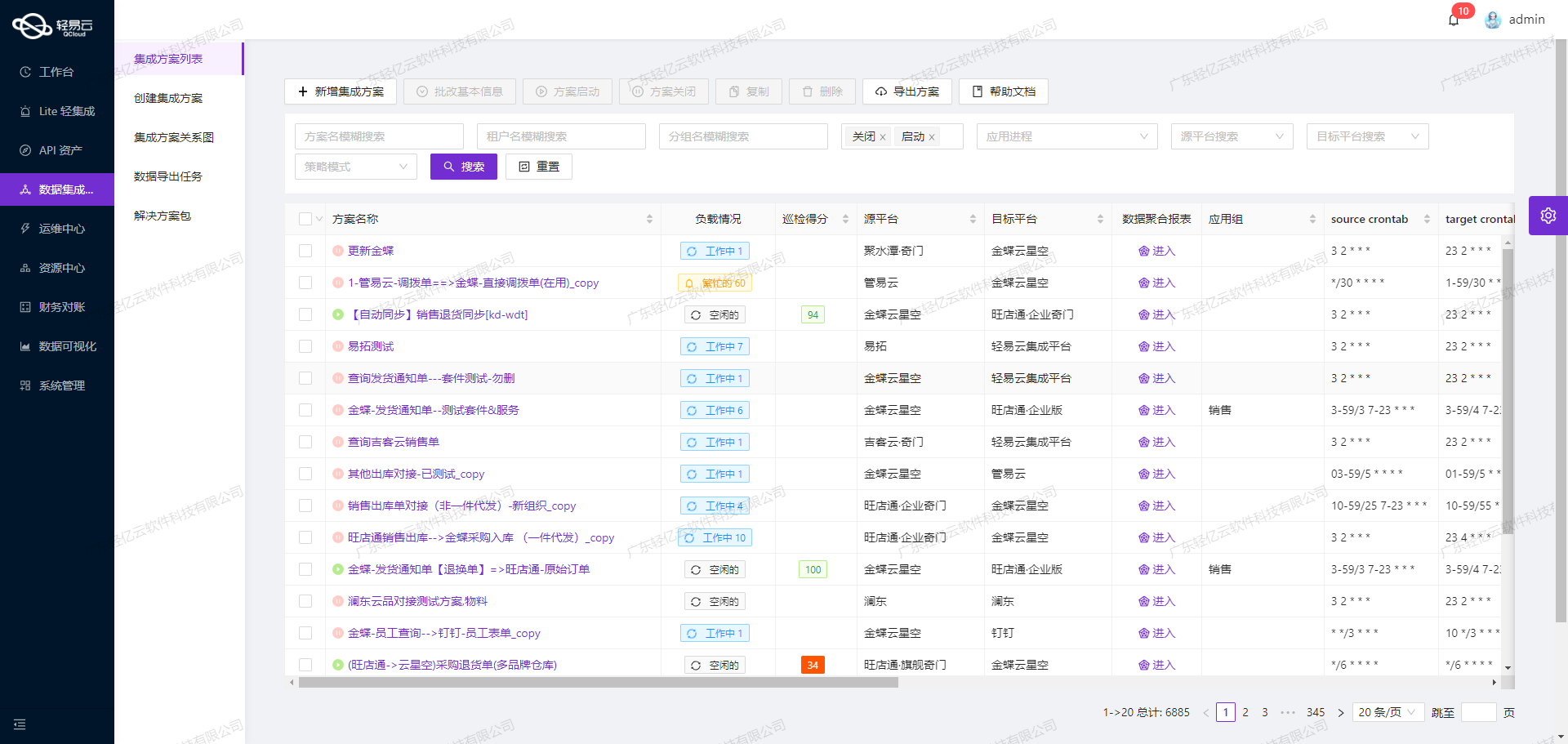

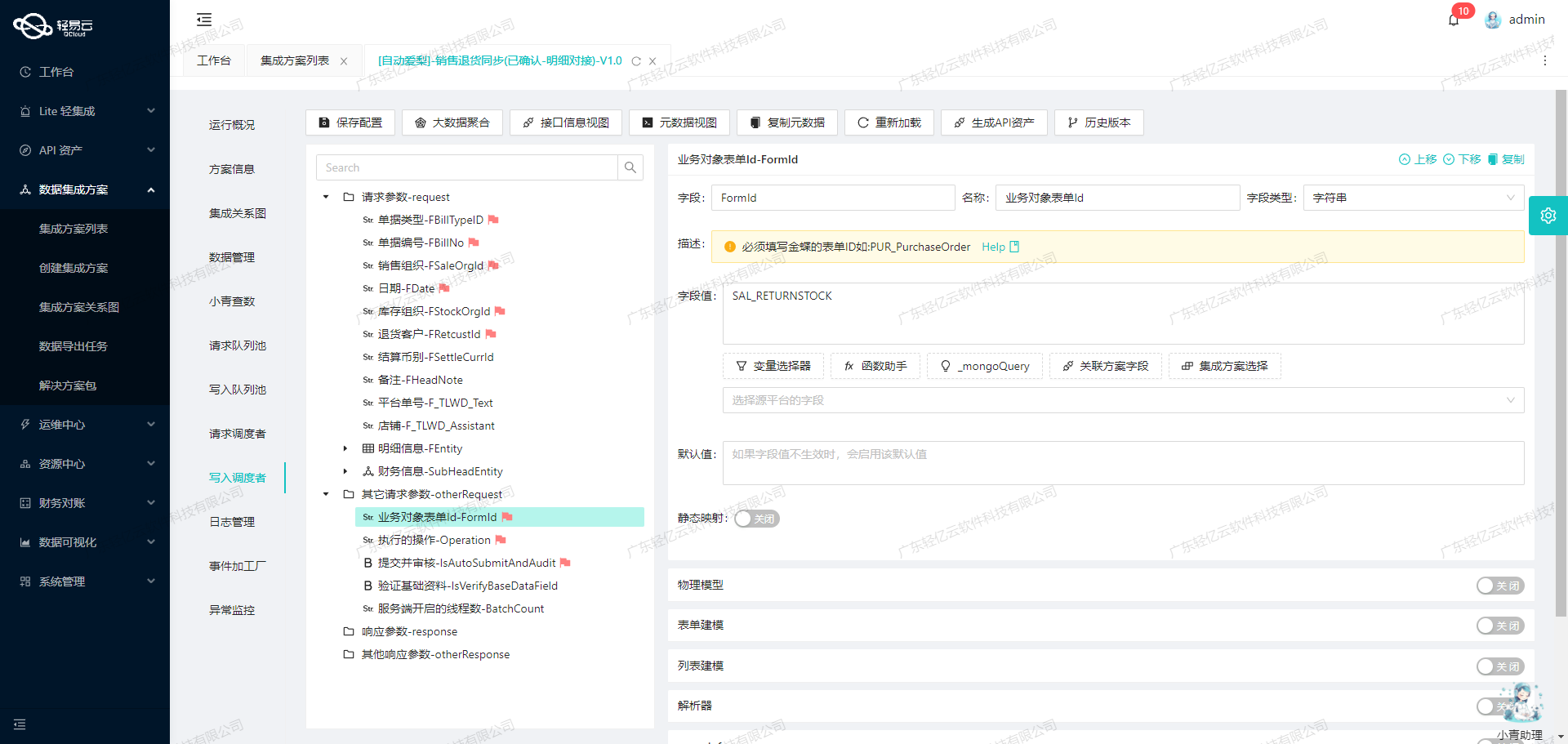

本次集成方案名为“手工补客户数据--运维”,主要任务是从有赞云获取客户信息,并将其批量写入到敦煌种业先锋系统。为了实现这一目标,我们利用了轻易云平台的一系列特性,包括高吞吐量的数据写入能力、实时监控与告警系统、以及自定义数据转换逻辑等。

首先,通过调用有赞云的API接口/youzan.users.info.query.1.0.0,我们能够定时可靠地抓取最新的客户数据。这一过程需要特别注意处理分页和限流问题,以确保所有数据都能完整无误地获取。同时,为了适应不同系统之间的数据格式差异,我们设计了定制化的数据映射对接逻辑,使得从有赞云获取的数据能够准确匹配敦煌种业先锋的要求。

在数据写入阶段,我们使用了敦煌种业先锋提供的API接口/Api/QEasyCloud/OtOCustomer。通过轻易云平台强大的高吞吐量支持,大量客户数据能够快速且稳定地导入目标系统。此外,集中监控和告警功能使得我们可以实时跟踪每个数据集成任务的状态,一旦出现异常情况,可以立即进行处理和重试,确保整个流程的可靠性和稳定性。

总之,通过合理配置和充分利用轻易云平台的各项特性,我们成功实现了有赞云与敦煌种业先锋之间的数据无缝对接,为企业提供了一套高效、可靠的数据集成解决方案。在后续章节中,我们将详细介绍具体实施步骤及技术细节。

调用有赞云接口/youzan.users.info.query.1.0.0获取并加工数据

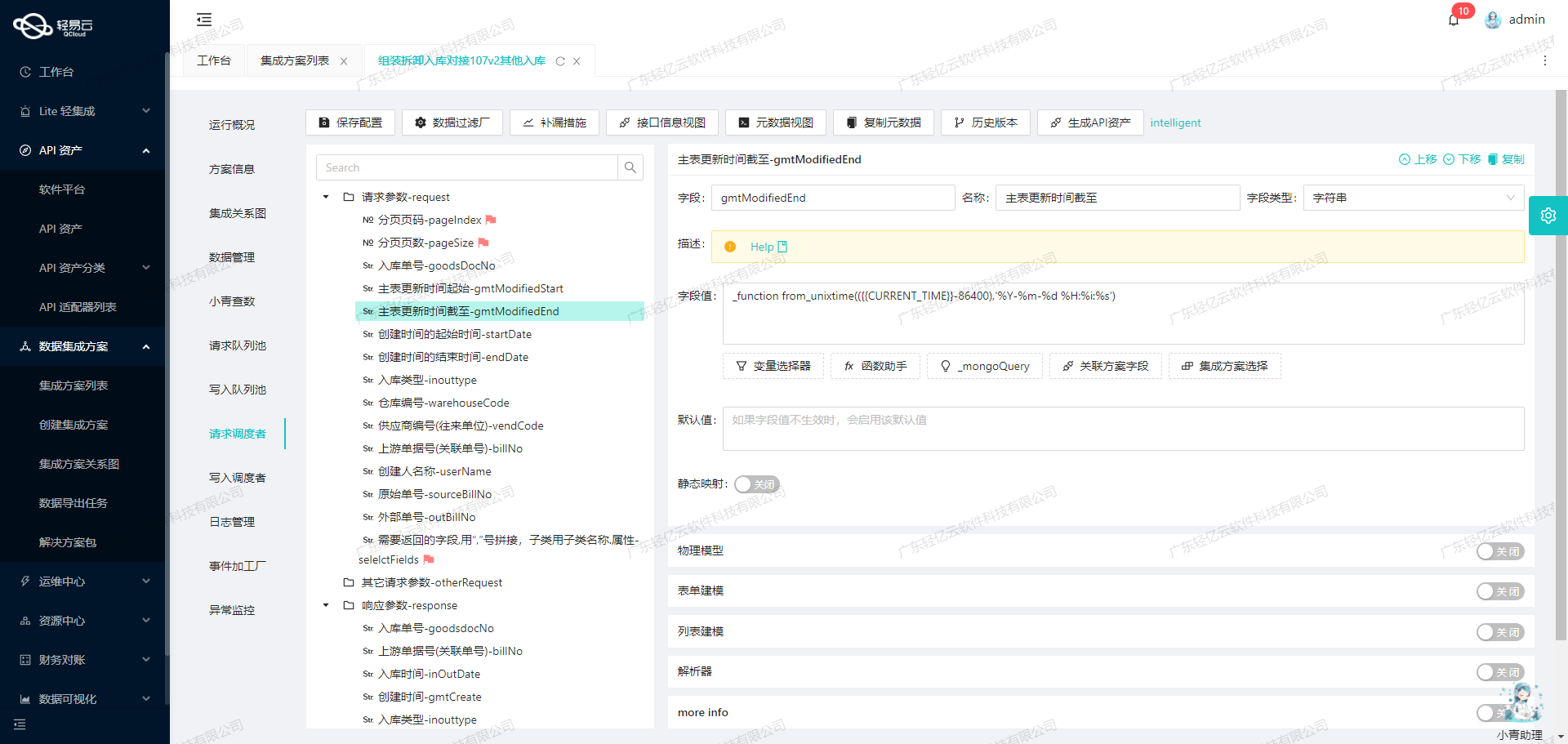

在数据集成过程中,调用源系统的API接口是至关重要的一步。本文将深入探讨如何通过轻易云数据集成平台调用有赞云接口/youzan.users.info.query.1.0.0来获取并加工客户数据。

接口调用配置

首先,我们需要配置元数据以便正确调用有赞云的API接口。以下是关键的元数据配置:

- API路径:

/youzan.users.info.query.1.0.0 - 请求方法:

GET - 请求参数:

yz_open_id: 用户唯一标识符,类型为字符串。

示例请求参数配置如下:

{

"field": "yz_open_id",

"label": "yz_open_id",

"type": "string",

"value": "111"

}数据请求与清洗

在发起API请求后,我们会收到包含用户信息的数据响应。为了确保数据质量和一致性,需要对返回的数据进行清洗和验证。例如,检查字段是否为空、格式是否正确等。

示例响应处理

假设我们从接口获取到如下响应:

{

"response": {

"users_info": [

{

"nick_name": "John Doe",

"yz_open_id": "111"

}

]

}

}我们需要提取其中的nick_name和yz_open_id字段,并进行必要的数据清洗操作,如去除空格、特殊字符等。

数据转换与写入

经过清洗后的数据可能需要进一步转换,以适应目标系统(如敦煌种业先锋)的要求。轻易云平台支持自定义数据转换逻辑,可以根据业务需求灵活调整。

自定义转换逻辑示例

例如,将nick_name字段统一转换为大写形式:

def transform_data(data):

data['nick_name'] = data['nick_name'].upper()

return data分页与限流处理

在实际应用中,有赞云接口可能会返回大量分页数据,同时存在限流机制。为了高效地抓取所有客户信息,需要实现分页处理和限流控制。

分页处理示例

通过递归或循环方式逐页请求:

def fetch_all_users():

page = 1

while True:

response = call_api(page=page)

if not response['users_info']:

break

process_response(response)

page += 1实时监控与日志记录

轻易云平台提供了实时监控和日志记录功能,可以帮助我们跟踪每一次API调用的状态和性能。这对于及时发现问题并进行调试非常重要。

日志记录示例

记录每次API调用的详细信息,包括时间戳、请求参数、响应结果等:

import logging

logging.basicConfig(level=logging.INFO)

def log_api_call(request, response):

logging.info(f"Request: {request}")

logging.info(f"Response: {response}")通过以上步骤,我们可以高效地调用有赞云接口获取客户数据,并进行必要的数据清洗、转换和写入操作。同时,通过分页处理、限流控制以及实时监控,确保整个过程顺畅无误。

集成数据写入敦煌种业先锋API接口的技术案例

在数据集成生命周期的第二步,我们将已经从源平台(如有赞云)获取的数据进行ETL转换,使其符合目标平台敦煌种业先锋API接口的要求,最终写入目标平台。本文将深入探讨这一过程中的技术细节和实现方法。

数据转换与清洗

在进行数据转换之前,首先需要对从源平台获取的数据进行清洗和预处理。清洗过程包括去除无效数据、格式化字段、处理缺失值等操作。为了确保数据质量,需要设置严格的校验规则,例如验证手机号码的有效性、检查用户ID是否重复等。

自定义数据转换逻辑

由于源平台与目标平台的数据结构和业务逻辑可能存在差异,我们需要编写自定义的数据转换逻辑,以适应特定需求。例如,从有赞云获取的用户信息包括yz_open_id、show_name、mobile和union_id等字段,而敦煌种业先锋API接口要求的字段分别为CustomerId、Name、MobilePhone和Unionid。

{

"api": "/Api/QEasyCloud/OtOCustomer",

"effect": "EXECUTE",

"method": "POST",

"number": "id",

"id": "id",

"name": "id",

"idCheck": true,

"request": [

{"field": "CustomerId", "label": "客户id", "type": "string", "value": "{yz_open_id}"},

{"field": "Name", "label": "用户名称(昵称)", "type": "string", "value": "{show_name}"},

{"field": "MobilePhone", "label": "手机号码", "type": "string", "value": "{mobile}"},

{"field": "Unionid", "label": "微信unionid", "type": "string", "value": "{union_id}"}

]

}在这个配置中,我们将有赞云的数据字段映射到敦煌种业先锋API接口所需的字段名称,确保数据能够正确传输并被目标系统接收。

批量数据处理与高吞吐量支持

为了提高数据处理效率,轻易云平台支持批量数据处理和高吞吐量的数据写入能力。这意味着我们可以一次性处理大量数据,并快速将其写入到敦煌种业先锋系统中,极大提升了数据集成的时效性。

分页与限流处理

在调用有赞云接口时,需要特别注意分页和限流问题。通过合理设置分页参数,可以确保每次请求的数据量在可控范围内,避免因单次请求过大而导致接口超时或失败。同时,通过限流机制,可以防止短时间内过多请求对系统造成压力,保障系统稳定性。

实时监控与日志记录

为了及时发现并解决数据集成过程中的问题,轻易云平台提供了实时监控和日志记录功能。通过集中监控系统,可以实时跟踪每个数据集成任务的状态和性能,及时发现异常情况并进行处理。此外,详细的日志记录能够帮助我们追溯问题根源,提供有效的故障排除依据。

异常处理与错误重试机制

在实际操作中,不可避免会遇到各种异常情况,如网络波动、接口响应超时等。为此,我们需要设计健壮的异常处理机制,包括错误捕获、重试策略等。例如,当某次请求失败时,可以根据预设的重试策略重新发起请求,以确保数据最终成功写入目标平台。

定制化数据映射对接

针对不同业务需求,我们可以通过轻易云平台提供的可视化工具,自定义数据映射规则,实现灵活的数据对接。例如,对于某些特定业务场景,我们可能需要对部分字段进行特殊处理,如加密敏感信息、格式化日期等,这些都可以通过自定义逻辑实现。

综上所述,通过合理配置元数据、自定义转换逻辑、高效批量处理以及完善的监控与异常处理机制,我们能够顺利完成从源平台到目标平台的数据ETL转换,实现高效可靠的数据集成。