查询班牛店铺:班牛数据集成到班牛的技术实现

在企业信息化管理中,数据的高效集成和处理是关键环节。本文将分享一个具体案例,展示如何通过轻易云数据集成平台,将班牛的数据无缝对接到班牛系统中,实现“查询班牛店铺”的功能。

高吞吐量的数据写入能力

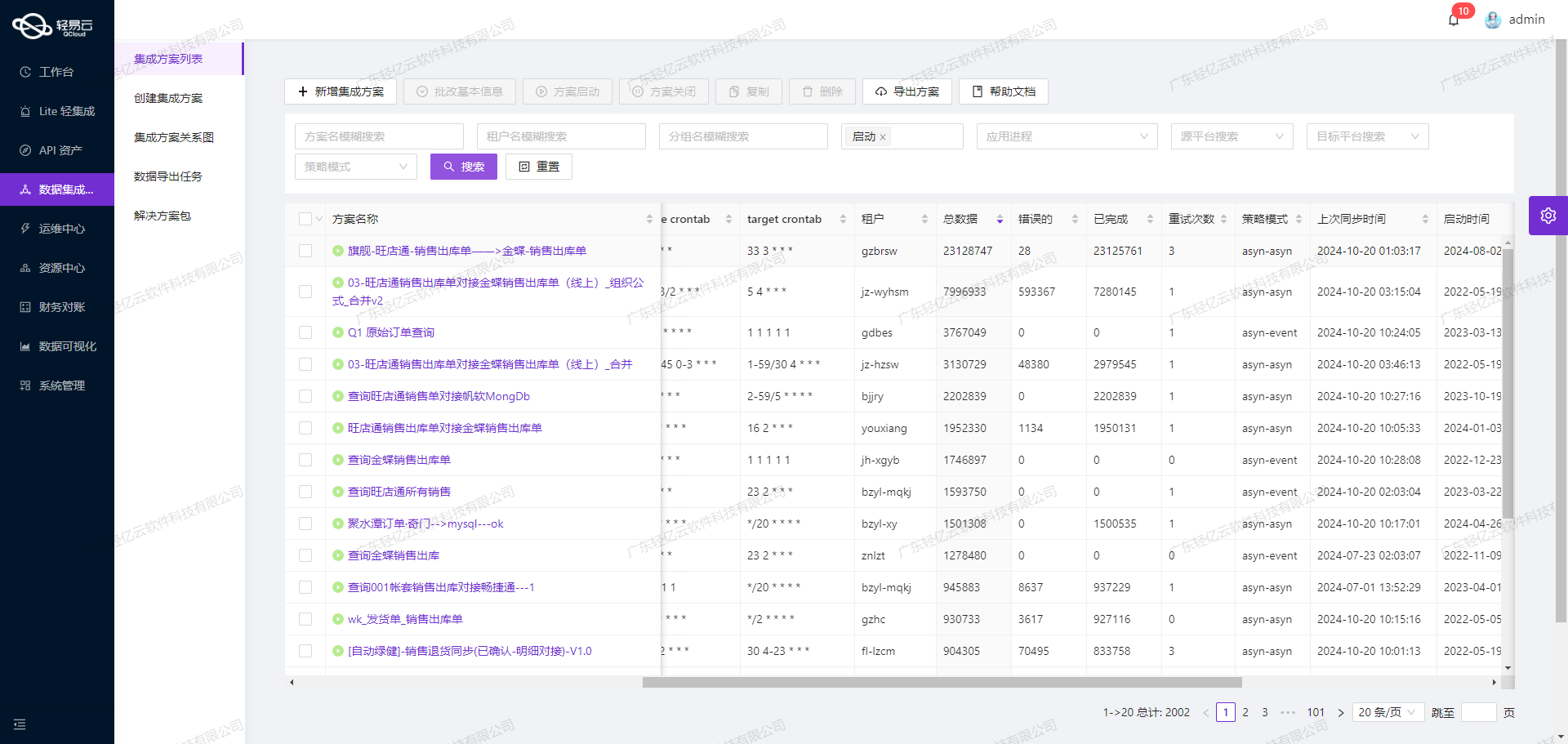

为了确保大量数据能够快速被集成到班牛系统,我们利用了平台强大的高吞吐量数据写入能力。这一特性使得在短时间内处理和传输大规模数据成为可能,大幅提升了整体效率。

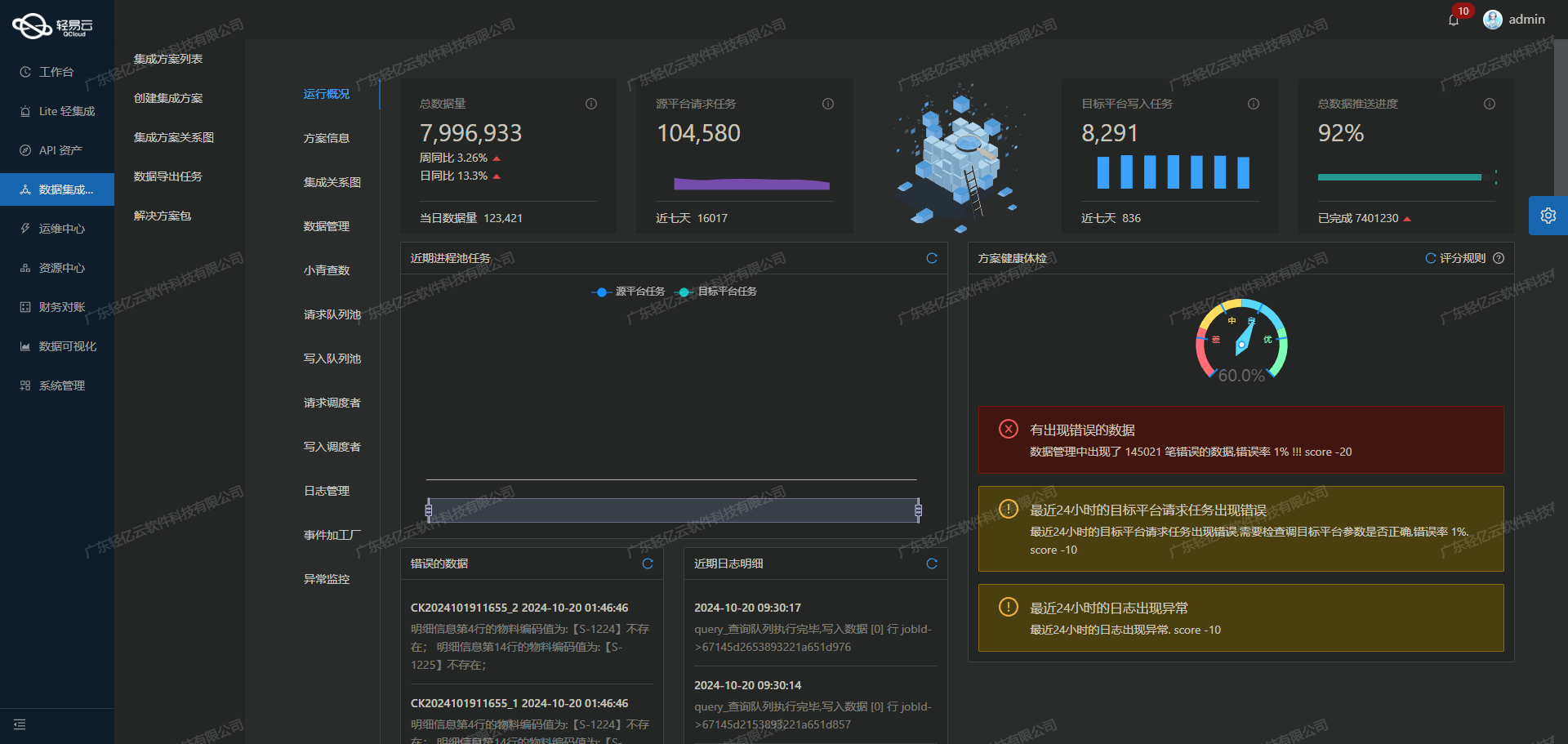

实时监控与告警系统

在整个数据集成过程中,实时监控与告警系统发挥了重要作用。通过这一系统,我们可以实时跟踪每个任务的状态和性能指标,及时发现并解决潜在问题,确保数据流动的顺畅和稳定。

数据质量监控与异常检测

为了保证集成过程中不漏单、不出错,我们特别关注了数据质量监控与异常检测机制。该机制能够自动识别并处理异常情况,从而保障最终写入的数据准确无误。

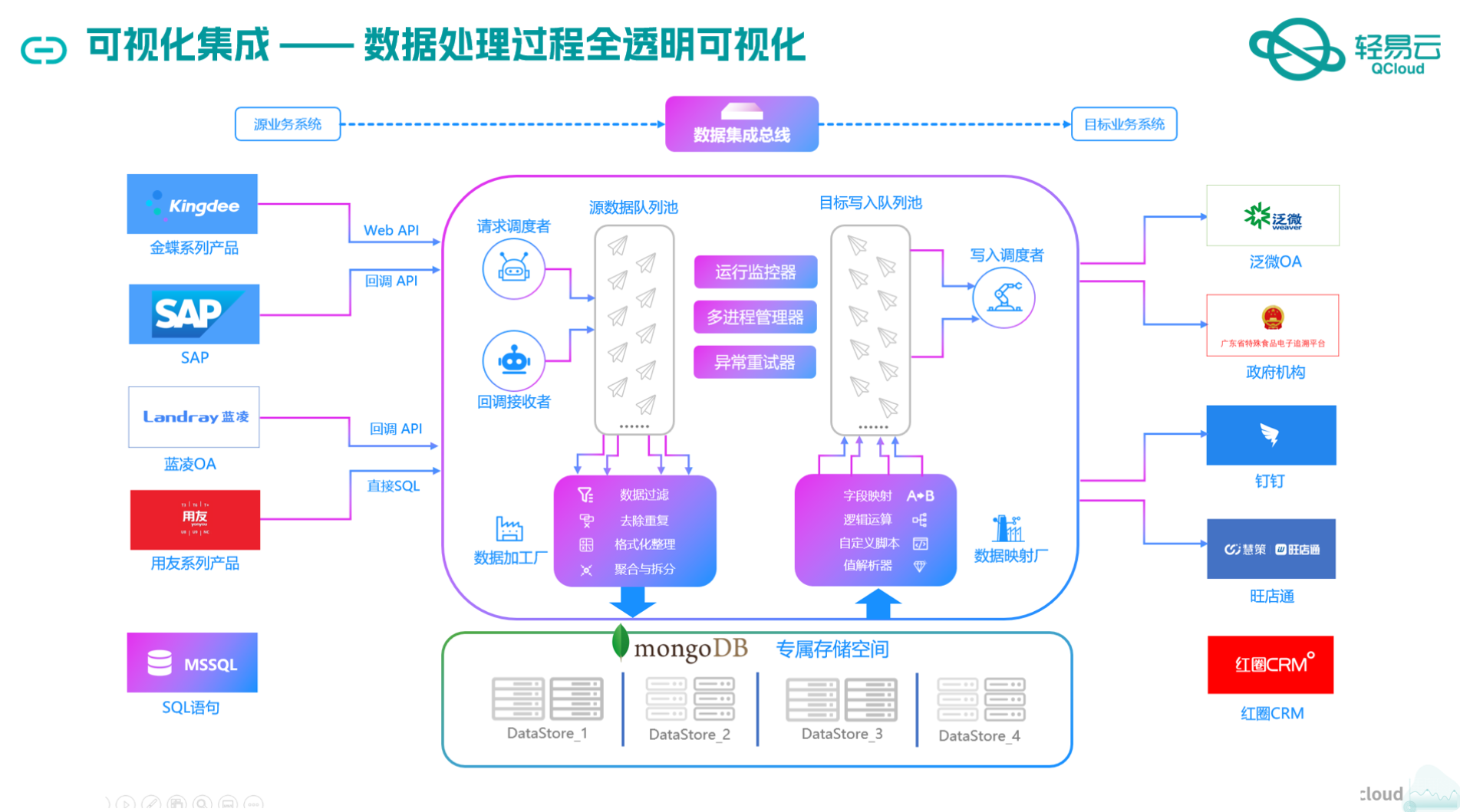

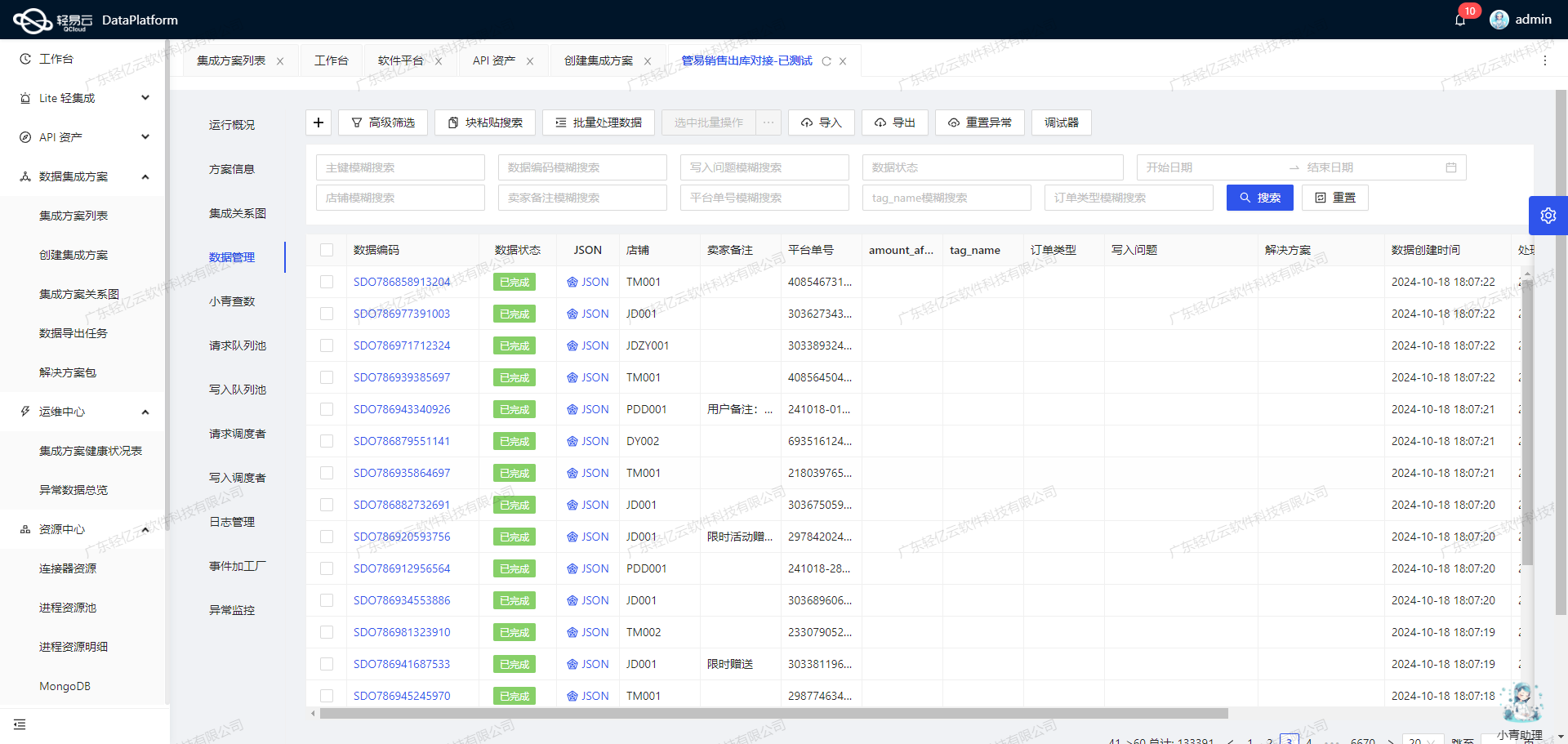

可视化的数据流设计工具

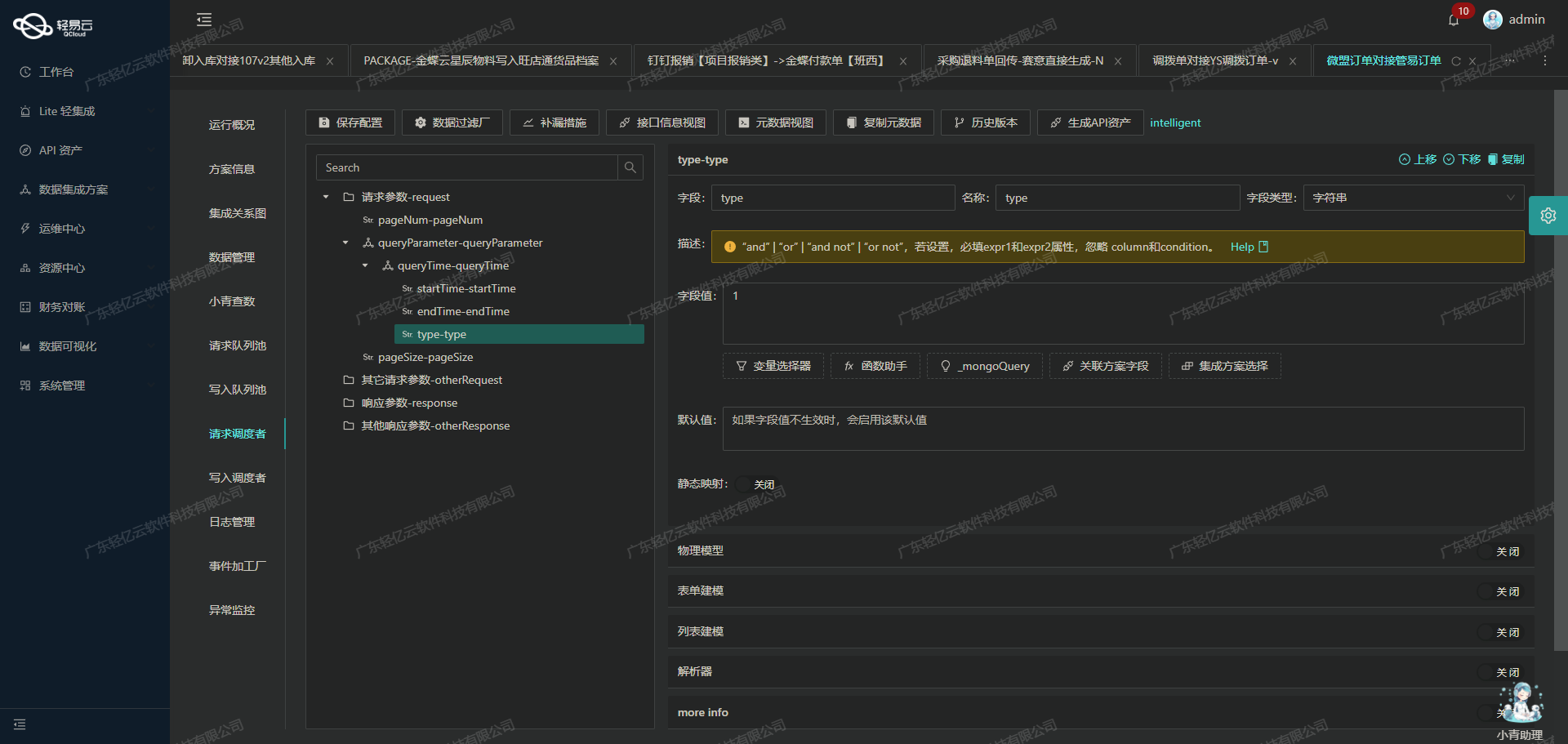

使用可视化的数据流设计工具,使得整个配置过程更加直观、易于管理。通过拖拽式操作界面,我们可以轻松定义和调整各个节点及其之间的关系,大大简化了复杂业务逻辑的实现过程。

自定义数据转换逻辑

针对特定业务需求和数据结构差异,我们还支持自定义的数据转换逻辑。这一功能允许我们根据实际情况灵活调整数据格式,以适应不同场景下的应用需求。

以上这些特性共同构建了一个高效、可靠且灵活的数据集成方案,为“查询班牛店铺”功能提供了坚实保障。在接下来的章节中,我们将详细介绍具体实施步骤及技术细节。

调用班牛接口column.list获取并加工数据

在数据集成的生命周期中,调用源系统接口是至关重要的一步。本文将详细探讨如何通过轻易云数据集成平台调用班牛接口column.list来获取和加工数据。

接口配置与请求参数

首先,我们需要了解如何配置和调用班牛的column.list接口。根据提供的元数据配置,以下是关键参数:

- API:

column.list - Method:

GET - Request Parameters:

project_id: 固定值为25821

- Condition:

column_id: 使用模糊查询,值为26388

这些参数定义了我们要从班牛系统中提取哪些特定的数据。

数据请求与清洗

在轻易云平台上,我们可以通过可视化界面配置上述参数,并发送HTTP GET请求到班牛的API端点。具体步骤如下:

-

配置API请求: 在轻易云平台的API管理模块中,选择创建新的API请求,并填写上述元数据中的各项参数。确保HTTP方法设置为GET,请求URL指向班牛的

column.list端点。 -

发送请求并获取响应: 配置完成后,发送请求以获取响应数据。这一步骤会返回一个包含多个字段的数据集,其中包括我们感兴趣的字段,如

column_id,project_id等。 -

清洗数据: 获取到原始数据后,需要对其进行清洗和预处理。例如,可以使用过滤条件来筛选出符合业务需求的数据记录。在本例中,我们使用模糊查询条件来筛选出所有包含特定

column_id=26388的数据条目。

数据转换与写入

在完成初步的数据清洗后,下一步是将这些数据转换为目标格式,并写入到指定的位置。这通常涉及以下几个步骤:

-

自定义转换逻辑: 根据业务需求,自定义转换逻辑以适应不同的数据结构。例如,将原始JSON格式的数据转换为表格形式,以便于后续处理和分析。

-

批量写入操作: 利用轻易云平台支持高吞吐量写入能力,将大量清洗后的数据快速写入到目标数据库或其他存储系统中。这一步骤确保了大规模数据能够被高效地处理和存储。

-

实时监控与异常处理: 在整个过程中,通过轻易云的平台提供的集中监控和告警系统,可以实时跟踪每个任务的状态。如果出现任何异常情况,例如网络超时或API限流问题,可以及时触发告警并进行错误重试机制,以保证任务顺利完成。

实践案例:查询店铺信息

假设我们需要查询某个项目下所有店铺的信息,并且这些店铺ID包含特定字符(如"26388")。具体操作如下:

- 在轻易云平台上创建一个新的API任务。

- 配置任务参数,包括项目ID(固定值25821)和模糊查询条件(列ID包含26388)。

- 发送GET请求到班牛接口,并接收返回结果。

- 对返回结果进行清洗,只保留符合条件的记录。

- 将清洗后的数据批量写入到目标数据库中,用于进一步分析和处理。

通过以上步骤,我们可以高效地从班牛系统中提取所需信息,并确保整个过程透明、可控且高效。这种方法不仅提高了工作效率,还极大地减少了手动操作带来的错误风险。

集成方案:查询班牛店铺

在数据集成生命周期的第二步,重点是将已经集成的源平台数据进行ETL转换,使其符合班牛API接口要求的格式,并最终写入目标平台。这里,我们以查询班牛店铺为例,详细探讨如何实现这一过程。

数据请求与清洗

首先,从源平台获取原始数据。这一阶段我们需要确保数据的完整性和准确性。通过轻易云的数据集成平台,我们能够高效地抓取所需的数据,并对其进行初步清洗,去除冗余信息和噪音数据。

数据转换与写入

进入ETL转换阶段,我们需要将清洗后的数据转换为班牛API接口能够接收的格式。这里以班牛API接口workflow.task.create为例,该接口通过POST方法执行任务创建操作。

元数据配置如下:

{

"api": "workflow.task.create",

"effect": "EXECUTE",

"method": "POST",

"idCheck": true

}数据格式转换

- 字段映射:首先,需要将源数据字段映射到目标API所需的字段。例如,源数据中的店铺名称、地址等信息需要分别映射到班牛API接口对应的字段。

- 数据类型转换:确保源数据类型与目标API字段类型一致。例如,将字符串类型的数据转换为整数或日期类型,以符合班牛API的要求。

- 自定义逻辑处理:根据业务需求,可以添加一些自定义的逻辑处理,例如对某些字段进行加密处理或者根据特定规则生成新的字段值。

批量处理与分页

由于班牛API可能对单次请求的数据量有限制,因此需要实现批量处理和分页功能。通过轻易云提供的高吞吐量写入能力,可以将大批量的数据分批次快速写入到班牛系统中。

异常处理与重试机制

在实际操作中,不可避免会遇到网络波动或其他异常情况。为了确保数据不漏单,需要实现异常处理与重试机制。一旦检测到写入失败,通过捕捉异常并记录日志,再进行重试操作,确保最终所有数据都能成功写入目标平台。

实时监控与告警

通过轻易云平台提供的集中监控和告警系统,可以实时跟踪整个ETL转换过程中的任务状态和性能。一旦发现异常情况,系统会及时发出告警通知,便于迅速采取措施。

数据质量监控与优化

在ETL过程中,保持高质量的数据至关重要。利用轻易云的数据质量监控功能,可以实时检测并处理异常数据,确保最终写入目标平台的数据质量可靠。此外,通过优化配置资源,实现高效利用和性能提升。

关键技术点总结

- 高吞吐量写入:确保大量数据能够快速且稳定地写入班牛系统。

- 自定义转换逻辑:灵活适应不同业务需求,实现精准的数据映射和转换。

- 异常处理机制:通过日志记录和重试机制,保证数据完整性和一致性。

- 实时监控与告警:全程跟踪ETL过程中的任务状态,及时响应问题。

- 分页与限流管理:合理控制单次请求的数据量,提高系统稳定性和效率。

通过以上技术手段,可以有效地完成从源平台到班牛API接口的数据ETL转换及写入工作,实现高效、稳定、可靠的数据集成。