案例分享:销售出库调用供应商配送通知

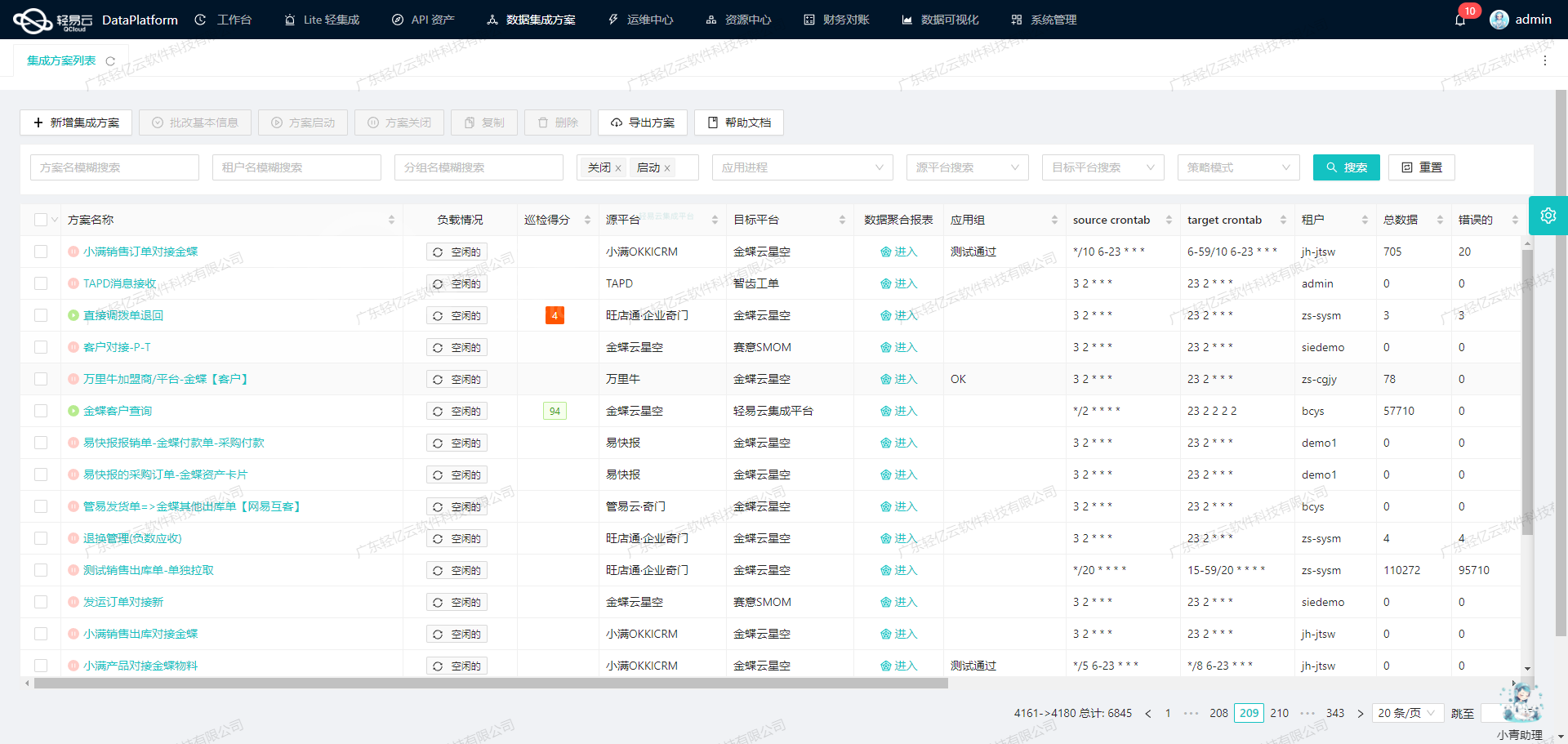

在本案例中,我们将深入探讨如何实现旺店通·企业版数据集成到南方电网商城平台的具体技术方案,尤其聚焦于"销售出库调用供应商配送通知"这一核心任务。此过程涉及多个关键步骤,包括数据抓取、转换、写入和实时监控。

首先,确保从旺店通·企业版系统准确且全量地获取销售信息,是整个集成流程的基础。我们采用stockout_order_query_trade API接口定时抓取销量数据,并处理分页和限流问题,以保证高效和稳定的数据传输。在此过程中,通过定时任务模块精确调度API调用频率,从而达到可靠的数据采集效果。

接着,需要解决的是二次加工与批量转换问题。南方电网商城平台对接接口要求特定的数据格式,因此,在将原始订单信息转化为目标系统接受的JSON结构之前,需要进行一系列字段映射及逻辑处理。这不仅需要解析所有必要字段,还需根据业务规则进行适当过滤与整合,以满足目的平台的需求。同时,利用轻易云提供的ETL(抽取-转换-加载)功能,可以快速完成大量数据的批处理操作,提高效率。

此外,为了应对双方系统可能存在的不一致性或异常情况,实现健壮而灵活错误重试机制是非常重要的一环。一旦监测到由网络波动或其他原因导致的数据传输失败,应当立即启动自动重试策略,同时记录详细日志以供后续分析追溯,从而最小化运营风险并提升服务连续性。而对于实际成功上报至/o2om/v1/csg-supplier-consignment-inform API 的每条订单,本项目开发了全面详尽的日志体系用于实时跟踪每笔交易状态,这有助于快速定位潜在问题并及时调整策略。

通过上述几个方面层层把关,不仅能够确保每份订单不漏单、迅速落地执行,而且实现端到端透明可视化管理,为客户带来前所未有的信息交互体验。本案例展示了智能化解决方案在复杂异构环境下卓越表现,将为业界提供宝贵参考范式。

调用旺店通·企业版接口stockout_order_query_trade获取并加工数据

在数据集成的生命周期中,调用源系统接口获取数据是至关重要的一步。本文将深入探讨如何使用轻易云数据集成平台调用旺店通·企业版的stockout_order_query_trade接口,并对获取的数据进行初步加工。

接口调用配置

首先,我们需要配置接口调用的元数据。根据提供的metadata,我们可以看到以下关键配置:

- API名称:

stockout_order_query_trade - 请求方法:

POST - 分页设置: 每页返回100条数据

- ID检查: 启用(

idCheck: true) - 条件过滤: 排除

trade_type为3的数据

请求参数

为了实现增量数据获取,我们需要设置开始时间和结束时间。以下是请求参数的详细配置:

-

开始时间 (

start_time):- 类型:datetime

- 描述:增量获取数据,格式为

yyyy-MM-dd HH:mm:ss - 值:

{{LAST_SYNC_TIME|datetime}}

-

结束时间 (

end_time):- 类型:datetime

- 描述:增量获取数据,格式为

yyyy-MM-dd HH:mm:ss - 值:

{{CURRENT_TIME|datetime}}

-

状态 (

status):- 类型:string

- 描述:订单状态,包括已取消、已审核、已发货等

-

系统订单编号 (

src_order_no):- 类型:string

-

原始单号 (

src_tid):- 类型:string

-

出库单号 (

stockout_no):- 类型:string

-

店铺编号 (

shop_no):- 类型:string

- 描述:用于区分不同店铺

-

仓库编号 (

warehouse_no):- 类型:string

- 描述:用于区分不同仓库

-

分页大小 (

page_size):- 类型:string

- 描述:每页返回的数据条数,默认为40,最大值为100

- 值:

{PAGINATION_PAGE_SIZE}

-

页号 (

page_no):- 类型:string

- 描述:不传值默认从0页开始

- 值:

{PAGINATION_START_PAGE}

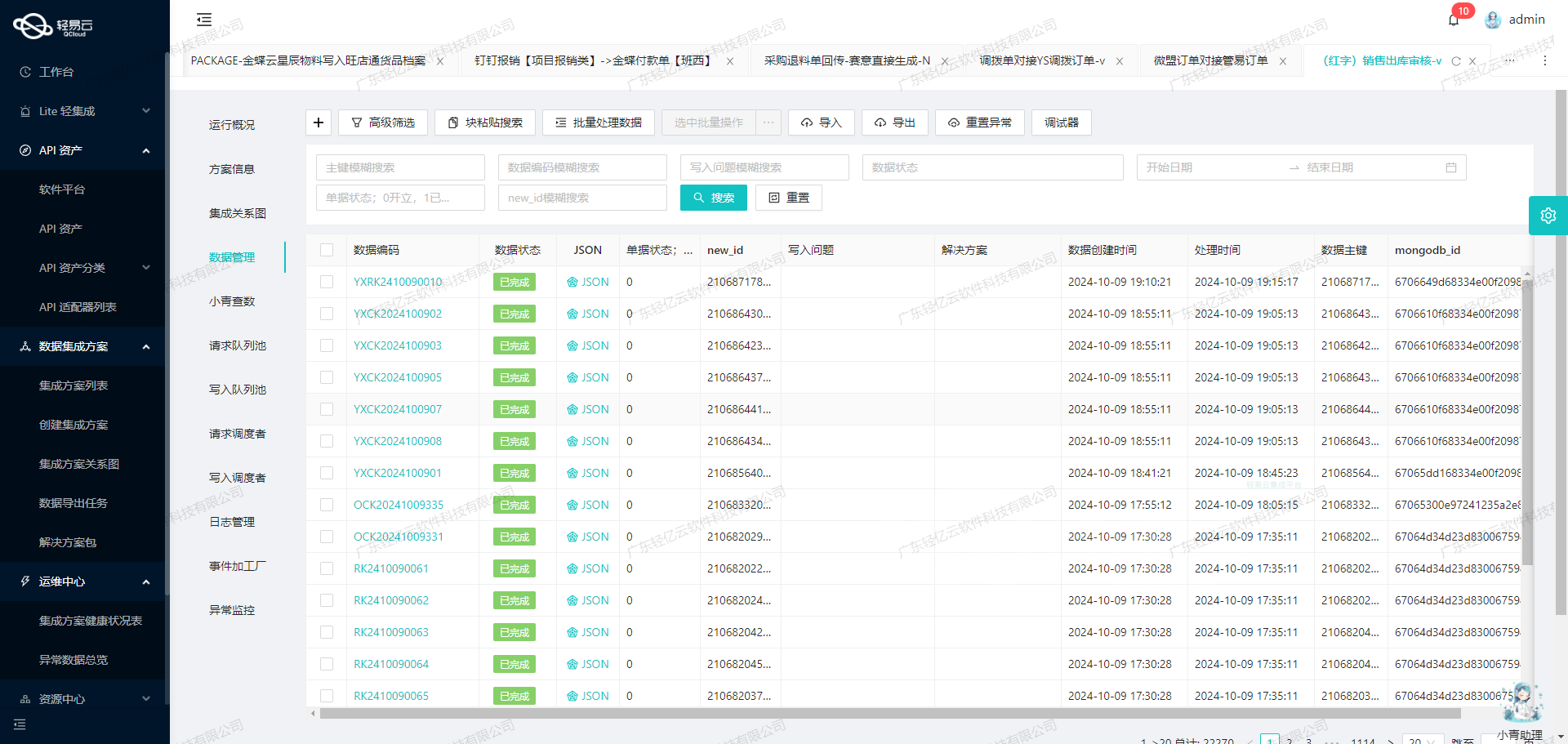

数据请求与清洗

在配置好请求参数后,我们可以通过轻易云平台发送POST请求到旺店通·企业版接口以获取销售出库数据。由于我们启用了分页,每次请求将返回最多100条记录。

在接收到响应后,需要对数据进行初步清洗和验证。以下是一些关键步骤:

-

ID检查: 确保每条记录都有唯一的出库单号(

stockout_id),避免重复处理。 -

过滤无效数据: 根据条件过滤掉不符合要求的数据,例如排除

trade_type为3的记录。 -

时间格式转换: 确保所有时间字段(如开始时间和结束时间)都符合标准格式,以便后续处理。

数据转换与写入

经过清洗后的数据需要进行进一步转换,以适应目标系统的需求。这可能包括字段重命名、类型转换等操作。最后,将处理好的数据写入目标系统或数据库中。

实时监控与错误处理

在整个过程中,实时监控和错误处理是不可或缺的部分。通过轻易云平台提供的可视化界面,可以实时查看数据流动和处理状态。一旦出现错误,可以快速定位并修正问题,确保数据集成过程顺利进行。

通过以上步骤,我们成功实现了从旺店通·企业版获取销售出库数据并进行初步加工,为后续的数据处理奠定了基础。这一过程展示了轻易云平台在异构系统集成中的强大能力和灵活性。

轻易云数据集成平台ETL转换技术案例:南方电网商城平台API接口

在数据集成的生命周期中,ETL(Extract, Transform, Load)转换是至关重要的一步。本文将详细探讨如何使用轻易云数据集成平台,将源平台的数据经过ETL转换后,写入南方电网商城平台的API接口。

数据请求与清洗

首先,我们需要从源平台获取原始数据。假设我们已经完成了数据请求与清洗阶段,接下来重点关注如何将这些数据转换为目标平台所需的格式,并通过API接口写入南方电网商城平台。

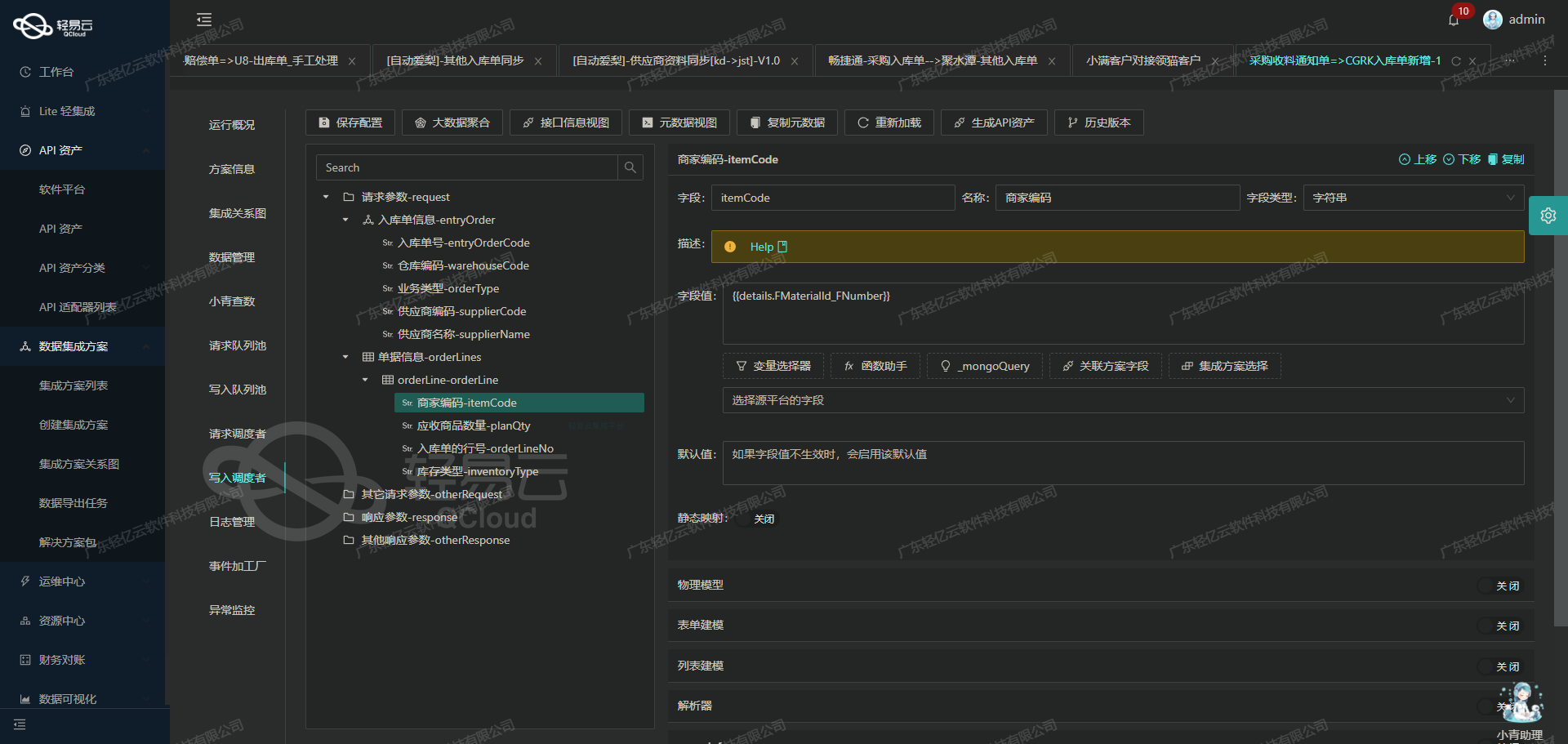

数据转换与写入

为了实现这一过程,我们需要配置元数据,并根据目标平台的API要求进行相应的数据转换。以下是具体的元数据配置和技术实现细节。

元数据配置解析

{

"api": "/o2om/v1/csg-supplier-consignment-inform",

"method": "POST",

"idCheck": true,

"request": [

{

"field": "orderId",

"label": "采购平台申购订单号",

"type": "string",

"value": "{src_tids}"

},

{

"field": "type",

"label": "类型",

"type": "string",

"value": "1"

},

{

"field": "deliveryInfo",

"label": "货运单信息集合",

"type": "array",

"children": [

{

"field": "deliveryId",

"label": "货运单号",

"type": "string",

"value": "{logistics_no}",

"parent": "deliveryInfo"

},

{

"field": "carrier",

"label": "承运商",

"type": "string",

...

},

...

]

}

]

}API接口字段映射

- orderId: 对应源平台的采购订单号

{src_tids}。 - type: 固定值

1,表示某种特定类型。 - deliveryInfo: 包含多个子字段,如

deliveryId、carrier等。

子字段详细配置

- deliveryId: 映射到源数据中的物流单号

{logistics_no}。 - carrier: 映射到承运商名称

{logistics_name},并进行正向映射。 - thirdSubOrderId: 使用随机生成的值

{random}。 - skuInfos: 商品信息数组,其中包括商品编码、商品名称和商品数量等字段。

数据转换逻辑

- 字符串映射:将源平台的字段直接映射到目标字段,例如

orderId和deliveryId。 - 固定值设置:如

type字段设置为固定值1。 - 数组处理:对于

deliveryInfo和skuInfos等数组类型字段,需要遍历源数据并逐一映射到目标结构中。 - 函数应用:对于需要计算或处理的数据,如商品数量,需要使用函数

_function round({{details_list.goods_count}},0)来确保数值正确。

实现步骤

- 提取原始数据:从源系统提取包含订单信息、物流信息和商品信息的数据。

- 应用元数据配置:根据元数据配置文件,将提取的数据进行转换。例如,将

{src_tids}映射到orderId字段,将{logistics_no}映射到deliveryId字段等。 - 调用API接口:使用POST方法,将转换后的数据发送到南方电网商城平台的

/o2om/v1/csg-supplier-consignment-inform接口。

import requests

import json

# 假设已经获取并清洗好的源数据

source_data = {

'src_tids': '123456789',

'logistics_no': '987654321',

'logistics_name': 'XYZ Logistics',

'details_list': [

{'goods_no': 'A001', 'goods_name': 'Product A', 'goods_count': 10},

{'goods_no': 'B002', 'goods_name': 'Product B', 'goods_count': 5}

]

}

# 转换后的目标数据结构

target_data = {

'orderId': source_data['src_tids'],

'type': '1',

'deliveryInfo': [

{

'deliveryId': source_data['logistics_no'],

'carrier': source_data['logistics_name'],

'thirdSubOrderId': str(uuid.uuid4()), # 随机生成

'skuInfos': [

{'skuId': item['goods_no'],

'skuName': item['goods_name'],

'skuNum': round(item['goods_count'], 0)}

for item in source_data['details_list']

]

}

]

}

# 调用API接口

response = requests.post(

url='https://example.com/o2om/v1/csg-supplier-consignment-inform',

headers={'Content-Type': 'application/json'},

data=json.dumps(target_data)

)

print(response.status_code, response.json())通过以上步骤,我们成功地将源平台的数据经过ETL转换后,写入到了南方电网商城的平台API接口中。