马帮补货表集成到MySQL的技术方案分享

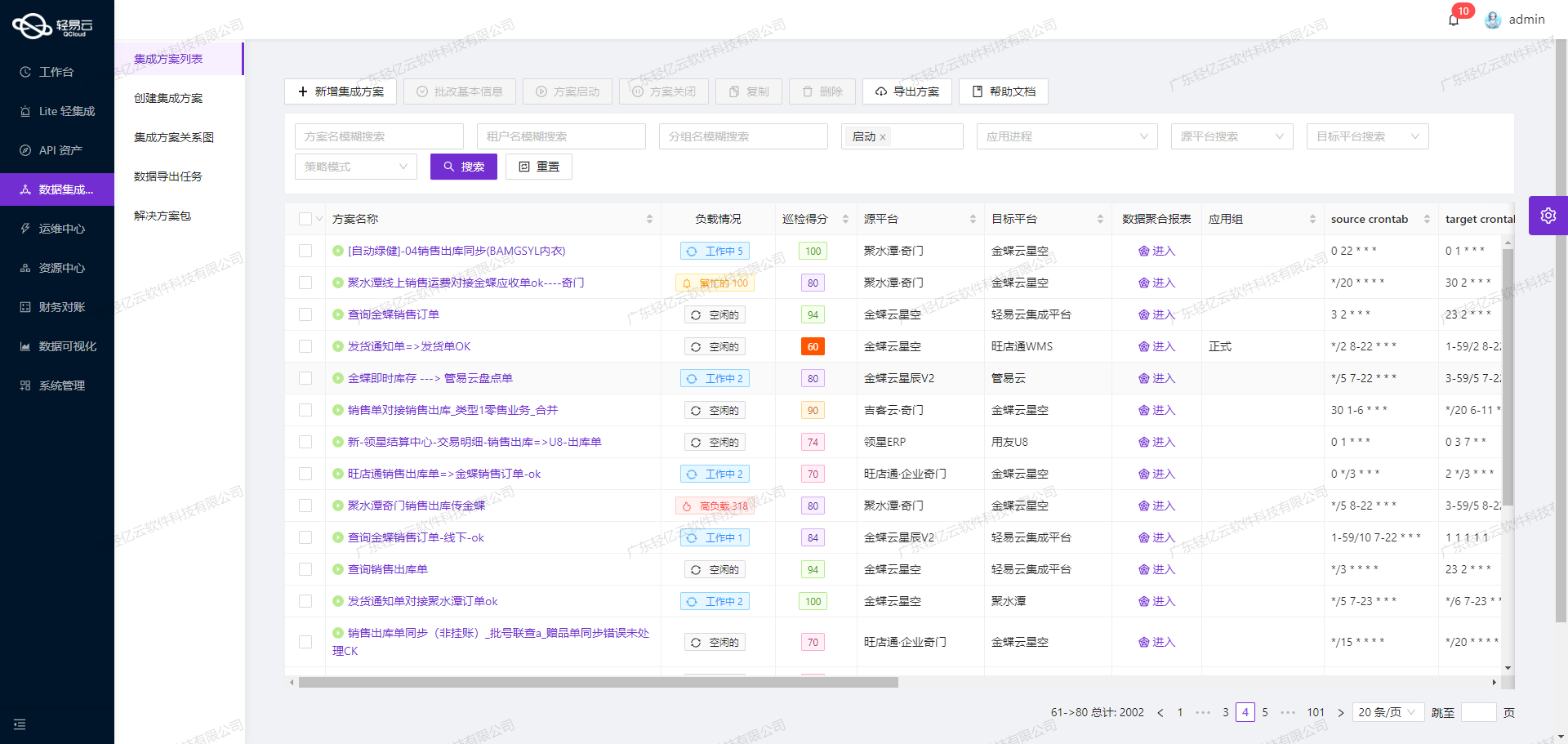

在数据驱动的业务环境中,如何高效、可靠地将马帮平台的数据集成到MySQL数据库,是许多企业面临的重要挑战。本文将详细介绍一个已验证的解决方案——“马帮补货表=>MYSQL”,通过轻易云数据集成平台实现这一目标。

任务背景与需求分析

马帮平台提供了丰富的API接口,其中fba-balntellect-stock-batch-list用于获取补货表数据。为了确保这些数据能够及时、高效地写入到MySQL数据库,我们需要一个具备高吞吐量和实时监控能力的数据集成方案。同时,考虑到数据质量和异常处理问题,必须实现全面的数据质量监控和错误重试机制。

技术要点与解决方案

-

高吞吐量的数据写入能力:为了应对大量数据的快速写入需求,我们采用了轻易云平台的批量写入功能,通过调用MySQL的

batchexecuteAPI,实现大规模数据的高效导入。这不仅提升了数据处理时效性,还减少了系统资源消耗。 -

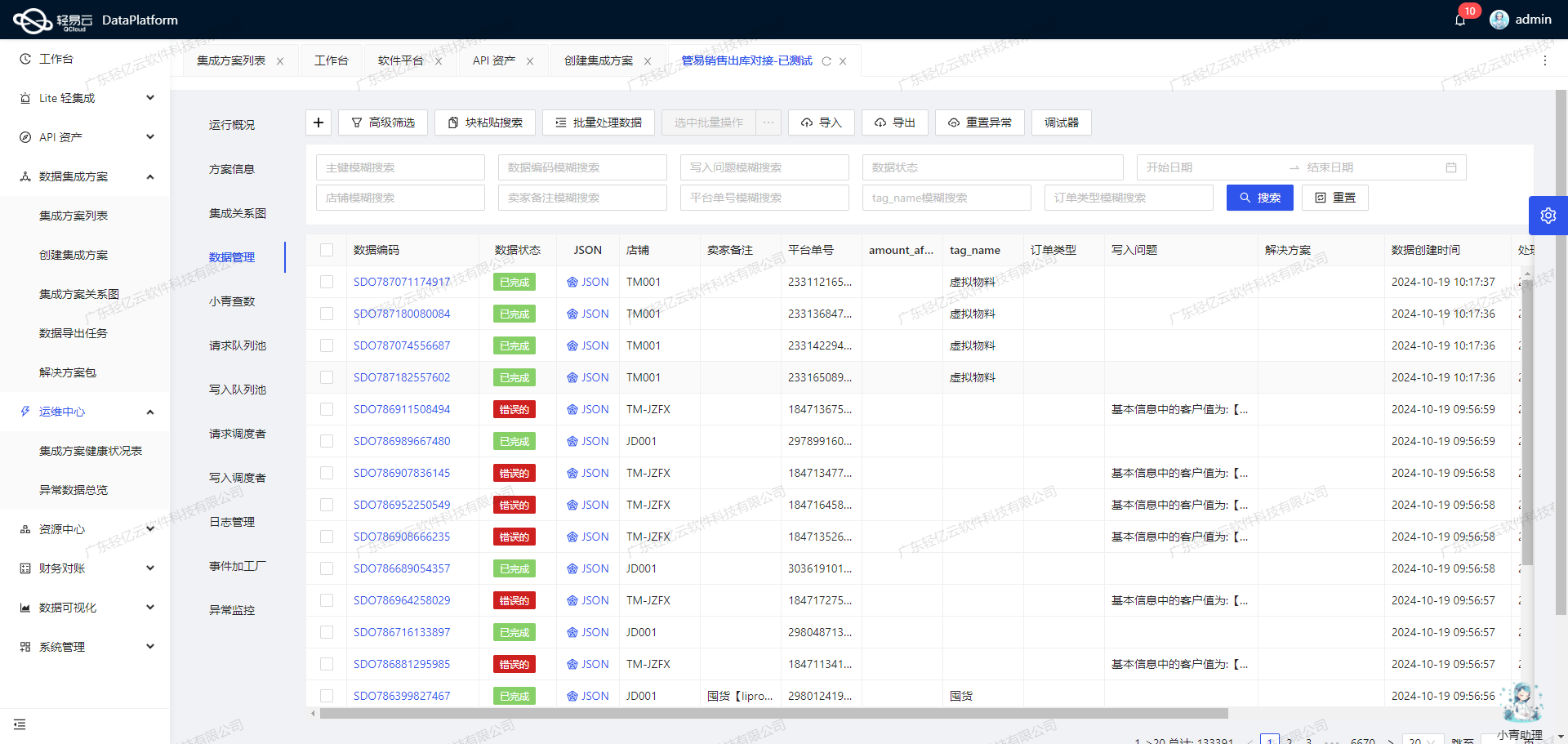

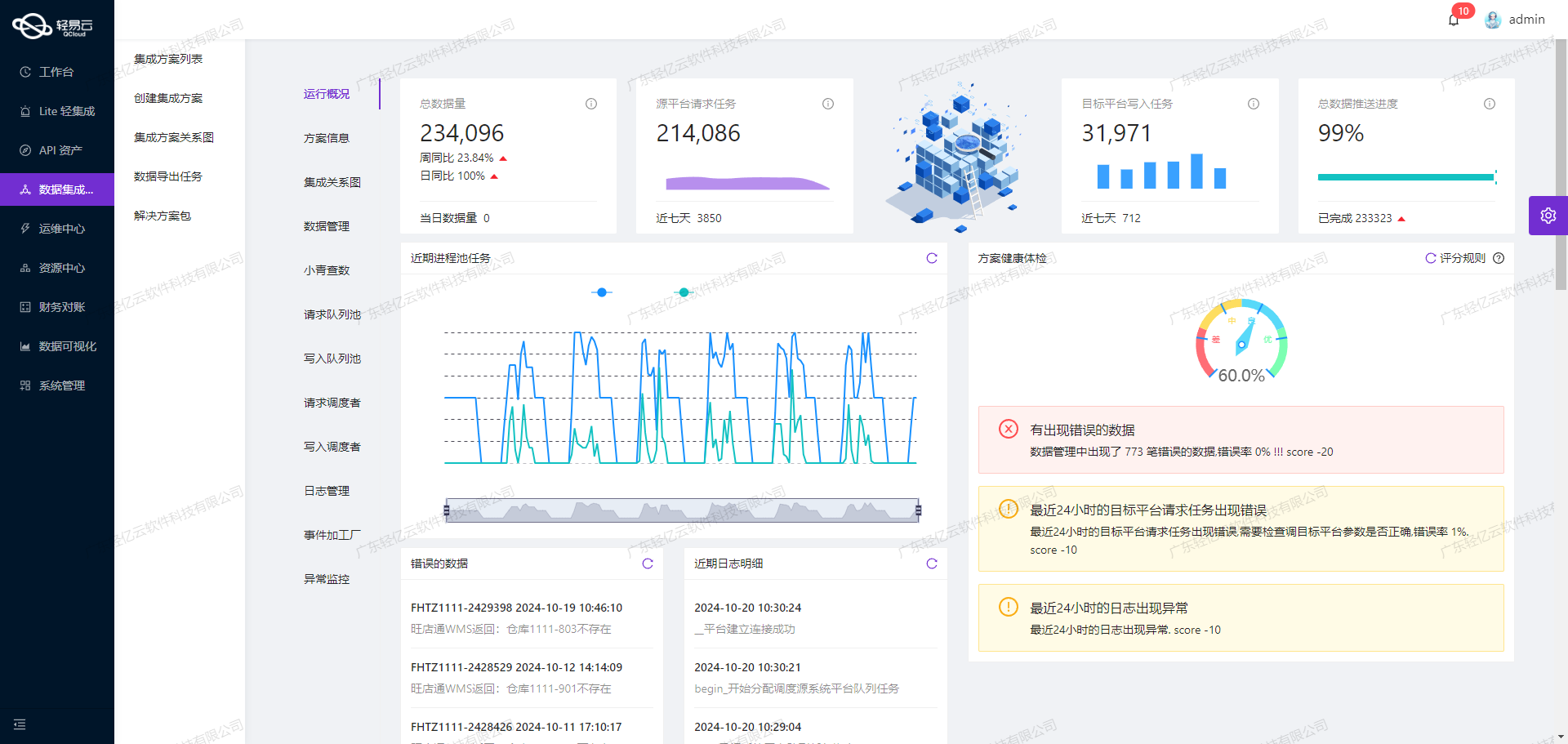

实时监控与告警系统:在整个数据集成过程中,轻易云提供了集中化的监控和告警系统。通过实时跟踪每个任务的状态和性能指标,我们能够迅速发现并处理潜在问题,确保数据流动顺畅无阻。

-

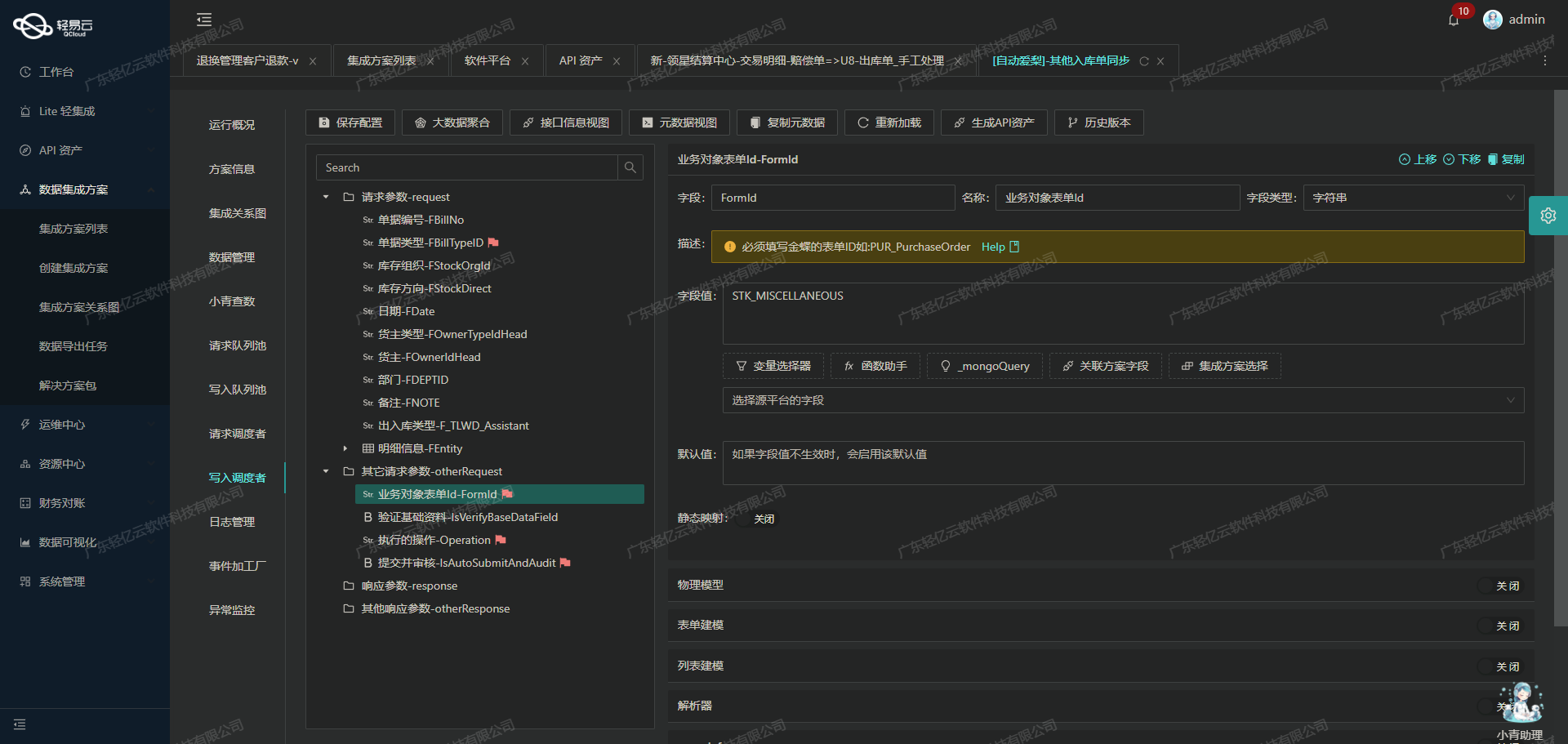

自定义数据转换逻辑:由于马帮与MySQL之间存在一定的数据格式差异,我们利用轻易云的平台特性,自定义了一套适应业务需求的数据转换逻辑。这一过程通过可视化的数据流设计工具完成,使得复杂的数据映射变得直观且易于管理。

-

分页与限流处理:针对马帮API接口可能存在的分页和限流问题,我们设计了一套智能调度机制,确保每次请求都能稳定获取所需数据,并避免因频繁请求导致接口被限流或超时。

-

异常处理与错误重试机制:为保证集成过程中的稳定性,我们引入了完善的异常处理策略。当出现网络波动或API调用失败等情况时,系统会自动触发错误重试机制,从而最大程度上保证数据不漏单、不丢失。

-

定制化的数据映射对接:在实际操作中,不同业务场景下可能需要不同的数据映射规则。我们通过灵活配置,实现了MySQL定制化的数据映射对接,以满足各种复杂业务需求。

以上技术要点构成了我们“马帮补货表=>MYSQL”解决方案的核心部分。在后续章节中,将进一步详细阐述具体实施步骤及相关技术细节。

调用马帮接口fba-balntellect-stock-batch-list获取并加工数据

在轻易云数据集成平台中,调用源系统马帮接口fba-balntellect-stock-batch-list是数据集成生命周期的第一步。这个过程包括从马帮系统请求数据、清洗和初步加工,为后续的数据转换与写入做好准备。

配置元数据

首先,我们需要配置元数据,以便正确调用马帮接口。以下是关键的元数据信息:

- API:

fba-balntellect-stock-batch-list - 方法:

POST - 请求参数:

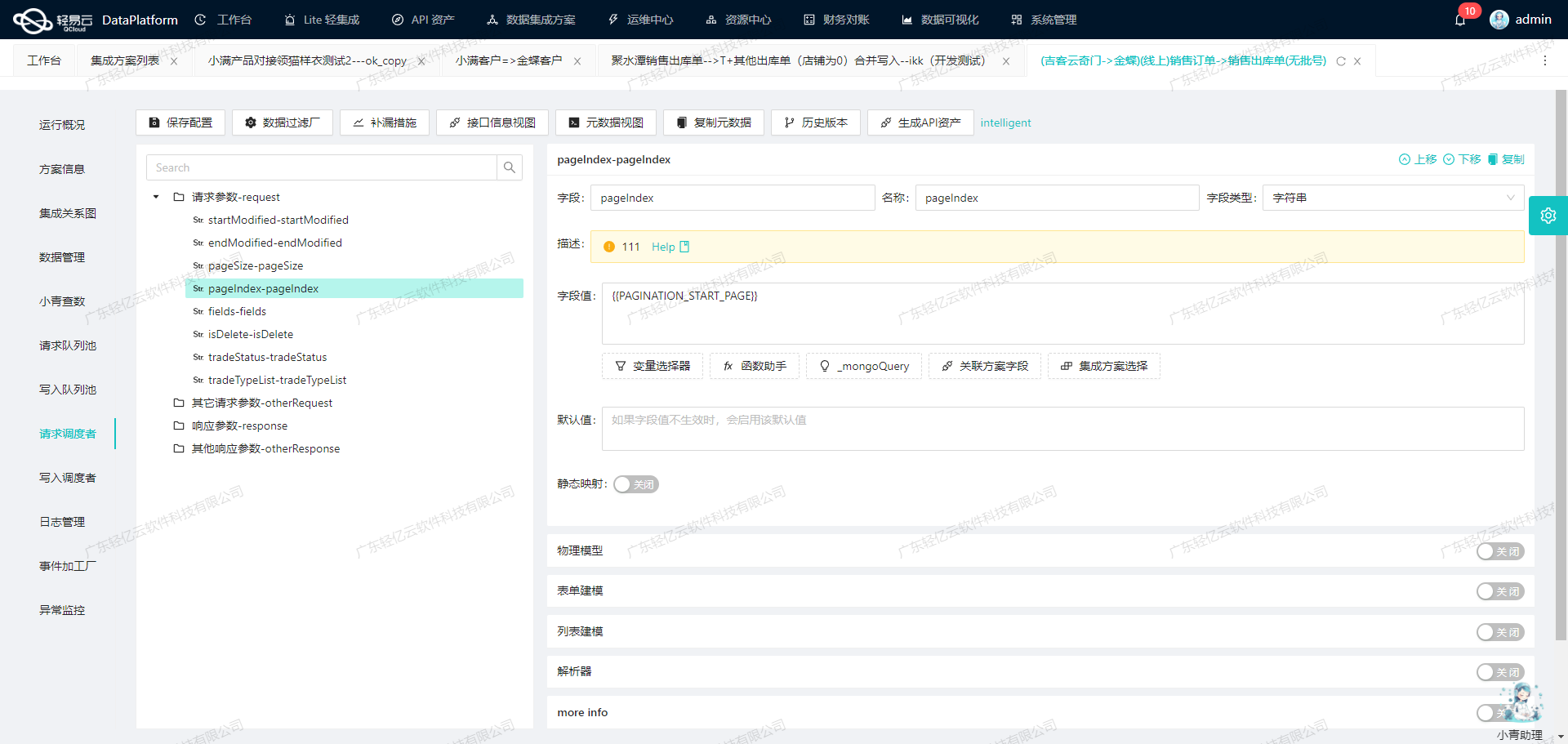

pageSize: 当前每页条数,设置为1000update_time_start: 开始更新时间,通过模板变量{{DAYS_AGO_s10|date}}动态生成update_time_end: 结束更新时间,通过模板变量{{CURRENT_TIME|date}}动态生成

这些参数确保了我们能够高效地分页获取大量数据,并且可以根据时间范围灵活调整查询条件。

数据请求与清洗

-

分页处理:由于单次请求的数据量有限,我们需要通过分页机制来获取所有符合条件的数据。每次请求返回的数据条数由

pageSize参数控制,通常设置为1000条,以平衡性能和响应时间。 -

限流管理:为了避免对马帮系统造成过大压力,需要实现限流机制。例如,可以在每次请求之间加入适当的延迟,或者根据API文档中的限流策略进行调整。

-

数据清洗:从马帮接口返回的数据可能包含冗余或不一致的信息。在将数据写入目标数据库之前,需要进行初步清洗。这包括:

- 去除重复记录

- 格式化日期和时间字段

- 标准化字段名称和类型

-

异常处理与重试机制:在实际操作中,网络波动或服务端问题可能导致请求失败。因此,需要设计健壮的异常处理和重试机制。例如,当遇到网络超时或服务器错误时,可以自动重试一定次数,并记录日志以便后续分析。

实现步骤

-

初始化请求参数:

{ "pageSize": "1000", "update_time_start": "{{DAYS_AGO_s10|date}}", "update_time_end": "{{CURRENT_TIME|date}}" } -

发送HTTP POST请求: 使用配置好的元数据,通过HTTP POST方法向马帮接口发送请求。确保携带必要的认证信息,如API密钥等。

-

解析响应并处理分页逻辑: 根据响应中的分页信息(如总记录数、当前页码等),循环发送后续请求,直到获取所有数据。

-

清洗与格式化数据: 对每批次返回的数据进行清洗,包括去除重复项、格式化日期等操作。可以使用轻易云提供的自定义转换逻辑功能,实现复杂的业务需求。

-

监控与告警: 利用平台提供的集中监控和告警系统,实时跟踪任务状态。如果出现异常情况(如连续多次重试失败),及时发出告警通知相关人员进行处理。

技术要点总结

- 高效分页与限流管理:通过合理设置分页参数和限流策略,确保稳定高效地获取大批量数据。

- 数据清洗与标准化:在将原始数据写入目标数据库之前,对其进行必要的清洗和标准化处理,提高后续处理环节的效率。

- 异常处理与重试机制:设计健壮的异常处理流程,确保即使在网络波动或服务端故障情况下,也能最大程度保证任务完成。

- 实时监控与告警:利用平台提供的监控工具,实时掌握任务执行状态,并及时应对潜在问题。

通过上述步骤,我们能够高效地调用马帮接口获取所需数据,并为后续的数据转换与写入打下坚实基础。这不仅提高了整体集成效率,还增强了系统的稳定性和可靠性。

集成马帮补货表数据至MySQL的ETL转换与写入

在集成平台生命周期的第二步,我们将已经集成的源平台数据进行ETL转换,转为目标平台MySQLAPI接口所能够接收的格式,并最终写入目标平台。以下是详细的技术实现步骤。

数据请求与清洗

首先,通过调用马帮接口(如fba-balntellect-stock-batch-list)获取补货表数据。这一步需要处理分页和限流问题,以确保数据完整性和系统稳定性。通过设置合理的分页参数,可以避免一次性请求过多数据导致接口超时或崩溃。

数据转换

接收到的数据需要根据目标平台MySQL的要求进行格式转换。我们使用元数据配置来指导这一过程。元数据配置定义了从源字段到目标字段的映射关系,以及每个字段的数据类型和格式。例如:

{

"field": "id",

"label": "补货计划ID",

"type": "string",

"value": "{id}"

}这种映射关系确保了每个字段都能准确地转换为MySQL所需的格式。在实际操作中,我们会遍历每一条记录,根据配置进行字段映射和类型转换。

数据写入

转换后的数据通过MySQLAPI接口写入目标数据库。为了实现高效的数据写入,我们使用批量操作。元数据配置中的main_sql定义了SQL语句模板:

REPLACE INTO new_replenishment_plan (id, company_id, fbastock_id, stock_no, num, plan_status, create_time, update_time, content, create_opear, shop_id, warehouseid, approval_remark, approval_opear, approval_time, is_delete, set_over_reason, check_status, next_checkid, has_checkid, lock_state, is_auto, flag, is_lock, purchase_plan_status, amazonsite, platformSku, merchantid, title, asin, status, stockId, stockType,FNSKU,pictureUrl,fbaWarehouseId ,stockSku ,sevenSales ,fourteenSales ,thirtySales ,ninetySales ,stockNameCN ,sevenReturn ,thirtyReturn ,shopIds ,quantity,reservedCustomerorders,reservedFcTransfers,reservedFcProcessing ,unsellablequantity ,afnInboundWorkingQuantity,onWayQuantity ,afnreservedquantity ,icon_type,fba_stock,sevenfundrate ,thirtyfundrate,diff_num ,print_num ,warehouse_name ,shop_name,state) VALUES通过批量执行上述SQL语句,可以显著提升数据写入效率。同时,为了应对大规模数据处理,轻易云平台支持高吞吐量的数据写入能力,确保大量数据能够快速被集成到MySQL中。

数据质量监控与异常处理

在整个ETL过程中,实时监控和异常处理至关重要。轻易云提供集中的监控和告警系统,实时跟踪数据集成任务的状态和性能。一旦发现异常情况,如网络故障或数据格式错误,系统会自动触发告警,并根据预设策略进行错误重试或人工干预。

此外,通过自定义的数据质量监控规则,可以及时发现并处理数据问题。例如,对关键字段进行非空校验、唯一性检查等,确保写入MySQL的数据符合业务需求和质量标准。

定制化数据映射与对接

针对特定业务需求,可以通过自定义数据转换逻辑实现更灵活的数据映射。例如,对于日期格式不一致的问题,可以在转换过程中统一格式;对于复杂的业务逻辑,可以编写自定义函数进行处理。这些定制化操作使得ETL过程更加灵活和适应性强。

实时监控与日志记录

为了全面掌握ETL过程中的每一个环节,轻易云提供了实时监控与日志记录功能。通过可视化的数据流设计工具,可以直观地查看每一步骤的执行情况,并在出现问题时快速定位和解决。此外,详细的日志记录有助于后续审计和问题排查。

综上所述,通过合理配置元数据、批量操作、高效监控以及定制化处理,我们可以高效地将马帮补货表数据集成到MySQL中,实现精准、可靠的数据同步。