HT汤臣退货订单数据集成案例分享

在企业信息化管理中,数据的高效流动和准确对接至关重要。本文将聚焦于一个具体的系统对接集成案例——将汤臣倍健营销云的数据集成到畅捷通T+,并详细探讨HT汤臣退货订单的实现过程。

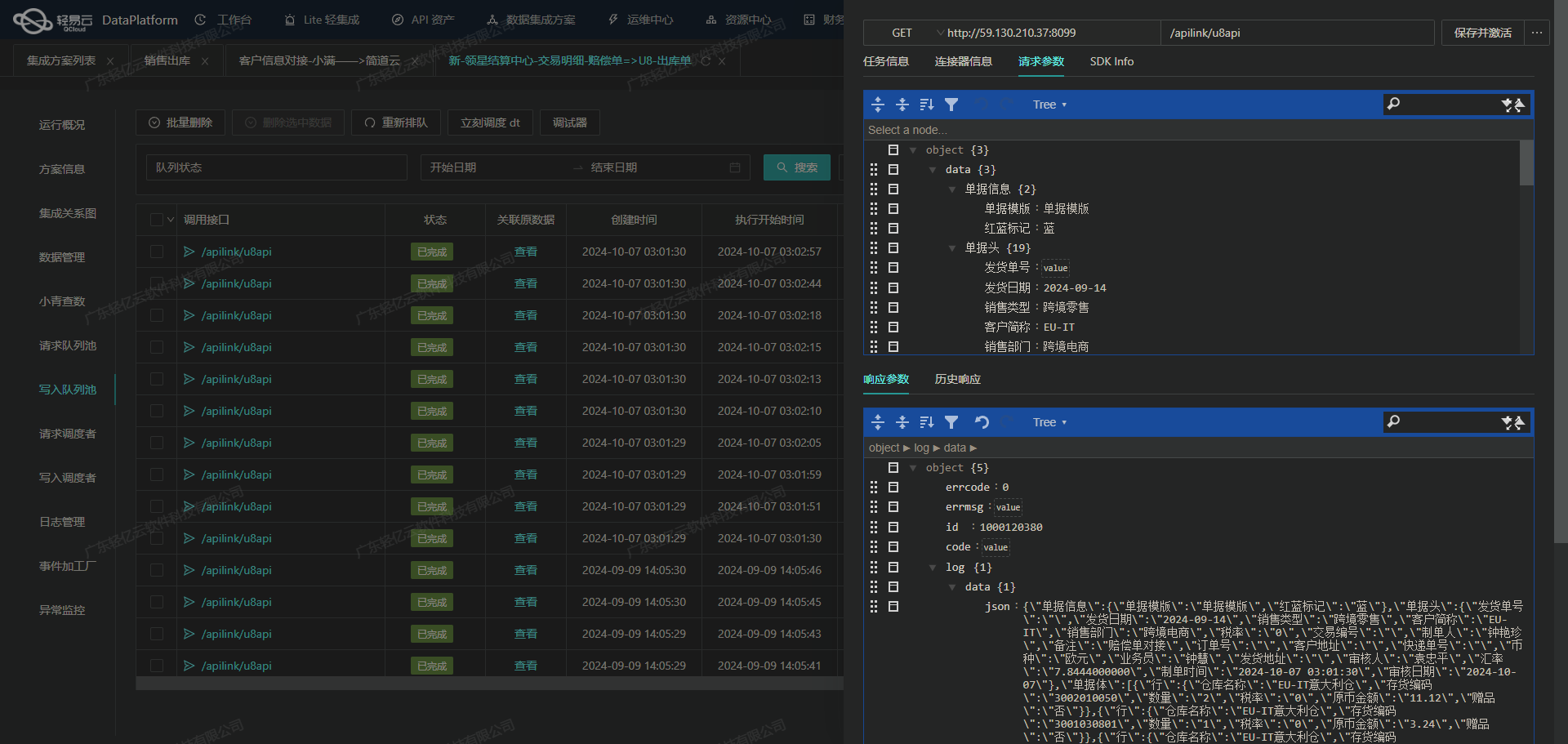

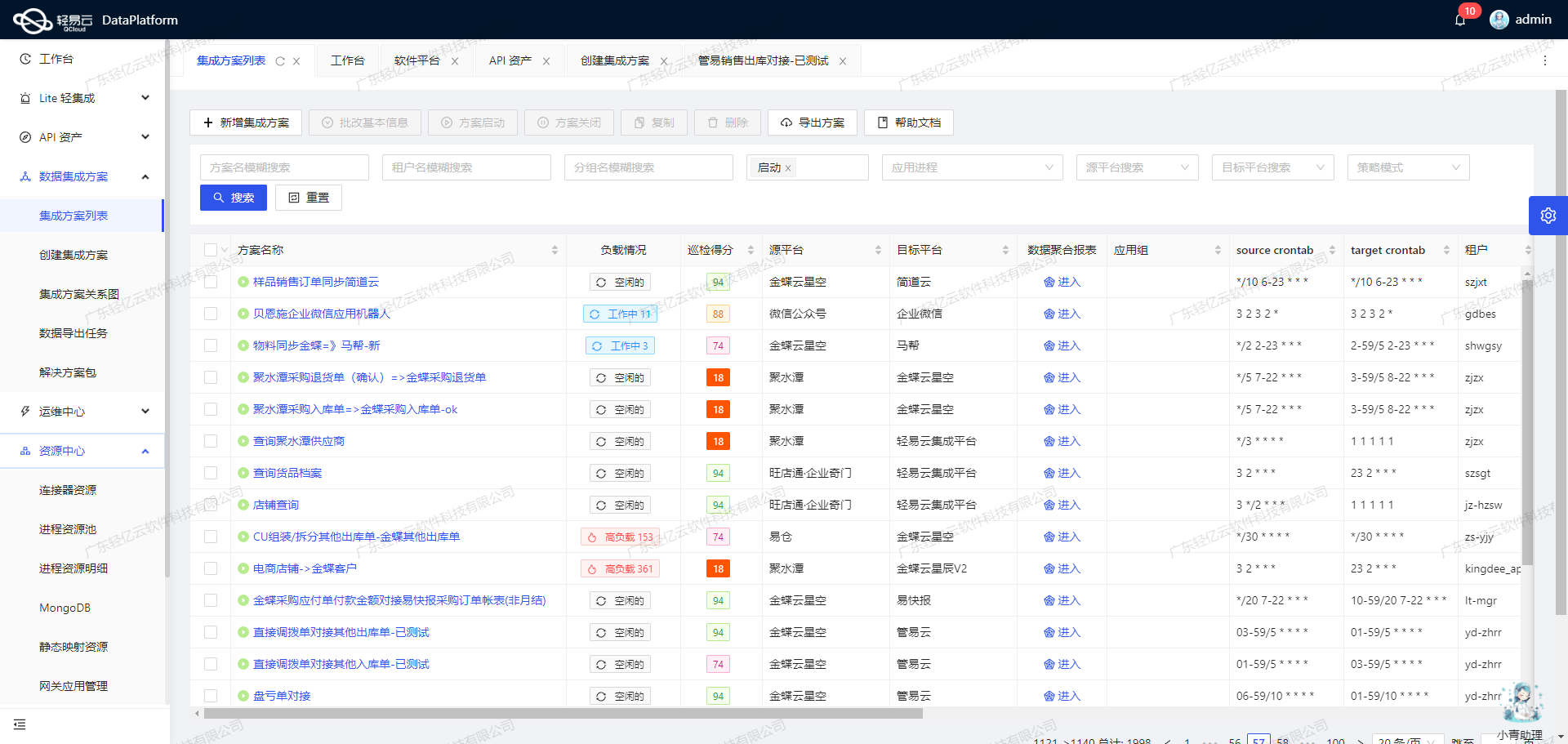

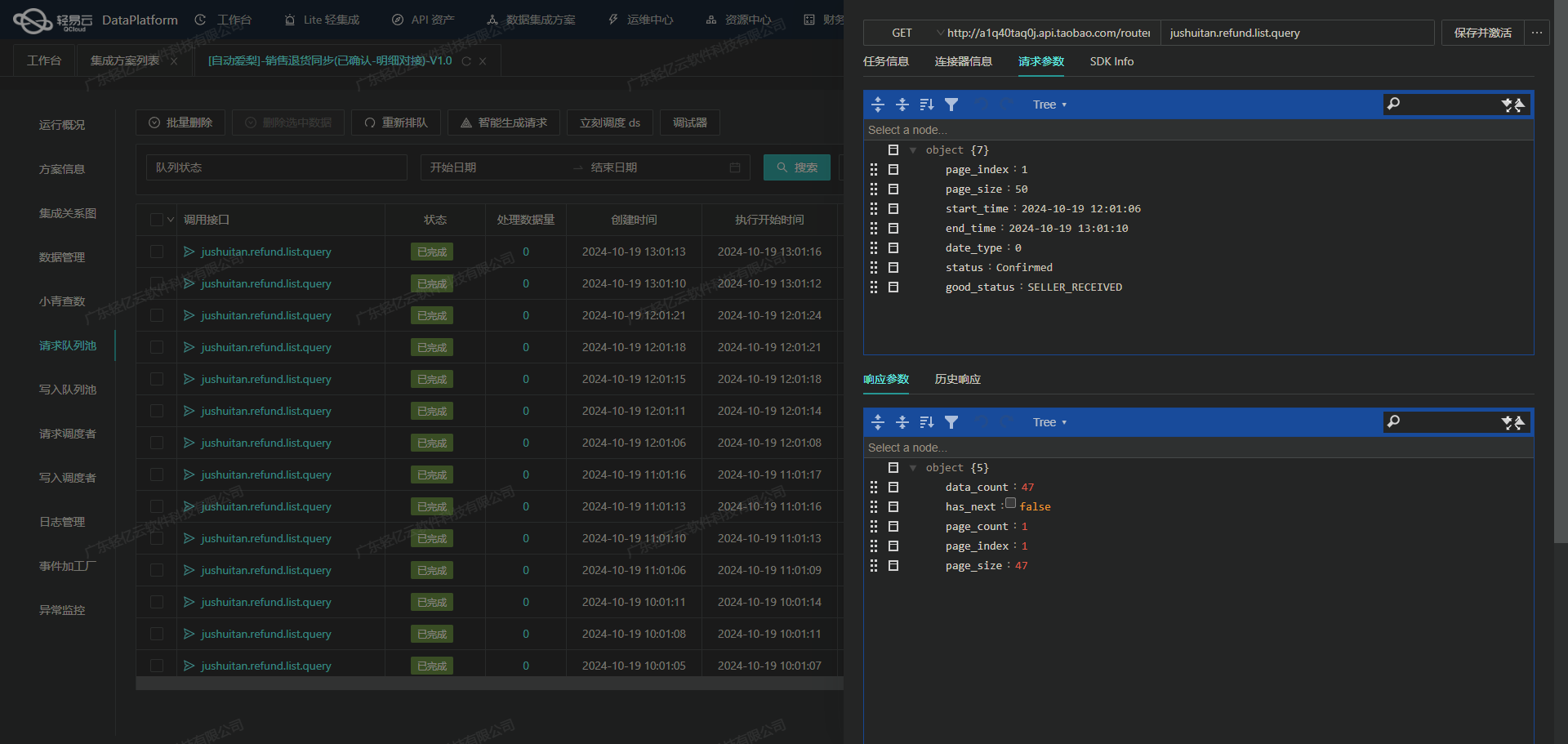

为了确保数据集成的高效性和可靠性,我们利用了轻易云数据集成平台的一系列特性。首先,通过支持高吞吐量的数据写入能力,使得大量退货订单数据能够快速被集成到畅捷通T+系统中,大幅提升了数据处理的时效性。此外,平台提供的集中监控和告警系统,可以实时跟踪每个数据集成任务的状态和性能,确保任何异常情况都能及时发现并处理。

在实际操作中,我们通过调用汤臣倍健营销云接口/erp/api/order/query/saleReturnOrder定时抓取退货订单数据,并利用自定义的数据转换逻辑,将其适配为畅捷通T+所需的数据格式。这一步骤不仅解决了两者之间的数据结构差异问题,还保证了数据质量和完整性。

为了进一步优化资源配置,我们借助API资产管理功能,通过统一视图全面掌握API使用情况,实现资源的高效利用。同时,为应对分页和限流问题,我们设计了一套可靠的抓取机制,确保所有订单数据都能被完整获取,不漏单。

最后,在将处理后的数据批量写入到畅捷通T+时,我们调用了其API接口/tplus/api/v2/saleDispatch/Create。整个过程中,通过可视化的数据流设计工具,使得复杂的数据集成过程变得直观且易于管理,并通过实时监控与日志记录功能,对每一步骤进行细致跟踪,以便及时调整和优化。

本案例展示了如何通过精细化配置与多层次监控,实现跨平台的数据无缝对接,为企业提供了一套高效、可靠的数据集成解决方案。

调用汤臣倍健营销云接口获取并加工数据

在轻易云数据集成平台中,调用汤臣倍健营销云的接口是数据集成生命周期的关键步骤之一。本文将详细探讨如何通过调用/erp/api/order/query/saleReturnOrder接口来获取退货订单数据,并对其进行初步加工处理。

接口调用配置

首先,我们需要配置元数据,以便正确地调用汤臣倍健营销云的API。以下是主要的配置参数:

- API路径:

/erp/api/order/query/saleReturnOrder - 请求方法:POST

- 分页设置:每页100条记录

- 必要字段:

tenantId: 经销商ID(必填)beginTime: 开始时间(必填,如果不传单号)endTime: 结束时间(必填,如果不传单号)

这些参数确保了我们能够准确地从源系统获取所需的数据。

数据请求与清洗

在实际操作中,首先要构建一个有效的请求体。以下是一个示例请求体:

{

"tenantId": "34cc4109705e4c058b7b3b0352e57d31",

"beginTime": "2023-01-01 00:00:00",

"endTime": "2023-01-31 23:59:59",

"pageNo": 1,

"pageSize": 100,

"timeType": 0

}这个请求体包含了基本的查询条件和分页信息。在发送请求后,我们会收到一批退货订单数据。这些数据需要经过初步清洗,以确保其质量和一致性。

数据转换与写入

接下来,我们需要对获取到的数据进行转换,以适应目标系统的数据结构。例如,将日期格式从YYYY-MM-DD HH:mm:ss转换为目标系统所需的格式。同时,还需要处理一些特定字段,如订单状态等。

{

"id": "12345",

"number": "XOUT0000000293",

...

}在转换过程中,可以利用轻易云平台提供的自定义数据转换逻辑功能,编写脚本或规则来实现复杂的数据映射和转换需求。

分页与限流处理

由于接口返回的数据量可能较大,需要进行分页处理。通过设置pageNo和pageSize参数,可以逐页获取全部数据。此外,为了避免触发源系统的限流机制,需要合理设置请求频率,并在必要时实现重试机制。

{

"pageNo": nextPage,

...

}每次成功获取一页数据后,更新pageNo参数以继续抓取下一页,直到所有页面都被处理完毕。

异常处理与监控

为了确保整个过程的稳定性和可靠性,需要实现异常处理机制。当出现网络故障或接口返回错误时,应及时记录日志并触发告警。同时,通过轻易云平台提供的集中监控和告警系统,可以实时跟踪任务状态,快速响应问题。

例如,当遇到网络超时时,可以自动重试三次:

{

// 重试逻辑示例

}通过上述步骤,我们可以高效地从汤臣倍健营销云获取退货订单数据,并对其进行初步加工,为后续的数据写入和进一步处理打下坚实基础。这种方法不仅提高了数据集成效率,还保证了数据的一致性和完整性。

集成HT汤臣退货订单到畅捷通T+的ETL转换与写入

在数据集成生命周期的第二步,我们需要将已经从源平台(如汤臣倍健营销云)获取的原始数据进行ETL(提取、转换、加载)处理,以便将其转化为畅捷通T+ API接口能够接收的格式,并最终写入目标平台。以下将详细探讨如何利用元数据配置完成这一过程。

数据提取与清洗

在ETL过程的第一步,我们需要从汤臣倍健营销云接口(例如/erp/api/order/query/saleReturnOrder)中定时抓取退货订单数据。为了确保数据不漏单,可以通过分页和限流机制来处理大量数据请求,保证每次抓取的数据完整且不超出接口限制。

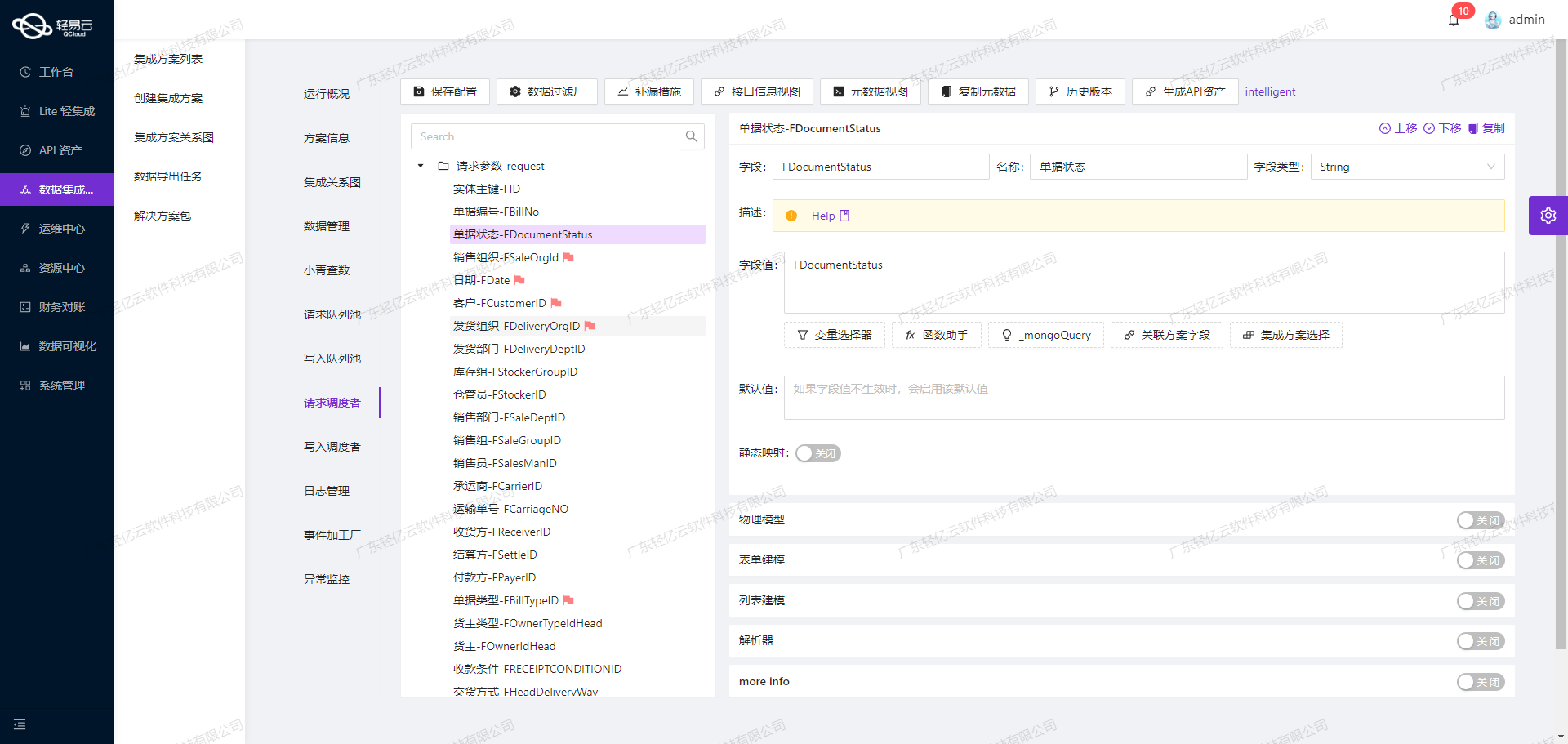

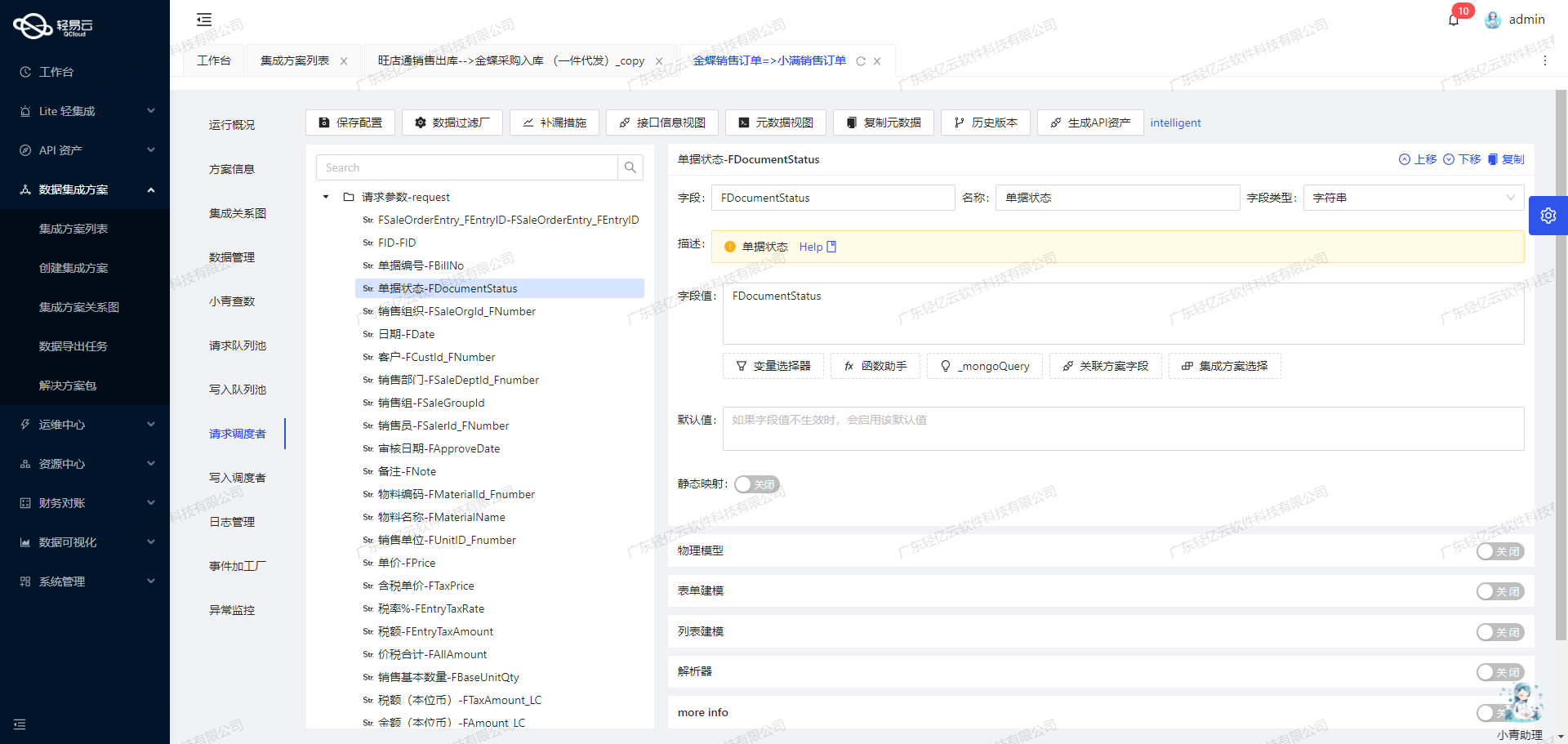

数据转换

一旦提取到原始数据,接下来需要根据畅捷通T+ API接口的要求进行数据转换。以下是关键字段及其解析方式:

- ExternalCode:外部系统数据编号,用于防止重复提交。

- Code:单据编码。

- Customer和Partner:客户信息,使用

ConvertObjectParser解析器,将客户信息转化为畅捷通T+所需格式。 - VoucherDate:单据日期。

- BusiType:业务类型,固定值为

15。 - Warehouse:仓库信息,同样使用

ConvertObjectParser解析器。 - DispatchAddress、TransDocNo、DeliveryCode、Memo:其他基本信息字段。

- RDRecordDetails:物料明细,包括存货、数量、批号、含税售价、明细备注、成本单价和成本金额等字段。

在具体实施过程中,我们需要确保每个字段都能正确映射。例如,对于客户信息,需要通过解析器将源平台中的客户代码转化为目标平台所需的格式:

{

"field": "Customer",

"label": "客户",

"type": "string",

"parser": {

"name": "ConvertObjectParser",

"params": "Code"

}

}类似地,对于物料明细,需要遍历每个物料条目并进行相应的字段映射和解析:

{

"field": "RDRecordDetails",

"label": "物料明细",

"type": "array",

"children": [

{

"field": "Inventory",

"label": "存货",

"type": "string",

"parser": {

"name": "ConvertObjectParser",

"params": "Code"

},

...

}

...

]

}数据写入

完成数据转换后,通过POST请求将转换后的数据发送到畅捷通T+ API接口(如/tplus/api/v2/saleDispatch/Create)。在这一阶段,确保高吞吐量的数据写入能力至关重要,以便能够快速处理大量订单数据。

此外,集中的监控和告警系统可以实时跟踪数据集成任务的状态和性能,及时发现并处理异常情况。对于可能出现的错误,可以实现错误重试机制,以提高系统的可靠性。

数据质量监控与异常处理

为了确保集成过程的准确性和可靠性,需要对数据质量进行监控,并设置异常检测机制。一旦发现问题,例如数据格式不匹配或字段缺失,可以通过日志记录和实时告警快速定位并解决问题。

综上所述,通过合理配置元数据,并利用轻易云平台提供的可视化工具和自定义转换逻辑,我们可以高效地完成从汤臣倍健营销云到畅捷通T+的数据集成任务,实现两者之间的数据无缝对接。