聚水潭·奇门数据集成到MySQL:案例分享

在现代企业的数据管理中,如何高效、可靠地实现不同系统之间的数据对接是一个关键问题。本文将聚焦于一个具体的技术案例,展示如何通过轻易云数据集成平台,将聚水潭·奇门的售后单数据无缝集成到MySQL数据库中。本次方案名称为“聚水潭-售后单-->BI崛起-售后表_原始查询_copy”。

背景与挑战

在本案例中,我们需要从聚水潭·奇门系统中获取售后单数据,并将其批量写入到MySQL数据库。这一过程中,我们面临以下几个主要挑战:

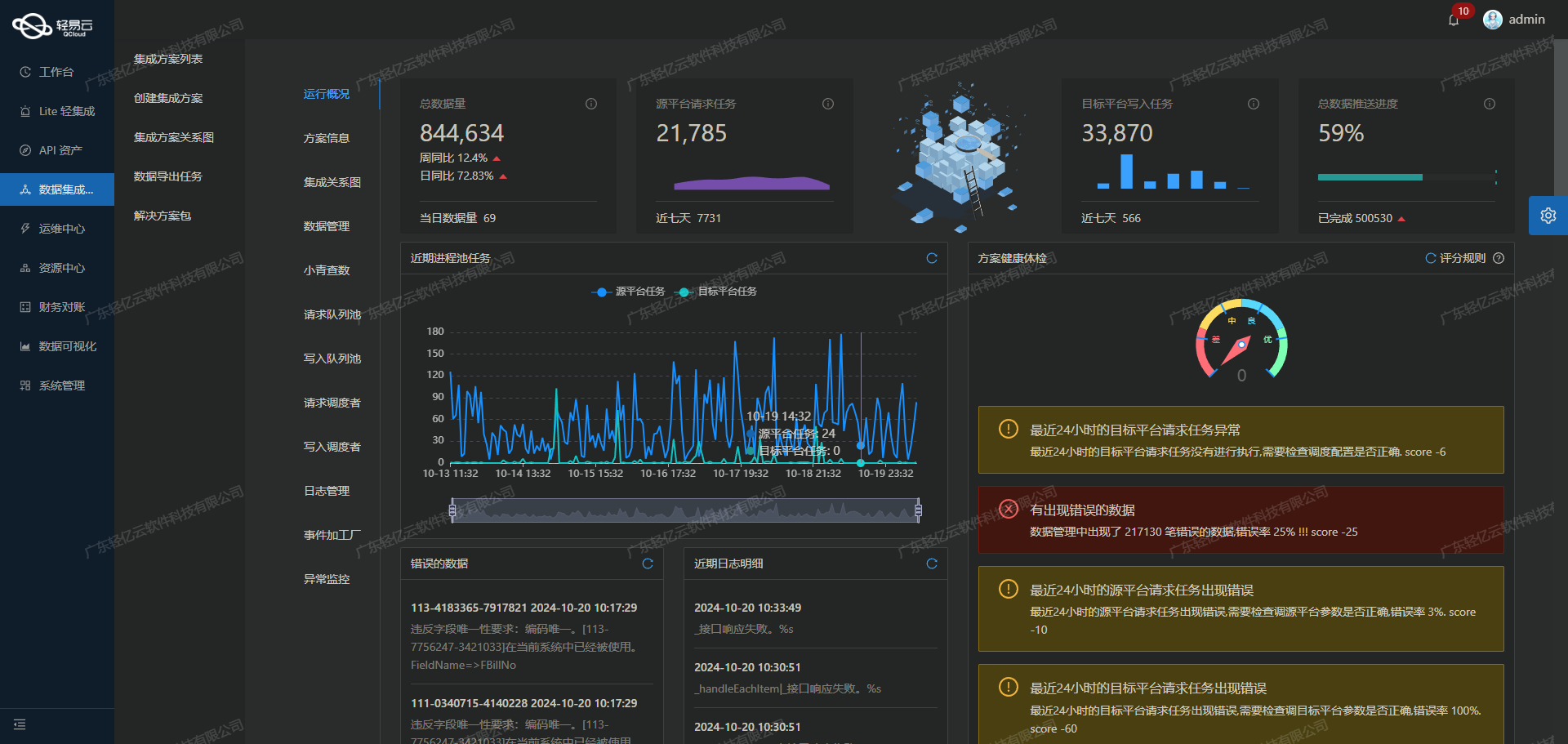

- 高吞吐量的数据写入能力:确保大量数据能够快速被集成到目标数据库,以提升数据处理的时效性。

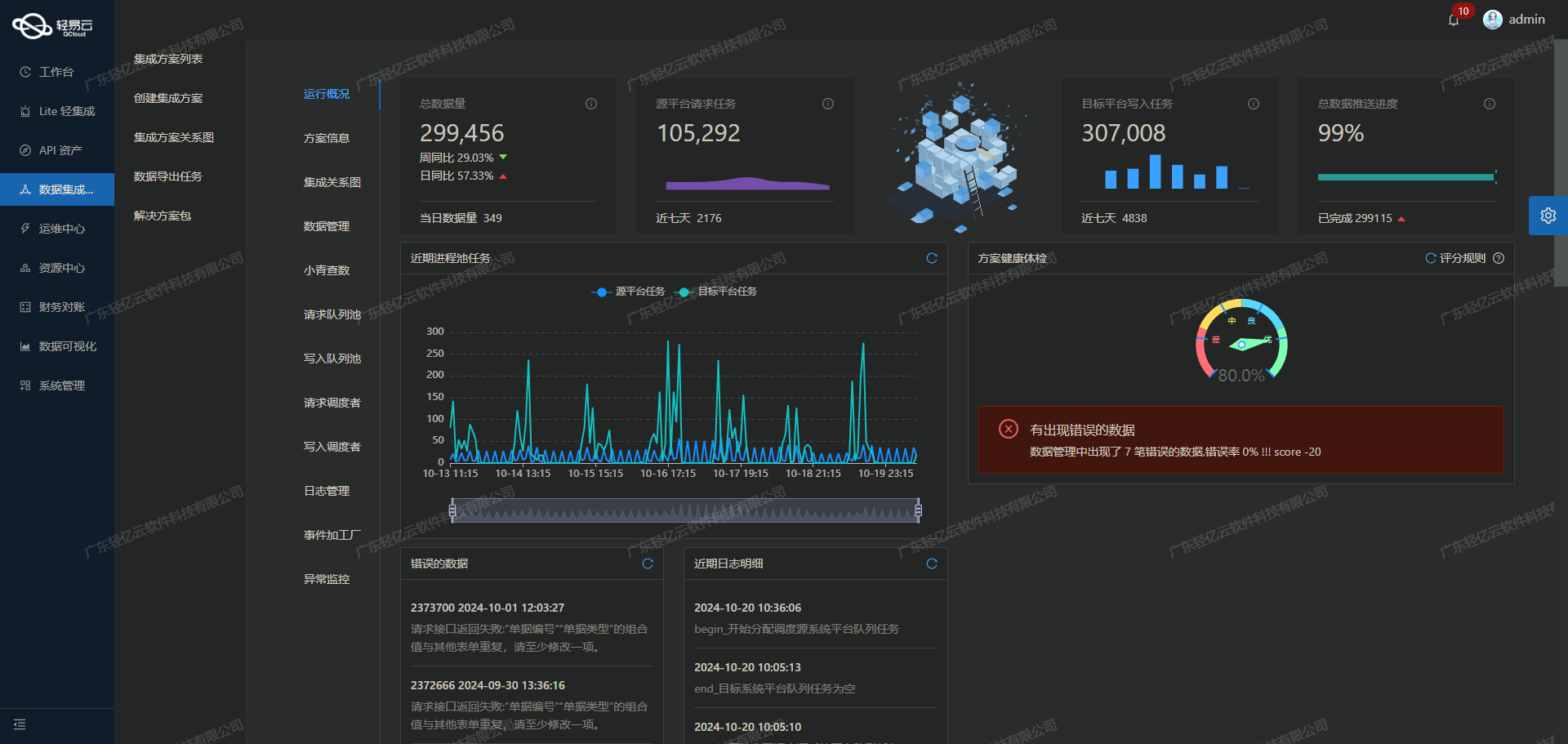

- 实时监控与告警:提供集中化的监控和告警系统,实时跟踪数据集成任务的状态和性能。

- API接口调用:如何有效调用聚水潭·奇门提供的

jushuitan.refund.list.query接口,并处理分页和限流问题。 - 数据质量监控与异常检测:及时发现并处理可能出现的数据问题,确保数据准确性。

- 自定义数据转换逻辑:适应特定业务需求和数据结构,实现定制化的数据映射。

解决方案概述

为了应对上述挑战,我们采用了以下技术手段:

-

高效API调用与分页处理:

- 利用轻易云平台强大的API资产管理功能,通过统一视图和控制台全面掌握API使用情况,有效调用

jushuitan.refund.list.query接口,并处理分页和限流问题。

- 利用轻易云平台强大的API资产管理功能,通过统一视图和控制台全面掌握API使用情况,有效调用

-

批量写入与性能优化:

- 通过支持高吞吐量的数据写入能力,使得大量售后单数据能够快速且稳定地被写入MySQL数据库。

-

实时监控与日志记录:

- 集中的监控和告警系统,实时跟踪每个集成任务的状态,并记录详细日志以便于故障排查。

-

自定义转换逻辑与格式差异处理:

- 支持自定义的数据转换逻辑,以适应聚水潭·奇门与MySQL之间的数据格式差异,实现精准对接。

-

异常处理与错误重试机制:

- 实现完善的异常处理机制,当出现错误时自动重试,确保任务最终成功完成。

通过这些技术手段,本方案不仅实现了高效、可靠的数据对接,还大幅提升了业务透明度和效率。在接下来的章节中,我们将详细探讨每一步骤的具体实现方法及其技术细节。

调用聚水潭·奇门接口jushuitan.refund.list.query获取并加工数据

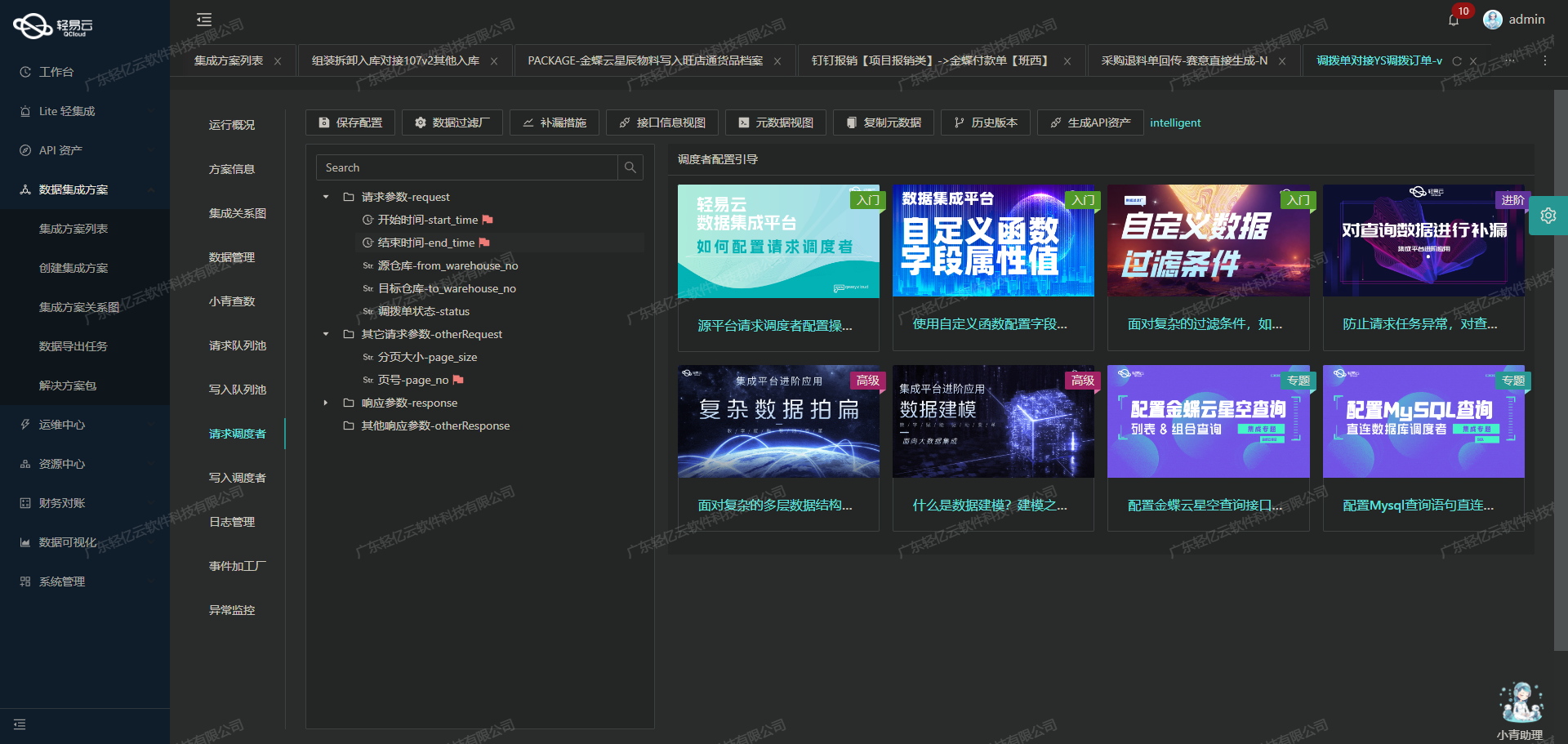

在数据集成的生命周期中,调用源系统接口是至关重要的一步。本文将详细探讨如何通过轻易云数据集成平台调用聚水潭·奇门接口jushuitan.refund.list.query,并对获取的数据进行初步加工处理。

接口配置与请求参数

首先,我们需要配置元数据以便正确调用该接口。根据提供的元数据配置,我们可以看到该接口采用POST方法,并且主要参数包括页码、页数、时间范围、售后单状态等。这些参数能够帮助我们精确地筛选和分页获取售后单数据。

{

"api": "jushuitan.refund.list.query",

"method": "POST",

"request": [

{"field": "page_index", "type": "int", "value": "1"},

{"field": "page_size", "type": "int", "value": "50"},

{"field": "start_time", "type": "datetime", "value":"{{LAST_SYNC_TIME|datetime}}"},

{"field": "end_time", "type":"datetime","value":"{{CURRENT_TIME|datetime}}"}

]

}数据请求与清洗

在实际操作中,我们需要定时可靠地抓取聚水潭·奇门接口的数据。为此,可以利用轻易云平台的调度功能,通过设置定时任务来自动化这一过程。例如,每天凌晨1点2分执行一次:

{

"crontab":"2 1 * * *"

}为了确保不漏单,我们还可以设置接管字段,如start_time,以便在上次同步失败或异常情况下,从前一天开始重新抓取数据。

分页处理与限流问题

由于售后单数量可能较大,需要分页处理。每次请求返回的数据量由page_size决定,这里设为50条。通过递增page_index值,可以逐页获取所有数据。同时,为了避免触发API限流机制,应合理设置请求频率和间隔。

{

// 初始请求参数

{"page_index":1, ...},

// 后续分页请求

{"page_index":2, ...},

...

}数据转换与写入准备

从聚水潭·奇门接口获取到原始售后单数据后,需要进行初步清洗和转换,以适应目标系统(如MySQL)的数据结构。在这个过程中,可以利用轻易云平台提供的自定义数据转换逻辑功能,对字段进行映射和格式调整。例如,将日期时间格式统一转换为目标数据库支持的格式。

此外,还需注意处理不同系统之间的数据格式差异。例如,聚水潭·奇门中的某些字段类型可能需要在写入MySQL之前进行类型转换或单位换算。

异常处理与重试机制

在整个过程中,异常处理是不可忽视的一环。当出现网络故障或API响应错误时,应及时记录日志并触发告警,同时实现错误重试机制,以保证任务的可靠性和连续性。

{

// 异常捕获与重试策略

{

try {

// API 请求代码

} catch (Exception e) {

log.error("API 请求失败: ", e);

retry();

}

}

}通过上述步骤,我们可以高效地调用聚水潭·奇门接口获取售后单数据,并对其进行初步加工,为下一阶段的数据转换与写入做好准备。这一过程不仅提高了业务透明度,也保障了数据集成的准确性和完整性。

数据转换与写入:从聚水潭到MySQL

在数据集成的生命周期中,第二步至关重要,即将已经集成的源平台数据进行ETL转换,并转为目标平台 MySQL API 接口所能够接收的格式,最终写入目标平台。本文将详细探讨如何通过轻易云数据集成平台实现这一过程。

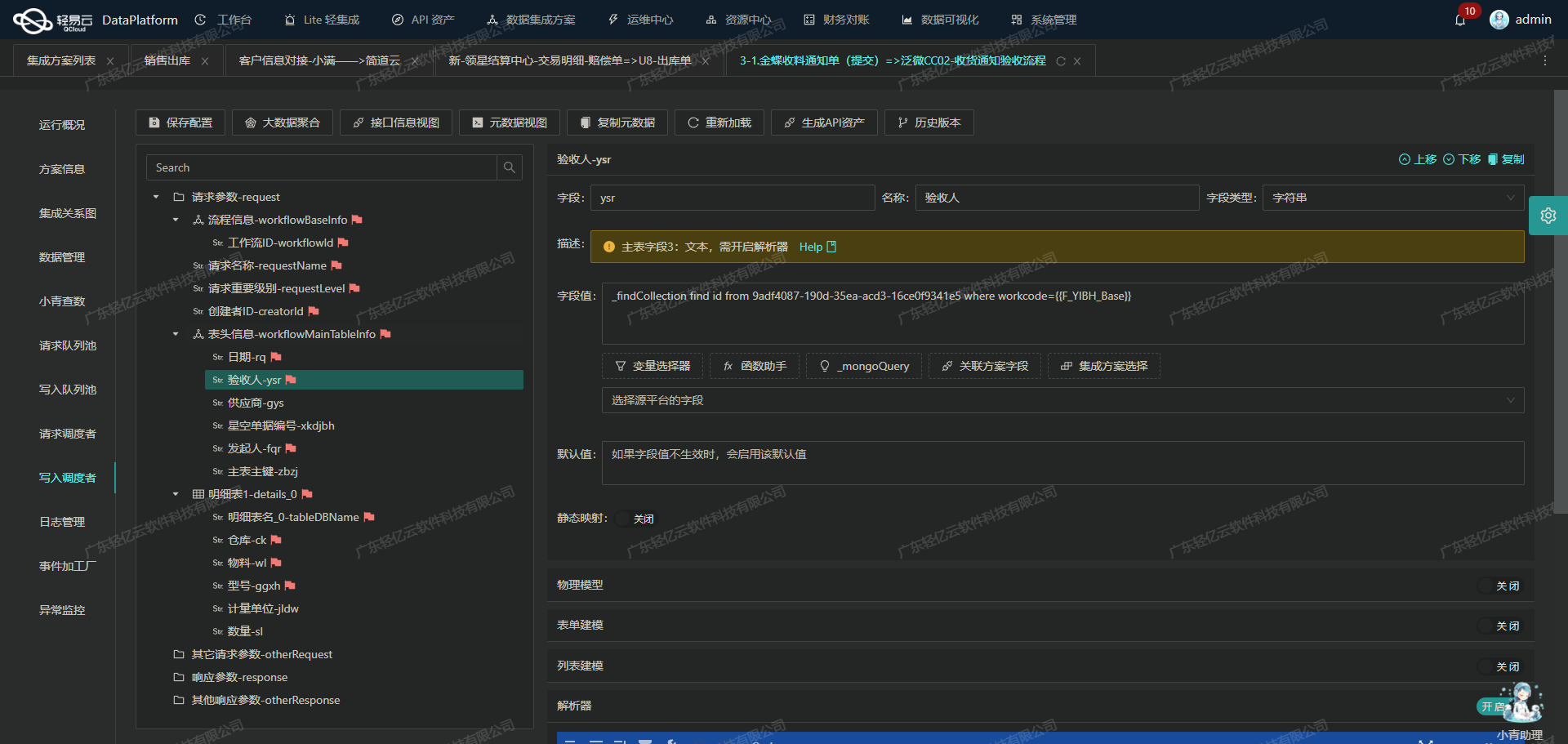

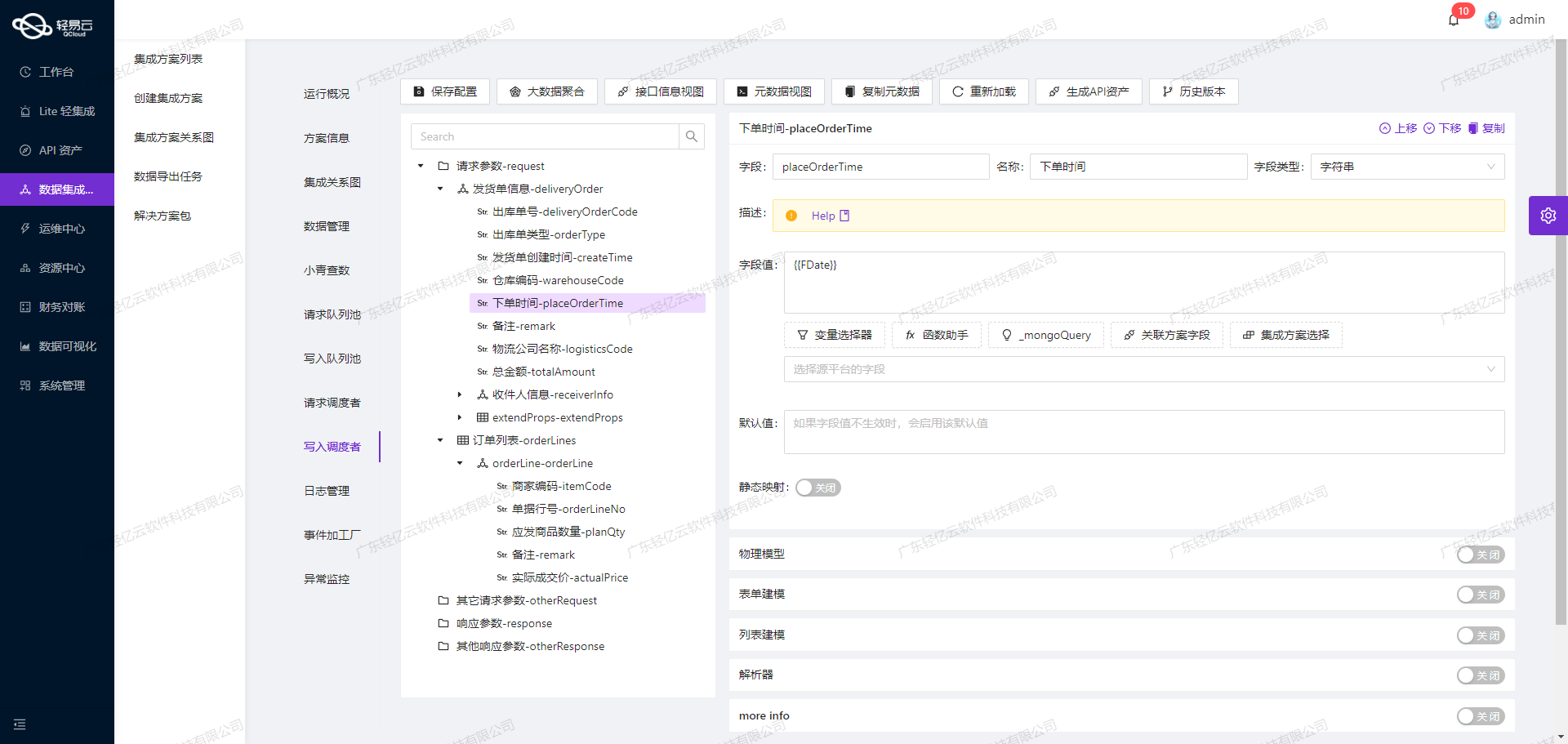

元数据配置解析

元数据配置是ETL过程中的核心部分,它定义了从源平台到目标平台的数据映射规则。以下是元数据配置的一些关键字段:

api: 表示API接口类型,这里为batchexecute。effect: 执行效果,这里为EXECUTE。method: 数据处理方法,这里为SQL。number,id,name: 主键字段,用于唯一标识记录。request: 包含多个字段的映射规则,每个字段包含其名称、标签、类型及其值映射关系。

例如,售后单号字段配置如下:

{

"field": "as_id",

"label": "售后单号",

"type": "string",

"value": "{as_id}"

}这表示将源数据中的as_id字段映射到目标数据库中的as_id字段。

数据清洗与转换

在ETL过程中,数据清洗和转换是必不可少的步骤。我们需要确保源数据符合目标平台的要求,包括数据格式、类型和完整性。

-

数据格式转换:不同系统可能使用不同的数据格式。例如,日期格式可能需要从

YYYY-MM-DD HH:MM:SS转换为YYYYMMDDHHMMSS。可以通过自定义转换逻辑来实现这一点。 -

类型匹配:确保源数据类型与目标数据库字段类型一致。例如,将字符串类型的金额转换为数值型。

-

数据完整性:检查并处理空值或缺失值,以避免写入过程中出现错误。例如,对于必填字段,如果源数据为空,可以设置默认值或丢弃该记录。

SQL语句生成与执行

根据元数据配置,我们需要生成相应的SQL语句,以便将清洗后的数据插入到MySQL数据库中。以下是一个示例SQL语句:

REPLACE INTO refund_list_query(id, as_id, as_date, outer_as_id, so_id, type, modified, status, remark, question_type, warehouse, refund, payment, good_status, shop_buyer_id, shop_id, logistics_company, l_id, o_id, order_status, drp_co_id_to, wh_id, drp_co_id_from, node, wms_co_id, shop_status, freight, labels, refund_version,sns_sku_id,sns_sn ,order_type ,confirm_date ,items_outer_oi_id ,items_receive_date ,items_i_id ,items_combine_sku_id ,items_asi_id ,items_sku_id ,items_qty ,items_price ,items_amount ,items_name ,items_type ,items_properties_value ,items_r_qty ,items_sku_type ,items_shop_sku_id ,items_defective_qty ,items_shop_amount ,items_remark ,created ,ts ,shop_name ,order_label ,free_amount ,creator_name,buyer_receive_refund,buyer_apply_refund) VALUES (?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?,?,?,?,?,?,?,?,?,?,?,?,?,?,?,?,?,?,?,?,?,?,?,?,?,?,?,?,?,?)上述语句中使用了占位符,以便在执行时动态填充具体的值。这种方式提高了效率和安全性,避免了SQL注入风险。

高效批量写入

为了提升性能,可以采用批量写入的方式。通过一次性插入多条记录,减少数据库连接开销和网络延迟。例如,可以设置每次批量插入1000条记录:

{

"field": "limit",

"label": "limit",

"type": "string",

"value": "1000"

}这种方式不仅提高了吞吐量,还能有效应对大规模数据处理需求。

实时监控与异常处理

在ETL过程中,实时监控和异常处理至关重要。可以通过轻易云平台提供的集中监控和告警系统,实时跟踪任务状态和性能。一旦发现异常,如网络故障或数据库连接失败,可以及时触发告警,并自动重试或采取其他补救措施。

例如,在处理分页和限流问题时,可以设置重试机制,确保所有分页的数据都能成功写入目标数据库。同时,通过日志记录功能,可以详细记录每次操作的状态,为后续排查问题提供依据。

总结

通过以上步骤,我们可以高效地将聚水潭售后单的数据进行ETL转换,并写入到MySQL数据库中。在这一过程中,元数据配置、数据清洗与转换、SQL语句生成与执行、高效批量写入以及实时监控与异常处理等环节缺一不可。充分利用轻易云平台提供的工具和特性,可以极大提升数据集成的效率和可靠性。