用友BIP数据集成到轻易云平台的技术案例分享:查询YS客户-01-ok

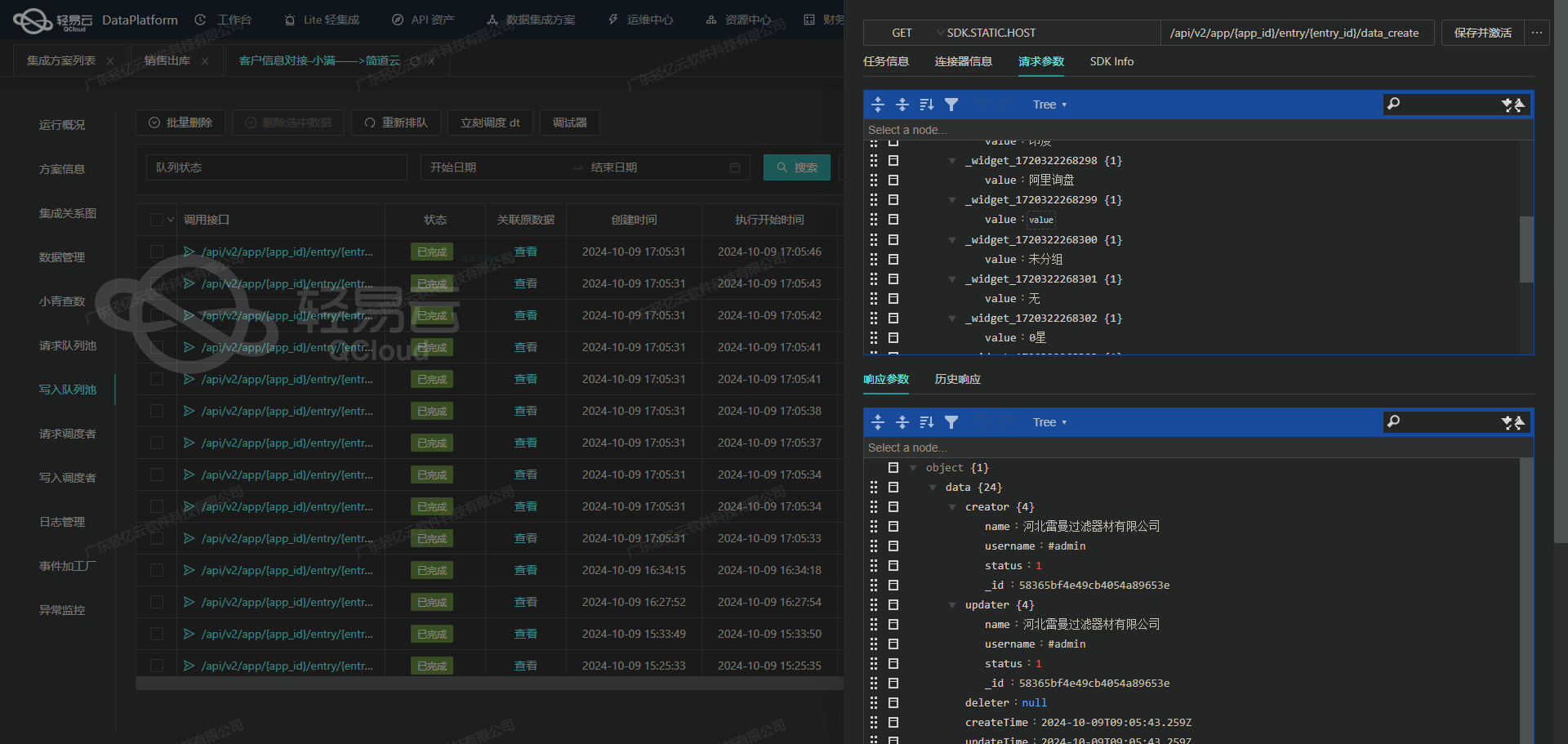

在本案例中,我们将深入探讨如何将用友BIP的数据高效无缝地集成到轻易云数据集成平台中。本次操作的实例方案名称为“查询YS客户-01-ok”,此方案旨在利用轻易云的高吞吐量数据写入能力,实现大规模、快速的数据处理,并确保每一个环节都可监控和追踪。

具体操作过程中,我们通过调用用友BIP提供的API /yonbip/digitalModel/merchant/newlist 获取所需业务数据,然后将这部分数据写入到轻易云指定接口。为了应对大量数据传输时可能出现的分页与限流问题,系统采用了批量处理和定时抓取策略,同时加入自定义的数据转换逻辑,以适配不同系统之间的数据结构差异。

此外,为保障整个流程顺畅进行并且不漏单,通过集中监控和告警系统实时跟踪任务状态,在异常情况下及时重试与修正。这些步骤不仅确保了高效的数据流动,还提升了整体系统运行稳定性。而对于日常操作中的日志记录及异常检测功能,也通过优化设计,使得每一次操作都有迹可循,极大减少了不可预见的问题发生。

接下来,将详细说明如何配置元数据、具体实施方法以及各个阶段需要注意的问题。

用友BIP接口数据集成与处理技术案例

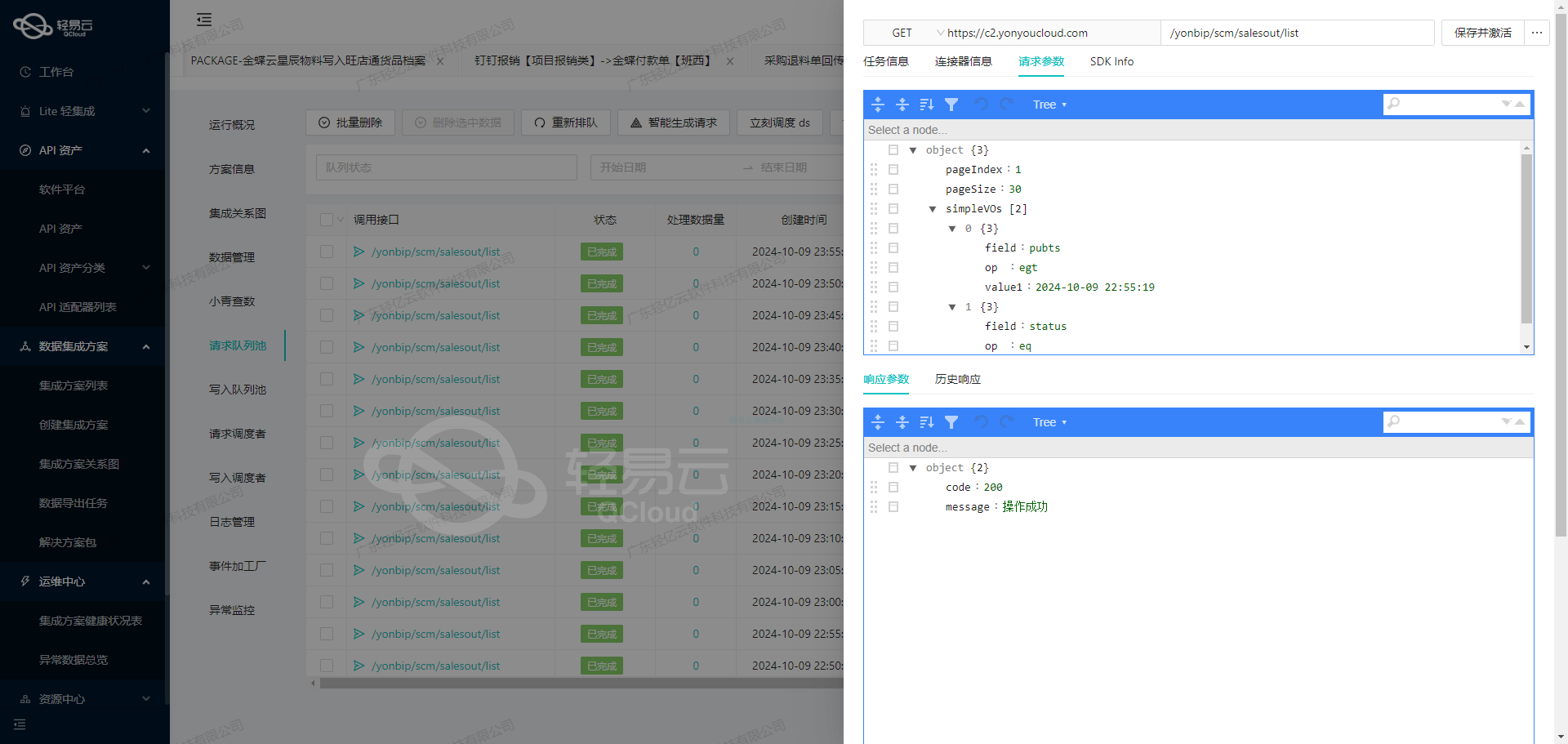

在轻易云数据集成平台中,调用用友BIP接口/yonbip/digitalModel/merchant/newlist获取并加工数据是生命周期的第一步。本文将深入探讨该接口的技术细节和数据集成过程中的关键步骤。

接口调用与请求配置

首先,我们需要配置请求参数,以便正确调用用友BIP的API接口。以下是元数据配置中的请求参数:

{

"field": "pageIndex",

"label": "页码",

"type": "string",

"describe": "例:1 默认值:1",

"value": "1"

},

{

"field": "pageSize",

"label": "每页数",

"type": "string",

"describe": "例:10 默认值:10",

"value": "200"

},

{

"field": "beganTime",

"label": "开始时间(时间戳对比使用)",

"type": "string",

"describe": "例:false 默认值:false",

"value": "2023-01-01 00:00:00"

},

{

"field": "endTime",

"label": "结束时间(时间戳对比使用)",

"type": "string",

"value": "{{CURRENT_TIME|datetime}}"

}这些参数定义了分页信息和时间范围,确保我们能够获取到所需的数据。特别是endTime字段使用了动态变量{{CURRENT_TIME|datetime}},可以自动填充当前时间,确保数据的实时性。

数据请求与清洗

在发送POST请求后,我们会收到一个包含多个字段的响应数据。为了便于后续处理,需要对响应数据进行清洗和格式化。元数据配置中的formatResponse字段定义了如何转换响应数据:

[

{

"old":"id",

"new":"new_id",

"format":"string"

}

]这意味着我们将响应中的id字段重命名为new_id,并将其格式化为字符串。这一步骤确保了数据的一致性和可读性。

数据转换与写入

在完成数据清洗后,下一步是将其转换为目标系统所需的格式,并写入数据库或其他存储系统。这一过程通常涉及以下几个步骤:

- 字段映射:根据目标系统的要求,将源系统的数据字段映射到目标字段。例如,将

new_id映射到目标系统中的相应字段。 - 数据验证:确保所有必需字段都已填充,并且数据符合目标系统的格式要求。

- 批量处理:为了提高效率,可以将多条记录打包成批量进行处理。

自动填充响应

元数据配置中的autoFillResponse: true表示系统会自动填充响应,这极大简化了开发工作量。开发者无需手动处理每个字段的映射和转换,只需关注业务逻辑即可。

通过上述步骤,我们实现了从用友BIP接口获取、清洗、转换并写入数据的全过程。这不仅提高了数据集成的效率,还确保了数据的一致性和准确性。在实际应用中,这一过程可以根据具体需求进行定制和优化,以满足不同业务场景的要求。

使用轻易云数据集成平台进行ETL转换并写入目标平台

在轻易云数据集成平台中,将已经集成的源平台数据进行ETL转换,并最终写入目标平台是一个关键步骤。本文将详细探讨如何利用API接口配置和元数据配置完成这一过程。

数据请求与清洗

在数据集成生命周期的第一步,我们已经成功地从源平台获取了原始数据,并对其进行了初步的清洗和整理。接下来,我们需要将这些清洗后的数据进行ETL转换,使其符合目标平台的要求。

数据转换与写入

在这个阶段,我们需要将清洗后的数据进行格式转换,并通过API接口将其写入到目标平台。以下是具体的步骤和技术细节:

-

定义API接口配置

根据提供的元数据配置,我们需要定义一个API接口配置,用于将处理后的数据写入目标平台。以下是该配置的详细信息:

{ "api": "写入空操作", "effect": "EXECUTE", "method": "POST", "idCheck": true }api: 指定了要调用的API名称,这里为“写入空操作”。effect: 定义了API调用的效果,这里为“EXECUTE”,表示执行操作。method: 指定了HTTP请求方法,这里为“POST”。idCheck: 表示是否需要进行ID检查,这里设置为true。

-

构建请求体

在定义好API接口配置后,我们需要构建一个符合目标平台要求的请求体。假设我们要写入的数据包含客户信息,构建请求体时应包括所有必要的字段,如下所示:

{ "customerId": "12345", "customerName": "张三", "contactInfo": { "phone": "13800000000", "email": "zhangsan@example.com" }, "address": { "province": "北京市", "city": "北京市", "district": "海淀区", "detailAddress": "中关村大街" } } -

调用API接口

使用上述构建好的请求体,通过POST方法调用定义好的API接口,将数据发送到目标平台。以下是一个示例代码段,展示了如何使用Python实现这一过程:

import requests import json url = 'https://api.qingyiyun.com/write' headers = { 'Content-Type': 'application/json' } data = { 'customerId': '12345', 'customerName': '张三', 'contactInfo': { 'phone': '13800000000', 'email': 'zhangsan@example.com' }, 'address': { 'province': '北京市', 'city': '北京市', 'district': '海淀区', 'detailAddress': '中关村大街' } } response = requests.post(url, headers=headers, data=json.dumps(data)) if response.status_code == 200: print('Data written successfully') else: print(f'Failed to write data: {response.status_code}') -

处理响应

在调用API接口后,我们需要处理响应结果,以确保数据成功写入目标平台。如果响应状态码为200,表示操作成功,否则需根据返回的错误信息进行相应处理。

结论

通过以上步骤,我们可以利用轻易云数据集成平台提供的API接口和元数据配置,实现从源平台到目标平台的数据ETL转换和写入。这一过程不仅确保了数据的一致性和完整性,还提高了业务流程的自动化程度。