吉客云数据集成到MySQL的技术案例分享

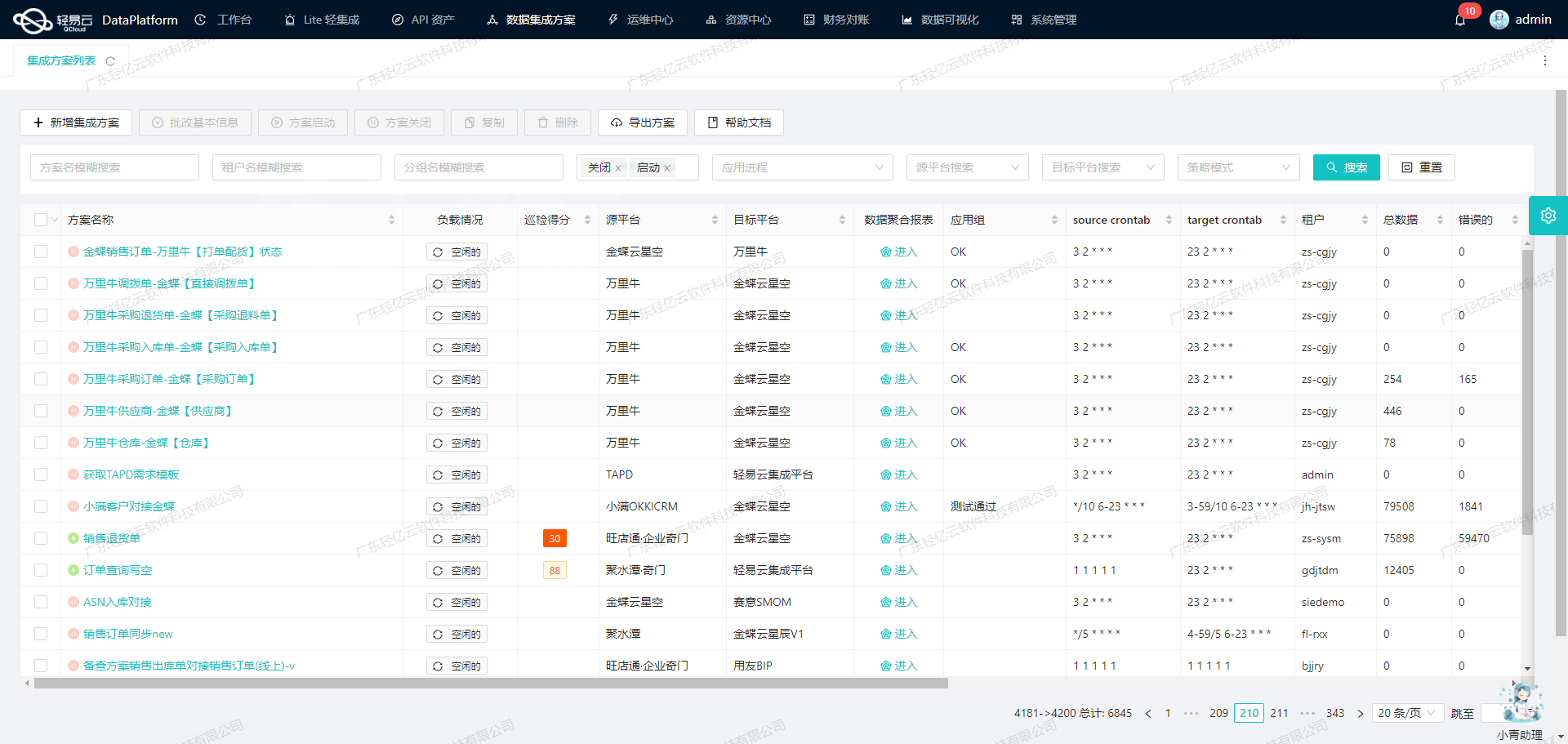

在本次系统对接项目中,我们选用轻易云数据集成平台,成功实现了吉客云的数据高效导入到MySQL数据库。具体操作流程围绕pkd-吉客云查询盘亏单-->mysql方案展开,通过调用吉客云的API接口wms.stocktake.get进行数据获取,并利用MySQL API execute完成数据写入。

技术方案概述

为确保数据在集成过程中不漏单,我们设计了一套定时可靠的抓取机制,通过周期性调度任务,规避潜在的数据丢失问题。同时,为应对大量数据快速写入需求,我们采取了批量处理策略,大幅提升了整体效率。

针对不同系统之间存在的数据格式差异,我们自定义了一系列数据转换逻辑,以匹配特定业务场景与数据库结构。此外,考虑到API接口调用可能遇到分页和限流问题,每个请求都进行了细致的分页管理和速率控制,以确保稳定运行。

整合过程中,还特别注重异常处理与错误重试机制。当出现网络抖动或其他意外情况时,系统能够自动记录日志并触发相应告警,实现实时监控与及时响应。

通过集中化监控和高吞吐量支持,这一解决方案为企业提供了一体化视图,使其全面掌握API资产使用情况,并优化资源配置。结合可视化的数据流设计工具,各个环节变得更加直观、易于管理,从而进一步保障了整个集成过程的透明度与精确性。

调用吉客云接口wms.stocktake.get获取并加工数据

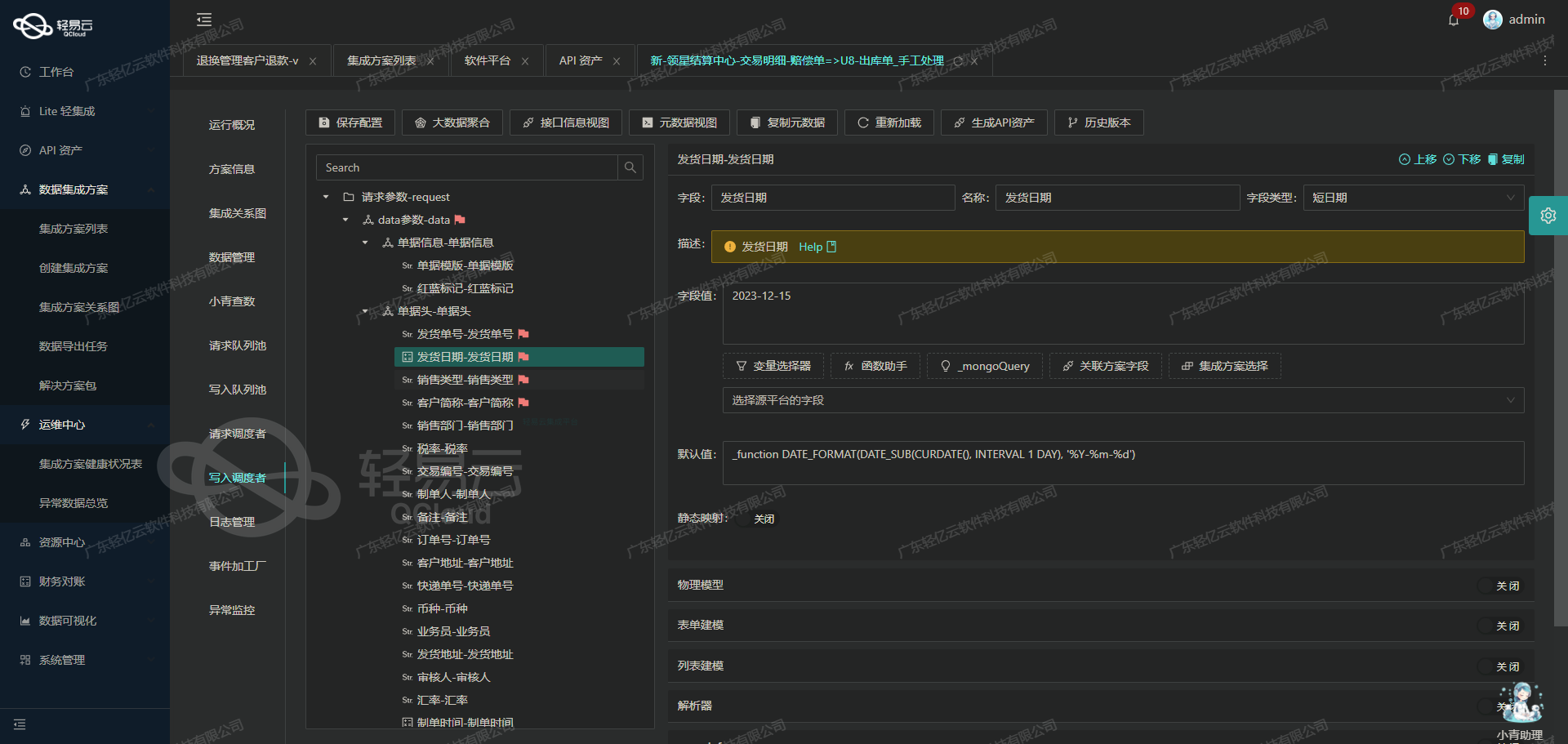

在数据集成的生命周期中,调用源系统接口是至关重要的一步。本文将详细探讨如何通过轻易云数据集成平台调用吉客云接口wms.stocktake.get,并对获取的数据进行加工处理。

接口调用配置

首先,我们需要配置元数据来调用吉客云的API接口。以下是针对wms.stocktake.get接口的元数据配置:

{

"api": "wms.stocktake.get",

"method": "POST",

"number": "stocktakeId",

"id": "id",

"pagination": {

"pageSize": 1

},

"idCheck": true,

"formatResponse": [

{

"old": "stocktakeDate",

"new": "datetime_new",

"format": "date"

},

{

"old": "stocktakeId",

"new": "order_no_new",

"format": "string"

}

],

"request": [

{

"field": "warehouseCode",

"label": "仓库编号",

"type": "string",

"describe": "123456"

},

{

"field": "skuBarcode",

"label": "条码 支持批量查询",

"type": "string"

},

{

"field": "pageSize",

"label": "条目",

"type": "string",

"value": "20"

},

{

"field": "pageIndex",

"label": "页码",

'type': 'string'

},

{

'label': '盘点时间-开始',

'field': 'startPdDate',

'type': 'string',

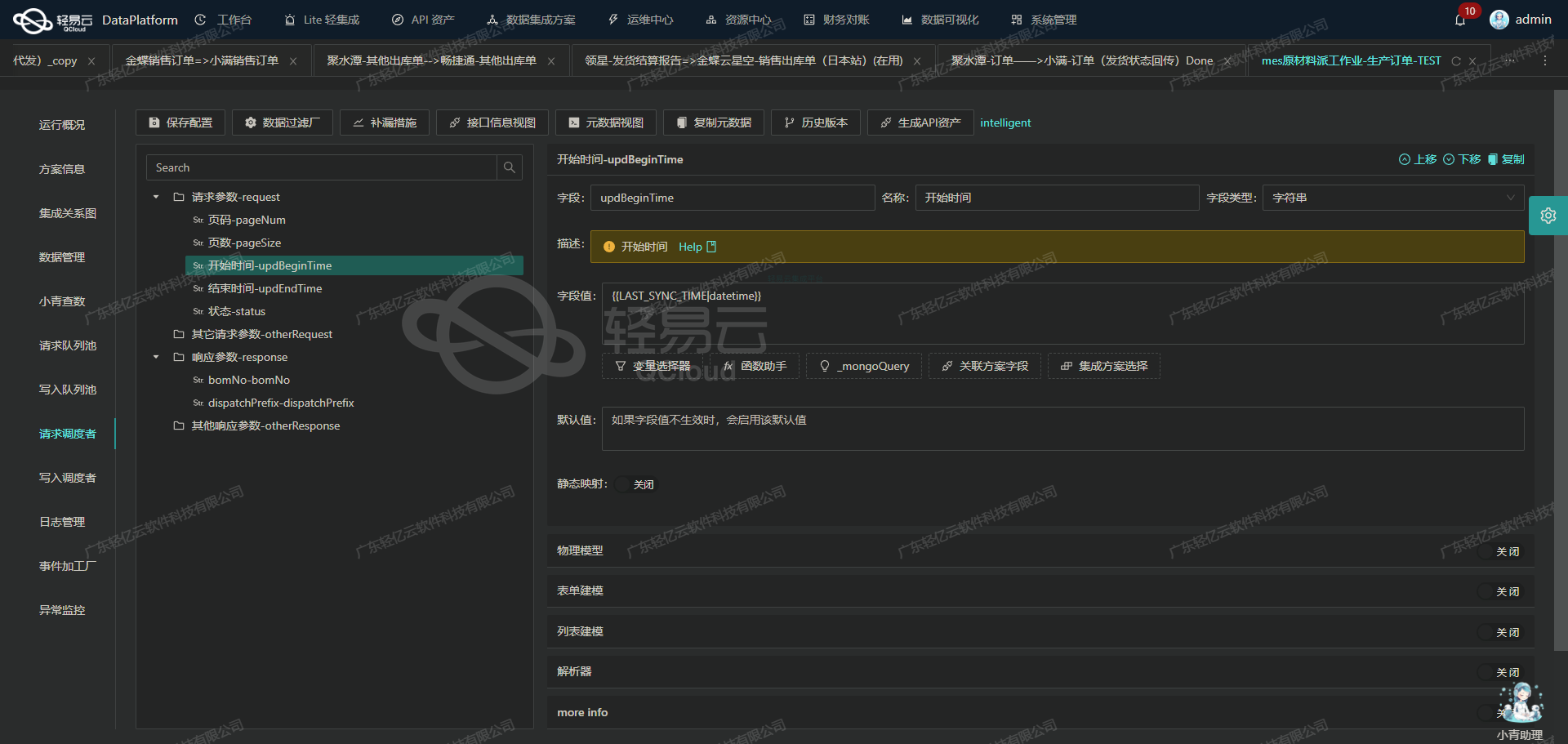

'value': '{{LAST_SYNC_TIME|datetime}}'

},

{

'label': '盘点时间-结束',

'field': 'endPdDate',

'type': 'string',

'value': '{{CURRENT_TIME|datetime}}'

}

],

'beatFlat': ['stockCountLoss']

}请求参数说明

在请求参数部分,我们定义了多个字段以确保能够准确获取所需的数据:

warehouseCode: 仓库编号,固定值为"123456"。skuBarcode: 条码,支持批量查询。pageSize: 每页条目数,固定值为"20"。pageIndex: 页码,由系统动态生成。startPdDate: 盘点时间开始,使用模板变量{{LAST_SYNC_TIME|datetime}}动态生成。endPdDate: 盘点时间结束,使用模板变量{{CURRENT_TIME|datetime}}动态生成。

这些参数确保了我们可以灵活地控制查询范围和分页信息。

数据格式化与转换

为了使数据更符合目标系统的需求,我们需要对返回的数据进行格式化和转换。在元数据配置中,我们定义了两个格式化规则:

- 将原始字段

stocktakeDate转换为新的字段名datetime_new,并格式化为日期类型。 - 将原始字段

stocktakeId转换为新的字段名order_no_new,并格式化为字符串类型。

这些规则通过formatResponse字段定义,并在数据返回后自动应用。

数据清洗与写入

在获取并格式化数据后,我们需要进一步清洗和处理这些数据。例如,通过配置中的beatFlat字段,我们可以将某些嵌套结构的数据平展为简单结构,以便于后续处理和存储。

最后,将清洗后的数据写入目标数据库(如MySQL)。这一步通常包括以下操作:

- 数据映射:将源系统的数据字段映射到目标数据库的表结构。

- 数据插入:执行批量插入操作,将处理后的数据写入数据库。

通过轻易云平台的全异步处理机制,这些操作可以高效地完成,并且支持实时监控和日志记录,以确保整个过程透明可控。

实践案例

假设我们需要从吉客云获取某仓库在特定时间段内的盘亏单信息,并将其存储到MySQL数据库中。具体步骤如下:

- 配置元数据,如上所述。

- 调用API接口,通过POST请求获取盘亏单信息。

- 对返回的数据进行格式化和转换,将日期和ID字段重新命名并调整类型。

- 清洗平展嵌套结构的数据,使其适应目标数据库的表结构。

- 执行批量插入操作,将清洗后的数据写入MySQL数据库。

通过以上步骤,我们实现了从吉客云到MySQL的无缝数据集成,为业务提供了可靠的数据支持。

数据集成生命周期第二步:ETL转换与写入MySQLAPI接口

在数据集成生命周期的第二步,我们需要将源平台的数据进行ETL(提取、转换、加载)处理,并将其转化为目标平台MySQLAPI接口能够接收的格式,最终写入目标平台。以下是详细的技术实现过程。

元数据配置解析

元数据配置是ETL过程中的核心部分,它定义了如何将源数据映射到目标数据结构中。以下是我们使用的元数据配置:

{

"api": "execute",

"effect": "EXECUTE",

"method": "POST",

"idCheck": true,

"request": [

{

"field": "main_params",

"label": "main_params",

"type": "object",

"describe": "111",

"children": [

{"field": "stockCountLoss_id", "label": "明细id", "type": "string", "value": "{stockCountLoss_id}"},

{"field": "order_no_new", "label": "单号", "type": "string", "value": "{order_no_new}"},

{"field": "datetime_new", "label": "时间", "type": "date", "value": "{datetime_new}"},

{"field": "qty_count", "label": "数量", "type": "string", "value": "{stockCountLoss_count}"},

{"field": "sales_count",