MySQL数据集成到钉钉的技术实现:留言

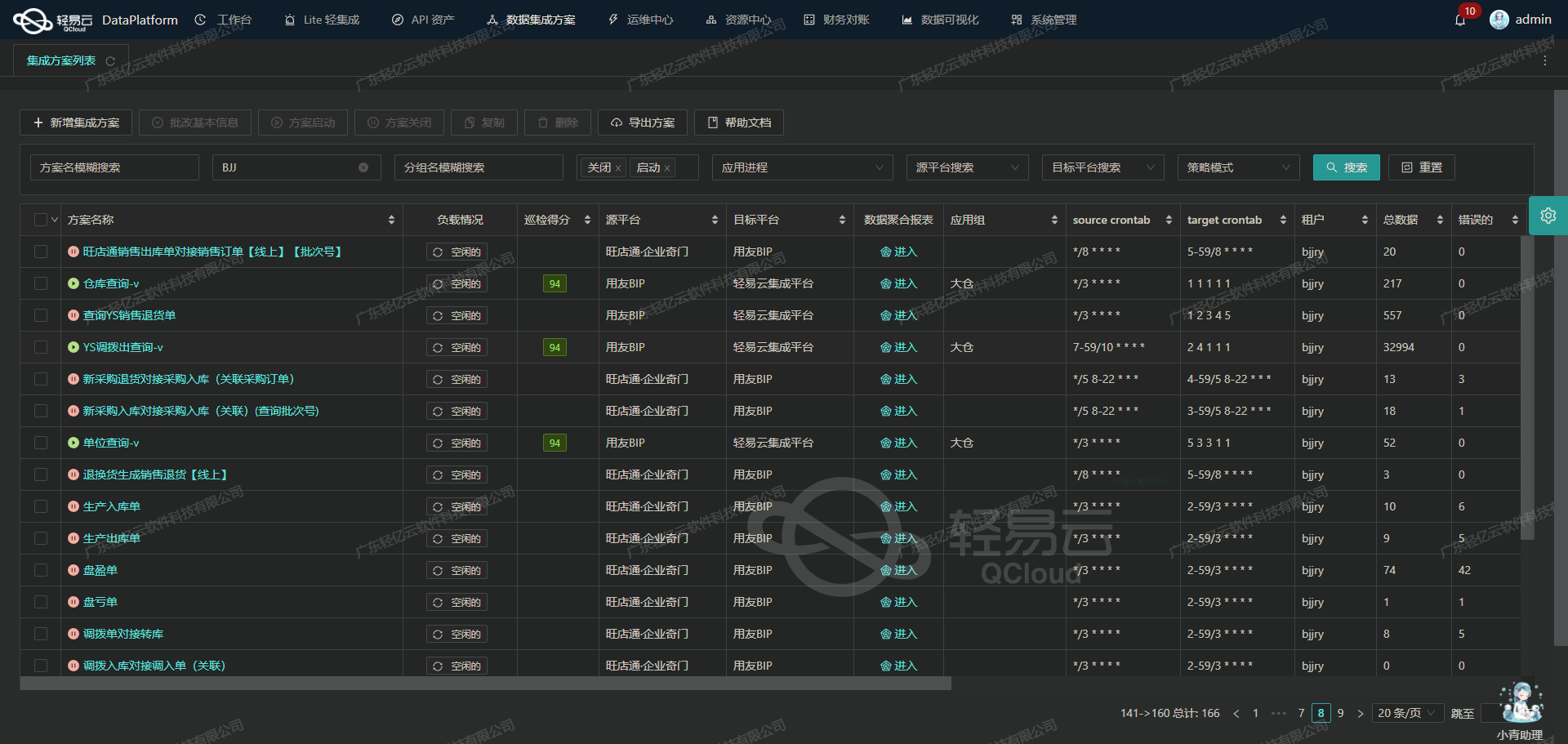

在数据驱动业务决策和流程优化的背景下,如何高效地将MySQL数据库中的数据集成到钉钉成为一个实际且迫切需要解决的问题。本案例分享了使用轻易云数据集成平台,实现MySQL数据库与钉钉之间的数据对接,通过select API获取MySQL数据,并利用DingTalkRoBotPush API进行写入。

确保MySQL集成过程不漏单

为了确保读取过程中不会有任何遗漏,我们采用分页抓取机制来处理大量数据。通过设置合理的分页参数及限流策略,不仅保证了每一笔记录都被准确提取,还能有效避免接口调用超时或异常。

SELECT * FROM my_table WHERE id > ? LIMIT ?大量数据快速写入到钉钉

为满足业务需求,大量的数据需要迅速、可靠地推送至钉钉。在此方案中,我们使用多线程并发处理,将批量抓取的数据通过DingTalkRoBotPush API高效分发至指定目标。结合灵活的映射规则,进一步简化了复杂字段转换任务,确保原始数据在格式上无缝兼容。

// 伪代码示例

function pushToDingTalk(dataBatch) {

dataBatch.forEach(record => {

DingTalkRoBotPush({

"message": record.message,

"timestamp": record.timestamp,

// other necessary payload

});

});

}定时可靠的数据同步机制

为了使系统能够实时监控并保持最新状态,我们设计了一套定时调度策略,每隔特定时间间隔触发一次API调用,对新产生或更新的数据进行捕获和同步。这不仅提高了系统实时性,也最大程度降低网络抖动等因素带来的影响。

# 每小时运行一次脚本

0 * * * * /path/to/integration_script.sh以上是我们在实际操作中总结出的几个关键点,为后续详细讨论具体实现提供基础框架。在接下来的部分,我们将深入探讨各环节中应用的具体技术方法,以及常见问题及其应对措施。

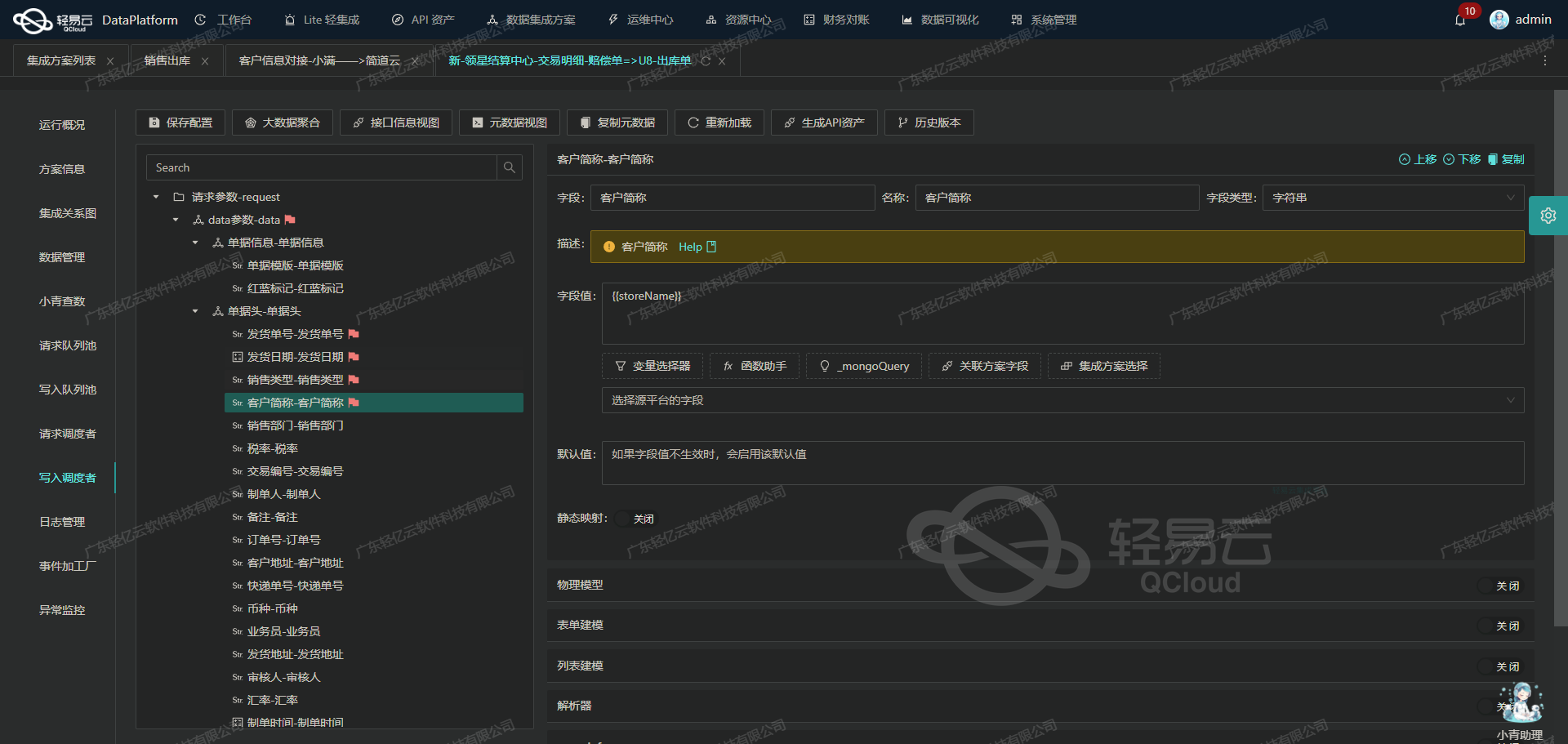

使用轻易云数据集成平台调用MySQL接口获取并加工数据

在数据集成过程中,调用源系统接口是至关重要的一步。本文将深入探讨如何通过轻易云数据集成平台调用MySQL接口select获取并加工数据。

元数据配置解析

首先,我们来看一下元数据配置的具体内容:

{

"api": "select",

"method": "POST",

"number": "phone",

"id": "name",

"pagination": {

"pageSize": 100

},

"idCheck": true,

"request": [

{

"field": "main_params",

"label": "主参数",

"type": "object",

"children": [

{

"field": "limit",

"label": "limit",

"type": "string",

"value": "{PAGINATION_PAGE_SIZE}",

"parent": "main_params"

},

{

"field": "offset",

"label": "offset",

"type": "string",

"value": "{PAGINATION_START_ROW}",

"parent": "main_params"

}

]

}

],

"otherRequest": [

{

"field": "main_sql",

"label": "主查询语句",

"type": "string",

"value":"select id,company,name,phone,created_at from www_contact where created_at >= '{{DAYS_AGO_1|datetime}}' limit :limit offset :offset"

}

]

}配置解读与应用

-

API与方法

api: 指定了要调用的MySQL接口类型为select。method: 使用POST方法进行请求。

-

分页设置

pagination.pageSize: 每次请求的数据条数,设置为100条。

-

请求参数

request: 定义了请求参数,其中包含一个名为main_params的对象,该对象包含两个子字段:limit: 用于限制返回记录的数量,值为{PAGINATION_PAGE_SIZE}。offset: 用于指定返回记录的起始位置,值为{PAGINATION_START_ROW}。

-

主查询语句

otherRequest.main_sql: 定义了主查询语句,用于从MySQL数据库中提取所需的数据。该语句包含两个占位符:limit和:offset,分别对应分页参数。

实际操作步骤

-

定义分页参数 在实际操作中,我们需要定义分页参数,以便在多次请求中逐步获取所有数据。例如:

page_size = metadata['pagination']['pageSize'] start_row = 0 -

构建请求体 根据元数据配置构建请求体:

request_body = { 'main_params': { 'limit': page_size, 'offset': start_row }, 'main_sql': metadata['otherRequest'][0]['value'] } -

发送请求并处理响应 使用HTTP库(如requests)发送POST请求,并处理响应数据:

import requests url = 'http://your-mysql-api-endpoint' response = requests.post(url, json=request_body) if response.status_code == 200: data = response.json() # 数据处理逻辑 process_data(data) # 更新start_row以获取下一页数据 start_row += page_size else: print(f"Error: {response.status_code}") -

循环获取所有数据 将上述步骤放入循环中,直到所有数据都被获取完毕:

while True: response = requests.post(url, json=request_body) if response.status_code == 200: data = response.json() if not data: # 如果没有更多数据,则退出循环 break process_data(data) start_row += page_size request_body['main_params']['offset'] = start_row else: print(f"Error: {response.status_code}") break

数据处理与清洗

在获取到原始数据后,可以根据业务需求进行进一步的数据清洗和转换。例如,可以使用pandas库对数据进行处理:

import pandas as pd

def process_data(data):

df = pd.DataFrame(data)

# 数据清洗和转换逻辑,例如去除空值、格式化日期等

df.dropna(inplace=True)

df['created_at'] = pd.to_datetime(df['created_at'])

# 保存或进一步处理清洗后的数据

save_to_database(df)

def save_to_database(df):

# 将清洗后的DataFrame保存到目标数据库或文件系统中

pass通过以上步骤,我们可以高效地调用MySQL接口获取并加工所需的数据。这种方法不仅简化了复杂的数据集成过程,还提高了系统间的数据交互效率。

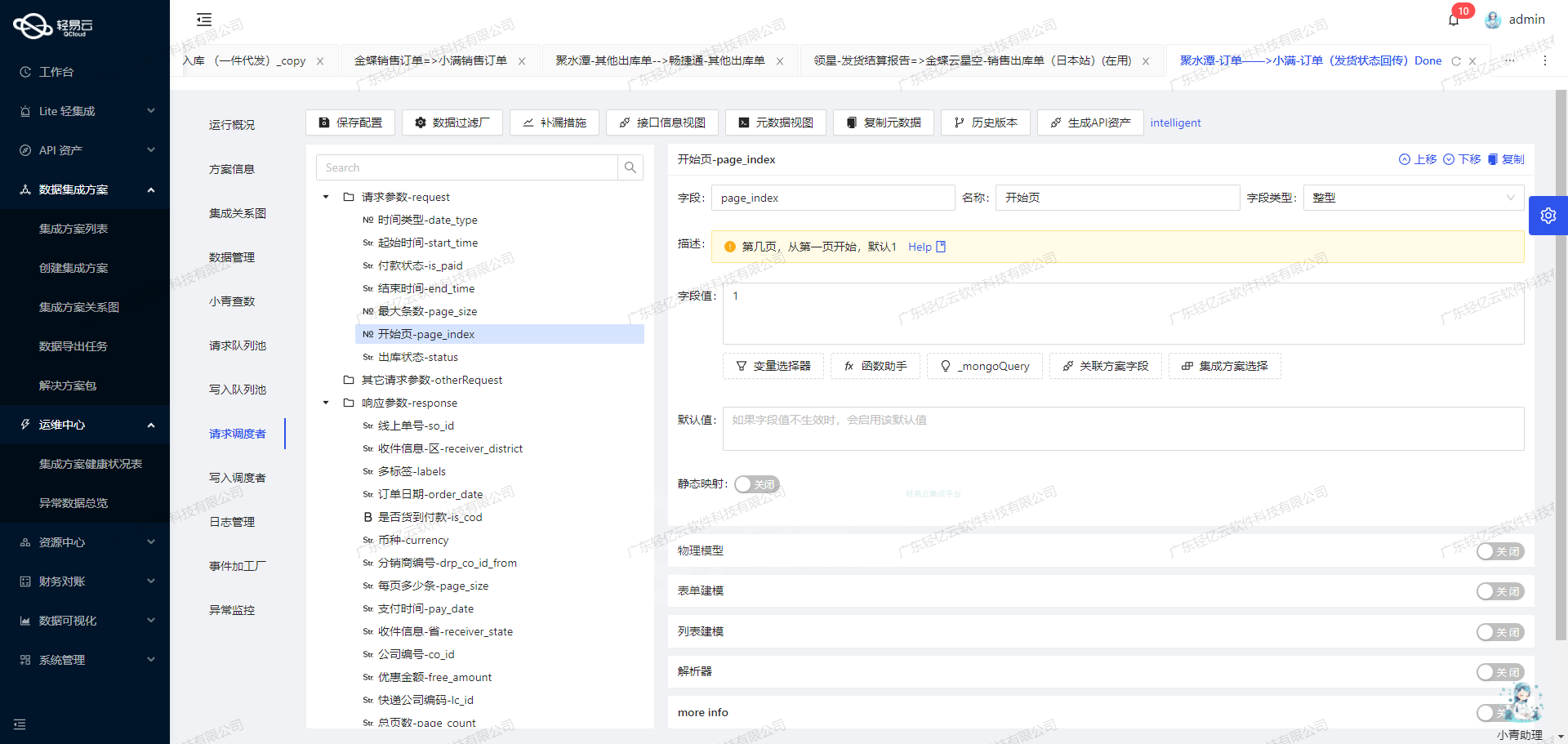

使用轻易云数据集成平台将源数据转换并写入钉钉API接口

在数据集成的生命周期中,第二步是将已经集成的源平台数据进行ETL(Extract, Transform, Load)转换,转为目标平台所能够接收的格式,并最终写入目标平台。本文将详细探讨如何使用轻易云数据集成平台将源数据转换为钉钉API接口所需的格式,并成功推送到钉钉。

元数据配置解析

在本案例中,我们需要将用户留言信息推送到钉钉机器人。以下是我们需要配置的元数据:

{

"api": "DingTalkRoBotPush",

"method": "POST",

"idCheck": true,

"request": [

{"field": "access_token", "label": "钉钉机器人token", "type": "string", "value": "7ba55a29f8bc455edd40c6f5c2698dabb61263d0b776e284434432a144f3c155"},

{"field": "title", "label": "首屏会话透出的展示内容", "type": "string", "value": "平台网站用户留言推送"},

{"field": "header", "label": "标题", "type": "string", "value": "用户留言"},

{"label": "留言用户姓名", "field": "name", "type": "string", "value": "{name}"},

{"label": "留言用户电话", "field": "phone", "type": "string", "value": "{phone}"},

{"label": "公司名称", "field": "company", "type": "string", "value": "{company}"},

{"label": "留言时间", "field": ":created_at","type":"string","value":"{created_at}"}

]

}数据转换与映射

在ETL过程中,首先需要从源系统提取数据,然后进行必要的清洗和转换,最后将其加载到目标系统。在这里,我们重点关注数据转换与映射。

-

提取与清洗

- 从源系统提取原始留言数据,包括用户姓名、电话、公司名称和留言时间等。

- 清洗数据以确保其格式和内容符合要求。例如,检查电话号码是否有效,日期格式是否正确等。

-

字段映射

- 将清洗后的源数据字段映射到钉钉API接口所需的字段。我们通过元数据配置中的

{}占位符来实现动态映射。 - 示例:

{ "{name}":"张三", "{phone}":"13800138000", "{company}":"某某公司", "{created_at}":"2023-10-01 12:00:00" }

- 将清洗后的源数据字段映射到钉钉API接口所需的字段。我们通过元数据配置中的

-

构建请求体

- 根据元数据配置,将映射后的字段值填充到请求体中:

{ “access_token”: “7ba55a29f8bc455edd40c6f5c2698dabb61263d0b776e284434432a144f3c155”, “title”: “平台网站用户留言推送”, “header”: “用户留言”, “name”: “张三”, “phone”: “13800138000”, “company”: “某某公司”, “created_at”: “2023-10-01 12:00:00” }

- 根据元数据配置,将映射后的字段值填充到请求体中:

API调用与写入

完成上述步骤后,即可通过HTTP POST方法调用钉钉API接口,将构建好的请求体发送至目标平台:

POST /robot/send?access_token=7ba55a29f8bc455edd40c6f5c2698dabb61263d0b776e284434432a144f3c155 HTTP/1.1

Host: oapi.dingtalk.com

Content-Type: application/json

{

“msgtype”: “text”,

“text”: {

“content”: “[平台网站用户留言推送] 用户姓名:张三,电话:13800138000,公司:某某公司,时间:2023-10-01 12:00:00”

}

}实时监控与日志记录

为了确保整个流程的顺利进行,需要对每个环节进行实时监控,并记录日志以便于后续追踪和问题排查。轻易云提供了全透明可视化操作界面,可以实时监控数据流动和处理状态,从而提升业务透明度和效率。

通过以上步骤,我们成功地将源平台的数据经过ETL转换后推送至钉钉API接口,实现了跨系统的数据无缝对接。这不仅提高了信息传递的及时性,也增强了企业内部沟通的效率。