吉客云数据集成到MySQL的技术案例分享:库位方案

在现代企业的数据管理中,系统间的数据集成是确保业务高效运作的关键环节。本文将详细介绍如何通过轻易云数据集成平台,将吉客云中的库位数据无缝对接到MySQL数据库中,实现高效、可靠的数据同步。

高吞吐量的数据写入能力

在本次集成方案中,我们首先需要解决的是大量库位数据从吉客云快速写入到MySQL的问题。轻易云平台提供了强大的高吞吐量数据写入能力,使得我们能够在短时间内完成大批量数据的传输和存储,极大提升了数据处理的时效性。

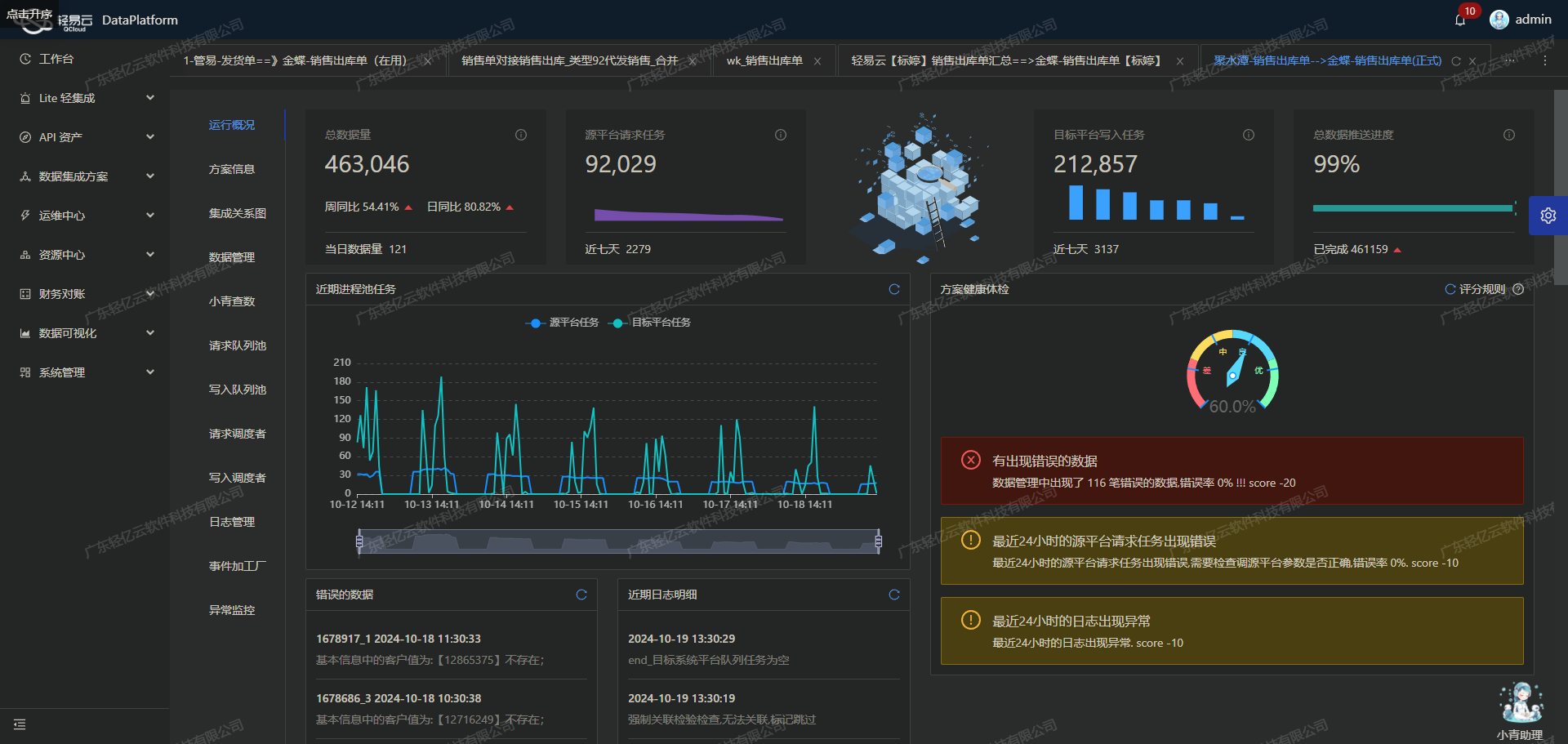

实时监控与告警系统

为了确保整个数据集成过程的稳定性和可靠性,轻易云平台还提供了集中化的监控和告警系统。通过实时跟踪每个数据集成任务的状态和性能,我们可以及时发现并处理潜在问题,避免因异常情况导致的数据丢失或延迟。

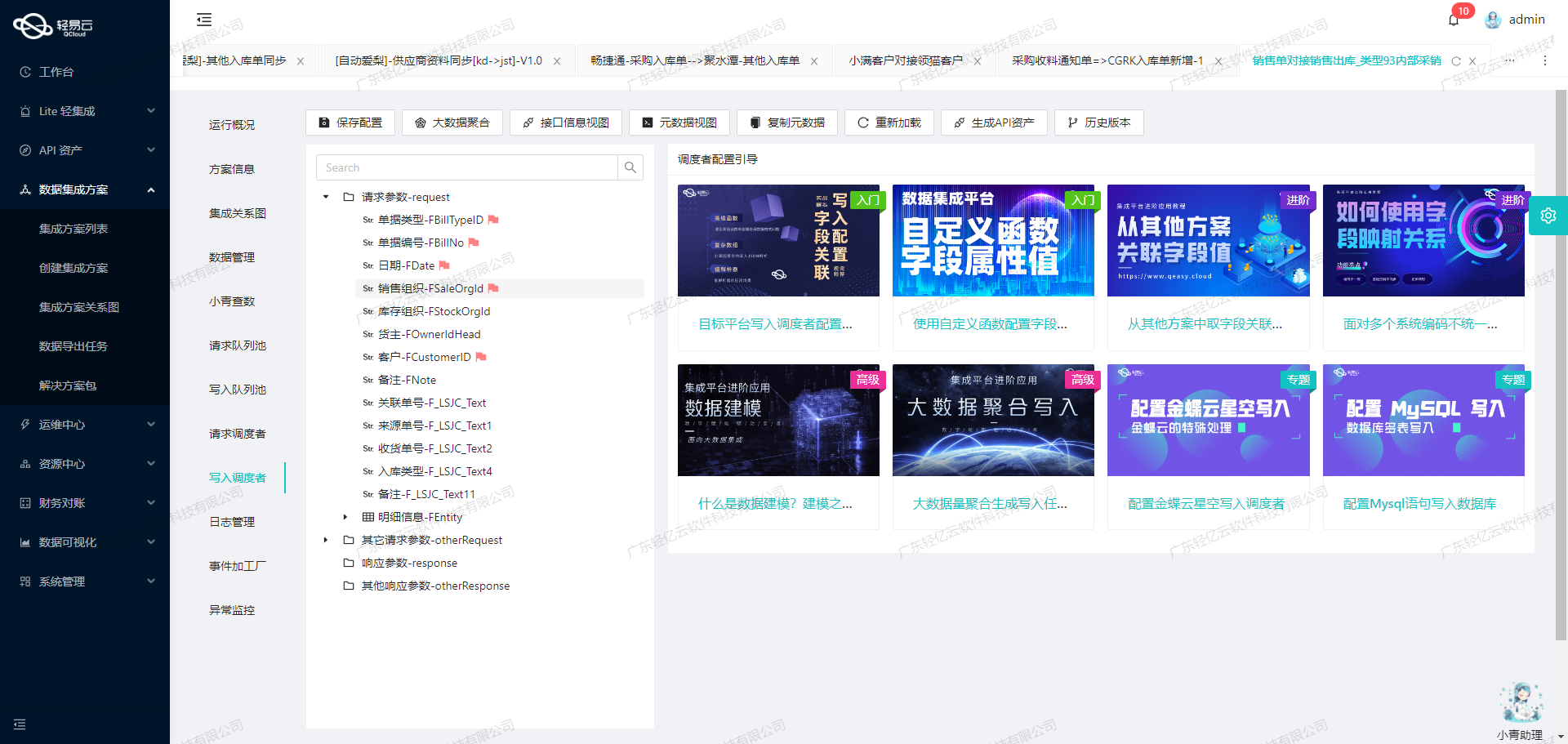

API资产管理与优化配置

吉客云与MySQL之间的数据对接不仅仅是简单的数据传输,更涉及到API资产管理功能。通过统一视图和控制台,我们能够全面掌握API资产的使用情况,并进行资源优化配置。这一特性帮助企业实现更高效的数据管理和利用。

数据质量监控与异常检测

在实际操作过程中,保证数据质量同样至关重要。轻易云平台支持全面的数据质量监控和异常检测机制,可以及时发现并处理任何可能影响数据准确性的异常情况,从而确保最终写入MySQL数据库中的每条记录都是准确无误的。

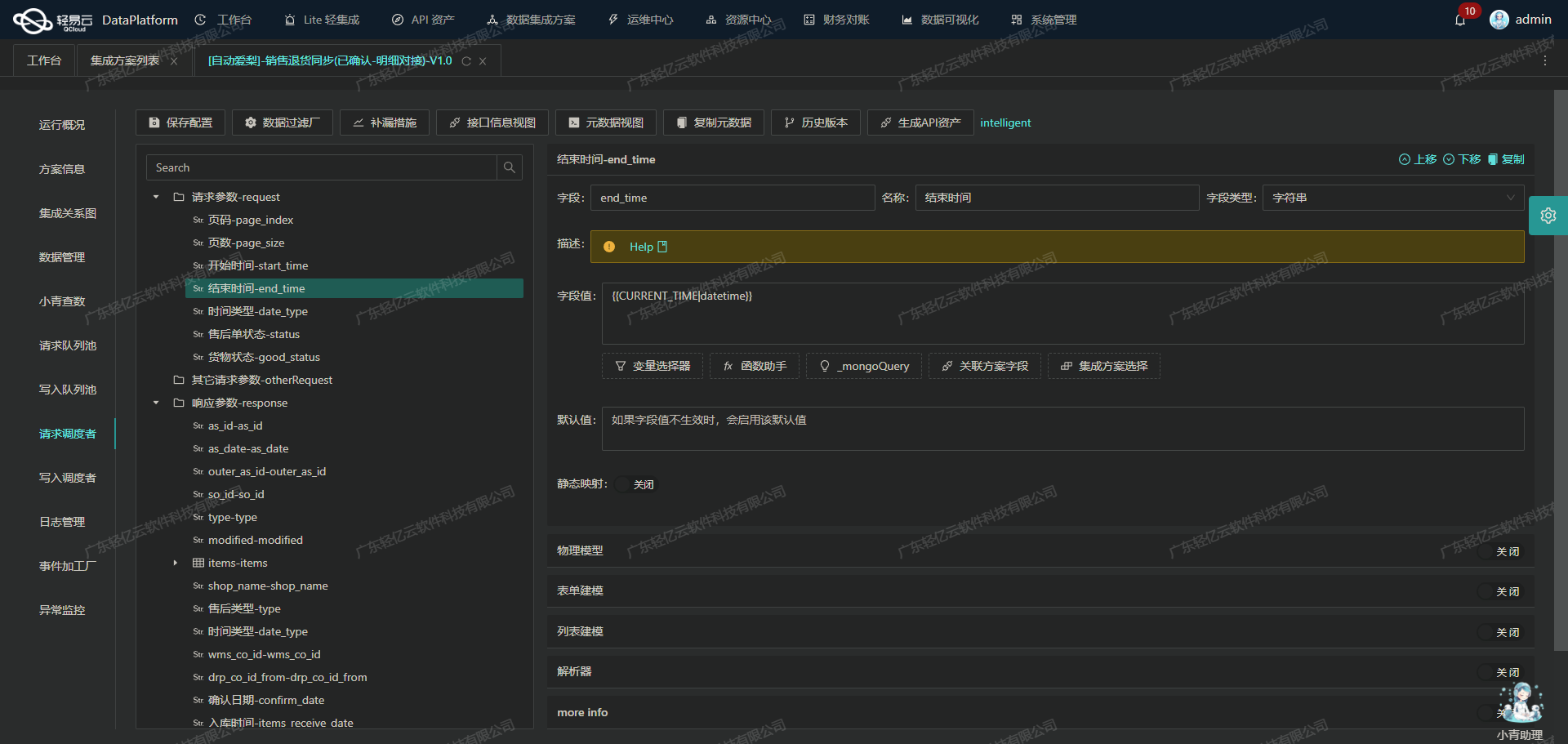

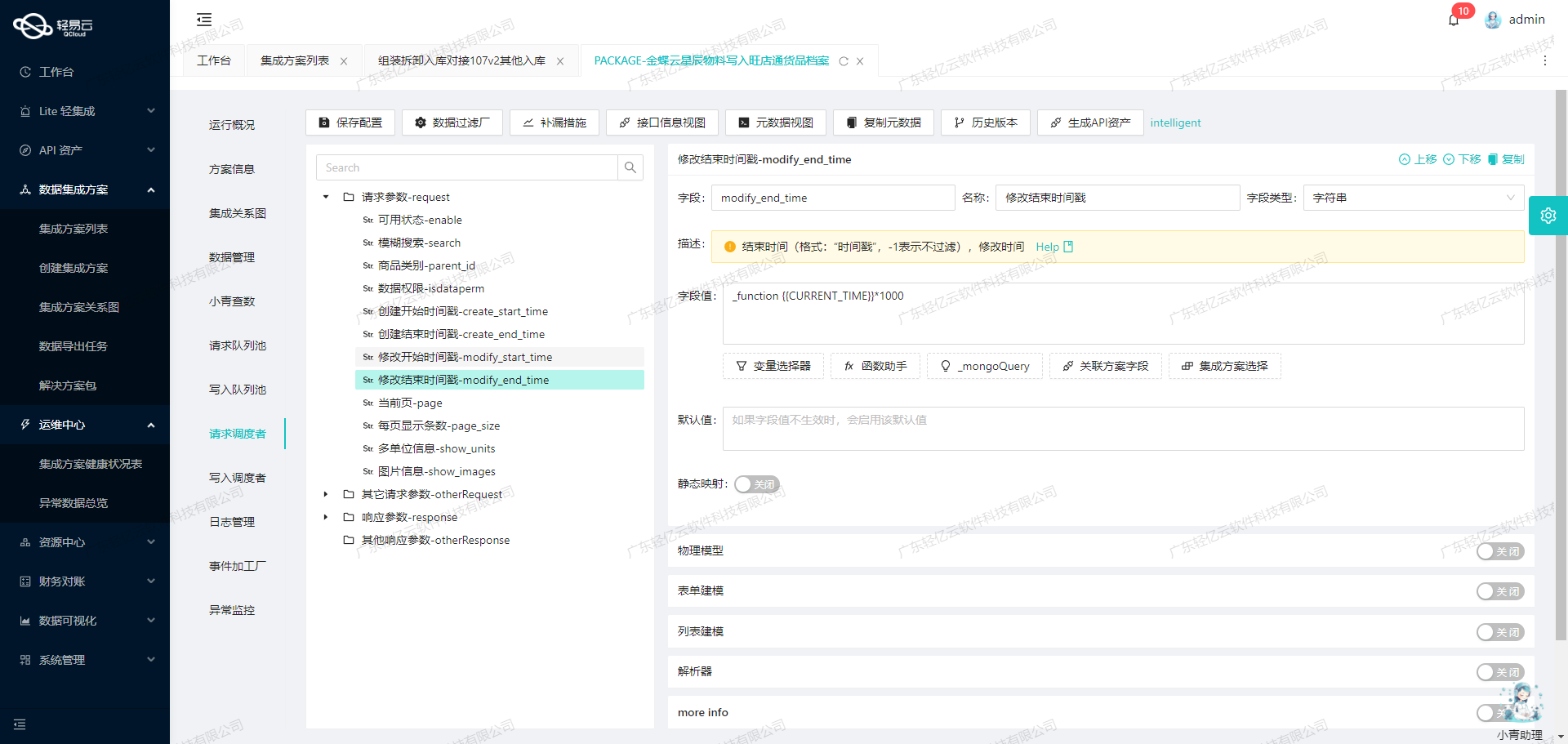

自定义数据转换逻辑

由于吉客云与MySQL之间可能存在数据结构上的差异,因此我们需要灵活应对各种复杂场景。轻易云平台允许用户自定义数据转换逻辑,以适应特定业务需求。这使得我们能够根据实际情况,对库位信息进行必要的格式转换和调整,从而实现完美对接。

综上所述,通过合理利用轻易云平台提供的一系列强大功能,我们成功地将吉客云中的库位信息高效、安全地集成到了MySQL数据库中,为企业后续的数据分析和决策提供了坚实基础。在接下来的章节中,我们将进一步探讨具体实施步骤及技术细节。

调用源系统吉客云接口erp.warehouse.get获取并加工数据

在轻易云数据集成平台中,调用吉客云接口erp.warehouse.get是生命周期的第一步。此步骤主要涉及从吉客云获取库位数据,并对其进行初步加工处理,以便后续的数据转换和写入操作。

配置元数据

根据提供的元数据配置,我们需要通过POST请求调用吉客云的erp.warehouse.get接口。该接口支持分页查询,每页返回50条记录。以下是关键的元数据配置项:

- API:

erp.warehouse.get - Method:

POST - Pagination: 每页50条记录

- Request参数:

pageIndex: 分页页码pageSize: 分页页数(固定为50)

请求参数设置

在实际调用过程中,需要动态设置分页参数以确保能够完整获取所有库位数据。示例如下:

{

"pageIndex": "1",

"pageSize": "50"

}每次请求时,通过递增pageIndex来实现分页抓取,直到所有数据被完全获取。

数据获取与初步加工

- 初始化请求:首先构建初始请求,设置

pageIndex为1,pageSize为50。 - 发送请求并解析响应:使用轻易云平台的HTTP客户端发送POST请求,并解析返回的数据。

- 检查ID唯一性:根据元数据配置中的

idCheck: true,确保每条记录的唯一标识符(如warehouseId)在整个集成过程中不重复。 - 处理分页逻辑:如果返回的数据量达到分页大小,则继续发送下一页请求,直至所有页面的数据都被抓取完毕。

异常处理与重试机制

在调用过程中可能会遇到网络波动、API限流等问题。为了保证数据抓取的可靠性,需要实现异常处理与重试机制:

- 网络异常重试:当网络异常或超时时,可以设置一定次数的重试机制。例如,每次失败后等待一段时间再重新尝试。

- 限流处理:如果API调用频率超过限制,可以捕获相应错误信息,并通过延迟策略进行重试。

数据质量监控与日志记录

为了确保集成过程中的数据质量和可追溯性,需要对每次API调用进行监控和日志记录:

- 实时监控:利用轻易云平台提供的集中监控系统,实时跟踪每个API调用的状态和性能指标。

- 日志记录:详细记录每次API调用的请求参数、响应结果以及任何异常情况,以便后续分析和问题排查。

自定义转换逻辑

在获取到原始库位数据后,根据业务需求可以对其进行自定义转换。例如,将某些字段格式化或计算新的派生字段。这一步骤可以通过轻易云平台提供的数据转换工具来实现,使得最终写入目标系统的数据符合预期结构。

综上所述,通过合理配置元数据、动态设置分页参数、实现异常处理与重试机制,以及利用实时监控和日志记录功能,可以高效地完成从吉客云接口获取并加工库位数据,为后续的数据转换与写入奠定坚实基础。

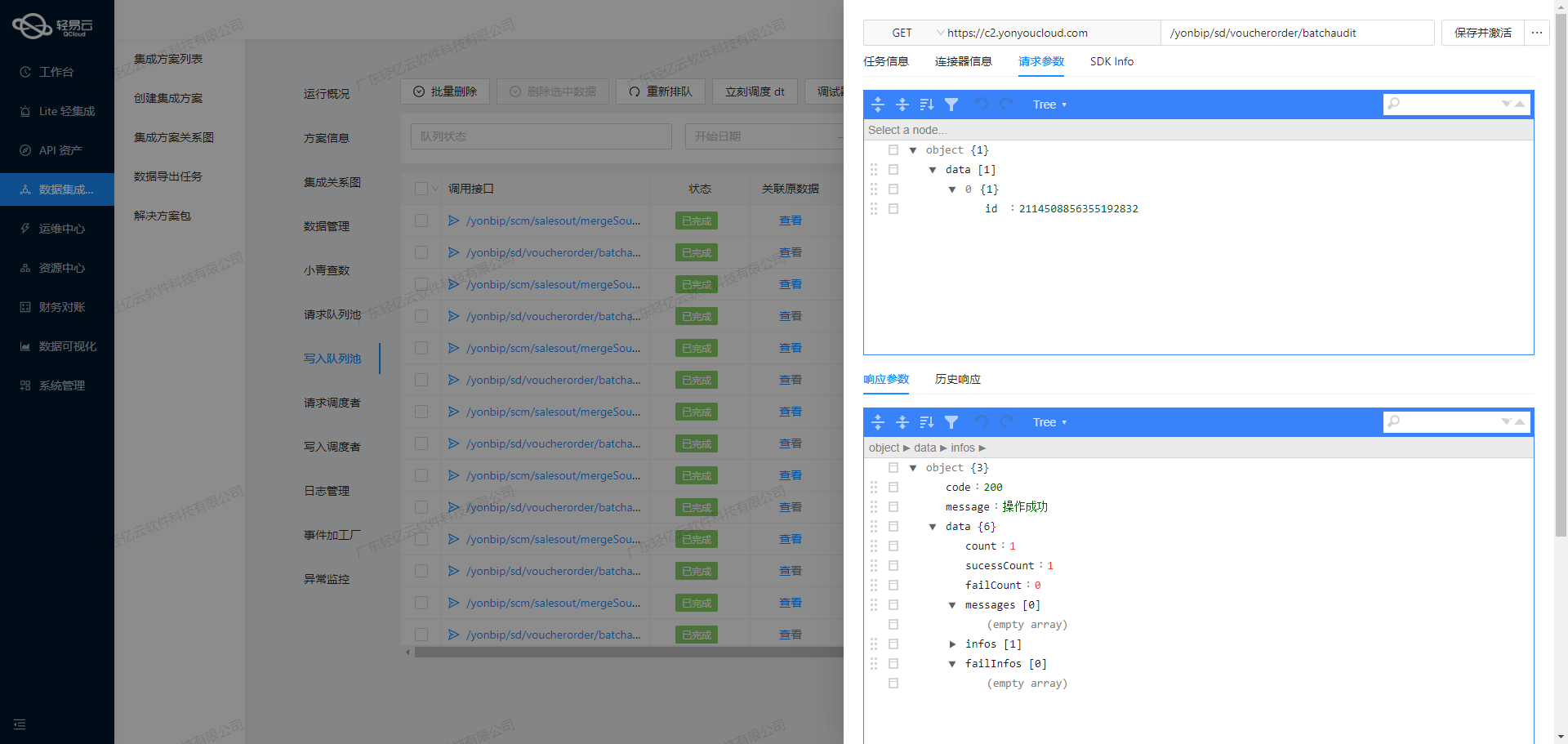

数据转换与写入:将源平台数据集成到MySQL

在数据集成生命周期的第二步,我们重点关注的是将已经集成的源平台数据进行ETL(抽取、转换、加载)处理,最终转为目标平台MySQLAPI接口能够接收的格式,并写入目标平台。以下是详细步骤和技术要点:

数据抽取与转换

首先,我们需要从源平台提取数据。在这个过程中,确保数据的完整性和一致性是至关重要的。提取的数据通常包含多个字段,这些字段需要按照目标平台MySQLAPI接口的要求进行相应的转换。

例如,在元数据配置中,我们定义了一个名为main_params的主表参数对象,其中包括多个字段,如编码(code)、名称(name)、类型编码(type_code)等。为了确保这些字段能够正确映射到目标MySQL数据库,我们需要对每个字段进行相应的转换。

{

"parent": "main_params",

"label": "编码",

"field": "code",

"type": "string",

"value": "{warehouseCode}"

}在上述配置中,warehouseCode是从源平台提取的数据字段,需要转换为目标平台MySQL数据库中的code字段。类似地,其他字段也需要进行相应的映射和转换。

数据加载与写入

完成数据转换后,下一步是将这些数据写入目标MySQL数据库。在这里,我们使用MySQLAPI接口进行数据写入操作。根据元数据配置,可以构造出相应的SQL插入语句:

INSERT INTO `warehouse`

(

`code`,

`name`,

`type_code`,

`type_name`,

`country`,

`province`,

`city`,

`district`,

`town`,

`street`,

`address`,

`contact`,

`phone`,

`owner_id`,

`owner_type_id`,

`stock_status`,

`is_inout_audit`,

`is_inout_task`,

`is_position_stock`,

`is_negative_stock`,

`created_by`,

`create_time`,

`updated_by`,

`update_time`

)

VALUES

(

<{code: }>,

<{name: }>,

<{type_code: }>,

<{type_name: }>,

<{country: }>,

<{province: }>,

<{city: }>,

<{district: }>,

<{town: }>,

<{street: }>,

<{address: }>,

<{contact: }>,

<{phone: }>,

<{owner_id: }>,

<{owner_type_id: }>,

<{stock_status: }>,

<{is_inout_audit: }>,

<{is_inout_task: }>,

<{is_position_stock: }>,

<{is_negative_stock: }>,

<{created_by: }>,

<{create_time: }>,

<{updated_by: }>,

<{update_time: }>

);上述SQL语句定义了将各个字段值插入到warehouse表中的具体操作。这些值通过占位符来标识,实际执行时会替换为对应的数据值。

数据质量监控与异常处理

在整个ETL过程中,数据质量监控和异常处理同样重要。轻易云提供了强大的监控和告警系统,可以实时跟踪数据集成任务的状态和性能。一旦发现异常情况,例如网络问题或数据格式不匹配,可以及时进行处理和重试。

例如,当调用MySQLAPI接口时,如果出现网络超时或数据库连接失败,可以实现错误重试机制,以确保数据最终成功写入目标数据库:

import requests

from time import sleep

def insert_data(payload):

url = 'http://example.com/api/insert'

retries = 3

for i in range(retries):

try:

response = requests.post(url, json=payload)

if response.status_code == 200:

print("Data inserted successfully")

break

except requests.exceptions.RequestException as e:

print(f"Error occurred: {e}")

sleep(2 ** i) # Exponential backoff

else:

print("Failed to insert data after retries")

# Example payload

payload = {

"code": "WH001",

"name": "Warehouse A",

# Other fields...

}

insert_data(payload)上述代码示例展示了如何实现错误重试机制,以确保在发生网络或其他异常情况时,仍然能够成功完成数据插入操作。

自定义数据转换逻辑

为了适应特定业务需求,有时需要自定义数据转换逻辑。例如,对于某些特定字段,需要根据业务规则进行动态计算或格式化。这可以通过编写自定义函数或脚本来实现。

def custom_transform(data):

# Example custom transformation logic

data['full_address'] = f"{data['street']}, {data['city']}, {data['province']}, {data['country']}"

return data

# Transform data before loading into MySQL

transformed_data = custom_transform(extracted_data)通过上述自定义转换逻辑,可以根据实际业务需求灵活调整数据格式,从而确保最终的数据能够正确写入目标MySQL数据库。

综上所述,通过合理配置元数据、实施有效的数据抽取与转换、以及采用可靠的数据加载与写入策略,可以高效地完成从源平台到目标平台MySQLAPI接口的数据集成任务。同时,通过实时监控和异常处理机制,确保整个过程的稳定性和可靠性。